포옹 얼굴 텍스트 생성 추론 (TGI)의 힘을 활용합니다.

큰 언어 모델 (LLM)은 특히 텍스트 생성에서 AI에 혁명을 일으키고 있습니다. 이로 인해 LLM 배포를 단순화하도록 설계된 도구가 급증했습니다. Hugging Face의 텍스트 생성 추론 (TGI)은 눈에 띄며 LLMS를 현지에서 서비스로 실행하기위한 강력한 생산 준비 프레임 워크를 제공합니다. 이 안내서는 TGI의 기능을 탐색하고 정교한 AI 텍스트 생성을 위해이를 활용하는 방법을 보여줍니다.

포옹 얼굴 이해 tgi

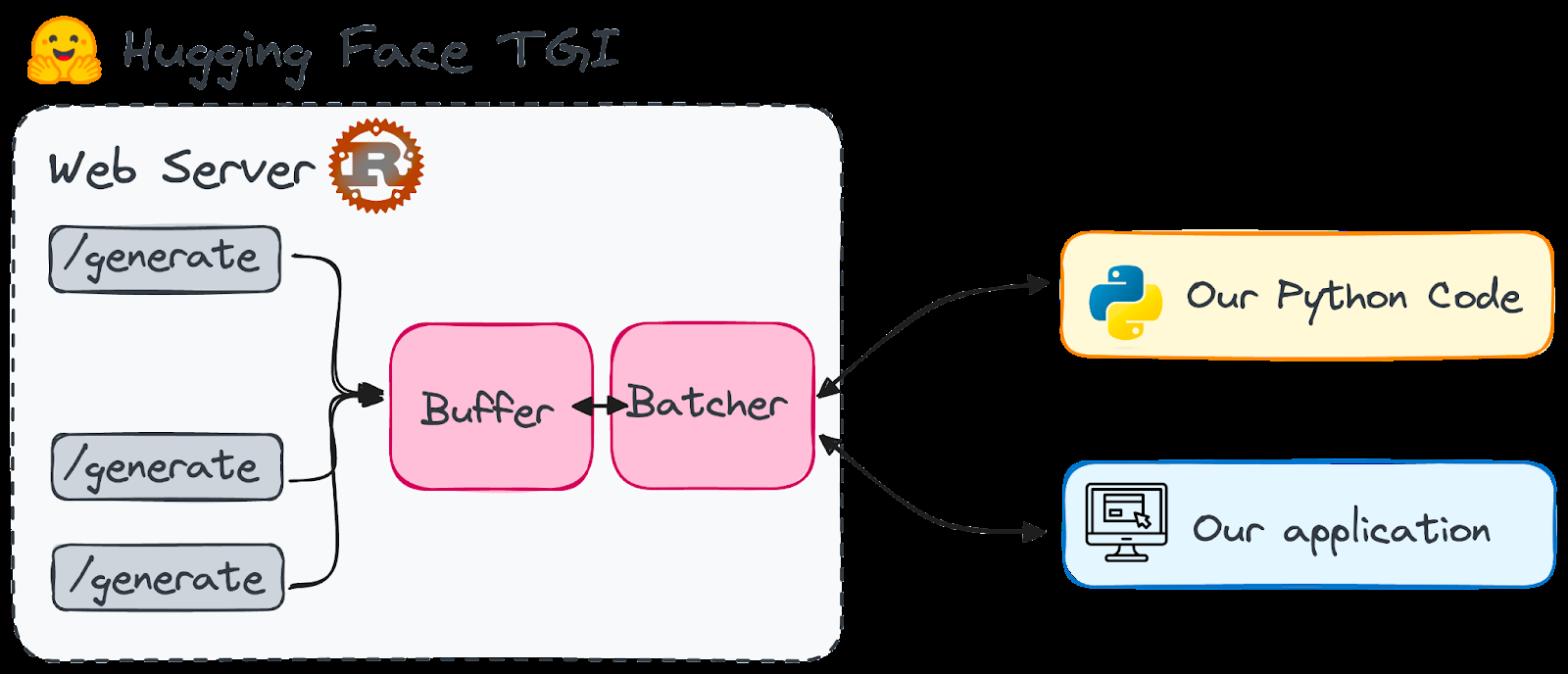

ROST 및 PYTHON FRAMEWORK, TGI는 로컬 컴퓨터에 LLMS를 배포하고 서빙 할 수 있습니다. HFOILV1.0에 따라 라이센스가 부여 된이 제품은 보충 도구로서 상업적으로 사용하기에 적합합니다. 주요 장점은 다음과 같습니다.

고성능 텍스트 생성 : TGI는 StarCoder, Bloom, GPT-Neox, LLAMA 및 T5와 같은 모델에 대한 텐서 병렬 처리 및 동적 배치를 사용하여 성능을 최적화합니다.

효율적인 리소스 사용 : 연속 배치 및 최적화 된 코드는 여러 요청을 동시에 처리하면서 리소스 소비를 최소화합니다.

유연성 :

는 워터 마킹, 바이어스 제어를위한 로이트 워핑 및 정지 시퀀스와 같은 안전 및 보안 기능을 지원합니다.

왜 포옹 얼굴 tgi를 선택합니까?

포옹 페이스는 오픈 소스 LLM의 중앙 허브입니다. 이전에는 많은 모델이 로컬 사용에 비해 너무 자원 집약적이어서 클라우드 서비스가 필요했습니다. 그러나 Qlora 및 GPTQ 양자화와 같은 발전으로 인해 일부 LLM은 로컬 머신에서 관리 할 수있었습니다.

TGI는 LLM 시작 시간의 문제를 해결합니다. 모델을 준비하면 즉시 응답을 제공하여 긴 대기 시간을 제거합니다. 다양한 최상층 언어 모델에 쉽게 액세스 할 수 있다고 상상해보십시오. .

TGI의 단순성은 주목할 만하다. 간소화 된 모델 아키텍처 및 파워의 완벽한 배포를 위해 설계되었습니다.

포옹 채팅

OpenAsSistant -

nat.dev

중요한 참고 사항 : TGI는 현재 ARM 기반 GPU MAC (M1 이상)과 호환되지 않습니다.

포옹 얼굴 TGI 설정

두 가지 방법이 제시됩니다. 처음부터 Docker 사용 (단순성에 권장). 메소드 1 : 처음부터 (더 복잡한)

Rust를 설치하십시오 :

파이썬 가상 환경을 만듭니다 :

Protoc 설치 (버전 21.12 권장) : ( 필요) 간결성에 대해 생략 된 지침은 원본 텍스트를 참조하십시오. curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh.

github 저장소를 복제하십시오 :

tgi를 설치하십시오 :

-

메소드 2 : Docker 사용 (권장)

conda create -n text-generation-inference python=3.9 && conda activate text-generation-inference

Docker가 설치되어 실행되도록하십시오

(먼저 호환성 확인) Docker 명령을 실행하십시오 (Falcon-7b 사용 예) : - sudo

응용 프로그램에서 TGI를 사용하는

TGI를 시작한 후

- 엔드 포인트에 대한 사후 요청을 사용하여 IT와 상호 작용하십시오 (또는 스트리밍의 경우 git clone https://github.com/huggingface/text-generation-inference.git). 파이썬과 컬을 사용한 예는 원본 텍스트에 제공됩니다. 파이썬 라이브러리 ()는 상호 작용을 단순화합니다

실용적인 팁과 추가 학습

-

cd text-generation-inference/ && BUILD_EXTENSIONS=False make install LLM 기초 이해 : 토큰 화,주의 메커니즘 및 변압기 아키텍처에 익숙해 지십시오.

모델 최적화 : 올바른 모델 선택, 토큰 화제 사용자 정의 및 미세 조정을 포함하여 모델을 준비하고 최적화하는 방법을 배우십시오.

생성 전략 : 다른 텍스트 생성 전략 탐색 (욕심 많은 검색, 빔 검색, Top-K 샘플링).

결론

Hugging Face TGI는 LLMS를 로컬로 배포하고 호스팅하는 사용자 친화적 인 방법을 제공하여 데이터 개인 정보 및 비용 관리와 같은 이점을 제공합니다. 강력한 하드웨어가 필요하지만 최근의 발전으로 많은 사용자가 실현 가능합니다. 고급 LLM 개념과 리소스 (원본 텍스트에 언급)를 추가로 탐색하는 것이 지속적으로 학습에 적극 권장됩니다.

위 내용은 Hugging Face '의 LLM 용 텍스트 생성 추론 툴킷 - AI의 게임 체인저의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!