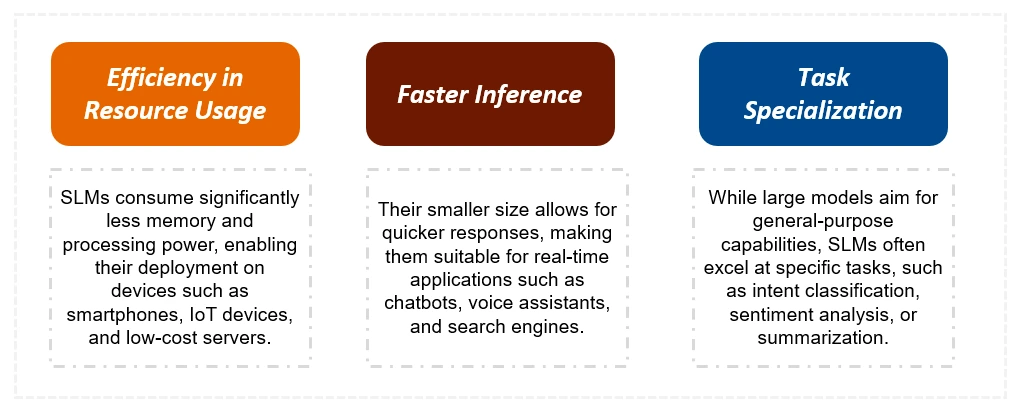

이 기사는 자원으로 제한 된 환경에 대한 효율성과 적합성에 중점을 둔 더 큰 상대방보다 작은 언어 모델 (SLM)의 장점을 탐구합니다. 100 억 미만의 매개 변수를 가진 SLM은 Edge Computing 및 실시간 응용 프로그램에 중요한 속도 및 자원 효율성을 제공합니다. 이 기사는 Google Colab에서 Ollama를 사용한 생성, 응용 프로그램 및 구현에 대해 자세히 설명합니다.

이 안내서는 다음과 같습니다.

주요 차이점 : SLM vs. LLM

SLM은 LLM보다 상당히 작으므로 교육 데이터와 계산 자원이 적습니다. 이로 인해 추론 시간이 빠르고 비용이 낮아집니다. LLM은 복잡한 작업에서는 탁월하지만 SLM은 특정 작업에 최적화되어 있으며 리소스 제한 장치에 더 적합합니다. 아래 표는 주요 차이점을 요약합니다.

| 특징 | 작은 언어 모델 (SLM) | 대형 언어 모델 (LLMS) |

|---|---|---|

| 크기 | 상당히 작습니다 (100 억 미만의 매개 변수) | 훨씬 더 큰 (수십억 또는 1 조의 매개 변수) |

| 교육 데이터 | 더 작고 집중된 데이터 세트 | 거대한 다양한 데이터 세트 |

| 훈련 시간 | 짧은 (주) | 더 긴 (개월) |

| 자원 | 낮은 계산 요구 사항 | 높은 계산 요구 사항 |

| 작업 능력 | 전문화 된 작업 | 범용 작업 |

| 추론 | 에지 장치에서 실행할 수 있습니다 | 일반적으로 강력한 GPU가 필요합니다 |

| 응답 시간 | 더 빠르게 | 느리게 |

| 비용 | 낮추다 | 더 높은 |

SLM 구축 : 기술 및 예제

이 섹션은 LLM에서 SLM을 만드는 데 사용되는 방법을 자세히 설명합니다.

그런 다음이 기사는 LLAMA 2, Microsoft Phi, Qwen 2, Gemma 2 및 Mistral 7B를 포함한 여러 최첨단 SLM을 자세히 비교하여 고유 한 기능과 성능 벤치 마크를 강조합니다.

Google Colab에서 Ollama와 함께 SLM을 실행합니다

실용 가이드는 Ollama를 사용하여 Google Colab에서 SLM을 실행하여 설치, 모델 선택 및 신속한 실행을위한 코드 스 니펫을 제공하는 방법을 보여줍니다. 이 기사는 다른 모델의 출력을 보여 주어 샘플 작업에서 성능을 직접 비교할 수 있습니다.

결론과 FAQ

이 기사는 SLM의 장점과 다양한 응용 프로그램에 대한 적합성을 요약함으로써 마무리됩니다. 자주 묻는 질문 섹션은 SLM, 지식 증류 및 가지 치기와 양자화의 차이에 대한 일반적인 쿼리를 다룹니다. 주요 테이크 아웃은 SLM이 효율성과 성능 사이의 균형을 강조하여 개발자와 비즈니스를위한 귀중한 도구를 제공합니다.

위 내용은 작은 언어 모델의 성능 평가의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!