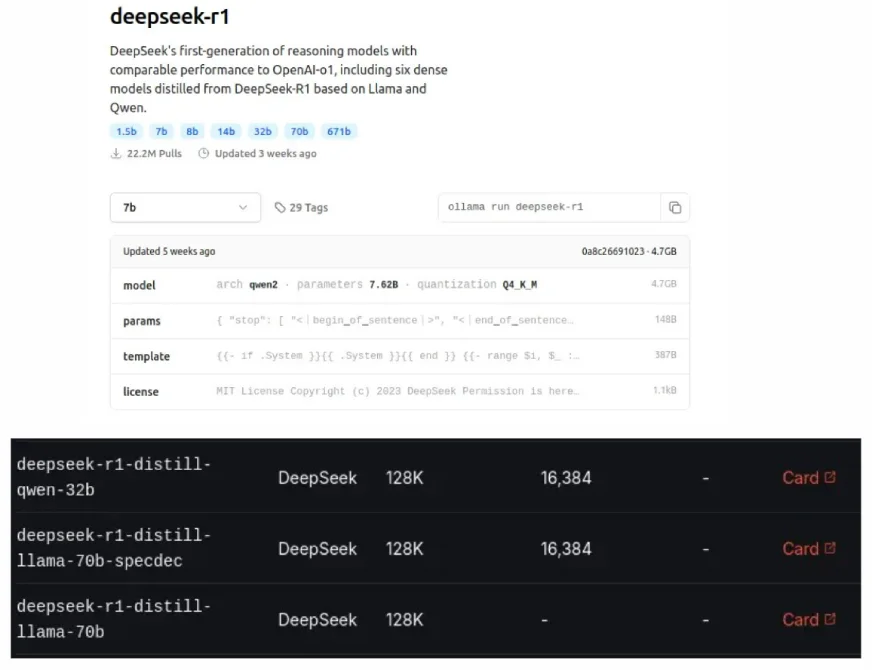

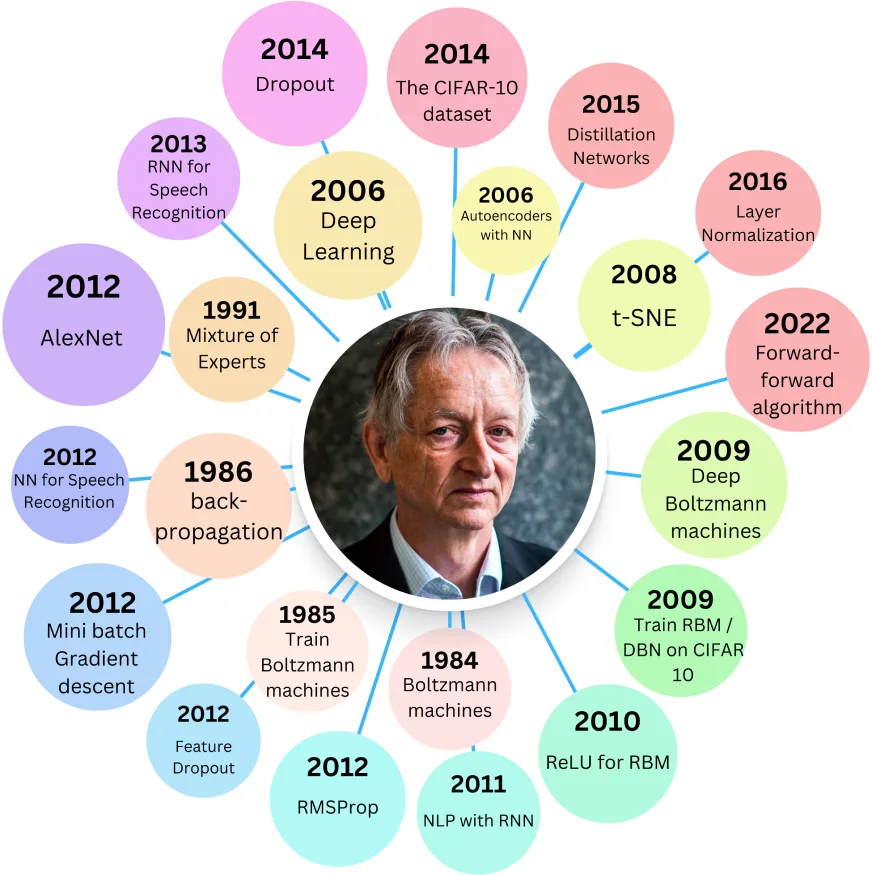

Ollama 및 Groq Cloud에서도 볼 수있는 Deepseek의 증류 모델은 더 적은 리소스를 사용하면서 더 큰 모델의 성능과 일치하도록 설계된 더 작고 효율적인 LLM 버전입니다. 모델 압축의 형태 인이 "증류"프로세스는 2015 년 Geoffrey Hinton이 도입했습니다.

목차 :

증류 모델의 이점 :

관련 : DeepSeek R1 증류 모델로 AI 추론을위한 헝겊 시스템 구축

증류 모델의 기원 :

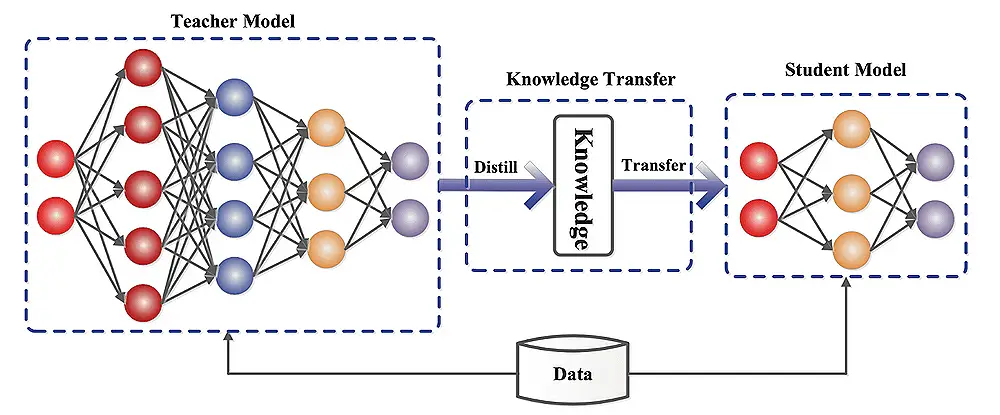

Hinton의 2015 년 논문 인 "신경망의 지식을 증류"하면서 대형 신경망을 더 작은 지식 보존 버전으로 압축했습니다. 더 큰 "교사"모델은 더 작은 "학생"모델을 훈련시켜 학생이 교사의 주요 학습 된 무게를 복제하도록 목표로합니다.

학생은 두 가지 목표에 대한 오류를 최소화함으로써 지상 진실 (단단한 목표)과 교사의 예측 (소프트 목표)에 대한 오류를 최소화함으로써 배웁니다.

이중 손실 구성 요소 :

총 손실은 파라미터 λ (Lambda)로 제어되는 이러한 손실의 가중 합입니다. 온도 매개 변수 (t)로 수정 된 SoftMax 함수는 확률 분포를 부드럽게하여 학습을 향상시킵니다. 소프트 손실에이를 보완하기 위해 T²에 곱합니다.

Distilbert 및 DistillGpt2 :

Distilbert는 Cosine Embedding 손실과 함께 Hinton의 방법을 사용합니다. Bert-Base보다 상당히 작지만 약간의 정확도 감소가 있습니다. DistillGPT2는 GPT-2보다 빠르지 만 큰 텍스트 데이터 세트에서 더 높은 당황 (성능)을 보여줍니다.

LLM 증류 구현 :

여기에는 데이터 준비, 교사 모델 선택 및 포옹 페이스 트랜스포머, Tensorflow 모델 최적화, Pytorch Distiller 또는 DeepSpeed와 같은 프레임 워크를 사용한 증류 프로세스가 포함됩니다. 평가 지표에는 정확도, 추론 속도, 모델 크기 및 자원 활용이 포함됩니다.

모델 증류 이해 :

학생 모델은 단순화 된 교사 모델이거나 다른 아키텍처를 가질 수 있습니다. 증류 과정은 학생이 예측의 차이를 최소화함으로써 교사의 행동을 모방하도록 훈련시킵니다.

도전과 한계 :

모델 증류의 향후 방향 :

실제 응용 프로그램 :

결론:

증류 모델은 성능과 효율성 사이의 귀중한 균형을 제공합니다. 원래 모델을 능가하지는 않지만 자원 요구 사항을 줄이면 다양한 응용 프로그램에서 매우 유익합니다. 증류 모델과 원본 사이의 선택은 허용 가능한 성능 트레이드 오프 및 사용 가능한 계산 리소스에 따라 다릅니다.

위 내용은 증류 모델이란 무엇입니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!