Python은 Baidu Encyclopedia 데이터를 크롤링합니다.

크롤링 전략

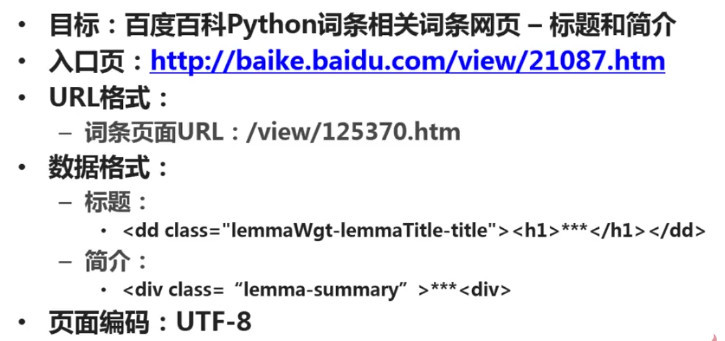

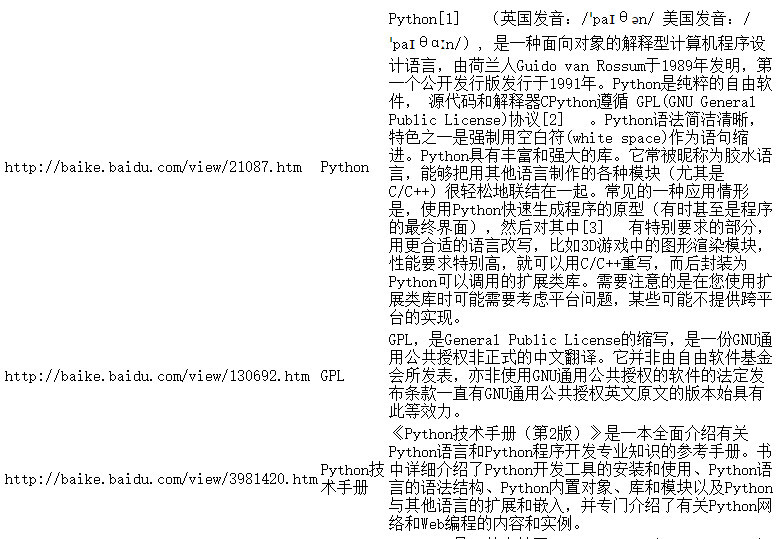

목표 결정: 어느 웹사이트의 어느 페이지 데이터 중 어느 부분을 크롤링할지 결정합니다. 바이두백과사전 파이썬 항목 페이지와 파이썬 관련 항목 페이지의 제목과 소개를 캡쳐한 예시입니다.

분석 목표: 크롤링할 URL의 형식을 분석하고 크롤링 범위를 제한합니다. 캡처할 데이터의 형식을 분석합니다. 이 예에서는 제목과 소개라는 두 가지 데이터가 위치한 태그의 형식을 분석해야 합니다. 크롤링할 페이지 인코딩의 형식을 분석하십시오. 웹 페이지 구문 분석기 섹션에서 올바른 구문 분석을 수행하기 전에 웹 페이지 인코딩을 지정해야 합니다.

코드 작성: 웹페이지 파서 부분에서는 대상을 분석하여 얻은 결과를 활용해야 합니다.

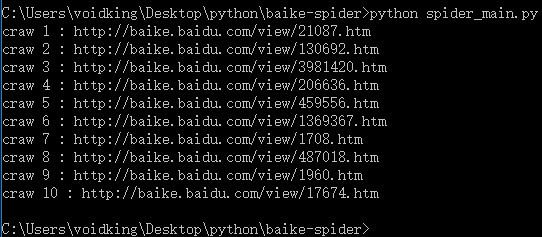

크롤러 실행: 데이터 캡처를 수행합니다.

분석 목표

1. URL 형식

Baidu Encyclopedia Python 항목 페이지에 들어가세요. 페이지의 관련 항목에 대한 링크는 대부분 /view/xxx.htm입니다.

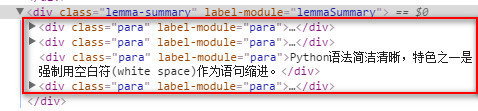

2. 데이터 형식

제목은 lemmaWgt-lemmaTitle-title 클래스 아래 h1 하위 태그에 위치하고, 소개는 클래스 lemma-summary 아래에 위치합니다.

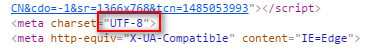

3. 인코딩 형식

페이지 인코딩 형식인 utf-8을 확인하세요.

위 분석 결과는 다음과 같습니다.

코드 작성

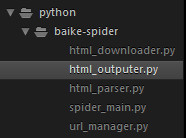

프로젝트 구조

sublime에서 프로젝트 루트 디렉터리로 baike-spider라는 새 폴더를 만듭니다.

크롤러 마스터 스케줄러로 새 spider_main.py를 만듭니다.

URL 관리자로 새 url_manger.py를 만듭니다.

html 다운로더로 새 html_downloader.py를 만듭니다.

html 파서로 새 html_parser.py를 만듭니다.

데이터 쓰기 도구로 새 html_outputer.py를 만듭니다.

최종 프로젝트 구조는 다음과 같습니다.

spider_main.py

# coding:utf-8

import url_manager, html_downloader, html_parser, html_outputer

class SpiderMain(object):

def __init__(self):

self.urls = url_manager.UrlManager()

self.downloader = html_downloader.HtmlDownloader()

self.parser = html_parser.HtmlParser()

self.outputer = html_outputer.HtmlOutputer()

def craw(self, root_url):

count = 1

self.urls.add_new_url(root_url)

while self.urls.has_new_url():

try:

new_url = self.urls.get_new_url()

print('craw %d : %s' % (count, new_url))

html_cont = self.downloader.download(new_url)

new_urls, new_data = self.parser.parse(new_url, html_cont)

self.urls.add_new_urls(new_urls)

self.outputer.collect_data(new_data)

if count == 10:

break

count = count + 1

except:

print('craw failed')

self.outputer.output_html()

if __name__=='__main__':

root_url = 'http://baike.baidu.com/view/21087.htm'

obj_spider = SpiderMain()

obj_spider.craw(root_url)url_manger.py

# coding:utf-8 class UrlManager(object): def __init__(self): self.new_urls = set() self.old_urls = set() def add_new_url(self, url): if url is None: return if url not in self.new_urls and url not in self.old_urls: self.new_urls.add(url) def add_new_urls(self, urls): if urls is None or len(urls) == 0: return for url in urls: self.add_new_url(url) def has_new_url(self): return len(self.new_urls) != 0 def get_new_url(self): new_url = self.new_urls.pop() self.old_urls.add(new_url) return new_url

html_downloader.py

# coding:utf-8 import urllib.request class HtmlDownloader(object): def download(self, url): if url is None: return None response = urllib.request.urlopen(url) if response.getcode() != 200: return None return response.read()

html_parser.py

# coding:utf-8

from bs4 import BeautifulSoup

import re

from urllib.parse import urljoin

class HtmlParser(object):

def _get_new_urls(self, page_url, soup):

new_urls = set()

# /view/123.htm

links = soup.find_all('a', href=re.compile(r'/view/\d+\.htm'))

for link in links:

new_url = link['href']

new_full_url = urljoin(page_url, new_url)

# print(new_full_url)

new_urls.add(new_full_url)

#print(new_urls)

return new_urls

def _get_new_data(self, page_url, soup):

res_data = {}

# url

res_data['url'] = page_url

# <dd class="lemmaWgt-lemmaTitle-title"> <h1>Python</h1>

title_node = soup.find('dd', class_='lemmaWgt-lemmaTitle-title').find('h1')

res_data['title'] = title_node.get_text()

# <p class="lemma-summary" label-module="lemmaSummary">

summary_node = soup.find('p', class_='lemma-summary')

res_data['summary'] = summary_node.get_text()

# print(res_data)

return res_data

def parse(self, page_url, html_cont):

if page_url is None or html_cont is None:

return

soup = BeautifulSoup(html_cont, 'html.parser')

# print(soup.prettify())

new_urls = self._get_new_urls(page_url, soup)

new_data = self._get_new_data(page_url, soup)

# print('mark')

return new_urls, new_datahtml_outputer.py

# coding:utf-8

class HtmlOutputer(object):

def __init__(self):

self.datas = []

def collect_data(self, data):

if data is None:

return

self.datas.append(data)

def output_html(self):

fout = open('output.html','w', encoding='utf-8')

fout.write('<html>')

fout.write('<body>')

fout.write('<table>')

for data in self.datas:

fout.write('<tr>')

fout.write('<td>%s</td>' % data['url'])

fout.write('<td>%s</td>' % data['title'])

fout.write('<td>%s</td>' % data['summary'])

fout.write('</tr>')

fout.write('</table>')

fout.write('</body>')

fout.write('</html>')

fout.close()실행

명령줄에서 python spider_main.py을 실행하세요.

인코딩 문제

문제 설명: UnicodeEncodeError: 'gbk' 코덱이 위치에 'xa0' 문자를 인코딩할 수 없습니다...

Python을 사용하여 파일을 작성할 때 또는 네트워크 데이터 스트림을 로컬 파일에 쓸 때 대부분의 경우 이 문제가 발생합니다. 이 문제를 해결하는 방법에 대한 유사한 기사가 인터넷에 많이 있지만 이는 인코딩 및 디코딩에 지나지 않습니다. 이것이 이 문제의 실제 원인입니까? 아니요. 여러번 디코드와 인코드를 사용하고, utf8, utf-8, gbk, gb2312 등 다양한 인코딩을 시도합니다. 모든 인코딩을 시도했지만 여전히 오류가 발생하여 답답합니다.

Windows에서 Python 스크립트를 작성할 때 코딩 문제가 매우 심각합니다. 네트워크 데이터 스트림을 파일에 쓸 때 다음과 같은 여러 인코딩을 만나게 됩니다:

1. #encoding='XXX'

여기서 인코딩(즉, Python 파일의 첫 번째 줄의 내용)은 Python을 나타냅니다. script 파일 자체의 인코딩은 중요하지 않습니다. XXX의 인코딩과 파일 자체가 동일하다면 괜찮습니다.

예를 들어 notepad++의 "형식" 메뉴에서 다양한 인코딩을 설정할 수 있습니다. 이 경우 메뉴에서 설정한 인코딩이 XXX 인코딩과 동일한지 확인해야 합니다. 보고됩니다.

2. 네트워크 데이터 스트림의 인코딩

예를 들어 웹 페이지를 얻은 경우 네트워크 데이터 스트림의 인코딩은 웹 페이지의 인코딩입니다. 유니코드 인코딩으로 디코딩하려면 디코드를 사용해야 합니다.

3. 대상 파일의 인코딩

네트워크 데이터 스트림을 새 파일에 씁니다. 파일 작성 코드는 다음과 같습니다.

fout = open('output.html','w')

fout.write(str)Windows에서는 새 파일의 기본 인코딩입니다. gbk, python 인터프리터는 네트워크 데이터 스트림 str을 구문 분석하기 위해 gbk 인코딩을 사용합니다. 그러나 str은 디코딩된 유니코드 인코딩이므로 구문 분석이 불가능하고 위의 문제가 발생합니다. 해결책은 대상 파일의 인코딩을 변경하는 것입니다:

fout = open('output.html','w', encoding='utf-8')运行结果

更多Python抓取百度百科数据 相关文章请关注PHP中文网!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7729

7729

15

15

1643

1643

14

14

1397

1397

52

52

1290

1290

25

25

1233

1233

29

29

PHP와 Python : 다른 패러다임이 설명되었습니다

Apr 18, 2025 am 12:26 AM

PHP와 Python : 다른 패러다임이 설명되었습니다

Apr 18, 2025 am 12:26 AM

PHP는 주로 절차 적 프로그래밍이지만 객체 지향 프로그래밍 (OOP)도 지원합니다. Python은 OOP, 기능 및 절차 프로그래밍을 포함한 다양한 패러다임을 지원합니다. PHP는 웹 개발에 적합하며 Python은 데이터 분석 및 기계 학습과 같은 다양한 응용 프로그램에 적합합니다.

PHP와 Python 중에서 선택 : 가이드

Apr 18, 2025 am 12:24 AM

PHP와 Python 중에서 선택 : 가이드

Apr 18, 2025 am 12:24 AM

PHP는 웹 개발 및 빠른 프로토 타이핑에 적합하며 Python은 데이터 과학 및 기계 학습에 적합합니다. 1.PHP는 간단한 구문과 함께 동적 웹 개발에 사용되며 빠른 개발에 적합합니다. 2. Python은 간결한 구문을 가지고 있으며 여러 분야에 적합하며 강력한 라이브러리 생태계가 있습니다.

Python vs. JavaScript : 학습 곡선 및 사용 편의성

Apr 16, 2025 am 12:12 AM

Python vs. JavaScript : 학습 곡선 및 사용 편의성

Apr 16, 2025 am 12:12 AM

Python은 부드러운 학습 곡선과 간결한 구문으로 초보자에게 더 적합합니다. JavaScript는 가파른 학습 곡선과 유연한 구문으로 프론트 엔드 개발에 적합합니다. 1. Python Syntax는 직관적이며 데이터 과학 및 백엔드 개발에 적합합니다. 2. JavaScript는 유연하며 프론트 엔드 및 서버 측 프로그래밍에서 널리 사용됩니다.

Windows 8에서 코드를 실행할 수 있습니다

Apr 15, 2025 pm 07:24 PM

Windows 8에서 코드를 실행할 수 있습니다

Apr 15, 2025 pm 07:24 PM

VS 코드는 Windows 8에서 실행될 수 있지만 경험은 크지 않을 수 있습니다. 먼저 시스템이 최신 패치로 업데이트되었는지 확인한 다음 시스템 아키텍처와 일치하는 VS 코드 설치 패키지를 다운로드하여 프롬프트대로 설치하십시오. 설치 후 일부 확장은 Windows 8과 호환되지 않을 수 있으며 대체 확장을 찾거나 가상 시스템에서 새로운 Windows 시스템을 사용해야합니다. 필요한 연장을 설치하여 제대로 작동하는지 확인하십시오. Windows 8에서는 VS 코드가 가능하지만 더 나은 개발 경험과 보안을 위해 새로운 Windows 시스템으로 업그레이드하는 것이 좋습니다.

PHP와 Python : 그들의 역사에 깊은 다이빙

Apr 18, 2025 am 12:25 AM

PHP와 Python : 그들의 역사에 깊은 다이빙

Apr 18, 2025 am 12:25 AM

PHP는 1994 년에 시작되었으며 Rasmuslerdorf에 의해 개발되었습니다. 원래 웹 사이트 방문자를 추적하는 데 사용되었으며 점차 서버 측 스크립팅 언어로 진화했으며 웹 개발에 널리 사용되었습니다. Python은 1980 년대 후반 Guidovan Rossum에 의해 개발되었으며 1991 년에 처음 출시되었습니다. 코드 가독성과 단순성을 강조하며 과학 컴퓨팅, 데이터 분석 및 기타 분야에 적합합니다.

Python에서 비주얼 스튜디오 코드를 사용할 수 있습니다

Apr 15, 2025 pm 08:18 PM

Python에서 비주얼 스튜디오 코드를 사용할 수 있습니다

Apr 15, 2025 pm 08:18 PM

VS 코드는 파이썬을 작성하는 데 사용될 수 있으며 파이썬 애플리케이션을 개발하기에 이상적인 도구가되는 많은 기능을 제공합니다. 사용자는 다음을 수행 할 수 있습니다. Python 확장 기능을 설치하여 코드 완료, 구문 강조 및 디버깅과 같은 기능을 얻습니다. 디버거를 사용하여 코드를 단계별로 추적하고 오류를 찾아 수정하십시오. 버전 제어를 위해 git을 통합합니다. 코드 서식 도구를 사용하여 코드 일관성을 유지하십시오. 라인 도구를 사용하여 잠재적 인 문제를 미리 발견하십시오.

터미널 VSCODE에서 프로그램을 실행하는 방법

Apr 15, 2025 pm 06:42 PM

터미널 VSCODE에서 프로그램을 실행하는 방법

Apr 15, 2025 pm 06:42 PM

vs 코드에서는 다음 단계를 통해 터미널에서 프로그램을 실행할 수 있습니다. 코드를 준비하고 통합 터미널을 열어 코드 디렉토리가 터미널 작업 디렉토리와 일치하는지 확인하십시오. 프로그래밍 언어 (예 : Python의 Python Your_file_name.py)에 따라 실행 명령을 선택하여 성공적으로 실행되는지 여부를 확인하고 오류를 해결하십시오. 디버거를 사용하여 디버깅 효율을 향상시킵니다.

VScode 확장자가 악의적입니까?

Apr 15, 2025 pm 07:57 PM

VScode 확장자가 악의적입니까?

Apr 15, 2025 pm 07:57 PM

VS 코드 확장은 악의적 인 코드 숨기기, 취약성 악용 및 합법적 인 확장으로 자위하는 등 악성 위험을 초래합니다. 악의적 인 확장을 식별하는 방법에는 게시자 확인, 주석 읽기, 코드 확인 및주의해서 설치가 포함됩니다. 보안 조치에는 보안 인식, 좋은 습관, 정기적 인 업데이트 및 바이러스 백신 소프트웨어도 포함됩니다.