머리말

최근 발견된 무료 프록시 IP 웹사이트를 예로 들어보겠습니다: http://www.xicidaili.com/nn/. 사용해 보니 많은 IP를 사용할 수 없다는 것을 알았습니다.

그래서 저는 사용 가능한 프록시 IP를 감지할 수 있는 스크립트를 Python으로 작성했습니다.

스크립트는 다음과 같습니다.

#encoding=utf8

import urllib2

from bs4 import BeautifulSoup

import urllib

import socket

User_Agent = 'Mozilla/5.0 (Windows NT 6.3; WOW64; rv:43.0) Gecko/20100101 Firefox/43.0'

header = {}

header['User-Agent'] = User_Agent

'''

获取所有代理IP地址

'''

def getProxyIp():

proxy = []

for i in range(1,2):

try:

url = 'http://www.xicidaili.com/nn/'+str(i)

req = urllib2.Request(url,headers=header)

res = urllib2.urlopen(req).read()

soup = BeautifulSoup(res)

ips = soup.findAll('tr')

for x in range(1,len(ips)):

ip = ips[x]

tds = ip.findAll("td")

ip_temp = tds[1].contents[0]+"\t"+tds[2].contents[0]

proxy.append(ip_temp)

except:

continue

return proxy

'''

验证获得的代理IP地址是否可用

'''

def validateIp(proxy):

url = "http://ip.chinaz.com/getip.aspx"

f = open("E:\ip.txt","w")

socket.setdefaulttimeout(3)

for i in range(0,len(proxy)):

try:

ip = proxy[i].strip().split("\t")

proxy_host = "http://"+ip[0]+":"+ip[1]

proxy_temp = {"http":proxy_host}

res = urllib.urlopen(url,proxies=proxy_temp).read()

f.write(proxy[i]+'\n')

print proxy[i]

except Exception,e:

continue

f.close()

if __name__ == '__main__':

proxy = getProxyIp()

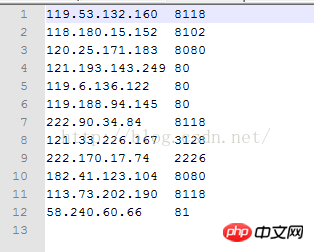

validateIp(proxy)성공적으로 실행한 후 E 드라이브에 있는 파일을 열면 됩니다. 다음의 사용 가능한 프록시 IP 주소 및 포트를 참조하세요.

요약

이것은 첫 페이지에 불과합니다. IP 주소를 크롤링하는 데 필요한 경우 몇 페이지를 더 크롤링할 수 있습니다. 동시에 웹사이트는 수시로 업데이트되므로 크롤링 시 처음 몇 페이지만 크롤링하는 것이 좋습니다. 위의 내용이 이 글의 전체 내용입니다. Python을 배우는 모든 사람에게 도움이 되기를 바랍니다.

Python 크롤링에 사용할 수 있는 프록시 IP와 관련된 더 많은 기사를 보려면 PHP 중국어 웹사이트를 주목하세요!