Python 크롤러로 캡처한 데이터를 PDF로 변환

이 기사에서는 Python 크롤러를 사용하여 "Liao Xuefeng의 Python 튜토리얼"을 PDF로 변환하는 방법과 코드를 공유합니다. 필요한 친구는 이를 참조할 수 있습니다.

크롤러를 작성하는 것은 사용하는 것보다 쉽지 않은 것 같습니다. 파이썬 맞습니다. 파이썬 커뮤니티에서 제공하는 크롤러 도구가 너무 많아서 직접 사용할 수 있는 다양한 라이브러리를 사용하면 몇 분 안에 크롤러를 작성할 수 있습니다. Liao Xuefeng의 Python 튜토리얼 누구나 오프라인에서 읽을 수 있는 PDF 전자책을 만드세요.

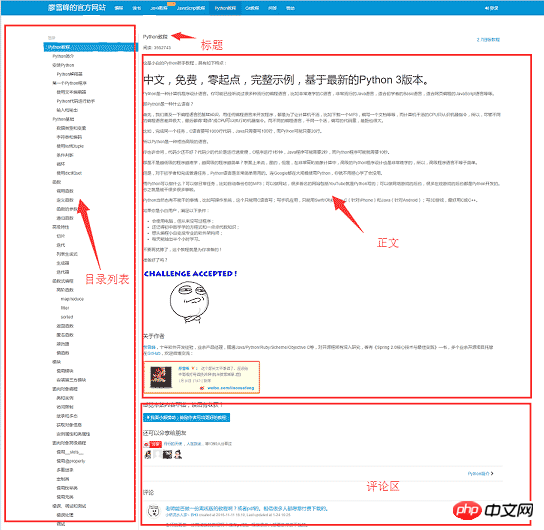

크롤러 작성을 시작하기 전에 먼저 웹사이트의 페이지 구조를 분석해 보겠습니다. 1. 웹 페이지의 왼쪽은 튜토리얼의 디렉토리 개요이며, 위쪽은 각 URL에 해당합니다. 오른쪽은 기사의 제목이고, 가운데는 기사의 텍스트 부분이고, 텍스트 내용은 우리가 관심을 두는 부분이고, 크롤링하려는 데이터는 모든 웹페이지의 텍스트 부분이고, 아래는 사용자의 댓글 영역입니다. , 댓글 영역은 우리에게 쓸모가 없으므로 무시해도 됩니다.

도구 준비

웹사이트의 기본 구조를 파악한 후 크롤러가 의존하는 도구 키트 준비를 시작할 수 있습니다. 에. 요청과 beautulsoup이 크롤러의 두 아티팩트인 경우reuqests는 네트워크 요청에 사용되고 beautifusoup는 html 데이터를 작동하는 데 사용됩니다. 이 두 개의 셔틀을 사용하면 작업을 빠르게 수행할 수 있습니다. 작은 프로그램에서 스크래피처럼 사용하는 것은 과도한 작업과 같습니다. 또한 html 파일을 pdf로 변환하려면 해당 라이브러리 지원도 있어야 합니다. wkhtmltopdf는 여러 플랫폼에서 html을 pdf로 변환하는 데 사용할 수 있는 매우 좋은 도구입니다. wkhtmltopdf의 Python 패키지. 먼저 다음 종속성 패키지를 설치한 다음 wkhtmltopdf

pip install requests pip install beautifulsoup pip install pdfkit

Windows 플랫폼을 wkhtmltopdf 공식에 직접 설치합니다. 웹 사이트 2 안정 버전을 다운로드하여 설치합니다. 설치가 완료된 후 프로그램의 실행 경로를 시스템 환경 $PATH

변수에 추가합니다. 그렇지 않으면 pdfkit이 wkhtmltopdf를 찾을 수 없으며 "wkhtmltopdf 실행 파일을 찾을 수 없습니다"라는 오류가 발생합니다. "가 나타납니다. Ubuntu 및 CentOS는 명령줄을 사용하여 직접 설치할 수 있습니다$ sudo apt-get install wkhtmltopdf # ubuntu

$ sudo yum intsall wkhtmltopdf # centos

모든 것이 준비되면 코딩을 시작할 수 있지만 그 전에 생각을 정리해야 합니다. 코드 작성 . 이 프로그램의 목적은 모든 URL에 해당하는 HTML 텍스트 부분을 로컬에 저장한 다음 pdfkit을 사용하여 이러한 파일을 pdf 파일로 변환하는 것입니다. 작업을 분할해 보겠습니다. 먼저 특정 URL에 해당하는 html 텍스트를 로컬에 저장한 다음 모든 URL을 찾아 동일한 작업을 수행합니다.

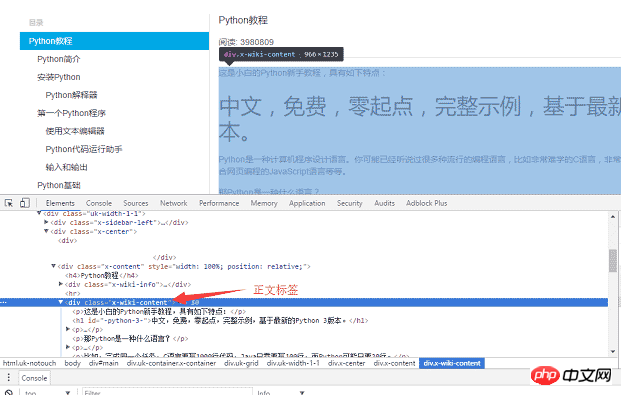

Chrome 브라우저를 사용하여 페이지의 본문 부분에서 태그를 찾고, F12를 눌러 본문에 해당하는 p 태그를 찾습니다.

, 여기서 p는 웹페이지의 본문 내용입니다. 요청을 사용하여 전체 페이지를 로컬로 로드한 후 beautifulsoup를 사용하여 HTML dom 요소를 작동하여 텍스트 콘텐츠를 추출할 수 있습니다.<p >

구체적인 구현 코드는 다음과 같습니다. 수프.find_all  함수

함수

를 사용하여 body 태그를 찾은 후 body 부분의 내용을 a에 저장합니다. .html 파일. def parse_url_to_html(url):

response = requests.get(url)

soup = BeautifulSoup(response.content, "html5lib")

body = soup.find_all(class_="x-wiki-content")[0]

html = str(body)

with open("a.html", 'wb') as f:

f.write(html)

<ul >

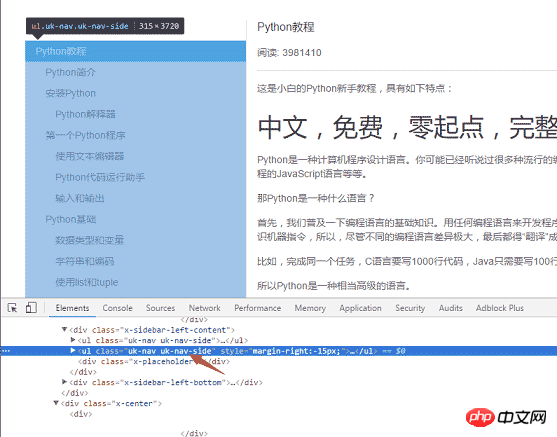

특정 코드 구현 논리: uk-nav 및 uk-nav 측 클래스가 두 개 있기 때문입니다. 페이지

특정 코드 구현 논리: uk-nav 및 uk-nav 측 클래스가 두 개 있기 때문입니다. 페이지

이며 실제 디렉토리 목록은 두 번째입니다. 모든 URL을 얻었고, 첫 번째 단계에서 URL을 HTML로 변환하는 기능이 작성되었습니다. def get_url_list():

"""

获取所有URL目录列表

"""

response = requests.get("http://www.liaoxuefeng.com/wiki/0014316089557264a6b348958f449949df42a6d3a2e542c000")

soup = BeautifulSoup(response.content, "html5lib")

menu_tag = soup.find_all(class_="uk-nav uk-nav-side")[1]

urls = []

for li in menu_tag.find_all("li"):

url = "http://www.liaoxuefeng.com" + li.a.get('href')

urls.append(url)

return urls

def save_pdf(htmls):

"""

把所有html文件转换成pdf文件

"""

options = {

'page-size': 'Letter',

'encoding': "UTF-8",

'custom-header': [

('Accept-Encoding', 'gzip')

]

}

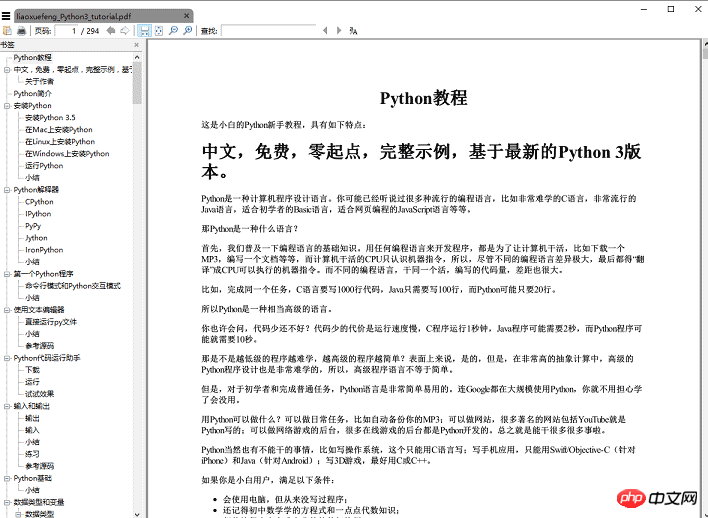

pdfkit.from_file(htmls, file_name, options=options)함수만 호출하면 전자책 pdf 파일이 생성됩니다. . 렌더링:

총 코드 양은 50줄 미만이지만, 실제로는 위에 제공된 코드는 기사 제목을 가져오는 방법과 같은 일부 세부 정보를 생략합니다. 텍스트 콘텐츠의 img 태그는 상대 경로를 사용합니다. PDF에서

그림을 정상적으로 표시하려면 상대경로를 절대경로로 변경하고 저장해야 합니다. 임시 html 파일은 삭제해야 하며, 이 내용은 모두 github에 게시되어 있습니다. 【관련 추천】

위 내용은 Python 크롤러로 캡처한 데이터를 PDF로 변환의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7488

7488

15

15

1377

1377

52

52

77

77

11

11

51

51

19

19

19

19

40

40

MySQL은 지불해야합니다

Apr 08, 2025 pm 05:36 PM

MySQL은 지불해야합니다

Apr 08, 2025 pm 05:36 PM

MySQL에는 무료 커뮤니티 버전과 유료 엔터프라이즈 버전이 있습니다. 커뮤니티 버전은 무료로 사용 및 수정할 수 있지만 지원은 제한되어 있으며 안정성이 낮은 응용 프로그램에 적합하며 기술 기능이 강합니다. Enterprise Edition은 안정적이고 신뢰할 수있는 고성능 데이터베이스가 필요하고 지원 비용을 기꺼이 지불하는 응용 프로그램에 대한 포괄적 인 상업적 지원을 제공합니다. 버전을 선택할 때 고려 된 요소에는 응용 프로그램 중요도, 예산 책정 및 기술 기술이 포함됩니다. 완벽한 옵션은없고 가장 적합한 옵션 만 있으므로 특정 상황에 따라 신중하게 선택해야합니다.

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

이 기사는 MySQL 데이터베이스의 작동을 소개합니다. 먼저 MySQLworkBench 또는 명령 줄 클라이언트와 같은 MySQL 클라이언트를 설치해야합니다. 1. MySQL-Uroot-P 명령을 사용하여 서버에 연결하고 루트 계정 암호로 로그인하십시오. 2. CreateABase를 사용하여 데이터베이스를 작성하고 데이터베이스를 선택하십시오. 3. CreateTable을 사용하여 테이블을 만들고 필드 및 데이터 유형을 정의하십시오. 4. InsertInto를 사용하여 데이터를 삽입하고 데이터를 쿼리하고 업데이트를 통해 데이터를 업데이트하고 DELETE를 통해 데이터를 삭제하십시오. 이러한 단계를 마스터하고 일반적인 문제를 처리하는 법을 배우고 데이터베이스 성능을 최적화하면 MySQL을 효율적으로 사용할 수 있습니다.

MySQL은 인터넷이 필요합니까?

Apr 08, 2025 pm 02:18 PM

MySQL은 인터넷이 필요합니까?

Apr 08, 2025 pm 02:18 PM

MySQL은 기본 데이터 저장 및 관리를위한 네트워크 연결없이 실행할 수 있습니다. 그러나 다른 시스템과의 상호 작용, 원격 액세스 또는 복제 및 클러스터링과 같은 고급 기능을 사용하려면 네트워크 연결이 필요합니다. 또한 보안 측정 (예 : 방화벽), 성능 최적화 (올바른 네트워크 연결 선택) 및 데이터 백업은 인터넷에 연결하는 데 중요합니다.

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

MySQL 데이터베이스 성능 최적화 안내서 리소스 집약적 응용 프로그램에서 MySQL 데이터베이스는 중요한 역할을 수행하며 대규모 트랜잭션 관리를 담당합니다. 그러나 응용 프로그램 규모가 확장됨에 따라 데이터베이스 성능 병목 현상은 종종 제약이됩니다. 이 기사는 일련의 효과적인 MySQL 성능 최적화 전략을 탐색하여 응용 프로그램이 고 부하에서 효율적이고 반응이 유지되도록합니다. 실제 사례를 결합하여 인덱싱, 쿼리 최적화, 데이터베이스 설계 및 캐싱과 같은 심층적 인 주요 기술을 설명합니다. 1. 데이터베이스 아키텍처 설계 및 최적화 된 데이터베이스 아키텍처는 MySQL 성능 최적화의 초석입니다. 몇 가지 핵심 원칙은 다음과 같습니다. 올바른 데이터 유형을 선택하고 요구 사항을 충족하는 가장 작은 데이터 유형을 선택하면 저장 공간을 절약 할 수있을뿐만 아니라 데이터 처리 속도를 향상시킬 수 있습니다.

hadidb : 파이썬의 가볍고 수평 확장 가능한 데이터베이스

Apr 08, 2025 pm 06:12 PM

hadidb : 파이썬의 가볍고 수평 확장 가능한 데이터베이스

Apr 08, 2025 pm 06:12 PM

HADIDB : 가볍고 높은 수준의 확장 가능한 Python 데이터베이스 HadIDB (HADIDB)는 파이썬으로 작성된 경량 데이터베이스이며 확장 수준이 높습니다. PIP 설치를 사용하여 HADIDB 설치 : PIPINSTALLHADIDB 사용자 관리 사용자 만들기 사용자 : createUser () 메소드를 작성하여 새 사용자를 만듭니다. Authentication () 메소드는 사용자의 신원을 인증합니다. Fromhadidb.operationimportuseruser_obj = user ( "admin", "admin") user_obj.

MongoDB 데이터베이스 비밀번호를 보는 Navicat의 방법

Apr 08, 2025 pm 09:39 PM

MongoDB 데이터베이스 비밀번호를 보는 Navicat의 방법

Apr 08, 2025 pm 09:39 PM

해시 값으로 저장되기 때문에 MongoDB 비밀번호를 Navicat을 통해 직접 보는 것은 불가능합니다. 분실 된 비밀번호 검색 방법 : 1. 비밀번호 재설정; 2. 구성 파일 확인 (해시 값이 포함될 수 있음); 3. 코드를 점검하십시오 (암호 하드 코드 메일).

MySQL Workbench가 Mariadb에 연결할 수 있습니다

Apr 08, 2025 pm 02:33 PM

MySQL Workbench가 Mariadb에 연결할 수 있습니다

Apr 08, 2025 pm 02:33 PM

MySQL Workbench는 구성이 올바른 경우 MariadB에 연결할 수 있습니다. 먼저 커넥터 유형으로 "mariadb"를 선택하십시오. 연결 구성에서 호스트, 포트, 사용자, 비밀번호 및 데이터베이스를 올바르게 설정하십시오. 연결을 테스트 할 때는 마리아드 브 서비스가 시작되었는지, 사용자 이름과 비밀번호가 올바른지, 포트 번호가 올바른지, 방화벽이 연결을 허용하는지 및 데이터베이스가 존재하는지 여부를 확인하십시오. 고급 사용에서 연결 풀링 기술을 사용하여 성능을 최적화하십시오. 일반적인 오류에는 불충분 한 권한, 네트워크 연결 문제 등이 포함됩니다. 오류를 디버깅 할 때 오류 정보를 신중하게 분석하고 디버깅 도구를 사용하십시오. 네트워크 구성을 최적화하면 성능이 향상 될 수 있습니다

MySQL에는 서버가 필요합니까?

Apr 08, 2025 pm 02:12 PM

MySQL에는 서버가 필요합니까?

Apr 08, 2025 pm 02:12 PM

생산 환경의 경우 성능, 신뢰성, 보안 및 확장 성을 포함한 이유로 서버는 일반적으로 MySQL을 실행해야합니다. 서버에는 일반적으로보다 강력한 하드웨어, 중복 구성 및 엄격한 보안 조치가 있습니다. 소규모 저하 애플리케이션의 경우 MySQL이 로컬 컴퓨터에서 실행할 수 있지만 자원 소비, 보안 위험 및 유지 보수 비용은 신중하게 고려되어야합니다. 신뢰성과 보안을 높이려면 MySQL을 클라우드 또는 기타 서버에 배포해야합니다. 적절한 서버 구성을 선택하려면 응용 프로그램 부하 및 데이터 볼륨을 기반으로 평가가 필요합니다.