前言

说到python,对它有点耳闻的人,第一反应可能都是爬虫~

这两天看了点python的皮毛知识,忍不住想写一个简单的爬虫练练手,JUST DO IT

准备工作

要制作数据抓取的爬虫,对请求的源页面结构需要有特定分析,只有分析正确了,才能更好更快的爬到我们想要的内容。

浏览器访问570973/,右键“查看源代码”,初步只想取一些简单的数据(文章标题、作者、发布时间等),在HTML源码中找到相关数据的部分:

1)标题(url):

3) 출시 시간: 게시일 2017-06-06 14:53

4) 현재 뉴스 ID:

물론 단서를 따라가려면 "이전 글"과 "다음 글" 링크의 구조가 매우 중요하지만 제가 찾아낸 것은 문제, 페이지에 있는 두 개의 태그와 해당 링크 및 텍스트 콘텐츠가 js를 통해 렌더링됩니다. 정보를 찾아보십시오(파이썬은 js 등을 실행합니다). 그러나 파이썬 초보자에게는 조금 앞서 있을 수 있으므로 다른 해결책을 찾을 계획입니다.

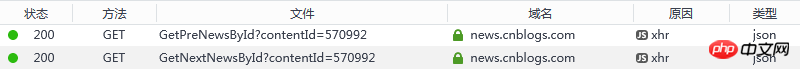

이 두 링크는 js를 통해 렌더링되지만 이론적으로 js가 콘텐츠를 렌더링할 수 있는 이유는 요청을 시작하고 응답을 받아야 하기 때문입니다. 그렇다면 웹 페이지 로딩 프로세스를 모니터링할 수 있는지 확인할 수 있습니까? 정보가 있나요? 크롬/파이어폭스 등의 브라우저에 엄지손가락을 치켜세우고 싶습니다. 개발자 도구/네트워크는 모든 리소스의 요청 및 응답 상태를 명확하게 볼 수 있습니다.

요청 주소는 다음과 같습니다:

1) 이전 뉴스 ID:

2) 다음 뉴스 ID:

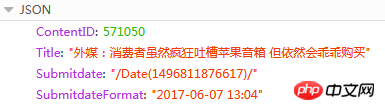

응답 콘텐츠는 JSON입니다.

여기서 ContentID가 필요합니다. 예, 알 수 있습니다. 보도 자료의 페이지 주소는 고정된 형식이기 때문에 이 값을 기반으로 하는 현재 뉴스의 이전 또는 다음 뉴스 URL: {{ContentID}}/ (빨간색 내용은 대체 가능한 ID입니다. )

Tools

1) python 3.6 (pip 설치와 환경변수 추가)

2) PyCharm 2017.1.3

3) 아니요. 타사 Python 라이브러리( 설치: cmd -> pip 설치 이름)

a) pyperclip: 클립보드를 읽고 쓰는 데 사용됩니다.

b) 요청: urllib 기반의 HTTP 라이브러리 및 Apache2 라이센스 오픈 소스 프로토콜 사용. urllib보다 더 편리하고 많은 작업을 절약할 수 있습니다

c) beautifulsoup4: Beautifulsoup는 탐색, 검색, 구문 분석 트리 수정 및 기타 기능을 처리하는 몇 가지 간단한 Python 스타일 기능을 제공합니다. 문서를 파싱하여 사용자가 캡처해야 하는 데이터를 제공하는 도구 상자입니다

소스 코드

개인적으로 코드는 매우 기본적이고 이해하기 쉽다고 생각합니다(결국 초보자는 고급 코드를 작성하지 마세요) ), 질문이나 제안 사항이 있으면 언제든지 알려주세요

#! python3

# coding = utf-8

# get_cnblogs_news.py

# 根据博客园内的任意一篇新闻,获取所有新闻(标题、发布时间、发布人)

#

# 这是标题格式 :<div id="news_title"><a href="//news.cnblogs.com/n/570973/">SpaceX重复使用的“龙”飞船成功与国际空间站对接</a></div>

# 这是发布人格式 :<span class="news_poster">投递人 <a href="//home.cnblogs.com/u/34358/">itwriter</a></span>

# 这是发布时间格式 :<span class="time">发布于 2017-06-06 14:53</span>

# 当前新闻ID :<input type="hidden" value="570981" id="lbContentID">

# html中获取不到上一篇和下一篇的直接链接,因为它是使用ajax请求后期渲染的

# 需要另外请求地址,获取结果,JSON

# 上一篇

# 下一篇

# 响应内容

# ContentID : 570971

# Title : "Mac支持外部GPU VR开发套件售599美元"

# Submitdate : "/Date(1425445514)"

# SubmitdateFormat : "2017-06-06 14:47"

import sys, pyperclip

import requests, bs4

import json

# 解析并打印(标题、作者、发布时间、当前ID)

# soup : 响应的HTML内容经过bs4转化的对象

def get_info(soup):

dict_info = {'curr_id': '', 'author': '', 'time': '', 'title': '', 'url': ''}

titles = soup.select('div#news_title > a')

if len(titles) > 0:

dict_info['title'] = titles[0].getText()

dict_info['url'] = titles[0].get('href')

authors = soup.select('span.news_poster > a')

if len(authors) > 0:

dict_info['author'] = authors[0].getText()

times = soup.select('span.time')

if len(times) > 0:

dict_info['time'] = times[0].getText()

content_ids = soup.select('input#lbContentID')

if len(content_ids) > 0:

dict_info['curr_id'] = content_ids[0].get('value')

# 写文件

with open('D:/cnblognews.csv', 'a') as f:

text = '%s,%s,%s,%s\n' % (dict_info['curr_id'], (dict_info['author'] + dict_info['time']), dict_info['url'], dict_info['title'])

print(text)

f.write(text)

return dict_info['curr_id']

# 获取前一篇文章信息

# curr_id : 新闻ID

# loop_count : 向上多少条,如果为0,则无限向上,直至结束

def get_prev_info(curr_id, loop_count = 0):

private_loop_count = 0

try:

while loop_count == 0 or private_loop_count < loop_count:

res_prev = requests.get('https://news.cnblogs.com/NewsAjax/GetPreNewsById?contentId=' + curr_id)

res_prev.raise_for_status()

res_prev_dict = json.loads(res_prev.text)

prev_id = res_prev_dict['ContentID']

res_prev = requests.get('https://news.cnblogs.com/n/%s/' % prev_id)

res_prev.raise_for_status()

soup_prev = bs4.BeautifulSoup(res_prev.text, 'html.parser')

curr_id = get_info(soup_prev)

private_loop_count += 1

except:

pass

# 获取下一篇文章信息

# curr_id : 新闻ID

# loop_count : 向下多少条,如果为0,则无限向下,直至结束

def get_next_info(curr_id, loop_count = 0):

private_loop_count = 0

try:

while loop_count == 0 or private_loop_count < loop_count:

res_next = requests.get('https://news.cnblogs.com/NewsAjax/GetNextNewsById?contentId=' + curr_id)

res_next.raise_for_status()

res_next_dict = json.loads(res_next.text)

next_id = res_next_dict['ContentID']

res_next = requests.get('https://news.cnblogs.com/n/%s/' % next_id)

res_next.raise_for_status()

soup_next = bs4.BeautifulSoup(res_next.text, 'html.parser')

curr_id = get_info(soup_next)

private_loop_count += 1

except:

pass

# 参数从优先从命令行获取,如果无,则从剪切板获取

# url是博客园新闻版块下,任何一篇新闻

if len(sys.argv) > 1:

url = sys.argv[1]

else:

url = pyperclip.paste()

# 没有获取到有地址,则抛出异常

if not url:

raise ValueError

# 开始从源地址中获取新闻内容

res = requests.get(url)

res.raise_for_status()

if not res.text:

raise ValueError

#解析Html

soup = bs4.BeautifulSoup(res.text, 'html.parser')

curr_id = get_info(soup)

print('backward...')

get_prev_info(curr_id)

print('forward...')

get_next_info(curr_id)

print('done')

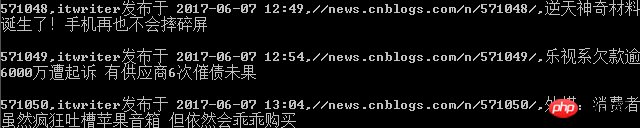

실행

위의 소스 코드를 D:/get_cnblogs_news.py에 저장하고 Windows 플랫폼에서 명령줄 도구 cmd를 엽니다.

py.exe D:/get_cnblogs_news 명령을 입력합니다. py Enter

분석: py.exe는 설명할 필요가 없습니다. 두 번째 매개변수는 Python 스크립트 파일이고, 세 번째 매개변수는 크롤링해야 할 소스 페이지입니다(코드에 복사하면 또 다른 고려 사항이 있습니다). 이 URL을 시스템 클립보드에 직접 실행할 수 있는 경우: py.exe D:/get_cnblogs_news.py

명령줄 출력 인터페이스(인쇄)

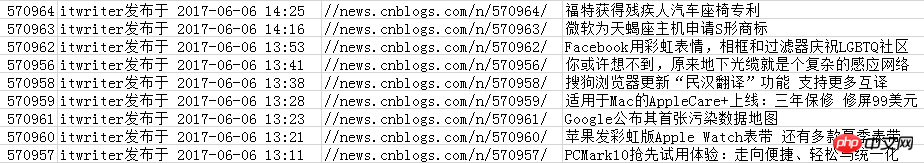

csv 파일에 저장된 콘텐츠

추천 초보자를 위한 Python 학습 책 상자 또는 정보:

1) 매우 기본적이고 이해하기 쉬운 Liao Xuefeng의 Python 튜토리얼:

2) Python 프로그래밍을 빠르게 시작하여 지루한 작업을 자동화하세요.pdf

이 글은 파이썬을 직접 배우기 위한 글입니다. 오해의 소지가 있는 내용이 있으면 비판하고 정정해 주시기 바랍니다. (마음에 들지 않으면 비난하지 마세요.) 도움이 되셨다면 영광입니다.

위 내용은 블로그 공원 뉴스를 캡처하는 Python 학습의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!