이 글은 주로 Python urllib 크롤링 Baidu 클라우드 연결의 예제 코드를 소개합니다. 관심 있는 친구들이 참고할 수 있습니다.

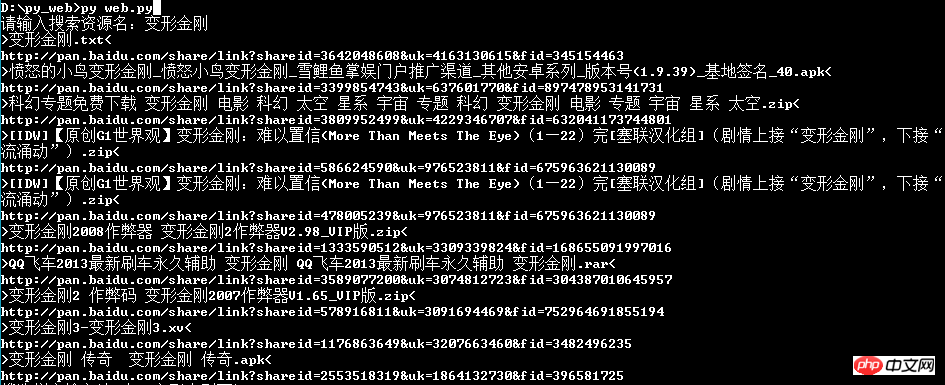

제가 이전에 작성한 프로그램을 살펴보니 제가 크롤링 디스크 Duoduo Baidu Cloud를 작성한 것을 발견했습니다. 제가 트랜스포머를 보고 싶었을 때 리소스는 제가 직접 작성했습니다. 처음으로 Python을 접하게 되었는데, 이 프로그램을 만드는 데 약 2일이 걸렸고, Python 언어를 배우고 코드 작성을 볼 수 있습니다. 그때는 정말 낮습니다. 지금은 별로 좋지는 않지만 ㅎㅎ 아직 배우는 중이라 자세한 설명은 생략하겠습니다. 변수 선언이 무엇인지 잊어버렸기 때문에(수동 오만함) 위 그림에 코드가 나와 있습니다. 그땐 파일 쓰는 법도 몰랐는데 ㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋ 클래스가 init로 초기화되는 줄도 몰랐네요 아아, 파이썬을 배우면서 참 많은 걸 배웠네요

from bs4 import BeautifulSoup

import urllib

import requests

import re

adr =[]

''''对搜素资源名字进行url编码'''

search_text =raw_input('请输入搜索资源名:')

search_text = search_text.decode('gbk')

search_text = search_text.encode('utf-8')

search_text = urllib.quote(search_text)

''''获取文件地址'''

home = urllib.urlopen('http://www.panduoduo.net/s/name/'+search_text)

'''获取百度云地址'''

def getbaidu(adr):

for i in adr:

url = urllib.urlopen('http://www.panduoduo.net'+i)

bs = BeautifulSoup(url)

bs1 = bs.select('.dbutton2')

href = re.compile('http\%(\%|\d|\w|\/\/|\/|\.)*')

b = href.search(str(bs1))

name = str(bs.select('.center')).decode('utf-8')

text1 = re.compile('\<h1\sclass\=\"center"\>[\d|\w|\D|\W]*\</h1\>')

text2 = text1.search(name)

rag1 = re.compile('\>[\d|\w|\D|\W]*\<')

if text2:

text3 = rag1.search(text2.group())

if text3:

print text3.group()

if b:

text = urllib.unquote(str(b.group())).decode('utf-8')

print text

'''初始化'''

def init(adr):

soup = BeautifulSoup(home)

soup = soup.select('.row')

pattern = re.compile('\/r\/\d+')

for i in soup:

i = str(i)

adress = pattern.search(i)

adress = adress.group()

adr.append(adress)

print 'running---------'

init(adr)

getbaidu(adr)위 내용은 Python에서 Baidu Cloud 연결 방법을 크롤링하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!