Python에서 K-평균 알고리즘 구현

K-평균은 기계 학습에서 일반적으로 사용되는 알고리즘입니다. 데이터 클러스터링에 자주 사용되는 알고리즘으로 데이터를 여러 범주로 자동 집계하기만 하면 됩니다. 한 클러스터에 있는 데이터의 유사성은 높고, 다른 클러스터에 있는 데이터의 유사성은 낮습니다.

K-MEANS 알고리즘은 k개의 클러스터 수와 n개의 데이터 객체가 포함된 데이터베이스를 입력하고 최소 분산 기준을 충족하는 k개의 클러스터를 출력하는 알고리즘입니다. k-평균 알고리즘은 입력 수량 k를 받아들인 다음 n개의 데이터 개체를 k개의 클러스터로 나누어 얻은 클러스터가 다음을 충족하도록 합니다. 동일한 클러스터에 있는 개체의 유사성은 더 높고 다른 클러스터에 있는 개체의 유사성은 더 작습니다. 이 기사에서는 Python에서 K-평균 알고리즘을 구현하는 방법을 소개합니다.

핵심 아이디어

k개 클러스터에 대한 분할 방식을 반복적으로 찾아 해당 k개 클러스터의 평균을 사용하여 해당 유형의 샘플을 나타낼 때 얻는 전체 오류가 최소화됩니다.

k 클러스터는 다음과 같은 특징을 가지고 있습니다. 각 클러스터 자체는 최대한 컴팩트하며 각 클러스터는 최대한 분리되어 있습니다.

k-평균 알고리즘은 최소 오류 제곱합 기준을 기반으로 합니다. K-menas의 장점과 단점:

장점:

간단한 원리

빠른 속도

대규모 데이터 세트에 대한 확장성이 비교적 좋습니다.

단점:

군집 수를 지정해야 함 K

이상값에 민감함

초기값에 민감함

K-평균의 군집화 과정

군집화 과정은 경사하강법과 유사 알고리즘 확립 비용 함수 및 반복을 통해 비용 함수 값을 점점 더 작게 만듭니다

c개 클래스의 초기 중심을 적절하게 선택합니다.

k번째 반복에서 모든 샘플에 대해 c 중심까지의 거리를 구하고, 가장 짧은 거리를 가진 중심이 위치한 클래스로 샘플을 분류합니다.

평균과 같은 방법을 사용하여 클래스의 중심 값을 업데이트합니다.

모든 c 클러스터 중심에 대해 반복 방법을 사용하여 업데이트한 후에도 값이 변경되지 않은 경우; (2) (3), 반복이 종료되고, 그렇지 않으면 반복이 계속됩니다.

이 알고리즘의 가장 큰 장점은 단순성과 속도입니다. 알고리즘의 핵심은 초기 중심과 거리 공식을 선택하는 데 있습니다.

K-수단 예제는 Python에서 km의 일부 매개변수를 보여줍니다.

sklearn.cluster.KMeans( n_clusters=8, init='k-means++', n_init=10, max_iter=300, tol=0.0001, precompute_distances='auto', verbose=0, random_state=None, copy_x=True, n_jobs=1, algorithm='auto' ) n_clusters: 簇的个数,即你想聚成几类 init: 初始簇中心的获取方法 n_init: 获取初始簇中心的更迭次数,为了弥补初始质心的影响,算法默认会初始10个质心,实现算法,然后返回最好的结果。 max_iter: 最大迭代次数(因为kmeans算法的实现需要迭代) tol: 容忍度,即kmeans运行准则收敛的条件 precompute_distances:是否需要提前计算距离,这个参数会在空间和时间之间做权衡,如果是True 会把整个距离矩阵都放到内存中,auto 会默认在数据样本大于featurs*samples 的数量大于12e6 的时候False,False 时核心实现的方法是利用Cpython 来实现的 verbose: 冗长模式(不太懂是啥意思,反正一般不去改默认值) random_state: 随机生成簇中心的状态条件。 copy_x: 对是否修改数据的一个标记,如果True,即复制了就不会修改数据。bool 在scikit-learn 很多接口中都会有这个参数的,就是是否对输入数据继续copy 操作,以便不修改用户的输入数据。这个要理解Python 的内存机制才会比较清楚。 n_jobs: 并行设置 algorithm: kmeans的实现算法,有:'auto', ‘full', ‘elkan', 其中 ‘full'表示用EM方式实现 虽然有很多参数,但是都已经给出了默认值。所以我们一般不需要去传入这些参数,参数的。可以根据实际需要来调用。

from sklearn.cluster import KMeans from sklearn.externals import joblib from sklearn import cluster import numpy as np # 生成10*3的矩阵 data = np.random.rand(10,3) print data # 聚类为4类 estimator=KMeans(n_clusters=4) # fit_predict表示拟合+预测,也可以分开写 res=estimator.fit_predict(data) # 预测类别标签结果 lable_pred=estimator.labels_ # 各个类别的聚类中心值 centroids=estimator.cluster_centers_ # 聚类中心均值向量的总和 inertia=estimator.inertia_ print lable_pred print centroids print inertia 代码执行结果 [0 2 1 0 2 2 0 3 2 0] [[ 0.3028348 0.25183096 0.62493622] [ 0.88481287 0.70891813 0.79463764] [ 0.66821961 0.54817207 0.30197415] [ 0.11629904 0.85684903 0.7088385 ]] 0.570794546829

50차원

1000000개 항목

50차원

수백만 개의 데이터에 대해 피팅 시간은 여전히 허용되며 효율성도 여전히 좋다는 것을 알 수 있습니다. 모델은 다른 기계 학습 알고리즘 모델을 저장하는 것과 유사합니다

from sklearn.cluster import KMeans

from sklearn.externals import joblib

from sklearn import cluster

import numpy as np

import matplotlib.pyplot as plt

data = np.random.rand(100,2)

estimator=KMeans(n_clusters=3)

res=estimator.fit_predict(data)

lable_pred=estimator.labels_

centroids=estimator.cluster_centers_

inertia=estimator.inertia_

#print res

print lable_pred

print centroids

print inertia

for i in range(len(data)):

if int(lable_pred[i])==0:

plt.scatter(data[i][0],data[i][1],color='red')

if int(lable_pred[i])==1:

plt.scatter(data[i][0],data[i][1],color='black')

if int(lable_pred[i])==2:

plt.scatter(data[i][0],data[i][1],color='blue')

plt.show()| k-평균 클러스터링 알고리즘을 사용하여 그림의 기본 색상을 식별합니다. | ||

|---|---|---|

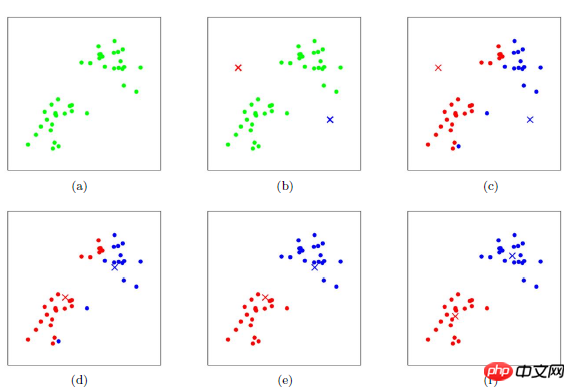

| K-평균 이해 이미지를 통한 알고리즘 |

위 내용은 Python에서 K-평균 알고리즘 구현의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7486

7486

15

15

1377

1377

52

52

77

77

11

11

51

51

19

19

19

19

39

39

MySQL은 지불해야합니다

Apr 08, 2025 pm 05:36 PM

MySQL은 지불해야합니다

Apr 08, 2025 pm 05:36 PM

MySQL에는 무료 커뮤니티 버전과 유료 엔터프라이즈 버전이 있습니다. 커뮤니티 버전은 무료로 사용 및 수정할 수 있지만 지원은 제한되어 있으며 안정성이 낮은 응용 프로그램에 적합하며 기술 기능이 강합니다. Enterprise Edition은 안정적이고 신뢰할 수있는 고성능 데이터베이스가 필요하고 지원 비용을 기꺼이 지불하는 응용 프로그램에 대한 포괄적 인 상업적 지원을 제공합니다. 버전을 선택할 때 고려 된 요소에는 응용 프로그램 중요도, 예산 책정 및 기술 기술이 포함됩니다. 완벽한 옵션은없고 가장 적합한 옵션 만 있으므로 특정 상황에 따라 신중하게 선택해야합니다.

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

이 기사는 MySQL 데이터베이스의 작동을 소개합니다. 먼저 MySQLworkBench 또는 명령 줄 클라이언트와 같은 MySQL 클라이언트를 설치해야합니다. 1. MySQL-Uroot-P 명령을 사용하여 서버에 연결하고 루트 계정 암호로 로그인하십시오. 2. CreateABase를 사용하여 데이터베이스를 작성하고 데이터베이스를 선택하십시오. 3. CreateTable을 사용하여 테이블을 만들고 필드 및 데이터 유형을 정의하십시오. 4. InsertInto를 사용하여 데이터를 삽입하고 데이터를 쿼리하고 업데이트를 통해 데이터를 업데이트하고 DELETE를 통해 데이터를 삭제하십시오. 이러한 단계를 마스터하고 일반적인 문제를 처리하는 법을 배우고 데이터베이스 성능을 최적화하면 MySQL을 효율적으로 사용할 수 있습니다.

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

MySQL 데이터베이스 성능 최적화 안내서 리소스 집약적 응용 프로그램에서 MySQL 데이터베이스는 중요한 역할을 수행하며 대규모 트랜잭션 관리를 담당합니다. 그러나 응용 프로그램 규모가 확장됨에 따라 데이터베이스 성능 병목 현상은 종종 제약이됩니다. 이 기사는 일련의 효과적인 MySQL 성능 최적화 전략을 탐색하여 응용 프로그램이 고 부하에서 효율적이고 반응이 유지되도록합니다. 실제 사례를 결합하여 인덱싱, 쿼리 최적화, 데이터베이스 설계 및 캐싱과 같은 심층적 인 주요 기술을 설명합니다. 1. 데이터베이스 아키텍처 설계 및 최적화 된 데이터베이스 아키텍처는 MySQL 성능 최적화의 초석입니다. 몇 가지 핵심 원칙은 다음과 같습니다. 올바른 데이터 유형을 선택하고 요구 사항을 충족하는 가장 작은 데이터 유형을 선택하면 저장 공간을 절약 할 수있을뿐만 아니라 데이터 처리 속도를 향상시킬 수 있습니다.

MySQL은 인터넷이 필요합니까?

Apr 08, 2025 pm 02:18 PM

MySQL은 인터넷이 필요합니까?

Apr 08, 2025 pm 02:18 PM

MySQL은 기본 데이터 저장 및 관리를위한 네트워크 연결없이 실행할 수 있습니다. 그러나 다른 시스템과의 상호 작용, 원격 액세스 또는 복제 및 클러스터링과 같은 고급 기능을 사용하려면 네트워크 연결이 필요합니다. 또한 보안 측정 (예 : 방화벽), 성능 최적화 (올바른 네트워크 연결 선택) 및 데이터 백업은 인터넷에 연결하는 데 중요합니다.

hadidb : 파이썬의 가볍고 수평 확장 가능한 데이터베이스

Apr 08, 2025 pm 06:12 PM

hadidb : 파이썬의 가볍고 수평 확장 가능한 데이터베이스

Apr 08, 2025 pm 06:12 PM

HADIDB : 가볍고 높은 수준의 확장 가능한 Python 데이터베이스 HadIDB (HADIDB)는 파이썬으로 작성된 경량 데이터베이스이며 확장 수준이 높습니다. PIP 설치를 사용하여 HADIDB 설치 : PIPINSTALLHADIDB 사용자 관리 사용자 만들기 사용자 : createUser () 메소드를 작성하여 새 사용자를 만듭니다. Authentication () 메소드는 사용자의 신원을 인증합니다. Fromhadidb.operationimportuseruser_obj = user ( "admin", "admin") user_obj.

MongoDB 데이터베이스 비밀번호를 보는 Navicat의 방법

Apr 08, 2025 pm 09:39 PM

MongoDB 데이터베이스 비밀번호를 보는 Navicat의 방법

Apr 08, 2025 pm 09:39 PM

해시 값으로 저장되기 때문에 MongoDB 비밀번호를 Navicat을 통해 직접 보는 것은 불가능합니다. 분실 된 비밀번호 검색 방법 : 1. 비밀번호 재설정; 2. 구성 파일 확인 (해시 값이 포함될 수 있음); 3. 코드를 점검하십시오 (암호 하드 코드 메일).

MySQL Workbench가 Mariadb에 연결할 수 있습니다

Apr 08, 2025 pm 02:33 PM

MySQL Workbench가 Mariadb에 연결할 수 있습니다

Apr 08, 2025 pm 02:33 PM

MySQL Workbench는 구성이 올바른 경우 MariadB에 연결할 수 있습니다. 먼저 커넥터 유형으로 "mariadb"를 선택하십시오. 연결 구성에서 호스트, 포트, 사용자, 비밀번호 및 데이터베이스를 올바르게 설정하십시오. 연결을 테스트 할 때는 마리아드 브 서비스가 시작되었는지, 사용자 이름과 비밀번호가 올바른지, 포트 번호가 올바른지, 방화벽이 연결을 허용하는지 및 데이터베이스가 존재하는지 여부를 확인하십시오. 고급 사용에서 연결 풀링 기술을 사용하여 성능을 최적화하십시오. 일반적인 오류에는 불충분 한 권한, 네트워크 연결 문제 등이 포함됩니다. 오류를 디버깅 할 때 오류 정보를 신중하게 분석하고 디버깅 도구를 사용하십시오. 네트워크 구성을 최적화하면 성능이 향상 될 수 있습니다

MySQL에는 서버가 필요합니까?

Apr 08, 2025 pm 02:12 PM

MySQL에는 서버가 필요합니까?

Apr 08, 2025 pm 02:12 PM

생산 환경의 경우 성능, 신뢰성, 보안 및 확장 성을 포함한 이유로 서버는 일반적으로 MySQL을 실행해야합니다. 서버에는 일반적으로보다 강력한 하드웨어, 중복 구성 및 엄격한 보안 조치가 있습니다. 소규모 저하 애플리케이션의 경우 MySQL이 로컬 컴퓨터에서 실행할 수 있지만 자원 소비, 보안 위험 및 유지 보수 비용은 신중하게 고려되어야합니다. 신뢰성과 보안을 높이려면 MySQL을 클라우드 또는 기타 서버에 배포해야합니다. 적절한 서버 구성을 선택하려면 응용 프로그램 부하 및 데이터 볼륨을 기반으로 평가가 필요합니다.