이번에는 쿠키 만료 시 자동 업데이트 및 자동 검색을 설정하는 노트와 만료 시 쿠키 자동 업데이트 및 자동 검색을 설정하는 방법을 소개하겠습니다. 다음은 실제 사례입니다.

이 문서에서는 쿠키 자동 획득 및 쿠키 만료 시 자동 업데이트를 구현합니다.

소셜 네트워킹 사이트의 많은 정보는 로그인이 필요합니다. 예를 들어 웨이보를 예로 들면, 로그인하지 않으면 빅 대들의 웨이보 상위 10개 게시물만 볼 수 있습니다. 로그인 상태를 유지하려면 쿠키가 필요합니다. 예를 들어 www.weibo.cn에 로그인하십시오:

Chrome에 입력: http://login.weibo.cn/login/

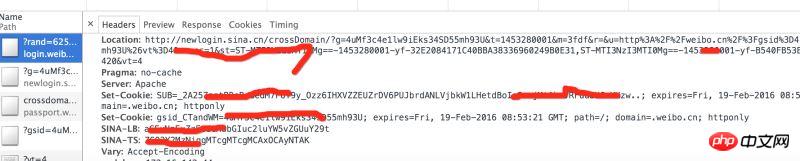

콘솔 헤더의 요청 반환을 분석하면 다음을 수행하게 됩니다. weibo.cn에 여러 세트의 반환된 쿠키가 있는지 확인하세요.

구현 단계:

1, 셀레늄을 사용하여 자동으로 로그인하여 쿠키를 얻고, 파일에 저장합니다.

2, 쿠키를 읽고, 쿠키의 유효 기간이 만료된 경우 비교합니다. 1단계를 다시 수행하세요.

3, in 다른 웹페이지를 요청할 때 로그인 상태를 유지하려면 쿠키를 입력하세요.

1. 온라인으로 쿠키 얻기

셀레늄과 PhantomJS를 사용하여 브라우저 로그인을 시뮬레이션하고 쿠키를 얻습니다.

일반적으로 여러 개의 쿠키가 있으며 쿠키는 .weibo 접미사가 있는 파일에 하나씩 저장됩니다.

def get_cookie_from_network():

from selenium import webdriver

url_login = 'http://login.weibo.cn/login/'

driver = webdriver.PhantomJS()

driver.get(url_login)

driver.find_element_by_xpath('//input[@type="text"]').send_keys('your_weibo_accout') # 改成你的微博账号

driver.find_element_by_xpath('//input[@type="password"]').send_keys('your_weibo_password') # 改成你的微博密码

driver.find_element_by_xpath('//input[@type="submit"]').click() # 点击登录

# 获得 cookie信息

cookie_list = driver.get_cookies()

print cookie_list

cookie_dict = {}

for cookie in cookie_list:

#写入文件

f = open(cookie['name']+'.weibo','w')

pickle.dump(cookie, f)

f.close()

if cookie.has_key('name') and cookie.has_key('value'):

cookie_dict[cookie['name']] = cookie['value']

return cookie_dict2, 파일에서 쿠키 가져오기

현재 디렉터리에서 .weibo로 끝나는 파일, 즉 쿠키 파일을 탐색합니다. 피클을 사용하여 dict로 압축을 풀고 만료 값을 현재 시간과 비교하고 만료되면 비어 있는 값을 반환합니다.

def get_cookie_from_cache():

cookie_dict = {}

for parent, dirnames, filenames in os.walk('./'):

for filename in filenames:

if filename.endswith('.weibo'):

print filename

with open(self.dir_temp + filename, 'r') as f:

d = pickle.load(f)

if d.has_key('name') and d.has_key('value') and d.has_key('expiry'):

expiry_date = int(d['expiry'])

if expiry_date > (int)(time.time()):

cookie_dict[d['name']] = d['value']

else:

return {}

return cookie_dict3 캐시 쿠키가 만료되면 네트워크에서 쿠키를 다시 가져옵니다.

def get_cookie(): cookie_dict = get_cookie_from_cache() if not cookie_dict: cookie_dict = get_cookie_from_network() return cookie_dict

4. 다른 Weibo 홈페이지를 요청하는 쿠키

def get_weibo_list(self, user_id):

import requests

from bs4 import BeautifulSoup as bs

cookdic = get_cookie()

url = 'http://weibo.cn/stocknews88'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/31.0.1650.57 Safari/537.36'}

timeout = 5

r = requests.get(url, headers=headers, cookies=cookdic,timeout=timeout)

soup = bs(r.text, 'lxml')

...

# 用BeautifulSoup 解析网页

...이 기사의 사례를 읽으신 후 방법을 마스터하셨다고 생각합니다. 더 흥미로운 정보를 보려면 PHP 중국어 웹사이트의 다른 관련 기사를 주목하세요!

추천 자료:

React 네이티브는 fetch를 사용하여 이미지를 업로드합니다.

압축 후 webpack으로 패키지된 파일을 더 작게 만드는 방법

위 내용은 자동 업데이트 및 자동 획득을 위해 쿠키 만료 설정의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!