스크래치에서 Python 크롤러 작성에 대한 전체 기록_python

처음 9개의 글은 기초부터 작성까지 자세하게 소개되어 있으니, 크롤러 프로그램 작성 방법을 단계별로 자세히 기록하겠습니다.

먼저 이야기해 보세요. 우리 학교 웹사이트 정보:

http://jwxt.sdu.edu.cn:7777/zhxt_bks/zhxt_bks.html

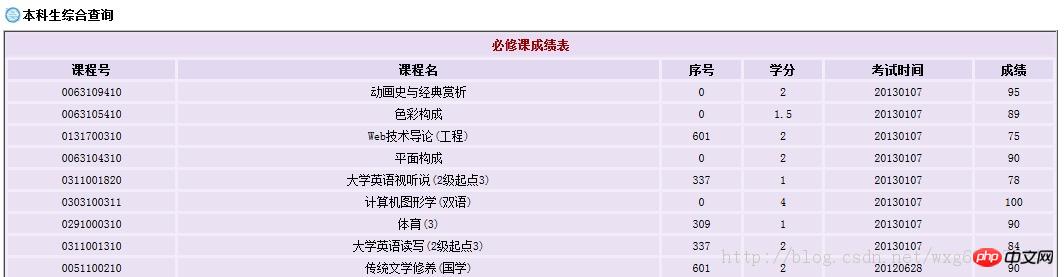

점수를 확인하려면 로그인해야 하며, 그러면 각 과목의 점수가 표시됩니다. 단, 가중평균점수인 성적은 없습니다.

물론 이렇게 수동으로 성적을 계산하는 것은 매우 번거로운 작업입니다. 따라서 우리는 Python을 사용하여 이 문제를 해결하는 크롤러를 만들 수 있습니다.

1. 결전을 앞두고

먼저 도구를 준비해보자: HttpFox 플러그인.

페이지 요청 및 응답의 시간과 내용은 물론 브라우저에서 사용하는 COOKIE를 분석하는 http 프로토콜 분석 플러그인입니다.

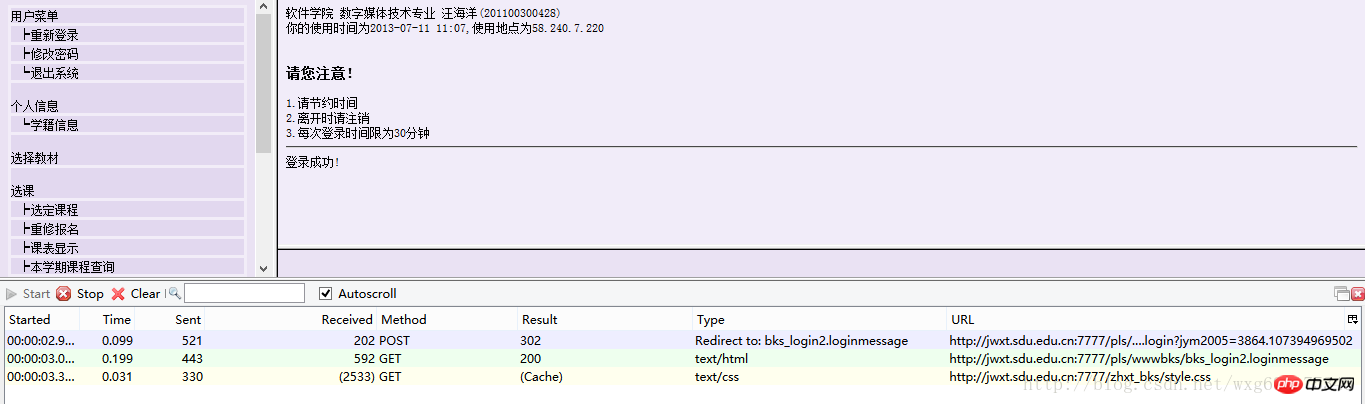

예를 들어 Firefox에 설치하면 아래와 같은 효과가 나타납니다.

해당 정보를 매우 직관적으로 볼 수 있습니다.

탐지를 시작하려면 시작을 클릭하고, 감지를 일시 중지하려면 중지를 클릭하고, 콘텐츠를 지우려면 지우기를 클릭하세요.

일반적으로 사용하기 전에 중지를 클릭하여 일시 중지한 다음 지우기를 클릭하여 화면을 지워 현재 페이지에 액세스하여 얻은 데이터를 볼 수 있는지 확인하세요.

2. 적진 깊숙이 침투하기

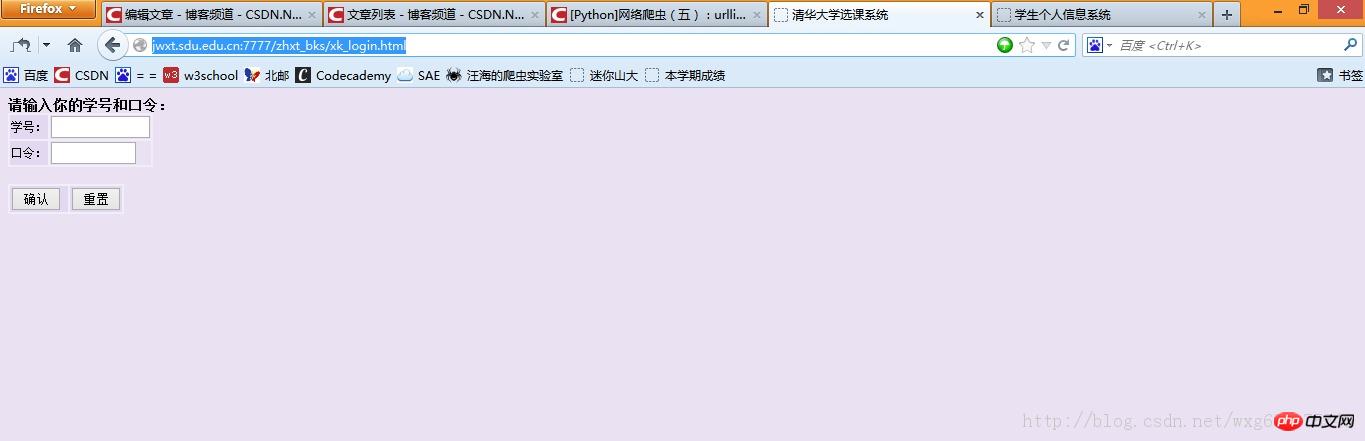

산동대학교 점수조회 사이트에 접속하여 로그인 시 어떤 정보가 전송되는지 살펴보겠습니다.

먼저 로그인 페이지로 이동하여 httpfox를 열고 이를 지운 다음 시작을 클릭하여 감지를 시작합니다.

개인 정보를 입력한 후 httpfox가 켜져 있는지 확인한 다음 확인을 클릭하여 정보를 제출하고 로그를 남깁니다. 안에.

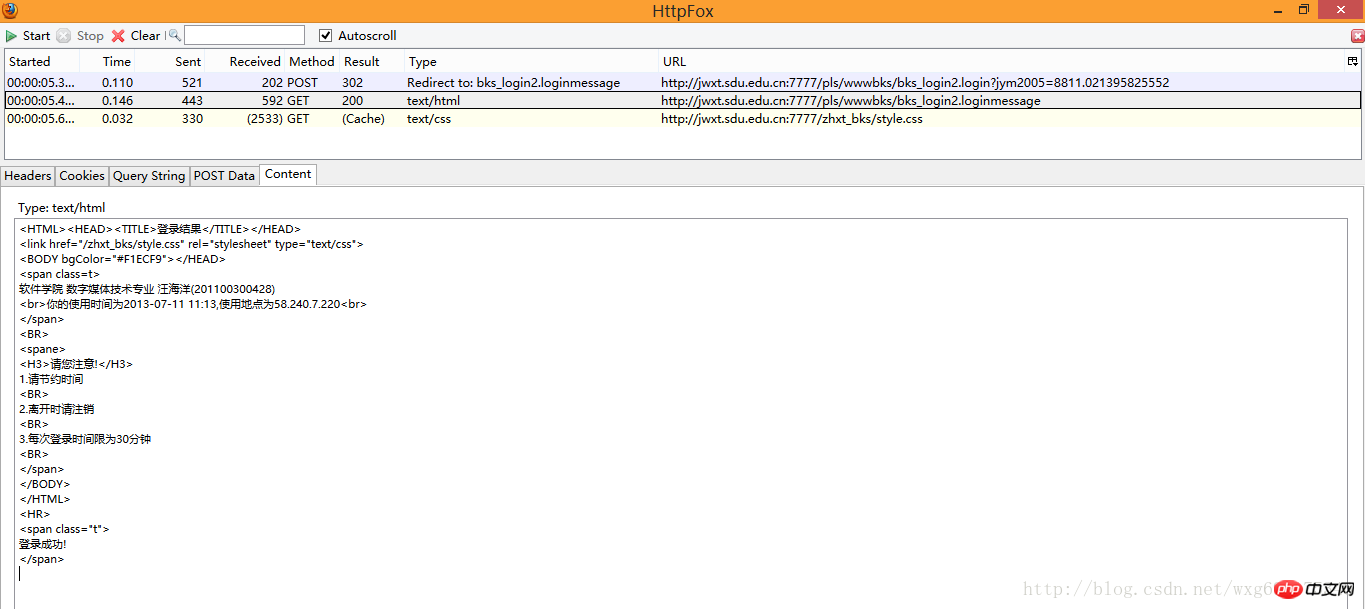

이때 httpfox가 세 가지 정보를 감지한 것을 볼 수 있습니다:

이때 중지 버튼을 클릭하여 페이지 방문 후 피드백된 데이터가 캡처되었는지 확인하여 로그인을 시뮬레이션할 수 있습니다. 크롤러를 할 때.

3.庖丁解牛

얼핏 보면 3개의 데이터가 있는데, 2개는 GET이고 하나는 POST이지만, 여전히 그 데이터가 무엇인지, 어떻게 사용하는지 모릅니다.

그래서 캡쳐한 내용을 하나씩 살펴봐야 합니다.

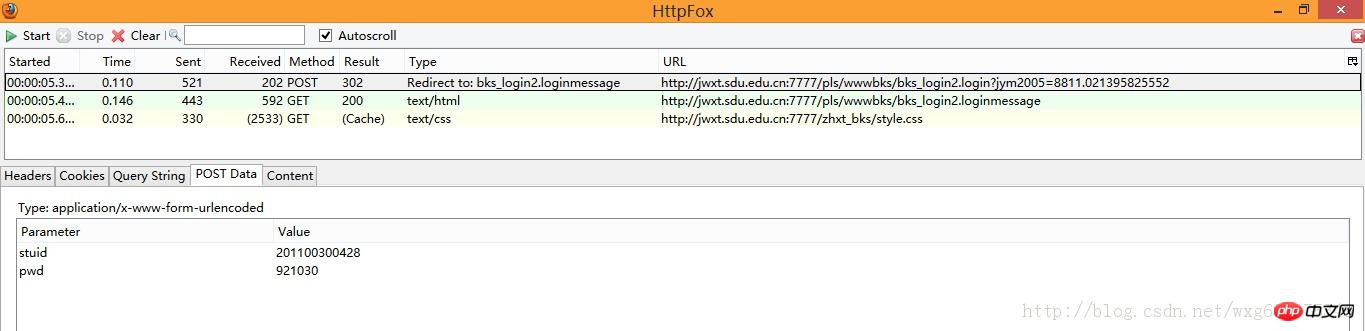

POST 정보를 먼저 살펴보겠습니다.

POST 정보이므로 PostData만 보면 됩니다.

POST 데이터에는 studid와 pwd라는 두 가지 데이터가 있는 것을 볼 수 있습니다.

그리고 Type의 Redirect to를 보면 POST가 완료된 후 bks_login2.loginmessage 페이지로 점프하는 것을 볼 수 있습니다.

이 데이터는 확인을 클릭한 후 제출한 양식 데이터임을 알 수 있습니다.

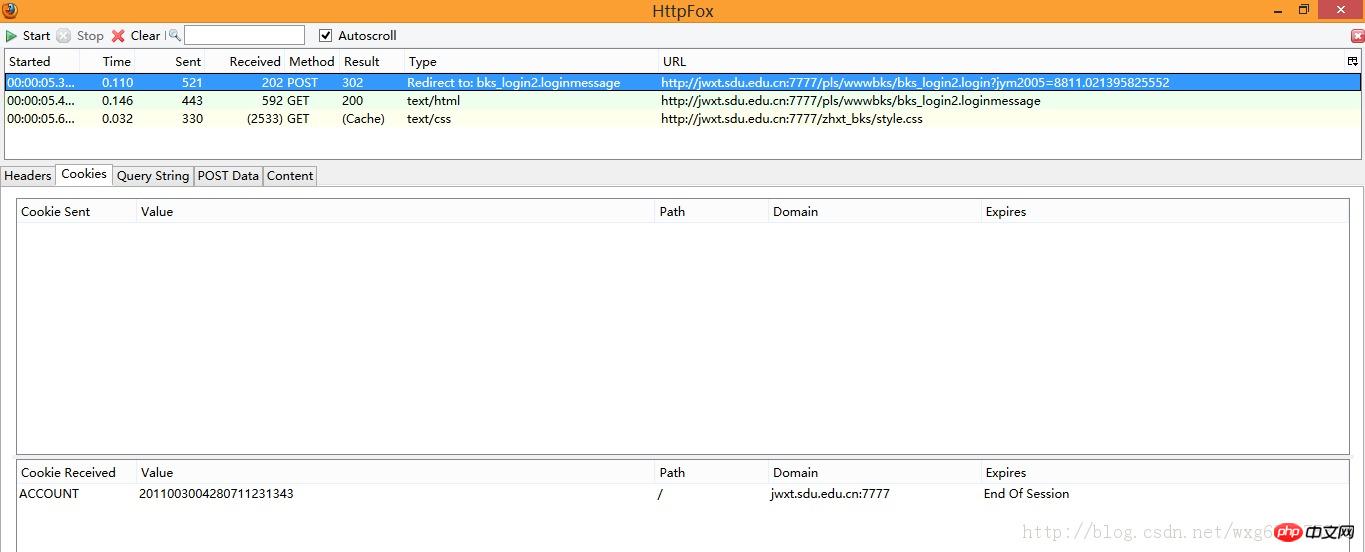

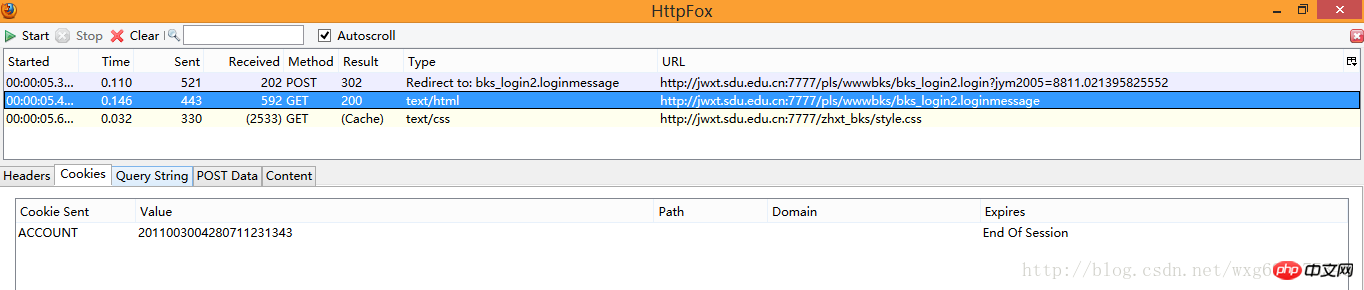

쿠키 정보를 보려면 쿠키 라벨을 클릭하세요.

예, 계정 쿠키가 수신되었으며 세션이 끝나면 자동으로 삭제됩니다.

그럼 제출 후 어떤 정보를 받으셨나요?

다음 두 개의 GET 데이터를 살펴보겠습니다.

먼저 첫 번째 내용을 살펴보겠습니다. 콘텐츠 태그를 클릭하면 받은 콘텐츠를 볼 수 있습니다. - 의심할 바 없이 HTML 소스 코드가 노출되어 있습니다:

이것은 단지 페이지의 HTML 소스 코드인 것 같습니다. 쿠키 관련 정보를 보려면 쿠키를 클릭하십시오:

아하, HTML 페이지의 원본 내용은 쿠키 정보가 전송된 후에 수신되었습니다.

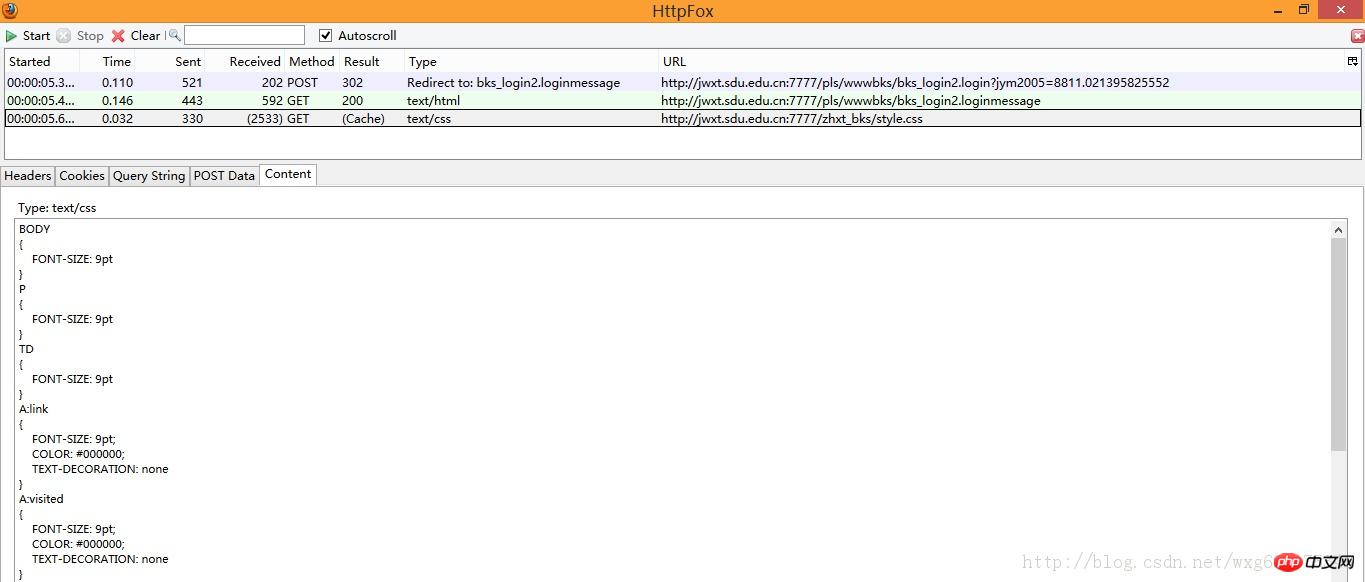

마지막으로 수신된 메시지를 살펴보겠습니다.

대략 살펴보면 style.css라는 CSS 파일일 뿐이며 이는 우리에게 큰 영향을 미치지 않습니다.

4. 침착하게 응답

이제 서버에 어떤 데이터를 보냈는지, 어떤 데이터를 받았는지 알았으니 기본 과정은 다음과 같습니다.

먼저 학생 ID와 비밀번호를 게시합니다--- > ;그런 다음 쿠키 값을 반환하고 쿠키를 서버로 보냅니다--->페이지 정보를 반환합니다. 성적 페이지에서 데이터를 얻고 정규식을 사용하여 성적과 학점을 별도로 추출하고 가중 평균을 계산합니다.

좋아요, 아주 간단한 샘플 종이처럼 보입니다. 그럼 한번 시험해 보겠습니다.

그런데 실험을 하기 전에 아직 해결되지 않은 문제가 있는데, POST 데이터는 어디로 보내지는 걸까요?

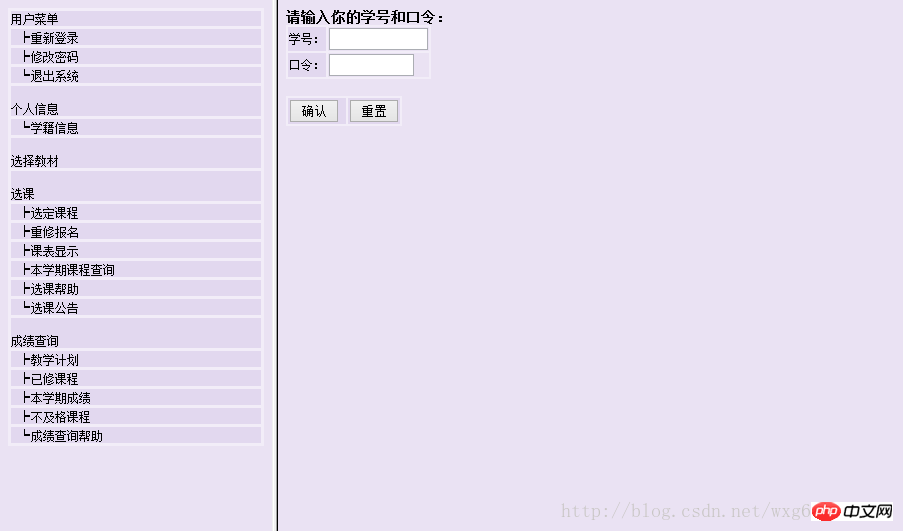

원본 페이지를 다시 보세요:

분명히 html 프레임워크를 사용하여 구현되었습니다. 즉, 주소 표시줄에 표시되는 주소는 오른쪽에 있는 양식을 제출하는 주소가 아닙니다.

실제 주소는 어떻게 알 수 있나요-. -페이지 소스 코드를 보려면 마우스 오른쪽 버튼을 클릭하세요.

예, 맞습니다. 이름이 "w_right"인 페이지가 우리가 원하는 로그인 페이지입니다.

웹사이트의 원래 주소는 다음과 같습니다:

http://jwxt.sdu.edu.cn:7777/zhxt_bks/zhxt_bks.html

따라서 실제 양식 제출 주소는 다음과 같습니다:

http://jwxt .sdu.edu.cn:7777/zhxt_bks/xk_login.html

입력한 결과 사실로 확인되었습니다.

청화대학교 수강신청 시스템으로 확인되었습니다. . . 내 생각엔 우리 학교가 페이지를 만드는 게 너무 게을러서 그냥 빌려온 것 같다. . 결과적으로 제목도 바뀌지 않았습니다. . .

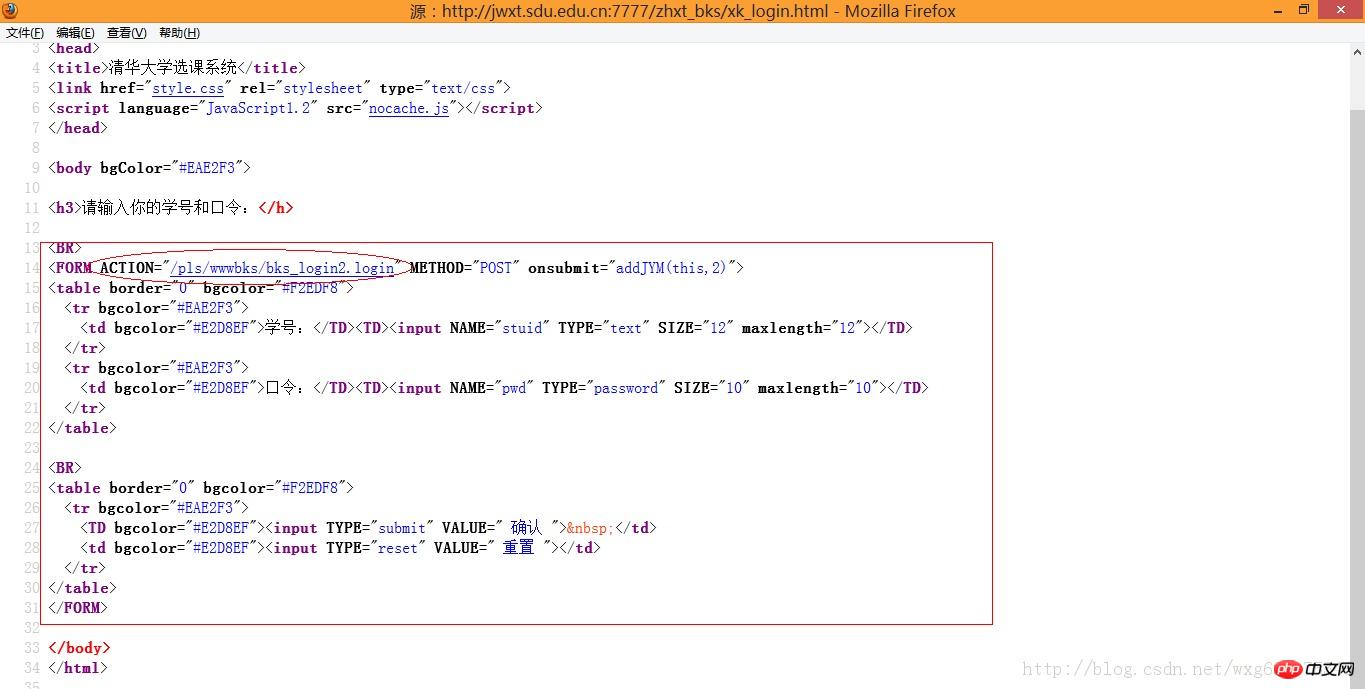

하지만 이 페이지는 여전히 우리에게 필요한 페이지가 아닙니다. 왜냐하면 POST 데이터가 제출되는 페이지는 양식의 ACTION으로 제출된 페이지여야 하기 때문입니다.

즉, POST 데이터가 전송되는 위치를 알기 위해 소스 코드를 확인해야 합니다.

시각적으로 이것은 POST 데이터가 제출되는 주소입니다.

주소 표시줄에 정리하세요. 전체 주소는 다음과 같아야 합니다.

http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bks_login2.login

(얻는 방법은 다음과 같습니다. 아주 간단합니다. Firefox에서 찾아보세요. 링크 주소를 보려면 브라우저에서 직접 링크를 클릭하세요.)

5. 사용해 보세요

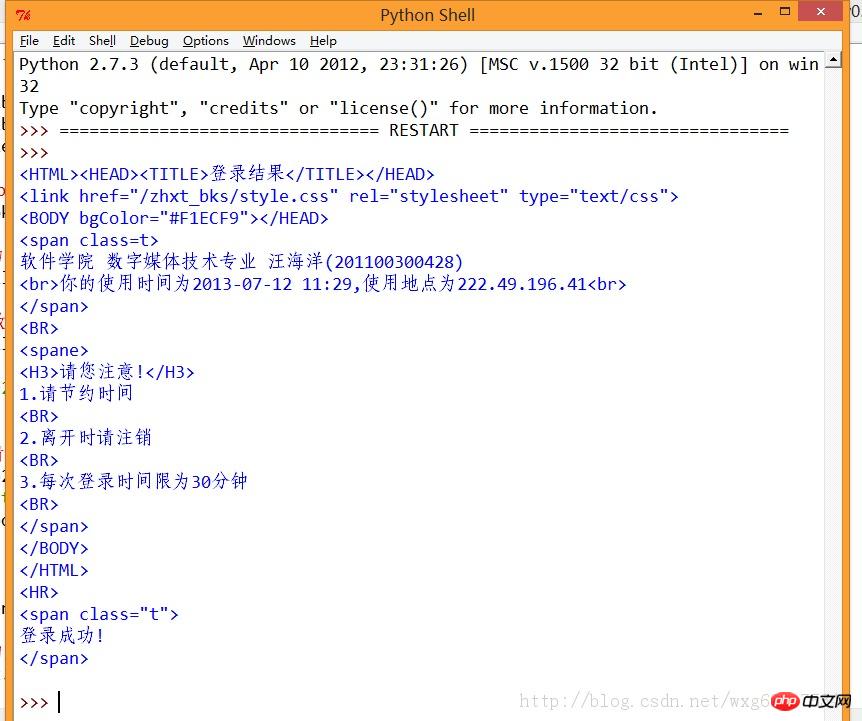

다음 작업은 Python을 사용하여 POST 데이터 전송을 시뮬레이션하고 반환된 쿠키 값 .

쿠키의 작동에 대해서는 다음 블로그 게시물을 읽어보실 수 있습니다:

http://www.jb51.net/article/57144.htm

먼저 POST 데이터를 준비한 후 쿠키 수신을 준비한 후 작성합니다. 소스 코드는 다음과 같습니다.

# -*- coding: utf-8 -*-

#---------------------------------------

# 程序:山东大学爬虫

# 版本:0.1

# 作者:why

# 日期:2013-07-12

# 语言:Python 2.7

# 操作:输入学号和密码

# 功能:输出成绩的加权平均值也就是绩点

#---------------------------------------

import urllib

import urllib2

import cookielib

cookie = cookielib.CookieJar()

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

#需要POST的数据#

postdata=urllib.urlencode({

'stuid':'201100300428',

'pwd':'921030'

})

#自定义一个请求#

req = urllib2.Request(

url = 'http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bks_login2.login',

data = postdata

)

#访问该链接#

result = opener.open(req)

#打印返回的内容#

print result.read()이후 실행 효과를 살펴보겠습니다.

좋아, 이렇게 하면 시뮬레이션된 로그인이 성공한 것으로 계산됩니다.

6. 한 가지를 다른 것으로 대체하기

다음 작업은 크롤러를 사용하여 학생들의 점수를 얻는 것입니다.

출처 사이트를 다시 살펴보겠습니다.

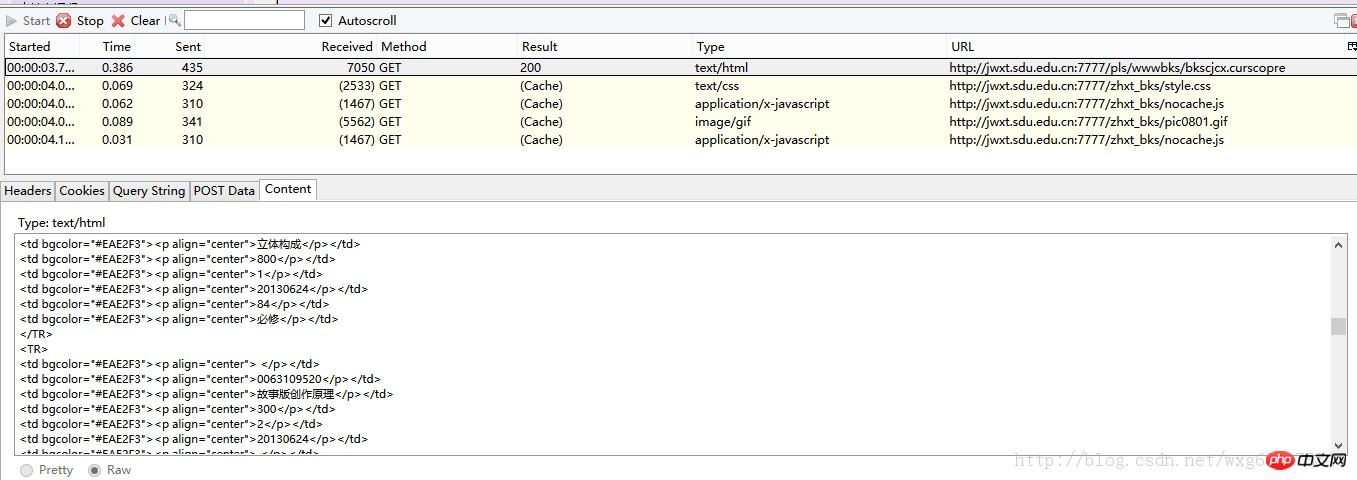

HTTPFOX를 연 후 클릭하여 결과를 보고 다음 데이터가 캡처된 것을 확인합니다.

첫 번째 GET 데이터를 클릭하고 내용을 보면 Content가 얻은 결과의 내용임을 알 수 있습니다.

얻은 페이지 링크는 마우스 오른쪽 버튼을 클릭하면 페이지 소스 코드에서 해당 요소를 볼 수 있고, 링크를 클릭하면 점프하는 페이지를 볼 수 있습니다(Firefox에서는 마우스 오른쪽 버튼을 클릭하고 "이 프레임 보기"만 하면 됩니다) ):

다음과 같이 결과를 볼 수 있는 링크를 얻을 수 있습니다:

http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bkscjcx.curscopre

7. 모든 것이 준비되었습니다

이제 모든 것이 준비되었으므로 크롤러에 링크를 적용하고 결과 페이지가 나타나는지 확인하십시오.

httpfox에서 볼 수 있듯이 점수 정보를 반환하려면 쿠키를 보내야 하므로 Python을 사용하여 점수 정보를 요청하는 쿠키 보내기를 시뮬레이션합니다.

# -*- coding: utf-8 -*-

#---------------------------------------

# 程序:山东大学爬虫

# 版本:0.1

# 作者:why

# 日期:2013-07-12

# 语言:Python 2.7

# 操作:输入学号和密码

# 功能:输出成绩的加权平均值也就是绩点

#---------------------------------------

import urllib

import urllib2

import cookielib

#初始化一个CookieJar来处理Cookie的信息#

cookie = cookielib.CookieJar()

#创建一个新的opener来使用我们的CookieJar#

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

#需要POST的数据#

postdata=urllib.urlencode({

'stuid':'201100300428',

'pwd':'921030'

})

#自定义一个请求#

req = urllib2.Request(

url = 'http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bks_login2.login',

data = postdata

)

#访问该链接#

result = opener.open(req)

#打印返回的内容#

print result.read()

#打印cookie的值

for item in cookie:

print 'Cookie:Name = '+item.name

print 'Cookie:Value = '+item.value

#访问该链接#

result = opener.open('http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bkscjcx.curscopre')

#打印返回的内容#

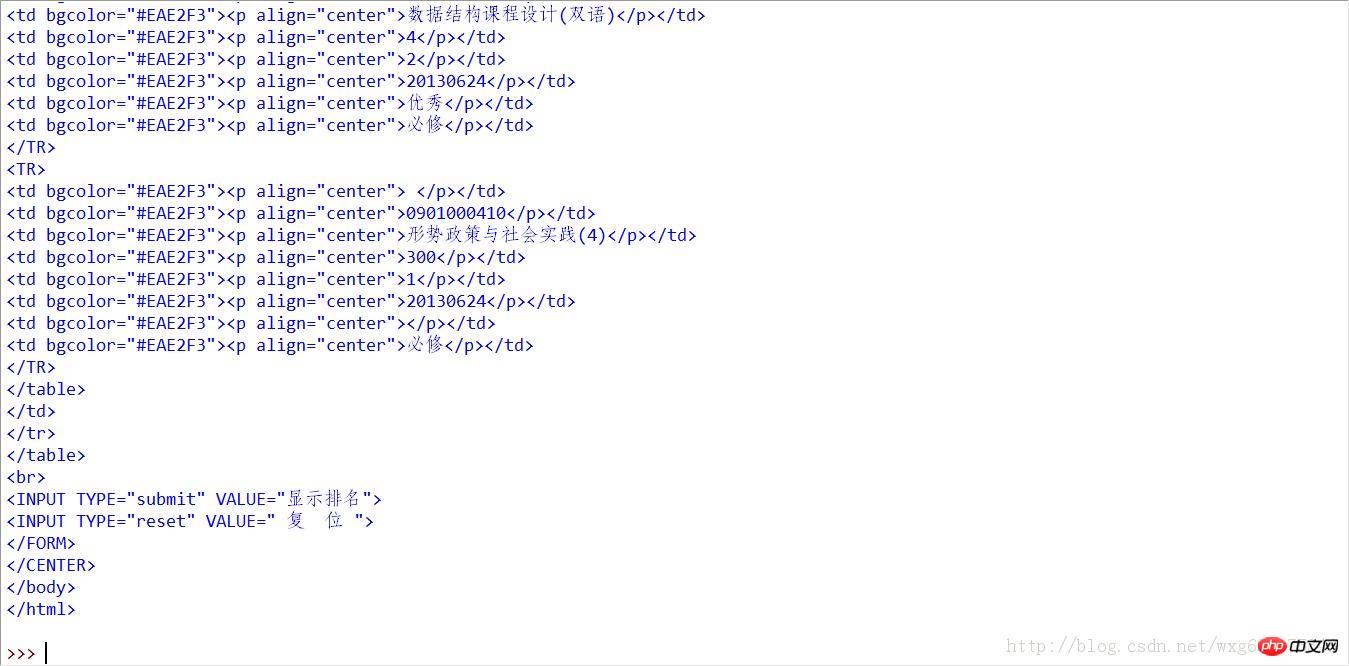

print result.read()F5를 눌러 실행하고 살펴봅니다. 캡처된 데이터 :

이 방법으로는 문제가 없으므로 정규식을 사용하여 데이터를 약간 처리한 후 크레딧과 해당 점수를 추출합니다.

8. 손끝에서

이렇게 많은 양의 HTML 소스 코드는 확실히 처리에 도움이 되지 않습니다. 다음으로, 필요한 데이터를 추출하기 위해 정규식을 사용해야 합니다.

정규식에 대한 튜토리얼을 보려면 다음 블로그 게시물을 확인하세요.

http://www.jb51.net/article/57150.htm

결과의 소스 코드를 살펴보겠습니다.

이 경우 정규식을 사용하면 쉽습니다.

코드를 조금 정리한 다음 정규 표현식을 사용하여 데이터를 추출하겠습니다.

# -*- coding: utf-8 -*-

#---------------------------------------

# 程序:山东大学爬虫

# 版本:0.1

# 作者:why

# 日期:2013-07-12

# 语言:Python 2.7

# 操作:输入学号和密码

# 功能:输出成绩的加权平均值也就是绩点

#---------------------------------------

import urllib

import urllib2

import cookielib

import re

class SDU_Spider:

# 申明相关的属性

def __init__(self):

self.loginUrl = 'http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bks_login2.login' # 登录的url

self.resultUrl = 'http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bkscjcx.curscopre' # 显示成绩的url

self.cookieJar = cookielib.CookieJar() # 初始化一个CookieJar来处理Cookie的信息

self.postdata=urllib.urlencode({'stuid':'201100300428','pwd':'921030'}) # POST的数据

self.weights = [] #存储权重,也就是学分

self.points = [] #存储分数,也就是成绩

self.opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(self.cookieJar))

def sdu_init(self):

# 初始化链接并且获取cookie

myRequest = urllib2.Request(url = self.loginUrl,data = self.postdata) # 自定义一个请求

result = self.opener.open(myRequest) # 访问登录页面,获取到必须的cookie的值

result = self.opener.open(self.resultUrl) # 访问成绩页面,获得成绩的数据

# 打印返回的内容

# print result.read()

self.deal_data(result.read().decode('gbk'))

self.print_data(self.weights);

self.print_data(self.points);

# 将内容从页面代码中抠出来

def deal_data(self,myPage):

myItems = re.findall('<TR>.*?<p.*?<p.*?<p.*?<p.*?<p.*?>(.*?)</p>.*?<p.*?<p.*?>(.*?)</p>.*?</TR>',myPage,re.S) #获取到学分

for item in myItems:

self.weights.append(item[0].encode('gbk'))

self.points.append(item[1].encode('gbk'))

# 将内容从页面代码中抠出来

def print_data(self,items):

for item in items:

print item

#调用

mySpider = SDU_Spider()

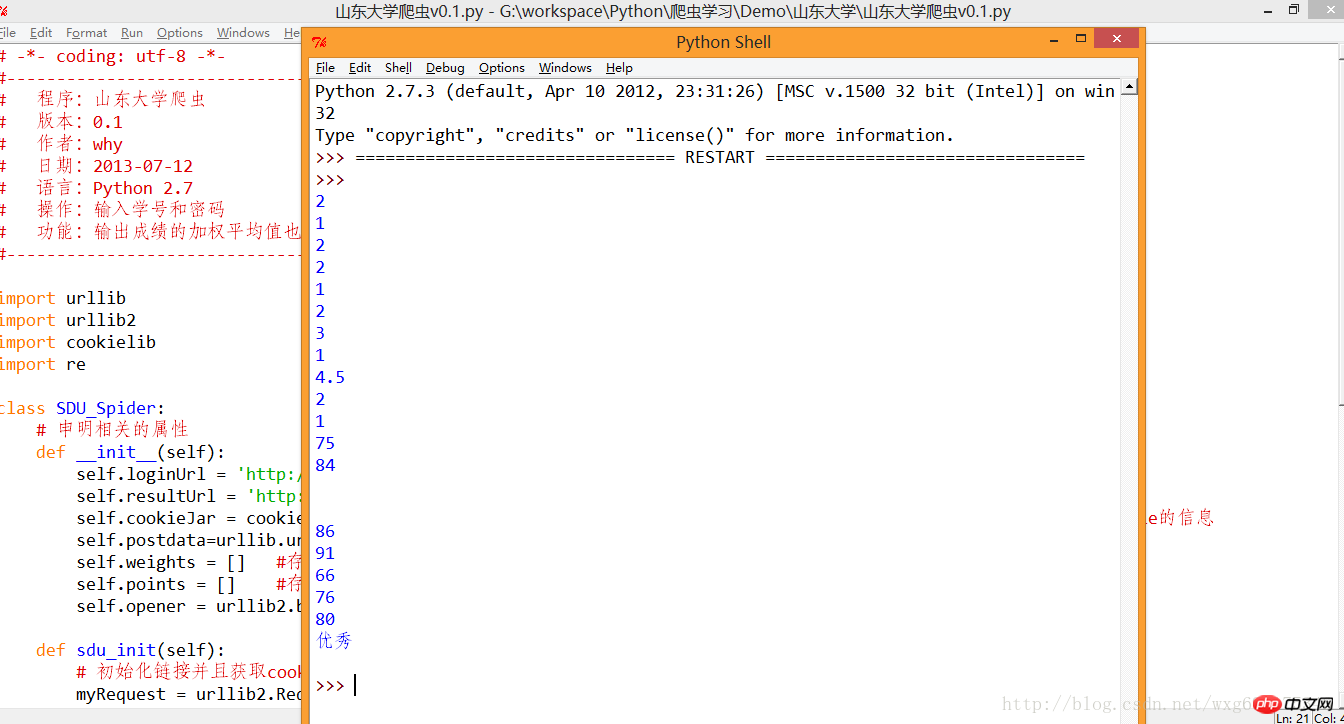

mySpider.sdu_init()레벨이 제한되어 있고 정규 표현식이 약간 보기 흉합니다. 실행 효과는 그림에 표시된 것과 같습니다.

좋아, 다음은 데이터 처리입니다. .

9. 승리의 복귀

완성된 코드는 다음과 같습니다. 이 시점에서 완전한 크롤러 프로젝트가 완성됩니다.

# -*- coding: utf-8 -*-

#---------------------------------------

# 程序:山东大学爬虫

# 版本:0.1

# 作者:why

# 日期:2013-07-12

# 语言:Python 2.7

# 操作:输入学号和密码

# 功能:输出成绩的加权平均值也就是绩点

#---------------------------------------

import urllib

import urllib2

import cookielib

import re

import string

class SDU_Spider:

# 申明相关的属性

def __init__(self):

self.loginUrl = 'http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bks_login2.login' # 登录的url

self.resultUrl = 'http://jwxt.sdu.edu.cn:7777/pls/wwwbks/bkscjcx.curscopre' # 显示成绩的url

self.cookieJar = cookielib.CookieJar() # 初始化一个CookieJar来处理Cookie的信息

self.postdata=urllib.urlencode({'stuid':'201100300428','pwd':'921030'}) # POST的数据

self.weights = [] #存储权重,也就是学分

self.points = [] #存储分数,也就是成绩

self.opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(self.cookieJar))

def sdu_init(self):

# 初始化链接并且获取cookie

myRequest = urllib2.Request(url = self.loginUrl,data = self.postdata) # 自定义一个请求

result = self.opener.open(myRequest) # 访问登录页面,获取到必须的cookie的值

result = self.opener.open(self.resultUrl) # 访问成绩页面,获得成绩的数据

# 打印返回的内容

# print result.read()

self.deal_data(result.read().decode('gbk'))

self.calculate_date();

# 将内容从页面代码中抠出来

def deal_data(self,myPage):

myItems = re.findall('<TR>.*?<p.*?<p.*?<p.*?<p.*?<p.*?>(.*?)</p>.*?<p.*?<p.*?>(.*?)</p>.*?</TR>',myPage,re.S) #获取到学分

for item in myItems:

self.weights.append(item[0].encode('gbk'))

self.points.append(item[1].encode('gbk'))

#计算绩点,如果成绩还没出来,或者成绩是优秀良好,就不运算该成绩

def calculate_date(self):

point = 0.0

weight = 0.0

for i in range(len(self.points)):

if(self.points[i].isdigit()):

point += string.atof(self.points[i])*string.atof(self.weights[i])

weight += string.atof(self.weights[i])

print point/weight

#调用

mySpider = SDU_Spider()

mySpider.sdu_init()관련 권장 사항:

Python 크롤러를 사용하여 귀중한 블로그 게시물을 얻는 방법

위 내용은 스크래치에서 Python 크롤러 작성에 대한 전체 기록_python의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7505

7505

15

15

1378

1378

52

52

78

78

11

11

52

52

19

19

19

19

55

55

hadidb : 파이썬의 가볍고 수평 확장 가능한 데이터베이스

Apr 08, 2025 pm 06:12 PM

hadidb : 파이썬의 가볍고 수평 확장 가능한 데이터베이스

Apr 08, 2025 pm 06:12 PM

HADIDB : 가볍고 높은 수준의 확장 가능한 Python 데이터베이스 HadIDB (HADIDB)는 파이썬으로 작성된 경량 데이터베이스이며 확장 수준이 높습니다. PIP 설치를 사용하여 HADIDB 설치 : PIPINSTALLHADIDB 사용자 관리 사용자 만들기 사용자 : createUser () 메소드를 작성하여 새 사용자를 만듭니다. Authentication () 메소드는 사용자의 신원을 인증합니다. Fromhadidb.operationimportuseruser_obj = user ( "admin", "admin") user_obj.

파이썬 : 기본 응용 프로그램 탐색

Apr 10, 2025 am 09:41 AM

파이썬 : 기본 응용 프로그램 탐색

Apr 10, 2025 am 09:41 AM

Python은 웹 개발, 데이터 과학, 기계 학습, 자동화 및 스크립팅 분야에서 널리 사용됩니다. 1) 웹 개발에서 Django 및 Flask 프레임 워크는 개발 프로세스를 단순화합니다. 2) 데이터 과학 및 기계 학습 분야에서 Numpy, Pandas, Scikit-Learn 및 Tensorflow 라이브러리는 강력한 지원을 제공합니다. 3) 자동화 및 스크립팅 측면에서 Python은 자동화 된 테스트 및 시스템 관리와 같은 작업에 적합합니다.

2 시간의 파이썬 계획 : 현실적인 접근

Apr 11, 2025 am 12:04 AM

2 시간의 파이썬 계획 : 현실적인 접근

Apr 11, 2025 am 12:04 AM

2 시간 이내에 Python의 기본 프로그래밍 개념과 기술을 배울 수 있습니다. 1. 변수 및 데이터 유형을 배우기, 2. 마스터 제어 흐름 (조건부 명세서 및 루프), 3. 기능의 정의 및 사용을 이해하십시오. 4. 간단한 예제 및 코드 스 니펫을 통해 Python 프로그래밍을 신속하게 시작하십시오.

MongoDB 데이터베이스 비밀번호를 보는 Navicat의 방법

Apr 08, 2025 pm 09:39 PM

MongoDB 데이터베이스 비밀번호를 보는 Navicat의 방법

Apr 08, 2025 pm 09:39 PM

해시 값으로 저장되기 때문에 MongoDB 비밀번호를 Navicat을 통해 직접 보는 것은 불가능합니다. 분실 된 비밀번호 검색 방법 : 1. 비밀번호 재설정; 2. 구성 파일 확인 (해시 값이 포함될 수 있음); 3. 코드를 점검하십시오 (암호 하드 코드 메일).

Amazon Athena와 함께 AWS Glue Crawler를 사용하는 방법

Apr 09, 2025 pm 03:09 PM

Amazon Athena와 함께 AWS Glue Crawler를 사용하는 방법

Apr 09, 2025 pm 03:09 PM

데이터 전문가는 다양한 소스에서 많은 양의 데이터를 처리해야합니다. 이것은 데이터 관리 및 분석에 어려움을 겪을 수 있습니다. 다행히도 AWS Glue와 Amazon Athena의 두 가지 AWS 서비스가 도움이 될 수 있습니다.

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

MySQL 데이터베이스 성능 최적화 안내서 리소스 집약적 응용 프로그램에서 MySQL 데이터베이스는 중요한 역할을 수행하며 대규모 트랜잭션 관리를 담당합니다. 그러나 응용 프로그램 규모가 확장됨에 따라 데이터베이스 성능 병목 현상은 종종 제약이됩니다. 이 기사는 일련의 효과적인 MySQL 성능 최적화 전략을 탐색하여 응용 프로그램이 고 부하에서 효율적이고 반응이 유지되도록합니다. 실제 사례를 결합하여 인덱싱, 쿼리 최적화, 데이터베이스 설계 및 캐싱과 같은 심층적 인 주요 기술을 설명합니다. 1. 데이터베이스 아키텍처 설계 및 최적화 된 데이터베이스 아키텍처는 MySQL 성능 최적화의 초석입니다. 몇 가지 핵심 원칙은 다음과 같습니다. 올바른 데이터 유형을 선택하고 요구 사항을 충족하는 가장 작은 데이터 유형을 선택하면 저장 공간을 절약 할 수있을뿐만 아니라 데이터 처리 속도를 향상시킬 수 있습니다.

Redis로 서버를 시작하는 방법

Apr 10, 2025 pm 08:12 PM

Redis로 서버를 시작하는 방법

Apr 10, 2025 pm 08:12 PM

Redis 서버를 시작하는 단계에는 다음이 포함됩니다. 운영 체제에 따라 Redis 설치. Redis-Server (Linux/MacOS) 또는 Redis-Server.exe (Windows)를 통해 Redis 서비스를 시작하십시오. Redis-Cli Ping (Linux/MacOS) 또는 Redis-Cli.exe Ping (Windows) 명령을 사용하여 서비스 상태를 확인하십시오. Redis-Cli, Python 또는 Node.js와 같은 Redis 클라이언트를 사용하여 서버에 액세스하십시오.

Redis 대기열을 읽는 방법

Apr 10, 2025 pm 10:12 PM

Redis 대기열을 읽는 방법

Apr 10, 2025 pm 10:12 PM

Redis의 대기열을 읽으려면 대기열 이름을 얻고 LPOP 명령을 사용하여 요소를 읽고 빈 큐를 처리해야합니다. 특정 단계는 다음과 같습니다. 대기열 이름 가져 오기 : "큐 :"와 같은 "대기열 : my-queue"의 접두사로 이름을 지정하십시오. LPOP 명령을 사용하십시오. 빈 대기열 처리 : 대기열이 비어 있으면 LPOP이 NIL을 반환하고 요소를 읽기 전에 대기열이 존재하는지 확인할 수 있습니다.