노드는 Lagou.com 데이터를 크롤링하여 Excel 파일로 내보냅니다.

이 글에서는 Lagou.com 데이터를 크롤링하고 이를 엑셀 파일로 내보내는 노드를 주로 소개합니다. 이제 필요한 친구들이 참고할 수 있도록 공유합니다.

#🎜 🎜# 서문 저는 예전부터 간헐적으로 node.js를 배워왔습니다. 오늘은 Lagou.com을 이용해 실력을 쌓아보겠습니다. 그런데 최근 채용 시장을 데이터를 통해 알 수 있게 되었습니다! 저는 node를 처음 접한 초보인데, 모두와 함께 배우고 발전할 수 있기를 바랍니다. 1. 요약 먼저 구체적인 요구 사항을 명확히 해야 합니다.- 를 전달할 수 있습니다. 노드 인덱스 도시 위치 관련 정보 크롤링

也可以输入node index start直接爬取我们预定义好的城市和职位数组,循环爬取不同城市的不同职位信息

将最终爬取的结果存储在本地的

./data目录下生成对应的excel文件,并存储到本地

node index 城市 职位来爬取相关信息二、爬虫用到的相关模块

fs: 用于对系统文件及目录进行读写操作

async:流程控制

superagent:客户端请求代理模块

node-xlsx:将一定格式的文件导出为excel

三、爬虫主要步骤:

初始化项目

新建项目目录

在合适的磁盘目录下创建项目目录 node-crwl-lagou

初始化项目

进入node-crwl-lagou文件夹下

执行npm init,初始化package.json文件

安装依赖包

npm install async

npm install superagent

npm install node-xlsx

命令行输入的处理

对于在命令行输入的内容,可以用process.argv来获取,他会返回个数组,数组的每一项就是用户输入的内容。

区分node index 地域 职位和node index start两种输入,最简单的就是判断process.argv的长度,长度为四的话,就直接调用爬虫主程序爬取数据,长度为三的话,我们就需要通过预定义的城市和职位数组来拼凑url了,然后利用async.mapSeries循环调用主程序。关于命令分析的主页代码如下:

if (process.argv.length === 4) {

let args = process.argv

console.log('准备开始请求' + args[2] + '的' + args[3] + '职位数据');

requsetCrwl.controlRequest(args[2], args[3])

} else if (process.argv.length === 3 && process.argv[2] === 'start') {

let arr = []

for (let i = 0; i <p>预定义好的城市和职位数组如下:</p><pre class="brush:php;toolbar:false">{

"city": ["北京","上海","广州","深圳","杭州","南京","成都","西安","武汉","重庆"],

"position": ["前端","java","php","ios","android","c++","python",".NET"]

}接下来就是爬虫主程序部分的分析了。

分析页面,找到请求地址

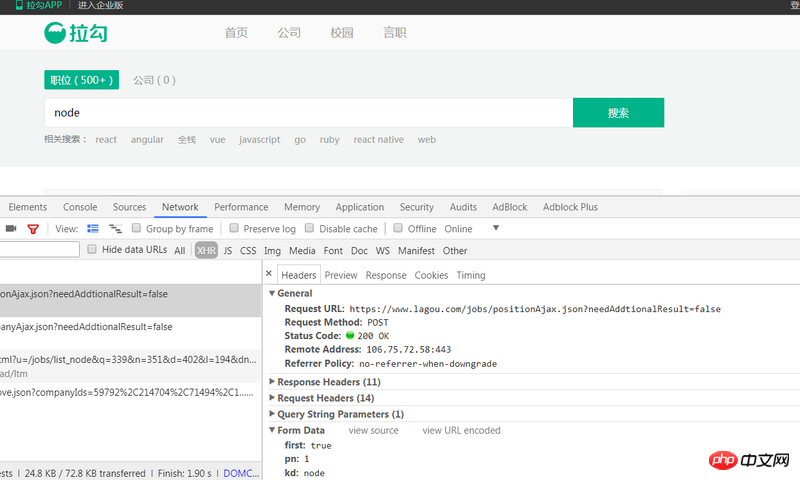

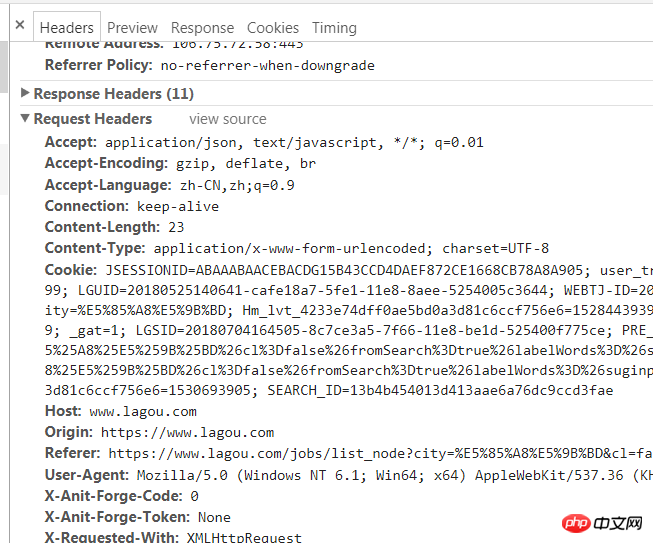

首先我们打开拉勾网首页,输入查询信息(比如node),然后查看控制台,找到相关的请求,如图:

这个post请求https://www.lagou.com/jobs/positionAjax.json?needAddtionalResult=false就是我们所需要的,通过三个请求参数来获取不同的数据,简单的分析就可得知:参数first是标注当前是否是第一页,true为是,false为否;参数pn是当前的页码;参数kd是查询输入的内容。

通过superagent请求数据

首先需要明确得是,整个程序是异步的,我们需要用async.series来依次调用。

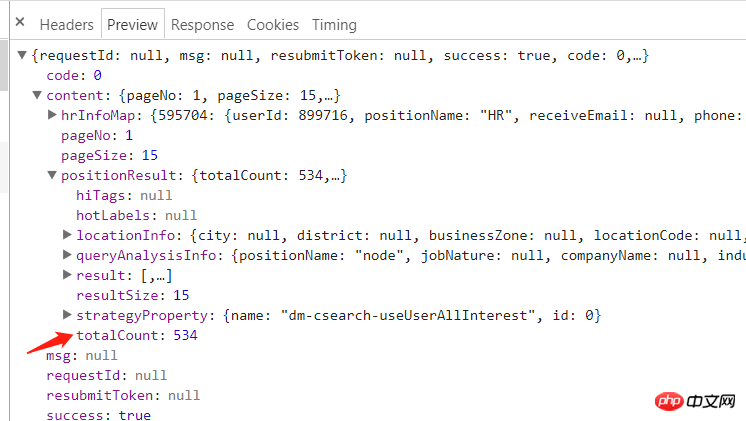

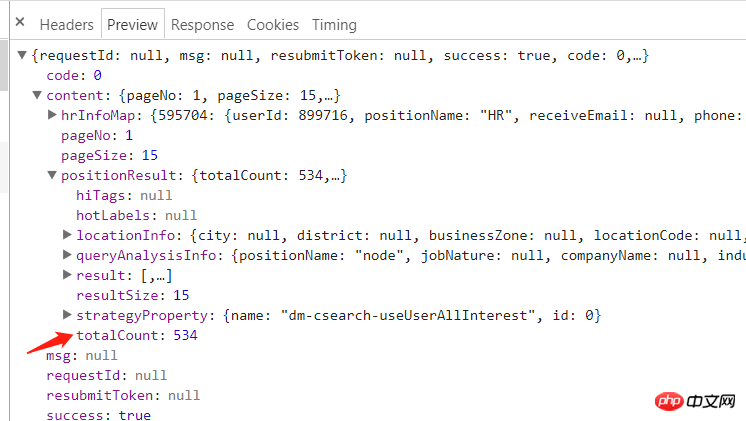

查看分析返回的response:

可以看到content.positionResult.totalCount就是我们所需要的总页数

我们用superagent直接调用post请求,控制台会提示如下信息:

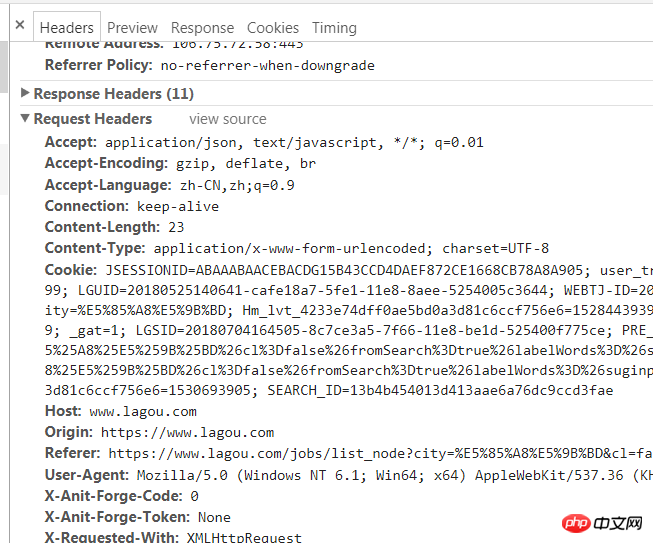

{'success': False, 'msg': '您操作太频繁,请稍后再访问', 'clientIp': '122.xxx.xxx.xxx'}这其实是反爬虫策略之一,我们只需要给其添加一个请求头即可,请求头的获取方式很简单,如下:

然后在用superagent调用post请求,主要代码如下:

// 先获取总页数

(cb) => {

superagent

.post(`https://www.lagou.com/jobs/positionAjax.json?needAddtionalResult=false&city=${city}&kd=${position}&pn=1`)

.send({

'pn': 1,

'kd': position,

'first': true

})

.set(options.options)

.end((err, res) => {

if (err) throw err

// console.log(res.text)

let resObj = JSON.parse(res.text)

if (resObj.success === true) {

totalPage = resObj.content.positionResult.totalCount;

cb(null, totalPage);

} else {

console.log(`获取数据失败:${res.text}}`)

}

})

},拿到总页数后,我们就可以通过总页数/15

- 최종 크롤링 결과를 로컬

- 해당 엑셀 파일을 생성하여 로컬에 저장#🎜🎜#

./data 디렉터리에 저장- #🎜🎜##🎜🎜#fs: 시스템 파일 및 디렉터리를 읽고 쓰는 데 사용됩니다#🎜🎜##🎜🎜##🎜🎜#async: 프로세스 제어 #🎜🎜# #🎜🎜##🎜🎜#superagent: 클라이언트 요청 프록시 모듈 #🎜🎜##🎜🎜##🎜🎜#node-xlsx: 특정 형식의 파일을 excel#🎜🎜#으로 내보내기

프로젝트 초기화

#🎜🎜#새 프로젝트 디렉토리#🎜🎜##🎜🎜 #프로젝트 생성 해당 디스크 디렉토리에 node-crwl-lagou#🎜🎜##🎜🎜#프로젝트 초기화#🎜🎜##🎜🎜##🎜🎜##🎜🎜##🎜🎜#Enter node-crwl- lagou 아래 폴더 #🎜🎜##🎜🎜##🎜🎜# npm init 실행 및 package.json 파일 초기화 #🎜🎜##🎜🎜##🎜🎜# 설치 종속성 패키지 #🎜🎜##🎜🎜##🎜🎜##🎜🎜##🎜🎜#npm install async#🎜🎜##🎜🎜##🎜🎜#npm install superagent#🎜🎜# li>#🎜🎜##🎜🎜#npm install node-xlsx#🎜🎜##🎜🎜#명령줄 입력 처리

#🎜🎜#명령 내용 행에 입력된 내용은process.argv를 사용하여 얻을 수 있으며, 배열의 각 항목은 사용자가 입력한 내용입니다. 노드 인덱스 지역 위치와 노드 인덱스 시작을 구별합니다. 가장 간단한 방법은 process.argv의 길이를 판단하는 것입니다. 크롤러 기본 프로그램은 데이터를 크롤링합니다. 길이가 3인 경우 미리 정의된 도시 및 위치 배열을 통해 URL을 모은 다음 async.mapSeries를 사용하여 루프에서 기본 프로그램을 호출해야 합니다. 명령 분석을 위한 홈페이지 코드는 다음과 같습니다. #🎜🎜#(cb) => {

for (let i=0;Math.ceil(i<totalpage>#🎜🎜#미리 정의된 도시 및 위치 배열은 다음과 같습니다. #🎜🎜#<div class="code" style="position:relative; padding:0px; margin:0px;"><pre class="brush:php;toolbar:false">// 控制并发为3

(cb) => {

async.mapLimit(urls, 3, (url, callback) => {

num++;

let page = url.split('&')[3].split('=')[1];

superagent

.post(url)

.send({

'pn': totalPage,

'kd': position,

'first': false

})

.set(options.options)

.end((err, res) => {

if (err) throw err

let resObj = JSON.parse(res.text)

if (resObj.success === true) {

console.log(`正在抓取第${page}页,当前并发数量:${num}`);

if (!fs.existsSync('./data')) {

fs.mkdirSync('./data');

}

// 将数据以.json格式储存在data文件夹下

fs.writeFile(`./data/${city}_${position}_${page}.json`, res.text, (err) => {

if (err) throw err;

// 写入数据完成后,两秒后再发送下一次请求

setTimeout(() => {

num--;

console.log(`第${page}页写入成功`);

callback(null, 'success');

}, 2000);

});

}

})

}, (err, result) => {

if (err) throw err;

// 这个arguments是调用controlRequest函数的参数,可以区分是那种爬取(循环还是单个)

if (arguments[2]) {

ok = 1;

}

cb(null, ok)

})

},

() => {

if (ok) {

setTimeout(function () {

console.log(`${city}的${position}数据请求完成`);

indexCallback(null);

}, 5000);

} else {

console.log(`${city}的${position}数据请求完成`);

}

// exportExcel.exportExcel() // 导出为excel

}페이지 분석 및 요청 주소 찾기

#🎜🎜#먼저 Lagou.com 홈페이지를 열고 쿼리 정보(노드 등)를 입력한 후 콘솔을 확인하여 그림과 같이 관련 요청을 찾으세요: #🎜🎜##🎜🎜#![1530957306181687.png 2217504720- 5b3c89dd656e7_articlex[1].png](https://img.php.cn//upload/image/164/490/640/1530957306181687.png) #🎜🎜##🎜🎜#이 게시물 요청 https://www.lagou.com/jobs/positionAjax.json? needAddtionalResult=false가 우리에게 필요한 것입니다. 세 가지 요청 매개변수를 통해 다양한 데이터를 얻습니다. 간단한 분석을 통해 알 수 있습니다.

#🎜🎜##🎜🎜#이 게시물 요청 https://www.lagou.com/jobs/positionAjax.json? needAddtionalResult=false가 우리에게 필요한 것입니다. 세 가지 요청 매개변수를 통해 다양한 데이터를 얻습니다. 간단한 분석을 통해 알 수 있습니다. first 매개변수는 현재 페이지가 첫 번째 페이지인지 여부를 표시하는 것이며, true는 의미합니다. 예, false는 아니요를 의미합니다. >pn 매개변수는 현재 페이지 번호이고, kd 매개변수는 쿼리 입력 내용입니다. #🎜🎜#슈퍼에이전트를 통한 데이터 요청

#🎜🎜#우선 전체 프로그램이 비동기식이라는 점을 분명히 해야 하며, 이를 순차적으로 호출하려면 async.series를 사용해야 합니다.분석에서 반환된 응답 보기: #🎜🎜##🎜🎜#

#🎜🎜##🎜🎜#content.positionResult.totalCount가 필요한 총 페이지 수임을 알 수 있습니다

#🎜🎜##🎜🎜#content.positionResult.totalCount가 필요한 총 페이지 수임을 알 수 있습니다슈퍼에이전트를 사용하여 post 요청을 직접 호출하면 콘솔에 다음 정보가 표시됩니다. #🎜🎜#

function exportExcel() {

let list = fs.readdirSync('./data')

let dataArr = []

list.forEach((item, index) => {

let path = `./data/${item}`

let obj = fs.readFileSync(path, 'utf-8')

let content = JSON.parse(obj).content.positionResult.result

let arr = [['companyFullName', 'createTime', 'workYear', 'education', 'city', 'positionName', 'positionAdvantage', 'companyLabelList', 'salary']]

content.forEach((contentItem) => {

arr.push([contentItem.companyFullName, contentItem.phone, contentItem.workYear, contentItem.education, contentItem.city, contentItem.positionName, contentItem.positionAdvantage, contentItem.companyLabelList.join(','), contentItem.salary])

})

dataArr[index] = {

data: arr,

name: path.split('./data/')[1] // 名字不能包含 \ / ? * [ ]

}

})

// 数据格式

// var data = [

// {

// name : 'sheet1',

// data : [

// [

// 'ID',

// 'Name',

// 'Score'

// ],

// [

// '1',

// 'Michael',

// '99'

//

// ],

// [

// '2',

// 'Jordan',

// '98'

// ]

// ]

// },

// {

// name : 'sheet2',

// data : [

// [

// 'AA',

// 'BB'

// ],

// [

// '23',

// '24'

// ]

// ]

// }

// ]

// 写xlsx

var buffer = xlsx.build(dataArr)

fs.writeFile('./result.xlsx', buffer, function (err)

{

if (err)

throw err;

console.log('Write to xls has finished');

// 读xlsx

// var obj = xlsx.parse("./" + "resut.xls");

// console.log(JSON.stringify(obj));

}

);

} #🎜🎜##🎜🎜#그런 다음 superagent를 사용하여 게시물 요청을 호출합니다. #🎜🎜#rrreee #🎜🎜#총 페이지 수를 얻은 후

#🎜🎜##🎜🎜#그런 다음 superagent를 사용하여 게시물 요청을 호출합니다. #🎜🎜#rrreee #🎜🎜#총 페이지 수를 얻은 후 총 페이지 수/15를 통해 pn 매개변수를 가져오고 루프를 통해 모든 URL을 생성하고 이를 URL에 저장할 수 있습니다. #🎜🎜#rrreee# 🎜🎜#모든 URL을 사용하여 모든 데이터를 크롤링하고 싶습니다. 계속해서 슈퍼에이전트의 게시 방법을 사용하여 데이터를 얻을 때마다 모든 URL을 요청합니다. 데이터에 json 파일을 만듭니다. 디렉터리에 저장하고 반환된 데이터를 씁니다. 간단해 보이지만 주목해야 할 두 가지 사항이 있습니다. #🎜🎜##🎜🎜##🎜🎜##🎜🎜#너무 많은 동시 요청으로 인해 IP가 차단되는 것을 방지하려면 비동기식을 사용해야 합니다. URL을 반복할 때 제어하는 .mapLimit 메소드 동시성은 3입니다. 각 요청 후 다음 요청을 보내는 데 2초가 걸립니다 #🎜🎜#在async.mapLimit的第四个参数中,需要通过判断调用主函数的第三个参数是否存在来区分一下是那种命令输入,因为对于node index start这个命令,我们使用得是async.mapSeries,每次调用主函数都传递了(city, position, callback),所以如果是node index start的话,需要在每次获取数据完后将null传递回去,否则无法进行下一次循环

主要代码如下:

// 控制并发为3

(cb) => {

async.mapLimit(urls, 3, (url, callback) => {

num++;

let page = url.split('&')[3].split('=')[1];

superagent

.post(url)

.send({

'pn': totalPage,

'kd': position,

'first': false

})

.set(options.options)

.end((err, res) => {

if (err) throw err

let resObj = JSON.parse(res.text)

if (resObj.success === true) {

console.log(`正在抓取第${page}页,当前并发数量:${num}`);

if (!fs.existsSync('./data')) {

fs.mkdirSync('./data');

}

// 将数据以.json格式储存在data文件夹下

fs.writeFile(`./data/${city}_${position}_${page}.json`, res.text, (err) => {

if (err) throw err;

// 写入数据完成后,两秒后再发送下一次请求

setTimeout(() => {

num--;

console.log(`第${page}页写入成功`);

callback(null, 'success');

}, 2000);

});

}

})

}, (err, result) => {

if (err) throw err;

// 这个arguments是调用controlRequest函数的参数,可以区分是那种爬取(循环还是单个)

if (arguments[2]) {

ok = 1;

}

cb(null, ok)

})

},

() => {

if (ok) {

setTimeout(function () {

console.log(`${city}的${position}数据请求完成`);

indexCallback(null);

}, 5000);

} else {

console.log(`${city}的${position}数据请求完成`);

}

// exportExcel.exportExcel() // 导出为excel

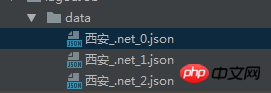

}导出的json文件如下:

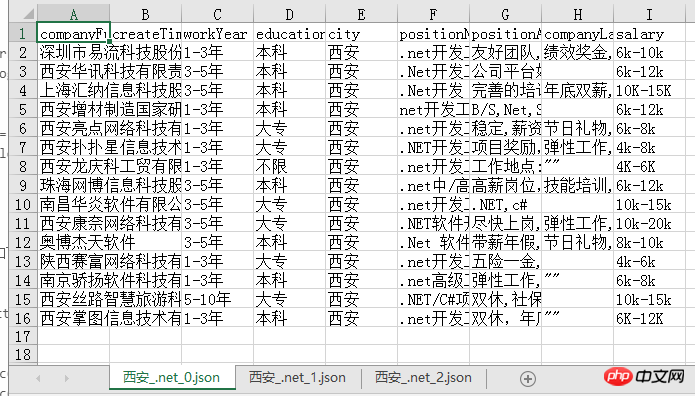

json文件导出为excel

将json文件导出为excel有多种方式,我使用的是node-xlsx这个node包,这个包需要将数据按照固定的格式传入,然后导出即可,所以我们首先做的就是先拼出其所需的数据格式:

function exportExcel() {

let list = fs.readdirSync('./data')

let dataArr = []

list.forEach((item, index) => {

let path = `./data/${item}`

let obj = fs.readFileSync(path, 'utf-8')

let content = JSON.parse(obj).content.positionResult.result

let arr = [['companyFullName', 'createTime', 'workYear', 'education', 'city', 'positionName', 'positionAdvantage', 'companyLabelList', 'salary']]

content.forEach((contentItem) => {

arr.push([contentItem.companyFullName, contentItem.phone, contentItem.workYear, contentItem.education, contentItem.city, contentItem.positionName, contentItem.positionAdvantage, contentItem.companyLabelList.join(','), contentItem.salary])

})

dataArr[index] = {

data: arr,

name: path.split('./data/')[1] // 名字不能包含 \ / ? * [ ]

}

})

// 数据格式

// var data = [

// {

// name : 'sheet1',

// data : [

// [

// 'ID',

// 'Name',

// 'Score'

// ],

// [

// '1',

// 'Michael',

// '99'

//

// ],

// [

// '2',

// 'Jordan',

// '98'

// ]

// ]

// },

// {

// name : 'sheet2',

// data : [

// [

// 'AA',

// 'BB'

// ],

// [

// '23',

// '24'

// ]

// ]

// }

// ]

// 写xlsx

var buffer = xlsx.build(dataArr)

fs.writeFile('./result.xlsx', buffer, function (err)

{

if (err)

throw err;

console.log('Write to xls has finished');

// 读xlsx

// var obj = xlsx.parse("./" + "resut.xls");

// console.log(JSON.stringify(obj));

}

);

}导出的excel文件如下,每一页的数据都是一个sheet,比较清晰明了:

我们可以很清楚的从中看出目前西安.net的招聘情况,之后也可以考虑用更形象的图表方式展示爬到的数据,应该会更加直观!

总结

其实整个爬虫过程并不复杂,注意就是注意的小点很多,比如async的各个方法的使用以及导出设置header等,总之,也是收获满满哒!

源码

gitbug地址: https://github.com/fighting12...

以上就是本文的全部内容,希望对大家的学习有所帮助,更多相关内容请关注PHP中文网!

相关推荐:

위 내용은 노드는 Lagou.com 데이터를 크롤링하여 Excel 파일로 내보냅니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7526

7526

15

15

1378

1378

52

52

81

81

11

11

54

54

19

19

21

21

74

74

WebSocket과 JavaScript를 사용하여 온라인 음성 인식 시스템을 구현하는 방법

Dec 17, 2023 pm 02:54 PM

WebSocket과 JavaScript를 사용하여 온라인 음성 인식 시스템을 구현하는 방법

Dec 17, 2023 pm 02:54 PM

WebSocket 및 JavaScript를 사용하여 온라인 음성 인식 시스템을 구현하는 방법 소개: 지속적인 기술 개발로 음성 인식 기술은 인공 지능 분야의 중요한 부분이 되었습니다. WebSocket과 JavaScript를 기반으로 한 온라인 음성 인식 시스템은 낮은 대기 시간, 실시간, 크로스 플랫폼이라는 특징을 갖고 있으며 널리 사용되는 솔루션이 되었습니다. 이 기사에서는 WebSocket과 JavaScript를 사용하여 온라인 음성 인식 시스템을 구현하는 방법을 소개합니다.

WebSocket 및 JavaScript: 실시간 모니터링 시스템 구현을 위한 핵심 기술

Dec 17, 2023 pm 05:30 PM

WebSocket 및 JavaScript: 실시간 모니터링 시스템 구현을 위한 핵심 기술

Dec 17, 2023 pm 05:30 PM

WebSocket과 JavaScript: 실시간 모니터링 시스템 구현을 위한 핵심 기술 서론: 인터넷 기술의 급속한 발전과 함께 실시간 모니터링 시스템이 다양한 분야에서 널리 활용되고 있다. 실시간 모니터링을 구현하는 핵심 기술 중 하나는 WebSocket과 JavaScript의 조합입니다. 이 기사에서는 실시간 모니터링 시스템에서 WebSocket 및 JavaScript의 적용을 소개하고 코드 예제를 제공하며 구현 원칙을 자세히 설명합니다. 1. 웹소켓 기술

JavaScript 및 WebSocket을 사용하여 실시간 온라인 주문 시스템을 구현하는 방법

Dec 17, 2023 pm 12:09 PM

JavaScript 및 WebSocket을 사용하여 실시간 온라인 주문 시스템을 구현하는 방법

Dec 17, 2023 pm 12:09 PM

JavaScript 및 WebSocket을 사용하여 실시간 온라인 주문 시스템을 구현하는 방법 소개: 인터넷의 대중화와 기술의 발전으로 점점 더 많은 레스토랑에서 온라인 주문 서비스를 제공하기 시작했습니다. 실시간 온라인 주문 시스템을 구현하기 위해 JavaScript 및 WebSocket 기술을 사용할 수 있습니다. WebSocket은 TCP 프로토콜을 기반으로 하는 전이중 통신 프로토콜로 클라이언트와 서버 간의 실시간 양방향 통신을 실현할 수 있습니다. 실시간 온라인 주문 시스템에서는 사용자가 요리를 선택하고 주문을 하면

WebSocket과 JavaScript를 사용하여 온라인 예약 시스템을 구현하는 방법

Dec 17, 2023 am 09:39 AM

WebSocket과 JavaScript를 사용하여 온라인 예약 시스템을 구현하는 방법

Dec 17, 2023 am 09:39 AM

WebSocket과 JavaScript를 사용하여 온라인 예약 시스템을 구현하는 방법 오늘날의 디지털 시대에는 점점 더 많은 기업과 서비스에서 온라인 예약 기능을 제공해야 합니다. 효율적인 실시간 온라인 예약 시스템을 구현하는 것이 중요합니다. 이 기사에서는 WebSocket과 JavaScript를 사용하여 온라인 예약 시스템을 구현하는 방법을 소개하고 구체적인 코드 예제를 제공합니다. 1. WebSocket이란 무엇입니까? WebSocket은 단일 TCP 연결의 전이중 방식입니다.

JavaScript와 WebSocket: 효율적인 실시간 일기예보 시스템 구축

Dec 17, 2023 pm 05:13 PM

JavaScript와 WebSocket: 효율적인 실시간 일기예보 시스템 구축

Dec 17, 2023 pm 05:13 PM

JavaScript 및 WebSocket: 효율적인 실시간 일기 예보 시스템 구축 소개: 오늘날 일기 예보의 정확성은 일상 생활과 의사 결정에 매우 중요합니다. 기술이 발전함에 따라 우리는 날씨 데이터를 실시간으로 획득함으로써 보다 정확하고 신뢰할 수 있는 일기예보를 제공할 수 있습니다. 이 기사에서는 JavaScript 및 WebSocket 기술을 사용하여 효율적인 실시간 일기 예보 시스템을 구축하는 방법을 알아봅니다. 이 문서에서는 특정 코드 예제를 통해 구현 프로세스를 보여줍니다. 우리

자바스크립트에서 insertBefore를 사용하는 방법

Nov 24, 2023 am 11:56 AM

자바스크립트에서 insertBefore를 사용하는 방법

Nov 24, 2023 am 11:56 AM

사용법: JavaScript에서 insertBefore() 메서드는 DOM 트리에 새 노드를 삽입하는 데 사용됩니다. 이 방법에는 삽입할 새 노드와 참조 노드(즉, 새 노드가 삽입될 노드)라는 두 가지 매개 변수가 필요합니다.

간단한 JavaScript 튜토리얼: HTTP 상태 코드를 얻는 방법

Jan 05, 2024 pm 06:08 PM

간단한 JavaScript 튜토리얼: HTTP 상태 코드를 얻는 방법

Jan 05, 2024 pm 06:08 PM

JavaScript 튜토리얼: HTTP 상태 코드를 얻는 방법, 특정 코드 예제가 필요합니다. 서문: 웹 개발에서는 서버와의 데이터 상호 작용이 종종 포함됩니다. 서버와 통신할 때 반환된 HTTP 상태 코드를 가져와서 작업의 성공 여부를 확인하고 다양한 상태 코드에 따라 해당 처리를 수행해야 하는 경우가 많습니다. 이 기사에서는 JavaScript를 사용하여 HTTP 상태 코드를 얻는 방법과 몇 가지 실용적인 코드 예제를 제공합니다. XMLHttpRequest 사용

JavaScript 및 WebSocket: 효율적인 실시간 이미지 처리 시스템 구축

Dec 17, 2023 am 08:41 AM

JavaScript 및 WebSocket: 효율적인 실시간 이미지 처리 시스템 구축

Dec 17, 2023 am 08:41 AM

JavaScript는 웹 개발에 널리 사용되는 프로그래밍 언어인 반면 WebSocket은 실시간 통신에 사용되는 네트워크 프로토콜입니다. 두 가지의 강력한 기능을 결합하면 효율적인 실시간 영상 처리 시스템을 만들 수 있습니다. 이 기사에서는 JavaScript와 WebSocket을 사용하여 이 시스템을 구현하는 방법을 소개하고 구체적인 코드 예제를 제공합니다. 첫째, 실시간 영상처리 시스템의 요구사항과 목표를 명확히 할 필요가 있다. 실시간 이미지 데이터를 수집할 수 있는 카메라 장치가 있다고 가정해 보겠습니다.