Anaconda 환경에서 Scrapy 크롤러 프레임워크를 생성하는 Python 크롤러

Anaconda 환경에서 Scrapy 크롤러 프레임워크를 만드는 방법은 무엇입니까? 이 글은 Anaconda 환경에서 Scrapy 크롤러 프레임워크 프로젝트를 생성하는 단계를 소개합니다. 읽어볼 가치가 있습니다.

Python 크롤러 튜토리얼-31-스크래피 크롤러 프레임워크 프로젝트 만들기

우선 이 글은 아나콘다 환경이므로 아나콘다가 설치되어 있지 않다면 공식 홈페이지에 가서 먼저 다운로드 받아 설치하시기 바랍니다

Anaconda 다운로드 주소: https://www.anaconda.com/download/

스크래피 크롤러 프레임워크 프로젝트 생성

0. [cmd]

1. 사용하려는 Anaconda 환경을 입력하세요.

여기서 프로젝트가 생성되었습니다.

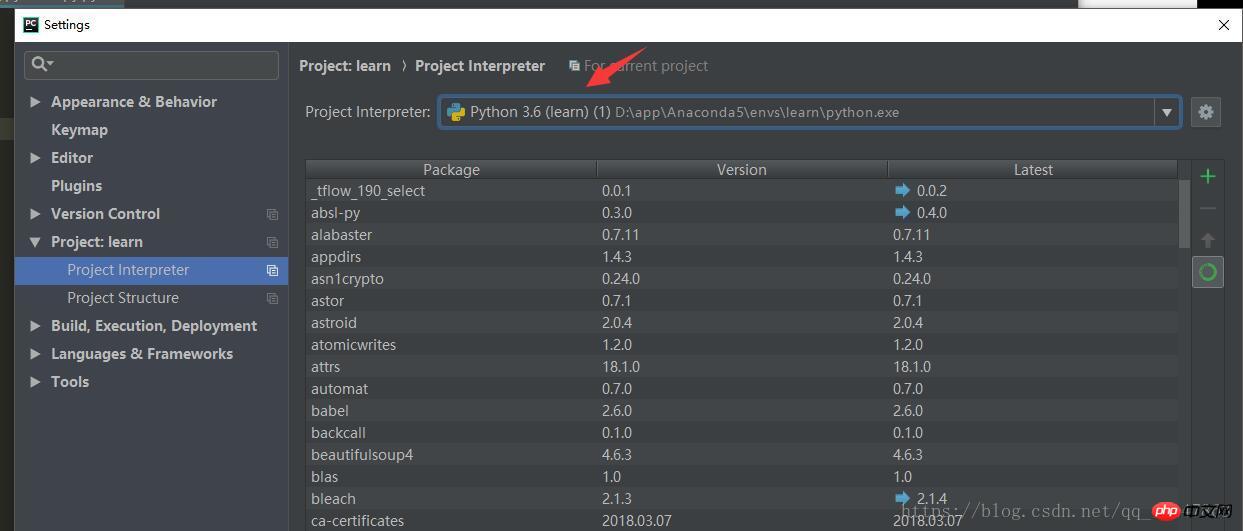

1의 역할은 [Pycharm]

2의 [설정] 아래 [프로젝트:]에서 찾을 수 있습니다. 예를 들면 다음과 같습니다.

activate learn

3. 원하는 scrapy 프로젝트가 저장될 디렉터리를 입력하세요. [참고]

4. 새 프로젝트: scrapy startproject xxx 프로젝트 이름, 예:

scrapy startproject new_project

5. 스크린샷:

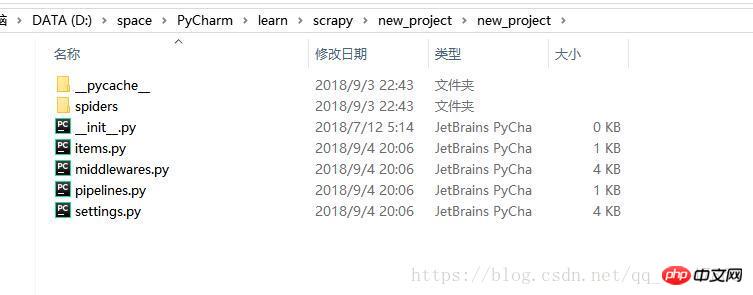

6. 파일 탐색기 디렉터리에서 열면 여러 파일이 생성된 것을 확인할 수 있습니다

7. Pycharm을 사용하여 프로젝트가 있는 디렉터리를 엽니다.

Scrapy 크롤러 프레임워크 프로젝트 개발

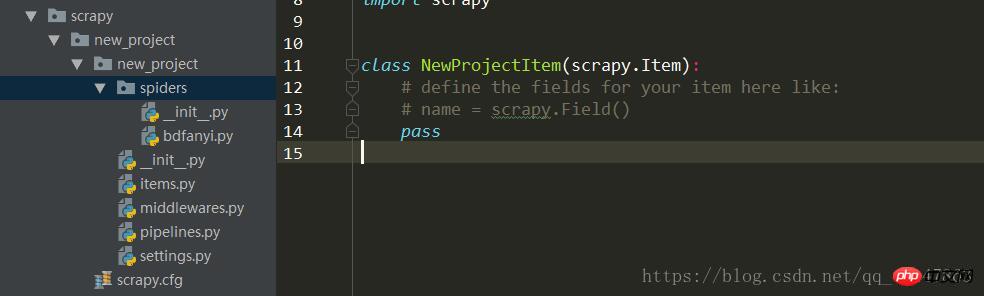

0. Pycharm을 사용하여 프로젝트를 엽니다. 스크린샷:

프로젝트 개발의 일반적인 프로세스:

spider/xxspider.py 주소는 다운로드한 데이터를 분해하고 추출하는 역할을 담당합니다

1. 크롤링해야 하는 대상/제품: item.py

2. 스파이더 디렉터리에서 다운로드하여 생성합니다. Python 파일 생성 크롤러:

3 저장 콘텐츠: Pipelines.py

Pipeline.py 파일

스파이더 객체가 닫힐 때 호출됨

스파이더 객체가 열릴 때 호출됨

필요한 매개변수를 초기화하기 위해

스파이더가 추출한 항목이 스파이더와 함께 매개변수로 전달됨

이 메서드를 구현해야 함

항목 개체를 반환해야 하며 버려진 항목은 후속 파이프라인

해당 파이프라인 파일

에 포함되지 않습니다. 크롤러가 데이터를 추출하여 항목에 저장한 후 항목에 저장된 데이터는 추가 처리가 필요합니다.

파이프라인에서는 process_item 함수를 처리해야 합니다.

process_item

_ init _: 생성자

open_spider( spider):

close_spider(spider): 아이더 디렉토리

Python 크롤러 프레임워크의 스크랩 예제에 대한 자세한 설명

Scrapy 크롤러 소개 튜토리얼 four Spider (크롤러)

Python의 Scrapy 프레임워크 사용 웹 크롤러 작성의 간단한 예

위 내용은 Anaconda 환경에서 Scrapy 크롤러 프레임워크를 생성하는 Python 크롤러의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7675

7675

15

15

1393

1393

52

52

1207

1207

24

24

91

91

11

11

73

73

19

19

Linux 터미널에서 Python 버전을 볼 때 발생하는 권한 문제를 해결하는 방법은 무엇입니까?

Apr 01, 2025 pm 05:09 PM

Linux 터미널에서 Python 버전을 볼 때 발생하는 권한 문제를 해결하는 방법은 무엇입니까?

Apr 01, 2025 pm 05:09 PM

Linux 터미널에서 Python 버전을 보려고 할 때 Linux 터미널에서 Python 버전을 볼 때 권한 문제에 대한 솔루션 ... Python을 입력하십시오 ...

10 시간 이내에 프로젝트 및 문제 중심 방법에서 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법?

Apr 02, 2025 am 07:18 AM

10 시간 이내에 프로젝트 및 문제 중심 방법에서 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법?

Apr 02, 2025 am 07:18 AM

10 시간 이내에 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법은 무엇입니까? 컴퓨터 초보자에게 프로그래밍 지식을 가르치는 데 10 시간 밖에 걸리지 않는다면 무엇을 가르치기로 선택 하시겠습니까?

중간 독서를 위해 Fiddler를 사용할 때 브라우저에서 감지되는 것을 피하는 방법은 무엇입니까?

Apr 02, 2025 am 07:15 AM

중간 독서를 위해 Fiddler를 사용할 때 브라우저에서 감지되는 것을 피하는 방법은 무엇입니까?

Apr 02, 2025 am 07:15 AM

Fiddlerevery Where를 사용할 때 Man-in-the-Middle Reading에 Fiddlereverywhere를 사용할 때 감지되는 방법 ...

한 데이터 프레임의 전체 열을 Python의 다른 구조를 가진 다른 데이터 프레임에 효율적으로 복사하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:15 PM

한 데이터 프레임의 전체 열을 Python의 다른 구조를 가진 다른 데이터 프레임에 효율적으로 복사하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:15 PM

Python의 Pandas 라이브러리를 사용할 때는 구조가 다른 두 데이터 프레임 사이에서 전체 열을 복사하는 방법이 일반적인 문제입니다. 두 개의 dats가 있다고 가정 해

Uvicorn은 Serving_forever ()없이 HTTP 요청을 어떻게 지속적으로 듣습니까?

Apr 01, 2025 pm 10:51 PM

Uvicorn은 Serving_forever ()없이 HTTP 요청을 어떻게 지속적으로 듣습니까?

Apr 01, 2025 pm 10:51 PM

Uvicorn은 HTTP 요청을 어떻게 지속적으로 듣습니까? Uvicorn은 ASGI를 기반으로 한 가벼운 웹 서버입니다. 핵심 기능 중 하나는 HTTP 요청을 듣고 진행하는 것입니다 ...

Linux 터미널에서 Python (Version 명령)을 사용할 때 권한 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:36 AM

Linux 터미널에서 Python (Version 명령)을 사용할 때 권한 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:36 AM

Linux 터미널에서 Python 사용 ...

문자열을 통해 객체를 동적으로 생성하고 방법을 파이썬으로 호출하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:18 PM

문자열을 통해 객체를 동적으로 생성하고 방법을 파이썬으로 호출하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:18 PM

파이썬에서 문자열을 통해 객체를 동적으로 생성하고 메소드를 호출하는 방법은 무엇입니까? 특히 구성 또는 실행 해야하는 경우 일반적인 프로그래밍 요구 사항입니다.