Python 크롤러---Autohome 글꼴 크롤링 방지

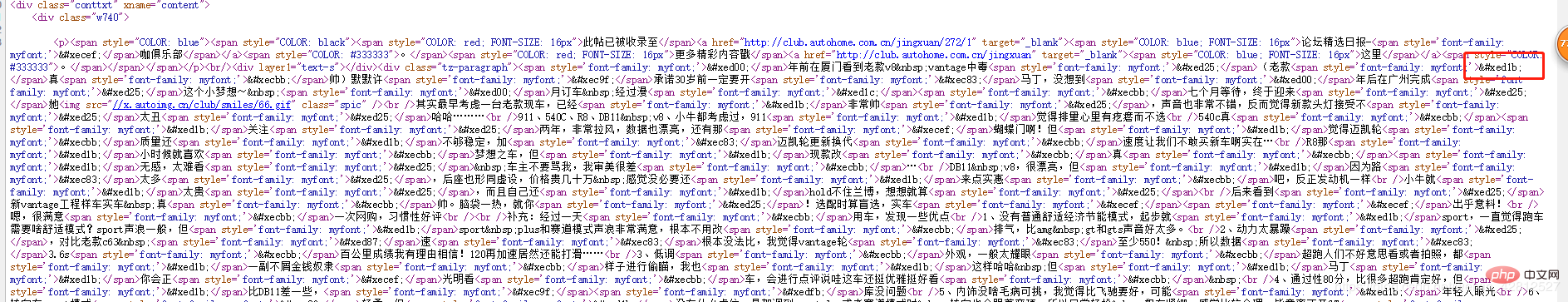

가 있어서 혹시 찾을 수 있을까 해서 myfont 를 살펴봤습니다. 그 결과 정말 뭔가를 발견했습니다

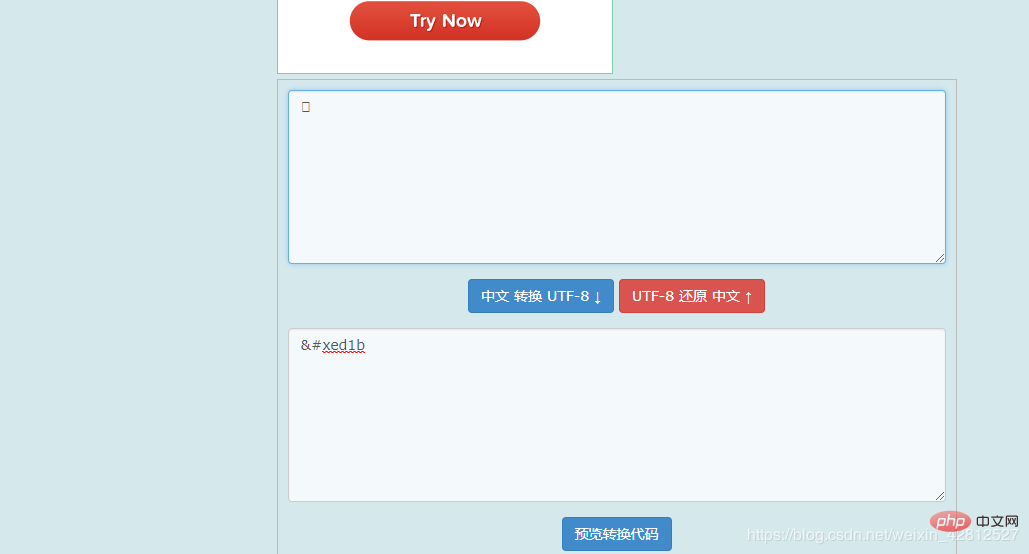

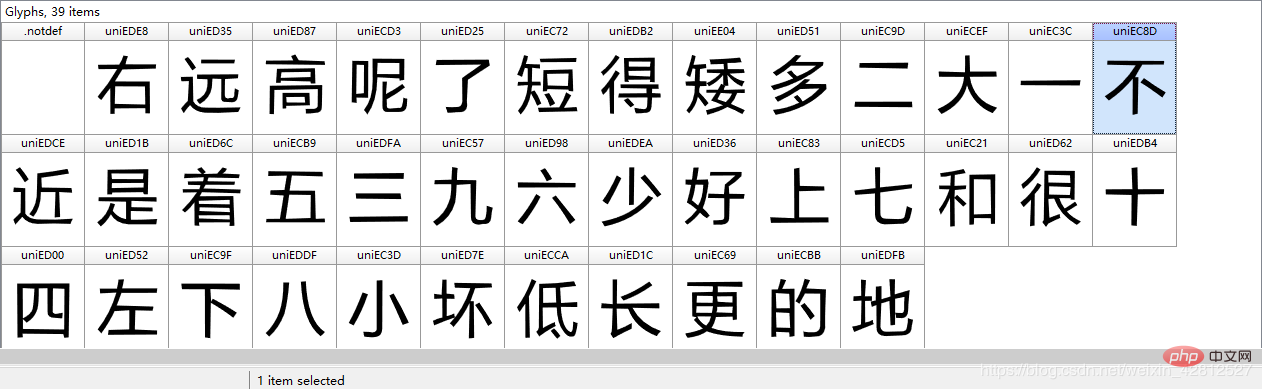

위의 각 문자는 해당 문자와 문자 코드를 표시하므로 이에 대해 생각하지 않을 수 없습니다. 이 두 글꼴은 어떻게 변환됩니까? 여러 대형 블로그를 뒤지다가 글꼴 분석을 전문으로 하는 Python 패키지, FontTools를 발견했습니다. pip installfonttools를 직접 설치하십시오. 참조 링크: https://darknode.in/font/font-tools-guide/

위의 각 문자는 해당 문자와 문자 코드를 표시하므로 이에 대해 생각하지 않을 수 없습니다. 이 두 글꼴은 어떻게 변환됩니까? 여러 대형 블로그를 뒤지다가 글꼴 분석을 전문으로 하는 Python 패키지, FontTools를 발견했습니다. pip installfonttools를 직접 설치하십시오. 참조 링크: https://darknode.in/font/font-tools-guide/

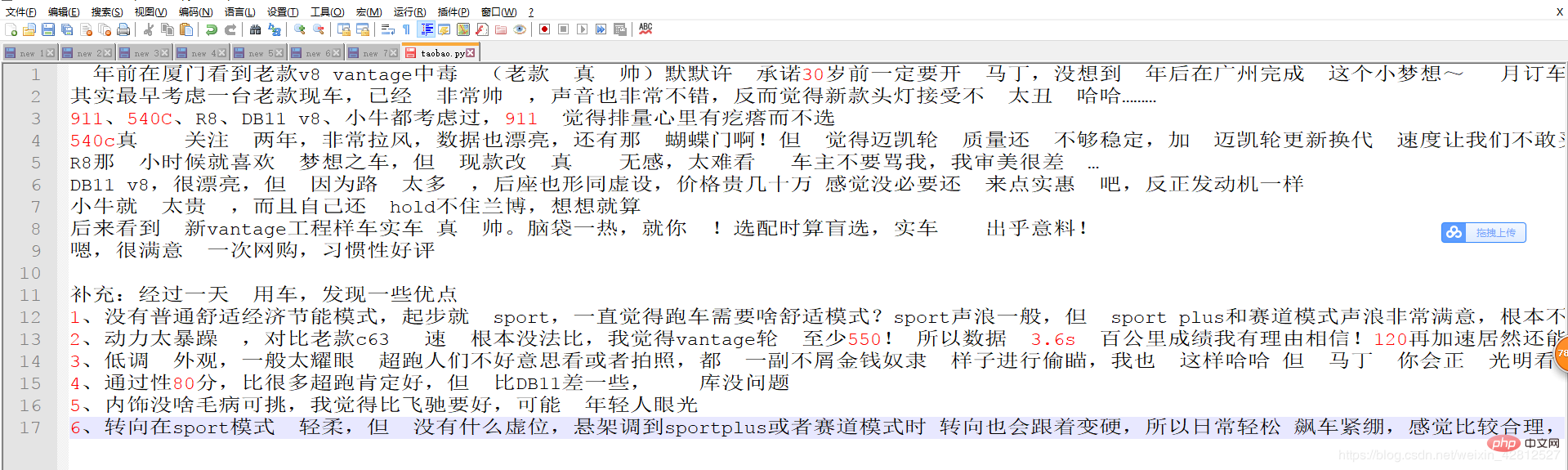

# 那么便开始通过字体库进行解析 world = TTFont('./world.ttf') # 读取响应的映射关系 uni_list = world['cmap'].tables[0].ttFont.getGlyphOrder() # 'cmap' 表示汉字对应的映射 为unicode编码 print(uni_list) # 按顺序拿到各个字符的unicode编码 # 打印结果: ['.notdef', 'uniEDE8', 'uniED35', 'uniED87', 'uniECD3', 'uniED25', 'uniEC72', 'uniEDB2', 'uniEE04', 'uniED51', 'uniEC9D', 'uniECEF', 'uniEC3C', 'uniEC8D', 'uniEDCE', 'uniED1B', 'uniED6C', 'uniECB9', 'uniEDFA', 'uniEC57', 'uniED98', 'uniEDEA', 'uniED36', 'uniEC83', 'uniECD5', 'uniEC21', 'uniED62', 'uniEDB4', 'uniED00', 'uniED52', 'uniEC9F', 'uniEDDF', 'uniEC3D', 'uniED7E', 'uniECCA', 'uniED1C', 'uniEC69', 'uniECBB', 'uniEDFB'] # .notdef 并不是汉字的映射, 而是表示字体家族名称。 将映射列表转换成unicode的类型,因为自己文中获取的是字符串unicode类型的,当然你也可以转化为utf-8,不过你获取的文章内容也要转化为utf-8 unicode_list= [eval(r"u'\u" + uni[3:] + "'") for uni in uni_list[1:]]

매핑과 관련하여 실제로 utf-8과 약간의 의심이 있습니다. 유니코드. 그게 무슨 상관이야? 자세한 설명은 Zhihu를 참조하는 것이 좋습니다:

https://www.zhihu.com/question/23374078좋아, 위에서 모든 것을 정리했습니다. 준비가 되었으니 코드를 작성해 보겠습니다.

# coding:utf-8

import re

import requests

from scrapy import Selector

from fontTools.ttLib import TTFont

class QiCheZhiJiaSpider:

def article_content(self):

url = 'https://club.autohome.com.cn/bbs/thread/2d8a42404ba24266/77486027-1.html#pvareaid=2199101'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/64.0.3282.119 Safari/537.36'

}

try:

response = requests.get(url=url, headers=headers).text

response_info = Selector(text=response)

except BaseException as e:

print(e)

else:

content = response_info.xpath('//div[@class="tz-paragraph"]//text()').extract() # 获取列表的形式内容。

# print(content)

content_str = ''.join(content)

# 紧接着获取字体的链接

world_href = re.findall(r",url\('(//.*\.ttf)'\).*", response, re.M or re.S)[0]

world_href = 'https:' + world_href

world_content = requests.get(url=world_href, headers=headers).content

# 对获取到的字体进行下载..........

with open('./world.ttf', 'wb') as f:

f.write(world_content)

# 那么便开始通过字体库进行解析

world = TTFont('./world.ttf')

# 读取响应的映射关系

uni_list = world['cmap'].tables[0].ttFont.getGlyphOrder()

unicode_list = [eval(r"u'\u" + uni[3:] + "'") for uni in uni_list[1:]]

world_list = ["右", "远", "高", "呢", "了", "短", "得", "矮", "多", "二", "大", "一", "不", "近",

"是", "着", "五", "三", "九", "六", "少", "好", "上", "七", "和", "很", "十",

"四", "左", "下", "八", "小", "坏", "低", "长", "更", "的", "地"] # # 录入字体文件中的字符。必须要以国际标准的unicode编码

for i in range(len(unicode_list )):

content_str = content_str.replace(unicode_list [i], world_list[i])

print(content_str)

if __name__ == '__main__':

qi_che_zhi_jia = QiCheZhiJiaSpider()

qi_che_zhi_jia.article_content()결과 표시:

# 🎜 🎜#

위 내용은 Python 크롤러---Autohome 글꼴 크롤링 방지의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7773

7773

15

15

1644

1644

14

14

1399

1399

52

52

1296

1296

25

25

1234

1234

29

29

Linux 터미널에서 Python 버전을 볼 때 발생하는 권한 문제를 해결하는 방법은 무엇입니까?

Apr 01, 2025 pm 05:09 PM

Linux 터미널에서 Python 버전을 볼 때 발생하는 권한 문제를 해결하는 방법은 무엇입니까?

Apr 01, 2025 pm 05:09 PM

Linux 터미널에서 Python 버전을 보려고 할 때 Linux 터미널에서 Python 버전을 볼 때 권한 문제에 대한 솔루션 ... Python을 입력하십시오 ...

중간 독서를 위해 Fiddler를 사용할 때 브라우저에서 감지되는 것을 피하는 방법은 무엇입니까?

Apr 02, 2025 am 07:15 AM

중간 독서를 위해 Fiddler를 사용할 때 브라우저에서 감지되는 것을 피하는 방법은 무엇입니까?

Apr 02, 2025 am 07:15 AM

Fiddlerevery Where를 사용할 때 Man-in-the-Middle Reading에 Fiddlereverywhere를 사용할 때 감지되는 방법 ...

한 데이터 프레임의 전체 열을 Python의 다른 구조를 가진 다른 데이터 프레임에 효율적으로 복사하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:15 PM

한 데이터 프레임의 전체 열을 Python의 다른 구조를 가진 다른 데이터 프레임에 효율적으로 복사하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:15 PM

Python의 Pandas 라이브러리를 사용할 때는 구조가 다른 두 데이터 프레임 사이에서 전체 열을 복사하는 방법이 일반적인 문제입니다. 두 개의 dats가 있다고 가정 해

10 시간 이내에 프로젝트 및 문제 중심 방법에서 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법?

Apr 02, 2025 am 07:18 AM

10 시간 이내에 프로젝트 및 문제 중심 방법에서 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법?

Apr 02, 2025 am 07:18 AM

10 시간 이내에 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법은 무엇입니까? 컴퓨터 초보자에게 프로그래밍 지식을 가르치는 데 10 시간 밖에 걸리지 않는다면 무엇을 가르치기로 선택 하시겠습니까?

Uvicorn은 Serving_forever ()없이 HTTP 요청을 어떻게 지속적으로 듣습니까?

Apr 01, 2025 pm 10:51 PM

Uvicorn은 Serving_forever ()없이 HTTP 요청을 어떻게 지속적으로 듣습니까?

Apr 01, 2025 pm 10:51 PM

Uvicorn은 HTTP 요청을 어떻게 지속적으로 듣습니까? Uvicorn은 ASGI를 기반으로 한 가벼운 웹 서버입니다. 핵심 기능 중 하나는 HTTP 요청을 듣고 진행하는 것입니다 ...

Linux 터미널에서 Python (Version 명령)을 사용할 때 권한 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:36 AM

Linux 터미널에서 Python (Version 명령)을 사용할 때 권한 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:36 AM

Linux 터미널에서 Python 사용 ...

Inversiting.com의 크롤링 메커니즘을 우회하는 방법은 무엇입니까?

Apr 02, 2025 am 07:03 AM

Inversiting.com의 크롤링 메커니즘을 우회하는 방법은 무엇입니까?

Apr 02, 2025 am 07:03 AM

Investing.com의 크롤링 전략 이해 많은 사람들이 종종 Investing.com (https://cn.investing.com/news/latest-news)에서 뉴스 데이터를 크롤링하려고합니다.