BigData 빅데이터 운영 및 유지관리

빅데이터 운영 및 유지보수

1.HDFS분산 파일 시스템 운영 및 유지보수

1.in HDFS 루트 디렉터리에 재귀 생성 파일 시스템 디렉토리 "1daoyun/file" , 첨부 파일의 BigDataSkills.txt 파일을 1daoyun/file 디렉토리에 업로드하고 관련 명령을 사용하여 파일을 확인하세요 시스템에서 1daoyun/file 디렉토리의 파일 목록 정보입니다. 2.

HDFS

파일 시스템의 루트 디렉터리에 재귀 디렉터리

"1daoyun/file"

을 만들고 첨부된 BigDataSkills.txt 를 업로드하세요. 파일을 1daoyun/ file 디렉터리를 탐색하고 HDFS File Systemcheck 도구를 사용하여 파일이 손상되었는지 확인하세요. hadoop fs -mkdir -p /1daoyun/filehadoop fs -put BigDataSkills.txt/1daoyun/filehadoop fsck /1daoyun/file/BigDataSkills.txt 3.

HDFS

파일 시스템의 루트 디렉터리에 재귀 디렉터리

"1daoyun/file"

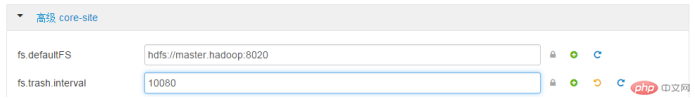

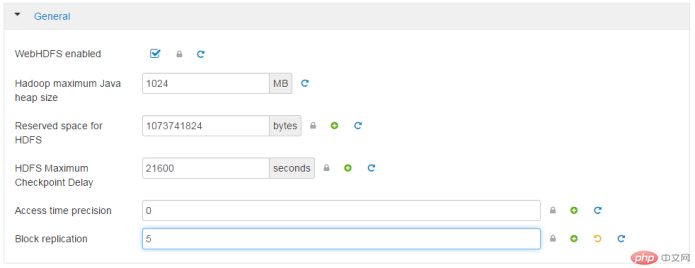

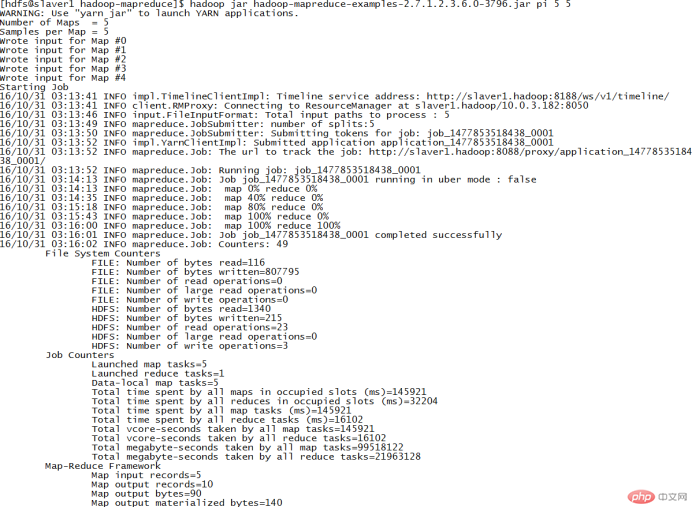

을 만들고 첨부된 BigDataSkills.txt 파일을 다음 위치에 업로드하세요. 1daoyun / 파일 디렉터리, 업로드 프로세스는 HDFS 파일 시스템의 bigdataskills.txt 파일을 2으로 지정하고 FSCK 을 사용합니다. 저장공간 확인 및 보관 블록의 복사본 수. hadoop fs -mkdir -p /1daoyun/file hadoop fs -D dfs.replication=2 -put BigDataSkills.txt /1daoyun/file hadoop fsck /1daoyun/file/BigDataSkills.txt 4.HDFS 파일 시스템의 루트 디렉토리에 /apps 파일 디렉토리가 있습니다. 이 디렉토리의 스냅샷 생성 기능을 활성화하고 스냅샷을 생성해야 합니다. Snapshot 이름은 apps_1daoyun이며, 를 사용하면 관련 명령을 사용하여 스냅샷 파일의 목록 정보를 볼 수 있습니다. hadoop dfsadmin -allowSnapshot /apps hadoop fs -createSnapshot /apps apps_1daoyun hadoop fs -ls /apps/.snapshot 5. 당 하둡 클러스터가 시작되면 먼저 안전 모드로 들어갑니다. 이 모드는 기본적으로 30 초 후에 종료됩니다. 시스템이 안전 모드에 있으면 HDFS 파일 시스템은 읽기만 가능하며 쓰기, 수정, 삭제 등의 작업을 수행할 수 없습니다. 이제 Hadoop 클러스터를 유지 관리해야 한다고 가정합니다. 클러스터를 안전 모드로 전환하고 상태를 확인해야 합니다. hdfs dfsadmin -safemode enter hdfs dfsadmin -safemode get 6.운영자가 실수로 파일을 삭제하는 것을 방지하기 위해 HDFS 파일 시스템은 다음 기능을 제공합니다. 하지만 정크 파일이 너무 많으면 저장 공간을 많이 차지하게 됩니다. Xiandian 빅 데이터 플랫폼의 WEB interface이 HDFS 파일 시스템 휴지통에 있는 파일을 완전히 삭제하는 데 필요한 기간은 7 일입니다. Advancedcore-sitefs.trash.interval: 10080 7.운영자가 실수로 파일을 삭제하는 것을 방지하기 위해 HDFS 파일 시스템에서는 휴지통 기능을 제공하지만 정크 파일이 너무 많으면 저장 공간을 많이 차지하게 됩니다. 해당 구성 파일과 매개변수 정보를 수정하고 휴지통 기능을 끄려면 Linux Shell 에서 "vi" 명령을 사용해야 합니다. 완료 후 해당 서비스를 다시 시작하세요. Advancedcore-sitefs.trash.interval: 0vi /etc/hadoop/2.4.3.0-227/0/core-site.xml sbin/stop-dfs.sh 8.Hadoop 클러스터의 호스트에 가동 중지 시간이 발생하거나 이러한 문제가 발생하면 파일 시스템의 데이터 파일이 필연적으로 손상되거나 손실됩니다. WEB 는 클러스터의 중복 복제 계수를 5로 수정합니다. 일반복제 차단5 9.Hadoop 경우에 따라 클러스터의 호스트에 가동 중지 시간이 발생하거나 시스템이 손상될 수 있습니다. 이러한 문제가 발생하면 HDFS 파일 시스템의 데이터 파일이 필연적으로 손상되거나 손상됩니다. 손실이 발생하면 HDFS 파일 시스템의 안정성을 보장하려면 클러스터의 중복 복제 요소를 Linux Shell 에서 사용되는 5, 으로 수정해야 합니다. "vi"명령어를 사용하여 해당 구성 파일 및 매개변수 정보를 수정합니다. 완료 후 해당 서비스를 다시 시작합니다. vi/etc/hadoop/2.4.3.0-227/0/hdfs-site.xml >dfs.복제< ;/이름> | sh --config /usr/hdp/current/hadoop-client/conf 중지 {namenode/datenode} /usr/ hdp/current/hadoop-client/sbin/hadoop-daemon.sh -- config /usr/hdp/current/hadoop-client/conf start {namenode/datenode} 10. hdfs /tmp . hadoop fs -count /tmp2.MapREDUCE 사례 질문 1.클러스터 노드 /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ 디렉터리에 JAR 패키지 hadoop이 있습니다. -맵리듀스 -examples.jar. PI 프로그램을 JAR 패키지에서 실행하여 piπ의 대략적인 값을 계산하려면 5번 Map 작업을 실행해야 합니다. The 작업의 던지기 횟수는 5입니다. cd hadoop jar hadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar 파이 5 5 클러스터 노드 /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ 디렉토리에 JAR이 있습니다 가방 hadoop-mapreduce-examples.jar. JAR 패키지의 wordcount 프로그램을 실행하여 /1daoyun/file/BigDataSkills.txt 파일에서 단어 계산을 수행하고 연산 결과를 /1daoyun/output 에 출력합니다. Directory 에서는 관련 명령을 사용하여 단어 수 결과를 쿼리합니다. hadoop jar/usr/hdp/2.4.3.0-227/hadoop-mapreduce/hadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar 단어 수 /1daoyun/file/BigDataSkills.txt /1daoyun/ 출력 3.클러스터 노드 /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ 디렉터리에 JAR 패키지 hadoop이 있습니다. -맵리듀스 -examples.jar. JAR 패키지의 sudoku 프로그램을 실행하여 아래 표의 스도쿠 문제 결과를 계산해 보세요. . cat puzzle1.dta hadoop jarhadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar sudoku /root/puzzle1.dta 4 . 클러스터 노드 /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ 디렉터리에 JAR 패키지 hadoop-mapreduce-examples.jar이 있습니다. . JAR 패키지에서 grep 프로그램을 실행하여 "Hadoop" 이 파일 시스템 /1daoyun/file/BigDataSkills.txt 에 나타나는 횟수를 계산합니다. 는 완료 후 통계결과 정보를 조회해 보세요. hadoop jarhadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar grep /1daoyun/file/BigDataSkills.txt /output hadoop

또는

또는  2.

2.

위 내용은 BigData 빅데이터 운영 및 유지관리의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7514

7514

15

15

1378

1378

52

52

79

79

11

11

53

53

19

19

19

19

64

64

패턴 매칭을 위해 Linux에서 정규식 (Regex)을 어떻게 사용합니까?

Mar 17, 2025 pm 05:25 PM

패턴 매칭을 위해 Linux에서 정규식 (Regex)을 어떻게 사용합니까?

Mar 17, 2025 pm 05:25 PM

이 기사는 패턴 매칭, 파일 검색 및 텍스트 조작을 위해 Linux에서 정규식 (Regex)을 사용하는 방법, 구문, 명령 및 Grep, Sed 및 Awk와 같은 도구를 자세히 설명합니다.

Top, HTOP 및 VMSTAT와 같은 도구를 사용하여 Linux에서 시스템 성능을 모니터링하려면 어떻게해야합니까?

Mar 17, 2025 pm 05:28 PM

Top, HTOP 및 VMSTAT와 같은 도구를 사용하여 Linux에서 시스템 성능을 모니터링하려면 어떻게해야합니까?

Mar 17, 2025 pm 05:28 PM

이 기사는 Linux 시스템 성능을 모니터링하기위한 Top, HTOP 및 VMSTAT 사용에 대해 설명하고 효과적인 시스템 관리를위한 고유 한 기능 및 사용자 정의 옵션을 자세히 설명합니다.

Linux에서 SSH에 대해 2 단계 인증 (2FA)을 구현하려면 어떻게합니까?

Mar 17, 2025 pm 05:31 PM

Linux에서 SSH에 대해 2 단계 인증 (2FA)을 구현하려면 어떻게합니까?

Mar 17, 2025 pm 05:31 PM

이 기사는 Google Authenticator를 사용하여 Linux에서 SSH에 대한 2 단계 인증 (2FA) 설정, 설치, 구성 및 문제 해결 단계에 대한 가이드를 제공합니다. Enhanced SEC와 같은 2FA의 보안 이점을 강조합니다.

패키지 관리자 (APT, YUM, DNF)를 사용하여 Linux에서 소프트웨어 패키지를 어떻게 관리합니까?

Mar 17, 2025 pm 05:26 PM

패키지 관리자 (APT, YUM, DNF)를 사용하여 Linux에서 소프트웨어 패키지를 어떻게 관리합니까?

Mar 17, 2025 pm 05:26 PM

기사는 APT, YUM 및 DNF를 사용하여 Linux의 소프트웨어 패키지 관리, 설치, 업데이트 및 제거를 다루는 것에 대해 설명합니다. 다양한 분포에 대한 기능과 적합성을 비교합니다.

Sudo를 사용하여 Linux의 사용자에게 높은 권한을 부여하는 방법은 무엇입니까?

Mar 17, 2025 pm 05:32 PM

Sudo를 사용하여 Linux의 사용자에게 높은 권한을 부여하는 방법은 무엇입니까?

Mar 17, 2025 pm 05:32 PM

이 기사는 Linux의 Sudo 권한을 관리하는 방법, 보안 및 보안 모범 사례를 포함하여 Linux의 Sudo 권한을 관리하는 방법을 설명합니다. 주요 초점은 /etc /sudoers를 안전하게 편집하고 액세스를 제한하는 데 중점을 둡니다. 문자 수 : 159

주요 Linux 운영 : 초보자 가이드

Apr 09, 2025 pm 04:09 PM

주요 Linux 운영 : 초보자 가이드

Apr 09, 2025 pm 04:09 PM

Linux 초보자는 파일 관리, 사용자 관리 및 네트워크 구성과 같은 기본 작업을 마스터해야합니다. 1) 파일 관리 : mkdir, touch, ls, rm, mv 및 cp 명령을 사용하십시오. 2) 사용자 관리 : userAdd, passwd, userdel 및 usermod 명령을 사용합니다. 3) 네트워크 구성 : ifconfig, echo 및 ufw 명령을 사용하십시오. 이러한 운영은 Linux 시스템 관리의 기초이며, 마스터하면 시스템을 효과적으로 관리 할 수 있습니다.

Linux의 5 기둥 : 역할 이해

Apr 11, 2025 am 12:07 AM

Linux의 5 기둥 : 역할 이해

Apr 11, 2025 am 12:07 AM

Linux 시스템의 5 개의 기둥은 다음과 같습니다. 1. Kernel, 2. System Library, 3. Shell, 4. 파일 시스템, 5. 시스템 도구. 커널은 하드웨어 리소스를 관리하고 기본 서비스를 제공합니다. 시스템 라이브러리는 애플리케이션에 대한 사전 컴파일 된 기능을 제공합니다. 쉘은 사용자가 시스템과 상호 작용할 수있는 인터페이스입니다. 파일 시스템은 데이터를 구성하고 저장합니다. 시스템 도구는 시스템 관리 및 유지 보수에 사용됩니다.

리눅스 유지 보수 모드 : 도구 및 기술

Apr 10, 2025 am 09:42 AM

리눅스 유지 보수 모드 : 도구 및 기술

Apr 10, 2025 am 09:42 AM

Linux 시스템에서 시작시 특정 키를 누르거나 "sudosystemctlrescue"와 같은 명령을 사용하여 유지 보수 모드를 입력 할 수 있습니다. 유지 보수 모드는 관리자가 파일 시스템 수리, 비밀번호 재설정, 보안 취약성 패치 등과 같은 간섭없이 시스템 유지 관리 및 문제 해결을 수행 할 수 있습니다.