K8s에 Redis 클러스터 배포 소개

1. 소개

아키텍처 원리: 각 마스터는 여러 슬레이브를 가질 수 있습니다. 마스터가 오프라인이 되면 Redis 클러스터는 여러 슬레이브에서 새 마스터를 교체로 선택하고, 이전 마스터는 다시 온라인 상태가 되면 새 마스터의 슬레이브가 됩니다.

권장(무료): redis

2. 준비 작업

이 배포는 주로 다음 프로젝트를 기반으로 합니다.

https://github.com/zuxqoj/kubernetes-redis-cluster

Redis 클러스터를 배포하는 두 가지 방법이 포함되어 있습니다:

StatefulSet

Service&Deployment

두 방법 모두 장점과 단점이 있습니다. Redis, Mongodb, Zookeeper 등과 같은 상태 저장 서비스의 경우 StatefulSet을 사용하는 것이 선호됩니다. 이 글에서는 주로 StatefulSet을 사용하여 Redis 클러스터를 배포하는 방법을 소개합니다.

3. StatefulSet 소개

RC, 배포 및 DaemonSet는 모두 상태 비저장 서비스입니다. 그들이 관리하는 Pod의 IP, 이름, 시작-중지 시퀀스 등은 모두 무작위입니다. 이름에서 알 수 있듯이 상태 저장 컬렉션은 MySQL, MongoDB 클러스터 등과 같은 모든 상태 저장 서비스를 관리합니다.

StatefulSet은 기본적으로 배포의 변형입니다. v1.9에서는 상태 저장 서비스의 문제를 해결하기 위해 관리하는 포드에 포드 이름이 고정되어 있고 포드 이름이 시작됩니다. 네트워크 식별자(호스트 이름)라고 하며, 공유 저장소도 사용해야 합니다.

Deployment에서는 해당 서비스가 service이고, StatefulSet에서는 headless service, 즉 headless service에 해당합니다. 서비스와의 차이점은 Cluster IP가 없으며, 실행 시 반환됩니다. 헤드리스 서비스에 해당하는 모든 포드의 엔드포인트 목록을 파싱합니다.

또한 StatefulSet은 Headless Service를 기반으로 StatefulSet이 제어하는 각 Pod 복사본에 대해 DNS 도메인 이름을 생성합니다. 이 도메인 이름의 형식은

$(podname).(headless server name) FQDN: $(podname).(headless server name).namespace.svc.cluster.local

즉, Stateful 서비스의 경우 최선을 다하는 것입니다. 고정된 네트워크 식별자(도메인 이름 정보 등)를 사용하여 노드를 표시합니다. 물론 이를 위해서는 애플리케이션의 지원도 필요합니다(예를 들어 Zookeeper는 구성 파일에 호스트 도메인 이름 쓰기를 지원합니다).

StatefulSet는 헤드리스 서비스(즉, 클러스터 IP가 없는 서비스)(팟의 호스트 이름 및 DNS 레코드 포함)를 기반으로 포드에 대한 안정적인 네트워크 플래그를 구현하며, 이는 포드가 다시 예약된 후에도 변경되지 않습니다. 동시에 StatefulSet은 PV/PVC와 결합하여 안정적인 영구 스토리지를 달성할 수 있으며, 포드가 다시 예약된 후에도 원본 영구 데이터에 계속 액세스할 수 있습니다.

다음은 StatefulSet을 사용하여 Redis를 배포하는 아키텍처입니다. 마스터이든 슬레이브이든 StatefulSet의 복사본이며 데이터는 PV를 통해 유지되고 클라이언트 요청을 수락하기 위해 서비스로 노출됩니다.

4. 배포 프로세스

이 문서에서는 StatefulSet을 기반으로 Redis를 생성하는 단계를 간략하게 소개하는 프로젝트의 README를 참조합니다.

1 NFS 스토리지 생성

2. PV 생성

3. PVC 생성

4 . Configmap 생성

5 .헤드리스 서비스 생성

6. Redis StatefulSet 생성

7. Redis 클러스터 초기화

여기에서는 위의 단계를 참고하여 작업을 연습하고 Redis 클러스터의 배포 과정을 자세히 소개하겠습니다. . 이 글에서는 많은 K8S 개념을 미리 이해하고 배울 수 있기를 바랍니다

1. NFS 저장소 생성

NFS 저장소 생성은 주로 Redis Pod를 다시 시작하거나 마이그레이션할 때 안정적인 백엔드 저장소를 제공하기 위한 것입니다. , 여전히 원본 데이터를 얻을 수 있습니다. 여기서는 먼저 NFS를 생성한 후 PV를 사용하여 Redis용 원격 NFS 경로를 마운트합니다.

NFS 설치

yum -y install nfs-utils(主包提供文件系统) yum -y install rpcbind(提供rpc协议)

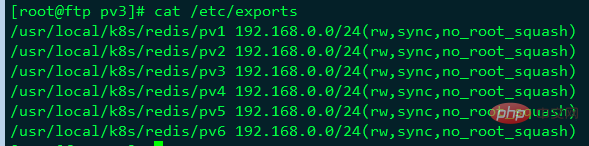

그런 다음 /etc/exports 파일을 추가하여 공유할 경로를 설정합니다.

[root@ftp pv3]# cat /etc/exports /usr/local/k8s/redis/pv1 192.168.0.0/24(rw,sync,no_root_squash) /usr/local/k8s/redis/pv2 192.168.0.0/24(rw,sync,no_root_squash) /usr/local/k8s/redis/pv3 192.168.0.0/24(rw,sync,no_root_squash) /usr/local/k8s/redis/pv4 192.168.0.0/24(rw,sync,no_root_squash) /usr/local/k8s/redis/pv5 192.168.0.0/24(rw,sync,no_root_squash) /usr/local/k8s/redis/pv6 192.168.0.0/24(rw,sync,no_root_squash)

해당 디렉터리를 만듭니다.

[root@ftp quizii]# mkdir -p /usr/local/k8s/redis/pv{1..6}그런 다음 NFS 및 rpcbind 서비스를 시작합니다.

systemctl restart rpcbind systemctl restart nfs systemctl enable nfs

[root@ftp pv3]# exportfs -v /usr/local/k8s/redis/pv1 192.168.0.0/24(sync,wdelay,hide,no_subtree_check,sec=sys,rw,secure,no_root_squash,no_all_squash) /usr/local/k8s/redis/pv2 192.168.0.0/24(sync,wdelay,hide,no_subtree_check,sec=sys,rw,secure,no_root_squash,no_all_squash) /usr/local/k8s/redis/pv3 192.168.0.0/24(sync,wdelay,hide,no_subtree_check,sec=sys,rw,secure,no_root_squash,no_all_squash) /usr/local/k8s/redis/pv4 192.168.0.0/24(sync,wdelay,hide,no_subtree_check,sec=sys,rw,secure,no_root_squash,no_all_squash) /usr/local/k8s/redis/pv5 192.168.0.0/24(sync,wdelay,hide,no_subtree_check,sec=sys,rw,secure,no_root_squash,no_all_squash) /usr/local/k8s/redis/pv6 192.168.0.0/24(sync,wdelay,hide,no_subtree_check,sec=sys,rw,secure,no_root_squash,no_all_squash)

고객 종료

yum -y install nfs-utils

저장소 보기 종료 공유

[root@node2 ~]# showmount -e 192.168.0.222 Export list for 192.168.0.222: /usr/local/k8s/redis/pv6 192.168.0.0/24 /usr/local/k8s/redis/pv5 192.168.0.0/24 /usr/local/k8s/redis/pv4 192.168.0.0/24 /usr/local/k8s/redis/pv3 192.168.0.0/24 /usr/local/k8s/redis/pv2 192.168.0.0/24 /usr/local/k8s/redis/pv1 192.168.0.0/24

Create PV

각 Redis Pod에는 자체 데이터를 저장하기 위해 독립적인 PV가 필요하므로 6개의 PV가 포함된 pv.yaml 파일을 생성할 수 있습니다.

[root@master redis]# cat pv.yaml apiVersion: v1 kind: PersistentVolume metadata: name: nfs-pv1 spec: capacity: storage: 200M accessModes: - ReadWriteMany nfs: server: 192.168.0.222 path: "/usr/local/k8s/redis/pv1" --- apiVersion: v1 kind: PersistentVolume metadata: name: nfs-vp2 spec: capacity: storage: 200M accessModes: - ReadWriteMany nfs: server: 192.168.0.222 path: "/usr/local/k8s/redis/pv2" --- apiVersion: v1 kind: PersistentVolume metadata: name: nfs-pv3 spec: capacity: storage: 200M accessModes: - ReadWriteMany nfs: server: 192.168.0.222 path: "/usr/local/k8s/redis/pv3" --- apiVersion: v1 kind: PersistentVolume metadata: name: nfs-pv4 spec: capacity: storage: 200M accessModes: - ReadWriteMany nfs: server: 192.168.0.222 path: "/usr/local/k8s/redis/pv4" --- apiVersion: v1 kind: PersistentVolume metadata: name: nfs-pv5 spec: capacity: storage: 200M accessModes: - ReadWriteMany nfs: server: 192.168.0.222 path: "/usr/local/k8s/redis/pv5" --- apiVersion: v1 kind: PersistentVolume metadata: name: nfs-pv6 spec: capacity: storage: 200M accessModes: - ReadWriteMany nfs: server: 192.168.0.222 path: "/usr/local/k8s/redis/pv6"

위와 같이 다음을 수행할 수 있습니다. 모든 PV는 이름과 장착 경로를 제외하면 기본적으로 동일함을 알 수 있습니다. 생성을 실행하세요:

[root@master redis]#kubectl create -f pv.yaml persistentvolume "nfs-pv1" created persistentvolume "nfs-pv2" created persistentvolume "nfs-pv3" created persistentvolume "nfs-pv4" created persistentvolume "nfs-pv5" created persistentvolume "nfs-pv6" created

2. Create Configmap

여기에서 Redis 구성 파일을 구성을 읽는 더 편리한 방법인 Configmap으로 직접 변환할 수 있습니다. redis.conf 구성 파일은 다음과 같습니다

[root@master redis]# cat redis.conf appendonly yes cluster-enabled yes cluster-config-file /var/lib/redis/nodes.conf cluster-node-timeout 5000 dir /var/lib/redis port 6379

redis-conf라는 Configmap을 생성합니다:

kubectl create configmap redis-conf --from-file=redis.conf

생성된 configmap 보기:

[root@master redis]# kubectl describe cm redis-conf Name: redis-conf Namespace: default Labels: <none> Annotations: <none> Data ==== redis.conf: ---- appendonly yes cluster-enabled yes cluster-config-file /var/lib/redis/nodes.conf cluster-node-timeout 5000 dir /var/lib/redis port 6379 Events: <none></none></none></none>

위와 같이 redis.conf의 모든 구성 항목은 Configmap redis-conf에 저장됩니다.

3. Headless 서비스 생성

Headless 서비스는 StatefulSet이 안정적인 네트워크 식별을 달성하기 위한 기반이며, 이를 미리 생성해야 합니다. 다음과 같이 headless-service.yml 파일을 준비합니다.

[root@master redis]# cat headless-service.yaml apiVersion: v1 kind: Service metadata: name: redis-service labels: app: redis spec: ports: - name: redis-port port: 6379 clusterIP: None selector: app: redis appCluster: redis-cluster

생성:

kubectl create -f headless-service.yml

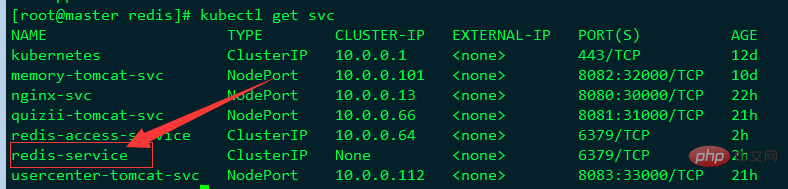

보기:

서비스 이름이 redis-service이고 CLUSTER-IP가 None인 것을 볼 수 있습니다. 이는 이것이 "headless"임을 나타냅니다. " 서비스.

4.创建Redis 集群节点

创建好Headless service后,就可以利用StatefulSet创建Redis 集群节点,这也是本文的核心内容。我们先创建redis.yml文件:

[root@master redis]# cat redis.yaml apiVersion: apps/v1beta1 kind: StatefulSet metadata: name: redis-app spec: serviceName: "redis-service" replicas: 6 template: metadata: labels: app: redis appCluster: redis-cluster spec: terminationGracePeriodSeconds: 20 affinity: podAntiAffinity: preferredDuringSchedulingIgnoredDuringExecution: - weight: 100 podAffinityTerm: labelSelector: matchExpressions: - key: app operator: In values: - redis topologyKey: kubernetes.io/hostname containers: - name: redis image: redis command: - "redis-server" args: - "/etc/redis/redis.conf" - "--protected-mode" - "no" resources: requests: cpu: "100m" memory: "100Mi" ports: - name: redis containerPort: 6379 protocol: "TCP" - name: cluster containerPort: 16379 protocol: "TCP" volumeMounts: - name: "redis-conf" mountPath: "/etc/redis" - name: "redis-data" mountPath: "/var/lib/redis" volumes: - name: "redis-conf" configMap: name: "redis-conf" items: - key: "redis.conf" path: "redis.conf" volumeClaimTemplates: - metadata: name: redis-data spec: accessModes: [ "ReadWriteMany" ] resources: requests: storage: 200M

如上,总共创建了6个Redis节点(Pod),其中3个将用于master,另外3个分别作为master的slave;Redis的配置通过volume将之前生成的redis-conf这个Configmap,挂载到了容器的/etc/redis/redis.conf;Redis的数据存储路径使用volumeClaimTemplates声明(也就是PVC),其会绑定到我们先前创建的PV上。

这里有一个关键概念——Affinity,请参考官方文档详细了解。其中,podAntiAffinity表示反亲和性,其决定了某个pod不可以和哪些Pod部署在同一拓扑域,可以用于将一个服务的POD分散在不同的主机或者拓扑域中,提高服务本身的稳定性。

而PreferredDuringSchedulingIgnoredDuringExecution 则表示,在调度期间尽量满足亲和性或者反亲和性规则,如果不能满足规则,POD也有可能被调度到对应的主机上。在之后的运行过程中,系统不会再检查这些规则是否满足。

在这里,matchExpressions规定了Redis Pod要尽量不要调度到包含app为redis的Node上,也即是说已经存在Redis的Node上尽量不要再分配Redis Pod了。但是,由于我们只有三个Node,而副本有6个,因此根据PreferredDuringSchedulingIgnoredDuringExecution,这些豌豆不得不得挤一挤,挤挤更健康~

另外,根据StatefulSet的规则,我们生成的Redis的6个Pod的hostname会被依次命名为 $(statefulset名称)-$(序号) 如下图所示:

[root@master redis]# kubectl get pods -o wide NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE redis-app-0 1/1 Running 0 2h 172.17.24.3 192.168.0.144 <none> redis-app-1 1/1 Running 0 2h 172.17.63.8 192.168.0.148 <none> redis-app-2 1/1 Running 0 2h 172.17.24.8 192.168.0.144 <none> redis-app-3 1/1 Running 0 2h 172.17.63.9 192.168.0.148 <none> redis-app-4 1/1 Running 0 2h 172.17.24.9 192.168.0.144 <none> redis-app-5 1/1 Running 0 2h 172.17.63.10 192.168.0.148 <none></none></none></none></none></none></none>

如上,可以看到这些Pods在部署时是以{0…N-1}的顺序依次创建的。注意,直到redis-app-0状态启动后达到Running状态之后,redis-app-1 才开始启动。

同时,每个Pod都会得到集群内的一个DNS域名,格式为$(podname).$(service name).$(namespace).svc.cluster.local ,也即是:

redis-app-0.redis-service.default.svc.cluster.local redis-app-1.redis-service.default.svc.cluster.local ...以此类推...

在K8S集群内部,这些Pod就可以利用该域名互相通信。我们可以使用busybox镜像的nslookup检验这些域名:

[root@master redis]# kubectl exec -ti busybox -- nslookup redis-app-0.redis-service Server: 10.0.0.2 Address 1: 10.0.0.2 kube-dns.kube-system.svc.cluster.local Name: redis-app-0.redis-service Address 1: 172.17.24.3

可以看到, redis-app-0的IP为172.17.24.3。当然,若Redis Pod迁移或是重启(我们可以手动删除掉一个Redis Pod来测试),IP是会改变的,但是Pod的域名、SRV records、A record都不会改变。

另外可以发现,我们之前创建的pv都被成功绑定了:

[root@master redis]# kubectl get pv NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE nfs-pv1 200M RWX Retain Bound default/redis-data-redis-app-2 3h nfs-pv3 200M RWX Retain Bound default/redis-data-redis-app-4 3h nfs-pv4 200M RWX Retain Bound default/redis-data-redis-app-5 3h nfs-pv5 200M RWX Retain Bound default/redis-data-redis-app-1 3h nfs-pv6 200M RWX Retain Bound default/redis-data-redis-app-0 3h nfs-vp2 200M RWX Retain Bound default/redis-data-redis-app-3 3h

5.初始化Redis集群

创建好6个Redis Pod后,我们还需要利用常用的Redis-tribe工具进行集群的初始化

创建Ubuntu容器

由于Redis集群必须在所有节点启动后才能进行初始化,而如果将初始化逻辑写入Statefulset中,则是一件非常复杂而且低效的行为。这里,本人不得不称赞一下原项目作者的思路,值得学习。也就是说,我们可以在K8S上创建一个额外的容器,专门用于进行K8S集群内部某些服务的管理控制。

这里,我们专门启动一个Ubuntu的容器,可以在该容器中安装Redis-tribe,进而初始化Redis集群,执行:

kubectl run -it ubuntu --image=ubuntu --restart=Never /bin/bash

我们使用阿里云的Ubuntu源,执行:

root@ubuntu:/# cat > /etc/apt/sources.list EOF

成功后,原项目要求执行如下命令安装基本的软件环境:

apt-get update apt-get install -y vim wget python2.7 python-pip redis-tools dnsutils

初始化集群

首先,我们需要安装redis-trib:

pip install redis-trib==0.5.1

然后,创建只有Master节点的集群:

redis-trib.py create \ `dig +short redis-app-0.redis-service.default.svc.cluster.local`:6379 \ `dig +short redis-app-1.redis-service.default.svc.cluster.local`:6379 \ `dig +short redis-app-2.redis-service.default.svc.cluster.local`:6379

其次,为每个Master添加Slave

redis-trib.py replicate \ --master-addr `dig +short redis-app-0.redis-service.default.svc.cluster.local`:6379 \ --slave-addr `dig +short redis-app-3.redis-service.default.svc.cluster.local`:6379 redis-trib.py replicate \ --master-addr `dig +short redis-app-1.redis-service.default.svc.cluster.local`:6379 \ --slave-addr `dig +short redis-app-4.redis-service.default.svc.cluster.local`:6379 redis-trib.py replicate \ --master-addr `dig +short redis-app-2.redis-service.default.svc.cluster.local`:6379 \ --slave-addr `dig +short redis-app-5.redis-service.default.svc.cluster.local`:6379

至此,我们的Redis集群就真正创建完毕了,连到任意一个Redis Pod中检验一下:

[root@master redis]# kubectl exec -it redis-app-2 /bin/bash root@redis-app-2:/data# /usr/local/bin/redis-cli -c 127.0.0.1:6379> cluster nodes 5d3e77f6131c6f272576530b23d1cd7592942eec 172.17.24.3:6379@16379 master - 0 1559628533000 1 connected 0-5461 a4b529c40a920da314c6c93d17dc603625d6412c 172.17.63.10:6379@16379 master - 0 1559628531670 6 connected 10923-16383 368971dc8916611a86577a8726e4f1f3a69c5eb7 172.17.24.9:6379@16379 slave 0025e6140f85cb243c60c214467b7e77bf819ae3 0 1559628533672 4 connected 0025e6140f85cb243c60c214467b7e77bf819ae3 172.17.63.8:6379@16379 master - 0 1559628533000 2 connected 5462-10922 6d5ee94b78b279e7d3c77a55437695662e8c039e 172.17.24.8:6379@16379 myself,slave a4b529c40a920da314c6c93d17dc603625d6412c 0 1559628532000 5 connected 2eb3e06ce914e0e285d6284c4df32573e318bc01 172.17.63.9:6379@16379 slave 5d3e77f6131c6f272576530b23d1cd7592942eec 0 1559628533000 3 connected 127.0.0.1:6379> cluster info cluster_state:ok cluster_slots_assigned:16384 cluster_slots_ok:16384 cluster_slots_pfail:0 cluster_slots_fail:0 cluster_known_nodes:6 cluster_size:3 cluster_current_epoch:6 cluster_my_epoch:6 cluster_stats_messages_ping_sent:14910 cluster_stats_messages_pong_sent:15139 cluster_stats_messages_sent:30049 cluster_stats_messages_ping_received:15139 cluster_stats_messages_pong_received:14910 cluster_stats_messages_received:30049 127.0.0.1:6379>

另外,还可以在NFS上查看Redis挂载的数据:

[root@ftp pv3]# ll /usr/local/k8s/redis/pv3 total 12 -rw-r--r-- 1 root root 92 Jun 4 11:36 appendonly.aof -rw-r--r-- 1 root root 175 Jun 4 11:36 dump.rdb -rw-r--r-- 1 root root 794 Jun 4 11:49 nodes.conf

6.创建用于访问Service

前面我们创建了用于实现StatefulSet的Headless Service,但该Service没有Cluster Ip,因此不能用于外界访问。所以,我们还需要创建一个Service,专用于为Redis集群提供访问和负载均衡:

[root@master redis]# cat redis-access-service.yaml apiVersion: v1 kind: Service metadata: name: redis-access-service labels: app: redis spec: ports: - name: redis-port protocol: "TCP" port: 6379 targetPort: 6379 selector: app: redis appCluster: redis-cluster

如上,该Service名称为 redis-access-service,在K8S集群中暴露6379端口,并且会对labels name为app: redis或appCluster: redis-cluster的pod进行负载均衡。

创建后查看:

[root@master redis]# kubectl get svc redis-access-service -o wide NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR redis-access-service ClusterIP 10.0.0.64 <none> 6379/TCP 2h app=redis,appCluster=redis-cluster</none>

如上,在K8S集群中,所有应用都可以通过10.0.0.64 :6379来访问Redis集群。当然,为了方便测试,我们也可以为Service添加一个NodePort映射到物理机上,这里不再详细介绍。

五、测试主从切换

在K8S上搭建完好Redis集群后,我们最关心的就是其原有的高可用机制是否正常。这里,我们可以任意挑选一个Master的Pod来测试集群的主从切换机制,如redis-app-0:

[root@master redis]# kubectl get pods redis-app-0 -o wide NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE redis-app-1 1/1 Running 0 3h 172.17.24.3 192.168.0.144 <none></none>

进入redis-app-0查看:

[root@master redis]# kubectl exec -it redis-app-0 /bin/bash root@redis-app-0:/data# /usr/local/bin/redis-cli -c 127.0.0.1:6379> role 1) "master" 2) (integer) 13370 3) 1) 1) "172.17.63.9" 2) "6379" 3) "13370" 127.0.0.1:6379>

如上可以看到,app-0为master,slave为172.17.63.9即redis-app-3。

接着,我们手动删除redis-app-0:

[root@master redis]# kubectl delete pod redis-app-0 pod "redis-app-0" deleted [root@master redis]# kubectl get pod redis-app-0 -o wide NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE redis-app-0 1/1 Running 0 4m 172.17.24.3 192.168.0.144 <none></none>

我们再进入redis-app-0内部查看:

[root@master redis]# kubectl exec -it redis-app-0 /bin/bash root@redis-app-0:/data# /usr/local/bin/redis-cli -c 127.0.0.1:6379> role 1) "slave" 2) "172.17.63.9" 3) (integer) 6379 4) "connected" 5) (integer) 13958

如上,redis-app-0变成了slave,从属于它之前的从节点172.17.63.9即redis-app-3。

六、疑问

至此,大家可能会疑惑,那为什么没有使用稳定的标志,Redis Pod也能正常进行故障转移呢?这涉及了Redis本身的机制。因为,Redis集群中每个节点都有自己的NodeId(保存在自动生成的nodes.conf中),并且该NodeId不会随着IP的变化和变化,这其实也是一种固定的网络标志。也就是说,就算某个Redis Pod重启了,该Pod依然会加载保存的NodeId来维持自己的身份。我们可以在NFS上查看redis-app-1的nodes.conf文件:

[root@k8s-node2 ~]# cat /usr/local/k8s/redis/pv1/nodes.conf 96689f2018089173e528d3a71c4ef10af68ee462 192.168.169.209:6379@16379 slave d884c4971de9748f99b10d14678d864187a9e5d3 0 1526460952651 4 connected237d46046d9b75a6822f02523ab894928e2300e6 192.168.169.200:6379@16379 slave c15f378a604ee5b200f06cc23e9371cbc04f4559 0 1526460952651 1 connected

c15f378a604ee5b200f06cc23e9371cbc04f4559 192.168.169.197:6379@16379 master - 0 1526460952651 1 connected 10923-16383d884c4971de9748f99b10d14678d864187a9e5d3 192.168.169.205:6379@16379 master - 0 1526460952651 4 connected 5462-10922c3b4ae23c80ffe31b7b34ef29dd6f8d73beaf85f 192.168.169.198:6379@16379 myself,slave c8a8f70b4c29333de6039c47b2f3453ed11fb5c2 0 1526460952565 3 connected

c8a8f70b4c29333de6039c47b2f3453ed11fb5c2 192.168.169.201:6379@16379 master - 0 1526460952651 6 connected 0-5461vars currentEpoch 6 lastVoteEpoch 4

如上,第一列为NodeId,稳定不变;第二列为IP和端口信息,可能会改变。

这里,我们介绍NodeId的两种使用场景:

当某个Slave Pod断线重连后IP改变,但是Master发现其NodeId依旧, 就认为该Slave还是之前的Slave。

当某个Master Pod下线后,集群在其Slave中选举重新的Master。待旧Master上线后,集群发现其NodeId依旧,会让旧Master变成新Master的slave。

对于这两种场景,大家有兴趣的话还可以自行测试,注意要观察Redis的日志。

위 내용은 K8s에 Redis 클러스터 배포 소개의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7675

7675

15

15

1393

1393

52

52

1207

1207

24

24

91

91

11

11

73

73

19

19

k8s 서비스 springboot 프로젝트 애플리케이션을 업그레이드할 때 502 오류를 해결하는 방법

May 11, 2023 pm 10:28 PM

k8s 서비스 springboot 프로젝트 애플리케이션을 업그레이드할 때 502 오류를 해결하는 방법

May 11, 2023 pm 10:28 PM

점점 더 많은 인터넷 회사가 작은 단계와 빠른 반복의 개발 모델을 인식하고 채택함에 따라 애플리케이션 변경 및 업그레이드 빈도가 점점 더 빈번해지고 있습니다. 다양한 업그레이드 요구 사항에 대처하고 업그레이드 프로세스가 원활하게 진행되도록 하기 위해 일련의 배포 및 릴리스 모델이 탄생했습니다. 종료 릴리스 - 이전 버전의 애플리케이션 인스턴스를 완전히 중지한 다음 새 버전을 릴리스합니다. 이번 출시 모델은 주로 새 버전과 이전 버전 간의 비호환성 및 공존 불가능 문제를 해결하기 위한 것입니다. 단점은 일정 기간 동안 서비스를 완전히 사용할 수 없다는 것입니다. 블루-그린 릴리스 - 동일한 수의 신규 및 기존 버전 애플리케이션 인스턴스를 동시에 온라인으로 배포합니다. 새 버전이 테스트를 통과하면 트래픽이 즉시 새 서비스 인스턴스로 전환됩니다. 이 게시 모델은 가동 중지 시간 게시 시 전체 서비스를 사용할 수 없는 문제를 해결하지만 상대적으로 큰

ThinkPHP6을 사용하여 Redis 클러스터 구현

Jun 20, 2023 am 08:36 AM

ThinkPHP6을 사용하여 Redis 클러스터 구현

Jun 20, 2023 am 08:36 AM

인터넷의 급속한 발전으로 인해 높은 동시성 문제가 점점 더 두드러지고 있습니다. 이러한 문제에 대한 대응으로 Redis의 등장은 메모리 읽기 및 쓰기를 통해 기존 관계형 데이터베이스의 과도한 읽기 및 쓰기 부담 문제를 해결하는 중요한 솔루션이 되었습니다. 그러나 단일 노드 Redis는 높은 동시성 조건에서 여전히 성능 병목 현상이 발생하므로 Redis 클러스터를 사용해야 합니다. 이 문서에서는 ThinkPHP6을 사용하여 Redis 클러스터를 구현하는 방법을 설명합니다. 1. Redis Cluster 소개 Redis Cluster는 Redis에서 제공하는 공식 클러스터이다.

k8s에 Redis 클러스터를 배포하는 방법

May 31, 2023 pm 05:25 PM

k8s에 Redis 클러스터를 배포하는 방법

May 31, 2023 pm 05:25 PM

redis 클러스터 구축 1.1 redis-cli를 사용하여 클러스터를 생성합니다. #redis 포드에 해당하는 ipkubectlgetpod-njxbp-owide를 확인하세요.>NAMEREADYSTATUSRESARTSAGEIPNODENOMINATEDNODEREADINESSGATESredis-01/1Running018h10.168.235.196k8s-masterredis-11/1Running018h10.168.235. 225 k8s-masterredis-21 /1실행018h10.168 .

Redis를 통해 PHP 데이터 캐시의 클러스터 배포를 구현하는 방법은 무엇입니까?

Aug 10, 2023 am 08:13 AM

Redis를 통해 PHP 데이터 캐시의 클러스터 배포를 구현하는 방법은 무엇입니까?

Aug 10, 2023 am 08:13 AM

Redis를 통해 PHP 데이터 캐시의 클러스터 배포를 구현하는 방법은 무엇입니까? 소개: PHP 애플리케이션이 높은 동시성과 대규모 트래픽에 직면할 때 종종 데이터베이스 성능 병목 현상이 발생합니다. 이때 캐싱 기술을 사용하면 시스템의 성능과 동시성을 크게 향상시킬 수 있습니다. 고성능 인메모리 키-값 데이터베이스인 Redis는 캐싱 솔루션 구현에 널리 사용됩니다. 이 기사에서는 Redis를 통해 PHP 데이터 캐시의 클러스터 배포를 구현하여 성능과 확장성을 더욱 향상시키는 방법을 소개합니다. 1. Redis 클러스터 Redis 개요

k8s에 Java 프로젝트를 배포하는 방법

May 15, 2023 pm 06:07 PM

k8s에 Java 프로젝트를 배포하는 방법

May 15, 2023 pm 06:07 PM

서문 Java 프로젝트는 개발 및 디버깅 과정에서 다양한 환경에서 설치 및 배포가 필요합니다. 과거에는 가상 머신 배포를 사용할 때 머신에서 명령을 실행하거나 Jenkins 스크립트를 구성하여 배포를 자동화했습니다. 그러나 컨테이너 환경에서 고가용성 프로젝트를 설치 및 배포하려면 컨테이너화 기술과 k8s 스케줄링 및 실행이 필요합니다. 일반적으로 공식 환경에서는 컨테이너화된 배포를 구성하기 위해 다음과 같은 부분을 갖습니다. 컨테이너 환경 dockerContainerdk8s 클러스터 k8s 관리 시스템 KubeSoheredashboard(k8s 자체 관리 시스템) 미러 웨어하우스 Dockerhub Registryharbor 코드 웨어하우스 githubgitlab

springboot 프로젝트를 k8s에 배포하는 방법

May 15, 2023 am 10:04 AM

springboot 프로젝트를 k8s에 배포하는 방법

May 15, 2023 am 10:04 AM

springboot를 k8s에 배포하는 단계 이미지 웨어하우스에 배포된 Springboot 프로젝트 패키징 이미지 프라이빗 이미지 웨어하우스에 로그인하고 이미지 가져오기 배포 생성 서비스 액세스 포트 노출 프라이빗 웨어하우스에 로그인하려면 비밀을 생성해야 합니다. docker 레지스트리의 인증 정보를 저장합니다. secret~$kubectlcreatesecretdocker-registryfdf-docker -secret--docker-server=registry.cn-chengdu.aliyuncs.com--docker-username=176을 생성합니다.

Redis 및 Node.js 클러스터 솔루션: 고가용성을 달성하는 방법

Jul 29, 2023 pm 05:42 PM

Redis 및 Node.js 클러스터 솔루션: 고가용성을 달성하는 방법

Jul 29, 2023 pm 05:42 PM

Redis 및 Node.js용 클러스터 솔루션: 고가용성을 달성하는 방법 소개: 인터넷의 급속한 발전으로 인해 데이터 처리가 점점 더 커지고 복잡해졌습니다. 시스템의 고가용성과 확장성을 보장하려면 분산 클러스터 아키텍처를 사용하여 대량의 데이터를 저장하고 처리해야 하는 요구 사항을 처리해야 합니다. 고성능 인메모리 데이터베이스인 Redis는 백엔드 프로그래밍 언어인 Node.js와 결합되어 가용성이 높은 분산 클러스터 솔루션을 구축할 수 있습니다. 이 기사에서는 Redis와 Node.js를 사용하여 구현하는 방법을 소개합니다.