Python을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법을 사용하여 많은 수의 이미지를 다운로드하는 방법은 무엇입니까? 다음 기사에서는 Python을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법을 사용하여 여러 스레드와 동시에 이미지를 다운로드하는 방법을 소개합니다. 도움이 되기를 바랍니다.

때로는 많은 수의 이미지를 다운로드하는 데 몇 시간이 걸리기도 합니다. 문제를 해결해 보겠습니다.

알겠습니다. 프로그램이 이미지를 다운로드할 때까지 기다리는 데 지쳤습니다. 때로는 몇 시간이 걸리는 수천 장의 이미지를 다운로드해야 하며, 프로그램이 이러한 어리석은 이미지 다운로드를 완료할 때까지 계속 기다릴 수 없습니다. 해야 할 중요한 일이 많이 있습니다.

텍스트 파일을 읽고 폴더에 나열된 모든 이미지를 초고속으로 다운로드하는 간단한 이미지 다운로더 스크립트를 만들어 보겠습니다.

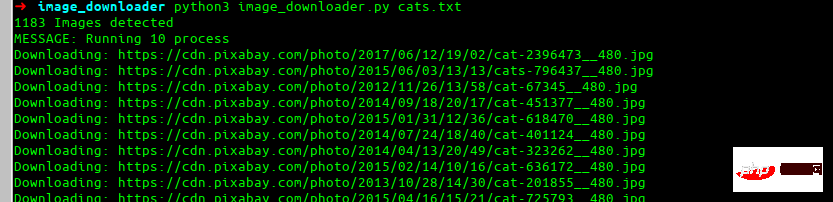

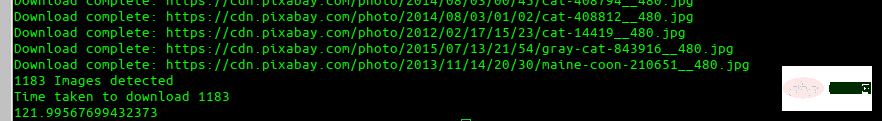

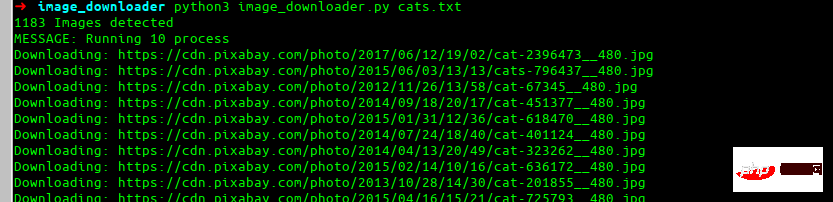

이것이 우리가 결국 만들게 될 것입니다.

모두가 좋아하는 요청 라이브러리를 설치해 봅시다.

pip install requests

이제 단일 URL을 다운로드하고 이미지 이름을 자동으로 찾는 몇 가지 기본 코드와 재시도 사용 방법을 살펴보겠습니다.

import requests

res = requests.get(img_url, stream=True)

count = 1

while res.status_code != 200 and count <= 5:

res = requests.get(img_url, stream=True)

print(f'Retry: {count} {img_url}')

count += 1여기에서는 실패할 경우를 대비해 이미지 다운로드를 5번 다시 시도합니다. 이제 자동으로 이미지 이름을 찾아 저장해 보겠습니다.

import more required library

import io

from PIL import Image

# lets try to find the image name

image_name = str(img_url[(img_url.rfind('/')) + 1:])

if '?' in image_name:

image_name = image_name[:image_name.find('?')]우리가 다운로드하려는 URL이

instagram.fktm7-1.fna.fbcdn.net/vp...

아, 이건 엉망입니다. URL에 대해 코드가 수행하는 작업을 분석해 보겠습니다. 먼저 rfind를 사용하여 마지막 슬래시(/)를 찾은 다음 그 뒤의 모든 항목을 선택합니다. 결과는 다음과 같습니다. rfind 找到最后一个正斜杠(/),然后选择之后的所有内容。这是结果:

65872070_1200425330158967_6201268309743367902_n.jpg?_nc_ht=instagram.fktm7–1.fna.fbcdn.net&_nc_cat=111

现在我们的第二部分找到一个 ?,然后只取它前面的任何东西。

这是我们最终的图像名称:

65872070_1200425330158967_6201268309743367902_n.jpg

这个结果非常好,适用于大多数用例。

现在我们已经下载了图像名称和图像,我们将保存它。

i = Image.open(io.BytesIO(res.content)) i.save(image_name)

如果你在想,「我到底应该怎么使用上面的代码?」那么你的想法是正确的。这是一个漂亮的函数,我们在上面所做的一切都被扁平处理了。在这里,我们还测试了下载的类型是否为图像,以防找不到图像名称。

def image_downloader(img_url: str):

"""

Input:

param: img_url str (Image url)

Tries to download the image url and use name provided in headers. Else it randomly picks a name

"""

print(f'Downloading: {img_url}')

res = requests.get(img_url, stream=True)

count = 1

while res.status_code != 200 and count <= 5:

res = requests.get(img_url, stream=True)

print(f'Retry: {count} {img_url}')

count += 1

# checking the type for image

if 'image' not in res.headers.get("content-type", ''):

print('ERROR: URL doesnot appear to be an image')

return False

# Trying to red image name from response headers

try:

image_name = str(img_url[(img_url.rfind('/')) + 1:])

if '?' in image_name:

image_name = image_name[:image_name.find('?')]

except:

image_name = str(random.randint(11111, 99999))+'.jpg'

i = Image.open(io.BytesIO(res.content))

download_location = 'cats'

i.save(download_location + '/'+image_name)

return f'Download complete: {img_url}'现在,你可能会问:「这个人所说的多处理在哪里?」。

这很简单。我们将简单地定义我们的池并将我们的函数和图像 URL 传递给它。

results = ThreadPool(process).imap_unordered(image_downloader, images_url)

for r in results:

print(r)让我们把它放在一个函数中:

def run_downloader(process:int, images_url:list):

"""

Inputs:

process: (int) number of process to run

images_url:(list) list of images url

"""

print(f'MESSAGE: Running {process} process')

results = ThreadPool(process).imap_unordered(image_downloader, images_url)

for r in results:

print(r)再一次,你可能会说,「这一切都很好,但我想立即开始下载我的 1000 张图像列表。我不想复制和粘贴所有这些代码并试图弄清楚如何合并所有内容。」

这是一个完整的脚本。它执行以下操作:

以图像列表文本文件和进程号作为输入

按照您想要的速度下载它们

打印下载文件的总时间

还有一些不错的函数可以帮助我们读取文件名并处理错误和其他东西

# -*- coding: utf-8 -*-

import io

import random

import shutil

import sys

from multiprocessing.pool import ThreadPool

import pathlib

import requests

from PIL import Image

import time

start = time.time()

def get_download_location():

try:

url_input = sys.argv[1]

except IndexError:

print('ERROR: Please provide the txt file\n$python image_downloader.py cats.txt')

name = url_input.split('.')[0]

pathlib.Path(name).mkdir(parents=True, exist_ok=True)

return name

def get_urls():

"""

通过读取终端中作为参数提供的 txt 文件返回 url 列表

"""

try:

url_input = sys.argv[1]

except IndexError:

print('ERROR: Please provide the txt file\n Example \n\n$python image_downloader.py dogs.txt \n\n')

sys.exit()

with open(url_input, 'r') as f:

images_url = f.read().splitlines()

print('{} Images detected'.format(len(images_url)))

return images_url

def image_downloader(img_url: str):

"""

输入选项:

参数: img_url str (Image url)

尝试下载图像 url 并使用标题中提供的名称。否则它会随机选择一个名字

"""

print(f'Downloading: {img_url}')

res = requests.get(img_url, stream=True)

count = 1

while res.status_code != 200 and count <= 5:

res = requests.get(img_url, stream=True)

print(f'Retry: {count} {img_url}')

count += 1

# checking the type for image

if 'image' not in res.headers.get("content-type", ''):

print('ERROR: URL doesnot appear to be an image')

return False

# Trying to red image name from response headers

try:

image_name = str(img_url[(img_url.rfind('/')) + 1:])

if '?' in image_name:

image_name = image_name[:image_name.find('?')]

except:

image_name = str(random.randint(11111, 99999))+'.jpg'

i = Image.open(io.BytesIO(res.content))

download_location = get_download_location()

i.save(download_location + '/'+image_name)

return f'Download complete: {img_url}'

def run_downloader(process:int, images_url:list):

"""

输入项:

process: (int) number of process to run

images_url:(list) list of images url

"""

print(f'MESSAGE: Running {process} process')

results = ThreadPool(process).imap_unordered(image_downloader, images_url)

for r in results:

print(r)

try:

num_process = int(sys.argv[2])

except:

num_process = 10

images_url = get_urls()

run_downloader(num_process, images_url)

end = time.time()

print('Time taken to download {}'.format(len(get_urls())))

print(end - start)将其保存到 Python을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법 文件中,然后运行它。

python3 image_downloader.py cats.txt

这是 GitHub 存储库的链接。

python3 image_downloader.py <filename_with_urls_seperated_by_newline.txt> <num_of_process>

这将读取文本文件中的所有 URL,并将它们下载到名称与文件名相同的文件夹中。

num_of_process

65872070_1200425330158967_6201268309743367902_n.jpg?_nc_ht=instagram.fktm7–1.fna.fbcdn.net&_nc_cat=111이제 두 번째 부분적으로 <코드를 찾습니다. >? 무엇이든 받아들이세요. 앞쪽.

최종 이미지 이름은 다음과 같습니다.

python3 image_downloader.py cats.txt

num_of_process는 선택 사항입니다(기본적으로 10개의 프로세스를 사용함). 🎜🎜🎜🎜예🎜🎜🎜rrreee🎜🎜🎜🎜🎜🎜🎜이 문제를 더욱 개선하는 방법에 대한 답변을 보내주시면 기쁠 것입니다. 🎜🎜【관련 추천: 🎜Python을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법3 비디오 튜토리얼🎜】🎜위 내용은 Python을 사용하여 여러 스레드로 동시에 이미지를 다운로드하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!