중국 의사와 Google 과학자들은 최근 비디오에서 여러 이벤트를 구별하고 설명할 수 있는 사전 훈련된 시각적 언어 모델 Vid2Seq를 제안했습니다. 이 논문은 CVPR 2023에 승인되었습니다.

최근 Google 연구원들은 다중 이벤트 비디오를 설명하기 위해 사전 훈련된 시각적 언어 모델인 Vid2Seq를 제안했으며 이는 CVPR23에서 승인되었습니다.

이전에는 비디오에 다양한 시간 규모에서 발생하는 여러 이벤트가 포함되어 있는 경우가 많았기 때문에 비디오 콘텐츠를 이해하는 것이 어려운 작업이었습니다.

예를 들어 머셔가 개를 썰매에 묶은 후 개가 달리기 시작하는 영상에는 긴 이벤트(개썰매)와 짧은 이벤트(개가 썰매에 묶여 있음)가 포함됩니다.

비디오 이해 연구를 발전시키는 한 가지 방법은 1분 길이의 비디오에서 모든 이벤트를 시간적으로 찾고 설명하는 조밀한 비디오 주석 작업을 이용하는 것입니다.

문서 주소: https://arxiv.org/abs/2302.14115

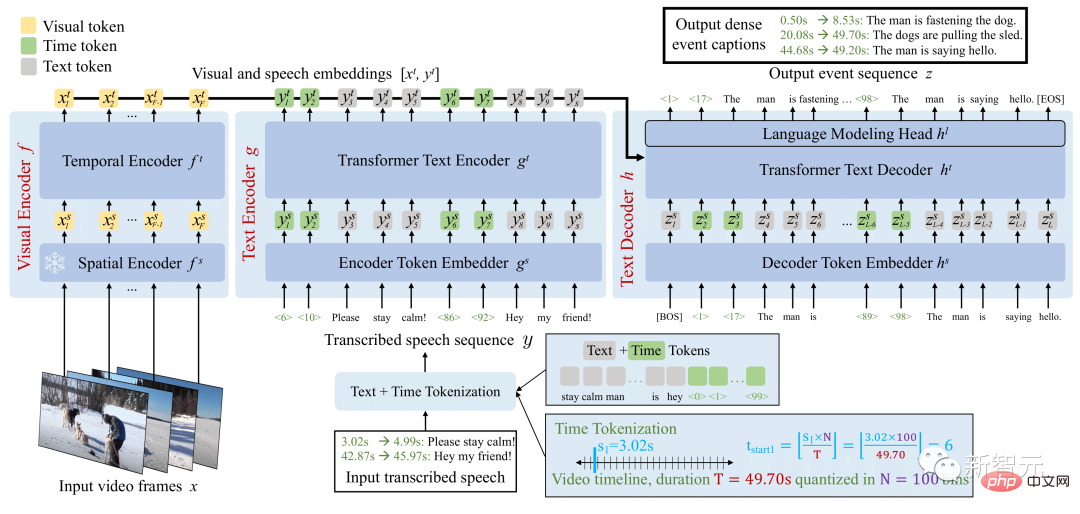

Vid2Seq 아키텍처는 특수 타임 스탬프를 사용하여 언어 모델을 향상시켜 동일한 출력 시퀀스에서 이벤트 경계와 텍스트 설명을 원활하게 예측할 수 있습니다.

이 통합 모델을 사전 훈련하기 위해 연구원들은 전사된 음성의 문장 경계를 의사 이벤트 경계로 재구성하고 전사된 음성 문장을 의사 이벤트 주석으로 사용하여 레이블이 없는 내레이션 비디오를 활용했습니다. ”

Vid2Seq는 또한 몇 장의 밀도가 높은 비디오 주석 설정, 비디오 세그먼트 주석 작업 및 표준 비디오 주석 작업에도 적합합니다.

촘촘한 비디오 주석을 위한 시각적 언어 모델

Multimodal Transformer 아키텍처는 동작 인식과 같은 다양한 비디오 작업의 SOTA를 새롭게 개선했습니다. 그러나 몇 분 길이의 비디오에서 이벤트를 공동으로 찾고 주석을 추가하는 복잡한 작업에 이러한 아키텍처를 적용하는 것은 간단하지 않습니다.

이 목표를 달성하기 위해 연구자들은 공간 영역의 Pix2Seq와 유사하게 비디오의 개별 타임스탬프를 나타내는 특수 시간 마커(예: 텍스트 마커)를 사용하여 시각적 언어 모델을 향상합니다.

대규모 비디오 사전 훈련

조밀한 비디오 주석을 위한 주석을 수동으로 수집하는 작업은 집약적인 작업 특성으로 인해 특히 비용이 많이 듭니다.

따라서 연구원들은 대규모로 쉽게 사용할 수 있는 레이블이 없는 내레이션 비디오를 사용하여 Vid2Seq 모델을 사전 훈련했습니다. 또한 광범위한 도메인을 다루는 1,800만 개의 내레이션 비디오가 포함된 YT-Temporal-1B 데이터 세트를 사용했습니다.

사전 훈련된 Vid2Seq 결과 모델은 교사 강제를 사용하는 간단한 최대 우도 목표를 통해 다운스트림 작업에서 미세 조정할 수 있습니다(예: 이전 정답 토큰이 다음 토큰을 예측하는 경우).

미세 조정 후 Vid2Seq는 3개의 표준 다운스트림 밀도 비디오 주석 벤치마크(ActivityNet Captions, YouCook2 및 ViTT)와 2개의 비디오 클립 주석 벤치마크(MSR-VTT, MSVD)에서 SOTA를 능가합니다.

논문에는 추가적인 절제 연구, 정성적 결과, 퓨샷 설정 및 비디오 단락 주석 작업 결과가 나와 있습니다.

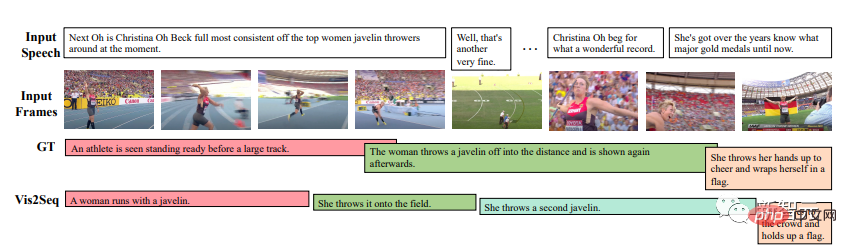

결과는 Vid2Seq가 의미 있는 이벤트 경계 및 주석을 예측할 수 있으며 예측된 주석 및 경계가 전사된 음성 입력과 크게 다르다는 것을 보여줍니다(이는 또한 입력에서 시각적 마커의 중요성을 보여줍니다).

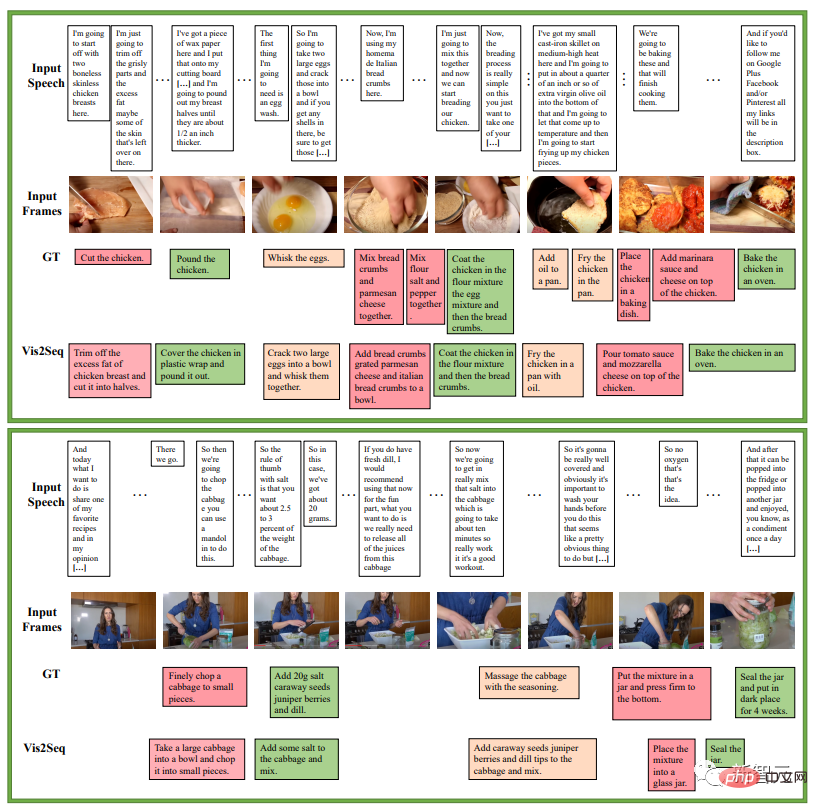

다음 예는 요리 레시피의 일련의 지침에 대한 것입니다. 이는 YouCook2 검증 세트에 대한 Vid2Seq의 조밀한 이벤트 주석 예측의 예입니다.

다음은 요리 레시피에 대한 Vid2Seq의 조밀한 이벤트 주석입니다. ActivityNet 캡션 검증 세트 예측 예제, 이 모든 비디오에는 녹음된 음성이 없습니다.

그러나 여전히 실패하는 경우가 있습니다. 예를 들어 Vid2Seq에 따르면 아래 빨간색으로 표시된 사진은 카메라 앞에서 모자를 벗는 사람입니다.

표 5는 Vid2Seq를 가장 진보된 고밀도 비디오 주석 방법과 비교합니다. Vid2Seq는 YouCook2, ViTT 및 ActivityNet Captions의 세 가지 데이터 세트에서 SOTA를 새로 고칩니다.

YouCook2 및 ActivityNet 캡션에 대한 Vid2Seq의 SODA 지표는 PDVC 및 UEDVC보다 각각 3.5포인트 및 0.3포인트 더 높습니다. 그리고 E2ESG는 Wikihow에서 도메인 내 일반 텍스트 사전 학습을 사용하며 Vid2Seq는 이 방법보다 낫습니다. 이러한 결과는 사전 훈련된 Vid2Seq 모델이 밀집 이벤트에 레이블을 지정하는 강력한 능력을 가지고 있음을 보여줍니다.

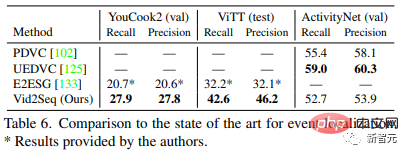

표 6은 조밀한 비디오 주석 모델의 이벤트 위치 파악 성능을 평가합니다. YouCook2 및 ViTT와 비교하여 Vid2Seq는 단일 시퀀스 생성 작업으로 조밀한 비디오 주석을 처리하는 데 탁월합니다.

그러나 Vid2Seq는 PDVC 및 UEDVC에 비해 ActivityNet 캡션에서 제대로 작동하지 않습니다. 이 두 가지 방법에 비해 Vid2Seq는 시간적 위치 파악에 대한 사전 지식이 덜 통합된 반면, 다른 두 가지 방법에는 이벤트 카운터와 같은 작업별 구성 요소가 포함되거나 위치 확인 하위 작업에 대해 별도로 모델을 교육합니다.

시각적 시간 변환기 인코더, 텍스트 인코더 및 텍스트 디코더는 모두 12개의 레이어, 12개의 헤드, 임베딩 차원 768, MLP 숨겨진 차원 2048을 갖습니다.

텍스트 인코더 및 디코더의 시퀀스는 사전 훈련 중에 L=S=1000 토큰으로 잘리거나 채워지고 미세 조정 중에 S=1000 및 L=256 토큰으로 채워집니다. 추론 중에는 빔 검색 디코딩이 사용되며 처음 4개 시퀀스가 추적되고 0.6의 길이 정규화가 적용됩니다.

저자는 가중치 감소 없이 Adam 최적화 프로그램인 β=(0.9, 0.999)를 사용합니다.

사전 훈련 중에는 1e^-4의 학습률이 사용되며 처음 1000회 반복 동안 선형적으로 워밍업(0부터 시작)되고 나머지 반복 동안 일정하게 유지됩니다.

미세 조정 중에 학습률 3e^-4를 사용하고 처음 10% 반복에서는 선형적으로 워밍업(0부터 시작)하고 나머지 90% 반복에서는 코사인 감쇠(0까지)를 유지합니다. 이 과정에서 32개 동영상의 배치 크기가 사용되어 16개의 TPU v4 칩에 나누어집니다.

저자는 YouCook2에 40번의 에포크 조정, ActivityNet Captions 및 ViTT에 20번의 에포크 조정, MSR-VTT에 5번의 에포크 조정, MSVD에 10번의 에포크 조정을 했습니다.

Google이 제안한 Vid2Seq는 Dense Video Annotation을 위한 새로운 시각적 언어 모델로, 라벨이 지정되지 않은 내레이션 비디오에 대해 대규모 사전 학습을 효과적으로 수행할 수 있으며 다양한 다운스트림 Dense Video Annotation을 수행할 수 있다는 벤치마크 결과를 얻었습니다.

저자 소개

논문의 제1저자: Antoine Yang

Antoine Yang은 파리의 Inria 및 École Normale Supérieure의 WILLOW 팀에서 박사 과정을 밟고 있는 3학년 학생입니다. 그의 지도교수는 Antoine Miech, Josef Sivic, Ivan Laptev 및 Cordelia Schmid입니다.

현재 연구는 비디오 이해를 위한 시각적 언어 모델 학습에 중점을 두고 있습니다. 그는 2019년 화웨이 노아의 방주 연구소에서 인턴으로 일했고, 파리 에콜 폴리테크니크에서 공학 학위를, 2020년 파리 사클레 국립대학교에서 수학, 비전, 학습 분야 석사 학위를 받았으며, 2022년에는 구글 리서치에서 인턴으로 일했다.

위 내용은 Google, 멀티 모달 Vid2Seq 출시, 온라인으로 비디오 IQ 이해, 자막은 CVPR 2023에 존재하지 않음 |의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!