Alpaca에 이어 Stanford는 CMU, UC Berkeley 및 기타 기관의 학자들과 함께 단돈 300달러로 ChatGPT 성능의 90%를 달성할 수 있는 130억 매개변수 모델 Vicuna를 다시 한번 출시했습니다.

Meta의 LLaMA 모델이 오픈 소스로 공개된 후 AI 업계의 연구자들은 이 모델을 기반으로 많은 버전을 파생해 왔습니다.

얼마 전 스탠포드에서 Meta의 LLaMA 7B를 미세 조정한 Alpaca를 출시했는데, 52k 데이터만 사용하고 성능은 GPT-3.5에 맞먹습니다.

오늘 스탠포드 학자들은 CMU, UC Berkeley 등과 팀을 이루어 새로운 모델인 130억 매개변수의 비쿠나, 흔히 "작은 알파카"(라마)로 알려진 새로운 모델을 다시 출시했습니다.

Vicuna는 ShareGPT에서 수집한 사용자 공유 대화에 대해 LLaMA를 미세 조정하여 훈련하며, 훈련 비용은 거의 US$300입니다.

연구원들은 수학, 작문, 코딩 등 8개의 질문 카테고리를 설계하고 Vicuna-13B 및 기타 4개 모델에 대한 성능 테스트를 실시했습니다.

테스트 과정에서는 GPT-4를 평가 표준으로 사용했으며, 결과에 따르면 Vicuna-13B는 90% 이상의 경우에서 ChatGPT 및 Bard에 필적하는 기능을 달성하는 것으로 나타났습니다.

동시에 90% 이상의 사례에서 LLaMA, 스탠포드 알파카 등 다른 모델보다 성능이 뛰어납니다.

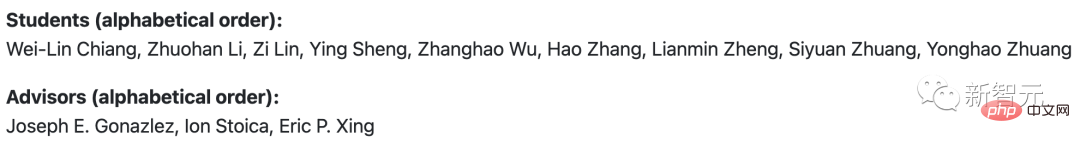

팀 구성원은 UC Berkeley, Carnegie Mellon University, Stanford University, UC San Diego 및 Bin Zayed University for Artificial Intelligence 출신입니다.

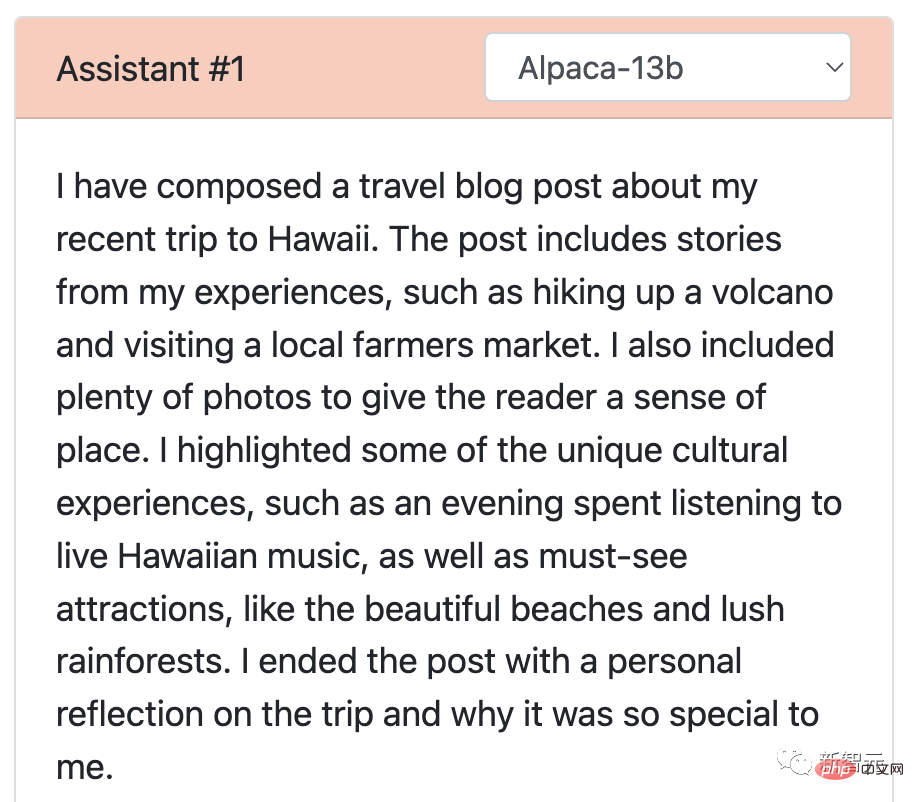

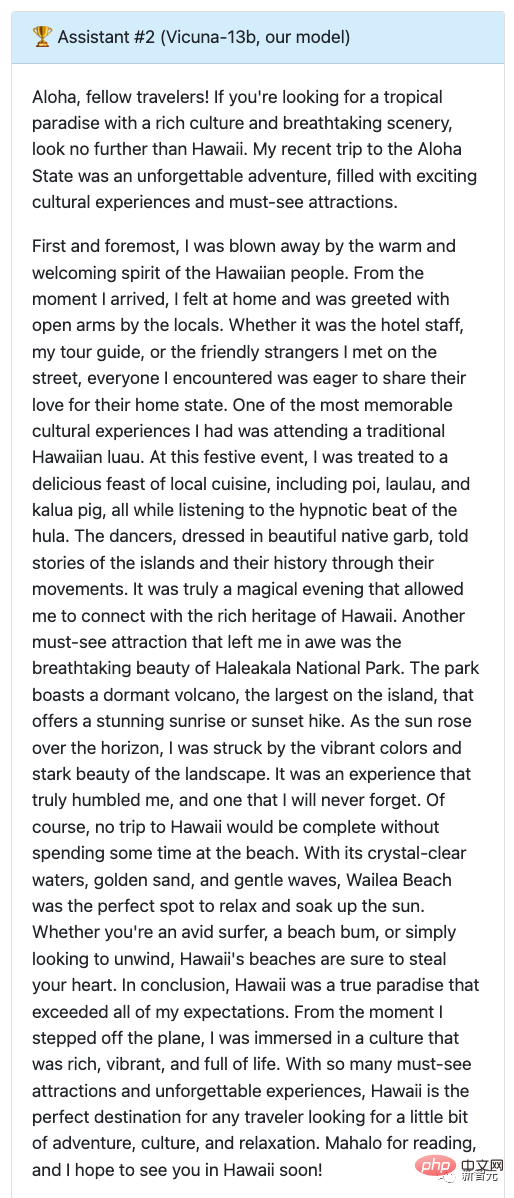

연구원들은 스탠포드의 Alpaca와 Vicuna에게 큰 경쟁을 요청하고 벤치마크 질문에 대한 답변을 각각 시연했습니다.

70,000명의 사용자가 공유한 ChatGPT 대화 데이터를 사용하여 Vicuna를 미세 조정한 후, 연구 결과 Vicuna가 Alpaca보다 더 상세하고 잘 구성된 답변을 생성할 수 있는 것으로 나타났습니다.

Q: 문화 체험과 꼭 봐야 할 명소를 강조하면서 최근 하와이 여행에 대한 재미있는 여행 블로그 게시물을 작성하세요.

알파카의 답변은 축약형이라고 할 수 있습니다. 단 몇 줄로 작성되었으며 요구되는 작업을 완료하지 못했습니다. 단순히 그가 블로그를 작성했다고 언급하고 블로그 내용에 대한 개요를 제공했습니다.

흥미로울 뿐만 아니라 하와이의 문화 체험과 꼭 가봐야 할 명소에 대해 자세히 설명하는 상세하고 매력적인 여행 블로그 게시물을 작성한 Vicuna를 다시 만나보세요.

이로부터 GPT-4가 점수를 주고 알파카는 7점, 비쿠나는 만점을 받게 됩니다.

그렇다면 Vicuna는 ChatGPT를 상대로 어떤 성적을 거두었나요?

둘다 9점 획득!

보시다시피, 하와이 여행을 제안하는 두 모델의 글은 재미있을 뿐만 아니라 유창하게 쓰여졌습니다.

또한 두 모델 모두 디테일과 정확성이 뛰어나며, 두 모델 모두 하와이 여행의 설렘과 아름다움을 효과적으로 전달하고 있습니다.

또한 연구원들은 LLaMA와 Google의 Bard 모델을 사용하여 Vicuna를 테스트한 결과 LLaMA가 가장 나쁜 성능(1점)을 보여 거의 응답이 없는 것으로 나타났습니다.

Bard 답변의 정확도와 관련성 역시 9점으로 상대적으로 높지만, 더 매력적인 답변이라는 점에서는 Vicuna보다 약간 낮습니다.

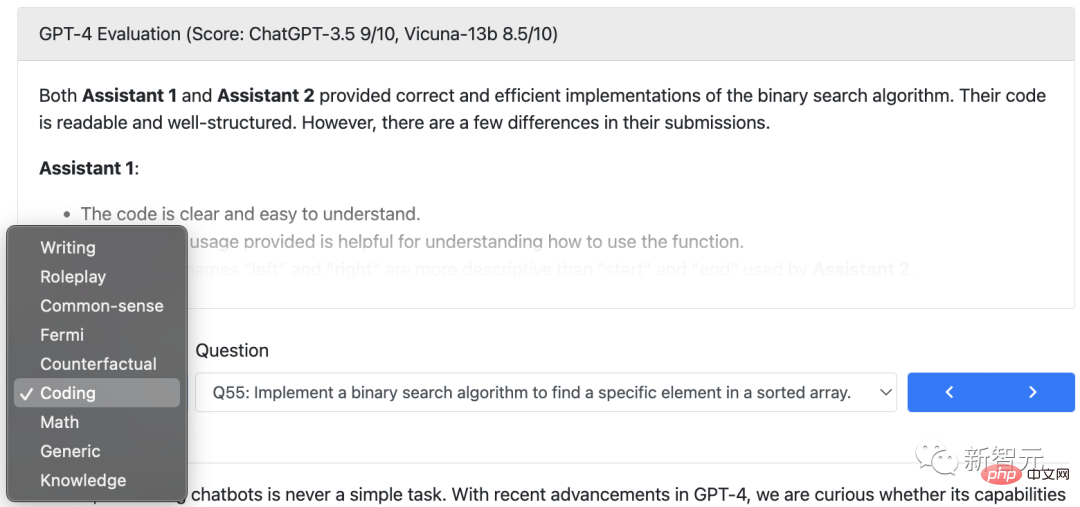

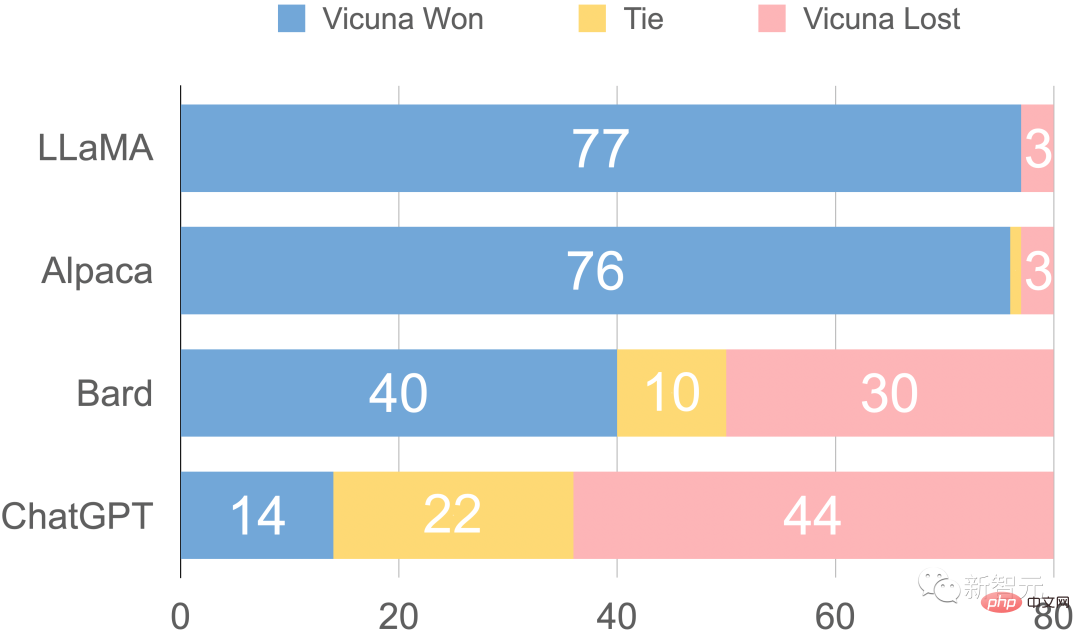

작문 외에도 연구원들은 총 80개의 질문을 통해 코딩, 수학, 역할극, 일반 지식 등에서 Vicuna 모델의 기능을 다른 4개 모델과 비교했습니다.

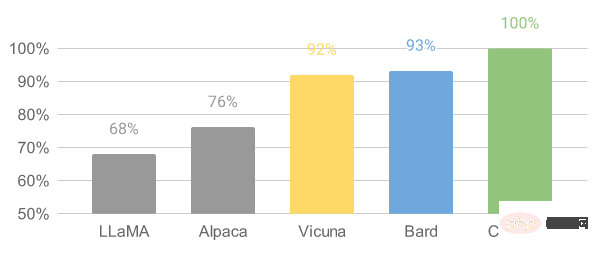

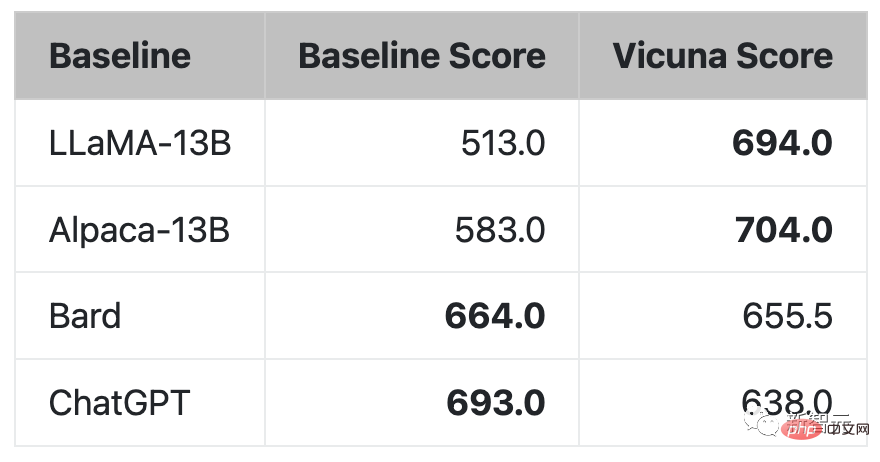

마지막으로 GPT-4를 기반으로 한 연구원의 예비 평가 요약이 그림에 나와 있습니다. Vicuna는 Bard/ChatGPT 기능의 90% 이상을 달성한 것을 볼 수 있습니다.

GPT-4로 평가한 상대 응답 품질

흥미롭게도 이 Vicuna 데모에서 팀은 Alpaca 및 LLaMA의 시험판에도 합류했으며 전자는 얼마 전에 종료되었습니다.

데모 주소: https://chat.lmsys.org/

ChatGPT의 등장은 사람들을 설레게 하지만, OpenAI가 Open이 아니라는 사실은 업계 사람들을 정말 당황하게 만듭니다.

정확히 Meta의 LLaMA 모델은 오픈 소스이므로 많은 연구자에게 자신만의 모델을 개발할 수 있는 옵션을 제공합니다.

Vicuna-13B의 탄생은 LLaMA 및 Stanford Alpaca 프로젝트에서 영감을 받았습니다. 이는 증강된 데이터 세트와 사용하기 쉽고 확장 가능한 인프라를 기반으로 하는 오픈 소스 챗봇입니다.

이 모델의 훈련 데이터는 ShareGPT에서 수집한 사용자들이 공유한 대화에서 나온 것이며, 연구원들은 기본 LLaMA 모델을 미세 조정하여 Vicuna-13B가 탄생했습니다.

Vicuna-13B는 Stanford Alpaca 등 다른 오픈소스 모델과 동등한 성능을 보여줍니다.

연구원들은 Vicuna-13B의 성능에 대한 예비 평가를 실시하고 훈련 및 서비스 인프라에 대해 설명했습니다.

동시에 이 모델 시연 데모가 시작되었으며 모든 연구원은 온라인 시연 상호 작용에 참여하여 이 챗봇의 기능을 테스트할 수 있습니다.

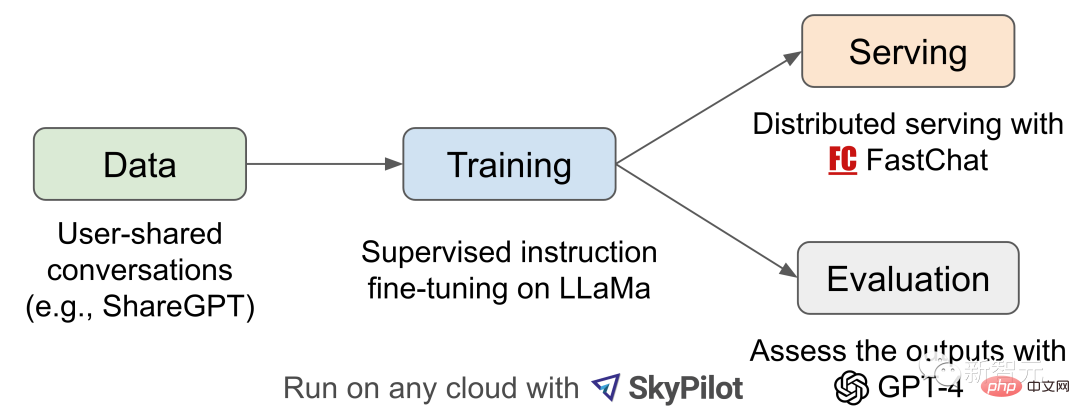

워크플로 개요

Vicuna-13B 훈련 과정의 세부 내용은 다음과 같습니다.

먼저, 연구원들은 ChatGPT 대화 공유 웹사이트 ShareGPT에서 약 70,000개의 대화를 수집했습니다.

다음으로 연구원들은 Alpaca가 제공하는 훈련 스크립트를 최적화하여 모델이 여러 라운드의 대화와 긴 시퀀스를 더 잘 처리할 수 있도록 했습니다. 그런 다음 PyTorch FSDP를 하루 동안 A100 GPU 8개로 훈련하는 데 사용했습니다.

모델 품질 평가 측면에서 연구원들은 80개의 다양한 질문을 만들고 GPT-4를 사용하여 모델 출력을 평가했습니다.

다양한 모델을 비교하기 위해 연구원들은 각 모델의 출력을 단일 프롬프트로 결합한 다음 GPT-4에서 어떤 모델이 더 나은 답변을 제공했는지 평가하도록 했습니다.

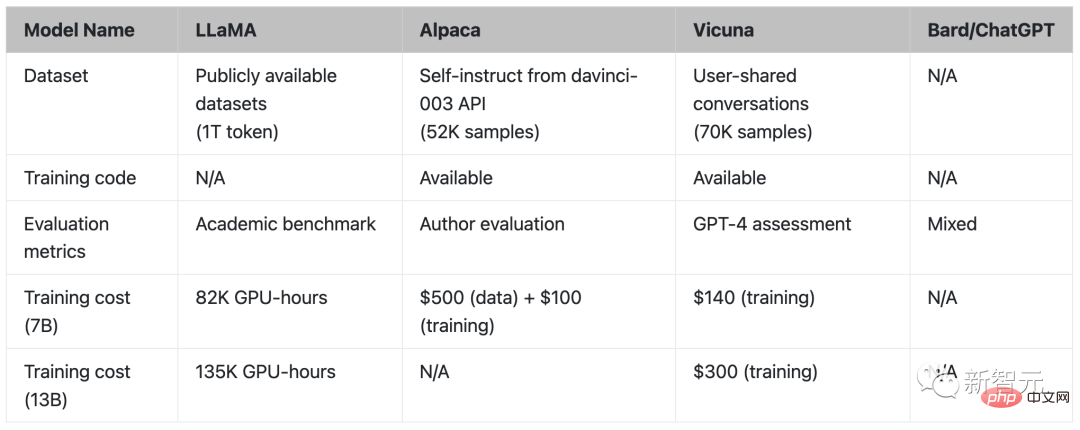

LLaMA, Alpaca, Vicuna 및 ChatGPT 비교

Training

Vicuna는 ShareGPT 공개 API에서 수집한 ~70K 사용자 공유 대화 데이터를 사용하여 미세 조정하여 만들어졌습니다.

데이터 품질을 보장하기 위해 연구원들은 HTML을 다시 마크다운으로 변환하고 부적절하거나 품질이 낮은 샘플을 필터링했습니다.

또한 연구원들은 모델의 최대 컨텍스트 길이를 수용하기 위해 긴 대화를 더 작은 세그먼트로 나누었습니다.

Vicuna의 학습 방법은 다음과 같은 개선 사항을 통해 Stanford의 Alpaca를 기반으로 구축되었습니다.

Vicuna가 긴 컨텍스트를 이해할 수 있도록 최대 컨텍스트 길이가 Alpaca의 512에서 2048로 확장되어 GPU가 크게 늘어납니다. 메모리 요구 사항. 여기에서 연구자들은 경사 체크포인트와 플래시 어텐션을 사용하여 메모리 부족 문제를 해결합니다.

여러 라운드의 대화를 고려하여 훈련 손실을 조정하고 챗봇의 출력에 대해서만 미세 조정 손실을 계산합니다.

40배의 데이터 세트와 4배의 시퀀스 길이는 교육에 상당한 어려움을 안겨줍니다. 연구원들은 SkyPilot이 호스팅하는 스팟 인스턴스를 사용하여 자동 복구 선점 및 자동 영역 전환을 활용하여 비용을 절감했습니다.

이 솔루션은 7B 모델의 훈련 비용을 $500에서 약 $140로 줄이고, 13B 모델의 훈련 비용을 약 $1000에서 $300로 줄입니다.

평가

AI 챗봇을 평가하는 것은 언어 이해, 추론, 상황 인식을 확인해야 하기 때문에 어려운 작업입니다. AI 챗봇이 더욱 발전함에 따라 기존 공개 벤치마크로는 더 이상 충분하지 않을 수 있습니다.

예를 들어 Stanford Alpaca에서 사용되는 평가 데이터 세트 self-instruct는 SOTA 챗봇을 통해 효율적으로 답변할 수 있어 인간이 성능의 차이를 구별하기 어렵습니다. 추가 제한 사항에는 교육/테스트 데이터 오염 및 새로운 벤치마크 생성에 따른 잠재적으로 높은 비용이 포함됩니다.

이러한 문제를 해결하기 위해 연구진은 챗봇 성능을 자동으로 평가할 수 있는 GPT-4 기반 평가 프레임워크를 제안했습니다.

첫째, GPT-4는 신중하게 설계된 프롬프트를 통해 다양하고 도전적인 질문을 생성할 수 있습니다. 롤플레잉, 코딩/수학 과제 등 8개 범주의 총 80개 질문을 사용하여 다양한 분야에서 이러한 모델(LLaMA, Alpaca, ChatGPT, Bard 및 Vicuna)의 성능을 테스트했습니다.

그런 다음 연구원들은 GPT-4에게 유용성, 관련성, 정확성 및 세부 사항을 기준으로 답변의 품질을 평가하도록 요청했습니다. 결과는 GPT-4가 상대적으로 일관된 점수를 생성할 수 있을 뿐만 아니라 왜 그러한 점수를 주는지에 대한 자세한 설명을 제공할 수 있음을 보여줍니다. 그러나 GPT-4는 코딩/수학 작업을 판단하는 데 능숙하지 않습니다.

GPT-4 평가 응답 비교

GPT-4는 문제의 90% 이상에서 기존 SOTA 오픈소스 모델(LLaMA, Alpaca)보다 Vicuna를 선호합니다.

질문의 45%에서 GPT-4는 Vicuna의 답변이 ChatGPT와 유사하거나 더 낫다고 믿었습니다.

모두 합치면 Vicuna의 총점은 ChatGPT의 92%에 달합니다.

제한 사항

연구원들은 다른 대규모 언어 모델과 마찬가지로 Vicuna에도 특정 제한 사항이 있다고 지적했습니다.

예를 들어, Vicuna는 프로그래밍, 추론, 수학, 사실적 정확성과 관련된 작업에서 성적이 좋지 않았습니다.

또한 안전을 보장하거나 잠재적인 독성이나 편견을 완화하기 위해 완전히 최적화되지 않았습니다.

보안 문제를 해결하기 위해 연구원들은 데모에서 OpenAI의 검열 API를 사용하여 부적절한 사용자 입력을 걸러냈습니다.

이제 라마(LLaMA), 알파카(Alpaca), 비쿠냐(Vicuna) 외에 다 정리가 되었습니다.

연구원님들, 남은 이름이 많지 않으니 서두르세요(1).

위 내용은 ChatGPT는 $300입니다! 스탠포드의 130억 매개변수 '리틀 알파카' 탄생의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!