뷰 합성은 컴퓨터 비전과 컴퓨터 그래픽의 교차점에서 중요한 문제입니다. 이는 여러 장면의 사진에서 장면의 새로운 뷰를 생성하는 것을 의미합니다.

장면의 새로운 뷰를 정확하게 합성하려면 모델은 상세한 3D 구조, 재료 및 조명 등과 같은 작은 참조 이미지 세트에서 여러 유형의 정보를 캡처해야 합니다.

2020년 연구원들이 NeRF(Neural Radiation Field) 모델을 제안한 이후 이 문제 역시 점점 더 주목을 받아 새로운 시점 합성 성능이 크게 향상되었습니다.

NeRF 분야에서 많은 논문을 발표한 Google도 있습니다. 이 기사에서는 Google이 CVPR 2022와 ECCV 2022에 대해 발표한 두 가지 논문을 소개합니다. Light Field Neural 렌더링 모델의 진화 .

첫 번째 논문에서는 참조 픽셀 색상을 결합하는 방법을 학습하는 Transformer 기반 2단계 모델을 제안합니다. 먼저 에피폴라 선(에피폴라 선)을 따라 특징을 얻은 다음 참조 뷰를 따라 특징을 얻어 목표 광선을 생성합니다. , 뷰 재현의 정확도가 크게 향상됩니다 .

문서 링크: https://arxiv.org/pdf/2112.09687.pdf

ClassicLight Field Rendering은 반사, 굴절, 반투명도가 있지만 장면의 조밀한 뷰 샘플링이 필요합니다. 기하학적 재구성에 기반한 방법은 희소 보기만 필요하지만 비램버트 효과, 즉 비이상적 산란을 정확하게 모델링할 수는 없습니다.

논문에서 제안된 새로운 모델은 이 두 방향의 장점을 결합하고 광장의 한계를 완화하여 모델은 시야를 정확하게 표현하는 방법을 학습할 수 있습니다. 관련 효과 . 장면 기하학은 훈련 및 추론 중에 기하학적 제약 조건을 적용하여 희박한 뷰 세트에서 암시적으로 학습됩니다.

이 모델은 여러 전방 및 360° 데이터 세트에서 최첨단 모델보다 성능이 뛰어나며 시선에 따른 변화가 심각한 장면에서 더 큰 여유를 갖습니다.

또 다른 논문은 정규화된 위치 인코딩과 함께 변환기 시퀀스를 사용하여 보이지 않는 장면을 합성하는 일반화 문제를 다루고 있습니다. 모델이 일련의 장면에 대해 학습된 후에는 새로운 장면의 뷰를 합성하는 데 사용할 수 있습니다.

논문 링크:https://arxiv.org/pdf/2207.10662.pdf

논문은 딥 피처와 NeRF와 같은 볼륨 렌더링이 필요하지 않은 다른 패러다임을 제안합니다. 이 방법은 장면에서 패치 세트를 간단히 샘플링하여 새 장면의 대상 광선 색상을 직접 예측할 수 있습니다.

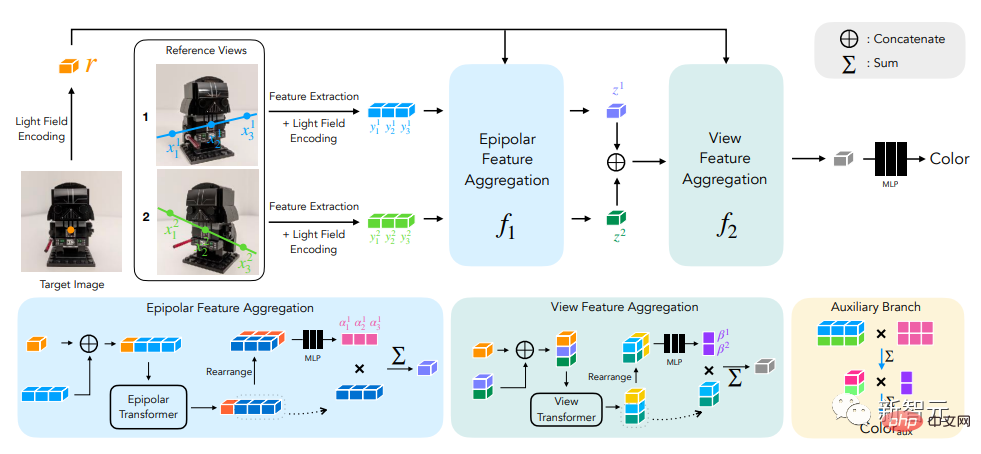

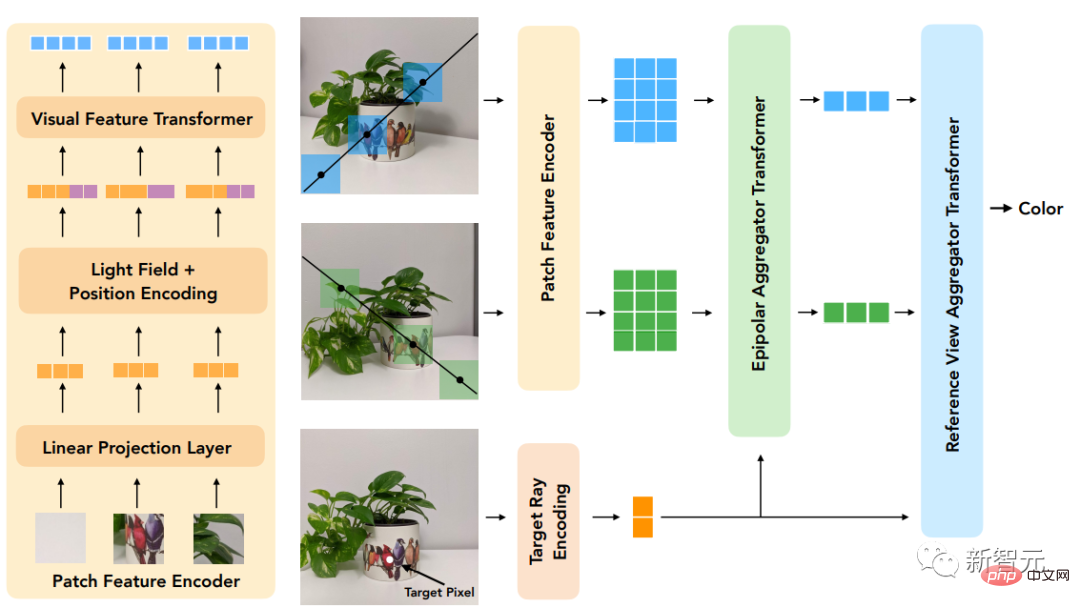

먼저 에피팔 기하학을 활용하여 각 참조 뷰의 에피폴라 선을 따라 패치를 추출하고 각 패치를 1차원 특징 벡터로 선형 투영한 다음 이 컬렉션을 처리하는 일련의 Transformer로 구성됩니다.

위치 인코딩의 경우 연구원들은 라이트 필드 표현 방법과 유사한 방식으로 광선을 매개변수화합니다. 차이점은 좌표가 대상 광선을 기준으로 정규화되어 방법이 참조 프레임과 독립적이게 하고 개선된다는 것입니다. 일반성.

모델의 혁신은 이미지 기반 렌더링을 수행하여 참조 이미지의 색상과 특성을 결합하여 새로운 뷰를 렌더링한다는 점이며, 순전히 Transformer 기반이며 이미지 패치 세트에서 작동합니다. . 또한 위치 인코딩을 위해 4D 라이트 필드 표현을 활용하여 뷰 관련 효과를 시뮬레이션하는 데 도움을 줍니다.

최종 실험 결과는 보다 훨씬 적은 데이터로 훈련

하는 경우에도 보이지 않는 장면의 새로운 뷰 합성에서 이 방법이 다른 방법보다 성능이 우수하다는 것을 보여줍니다.라이트 필드 신경 렌더링

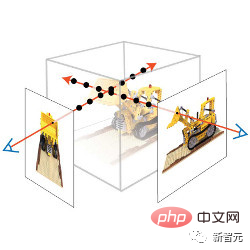

모델에 대한 입력은 참조 이미지 세트, 해당 카메라 매개변수(초점 거리, 위치 및 공간 방향), 사용자가 색상을 원하는 대상 광선의 좌표로 구성됩니다. 결정하다.새 이미지를 생성하려면 입력 이미지의 카메라 매개변수부터 시작하여 먼저 대상 광선의 좌표(각각 픽셀에 해당)를 얻은 다음 각 좌표에 대한 모델 쿼리를 수행해야 합니다.

연구원의 솔루션은 각 참조 이미지를 완전히 처리하는 것이 아니라 대상 픽셀에 영향을 줄 수 있는 영역만 살펴보는 것입니다. 이러한 영역은 각 대상 픽셀을 각 참조 프레임의 선에 매핑하는 에피폴라 기하학에 의해 결정될 수 있습니다.

안전을 위해 에피폴라 선의 일부 지점 주변의 작은 영역을 선택하여 모델에서 실제로 처리할 패치 세트를 형성한 다음 이 패치 세트에 Transformer를 적용하여 대상 픽셀의 색상을 얻습니다.

Transformer는 Self-Attention 메커니즘이 자연스럽게 패치 컬렉션을 입력으로 사용할 수 있고 Attention 가중치 자체를 사용하여 참조 뷰 색상 및 기능과 함께 출력 픽셀을 예측할 수 있기 때문에 이 경우 특히 유용합니다. .s 색상.

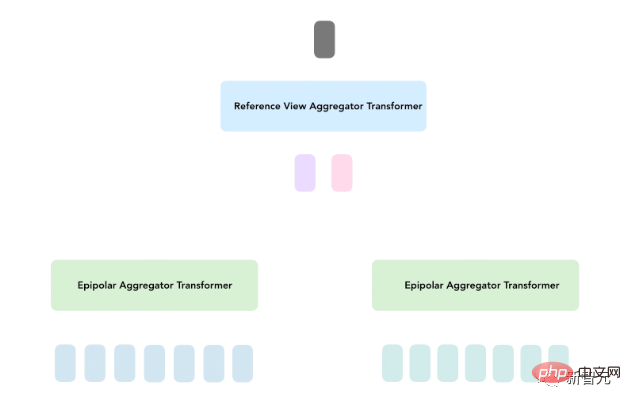

광장 신경 렌더링(LFNR)에서 연구원들은 두 개의 Transformer 시퀀스를 사용하여 패치 모음을 대상 픽셀 색상에 매핑합니다.

첫 번째 Transformer는 각 에피폴라 선을 따라 정보를 집계하고, 두 번째 Transformer는 각 참조 이미지를 따라 정보를 집계합니다.

이 접근 방식은 첫 번째 Transformer를 각 참조 프레임에서 대상 픽셀의 잠재적 일치성을 찾는 것으로 해석할 수 있는 반면, 두 번째 Transformer는 역시 이미지 기반인 폐색 및 시선 종속 효과에 대해 추론합니다. .

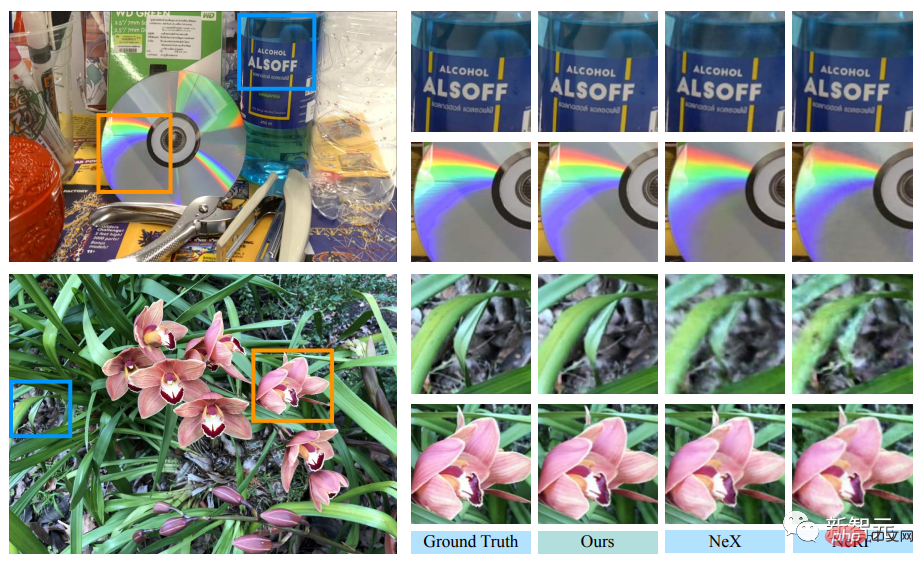

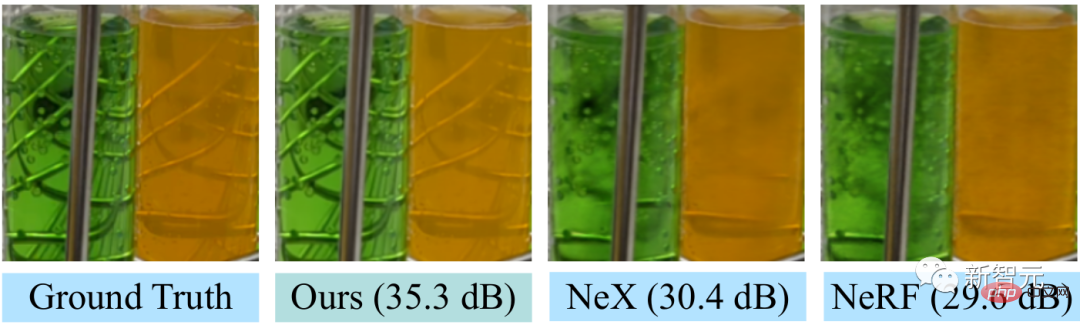

LFNR은 가장 인기 있는 뷰 합성 벤치마크(NeRF의 Blender 및 Real Forward-Facing 장면 및 NeX의 Shiny)에서 sota 모델에 비해 피크 신호 대 잡음비(PSNR)를 최대 5dB 향상합니다. 이는 상당히 픽셀 수준의 오류를 1.8배 줄여줍니다.

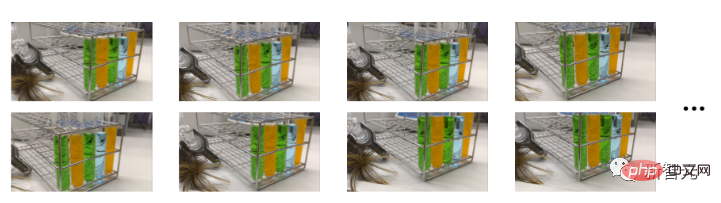

LFNR은 NeX/Shiny 데이터세트에서 무지개와 CD의 반사, 반사, 굴절, 병의 반투명과 같은 좀 더 어려운 시선 의존 효과를 재현할 수 있습니다.

NeX 및 NeRF와 같은 이전 방법과 비교하여 NeX/Shiny 데이터 세트의 실험실 장면에서 시험관의 반투명도 및 굴절률과 같은 시선 관련 효과를 재현할 수 없습니다. .

한 번 훈련하고 새로운 장면에 일반화하세요

첫 번째 Transformer는 각 참조 이미지에 대해 독립적으로 각 에피폴라 선을 따라 정보를 접습니다. 이는 또한 모델이 각 참조 이미지의 출력 광선 좌표 및 패치를 기반으로 유지할 정보만 결정할 수 있음을 의미합니다. 훈련 장면(대부분의 신경 렌더링 방법과 마찬가지로)에서는 잘 작동하지만 다른 장면으로 일반화되지는 않습니다.

일반화 가능한 모델은 재교육 없이 새로운 시나리오에 직접 적용할 수 있기 때문에 중요합니다.

연구원들은 이러한 LFNR의 단점을 해결하기 위해 일반적인 패치 기반 신경 렌더링(GPNR) 모델을 제안했습니다.

모델에 Transformer를 추가하여 다른 두 Transformer보다 먼저 실행되고 모든 참조 이미지에서 동일한 깊이의 지점 간에 정보를 교환합니다.

GPNR은 에피폴라 선을 따라 추출된 패치 세트를 픽셀 색상으로 매핑하는 세 개의 변환기 시퀀스로 구성됩니다. 이미지 패치는 선형 투영 레이어를 통해 초기 특징에 매핑되고, 이러한 특징은 모델에 의해 지속적으로 정제되고 집계되어 최종적으로 특징과 색상을 형성합니다.

예를 들어 첫 번째 Transformer가 "Park Bench"에서 패치 시퀀스를 추출한 후 새 모델은 두 뷰의 해당 깊이에 나타나는 "꽃"과 같은 단서를 사용하여 잠재적인 일치가 있음을 나타낼 수 있습니다.

이 작업의 또 다른 핵심 아이디어는 대상 광선에 따라 위치 인코딩을 정규화하는 것입니다. 왜냐하면 다른 시나리오에서 일반화하려면 절대 참조가 아닌 상대 값으로 수량을 표현해야 하기 때문입니다. system

모델의 일반화 성능을 평가하기 위해 연구원들은 일련의 시나리오에서 GPNR을 교육하고 새로운 시나리오에서 테스트했습니다.

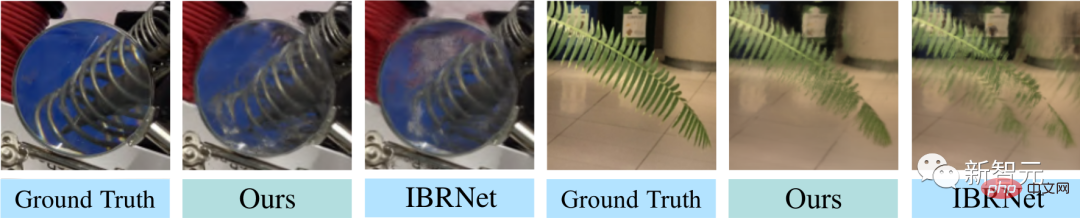

GPNR은 여러 벤치마크(IBRNet 및 MVSNeRF 프로토콜에 따름)에서 평균 0.5-1.0dB 향상되었으며, 특히 IBRNet 벤치마크에서 GPNR은 훈련 시나리오의 11%만 사용하여 기준 모델을 능가했습니다.

GPNR은 미세 조정 없이 NeX/Shiny 및 LLFF에서 유지 관리되는 장면에 대한 세부 정보 보기를 생성했습니다. GPNR은 IBRNet보다 블레이드의 세부 사항과 렌즈를 통한 굴절을 더 정확하게 재현합니다.

위 내용은 한 번 훈련하면 새로운 3D 장면을 생성할 수 있습니다! Google '라이트 필드 신경망 렌더링'의 진화 역사의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!