딥 러닝은 이미지, 언어, 오디오 등의 영역에서 큰 발전을 이루었습니다. 그러나 딥 러닝은 표 형식 데이터를 처리할 때 평범한 성능을 발휘합니다. 표 형식 데이터는 특성이 고르지 않고, 표본 크기가 작으며, 극단값이 큰 등의 특성을 가지므로 해당 불변량을 찾기가 어렵습니다.

트리 기반 모델은 미분 불가능하고 딥러닝 모듈과 공동으로 학습할 수 없기 때문에 테이블별 딥러닝 아키텍처를 만드는 것은 매우 활발한 연구 분야입니다. 많은 연구에서 트리 기반 모델을 능가하거나 경쟁할 수 있다고 주장했지만, 그들의 연구는 많은 회의론에 부딪혔습니다.

표 형식 데이터에 대한 학습에는 확립된 벤치마크가 부족하다는 사실은 연구자가 방법을 평가할 때 많은 자유를 제공합니다. 게다가 온라인에서 사용할 수 있는 대부분의 표 형식 데이터세트는 다른 기계 학습 하위 도메인의 벤치마크에 비해 크기가 작아 평가가 더 어렵습니다.

이러한 우려를 완화하기 위해 프랑스 국립 정보 자동화 연구소, 소르본 대학 및 기타 기관의 연구원들은 최신 딥 러닝 모델을 평가하고 트리 기반 모델이 다음에서 잘 수행될 수 있음을 보여줄 수 있는 표 형식 데이터 벤치마크를 제안했습니다. 표 형식 데이터 세트의 중간 크기 Still SOTA.

이 결론에 대해 이 기사는 결정적인 증거를 제공합니다. 연구원들은 딥 러닝(심지어 현대 아키텍처 포함)보다 트리 기반 방법을 사용하여 좋은 예측을 달성하는 것이 더 쉽습니다.

논문 주소: https://hal.archives-ouvertes.fr/hal-03723551/document논문의 저자 중 한 명이 Gaël Varoquaux라는 점을 언급할 가치가 있습니다. Scikit-learn 프로그램의 리더 중 하나입니다. 이 프로젝트는 이제 GitHub에서 가장 인기 있는 기계 학습 라이브러리 중 하나가 되었습니다. Gaël Varoquaux의 "Scikit-learn: Python의 기계 학습" 기사는 58,949회 인용되었습니다.

이 기사의 기여는 다음과 같이 요약될 수 있습니다.

이 연구는 표 형식 데이터(45개의 공개 데이터 세트 선택)에 대한 새로운 벤치마크를 만들고 이러한 데이터 세트를 OpenML을 통해 공유하므로 사용하기 쉽습니다. .

본 연구에서는 표 형식 데이터를 대상으로 다양한 설정에서 딥러닝 모델과 트리 기반 모델을 비교하고 하이퍼파라미터 선택 비용을 고려합니다. 또한 이 연구는 무작위 검색의 원시 결과를 공유하므로 연구자는 고정된 하이퍼파라미터 최적화 예산에 대한 새로운 알고리즘을 저렴하게 테스트할 수 있습니다.

새로운 벤치마크는 45개의 테이블 형식 데이터 세트를 참조하며 선택 벤치마크는 다음과 같습니다.

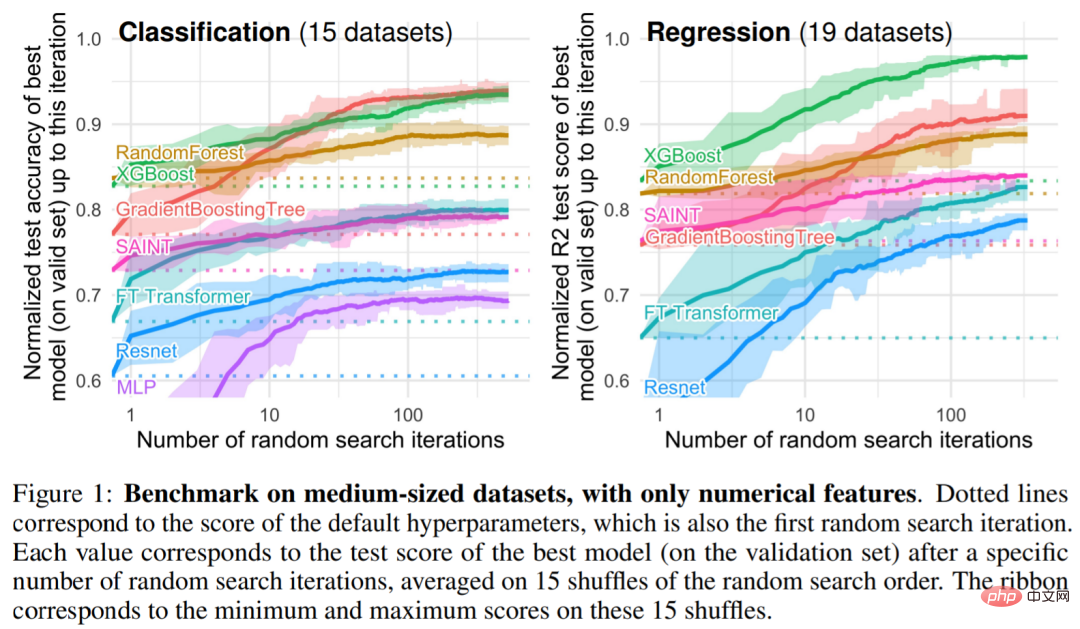

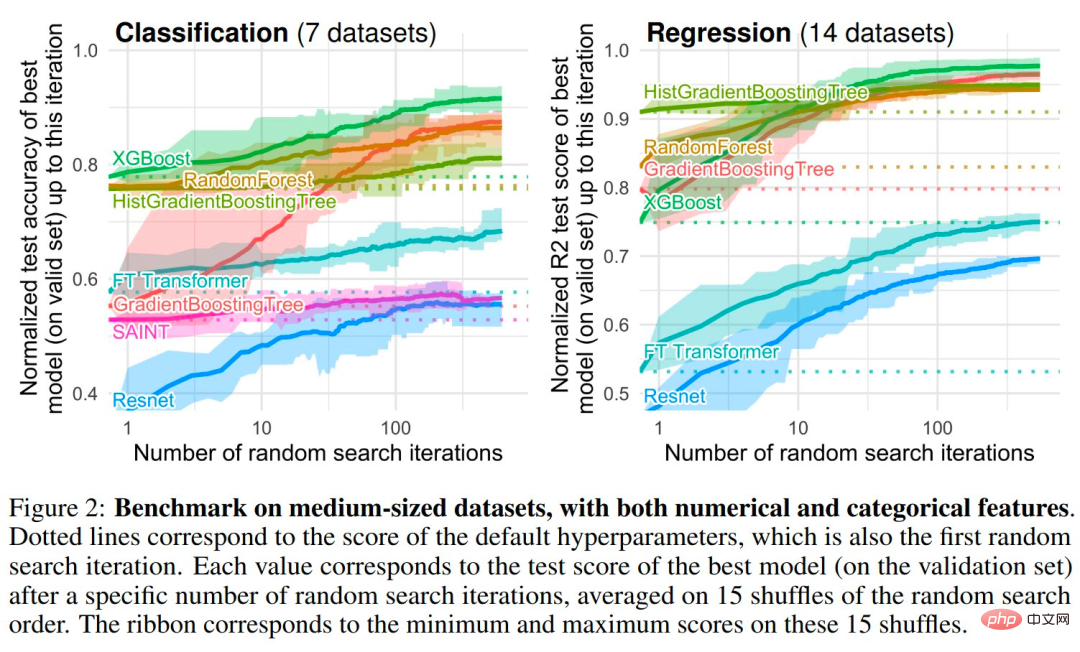

연구원들은 트리 기반 모델 중에서 Scikit Learn의 RandomForest, GradientBoostingTrees(GBTs) 및 XGBoost의 3가지 SOTA 모델을 선택했습니다. 이 연구에서는 MLP, Resnet, FT Transformer, SAINT와 같은 딥 모델에 대해 벤치마크를 수행했습니다. 그림 1과 그림 2는 다양한 유형의 데이터 세트에 대한 벤치마크 결과를 제공합니다

귀납적 편향. 트리 기반 모델은 다양한 하이퍼파라미터 선택에서 신경망을 능가합니다. 실제로 표 형식 데이터를 처리하는 가장 좋은 방법에는 두 가지 공통점이 있습니다. 즉, 앙상블 방법인 배깅(랜덤 포레스트) 또는 부스팅(XGBoost, GBT)이며 이러한 방법에 사용되는 약한 학습기는 의사결정 트리입니다.

발견 1: 신경망(NN)은 지나치게 부드러운 솔루션을 사용하는 경향이 있습니다.

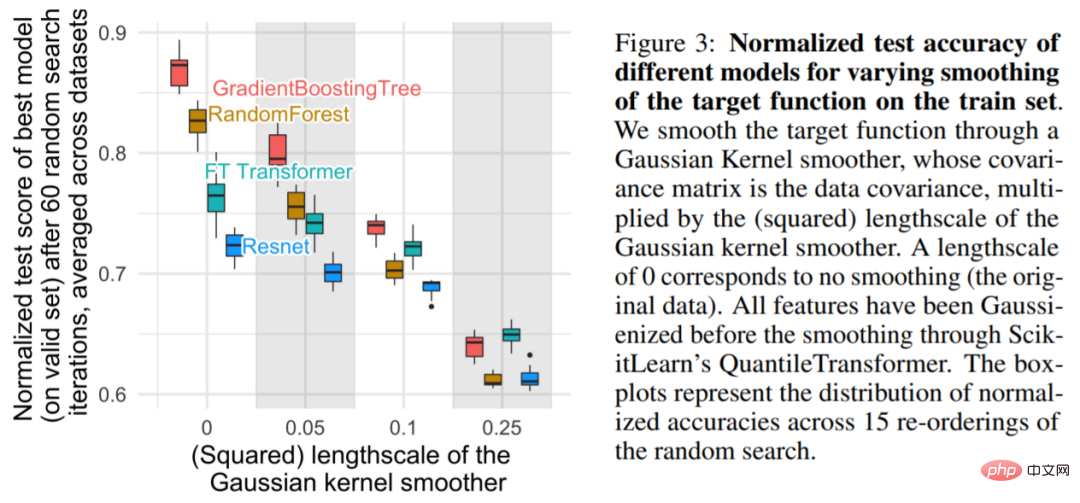

그림 3에 표시된 것처럼 소규모 규모의 경우 부드러운 훈련 세트의 목적 함수는 정확도에 따라 크게 감소합니다. 트리 모델에 적용되지만 NN에는 거의 영향을 미치지 않습니다. 이러한 결과는 데이터 세트의 목적 함수가 원활하지 않으며 NN이 트리 기반 모델에 비해 이러한 불규칙 함수에 적응하는 데 어려움이 있음을 나타냅니다. 이는 NN이 저주파 함수에 편향되어 있음을 발견한 Rahaman et al.의 연구 결과와 일치합니다. 의사결정 트리 기반 모델은 이러한 편향 없이 조각별 상수 함수를 학습합니다.

발견 2: 정보가 없는 특성은 MLP와 유사한 NN

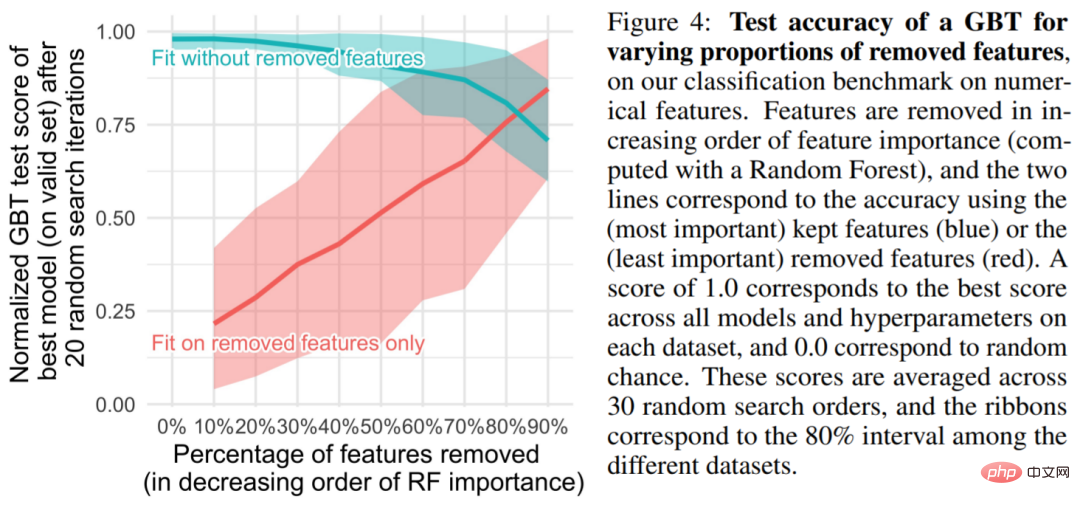

표 형식의 데이터 세트에는 정보가 없는 많은 특성이 포함되어 있습니다. of는 특정 비율의 기능을 삭제하도록 선택합니다(일반적으로 Random Forest에 의해 정렬됨). 그림 4에서 볼 수 있듯이 특징의 절반 이상을 제거해도 GBT 분류 정확도에는 거의 영향을 미치지 않습니다.

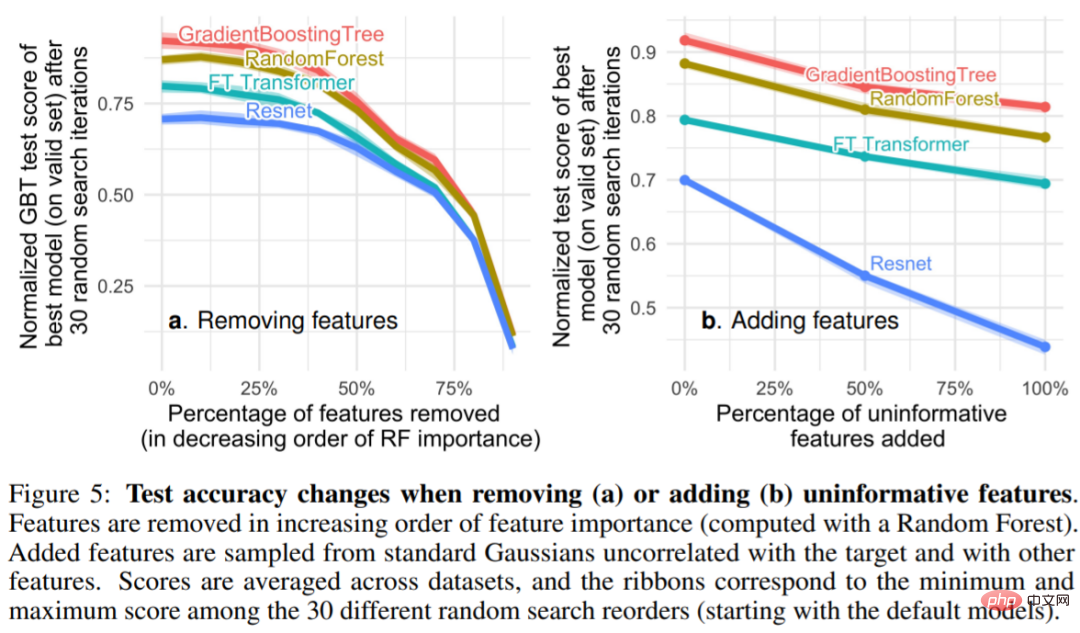

그림 5 비정보 기능(5a)을 제거하면 MLP(Resnet)와 다른 모델(FT Transformers 및 트리 기반 모델) 간의 성능 격차가 줄어들고 비정보 기능을 추가하는 것을 볼 수 있습니다. 유익한 기능 기능은 격차를 넓혀 MLP가 정보가 없는 기능에 덜 강력하다는 것을 나타냅니다. 그림 5a에서 연구자가 더 많은 비율의 특징을 제거하면 그에 따라 유용한 정보 특징도 제거됩니다. 그림 5b는 이러한 특징을 제거함으로써 발생하는 정확도 저하가 비정보적 특징을 제거함으로써 보상될 수 있음을 보여줍니다. 이는 다른 모델에 비해 MLP에 더 도움이 됩니다(동시에 이 연구에서는 중복된 특징도 제거하고 모델 성능에 영향을 미치지 않습니다) ).

발견 3: 회전을 통해 데이터는 변하지 않습니다.

MLP가 다른 모델에 비해 정보가 없는 기능에 더 취약한 이유는 무엇입니까? 한 가지 대답은 MLP가 회전 불변이라는 것입니다. 훈련 세트에서 MLP를 학습하고 테스트 세트에서 이를 평가하는 프로세스는 훈련 및 테스트 세트 기능에 회전이 적용될 때 불변입니다. 실제로 모든 회전 불변 학습 프로세스에는 적어도 관련 없는 기능의 수가 선형적으로 증가하는 최악의 경우 샘플 복잡성이 있습니다. 직관적으로 쓸모 없는 특징을 제거하기 위해 회전 불변 알고리즘은 먼저 특징의 원래 방향을 찾은 다음 정보가 가장 적은 특징을 선택해야 합니다.

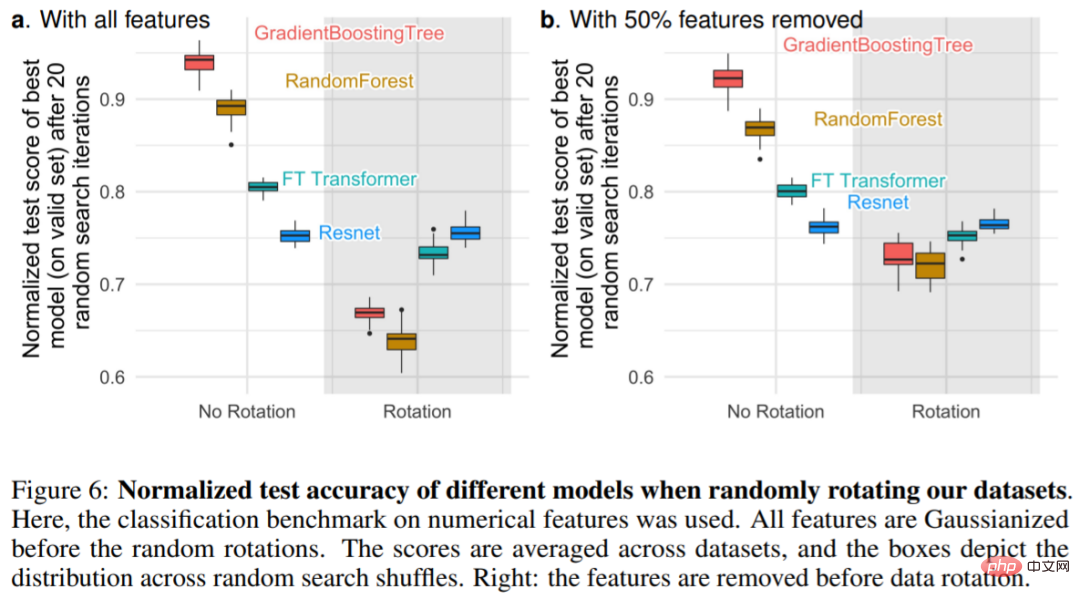

그림 6a는 데이터 세트가 무작위로 회전할 때 테스트 정확도의 변화를 보여주며 Resnet만이 회전 불변임을 확인합니다. 특히, 무작위 회전은 성능 순서를 뒤집습니다. 결과는 트리 기반 모델 위의 NN과 FT Transformer 위의 Resnet으로, 회전 불변이 바람직하지 않음을 나타냅니다. 실제로 표 형식 데이터에는 나이, 체중 등과 같은 개별적인 의미가 있는 경우가 많습니다. 그림 6b에서 볼 수 있듯이(회전 전) 각 데이터 세트에서 가장 중요하지 않은 절반의 기능을 제거하면 Resnet을 제외한 모든 모델의 성능이 감소하지만 기능을 제거하지 않고 모든 기능을 사용하는 것과 비교하면 감소가 더 작습니다.

위 내용은 트리 기반 모델이 표 형식 데이터에서 여전히 딥 러닝보다 성능이 뛰어난 이유는 무엇입니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!