Transformer는 2017년에 탄생하여 Google이 "Attention is all you need"라는 논문에 소개했습니다. 이 논문에서는 이전 딥러닝 작업에 사용된 CNN과 RNN을 포기합니다. 이 획기적인 연구는 시퀀스 모델링과 RNN을 동일시하던 이전의 생각을 뒤집었고, 현재 NLP에서 널리 사용되고 있습니다. 널리 사용되는 GPT, BERT 등은 모두 Transformer를 기반으로 구축되었습니다.

Transformer 도입 이후 연구자들은 다양한 변형을 제안했습니다. 하지만 Transformer에 대한 모든 사람의 설명은 아키텍처를 구두 형식, 그래픽 설명 등으로 소개하는 것 같습니다. Transformer의 의사코드 설명에 사용할 수 있는 정보가 거의 없습니다.

다음 구절에 표현되어 있습니다. AI 분야의 매우 유명한 연구자가 자신이 생각하기에 매우 잘 쓰여진 논문을 유명한 복잡성 이론가에게 보낸 적이 있습니다. 이론가의 대답은 다음과 같습니다. 논문에서 어떤 정리도 찾을 수 없습니다. 논문이 무엇에 관한 것인지 모르겠습니다.

실무자의 경우 논문이 충분히 자세할 수 있지만 이론가의 경우 일반적으로 더 높은 정밀도가 필요합니다. 어떤 이유로 DL 커뮤니티는 신경망 모델에 의사 코드를 제공하는 것을 꺼려하는 것 같습니다.

현재 DL 커뮤니티에는 다음과 같은 문제가 있는 것 같습니다.

DL 출판물에는 과학적 정확성과 세부 사항이 부족합니다. 딥러닝은 지난 5~10년 동안 매년 수천 편의 논문이 출판될 정도로 큰 성공을 거두었습니다. 많은 연구자들은 이전 모델을 수정한 방법을 비공식적으로만 설명하며, 비공식적인 모델 설명 몇 줄만 포함된 100페이지가 넘는 논문을 사용합니다. 기껏해야 일부 고급 다이어그램, 의사 코드, 방정식, 모델의 정확한 해석에 대한 언급이 없습니다. 어느 누구도 유명한 Transformer와 그 인코더/디코더 변형에 대한 의사 코드를 제공하지 않습니다.

소스 코드 및 의사 코드. 오픈 소스 소스 코드는 매우 유용하지만 수천 줄의 실제 소스 코드와 비교할 때 잘 설계된 의사 코드는 일반적으로 한 페이지보다 적으며 여전히 본질적으로 완전합니다. 누구도 하고 싶지 않은 힘든 일 같았어요.

훈련 과정을 설명하는 것도 마찬가지로 중요하지만 때로는 논문에서 모델의 입력과 출력이 무엇인지, 잠재적인 부작용이 무엇인지 언급조차 하지 않습니다. 논문의 실험 섹션에서는 알고리즘에 무엇이 어떻게 입력되는지 설명하지 않는 경우가 많습니다. 방법 섹션에 몇 가지 설명이 있는 경우 실험 섹션에 설명된 내용과 연결이 끊어지는 경우가 많습니다. 아마도 작성자마다 다른 섹션을 작성했기 때문일 것입니다.

어떤 사람들은 다음과 같이 질문할 수 있습니다. 의사코드가 정말 필요한가요?

DeepMind 연구원들은 의사코드를 제공하면 기사를 읽거나 실제 코드 1000줄을 스크롤하는 것과 비교할 때 의사코드가 모든 중요한 내용을 한 페이지에 압축하여 새로운 변형을 더 쉽게 개발할 수 있다고 믿습니다. 이를 위해 그들은 최근 Transformer 아키텍처를 완전하고 수학적으로 정확한 방식으로 설명하는 "Transformal Algorithms for Transformers"라는 논문을 발표했습니다.

이 기사에서는 Transformer가 무엇인지, Transformer가 훈련되는 방법, Transformer가 사용되는 용도, Transformer의 주요 아키텍처 구성 요소 및 더 유명한 모델의 미리보기를 다룹니다.

논문 주소: https://arxiv.org/pdf/2207.09238.pdf

그러나 이 기사를 읽으려면 독자는 기본 ML 용어와 간단한 신경망 아키텍처에 익숙해야 합니다. (예: MLP) ). 독자의 경우 기사의 내용을 이해한 후 Transformer에 대해 확실히 이해하고 의사 코드를 사용하여 자체 Transformer 변형을 구현할 수 있습니다.

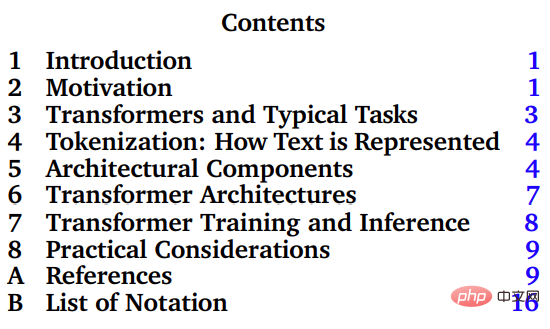

이 문서의 주요 부분은 3-8장으로, Transformer와 그 일반적인 작업, 토큰화, Transformer의 아키텍처 구성, Transformer 훈련 및 추론, 실제 적용을 소개합니다.

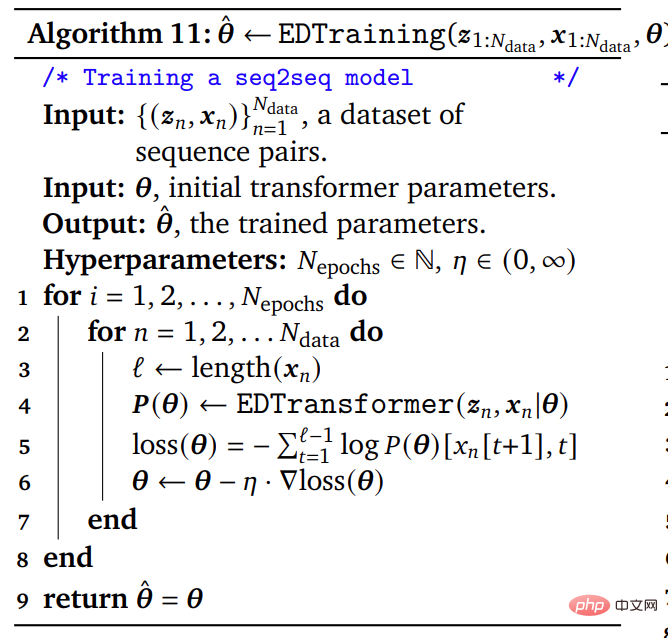

논문에서 기본적으로 완전한 의사 코드는 약 50줄인 반면 실제 실제 소스 코드는 수천 줄입니다. 논문에서 알고리즘을 설명하는 의사코드는 간결하고 완전하며 정확한 공식이 필요한 이론 연구자, Transformer를 처음부터 구현하는 실험 연구자에게 적합하며, 정식 Transformer 알고리즘을 사용하여 논문이나 교과서를 확장하는 데에도 유용합니다.

논문에 나온 의사코드 예제

기본 ML 용어와 간단한 신경망 아키텍처(예: MLP)에 익숙한 초보자를 위해 이 백서는 Transformer의 탄탄한 기초를 익히고 이를 사용하는 데 도움이 될 것입니다. 자신만의 Transformer 모델을 구현하기 위한 의사코드 템플릿입니다.

저자 소개

본 논문의 제1저자는 올해 3월 딥마인드에 정식 합류한 연구원 Mary Phuong입니다. 그녀는 오스트리아 과학 기술 연구소에서 박사 학위를 취득했으며 주로 기계 학습에 대한 이론적 연구에 종사했습니다.

이 논문의 또 다른 저자는 DeepMind의 선임 연구원이자 호주 국립 대학교(ANU) 컴퓨터 과학 연구소(RSCS)의 명예 교수인 Marcus Hutter입니다.

Marcus Hutter는 수년 동안 인공 지능의 수학적 이론에 대한 연구에 참여해 왔습니다. 이 연구 분야는 강화 학습, 확률 이론, 알고리즘 정보 이론, 최적화, 검색 및 계산 이론을 포함한 여러 수학 및 계산 과학 개념을 기반으로 합니다. 그의 책인 General Artificial Intelligence: Sequential Decision-Making on Algorithmic Probability는 2005년에 출판되었으며 매우 기술적이고 수학적인 책입니다.

2002년 Marcus Hutter는 Jurgen Schmidhuber 및 Shane Legg와 함께 이상화된 에이전트와 보상 강화 학습을 기반으로 하는 인공 지능 AIXI의 수학적 이론을 제안했습니다. 2009년에 Marcus Hutter는 특징 강화 학습 이론을 제안했습니다.

위 내용은 처음부터 새로 제작된 DeepMind의 새 논문에서는 Transformer를 의사 코드로 자세히 설명합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!