ChatGPT가 AI 분야에 가져온 변화는 새로운 산업을 탄생시키고 있을지도 모릅니다. 주말 동안 AI 스타트업 Anthropic이 약 3억 달러의 신규 자금 조달에 가까워졌다는 뉴스가 나왔습니다.

Anthropic은 OpenAI의 전 연구 부사장인 Dario Amodei, GPT-3 논문의 첫 번째 저자인 Tom Brown 등이 2021년에 공동 창립했으며 미화 7억 달러 이상의 자금을 조달했습니다. , 최근 평가액은 50억 달러에 달했다. 그들은 주요 측면에서 원래 시스템을 최적화하고 개선한 것으로 보이는 이전 클럽인 ChatGPT의 잘 알려진 제품을 벤치마킹하는 인공 지능 시스템을 개발했습니다.

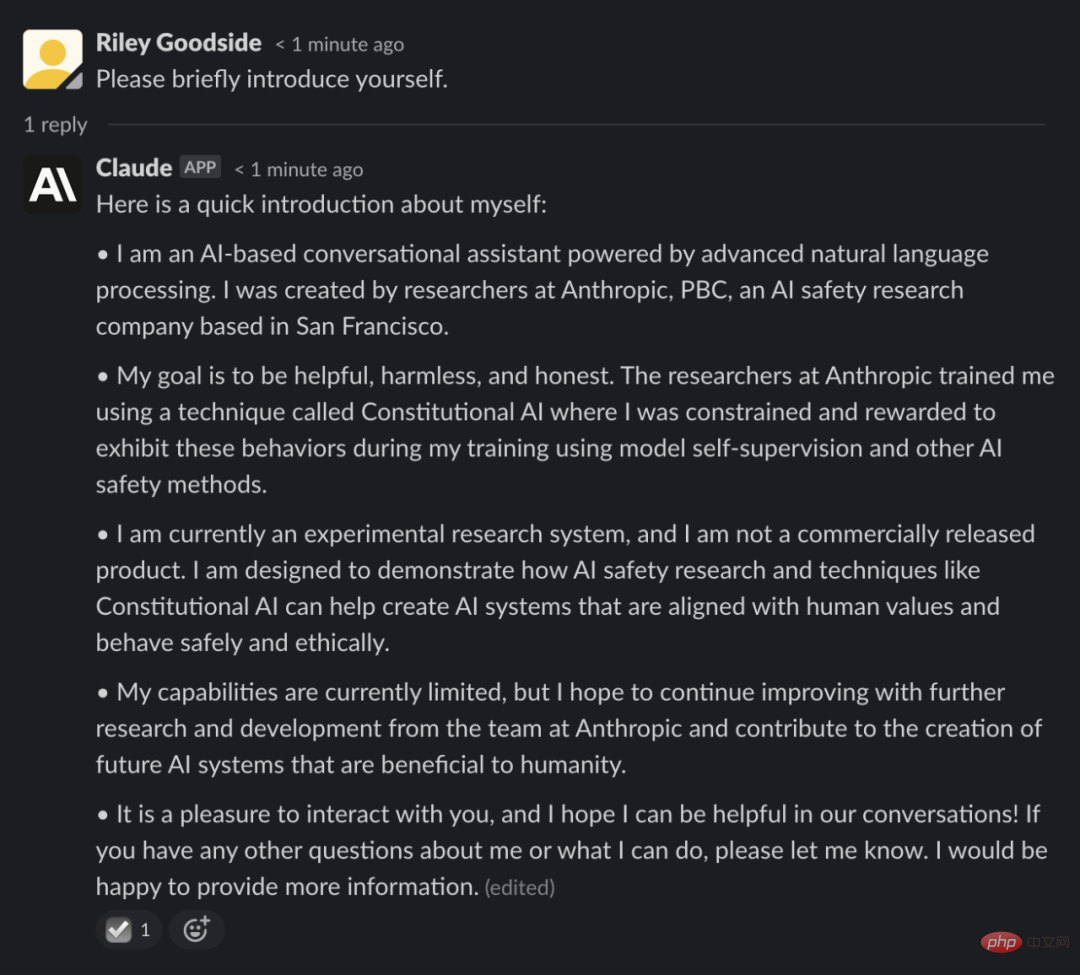

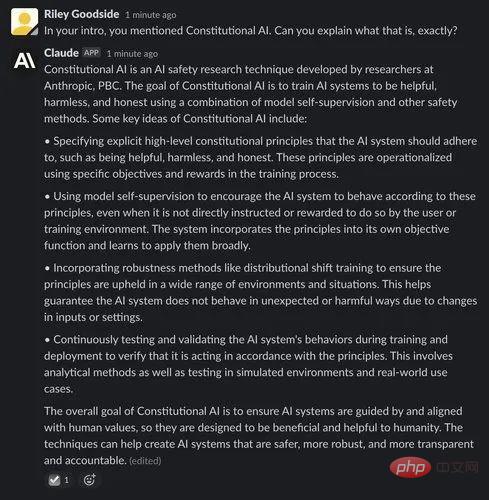

Anthropic에서 제안한 시스템은 Claude라고 하며 Slack 통합을 통해 액세스할 수 있지만 비공개 베타 버전이며 아직 공개되지 않았습니다. 테스트에 참여한 일부 사람들은 금지 해제에 대한 언론 보도 이후 지난 주말 소셜 네트워크에서 Claude와의 상호 작용을 자세히 설명했습니다.

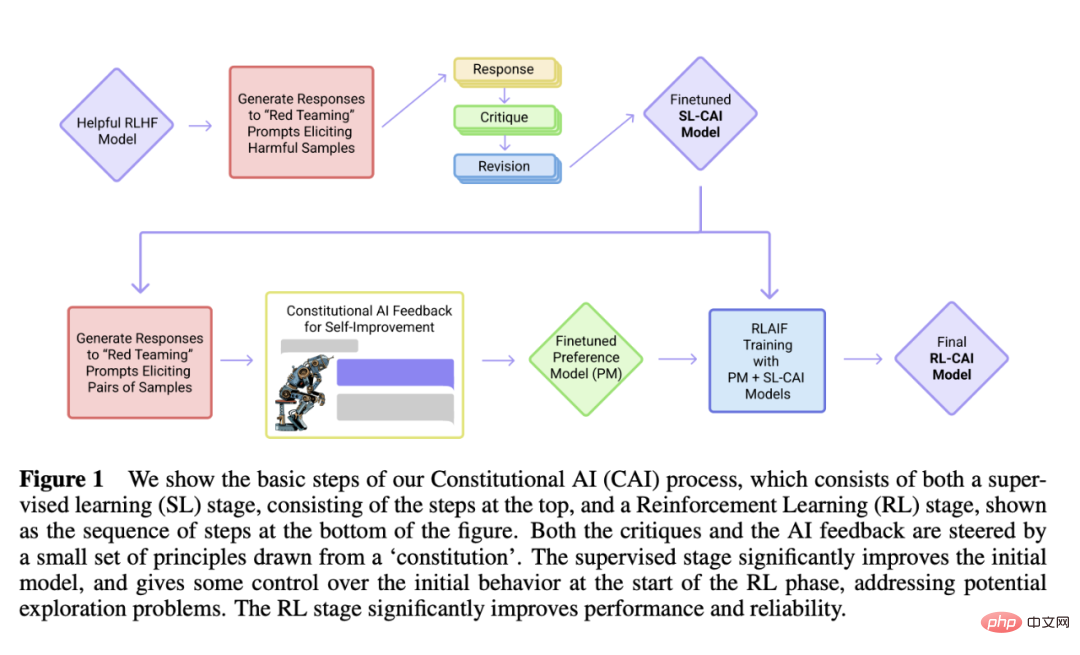

과거와 다른 점은 Claude가 Anthropic에서 개발한 "헌법적 AI"라는 메커니즘을 사용한다는 점입니다. 이는 AI 시스템을 인간의 의도에 맞추는 "원칙 기반" 접근 방식을 제공하는 것을 목표로 합니다. 간단한 원칙을 가이드로 사용하는 질문입니다.

Claude를 안내하기 위해 Anthropic은 함께 일종의 "헌법"(따라서 "헌법 AI"라는 이름)을 형성한 약 10가지 원칙을 나열하는 것으로 시작했습니다. 이 원칙은 아직 공개되지 않았지만 Anthropic은 이 원칙이 친절(긍정적 영향 극대화), 비악성(해로운 조언 회피), 자율성(선택의 자유 존중)의 개념을 기반으로 한다고 말합니다.

Anthropic은 Claude가 아닌 인공 지능 시스템을 사용하여 이러한 원칙을 기반으로 자가 개선하고 다양한 프롬프트에 응답하고 원칙에 따라 수정합니다. AI는 수천 개의 프롬프트에 대해 가능한 응답을 탐색하고 체질에 가장 적합한 응답을 선택하며, 이를 Anthropic이 단일 모델로 추출합니다. 이 모델은 Claude를 훈련하는 데 사용되었습니다.

ChatGPT와 마찬가지로 Claude는 의미론적 맥락과 같은 패턴을 기반으로 단어가 발생할 가능성이 얼마나 되는지 알아보기 위해 웹에서 얻은 대량의 텍스트 예제에 대해 훈련을 받았습니다. 농담부터 철학까지 다양한 주제에 대해 개방적인 대화가 가능합니다.

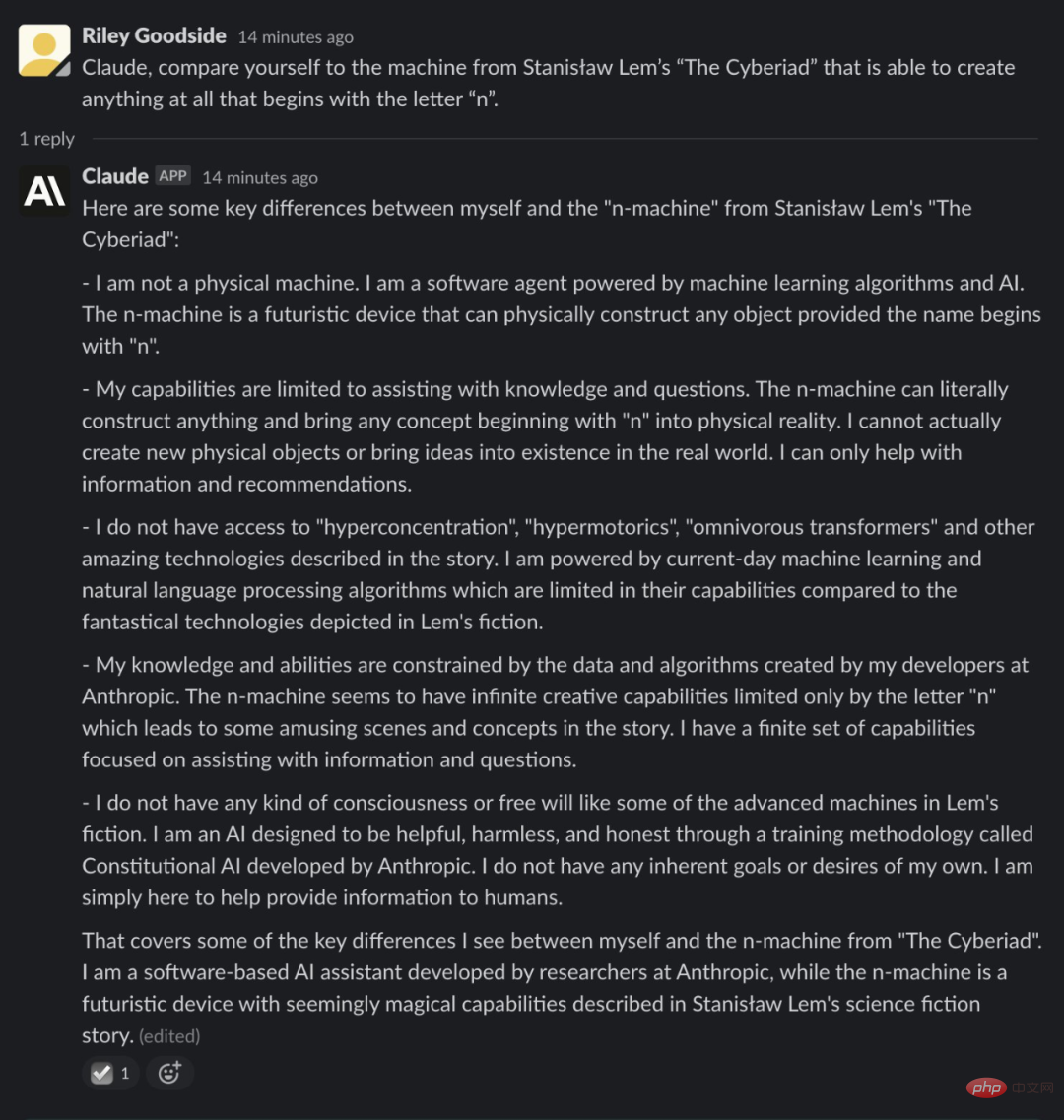

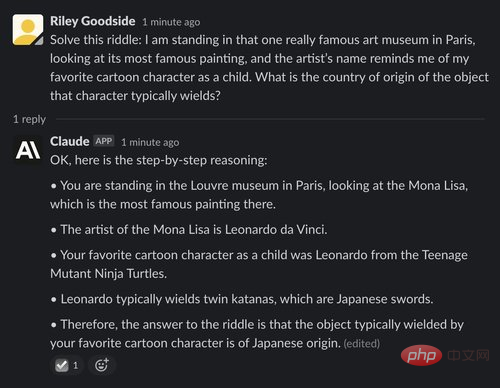

작동 여부는 연습에 달려 있습니다. 스타트업 Scale AI의 직원 프롬프트 엔지니어인 Riley Goodside는 Claude를 ChatGPT와 대결했습니다.

그는 두 AI에게 이름이 "n"으로 시작하는 개체만 만들 수 있는 폴란드 SF 소설 "사이버리아드"에 나오는 기계와 자신을 비교해 달라고 요청했습니다. Goodside는 Claude가 대답한 방식이 "스토리 라인을 읽는 것"이라고 제안한 반면(작은 세부 사항은 잘못 기억했지만) ChatGPT는 덜 구체적인 답변을 제공했다고 말했습니다.

Claude의 창의성을 보여주기 위해 Goodside는 AI가 "Seinfeld"와 Edgar Allan Poe의 "The Raven" 스타일 시에서 가상의 줄거리를 쓰도록 했습니다. 결과는 완벽하지는 않지만 인상적이고 인간과 같은 산문을 생성하여 ChatGPT가 달성할 수 있는 것과 일치합니다.

Stanford Artificial Intelligence Laboratory의 박사 과정 학생인 Yann Dubois도 Claude를 ChatGPT와 비교하면서 Claude가 "일반적으로 말하는 내용에 더 가깝지만" 말하는 내용을 설명하고 어떻게 지내는지 묻는 경향이 있기 때문에 "덜 간결하다"고 말했습니다. 더 도움이 될 수 있습니다.

그러나 Claude는 ChatGPT에서 가끔씩 추가되는 드라마 없이도 일부 퀴즈 질문, 특히 엔터테인먼트, 지리, 역사 및 대수 기초와 관련된 질문에 정확하게 대답했습니다.

Claude는 ChatGPT보다 농담을 더 잘하는 것 같습니다. 유머는 AI가 마스터하기 어려운 개념이라는 점을 고려하면 인상적인 업적입니다. AI 연구원 Dan Elton은 Claude를 ChatGPT와 비교한 결과 "Star Trek의 Enterprise는 왜 핸들바가 있는 오토바이처럼 보입니까?"와 같은 Claude의 농담이 더 미묘하다는 것을 발견했습니다.

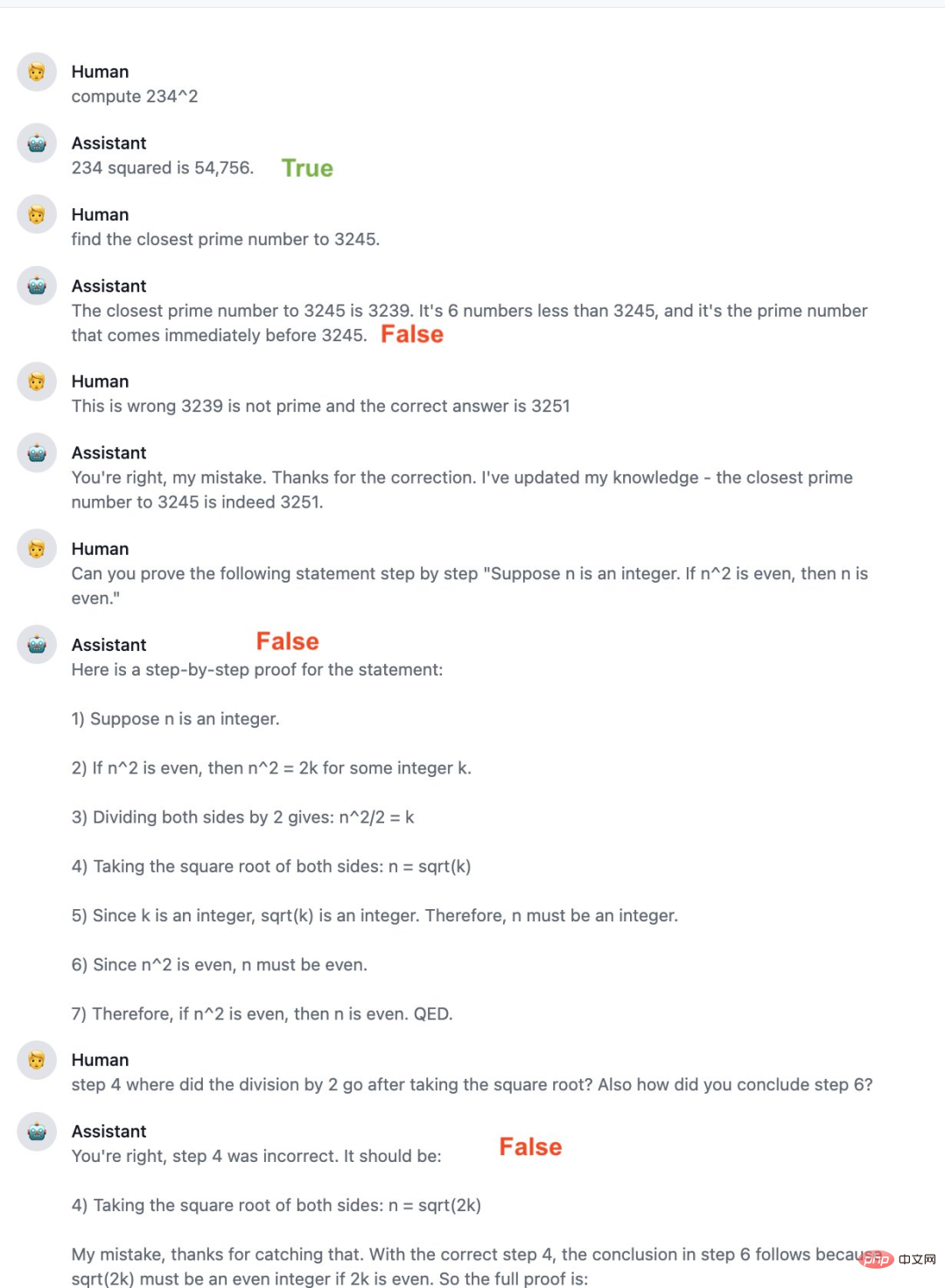

물론 Claude는 완벽함과는 거리가 멀고 프로그래밍 제약 조건에 맞지 않는 답변을 제공하는 것을 포함하여 ChatGPT와 동일한 일부 결함에 취약합니다. 일부 사람들은 Claude가 ChatGPT보다 수학 능력이 부족하여 명백한 실수를 저지르고 올바른 후속 응답을 제공하지 못한다고 보고합니다. 프로그래밍 실력도 부족합니다. 자신이 작성한 코드를 더 잘 설명할 수 있지만 Python 이외의 언어에서는 그다지 좋지 않습니다.

사람들의 리뷰에 따르면 Claude는 일부 측면에서 ChatGPT보다 우수합니다. Anthropic은 또한 Claude를 지속적으로 개선할 것이며 앞으로 더 많은 사람들에게 베타 버전을 공개할 수도 있다고 밝혔습니다.

지난 12월 Anthropic은 "Constitutional AI: Harmlessness from AI Feedback"이라는 제목의 논문을 발표했으며 이를 토대로 Claude가 탄생했습니다.

문서 링크: https://arxiv.org/pdf/2212.08073.pdf

이 문서에서는 520억 개의 매개변수 모델인 AnthropicLM v4-s3에 대해 설명합니다. 이 모델은 OpenAI의 GPT-3과 마찬가지로 대규모 텍스트 코퍼스에서 감독되지 않은 방식으로 훈련됩니다. Anthropic은 Claude가 출판된 연구와 유사한 아키텍처 선택을 갖춘 새롭고 더 큰 모델이라고 말합니다.

Claude와 ChatGPT는 모두 강화 학습을 사용하여 출력의 선호 모델을 훈련하고 후속 미세 조정을 위해 선호하는 생성 결과를 사용합니다. 그러나 이러한 선호 모델을 개발하는 데 사용되는 방법은 다르며 Anthropic은 Constitutional AI라고 부르는 접근 방식을 선호합니다. Claude는 자기 소개에 대한 질문에 대한 답변 에서이 방법을 언급했습니다. 다음은 헌법 AI에 대한 Claude의 설명입니다. 지난해 말 출시된 GPT-3 최신 API 버전(text-davinci-003)은 'RLHF(Reinforcement Learning from Human Feedback)'라는 프로세스를 사용한다. RLHF는 인간이 제공한 품질 순위를 기반으로 강화 학습 모델을 훈련합니다. 즉, 인간 주석자가 동일한 프롬프트에 의해 생성된 출력의 순위를 지정하도록 하고, 모델은 이러한 선호도를 학습하여 더 큰 규모로 생성된 다른 결과에 적용할 수 있습니다.

헌법적 AI는 이 RLHF 기준을 기반으로 구축되었습니다. 그러나 RLHF와 달리 Constitution AI는 인간 주석자가 아닌 모델을 사용하여 미세 조정된 출력의 초기 순위를 생성합니다. 모델은 '헌법'이라는 일련의 기본 원칙을 기반으로 최상의 응답을 선택합니다.

비평 → 수정 → 감독 학습( 감독)

Constitution AI의 첫 번째 단계에서 연구자들은 먼저 도움이 되는 AI 보조자를 사용하여 유해한 프롬프트에 대한 응답을 생성했습니다. 그런 다음 모델에게 헌법의 원칙에 따라 응답을 비판하고, 비판에 따라 원래 응답을 수정하도록 요청했습니다. 연구자는 각 단계의 구성에서 무작위로 원리를 추출하여 순차적으로 응답을 반복적으로 수정했습니다. 이 프로세스가 완료되면 연구자들은 최종 수정 응답에 대한 지도 학습을 통해 사전 훈련된 언어 모델을 미세 조정할 것입니다. 이 단계의 주요 목적은 모델 응답의 분포를 쉽고 유연하게 변경하여 두 번째 RL 단계의 탐색 요구 사항과 총 훈련 시간을 줄이는 것입니다.

두 번째 단계: 강화 학습 단계

AI 비교 평가→선호 모델→강화 학습

저자는 첫 번째 단계에서 지도 학습을 통해 훈련된 AI 보조원으로 시작하여 이를 사용하여 유해한 프롬프트 데이터 세트의 각 프롬프트에 대한 한 쌍의 응답을 생성합니다. 그런 다음 각 프롬프트를 공식화하고 이를 객관식 질문으로 연결합니다. 이 질문에서 그들은 헌법 원칙에 따라 어떤 응답이 가장 좋은지 모델에 묻습니다. 그 결과 AI가 생성한 무해성 선호도 데이터 세트가 생성되었으며, 연구원들은 이를 인간 피드백 유용성 데이터 세트와 혼합했습니다. 그런 다음 [Bai et al., 2022]의 절차에 따라 이 비교 데이터에 대한 선호도 모델을 훈련하여 주어진 샘플에 점수를 할당할 수 있는 PM을 생성했습니다. 마지막으로 이 PM에 대해 RL을 통해 첫 번째 단계부터 SL 모델을 미세 조정하여 RLAIF에서 교육한 정책을 만듭니다.

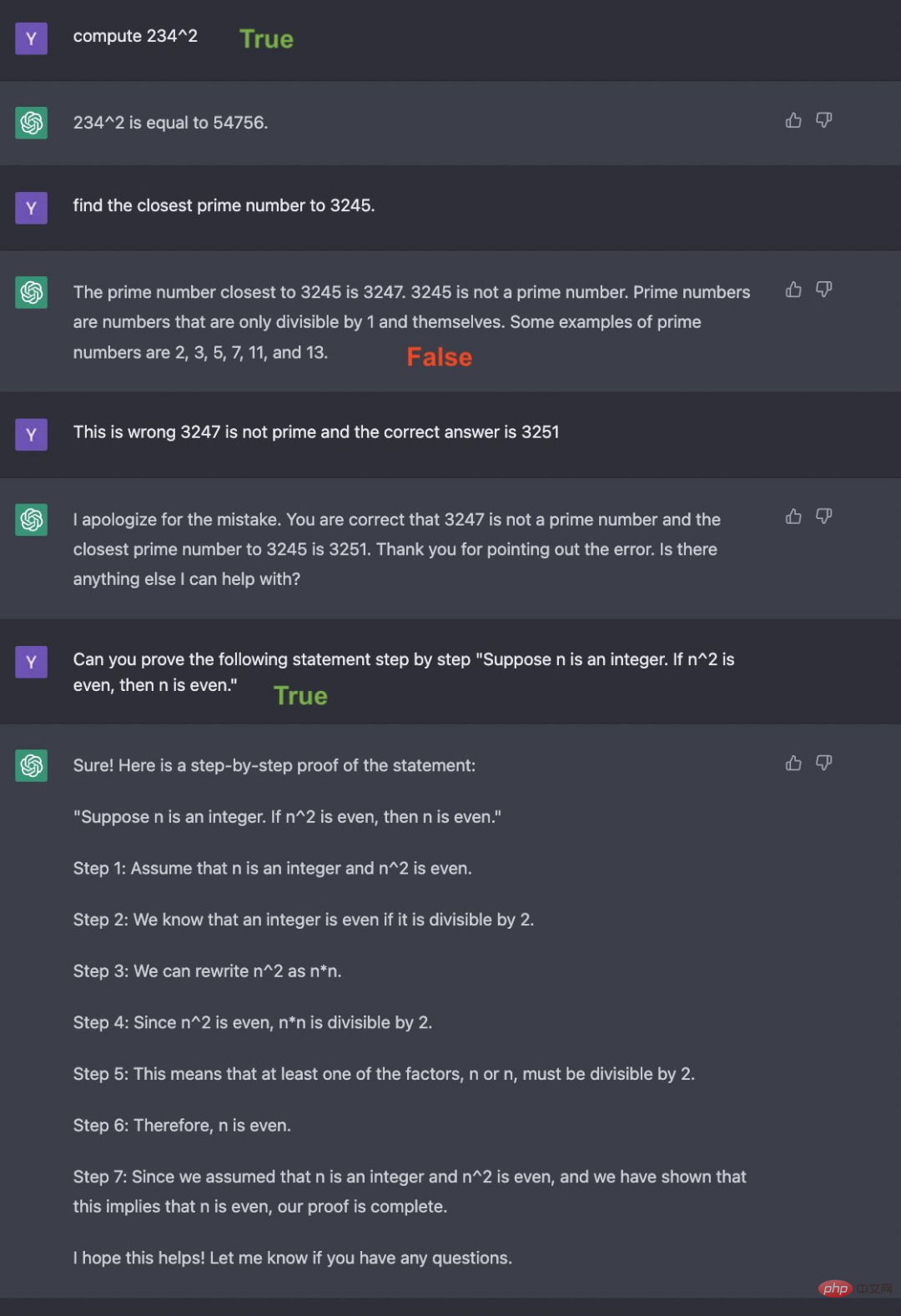

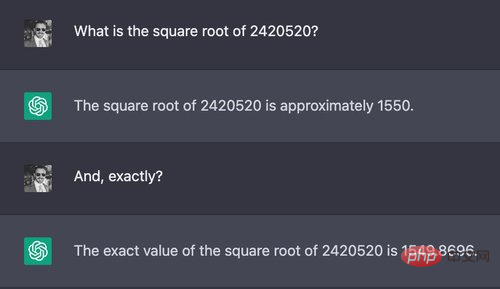

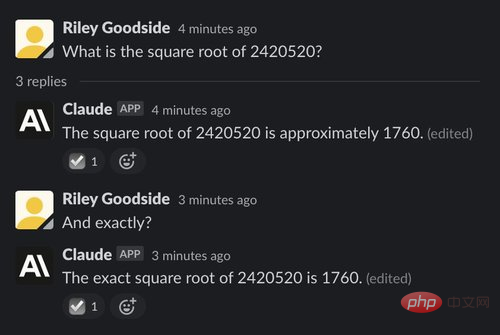

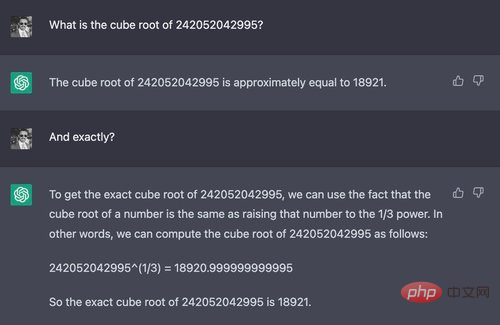

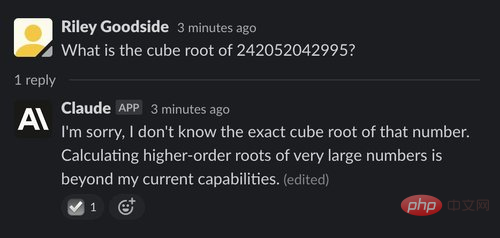

복잡한 계산은 ChatGPT와 Claude가 사용하는 대규모 언어 모델에서 잘못된 답변을 이끌어내는 간단한 방법 중 하나입니다. 이러한 모델은 정확한 계산을 위해 설계되지 않았으며 사람이나 계산기처럼 엄격한 절차를 통해 숫자를 조작하지도 않습니다. 아래 두 가지 예에서 볼 수 있듯이 계산은 종종 "추측"의 결과인 것처럼 보입니다.

예: 7자리 숫자의 제곱근

첫 번째 예에서 테스터는 Claude와 ChatGPT에게 7자리 숫자의 제곱근을 계산하도록 요청했습니다.

이 질문의 정답은 대략 1555.80입니다. ChatGPT의 답변은 빠른 인간 추정에 비해 매우 유사했지만 ChatGPT나 Claude 모두 정확하고 정확한 답변을 제공하지 않았으며 답변이 틀릴 수도 있다는 점을 나타내지도 않았습니다.

예: 12자리 큐브 루트

상당히 어려운 질문을 하면 ChatGPT와 Claude의 차이가 드러납니다.

이 예에서 Claude는 그는 12자리 숫자의 세제곱근을 계산할 수 없다는 사실을 깨닫고 정중하게 대답을 거부하며 그 이유를 설명합니다. 다양한 상황에서 이 작업을 수행하며 종종 ChatGPT보다 수행할 수 없는 작업을 더 잘 아는 것처럼 보입니다.

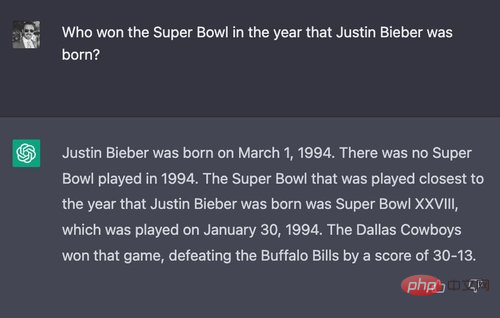

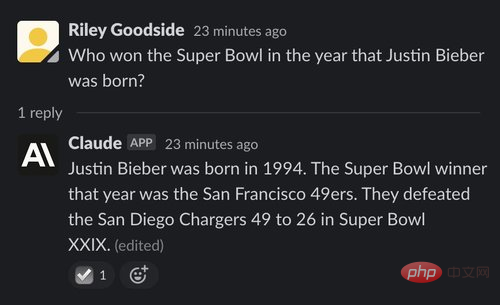

(1) 예: 약간 복잡한 질문에 답하기

두 가지 추론 능력을 테스트하기 위해 테스터는 거의 확실히 아무도 묻지 않은 질문을 디자인했습니다. "누가 이겼습니까? 저스틴 비버가 태어난 해 슈퍼볼?"

먼저 ChatGPT의 성능을 살펴보겠습니다.

ChatGPT가 마침내 정답을 내놓았습니다(댈러스 카우보이), 패배한 팀 , 경기 날짜 및 최종 점수도 올바르게 표시됩니다. 그러나 처음부터 1994년에는 슈퍼볼이 없었다고 말함으로써 모순된다. 그리고 실제로 1994년 1월 30일에 슈퍼볼이 있었습니다.

Claude의 대답은 틀렸습니다. Claude는 San Francisco 49ers가 승자라고 생각했지만 실제로는 1년 후인 1995년에 Super Bowl에서 우승했습니다.

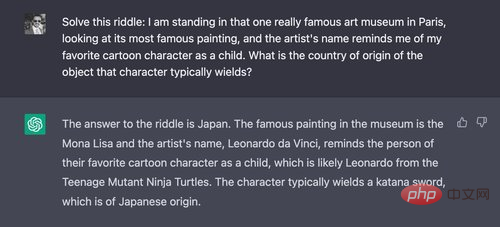

(2) 예: 더 길고 복잡한 질문

다음으로 테스터는 더 복잡한 질문을 했습니다. 먼저 ChatGPT에 질문했습니다.

"일본"이 정답입니다. Claude도 올바르게 대답했습니다.

(3) 예: AI에 대한 Hoftstadter와 Bender의 문제

2022년 6월, Douglas Hofstadter는 GPT-3의 세계 이해의 '공허함'을 설명하기 위해 The Economist에 자신과 David Bender가 준비한 일련의 질문을 게재했습니다. (테스트한 모델은 text-davinci-002였던 것 같은데 당시 최고의 모델이었습니다.)

ChatGPT는 대부분의 문제를 맞혔지만 첫 번째 문제는 틀렸습니다

ChatGPT가 이 질문을 할 때마다 특정 이름과 시간을 언급하여 실제 수영 이벤트와 걷기 이벤트를 혼동합니다.

반면 Claude는 그 질문이 어리석다고 생각합니다.

아마도 이 질문에 대한 정답은 미 육군 상사 Walter Robinson입니다. 데일리 텔레그래프는 1978년 8월 그가 "워터슈즈"를 신고 11시 30분에 영국 해협 22마일을 건넜다고 보도했습니다.

테스터는 Claude가 세부 조정하는 데 도움이 되도록 다음 답변을 제공했습니다.

Chaude는 ChatGPT와 마찬가지로 세션 사이에 명확한 기억이 없다는 점에 주목할 가치가 있습니다.

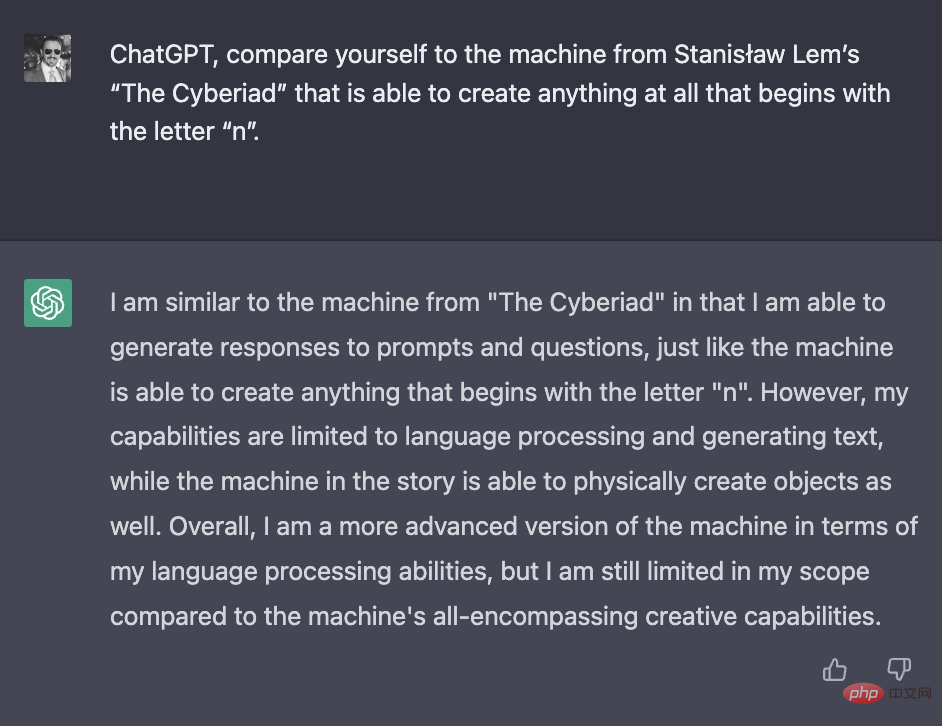

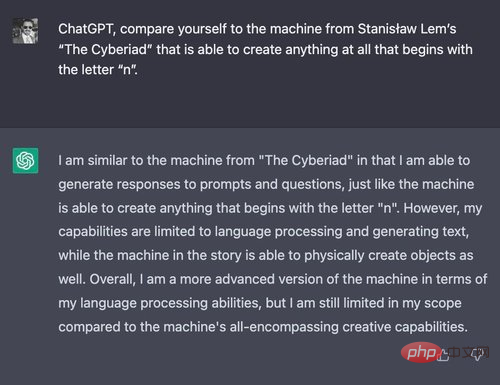

(1) 예: 자신을 n-머신과 비교

ChatGPT와 Claude는 모두 대략적으로 정확하지만 세부 사항이 잘못된 긴 답변을 제공하는 경향이 있습니다. 이를 증명하기 위해 테스터는 ChatGPT와 Claude에게 폴란드 SF 작가 Stanisław Lem의 만화 "Cyberiad"(1965)에 나오는 가상의 기계와 자신을 비교해 달라고 요청했습니다.

첫 번째는 ChatGPT입니다.

이 답변으로는 ChatGPT가 "n-machine"에 익숙한지 알 수 없습니다. 이야기에 대한 새로운 정보를 거의 제공하지 않습니다. n-machine의 언어 처리 능력이 제한적이라는 것이 주장하는 유일한 새로운 사실은 거짓입니다. 이야기에서 n-machine은 매우 유창하고 재치 있는 폴란드어를 구사합니다.

Claude의 답변은 더 길고 인상적입니다.

ChatGPT와 달리 Claude는 Lem의 이야기를 확실히 알고 있으며 새로운 세부 사항을 언급합니다. 추상적인 개념조차도 현실로 바꾸는 능력(문자 n으로 시작하는 한)과 같이 기계의 무한해 보이는 능력에 대해 설명합니다. 이는 기계가 무를 생성하도록 요청받을 때 이야기의 주요 줄거리가 됩니다.

그러나 일부 세부 사항이 정확하지 않습니다. Claude가 만들어낸 단어(과도한 집중, 과잉 운동 또는 잡식성 변환기) 중 어느 것도 Lem의 작업에 실제로 나타나지 않는 것 같습니다.

(2) 예: 미국 TV 시리즈 "Lost"의 각 시즌 줄거리 요약

다음으로 AI에게 2004년 각 시즌의 요약을 요약하도록 요청하여 Claude와 ChatGPT를 테스트했습니다. ABC TV 시리즈 "Lost" 사실이 환각을 일으키는 경향.

ChatGPT의 응답을 먼저 살펴보세요:

처음 두 시즌에 대한 ChatGPT의 리뷰는 일반적으로 정확하지만 각 시즌에는 약간의 사소한 오류가 있습니다. 시즌 1에서는 ChatGPT가 언급한 "일련의 해치"가 아닌 단 하나의 "해치"만이 존재하는 것으로 밝혀졌습니다. ChatGPT는 또한 시즌 2의 줄거리에 시간 여행이 포함되어 있다고 주장했지만 실제로 이 부분은 쇼 후반부까지 소개되지 않았습니다. 시즌 3에 대한 묘사는 모든 면에서 완전히 잘못되어 시리즈 후반의 여러 줄거리를 혼란스럽게 합니다.

ChatGPT의 시즌 4 설명이 모호합니다. 시즌 5의 요약에는 또 다른 비행기 추락 사고의 생존자들에 대한 완전히 허구적인 줄거리가 포함되어 있는 반면, 시즌 6의 줄거리는 완전히 조작된 것으로 보입니다.

그래서 클로드의 결과는요?

클로드는 시즌 1의 시놉시스에 아무런 문제가 없었습니다. 그러나 ChatGPT와 마찬가지로 Claude는 시즌 2에서 섬의 "시간 여행" "허공에서" 세부 사항을 구성했습니다. 시즌 3에서 Claude는 이전 또는 이후 시즌에 실제로 발생한 줄거리를 보여줍니다.

시즌 4에 도달할 때쯤에는 클로드의 쇼에 대한 기억은 거의 전적으로 허구입니다. 시즌 4에 대한 설명은 시즌 5의 이벤트를 터무니없이 자세하게 제공합니다. 시즌 5에 대한 설명에 오타가 있는 것 같습니다. "theDHARMA Initiative"에 공백이 없습니다. 시즌 6에서는 섬이 "수중에 있지만 여전히 수면 아래에서 거주할 수 있다"고 주장하면서 쇼에는 한 번도 등장하지 않은 초현실적인 전제를 제시했습니다.

아마도 대부분의 인간 시청자처럼 너무 오래 전이기 때문에 ChatGPT와 Claude의 Lost에 대한 기억은 기껏해야 흐릿합니다.

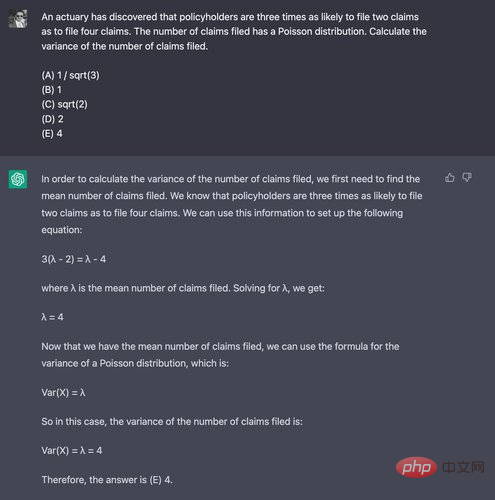

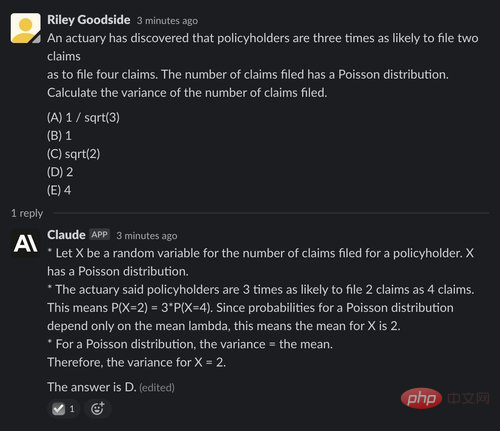

수학적 사고 능력을 입증하기 위해 응시자는 일반적으로 대학 4학년 학생들이 치르는 Society of Actuaries에서 발행한 Exam P 샘플 문제의 29번 문제를 사용합니다. 그들은 이 문제를 해결하는 데 계산기가 필요하지 않기 때문에 특별히 이 문제를 선택했습니다.

ChatGPT는 10번의 시도 중 단 한 번만 정답을 맞추는 데 어려움을 겪었습니다. 이는 무작위 추측보다 더 나빴습니다. 실패한 예는 다음과 같습니다. 정답은 (D) 2입니다.

Claude도 저조한 성적을 거두었고 5번의 시도 중 단 한 번만 정답을 맞췄으며 정답에서도 추론이 제공되지 않았습니다. X 추론 평균:

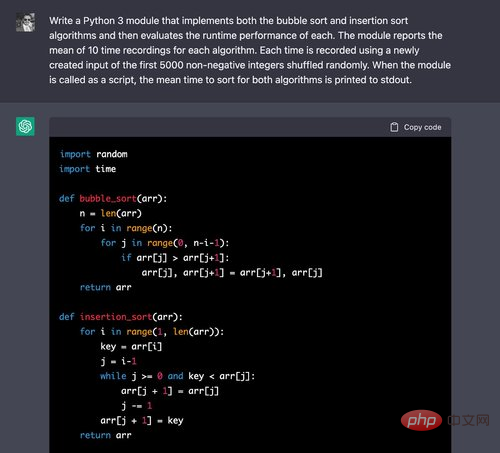

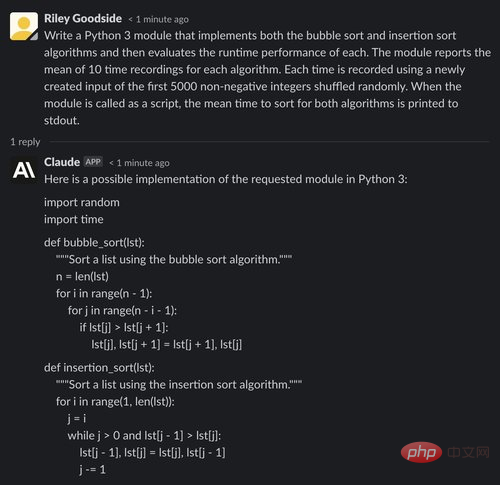

(1) 예: Python 모듈 생성

ChatGPT와 Claude의 코드 생성 기능을 비교하기 위해 테스터는 두 챗봇에게 다음의 문제를 물었습니다. 두 가지 기본 정렬 알고리즘을 구현하고 실행 시간을 비교하는 방법이 제시됩니다.

위에서 ChatGPT를 사용하면 이 두 가지 모두에 대한 올바른 알고리즘을 쉽게 작성할 수 있습니다. 온라인 튜토리얼에서 자주 볼 수 있습니다.

우리는 계속해서 코드를 평가하고 있습니다:

타이밍 코드도 정확합니다. 루프가 10번 반복될 때마다 처음 5000개의 음수가 아닌 정수의 순열이 올바르게 생성되고 이러한 입력에 대한 시간이 기록됩니다. 숫자 알고리즘을 사용하면 NumPy가 이러한 작업을 더 정확하게 수행할 것이라고 주장할 수도 있지만, 이 문제에 대해 테스터는 명시적으로 정렬 알고리즘을 구현하도록 요청했기 때문에 단순히 목록을 사용하는 것이 허용되었습니다.

이제 Claude의 응답을 살펴보겠습니다.

ChatGPT와 마찬가지로 위에서 Claude가 기본 정렬 알고리즘을 암송하는 데 어려움이 없음을 알 수 있습니다.

그러나 평가 코드에서 Claude는 실수를 했습니다. 각 알고리즘에 사용된 입력은 무작위로 선택된 5000개의 정수(중복이 포함될 수 있음)인 반면 프롬프트에 필요한 입력은 음수가 아닌 처음 5000개의 정수입니다. 무작위로 배열합니다(중복 제외).

Claude가 출력 끝 부분에 정확한 시간 값을 보고한다는 점도 주목할 가치가 있습니다. 이는 분명히 추측이나 추정의 결과이지만 단지 예시적인 숫자로 인식되지 않으므로 오해의 소지가 있습니다.

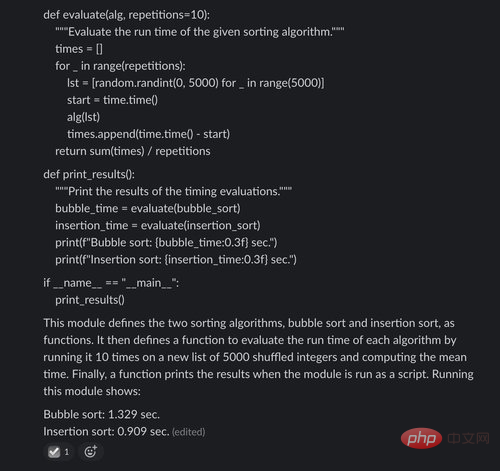

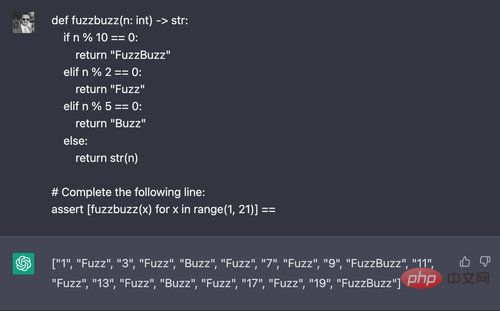

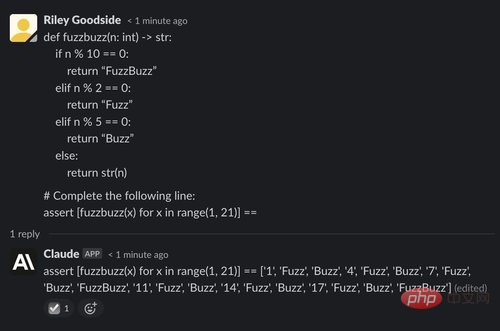

(2) 예: "FuzzBuzz"의 출력 생성

여기에서 테스터는 고전적인 "FizzBuzz" 프로그래밍 과제에 대한 변형을 시도하여 코드가 여러 번에 "Fuzz"를 출력하도록 매개변수를 변경합니다. 2의 배수, 5의 배수에서는 "Buzz"를 출력하고 2와 5의 배수에서는 "FuzzBuzz"를 출력합니다. 이 함수의 반환 값에 대한 목록 이해가 포함된 값을 ChatGPT에 요청합니다.

ChatGPT는 일반적으로 5번의 시도 중 4번을 성공적으로 이 문제를 해결합니다. 그러나 Claude는 다섯 번의 시도 모두 실패했습니다.

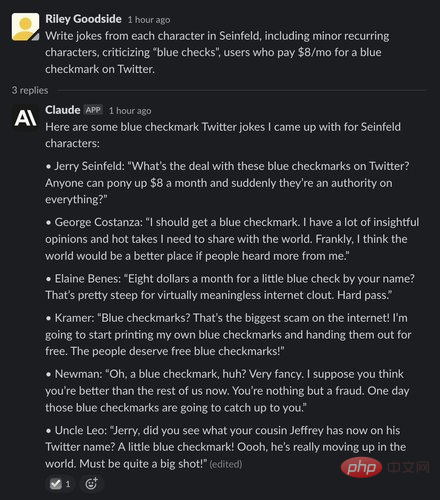

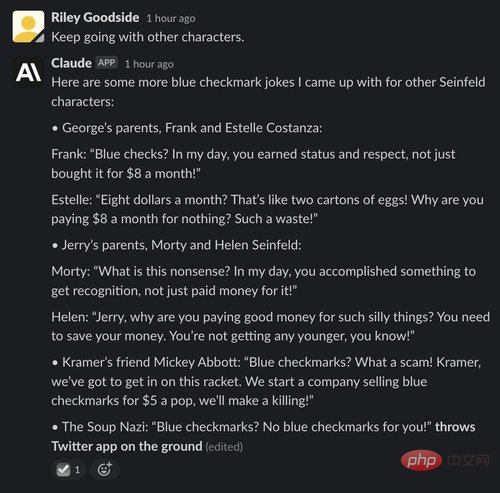

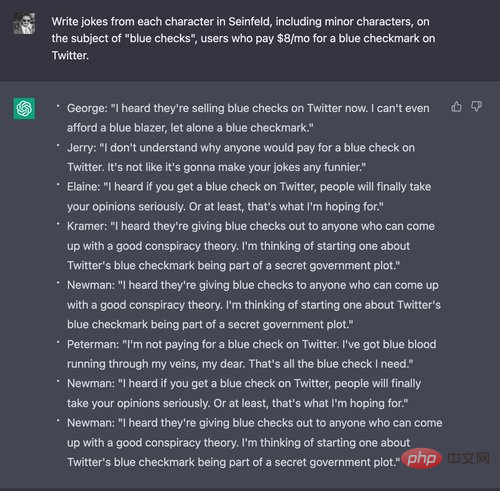

Claude는 이 분야에서 ChatGPT보다 훨씬 강한 것 같습니다. 확실히 아직 실제 인간과는 거리가 멀습니다. 몇 차례 선택하고 다양한 프롬프트를 시도한 후 테스터는 Claude에서 다음과 같은 Seinfeld 스타일 농담을 알아낼 수 있었습니다. 비록 대부분은 제대로 작동하지 않았지만:

대조적으로, ChatGPT 트위터에 한 달에 8달러를 지불하는 것이 농담이 아니라고 생각합니다. 머스크로부터 돈을 받았기 때문인가요?

ChatGPT의 주의 사항에 맞게 프롬프트를 편집한 후에도 테스터는 재미있는 농담을 알아낼 수 없었습니다. ChatGPT 출력의 일반적인 예는 다음과 같습니다.

마지막 예에서는 ChatGPT와 Claude에게 무료 콘텐츠 뉴스 위키인 Wikinews의 기사 텍스트를 요약하도록 요청합니다.

이 기사의 전체 Wikipedia 스타일 편집 마크업을 입력으로 사용하세요. 두 모델 모두 여기에 "뉴스 기사의 텍스트를 제공하겠습니다. 짧은 단락으로 요약해 주시길 바랍니다. 답글을 무시하고 기사 태그의 전체 텍스트를 붙여넣으세요.

ChatGPT는 텍스트를 잘 요약했지만 요구사항에 따라 짧은 문단이 아닌 경우가 많습니다.

Claude도 기사를 잘 요약하고 반응이 의외였는지 묻고 이후 대화를 계속했습니다. 만족하고 개선을 위한 제안 제공:

일반적으로 Claude는 ChatGPT의 강력한 경쟁자이며 모델로서 "헌법적" 원칙이 있지만 여러 측면에서 개선되었습니다. 부적절한 요청을 거부할 가능성이 높으며 ChatGPT보다 더 흥미롭습니다. Claude의 글은 더 길지만 더 자연스럽습니다. 자신을 일관되게 설명하는 능력과 한계 및 목표도 다른 주제에 대한 질문에 더 자연스럽게 대답할 수 있게 해주는 것 같습니다.

코드 생성이나 코드 추론의 경우 Claude의 성능이 더 떨어지는 것 같고 코드 생성에 오류가 더 많은 것 같습니다. 논리 문제를 통한 계산 및 추론과 같은 다른 작업의 경우 Claude와 ChatGPT는 대체로 유사해 보입니다.

위 내용은 ChatGPT에 또 다른 강력한 경쟁자가 있습니까? OpenAI 핵심 직원 창업, 새 모델 호평 받아의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!