기술 주변기기

기술 주변기기

일체 포함

일체 포함

AIGC 통합 모델이 나왔습니다! 이력서 업계의 선두주자인 황서타오(Huang Xutao)가 설립한 팀이 'Almighty Diffusion'을 제안했습니다.

AIGC 통합 모델이 나왔습니다! 이력서 업계의 선두주자인 황서타오(Huang Xutao)가 설립한 팀이 'Almighty Diffusion'을 제안했습니다.

AIGC 통합 모델이 나왔습니다! 이력서 업계의 선두주자인 황서타오(Huang Xutao)가 설립한 팀이 'Almighty Diffusion'을 제안했습니다.

확산 모델의 최근 발전은 많은 생성 작업에서 인상적인 이정표를 세웠습니다. DALL·E 2, Imagen, SD(Stable Diffusion) 등 매력적인 작품들이 학계와 업계에서 큰 관심을 불러일으켰습니다.

이러한 모델은 놀라운 성능을 발휘하지만 기본적으로 특정 텍스트에서 이미지를 생성하는 등 특정 유형의 작업에 중점을 두고 있으며, 다양한 유형의 작업을 수행하려면 모델을 별도로 학습하거나 재구성해야 하는 경우가 많습니다.

그렇다면 AIGC 모델의 통합을 달성하기 위해 이전 모델을 기반으로 "만능" 확산을 구축할 수 있을까요? 어떤 사람들은 이 방향으로 탐구하려고 노력하고 있으며 진전을 이루었습니다.

일리노이 대학교 어바나-샴페인 캠퍼스와 텍사스 대학교 오스틴 캠퍼스의 공동 팀은 기존의 단일 스트림 확산을 VD(Versatile Diffusion)라는 다중 스트림 네트워크로 확장하려고 합니다. 첫째, 통합 다중 스트림 다중 모드 확산 프레임워크는 일반 생성 인공 지능을 향한 단계입니다.

문서 주소: https://arxiv.org/abs/2211.08332

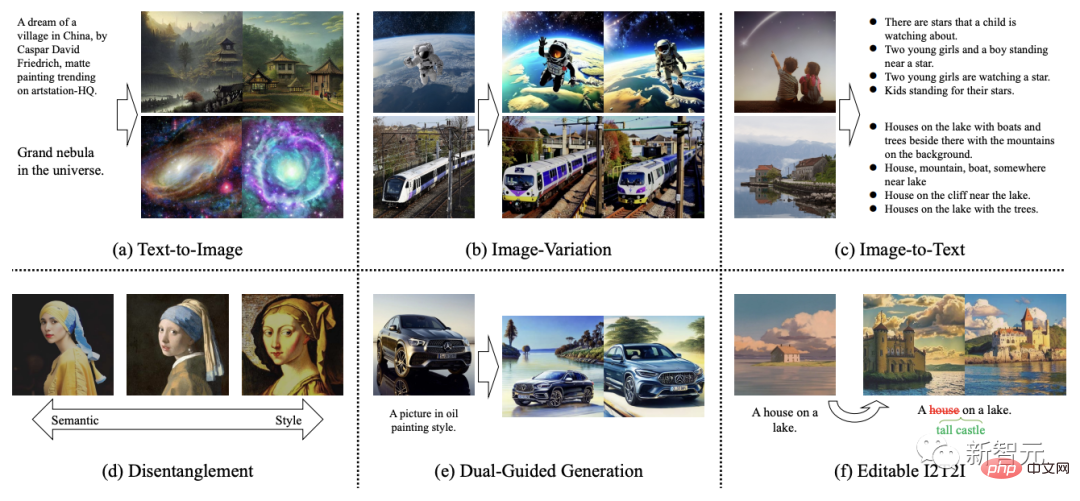

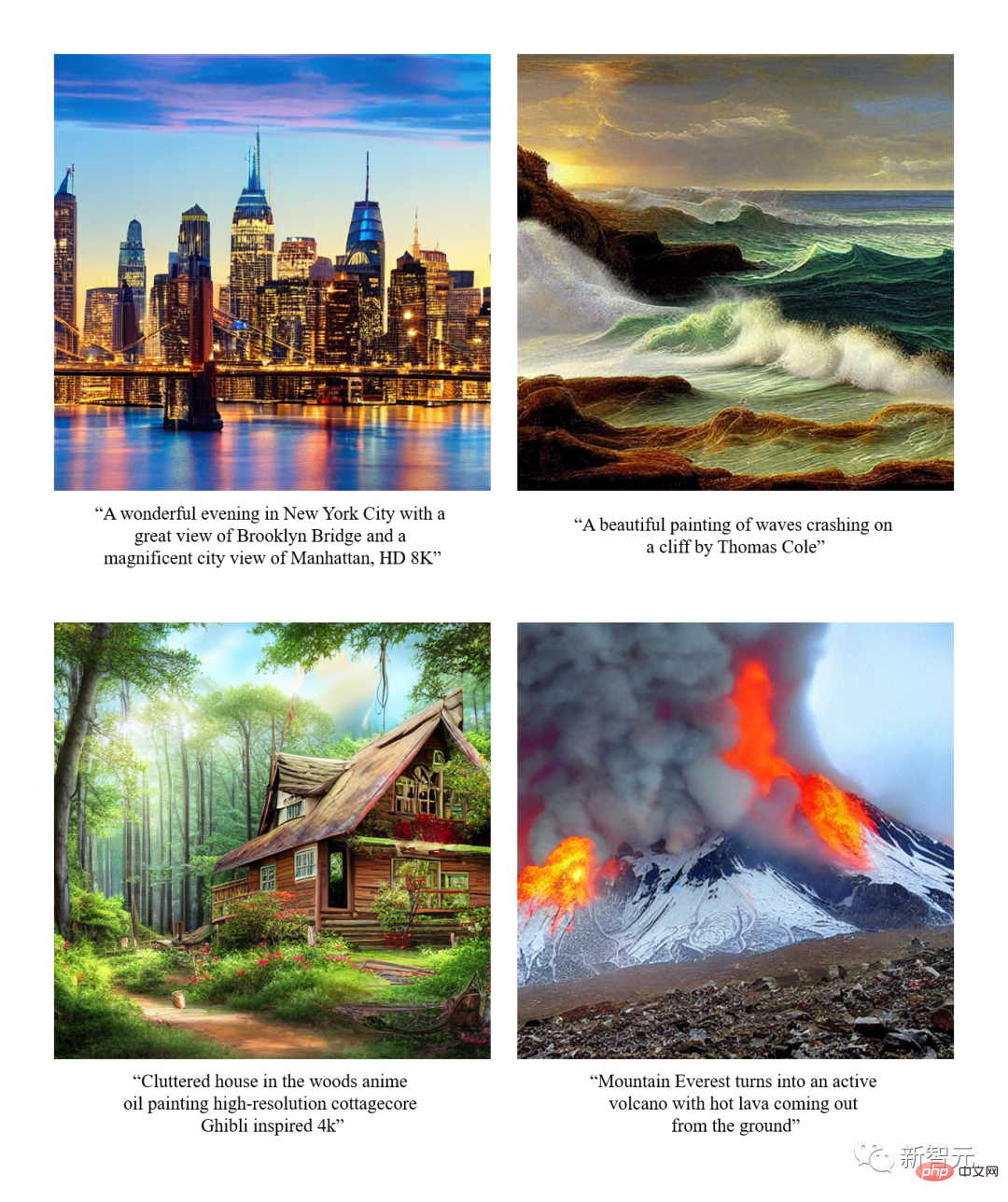

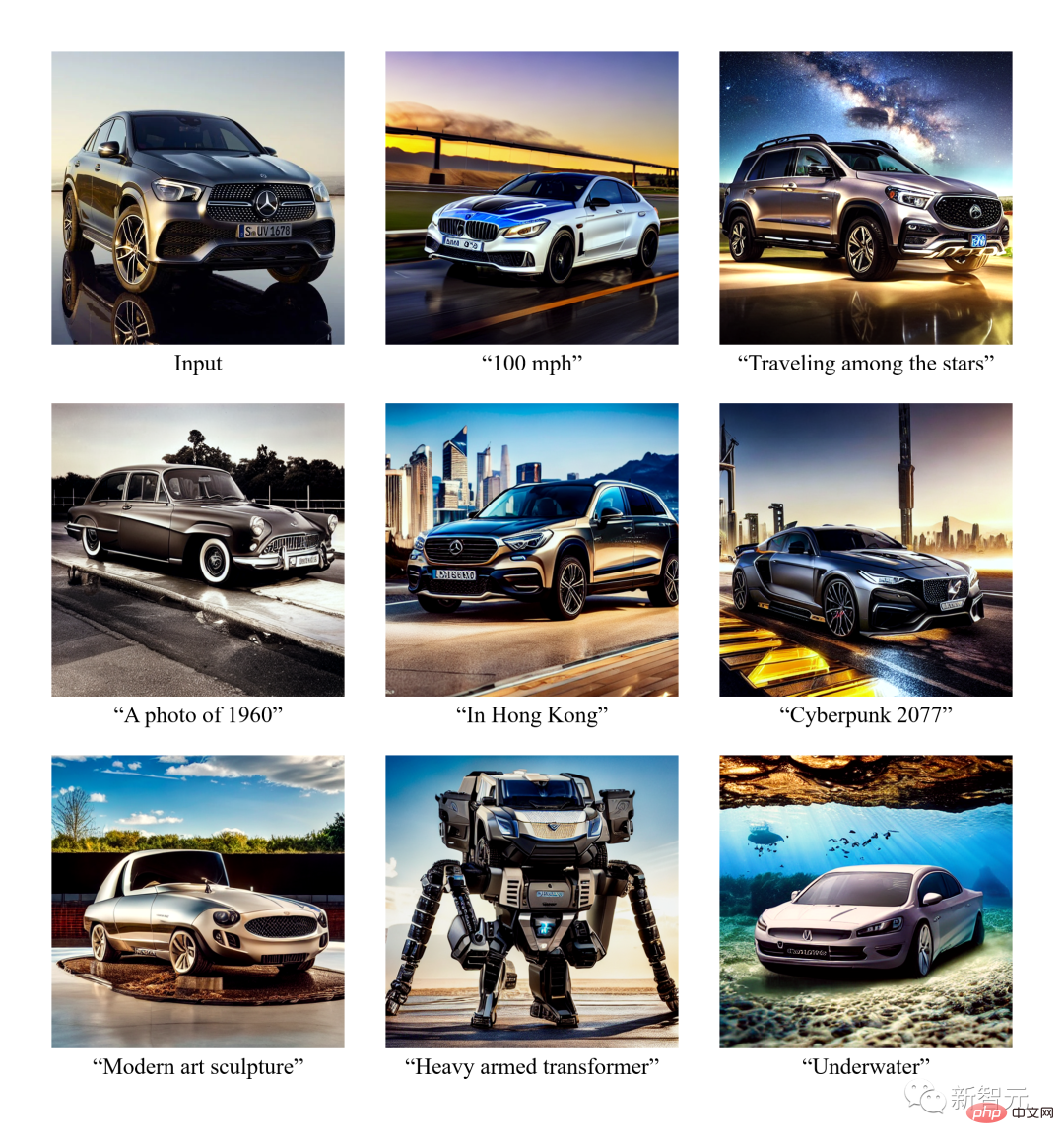

Versatile Diffusion은 일반적인 텍스트 생성 이미지 기능 외에도 이미지를 입력하여 유사한 이미지를 생성할 수도 있습니다. .텍스트를 생성하기 위한 이미지 입력, 유사 텍스트 생성을 위한 텍스트 입력, 이미지 의미 분리 편집, 비디오 생성을 위한 이미지와 텍스트 입력, 잠재 공간을 기반으로 이미지 콘텐츠 편집 등

향후 버전에서는 음성, 음악, 비디오, 3D 등 더 많은 모드도 지원할 예정입니다.

논문에 따르면 VD와 그 기본 프레임워크는 다음과 같은 장점이 있는 것으로 입증되었습니다.

a) 경쟁력 있는 고품질로 모든 하위 작업을 처리할 수 있습니다.

b) 그래픽 스타일과 의미 분리, 이미지-텍스트 이중 안내 생성 등과 같은 새로운 확장 및 애플리케이션을 지원합니다.

c) 이러한 실험과 애플리케이션은 생성된 출력에 대한 더 풍부한 의미론적 통찰력을 제공합니다.

VD에서는 학습 데이터 세트의 경우 맞춤형 데이터 필터가 포함된 Laion2B-en을 주요 데이터 세트로 사용합니다.

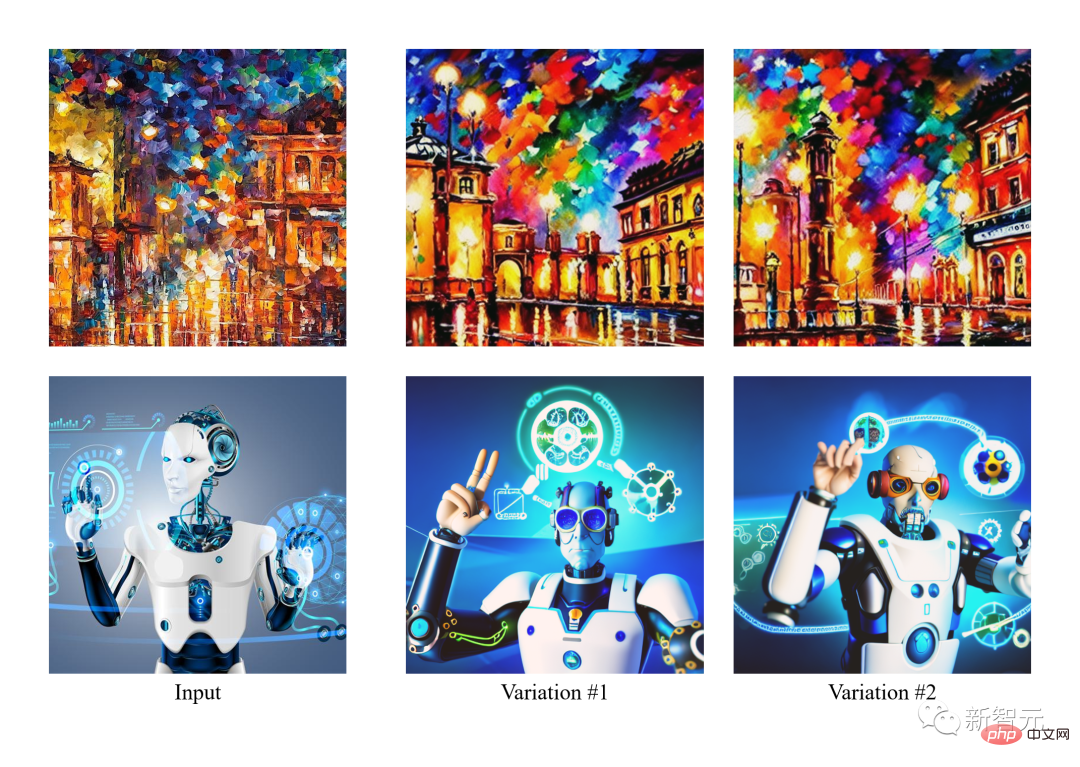

VD의 첫 번째 탐색에서 흥미로운 발견은 추가 감독 없이 이미지 스타일을 의미상 향상하거나 줄일 수 있다는 것입니다.

이러한 현상은 저자가 완전히 새로운 분야를 탐구하도록 영감을 주었습니다. 여기서는 임의의 스타일과 임의의 콘텐츠가 포함된 이미지에 대해 스타일과 의미의 분리가 발생할 수 있습니다.

저자들은 a) 영역 지정 없이 자연 이미지의 의미론적 및 스타일 해석 b) 확산 모델의 잠재 공간에 대한 의미론적 및 스타일 분해를 탐구한 최초의 팀이라고 밝혔습니다.

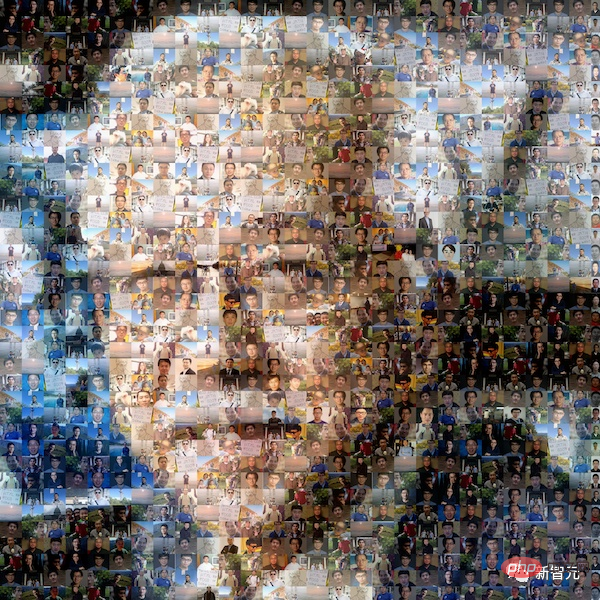

아래 이미지에서 작성자는 먼저 입력 이미지의 변형을 생성한 다음 의미(왼쪽) 또는 스타일(오른쪽)에 초점을 맞춰 작업합니다.

VD는 이미지를 텍스트로, 텍스트를 이미지로 모두 지원하기 때문에 저자 팀은 처음으로 다음 단계에 따라 텍스트 프롬프트의 관점에서 이미지를 편집하려고 시도했습니다. a) 이미지를 텍스트로 변환, b) 텍스트 편집,c) 텍스트를 다시 이미지로 변환합니다.

실험에서 저자는 이미지에서 설명된 내용을 제거한 다음 이 이미지-텍스트-이미지(I2T2I) 패러다임을 사용하여 새로운 콘텐츠를 추가했습니다. 객체의 위치를 입력으로 요구하는 페인팅이나 기타 이미지 편집 방법과 달리 VD의 I2T2I는 지시에 따라 객체를 자동으로 배치하고 교체할 수 있으므로 마스크가 필요하지 않습니다.

그러나 I2T2I의 출력 이미지는 입력 이미지의 픽셀과 일치하지 않습니다. 이는 이미지-텍스트 의미 정제 및 텍스트-이미지 콘텐츠 생성으로 인해 발생합니다.

아래 디스플레이에서는 입력 이미지가 먼저 프롬프트로 변환된 다음 빼기(빨간색 상자)와 추가(녹색 상자)를 사용하여 프롬프트가 편집됩니다. 마지막으로 편집된 프롬프트가 이미지로 변환됩니다.

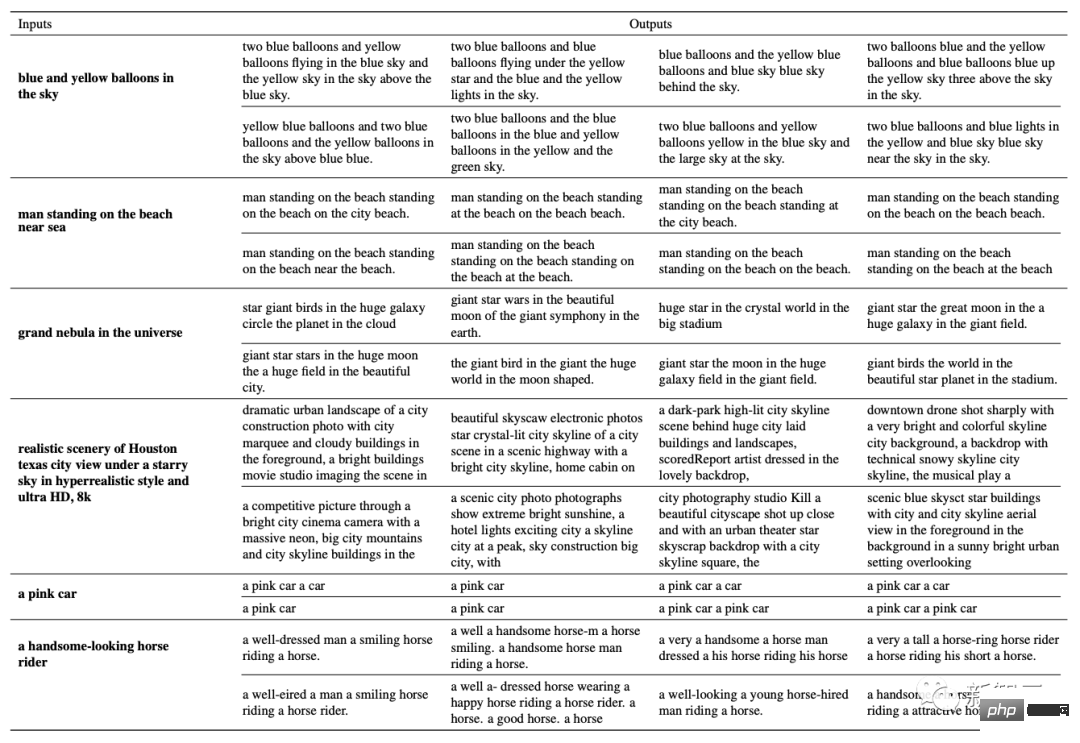

또한 그들은 주어진 텍스트를 기반으로 유사한 텍스트를 생성하는 방법을 연구하는 최초의 팀이기도 합니다.

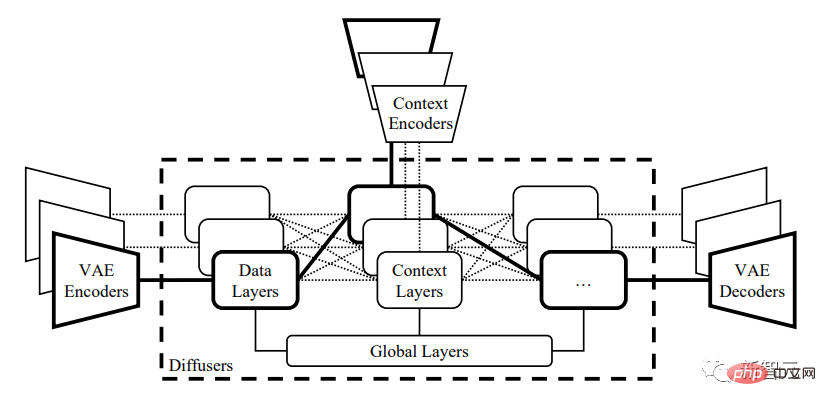

Network Framework

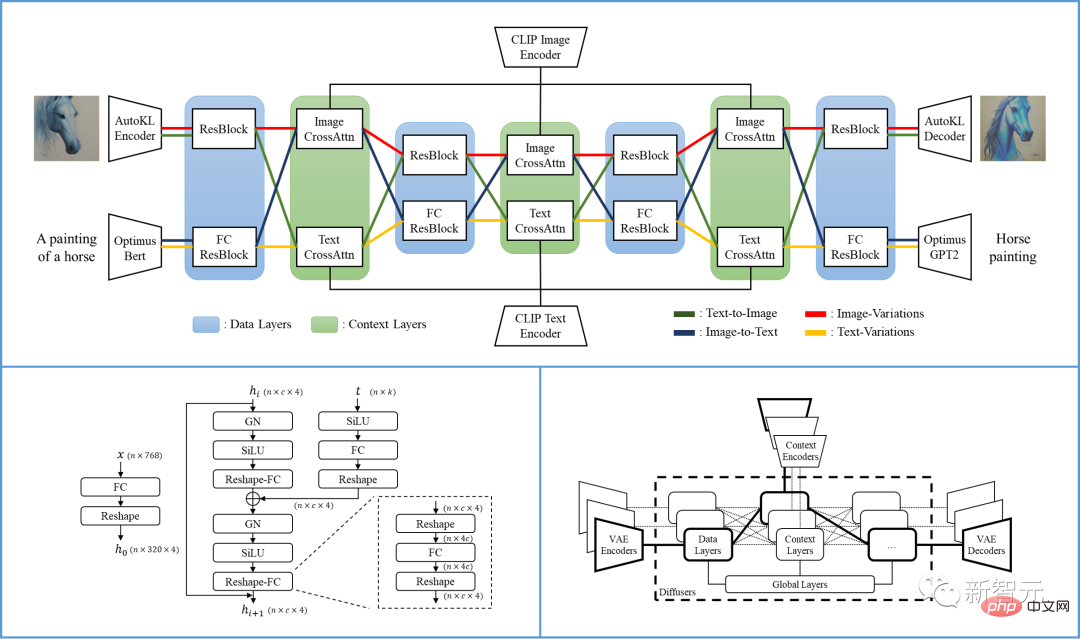

구체적으로, 논문에서 제안하는 VD 프레임워크는 다양한 유형의 데이터를 입력 및 배경으로 사용하는 멀티 스트림 네트워크입니다.

VD 다중 스트림 다중 모달 확산 프레임워크는 해석 가능한 잠재 공간, 모달 구조 및 낮은 계산 비용 등 LDM/SD의 장점을 계승합니다.

VD는 여러 스트림을 공동으로 훈련할 수 있으며 각 스트림은 교차 모달 작업을 나타냅니다. 핵심 설계는 네트워크 내에서 프로토콜 그룹화, 공유 및 전환을 확산하여 지원되는 모든 작업 및 그 이상에 프레임워크를 적용하는 것입니다.

디퓨저는 글로벌 레이어, 데이터 레이어, 컨텍스트 레이어의 세 그룹으로 나뉩니다. 전역 레이어는 시간적 임베딩 레이어, 데이터 레이어는 잔차 블록, 컨텍스트 레이어는 교차 주의입니다.

이 그룹화는 레이어의 기능에 해당합니다. 여러 작업을 수행할 때 글로벌 레이어는 모든 작업에서 공유됩니다. 데이터 계층과 컨텍스트 계층에는 여러 데이터 흐름이 포함되어 있습니다. 각 데이터 스트림은 현재 데이터 및 컨텍스트 유형에 따라 공유되거나 교환될 수 있습니다.

예를 들어 텍스트 이미지 요청을 처리할 때 디퓨저는 이미지 데이터 레이어와 텍스트 컨텍스트 레이어를 사용합니다. 이미지 변형 작업을 처리할 때 이미지 데이터 계층과 이미지 컨텍스트 계층이 사용됩니다.

단일 VD 프로세스에는 VAE, 디퓨저 및 컨텍스트 인코더가 포함되어 있으며, 하나의 데이터 유형(예: 이미지)과 하나의 컨텍스트 유형(예: 텍스트)에서 하나의 작업(예: 텍스트에서 이미지로)을 처리합니다.

Versatile Diffusion의 멀티 스트림 구조는 아래 그림에 나와 있습니다.

Versatile Diffusion을 기반으로 연구원들은 VAE, 컨텍스트를 포함하는 일반적인 멀티 스트림 멀티 모드 프레임워크를 추가로 제안했습니다. 인코더 및 3계층(예: 전역, 데이터 및 컨텍스트 계층) 디퓨저.

디퓨저:

VD는 널리 채택된 교차 초점 UNet을 디퓨저 네트워크의 주요 아키텍처로 사용하여 레이어를 글로벌 레이어, 데이터 레이어 및 컨텍스트 레이어로 나눕니다. 데이터 계층과 컨텍스트 계층에는 이미지와 텍스트를 지원하는 두 개의 데이터 스트림이 있습니다.

이미지 데이터 흐름에는 LDM을 따르고 공간 차원이 점차 감소하고 채널 수가 점차 증가하는 잔여 블록(ResBlock)을 사용합니다.

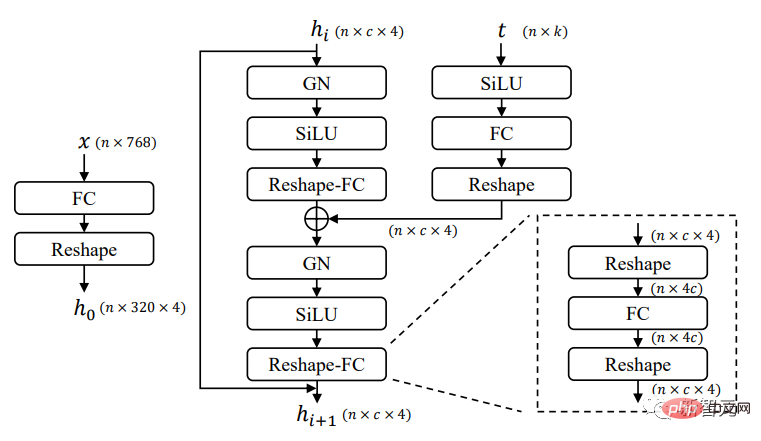

텍스트 데이터 흐름의 경우 새로운 완전 연결 잔여 블록(FCResBlock)을 사용하여 768차원 텍스트 잠재 벡터를 320*4 숨겨진 기능으로 확장하고 유사한 채널 증가 패러다임을 따른 다음 GroupNorms, SiLU 및 일반적인 ResBlock과 마찬가지로 연결을 건너뜁니다.

위 그림에서 볼 수 있듯이 FCResBlock에는 완전 연결 레이어(FC), 그룹 정규화(GN) 및 시그모이드 선형 유닛(SiLU)의 두 세트가 포함되어 있습니다. x는 입력 텍스트 잠재 코드, t는 입력 시간 임베딩, hi는 중간 특성입니다.

컨텍스트 그룹의 경우 교차 관심 레이어는 이미지와 컨텍스트 스트림 모두에 사용되며, 여기서 콘텐츠 임베딩은 프로젝션 레이어, 내적 및 시그모이드를 통해 데이터 기능에 대해 작동합니다.

Variational Autoencoder (VAE):

VD는 이전의 잠재 확산 모델(Latent Diffusion Model, LDM) -KL의 오토인코더 -KL을 이미지 데이터 VAE로, Optimus를 텍스트 DataVAE로 사용합니다. Optimus는 BERT 텍스트 인코더와 GPT2 텍스트 디코더로 구성되어 문장을 768차원 정규 분포 잠재 벡터로 양방향으로 변환할 수 있습니다.

동시에 Optimus는 재구성 및 해석 가능한 텍스트 잠재 공간으로 만족스러운 VAE 속성도 보여줍니다. 따라서 Optimus는 다중 스트림 다중 모드 프레임워크의 전제 조건에 잘 맞기 때문에 텍스트 VAE로 선택되었습니다.

컨텍스트 인코더:

VD는 CLIP 텍스트 및 이미지 인코더를 컨텍스트 인코더로 사용합니다. 컨텍스트 입력으로 원시 텍스트 임베딩만 사용하는 LDM 및 SD와 달리 VD는 정규화 및 투영 임베딩을 사용하여 텍스트와 이미지의 CLIP 대비 손실을 최소화합니다.

실험에 따르면 컨텍스트 유형 간의 삽입 공간이 더 가까울수록 모델이 더 빠르게 수렴되고 더 나은 성능을 발휘하는 데 도움이 됩니다. DALL·E 2에서도 유사한 결론을 얻을 수 있습니다. 이는 추가 프로젝션 레이어를 사용하여 텍스트-이미지 모델을 미세 조정하여 이미지 변형에 대한 텍스트와 이미지 임베딩 간의 차이를 최소화합니다.

Performance

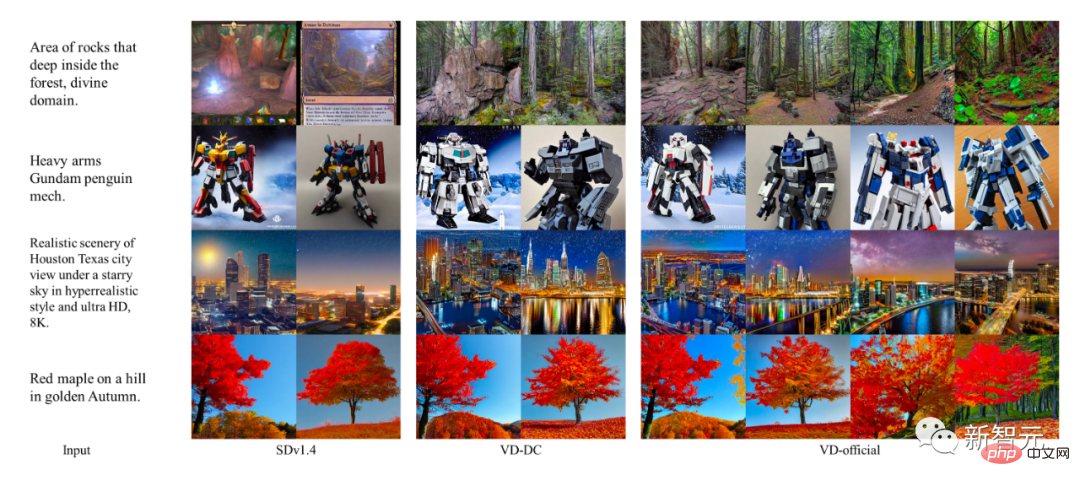

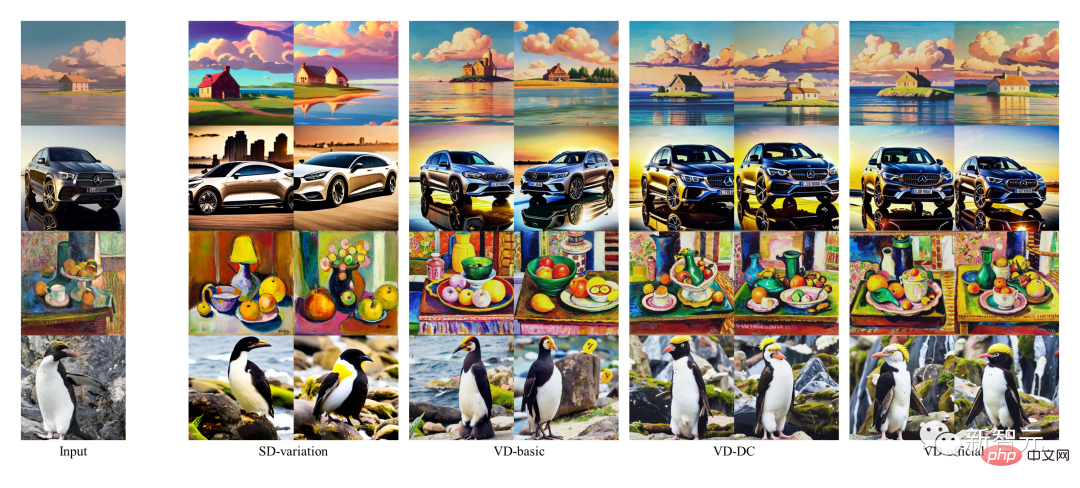

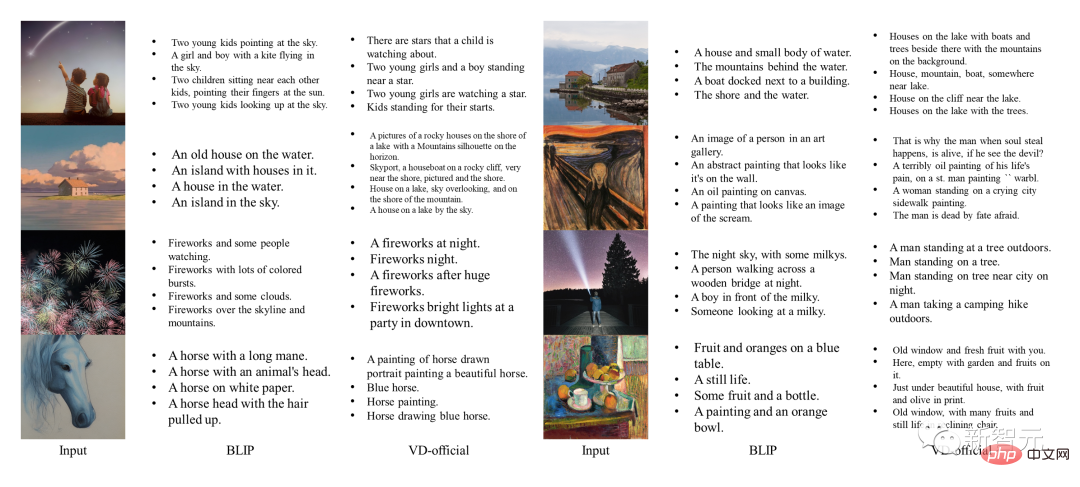

저자는 초기 단일 작업 모델을 기준 모델로 사용하고 VD 결과를 이러한 기준과 비교했습니다. 그 중 SDv1.4는 텍스트에서 이미지까지의 기본 모델로 사용되며, 이미지 변형에는 SD-variation, 이미지-텍스트에는 BLIP이 사용됩니다.

한편, 저자는 다양한 VD 모델에 대한 질적 비교도 수행했는데, 여기서 VDDC와 VD-official은 텍스트-이미지 변환에 사용되었고 세 가지 모델은 모두 이미지 변형에 사용되었습니다.

SD 및 VD의 이미지 샘플은 더 나은 품질 확인을 위해 제어된 무작위 시드를 사용하여 생성됩니다.

텍스트를 이미지로 변환하는 성능

DALLE 2와 Imagen도 이러한 작업에 대해 최첨단 결과를 달성했지만, 저자는 공개 코드나 교육 세부 정보가 없기 때문에 검토를 건너뛰었습니다. . 비교하다.

결과에 따르면 다중 프로세스 구조와 다중 작업 교육은 VD가 상황별 의미를 포착하고 출력을 보다 정확하게 생성하며 모든 하위 작업을 훌륭하게 완료하는 데 도움이 될 수 있음을 보여줍니다.

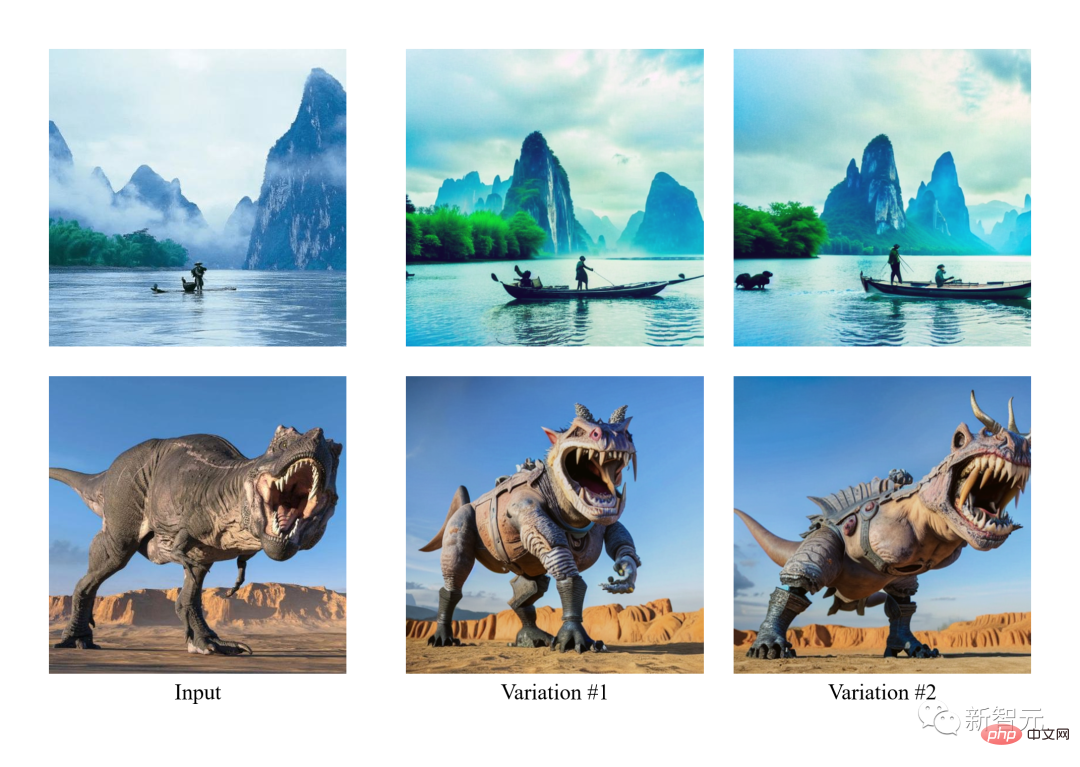

이미지 변형 성능

또한 VD에서 생성된 이미지 주석에는 창의적인 단어도 포함되어 있습니다. 이에 비해 BLIP의 생성은 매우 짧고 세부적인 설명이 부족합니다.

이미지를 텍스트로 변환하는 성능

효과 표시

Vincent Picture

이미지 변형

의미 중심 이미지 변형

이중 부팅

Summary

- 저자는 VD(Versatile Diffusion)를 소개합니다. 통합 모델에서 텍스트, 이미지 및 변형을 처리하는 다중 스트림 다중 모드 확산 네트워크입니다. VD를 기반으로 저자는 새로운 작업과 도메인을 포함할 수 있는 일반적인 다중 스트림 다중 모드 프레임워크를 추가로 소개합니다.

- 저자는 실험을 통해 VD가 지원되는 모든 작업에서 고품질 출력을 생성할 수 있다는 사실을 발견했습니다. 그 중 VD의 텍스트-이미지 및 이미지-변형 결과는 맥락에서 의미를 더 잘 포착할 수 있으며 VD의 이미지는- to-text 결과는 창의적이고 예시적입니다.

- VD의 다중 스트림 다중 모드 속성을 고려하여 저자는 이 기술을 사용하는 다운스트림 사용자에게 더욱 도움이 될 수 있는 새로운 확장 및 응용 프로그램을 소개합니다.

팀 소개

일리노이 대학 어바나-샴페인 캠퍼스의 IFP 팀은 1980년대 Huang Xutao 교수에 의해 설립되었으며, 원래는 Beckman Institute for Advanced Science and Technology의 이미지 형성 및 처리 그룹이었습니다.

수년에 걸쳐 IFP는 이미지 및 비디오 코딩, 다중 모드 인간-컴퓨터 상호 작용, 멀티미디어 주석 및 검색, 컴퓨터 비전 및 패턴 인식, 기계 학습, 빅 데이터, 딥 러닝 및 고성능 컴퓨팅.

IFP의 현재 연구 방향은 빅데이터, 딥 러닝 및 고성능 컴퓨팅을 공동으로 결합하여 다중 모드 정보 처리 문제를 해결하는 것입니다.

또한 IFP는 인공 지능 분야 최고의 컨퍼런스에서 다수의 최우수 논문을 수상했으며 최초의 NIST TrecVID, 최초의 ImageNet Challenge, 최초의 인공 지능 시티 챌린지를 포함하여 많은 국제 대회에서 우승했습니다.

흥미롭게도 황 교수가 1960년대 MIT에서 가르치기 시작한 이후 IFP 그룹의 "구성원"에는 친구, 학생, 학생의 학생, 학생의 학생, 심지어 학생의 학생도 포함되었습니다.

위 내용은 AIGC 통합 모델이 나왔습니다! 이력서 업계의 선두주자인 황서타오(Huang Xutao)가 설립한 팀이 'Almighty Diffusion'을 제안했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7333

7333

9

9

1627

1627

14

14

1351

1351

46

46

1263

1263

25

25

1209

1209

29

29

Uvicorn은 Serving_forever ()없이 HTTP 요청을 어떻게 지속적으로 듣습니까?

Apr 01, 2025 pm 10:51 PM

Uvicorn은 Serving_forever ()없이 HTTP 요청을 어떻게 지속적으로 듣습니까?

Apr 01, 2025 pm 10:51 PM

Uvicorn은 HTTP 요청을 어떻게 지속적으로 듣습니까? Uvicorn은 ASGI를 기반으로 한 가벼운 웹 서버입니다. 핵심 기능 중 하나는 HTTP 요청을 듣고 진행하는 것입니다 ...

문자열을 통해 객체를 동적으로 생성하고 방법을 파이썬으로 호출하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:18 PM

문자열을 통해 객체를 동적으로 생성하고 방법을 파이썬으로 호출하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:18 PM

파이썬에서 문자열을 통해 객체를 동적으로 생성하고 메소드를 호출하는 방법은 무엇입니까? 특히 구성 또는 실행 해야하는 경우 일반적인 프로그래밍 요구 사항입니다.

Go 또는 Rust를 사용하여 Python 스크립트를 호출하여 실제 병렬 실행을 달성하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:39 PM

Go 또는 Rust를 사용하여 Python 스크립트를 호출하여 실제 병렬 실행을 달성하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:39 PM

Go 또는 Rust를 사용하여 Python 스크립트를 호출하여 실제 병렬 실행을 달성하는 방법은 무엇입니까? 최근에 나는 파이썬을 사용하고 있습니다 ...

Chatgpt 시대에는 기술 Q & A 커뮤니티가 어떻게 도전에 대응할 수 있습니까?

Apr 01, 2025 pm 11:51 PM

Chatgpt 시대에는 기술 Q & A 커뮤니티가 어떻게 도전에 대응할 수 있습니까?

Apr 01, 2025 pm 11:51 PM

Chatgpt 시대의 기술 Q & A 커뮤니티 : Segmentfault의 응답 전략 stackoverflow ...

Python Multi-Process Pipe 통신에서 '파이프 폐쇄'오류를 우아하게 처리하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:12 PM

Python Multi-Process Pipe 통신에서 '파이프 폐쇄'오류를 우아하게 처리하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:12 PM

파이썬 다중 프로세스 파이프 오류 "파이프가 닫혔습니다"? 부모-자식 프로세스 커뮤니케이션을 위해 Python의 멀티 프로세싱 모듈에서 파이프 메소드를 사용하는 경우 발생할 수 있습니다.

웹 페이지 데이터를 얻을 때 동적로드 컨텐츠 누락 문제를 해결하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:24 PM

웹 페이지 데이터를 얻을 때 동적로드 컨텐츠 누락 문제를 해결하는 방법은 무엇입니까?

Apr 01, 2025 pm 11:24 PM

요청 라이브러리를 사용하여 웹 페이지 데이터를 크롤링 할 때 문제 및 솔루션이 발생합니다. 요청 라이브러리를 사용하여 웹 페이지 데이터를 얻을 때 때때로 ...

데비안 메일 서버를 복구하는 방법

Apr 02, 2025 am 07:33 AM

데비안 메일 서버를 복구하는 방법

Apr 02, 2025 am 07:33 AM

Debian Mail 서버 복원을위한 자세한 단계이 기사에서는 Debian Mail Server를 복원하는 방법을 안내합니다. 시작하기 전에 데이터 백업의 중요성을 기억하는 것이 중요합니다. 복구 단계 : 백업 데이터 : 복구 작업을 수행하기 전에 모든 중요한 이메일 데이터 및 구성 파일을 백업해야합니다. 이렇게하면 복구 프로세스 중에 문제가 발생할 때 폴백 버전이 발생할 수 있습니다. 로그 파일 확인 : 오류 또는 예외는 메일 서버 로그 파일 (예 : /var/log/mail.log)을 확인하십시오. 로그 파일은 종종 문제의 원인에 대한 귀중한 단서를 제공합니다. 서비스 중지 : 추가 데이터 손상을 방지하기 위해 메일 서비스를 중지하십시오. 다음 명령을 사용하십시오 : Su

데비안에서 Zookeeper Performance Tuning을 운영하는 방법

Apr 02, 2025 am 07:42 AM

데비안에서 Zookeeper Performance Tuning을 운영하는 방법

Apr 02, 2025 am 07:42 AM

이 기사에서는 데비안 시스템에서 Zookeeper 성능을 최적화하는 방법에 대해 설명합니다. 우리는 하드웨어, 운영 체제, Zookeeper 구성 및 모니터링에 대한 조언을 제공 할 것입니다. 1. 시스템 수준에서 스토리지 미디어 업그레이드 최적화 : 기존의 기계식 하드 드라이브를 SSD 솔리드 스테이트 드라이브로 교체하면 I/O 성능이 크게 향상되고 액세스 대기 시간이 줄어 듭니다. 스왑 파티셔닝 비활성화 : 커널 매개 변수를 조정하여 스왑 파티션에 대한 의존성을 줄이고 자주 메모리 및 디스크 스왑으로 인한 성능 손실을 피하십시오. 파일 디스크립터 상한도 : Zookeeper의 처리 효율에 영향을 미치는 리소스 한계를 피하기 위해 시스템별로 동시에 파일 설명 자의 수를 늘리십시오. 2. Zookeeper 구성 최적화 zoo.cfg 파일 구성