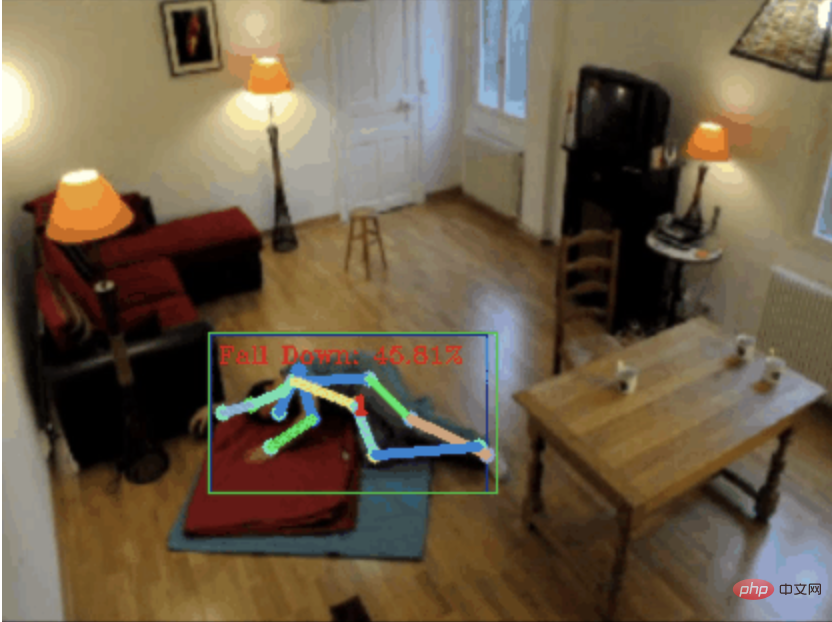

낙상 감지, 골격점 인간 행동 인식을 기반으로 코드의 일부가 Chatgpt로 완성됨

안녕하세요 여러분.

오늘 저는 넘어짐 감지 프로젝트를 여러분과 공유하고 싶습니다. 정확하게는 골격점을 기반으로 한 인간의 움직임 인식입니다.

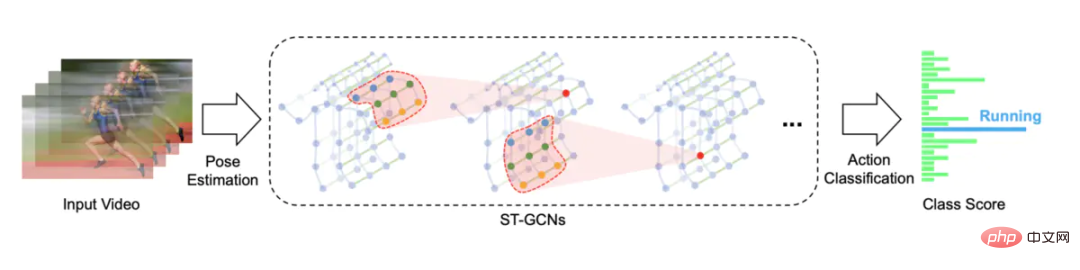

은 크게 3단계로 나누어집니다.

- 인체 인식

- 인체 골격 지점 인식

- 액션 분류

프로젝트 소스 코드가 패키지되어 있습니다. 방법은 기사 끝 부분을 참조하세요. 그것을 얻으십시오.

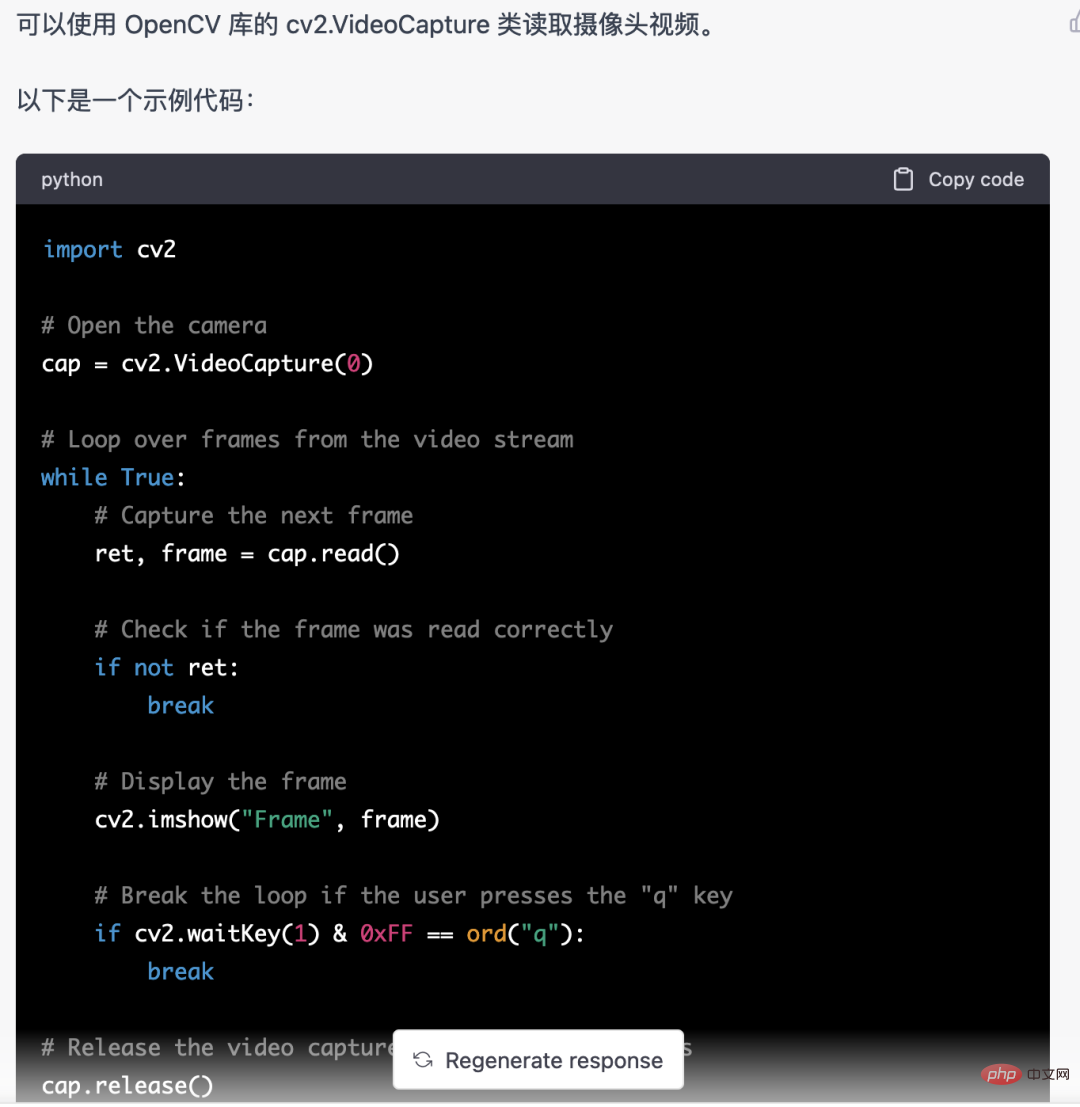

0.chatgpt

먼저 모니터링되는 비디오 스트림을 가져와야 합니다. 이 코드는 비교적 고정되어 있습니다. chatgpt가 직접 작성한 이 코드는 문제가 없으며 직접 사용할 수 있습니다.

그러나 미디어파이프를 사용하여 인체 골격 지점을 식별하는 등의 비즈니스 작업에서는 chatgpt에서 제공하는 코드가 올바르지 않습니다.

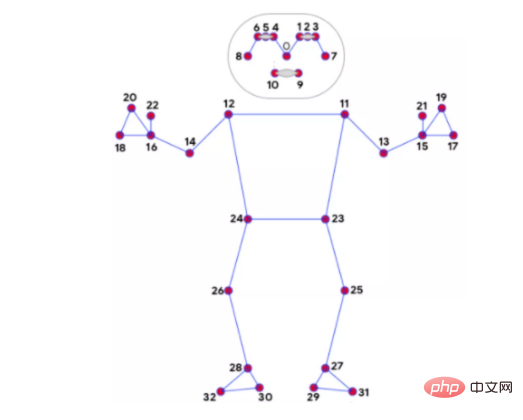

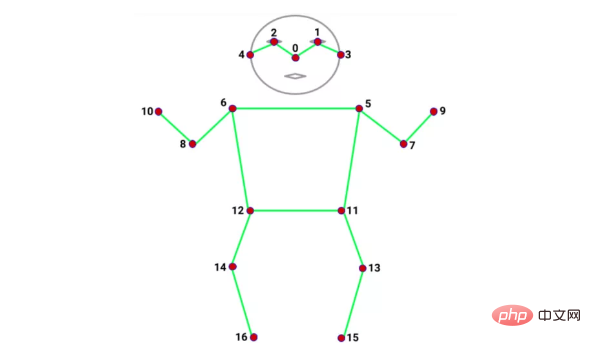

mediapipe 32 Bone Points

coco 17 Bone Points

저는 아직도 Bone Point 인식을 위해 Mediapipe를 사용하고 있습니다. 속도 외에도 또 다른 장점은 뼈를 인식한다는 것입니다. mediapipe에는 우리의 요구를 충족할 수 있는 32개의 지점이 있습니다. 아래에서 사용되는 인체 움직임의 분류는 골격점에 크게 의존하기 때문입니다.

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB) results = pose.process(image) if not results.pose_landmarks: continue # 识别人体骨骼点 image.flags.writeable = True image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR) mp_drawing.draw_landmarks( image, results.pose_landmarks, mp_pose.POSE_CONNECTIONS, landmark_drawing_spec=mp_drawing_styles.get_default_pose_landmarks_style() )

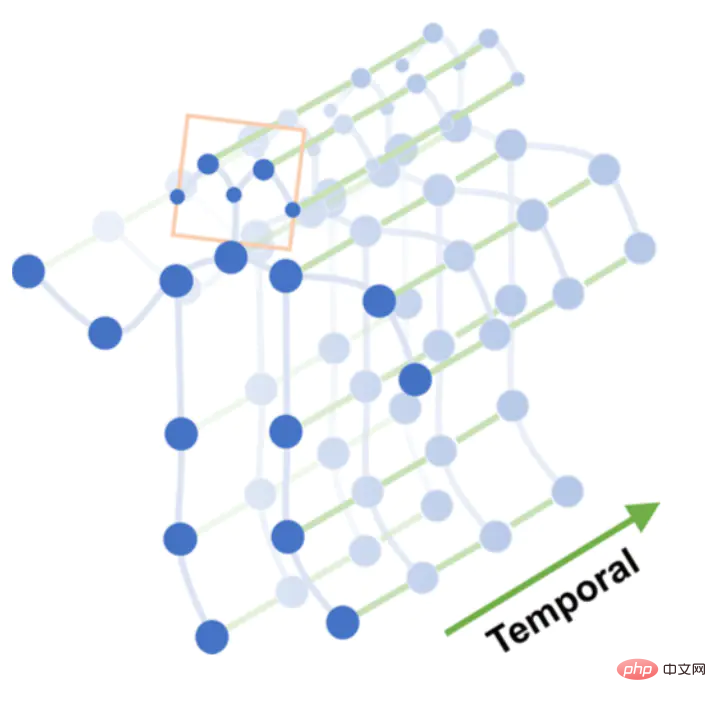

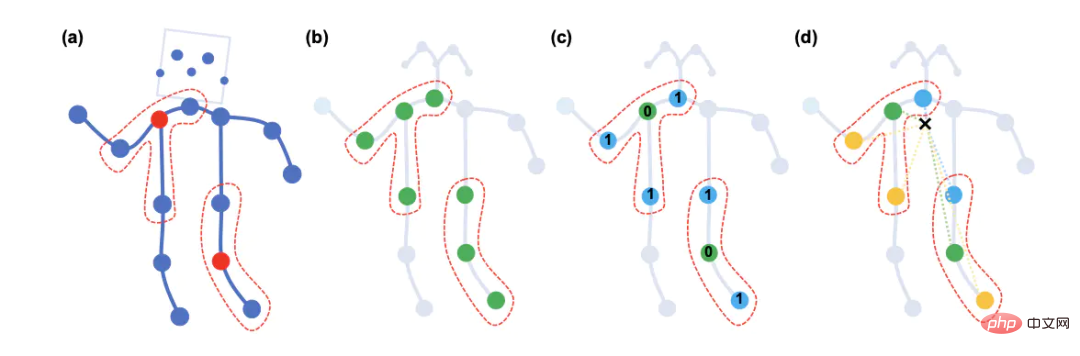

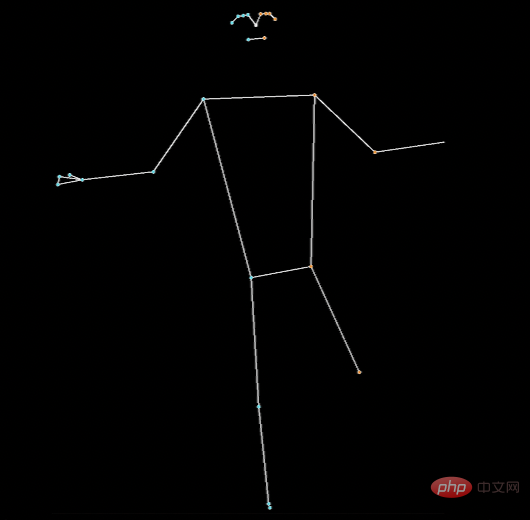

낙하 등의 일련의 동작은 N개의 프레임으로 구성됩니다. 각 프레임은 프레임 간 골격점을 연결하여 시간 그래프를 형성하는 공간 그래프를 구성할 수 있습니다. , 뼈점의 연결과 시간 프레임의 연결을 통해 시공간 그래프를 구성할 수 있습니다.

시공간 그래프

시공간 그래프에 대해 다층 그래프 컨볼루션 작업을 수행하여 더 높은 수준의 특징 맵을 생성합니다. 그런 다음 동작 분류(Action Classification)를 위해 SoftMax 분류기에 입력됩니다.

Graph convolution

원래는 STGCN 모델을 학습시키려고 했으나, 함정이 너무 많아 결국 남들이 학습시킨 모델을 직접 사용하게 되었습니다.

https://github.com/GajuuzZ/Human-Falling-Detect-Tracks

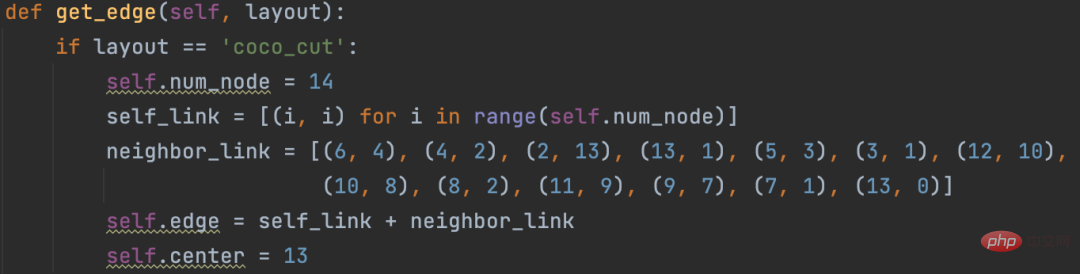

我看了下mediapipe包含了这 14 个骨骼点,所以可以用mediapipe识别的骨骼点输入他的模型,实现动作分类。

mediapipe 32个骨骼点

选出14个关键骨骼点

14个骨骼点提取代码:

KEY_JOINTS = [ mp_pose.PoseLandmark.NOSE, mp_pose.PoseLandmark.LEFT_SHOULDER, mp_pose.PoseLandmark.RIGHT_SHOULDER, mp_pose.PoseLandmark.LEFT_ELBOW, mp_pose.PoseLandmark.RIGHT_ELBOW, mp_pose.PoseLandmark.LEFT_WRIST, mp_pose.PoseLandmark.RIGHT_WRIST, mp_pose.PoseLandmark.LEFT_HIP, mp_pose.PoseLandmark.RIGHT_HIP, mp_pose.PoseLandmark.LEFT_KNEE, mp_pose.PoseLandmark.RIGHT_KNEE, mp_pose.PoseLandmark.LEFT_ANKLE, mp_pose.PoseLandmark.RIGHT_ANKLE ] landmarks = results.pose_landmarks.landmark joints = np.array([[landmarks[joint].x * image_w, landmarks[joint].y * image_h, landmarks[joint].visibility] for joint in KEY_JOINTS])

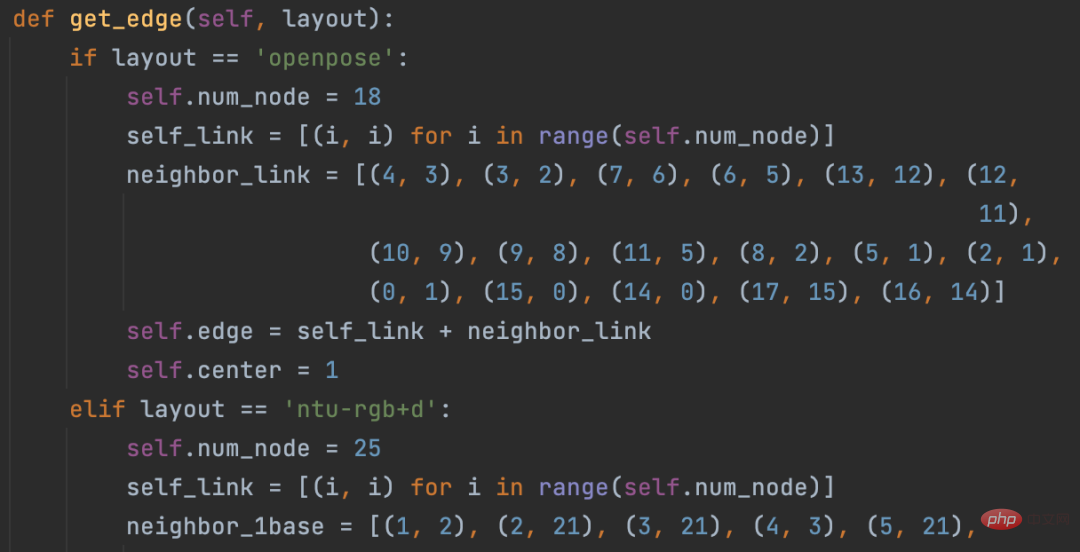

STGCN原始方案构造的空间图只支持openpose18个骨骼点和NTU RGB+D数据集25个骨骼点

修改这部分源码,以支持自定义的14个骨骼点

模型直接使用Human-Falling-Detect-Tracks项目已经训练好的,实际运行发现识别效果很差,因为没有看到模型训练过程,不确定问题出在哪。

有能力的朋友可以自己训练模型试试,另外,百度的Paddle也基于STGCN开发了一个跌倒检测模型,只支持摔倒这一种行为的识别。

当然大家也可以试试Transformer的方式,不需要提取骨骼点特征,直接将 N 帧낙상 감지, 골격점 인간 행동 인식을 기반으로 코드의 일부가 Chatgpt로 완성됨送入模型分类。

关于STGCN的原理,大家可以参考文章:https://www.jianshu.com/p/be85114006e3 总结的非常好。

需要源码的朋友留言区回复即可。

如果大家觉得本文对你有用就点个 在看 鼓励一下吧,后续我会持续分享优秀的 Python+AI 项目。

위 내용은 낙상 감지, 골격점 인간 행동 인식을 기반으로 코드의 일부가 Chatgpt로 완성됨의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7695

7695

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

이제 ChatGPT를 사용하면 무료 사용자가 일일 한도가 있는 DALL-E 3를 사용하여 이미지를 생성할 수 있습니다.

Aug 09, 2024 pm 09:37 PM

이제 ChatGPT를 사용하면 무료 사용자가 일일 한도가 있는 DALL-E 3를 사용하여 이미지를 생성할 수 있습니다.

Aug 09, 2024 pm 09:37 PM

DALL-E 3는 이전 모델보다 대폭 개선된 모델로 2023년 9월 공식 출시되었습니다. 복잡한 디테일의 이미지를 생성할 수 있는 현재까지 최고의 AI 이미지 생성기 중 하나로 간주됩니다. 그러나 출시 당시에는 제외되었습니다.

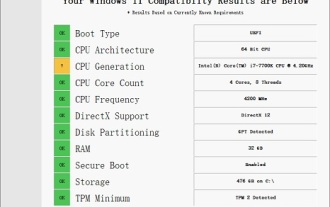

Windows 11로 업그레이드할 수 없는 i7-7700에 대한 솔루션

Dec 26, 2023 pm 06:52 PM

Windows 11로 업그레이드할 수 없는 i7-7700에 대한 솔루션

Dec 26, 2023 pm 06:52 PM

i77700의 성능은 win11을 실행하기에 충분하지만 사용자는 i77700을 win11로 업그레이드할 수 없다는 것을 알게 됩니다. 이는 주로 Microsoft에서 부과한 제한 사항 때문이므로 이 제한 사항을 건너뛰는 한 설치할 수 있습니다. i77700은 win11로 업그레이드할 수 없습니다. 1. Microsoft에서는 CPU 버전을 제한하기 때문입니다. 2. Intel의 8세대 이상 버전만 win11로 직접 업그레이드할 수 있습니다. 3. 7세대인 i77700은 win11의 업그레이드 요구 사항을 충족할 수 없습니다. 4. 하지만 i77700은 성능면에서 win11을 완벽하게 원활하게 사용할 수 있습니다. 5. 따라서 이 사이트의 win11 직접 설치 시스템을 사용할 수 있습니다. 6. 다운로드가 완료되면 파일을 마우스 오른쪽 버튼으로 클릭하고 "로드"합니다. 7. 더블클릭하여 "원클릭"을 실행합니다.

ChatGPT와 Python의 완벽한 조합: 지능형 고객 서비스 챗봇 만들기

Oct 27, 2023 pm 06:00 PM

ChatGPT와 Python의 완벽한 조합: 지능형 고객 서비스 챗봇 만들기

Oct 27, 2023 pm 06:00 PM

ChatGPT와 Python의 완벽한 조합: 지능형 고객 서비스 챗봇 만들기 소개: 오늘날의 정보화 시대에 지능형 고객 서비스 시스템은 기업과 고객 간의 중요한 커뮤니케이션 도구가 되었습니다. 더 나은 고객 서비스 경험을 제공하기 위해 많은 기업이 고객 상담, 질문 답변 등의 업무를 완료하기 위해 챗봇을 활용하기 시작했습니다. 이 기사에서는 OpenAI의 강력한 모델인 ChatGPT와 Python 언어를 사용하여 지능형 고객 서비스 챗봇을 만드는 방법을 소개합니다.

휴대폰에 chatgpt를 설치하는 방법

Mar 05, 2024 pm 02:31 PM

휴대폰에 chatgpt를 설치하는 방법

Mar 05, 2024 pm 02:31 PM

설치 단계: 1. ChatGTP 공식 웹사이트 또는 모바일 스토어에서 ChatGTP 소프트웨어를 다운로드합니다. 2. 이를 연 후 설정 인터페이스에서 언어를 중국어로 선택합니다. 3. 게임 인터페이스에서 인간-기계 게임을 선택하고 설정합니다. 4. 시작한 후 채팅 창에 명령을 입력하여 소프트웨어와 상호 작용합니다.

MIT의 최신 걸작: GPT-3.5를 사용하여 시계열 이상 탐지 문제 해결

Jun 08, 2024 pm 06:09 PM

MIT의 최신 걸작: GPT-3.5를 사용하여 시계열 이상 탐지 문제 해결

Jun 08, 2024 pm 06:09 PM

오늘은 지난 주 MIT에서 발표한 기사를 소개하고자 합니다. GPT-3.5-turbo를 사용하여 시계열 이상 탐지 문제를 해결하고, 시계열 이상 탐지에서 LLM의 효율성을 초기에 검증한 내용입니다. 전체 과정에 미세한 조정은 없으며, 이상 탐지를 위해 GPT-3.5-turbo를 직접 사용하는 것이 이 글의 핵심이다. LLM이 이상 탐지 작업을 해결하도록 하는 프롬프트 또는 파이프라인입니다. 이 작품을 자세히 소개하겠습니다. 이미지 논문 제목: Large Languagemodelscanbezero-shotanomalydete

ChatGPT와 Java를 사용하여 지능형 챗봇을 개발하는 방법

Oct 28, 2023 am 08:54 AM

ChatGPT와 Java를 사용하여 지능형 챗봇을 개발하는 방법

Oct 28, 2023 am 08:54 AM

이 기사에서는 ChatGPT와 Java를 사용하여 지능형 챗봇을 개발하는 방법을 소개하고 몇 가지 구체적인 코드 예제를 제공합니다. ChatGPT는 자연어를 이해하고 인간과 유사한 텍스트를 생성할 수 있는 신경망 기반 인공지능 기술인 OpenAI가 개발한 Generative Pre-training Transformer의 최신 버전입니다. ChatGPT를 사용하면 적응형 채팅을 쉽게 만들 수 있습니다.

탐지 알고리즘 개선: 고해상도 광학 원격탐사 이미지에서 표적 탐지용

Jun 06, 2024 pm 12:33 PM

탐지 알고리즘 개선: 고해상도 광학 원격탐사 이미지에서 표적 탐지용

Jun 06, 2024 pm 12:33 PM

01 전망 요약 현재로서는 탐지 효율성과 탐지 결과 간의 적절한 균형을 이루기가 어렵습니다. 우리는 광학 원격 탐사 이미지에서 표적 감지 네트워크의 효과를 향상시키기 위해 다층 특징 피라미드, 다중 감지 헤드 전략 및 하이브리드 주의 모듈을 사용하여 고해상도 광학 원격 감지 이미지에서 표적 감지를 위한 향상된 YOLOv5 알고리즘을 개발했습니다. SIMD 데이터 세트에 따르면 새로운 알고리즘의 mAP는 YOLOv5보다 2.2%, YOLOX보다 8.48% 우수하여 탐지 결과와 속도 간의 균형이 더 잘 이루어졌습니다. 02 배경 및 동기 원격탐사 기술의 급속한 발전으로 항공기, 자동차, 건물 등 지구 표면의 많은 물체를 묘사하기 위해 고해상도 광학 원격탐사 영상이 활용되고 있다. 원격탐사 이미지 해석에서 물체 감지

ChatGPT PHP를 사용하여 지능형 고객 서비스 로봇을 구축하는 방법

Oct 28, 2023 am 09:34 AM

ChatGPT PHP를 사용하여 지능형 고객 서비스 로봇을 구축하는 방법

Oct 28, 2023 am 09:34 AM

ChatGPTPHP를 사용하여 지능형 고객 서비스 로봇을 구축하는 방법 소개: 인공 지능 기술의 발전으로 로봇이 고객 서비스 분야에서 점점 더 많이 사용되고 있습니다. ChatGPTPHP를 사용하여 지능형 고객 서비스 로봇을 구축하면 기업이 보다 효율적이고 개인화된 고객 서비스를 제공하는 데 도움이 될 수 있습니다. 이 기사에서는 ChatGPTPHP를 사용하여 지능형 고객 서비스 로봇을 구축하는 방법을 소개하고 특정 코드 예제를 제공합니다. 1. ChatGPTPHP를 설치하고 ChatGPTPHP를 사용하여 지능형 고객 서비스 로봇을 구축합니다.