역사상 가장 큰 ViT를 편리하게 훈련하셨나요? Google, 시각적 언어 모델 PaLI 업그레이드: 100개 이상의 언어 지원

최근 몇 년간 자연어 처리의 발전은 주로 대규모 언어 모델에서 비롯되었습니다. 출시되는 각각의 새로운 모델은 매개변수와 훈련 데이터의 양을 새로운 최고 수준으로 끌어올리고 기존 벤치마크 순위도 업데이트합니다.

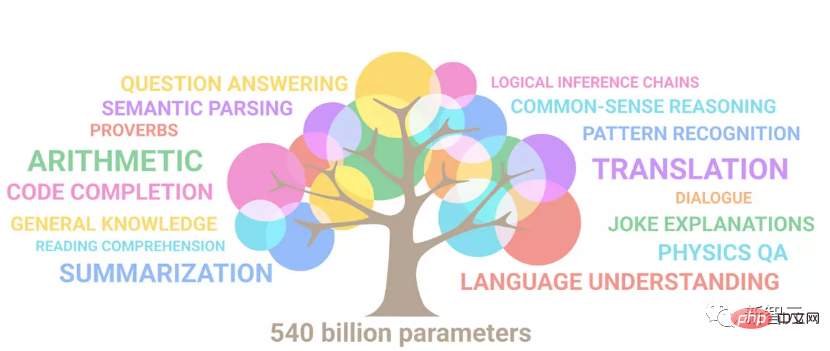

예를 들어올해 4월 Google은 5,400억 매개변수 언어 모델 PaLM(Pathways Language Model)을 출시했습니다. 이는 일련의 언어 및 추론 테스트, 특히 몇 가지- Shot 샘플 학습 시나리오의 뛰어난 성능 덕분에 PaLM은 차세대 언어 모델의 개발 방향도 고려하게 되었습니다. ㅋㅋㅋ

물론

물론

이라면 분명히 보편적이지 않으며 다양한 언어의 입력 및 출력을 지원해야 합니다 . 최근 Google은 PaLM 확장을 PALI(Pathways Language and Image model)로 업그레이드했습니다. PALI는 다국어 및 이미지 이해 기능을 모두 갖추고

100개 이상의 언어를 지원하여 다양한 교차 시각적 작업을 수행합니다. , 시각적 질문 답변, 이미지 캡션, 개체 감지, 이미지 분류, OCR, 텍스트 추론 등과 같은 언어 및 다중 모드 이미지 및 언어 응용 프로그램입니다.

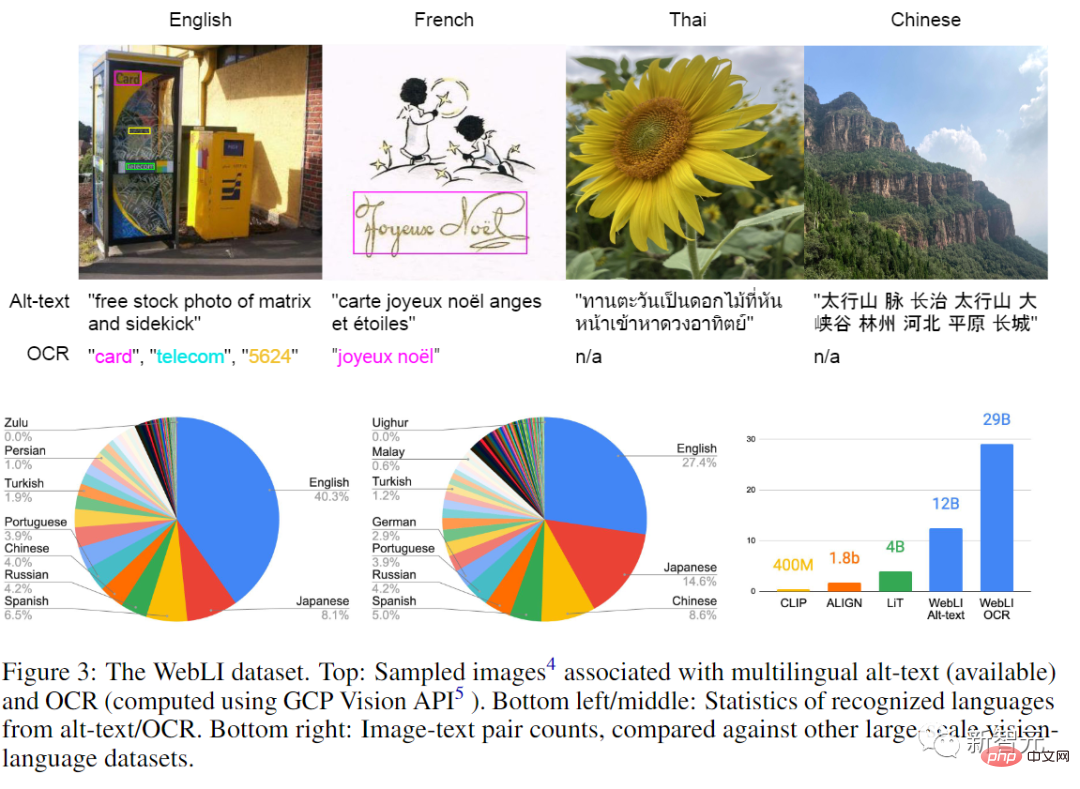

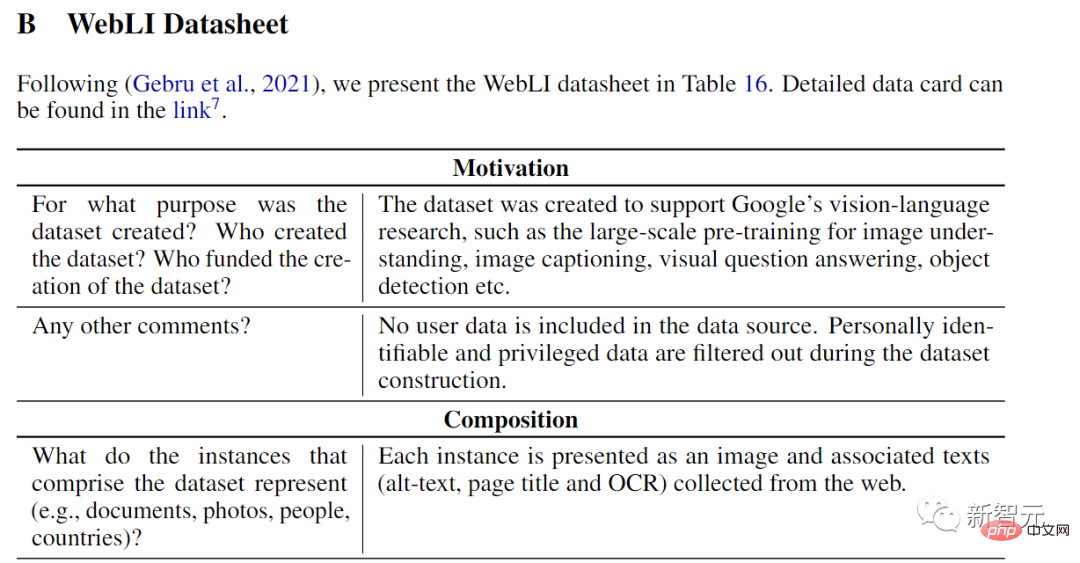

문서 링크: https://arxiv.org/abs/2209.06794모델은 자동으로 크롤링된 109개의 이미지가 포함된 공개 이미지 컬렉션을 사용하여 훈련되었습니다. 언어 주석 은 다음과 같습니다. 이 문서에서는 WebLIdataset라고도 합니다.

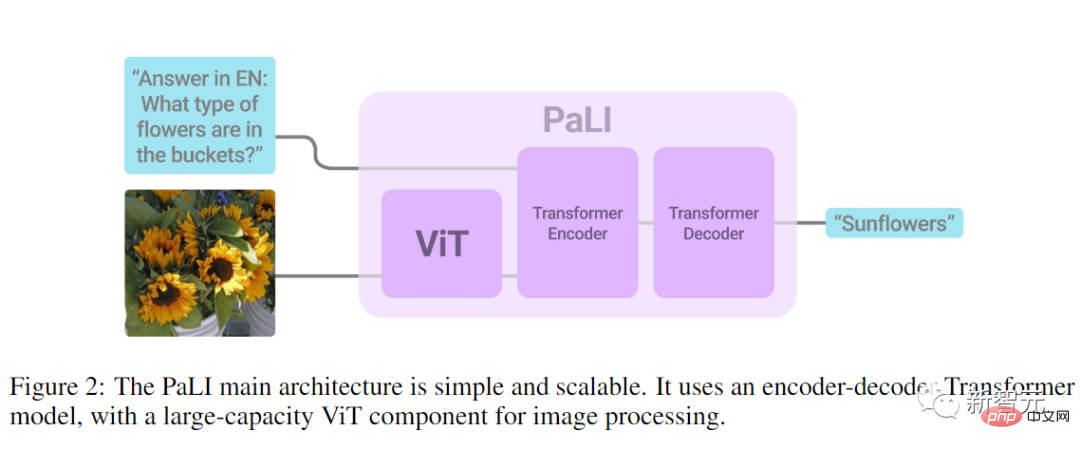

모델 아키텍처

PALI의 목표 중 하나는언어와 비주얼모델 간의 관계가 성능 및 규모, 특히 언어-이미지 모델의 확장성 측면에서 동일한지 연구하는 것입니다.

그래서 모델의 아키텍처 디자인은 주로 실험의 편의, 특히 재사용성과 확장성을 위해 매우 간단합니다.

모델은 입력 텍스트를 처리하는 Transformer 인코더와 출력 텍스트를 생성하는 자동 회귀 Transformer 디코더로 구성됩니다. 이미지를 처리할 때 Transformer 인코더에 대한 입력에는 ViT에서 처리된 이미지를 나타내는 시각적 단어도 포함됩니다.

PaLI 모델의 핵심 설계는 재사용입니다. 연구원들은 이전에 훈련된 단일 모달 비전 및 언어 모델(예: mT5-XXL 및 대형 ViT)의 가중치를 모델의 씨앗으로 사용했습니다. 단일 모달을 만듭니다. 동적 훈련 기능을 마이그레이션하고 컴퓨팅 비용도 절약할 수 있습니다.

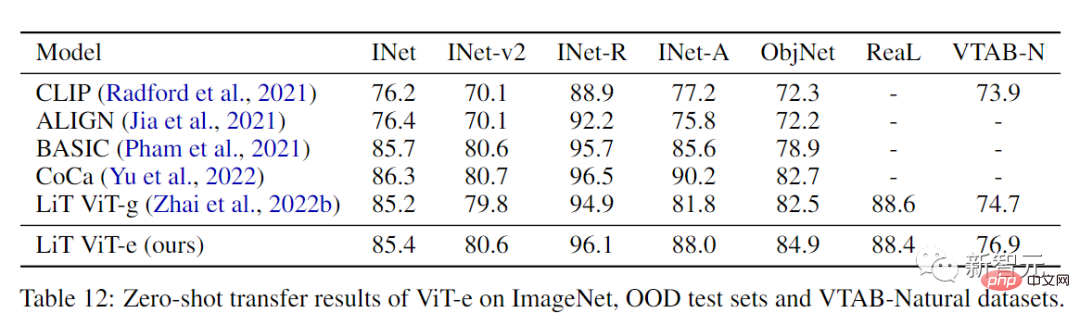

모델의 시각적 구성 요소는 현재까지 가장 큰 ViT 아키텍처인  ViT-e

ViT-e

40억 개의 매개변수 로 확장되었습니다.

비주얼 및 언어 분야 모두에서 스케일링 법칙이 연구되었지만 시각 백본 모델의 스케일을 확장하면 분류 작업에 문제가 발생할 수 있습니다. .

연구원들은 이를 추가로 확인했으며 ViT-e가 ImageNet의 ViT-G보다 약간 더 나은 것을 관찰할 수 있지만 ViT-e는 PaLI의 시각적 언어 작업에서 크게 향상되었습니다. 예를 들어, ViT-e는 COCO 자막 작업에서 거의 3 CIDEr 포인트만큼 ViT-G를 능가합니다. 작업에서 ViT-G보다 3포인트 더 높습니다. 이는 또한 향후 시각적 언어 작업에 더 큰 ViT 뼈대 모델을 사용할 여지가 있음을 암시합니다.

연구원들은 사전 훈련된 mT5-Large(10억 매개변수) 및 mT5-XXL(130억 매개변수)을 사용하여 PaLI의 언어 인코더-디코더를 초기화하는 언어 모델링 구성 요소로 mT5 백본을 채택했습니다. 그런 다음 순수한 언어 이해 작업을 포함하여 다양한 언어 작업에 대한 혼합 훈련을 계속하며 이는 mT5의 언어 이해 및 생산 능력을 망각하는 것을 방지하는 데도 도움이 됩니다.

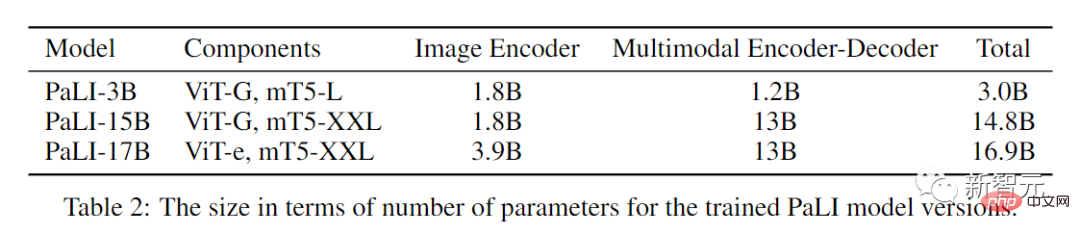

드디어 크기가 다른 세 가지 PALI 모델이 생겼습니다.

109개 언어로 제공되는 데이터 세트

딥 러닝과 관련된 확장된 연구에 따르면 모델이 클수록 필요한 학습 데이터 세트도 더 커집니다.

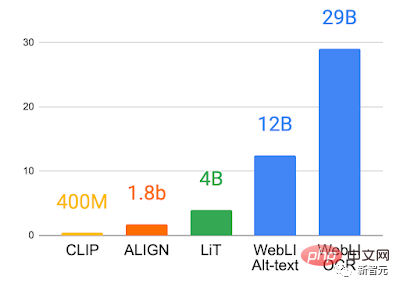

그래서 언어-이미지 사전 학습 모델의 잠재력을 종합적으로 연구하고 활용하기 위해 연구자들은 인터넷에서 대량의 이미지 및 텍스트 데이터를 크롤링하여 109개 언어로 된 120개의 이미지가 포함된 새로운 데이터 세트 WebLI를 구축했습니다. 수십억 개의 대체 텍스트와 100억 개의 이미지.

연구원들은 주석을 위해 웹 텍스트를 사용하는 것 외에도 Cloud Vision API를 적용하여 이미지에 대한 OCR 인식을 수행하여 290억 개의 이미지-OCR 데이터 쌍을 얻었습니다.

다운스트림 평가 작업에서 데이터 유출을 방지하기 위해 거의 중복을 사용하여 68개의 일반적인 시각적 및 시각적 언어 데이터 세트의 훈련, 검증 및 테스트 부분의 이미지가 중복 제거되었습니다.

데이터 품질을 더욱 향상시키기 위해 연구원들은 "이미지 및 대체 텍스트"의 모달간 유사성을 기반으로 점수를 매기고 임계값을 조정하여 최종적으로 10%만 유지합니다. 이미지, 총 10억 개의 이미지가 PaLI를 훈련하는 데 사용됩니다

대형 모델 훈련

시각 언어 작업은 다중 모드이므로 모델은 여러 의미 처리 기능을 가져야 하며 서로 다른 목표를 갖게 됩니다. 예를 들어, 일부 작업에는 작업을 정확하게 해결하기 위해 객체의 로컬 위치화가 필요한 반면, 다른 작업에는 더 많은 전역 의미 정보가 필요할 수 있습니다.

마찬가지로 일부 언어 작업에는 긴 답변이 필요한 반면, 다른 언어 작업에는 간결한 답변이 필요할 수 있습니다.

이러한 일관되지 않은 모든 목표를 해결하기 위해 연구원들은 풍부한 WebLI 사전 훈련 데이터를 활용하고 사전 훈련 작업 혼합을 도입하여 다양한 다운스트림 애플리케이션을 위한 모델을 준비합니다.

다양한 작업을 해결할 수 있는 모델의 활용도를 높이기 위해 저자는 모든 작업을 하나의 공통 API(입력: 이미지 + 텍스트, 출력: 텍스트)로 분류하여 여러 이미지 및 언어 작업을 수행할 수 있도록 했습니다. 사전 훈련된 설정과도 공유되는 지식 공유입니다.

사전 훈련에 사용되는 대상은 모델 구성 요소 재사용 기능을 유지하는 동시에 새로운 작업을 수행하도록 모델을 훈련시키는 것을 목표로 가중치 혼합과 동일한 API에 투영됩니다.

모델은 오픈 소스 T5X 및 Flaxformer 프레임워크를 사용하고 JAX에서 Flax로 교육됩니다. ViT-e의 시각적 부분은 오픈 소스 BigVision 프레임워크를 사용하여 언어 부분의 단어 벡터와 생성된 패치 벡터를 계단식으로 배열합니다. 시각적 부분은 멀티모달 인코더-디코더에 대한 입력으로 mT5-XXL 사전 훈련을 사용하여 인코더가 초기화됩니다. PaLI의 훈련 과정에서 시각적 구성 요소의 가중치는 고정되고 다중 모드 인코더-디코더의 가중치만 업데이트됩니다.

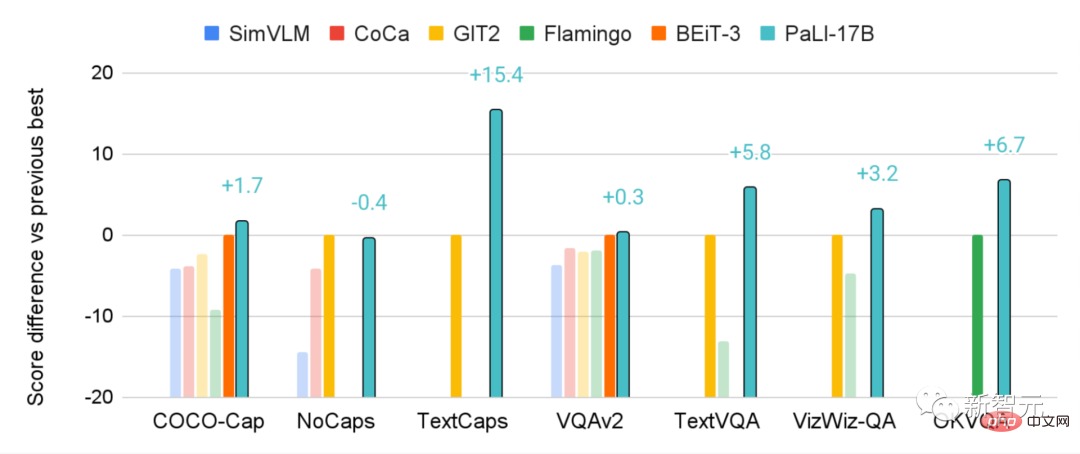

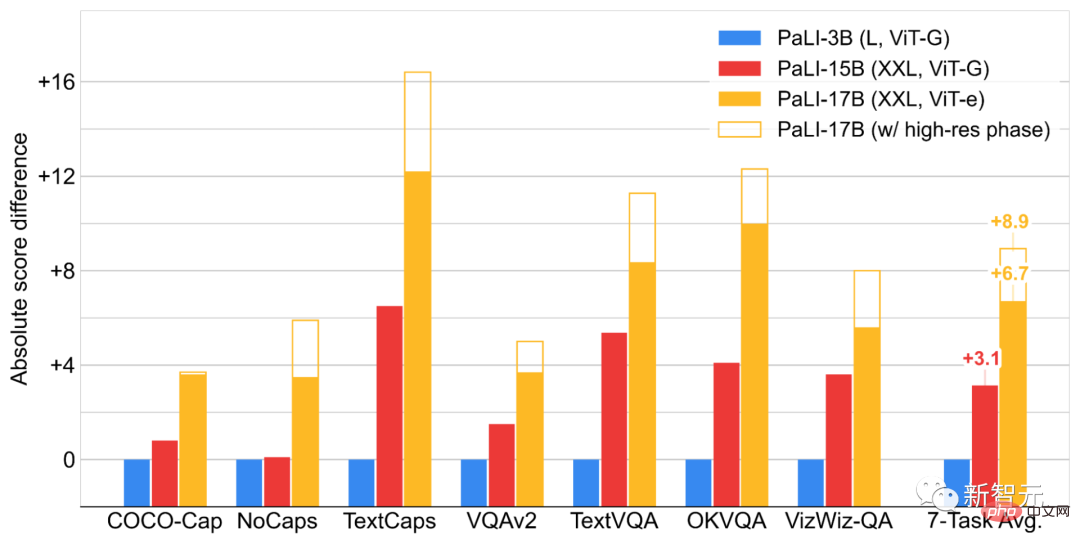

실험 부분에서 연구자들은 일반적인 시각적 언어 벤치마크에서 PaLI를 비교했으며 PaLI 모델은 이러한 작업에 대해 이전 문헌에서 제안된 매우 큰 모델을 능가하는 최첨단 결과를 달성했습니다.

예를 들어, 170억 매개변수 PALI는 일부 VQA 및 이미지 캡션 작업에서 800억 매개변수 Flamingo 모델보다 더 나은 성능을 발휘합니다.

PALI는 단일 언어 또는 단일 시각적 작업에서도 좋은 성능을 유지하지만 이것이 PALI의 주요 교육 목표는 아닙니다.

또한 모델 확장 측면에서 이미지와 언어 모델 구성 요소가 어떻게 상호 작용하는지, 그리고 모델이 가장 큰 이점을 제공하는 부분도 조사합니다.

최종 결론은 이 두 구성 요소의 공동 스케일링(스케일링)이 최고의 성능을 발휘한다는 것입니다. 특히 상대적으로 적은 매개 변수를 필요로 하는 시각적 구성 요소의 스케일링이 가장 중요하며, 다국어 작업의 성능 향상에도 스케일링이 중요합니다. .

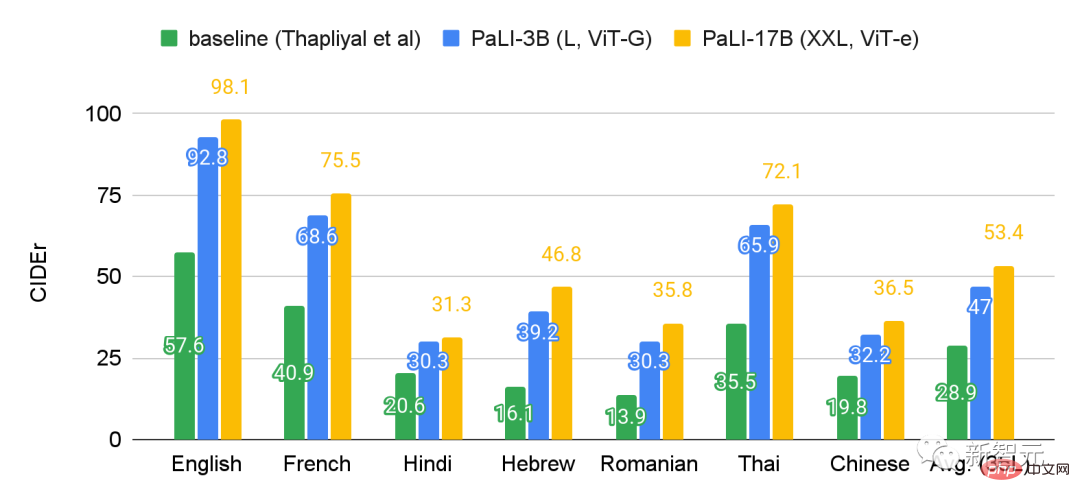

벤치마크 Crossmodal-3600에서 35개 언어로 PaLI를 평가한 후 PaLI 모델 확장을 통해 다국어 타이틀 작업에 더 많은 이점이 있다는 것을 알 수 있습니다.

대규모 언어 및 이미지 모델에서 불공정한 편견이 생성되거나 강화되는 것을 방지하려면 사용된 데이터와 모델이 해당 데이터를 사용하는 방식을 투명하게 공개하고 모델의 공정성을 테스트해야 합니다. 책임감 있는 데이터 분석을 수행하므로 기사에서는 데이터 카드와 모델 카드를 모두 제공합니다

위 내용은 역사상 가장 큰 ViT를 편리하게 훈련하셨나요? Google, 시각적 언어 모델 PaLI 업그레이드: 100개 이상의 언어 지원의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7491

7491

15

15

1377

1377

52

52

77

77

11

11

52

52

19

19

19

19

41

41

Google Pixel 9 및 Pixel 9 Pro는 출시 시 Creative Assistant AI를 얻을 것이라는 소문이 있습니다.

Jun 22, 2024 am 10:50 AM

Google Pixel 9 및 Pixel 9 Pro는 출시 시 Creative Assistant AI를 얻을 것이라는 소문이 있습니다.

Jun 22, 2024 am 10:50 AM

현재 올 가을에는 4개의 새로운 Pixel 스마트폰이 출시될 것으로 예상됩니다. 요약하자면, 이 시리즈에는 출시 시 Pixel 9와 Pixel 9 Pro가 탑재될 것이라는 소문이 있습니다. 그러나 Pixel 9 Pro는 Pixel 8 Pro가 아닌 iPhone 16 Pro의 경쟁자가 될 것입니다.

Google Pixel 9 Pro XL은 데스크톱 모드로 테스트되었습니다.

Aug 29, 2024 pm 01:09 PM

Google Pixel 9 Pro XL은 데스크톱 모드로 테스트되었습니다.

Aug 29, 2024 pm 01:09 PM

Google은 Pixel 8 시리즈에 DisplayPort 대체 모드를 도입했으며 새로 출시된 Pixel 9 라인업에 포함되어 있습니다. 주로 연결된 화면으로 스마트폰 디스플레이를 미러링할 수 있도록 하기 위해 존재하지만 데스크탑에서도 사용할 수 있습니다.

Pixel 9 Pro XL의 Google Tensor G4는 원신에서 Tensor G2보다 뒤떨어집니다.

Aug 24, 2024 am 06:43 AM

Pixel 9 Pro XL의 Google Tensor G4는 원신에서 Tensor G2보다 뒤떨어집니다.

Aug 24, 2024 am 06:43 AM

Google은 최근 Pixel 9 라인의 Tensor G4에 대한 성능 문제에 대응했습니다. 회사는 SoC가 벤치마크를 이길 수 있도록 설계되지 않았다고 말했습니다. 대신 팀은 Google이 C를 원하는 영역에서 좋은 성능을 발휘하도록 집중했습니다.

Google AI, 개발자를 위한 Gemini 1.5 Pro 및 Gemma 2 발표

Jul 01, 2024 am 07:22 AM

Google AI, 개발자를 위한 Gemini 1.5 Pro 및 Gemma 2 발표

Jul 01, 2024 am 07:22 AM

Google AI는 Gemini 1.5 Pro LLM(대형 언어 모델)부터 개발자에게 확장된 컨텍스트 창과 비용 절감 기능에 대한 액세스를 제공하기 시작했습니다. 이전에는 대기자 명단을 통해 제공되었으며 전체 200만 개의 토큰 컨텍스트 창

Google 앱 베타 APK 분해로 Gemini AI 비서에 추가되는 새로운 확장 기능 공개

Jul 30, 2024 pm 01:06 PM

Google 앱 베타 APK 분해로 Gemini AI 비서에 추가되는 새로운 확장 기능 공개

Jul 30, 2024 pm 01:06 PM

최신 업데이트(v15.29.34.29 베타)의 APK 분해를 고려하면 Google의 AI 비서인 Gemini가 더욱 강력해질 예정입니다. 거대 기술 기업의 새로운 AI 비서는 몇 가지 새로운 확장 기능을 얻을 수 있는 것으로 알려졌습니다. 이러한 확장 기능은

Google Pixel 9 스마트폰은 7년 업데이트 약속에도 불구하고 Android 15와 함께 출시되지 않습니다.

Aug 01, 2024 pm 02:56 PM

Google Pixel 9 스마트폰은 7년 업데이트 약속에도 불구하고 Android 15와 함께 출시되지 않습니다.

Aug 01, 2024 pm 02:56 PM

Pixel 9 시리즈는 8월 13일 출시로 예정되어 거의 다가왔습니다. 최근 소문에 따르면 Pixel 9, Pixel 9 Pro 및 Pixel 9 Pro XL은 128GB의 스토리지부터 시작하여 Pixel 8 및 Pixel 8 Pro(Amazon에서 현재 $749)를 미러링할 예정입니다.

새로운 Google Pixel 데스크탑 모드는 Motorola Ready For 및 Samsung DeX 대안으로 신선한 비디오로 선보였습니다.

Aug 08, 2024 pm 03:05 PM

새로운 Google Pixel 데스크탑 모드는 Motorola Ready For 및 Samsung DeX 대안으로 신선한 비디오로 선보였습니다.

Aug 08, 2024 pm 03:05 PM

Android Authority가 Google이 Android 14 QPR3 베타 2.1에 숨겨둔 새로운 Android 데스크톱 모드를 시연한 지 몇 달이 지났습니다. Pixel 8 및 Pixel 8에 대한 DisplayPort Alt 모드 지원을 추가하는 Google의 뒤를 이어 뜨거워졌습니다.

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

편집자 |ScienceAI 질문 응답(QA) 데이터 세트는 자연어 처리(NLP) 연구를 촉진하는 데 중요한 역할을 합니다. 고품질 QA 데이터 세트는 모델을 미세 조정하는 데 사용될 수 있을 뿐만 아니라 LLM(대형 언어 모델)의 기능, 특히 과학적 지식을 이해하고 추론하는 능력을 효과적으로 평가하는 데에도 사용할 수 있습니다. 현재 의학, 화학, 생물학 및 기타 분야를 포괄하는 과학적인 QA 데이터 세트가 많이 있지만 이러한 데이터 세트에는 여전히 몇 가지 단점이 있습니다. 첫째, 데이터 형식이 비교적 단순하고 대부분이 객관식 질문이므로 평가하기 쉽지만 모델의 답변 선택 범위가 제한되고 모델의 과학적 질문 답변 능력을 완전히 테스트할 수 없습니다. 이에 비해 개방형 Q&A는