모든 성공에는 흔적이 있으며 ChatGPT도 예외는 아닙니다.

얼마 전 Turing Award 수상자 Yann LeCun이 ChatGPT에 대한 가혹한 평가로 인해 뜨거운 검색 목록에 올랐습니다.

그는 "기본 기술에 관한 한 ChatGPT에는 특별한 혁신이 없으며" "혁신적인 것"도 없다고 생각합니다. 많은 연구실에서 동일한 기술을 사용하고 동일한 작업을 수행하고 있습니다. 게다가 ChatGPT와 그 뒤에 있는 GPT-3는 여러 면에서 여러 당사자가 수년에 걸쳐 개발한 여러 기술로 구성되어 있으며 다양한 사람들이 수십 년 동안 기여한 결과입니다. 따라서 LeCun은 ChatGPT가 과학적 혁신이라기보다는 적절한 엔지니어링 사례라고 믿습니다.

"ChatGPT가 혁명적인가"는 논란의 여지가 있는 주제입니다. 하지만 이전에 축적된 많은 기술을 기반으로 구축되었다는 점에는 의심의 여지가 없습니다. 예를 들어 몇 년 전 Google이 핵심 Transformer를 제안했고 Transformer는 주의 개념에 대한 Bengio의 작업에서 영감을 받았습니다. 더 거슬러 올라가면 수십 년 전의 연구와도 연결할 수 있습니다.

물론 대중은 이러한 단계별 감각을 높이 평가하지 못할 수도 있습니다. 결국 모든 사람이 논문을 하나씩 읽지는 않을 것입니다. 그러나 기술자에게는 이러한 기술의 발전을 이해하는 것이 여전히 매우 도움이 됩니다.

최근 리뷰 기사에서 Michigan State University, Beijing Aeronautical University, Lehigh University 및 기타 기관의 연구원들은 주로 텍스트, 이미지 및 사전 훈련된 기본 모델에 중점을 두고 이 분야의 수백 편의 논문을 주의 깊게 샅샅이 조사했습니다. 그래프 학습 분야에서는 읽어볼 가치가 충분히 있습니다. Philip S. ) Salesforce AI Research 부사장Xiong Caimingdu은 논문의 저자 중 한 명입니다. 논문 링크: https://arxiv.org/pdf/2302.09419.pdf논문 목차는 다음과 같습니다.

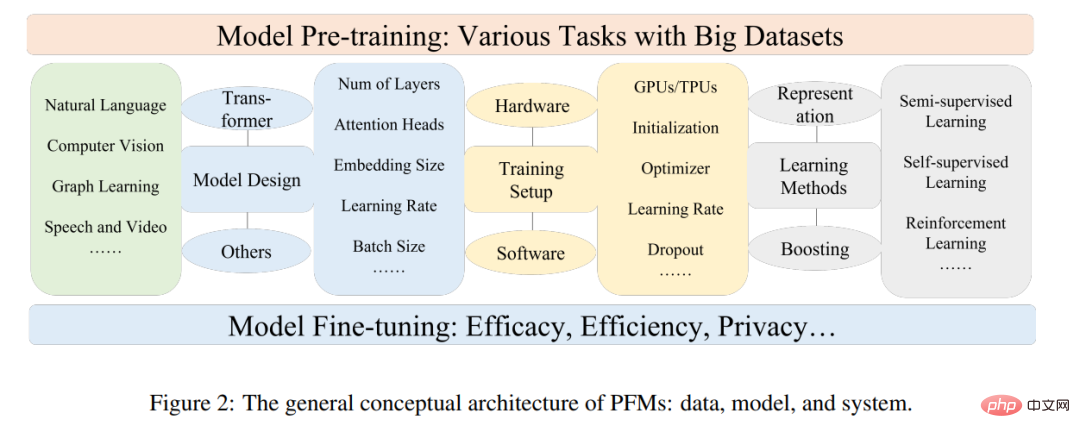

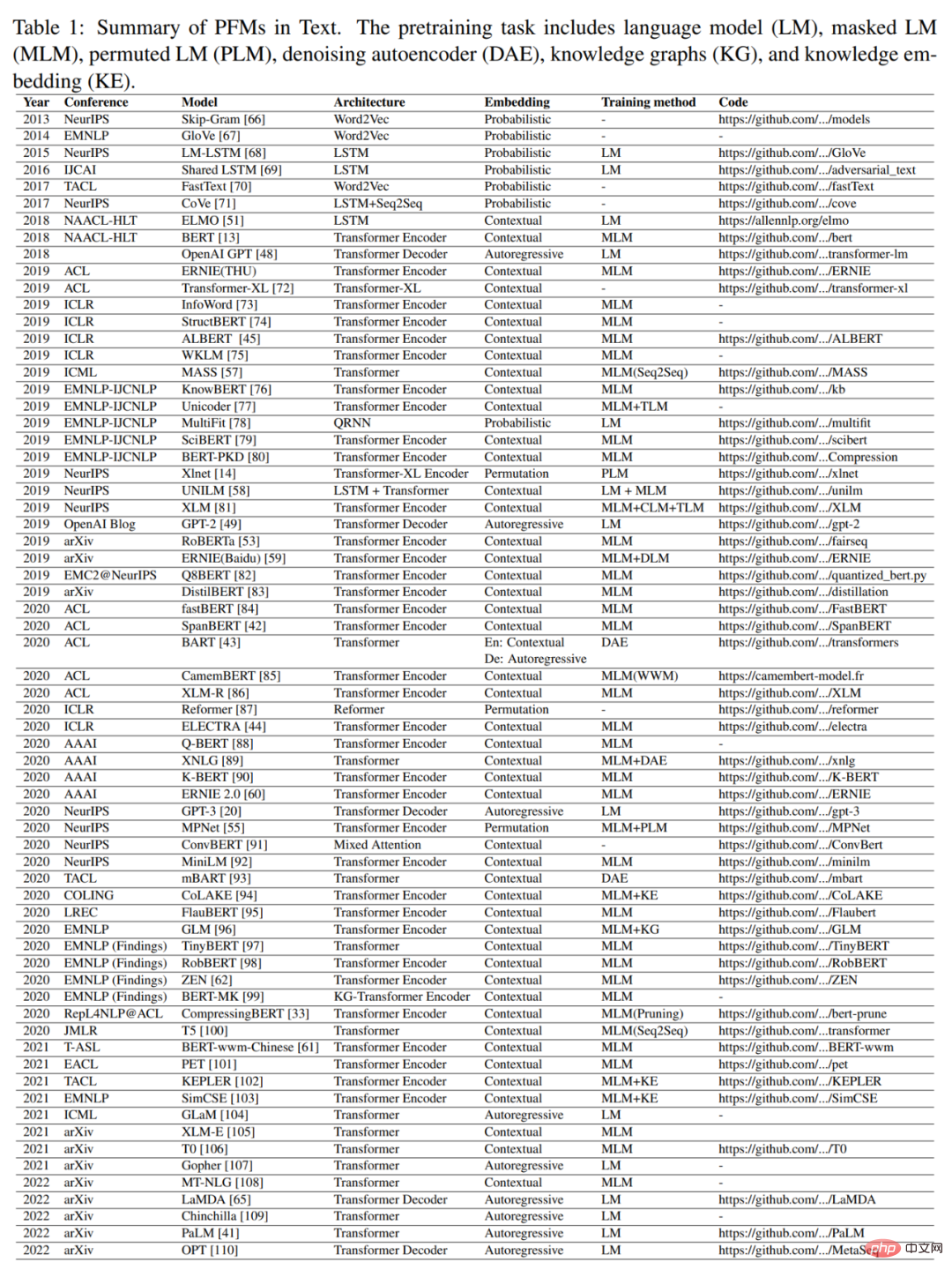

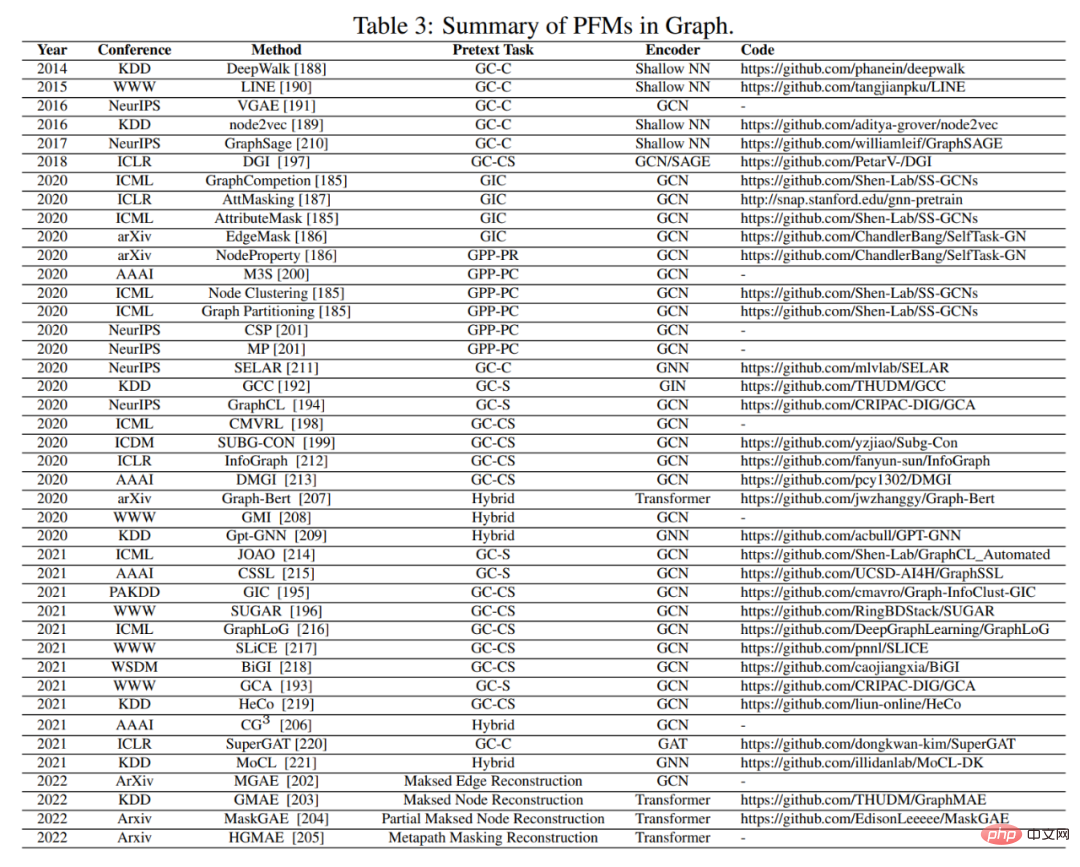

해외 소셜 플랫폼에서 DAIR.AI 공동 창립자 Elvis S.가 이 리뷰를 추천했고 천 개가 넘는 좋아요를 받았습니다. 사전 학습된 기본 모델(PFM)은 빅데이터 시대 인공지능의 중요한 부분입니다. "기본 모델"이라는 이름은 Percy Liang, Li Feifei 등이 출판한 리뷰인 "기초 모델의 기회 및 위험에 관하여"에서 따온 것입니다. 이는 모델 유형과 해당 기능에 대한 일반적인 용어입니다. PFM은 NLP, CV, 그래프 학습 분야에서 광범위하게 연구되어 왔습니다. 이는 텍스트 분류, 텍스트 생성, 이미지 분류, 객체 감지 및 그래프 분류와 같은 다양한 학습 작업에서 특징 표현 학습에 대한 강력한 잠재력을 보여줍니다. 대규모 데이터 세트를 사용하는 여러 작업에 대한 교육이든 소규모 작업에 대한 미세 조정이든 PFM은 탁월한 성능을 발휘하므로 데이터 처리를 빠르게 시작할 수 있습니다. PFM 및 사전 훈련 PFM은 사전 훈련 기술을 기반으로 하며, 이는 다양한 다운스트림에서 쉽게 미세 조정할 수 있는 일반 모델을 훈련하기 위해 많은 양의 데이터와 작업을 활용하는 것을 목표로 합니다. 응용 프로그램. 사전 교육의 아이디어는 CV 과제의 전이 학습에서 비롯되었습니다. 하지만 CV 분야에서 이 기술의 효과를 본 후 사람들은 이 기술을 다른 분야의 모델 성능 향상에 사용하기 시작했습니다. 사전 훈련 기술이 NLP 분야에 적용되면 잘 훈련된 언어 모델은 장기 의존성, 계층적 관계 등 다운스트림 작업에 도움이 되는 풍부한 지식을 포착할 수 있습니다. 또한 NLP 분야에서 사전 훈련의 중요한 이점은 훈련 데이터가 레이블이 없는 모든 텍스트 코퍼스에서 나올 수 있다는 것입니다. 즉, 사전 훈련 프로세스에 사용할 수 있는 훈련 데이터의 양이 거의 무제한이라는 것입니다. . 초기 사전 훈련은 NNLM, Word2vec과 같은 정적 기법이었지만 정적 방법은 다양한 의미 환경에 적응하기 어렵습니다. 따라서 BERT, XLNet 등과 같은 동적 사전 훈련 기술이 제안되었습니다. 그림 1은 NLP, CV 및 GL 분야에서 PFM의 역사와 발전을 보여줍니다. 사전 훈련 기술을 기반으로 하는 PFM은 대규모 말뭉치를 사용하여 일반적인 의미 표현을 학습합니다. 이러한 선구적인 작품이 소개된 이후 다양한 PFM이 등장하여 다운스트림 작업 및 애플리케이션에 적용되었습니다. 최근 인기를 얻고 있는 ChatGPT가 PFM 적용의 대표적인 사례입니다. 다량의 본 논문과 코드를 사용하여 훈련한 생성적 사전 훈련된 변환기 모델 GPT-3.5를 미세 조정했습니다. 또한 ChatGPT는 대규모 LM을 인간의 의도에 맞추는 유망한 방법으로 등장한 인간 피드백 강화 학습(RLHF)을 적용합니다. ChatGPT의 뛰어난 성능은 지시 정렬 기술 적용, 강화 학습, 신속한 조정 및 사고 체인 등 각 PFM 유형의 훈련 패러다임에 변화를 가져와 일반 인공 지능으로 이동할 수 있습니다. 이 기사에서는 비교적 성숙한 연구 분류 방법인 텍스트, 이미지, 그래프 분야의 PFM에 중점을 둘 것입니다. 텍스트의 경우 시퀀스의 다음 단어나 문자를 예측하는 데 사용되는 범용 LM입니다. 예를 들어 PFM은 기계 번역, 질문 응답 시스템, 주제 모델링, 감정 분석 등에 사용될 수 있습니다. 이미지의 경우 대규모 데이터 세트를 사용하여 많은 CV 작업에 적합한 대규모 모델을 교육한다는 점에서 텍스트의 PFM과 유사합니다. 그래프의 경우 유사한 사전 학습 아이디어를 사용하여 많은 다운스트림 작업에 사용되는 PFM을 얻습니다. 이 기사에서는 특정 데이터 도메인에 대한 PFM 외에도 음성, 비디오, 도메인 간 데이터에 대한 PFM, 멀티모달 PFM과 같은 일부 다른 고급 PFM에 대해서도 검토하고 자세히 설명합니다. 또한, 멀티모달 작업을 처리할 수 있는 PFM의 대규모 융합, 소위 통합 PFM이 등장하고 있습니다. 저자는 먼저 통합 PFM의 개념을 정의한 다음 SOTA를 달성한 통합 PFM(예: OFA, UNIFIED-IO, FLAVA, BEiT-3 등)에 대한 최근 연구를 검토합니다. 위의 세 가지 분야에서 기존 PFM의 특성을 토대로 저자는 PFM이 다음과 같은 두 가지 주요 장점을 가지고 있다고 결론지었습니다. 첫째, 다운스트림 작업의 성능을 향상시키기 위해 모델에는 약간의 미세 조정만 필요합니다. 둘째, PFM은 품질 측면에서 면밀히 조사되었습니다. 유사한 문제를 해결하기 위해 처음부터 모델을 구축하는 대신 작업 관련 데이터 세트에 PFM을 적용할 수 있습니다. PFM의 광범위한 전망은 모델 효율성, 보안 및 압축과 같은 문제에 초점을 맞추는 많은 양의 관련 작업에 영감을 주었습니다. 논문 기여 및 구조 이 기사가 게시되기 전에 텍스트 생성, 시각적 변환기 및 객체 감지와 같은 특정 분야에서 사전 훈련된 모델을 검토하는 여러 리뷰가 있었습니다. "기초 모델의 기회와 위험"에는 기초 모델의 기회와 위험이 요약되어 있습니다. 그러나 기존 작업은 사전 훈련 작업, 효율성, 효율성 및 개인 정보 보호와 같은 다양한 측면에서 다양한 도메인(예: CV, NLP, GL, 음성, 비디오)의 PFM에 대한 포괄적인 검토를 달성하지 못합니다. 이 리뷰에서 저자는 NLP 분야에서 PFM의 진화와 CV 및 GL 분야에서 사전 훈련이 어떻게 이전되고 채택되었는지 자세히 설명합니다. 다른 리뷰에 비해 이 글은 세 분야 모두에서 기존 PFM에 대한 포괄적인 소개와 분석을 제공하지 않습니다. 저자는 이전의 사전 학습된 모델에 대한 리뷰와 달리 전통적인 모델부터 PFM까지 기존 모델과 세 가지 분야의 최신 작업을 요약합니다. 기존 모델은 정적 특성 학습을 강조합니다. Dynamic PFM은 주류 연구인 구조에 대한 소개를 제공합니다. 저자는 기타 고급 및 통합 PFM, 모델 효율성 및 압축, 보안, 개인 정보 보호 등 PFM에 대한 다른 연구를 소개합니다. 마지막으로 저자들은 다양한 분야의 향후 연구 과제와 미해결 문제를 요약합니다. 또한 부록 F와 G에서 관련 평가 지표와 데이터 세트에 대한 포괄적인 소개를 제공합니다. 요약하면 이 기사의 주요 기여는 다음과 같습니다. 각 장의 주요 내용은 다음과 같습니다. 논문의 2장에서는 PFM의 일반적인 개념 아키텍처를 소개합니다. 소개

3장, 4장, 5장에서는 각각 NLP, CV, GL 분야의 기존 PFM을 요약합니다.

6장과 7장은 최첨단 통합 PFM, 모델 효율성 및 압축, 보안 및 개인 정보 보호를 포함하여 PFM에 대한 기타 최첨단 연구를 소개합니다.

8장에서는 PFM의 주요 과제를 요약합니다. 9장에서는 전체 내용을 요약합니다.

위 내용은 BERT부터 ChatGPT까지, 100페이지 분량의 리뷰에 사전 학습된 대형 모델의 진화 이력이 요약되어 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!