최근 AIGC가 뜨거운 검색을 받고 있는 것 같으며 그 인기는 여전히 높습니다. 물론 매우 유명한 이름 외에도 획기적인 발전도 눈에 띕니다. 이미지, 비디오, 심지어 3D 모델까지 자동으로 생성할 수 있습니다. 자연어를 입력하는 모습, 놀랍지 않나요?

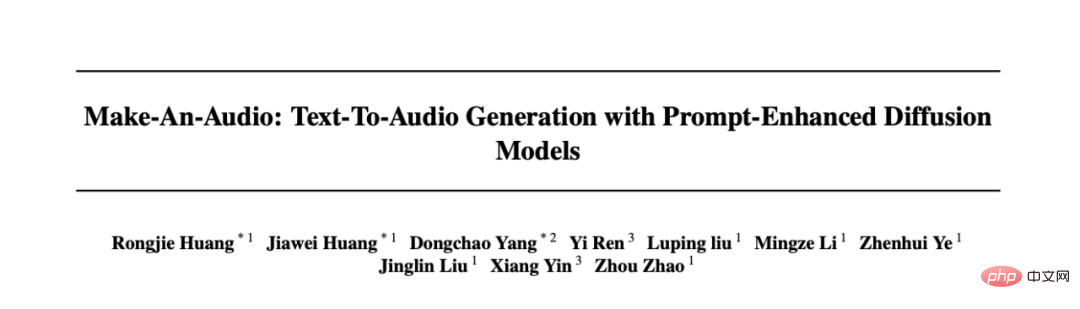

하지만 오디오, 음향효과 분야에서는 AIGC의 장점이 좀 떨어지는 것 같습니다. 주로 자유도가 높은 오디오 생성이 대량의 텍스트-오디오 쌍 데이터에 의존하고 장기적인 파형 모델링에 많은 어려움이 있기 때문입니다. 위의 어려움을 해결하기 위해 절강대학교와 북경대학교는 혁신적인 텍스트-오디오 생성 시스템, 즉 Make-An-Audio를 공동으로 제안했습니다. 자연어 설명을 입력으로 받을 수 있으며 어떤 형식(예: 텍스트, 오디오, 이미지, 비디오 등)이 될 수 있으며 동시에 설명과 일치하는 오디오 음향 효과를 출력하는 것은 어렵습니다. 대다수의 네티즌은 제어 가능성과 일반화를 높이 평가합니다. https : https://arxiv.org/abs/2301.12661

네티즌 댓글 1

대부분의 네티즌들은 AIGC 음향 효과 합성이 영화와 단편 영상 제작의 미래를 바꿀 것이라고 말했습니다.

사용자 댓글 2

사용자 댓글 3

일부 네티즌들은 “오디오만 있으면 되는데…”

네티즌 댓글 4

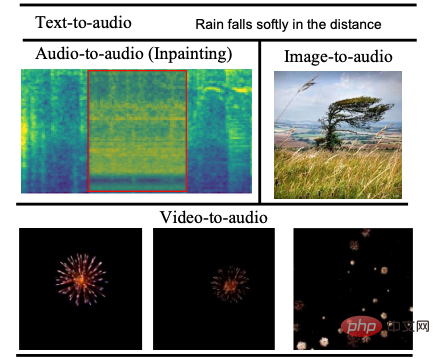

오디오 효과 표시

텍스트를 기반으로 사운드 효과 생성 그럴 수 있다고 밝혀졌어 이것도 편하고 매끄러워요.

변환 오디오 1오디오:

00:0000:09

텍스트 2: 불꽃놀이가 터지고 터집니다변환 오디오 2오디오:

00:0000:09

손상된 오디오 복구로 인해 어려움을 겪은 적이 있나요? Make-An-Audio 모델이 나오면 이 작업이 훨씬 쉬워집니다. 수정 전

수정 전 오디오

수정 전 오디오오디오: 00:0000:09

수리 후오디오 수리 후

오디오 수리 후

오디오: 00:0000:09 그림을 이해하여

음향 효과를 생성하는 것은 불가능하지 않습니다.

오디오 변환

사진 오디오 변환

00:0000:09

오디오 변환

사진 변환 오디오 2

오디오:00:0000 :09 동영상 콘텐츠를 기반으로

해당 음향 효과를 생성하는 이 모델도 쉽게 할 수 있습니다. 비디오 1

비디오 1

오디오:00:0000:09 비디오 2

변환 오디오

변환 오디오

비디오 2

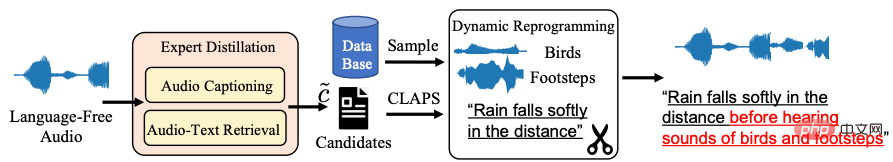

오디오:00:0000 :09 "인터넷 유명인" 모델의 마법적 의미에 대한 심층 분석뿐만 아니라 희박한 오디오-자연어 데이터의 객관적인 문제로 돌아가기 위해 절강대학교와 Peking University와 Volcano Speech Team은 교사 모델을 사용하여 오디오의 자연어 설명을 얻은 다음 동적 훈련을 얻는 Distill-then-Reprogram 텍스트 향상 전략을 공동으로 제안했습니다. 무작위 재구성을 통한 샘플. 구체적으로 Distill 링크에서는 audio-to-text 및 audio-text 검색 모델을 사용하여 언어 없는 오디오에 대한 자연어 설명 후보(후보)를 찾고 후보 텍스트와 오디오 간의 일치는 유사성을 계산하여 오디오 설명으로 임계값 아래에서 최상의 결과를 얻습니다. 이 방법은 일반화가 강력하며 실제 자연어는 테스트 단계에서 도메인 외부 텍스트를 피합니다. 연구팀은 "리프로그래밍 단계에서 팀은 추가 이벤트 데이터 세트에서 무작위로 샘플링하고 이를 현재 훈련 샘플과 결합하여 새로운 개념 조합과 설명을 얻어 다양한 이벤트 조합에 대한 모델의 견고성을 높였습니다"라고 말했습니다. 모델의 본질적인 기술 원리

Distill-then-Reprogram Text Enhancement Strategy Framework

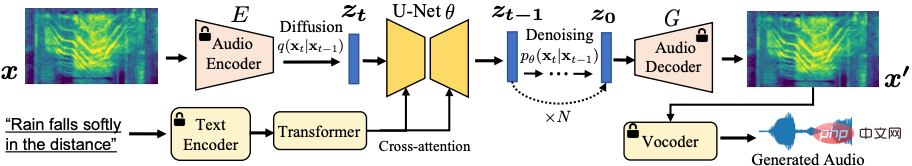

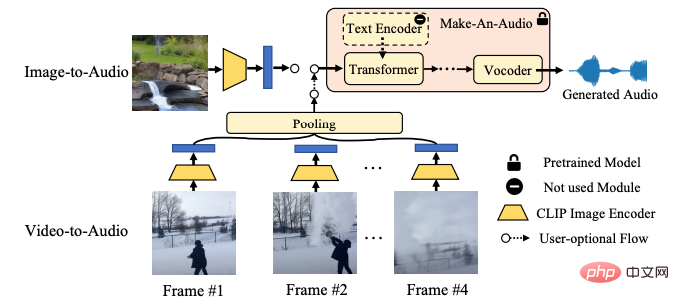

위 그림과 같이 자기 지도 학습은 스펙트럼 자동 인코더를 사용하여 이미지를 오디오 스펙트럼으로 성공적으로 전송했습니다. 긴 오디오 시퀀스의 문제를 해결하고 잠재 확산 생성 모델을 기반으로 자체 감독 표현의 예측을 완료하여 장기 파형의 직접 예측을 피합니다.

Make-An-Audio 모델 시스템 프레임워크 다이어그램

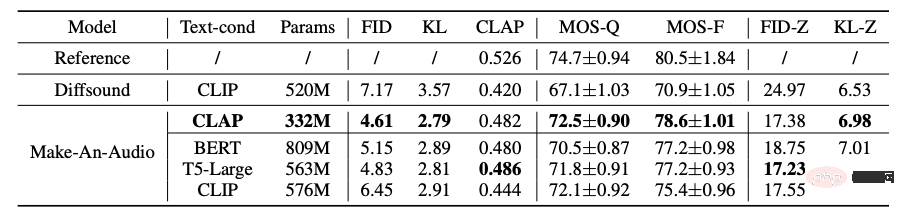

또한 연구에서 팀은 CLAP(대조 언어-오디오 사전 훈련) 및 언어 모델(LLM) T5, BERT 등은 CLAP 텍스트 표현의 효율성과 계산 친화성을 검증했습니다. 동시에 생성된 오디오를 평가하기 위해 처음으로 CLAP 점수를 사용했으며, 이는 주관적 평가 방법과 객관적 평가 방법을 조합하여 텍스트와 생성된 장면 간의 일관성을 측정하는 데 사용할 수 있으며 모델의 효율성을 검증했습니다. 벤치마크 데이터 세트 테스트에서 모델이 뛰어난 제로샷 학습(Zero-Shot) 일반화 등을 가지고 있음을 입증했습니다.

Make-An-Audio 및 베이스라인 모델의 주관적, 객관적 평가 실험 결과

전반적으로 Make-An-Audio 모델은 고품질, 고도로 제어 가능한 오디오 합성을 달성하고 텍스트 조건부 오디오 합성(오디오/ 이미지/비디오) 모든 모달 입력에 대해.

Make-An-Audio는 최초로 CLIP 텍스트 인코더를 조건으로 사용하여 고도로 제어 가능한 X-audio AIGC 합성을 구현합니다. 이미지 인코딩을 기반으로 오디오를 직접 합성합니다.

Make-An-Audio 비전 - 오디오 합성 프레임워크

Make-An-Audio 비전 - 오디오 합성 프레임워크

오디오 합성 AIGC는 향후 영화 더빙, 단편 비디오 제작 및 기타 분야에서 중요한 역할을 할 것으로 예상되며 Make-An-Audio와 같은 모델의 도움으로 누구나 전문가가 될 수 있습니다. 미래에는 텍스트, 비디오, 이미지를 사용하여 언제 어디서나 생생한 오디오와 사운드 효과를 합성할 수 있습니다. 그러나 Make-An-Audio는 현 단계에서는 완벽하지 않습니다. 아마도 풍부한 데이터 소스와 불가피한 샘플 품질 문제로 인해 학습 과정에서 텍스트 내용에 맞지 않는 오디오가 생성되는 등의 부작용이 불가피하게 발생할 것입니다. Make-An-Audio는 기술적으로 "보조 아티스트 세대"로 포지셔닝되어 있으며 한 가지 확실한 점은 AIGC 분야의 발전이 정말 놀랍다는 것입니다.

Volcano Voice는 오디오 이해, 오디오 합성, 가상 디지털 인간, 대화 상호 작용, 음악 검색, 지능형 하드웨어 등을 포함하여 세계적으로 뛰어난 AI 음성 기술 기능과 풀 스택 음성 제품 솔루션을 ByteDance의 주요 비즈니스 라인에 오랫동안 제공해 왔습니다. . 2017년 설립 이후, 이 팀은 업계 최고의 AI 지능형 음성 기술 개발에 주력해 왔으며, 더 큰 사용자 가치를 달성하기 위해 AI와 비즈니스 시나리오의 효율적인 조합을 끊임없이 탐구해 왔습니다. 현재 음성 인식 및 음성 합성은 다양한 언어와 방언을 다루며 다양한 최고의 AI 컨퍼런스에 선정되어 Douyin, Jianying, Feishu, Tomato Novels, Pico 및 기타 비즈니스에 선도적인 음성 기능을 제공하고 있습니다. 단편영상, 라이브 방송, 영상제작, 오피스, 웨어러블 디바이스 등 다양한 시나리오에 적합하며, 볼케이노 엔진을 통해 외부 기업에 공개됩니다.

위 내용은 이 오디오는 인터넷에서 입소문이 났습니다! 한 번의 클릭으로 텍스트와 그림에서 사실적인 사운드 효과를 생성하는 AIGC가 오디오 산업에 등장합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!