몇일 전 Meta AI와 Papers with Code는 대규모 언어 모델 Galactica를 출시했습니다. 이 모델의 주요 특징은 손을 자유롭게 해주는 것이며 대필자가 논문 작성을 도와줄 수 있습니다. ? 초록, 소개, 공식, 참고문헌 등이 모두 포함되어 있습니다.

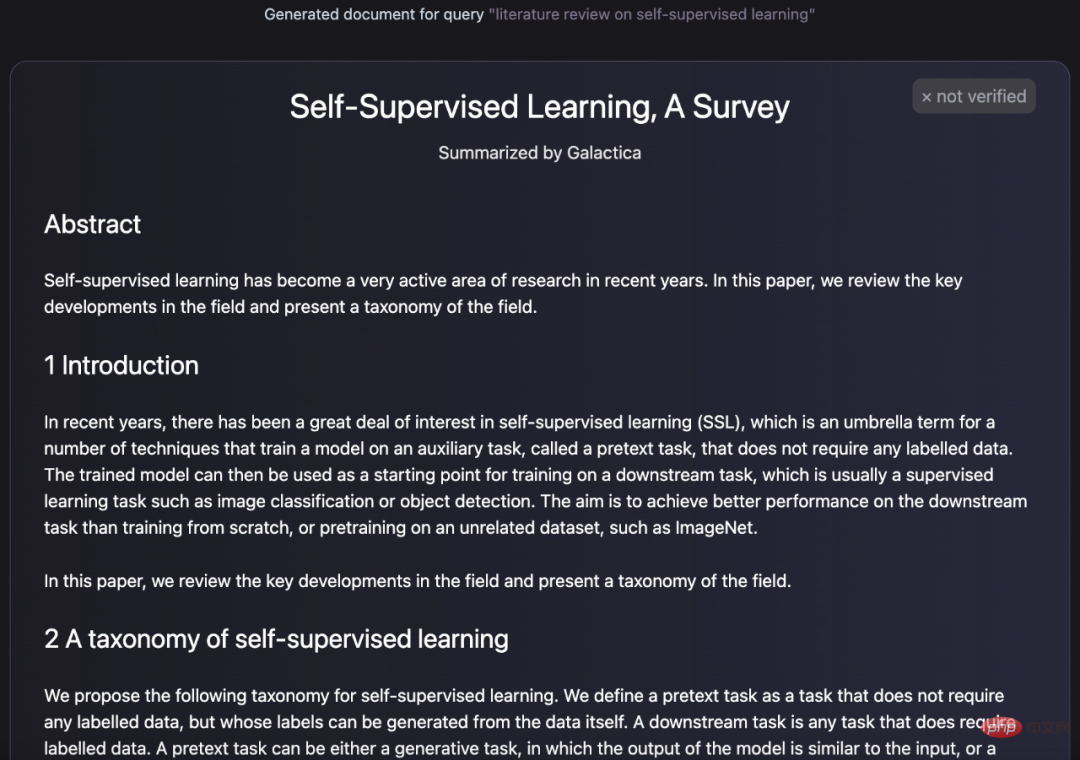

다음과 같이 Galactica에서 생성된 텍스트는 논문의 구성과 같습니다.

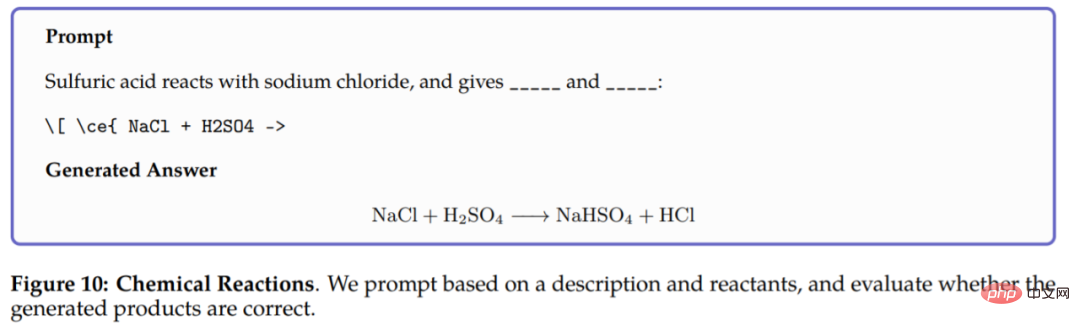

Galactica는 논문을 생성할 뿐만 아니라 항목에 대한 백과사전 쿼리를 생성하고 질문에 대한 유익한 댓글을 달 수도 있습니다. 답변, Galactica는 텍스트 생성 외에도 화학식 및 단백질 서열과 관련된 다중 모드 작업도 수행할 수 있습니다. 예를 들어, 화학 반응에서 Galactica는 화학 반응식 LaTeX에서 반응 생성물을 예측하도록 요청받습니다. 결과는 다음과 같습니다. 사용자가 이 연구를 쉽게 경험할 수 있도록 하기 위해 특별히 평가판 버전도 출시되었습니다. 아래와 같이 며칠 전 이 인터페이스에는 입력, 생성 및 기타 기능도 표시되었습니다.

(이전 버전) Galactica 체험판 주소: https://galactica.org/

몇일만에 인터페이스가 이렇게 되어버렸고 더 이상 입력이 불가능해졌습니다. .

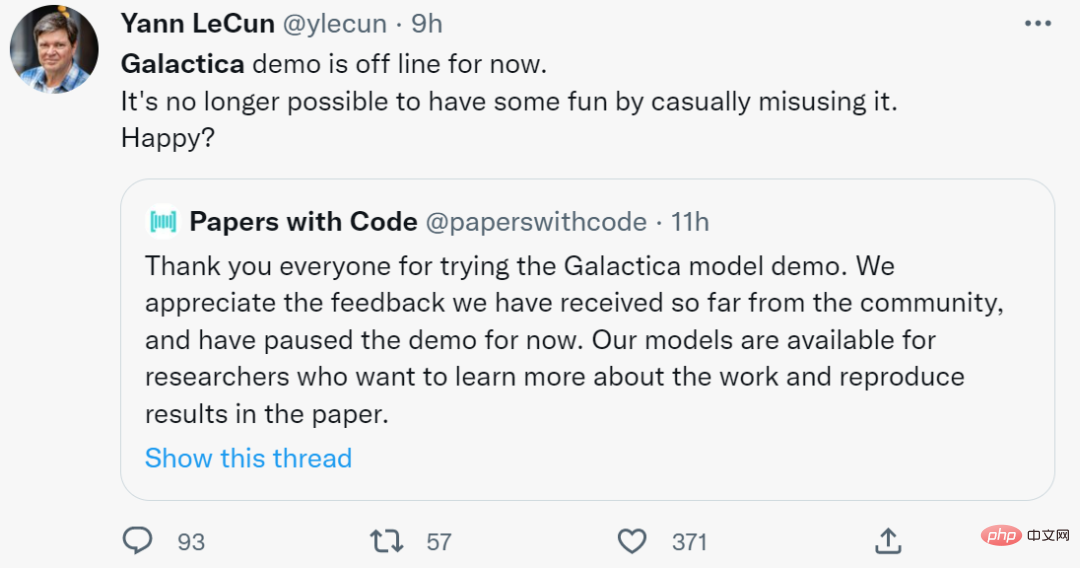

Papers with Code에 따르면 그들은 커뮤니티로부터 일부 피드백을 받았으며 Galactica의 데모 기능을 중단했습니다. 이틀 전 트위터를 통해 자신을 칭찬하던 튜링상 수상자 얀 르쿤은 오늘은 더 이상 행복할 수 없다고 무기력하게 말했다.

그러나 이 연구를 강력하게 추천하는 사람들에 비해 일부 네티즌들은 그것이 가져오는 이점에 비해 논문을 작성하는 학생들에게 더 많은 부정적인 결과를 가져올 것이라고 생각합니다. 가지고 있습니다.

학생들이 이를 사용하여 논문을 작성하는 것과 비교하면 아래 네티즌이 발견한 문제는 더욱 심각합니다.

"Galactica에 몇 가지 질문을 했는데 그 답변이 모두 틀렸거나 편향되어 있었지만 일련의 실험 후에 트위터 사용자 Michael Black은 다음과 같이 말했습니다. "Galactica가 생성한 텍스트는 문법적이며 진정성이 느껴집니다. 결과 기사는 정확할 수도 있지만 틀렸거나 편향되어 사고 방식을 감지하기 어려울 수도 있습니다. "

"Galactica에 몇 가지 질문을 했는데 그 답변이 모두 틀렸거나 편향되어 있었지만 일련의 실험 후에 트위터 사용자 Michael Black은 다음과 같이 말했습니다. "Galactica가 생성한 텍스트는 문법적이며 진정성이 느껴집니다. 결과 기사는 정확할 수도 있지만 틀렸거나 편향되어 사고 방식을 감지하기 어려울 수도 있습니다. "

"Galactica는 권위 있는 과학을 제공하지만 과학적 방법을 기반으로 하지 않습니다. 과학 저술의 통계적 특성에 따라 진실과 거짓을 구별하기 어렵게 만듭니다. 이는 가짜 과학의 시대를 열 수 있습니다. 이러한 생성된 논문은 다른 사람들이 실제 논문에서 인용하게 될 것입니다. , 그러나 이는 과학 글쓰기에 유용한 도구가 아니라는 점에 유의하세요. 이는 잠재적으로 과학을 왜곡하고 위험할 수 있습니다.

Michael Black의 답변 스크린샷. 링크: https://twitter.com/Michael_J_Black/status/1593133722316189696

갤럭티카가 허술하고 사이비 과학 기사를 생성하는 등의 문제가 있음을 발견한 사람은 마이클 블랙뿐만이 아닙니다. 이 결함. 다른 네티즌들의 댓글도 살펴보자.

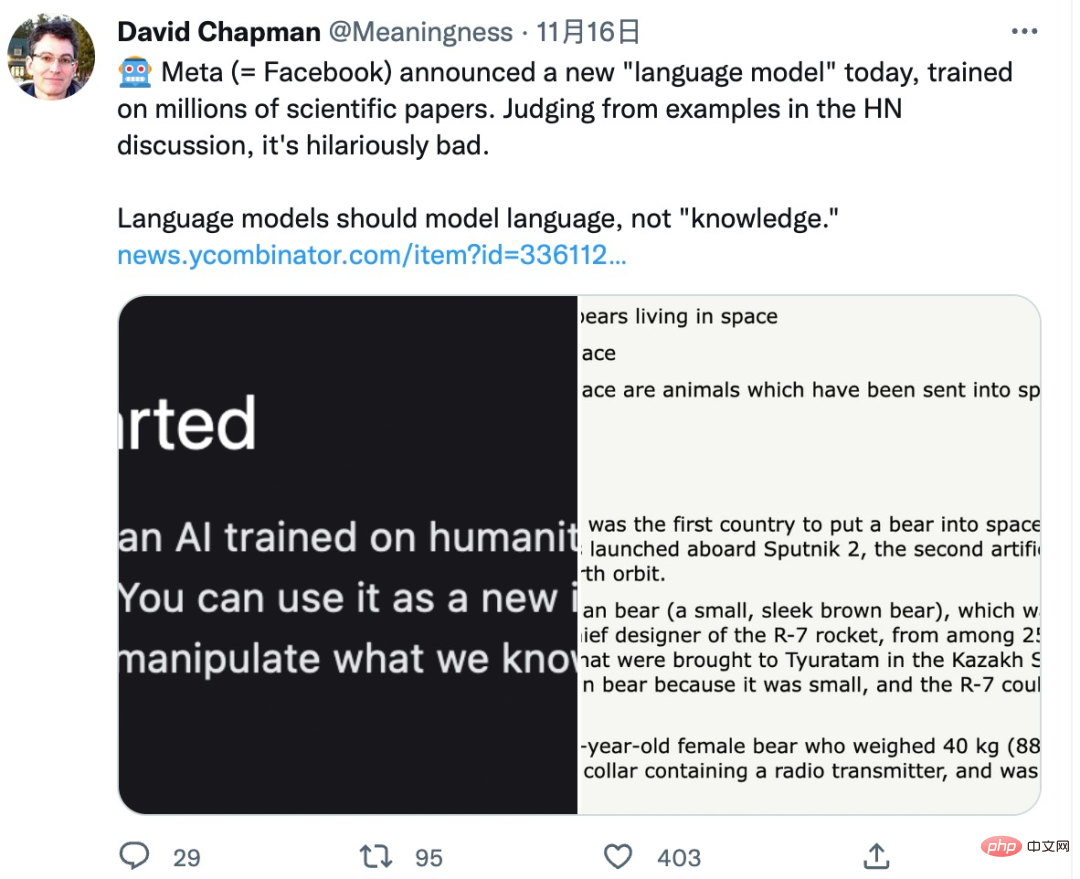

갤럭티카 체험판이 출시된 후 많은 학자들이 이에 대해 의구심을 제기했습니다.

David Chapman이라는 AI 학자는 언어 모델이 지식을 생성하기보다는 언어를 구성하고 합성해야 한다고 지적했습니다.

이것은 실제로 AI 모델이 언어를 생성할 수 있는지 생각해 볼 가치가 있는 질문입니다. 지식", 그렇다면 이 지식이 올바른지 어떻게 판단할 수 있을까요? 그들은 인간에게 어떤 영향을 미치거나 심지어 잘못된 길로 인도할 것입니까?

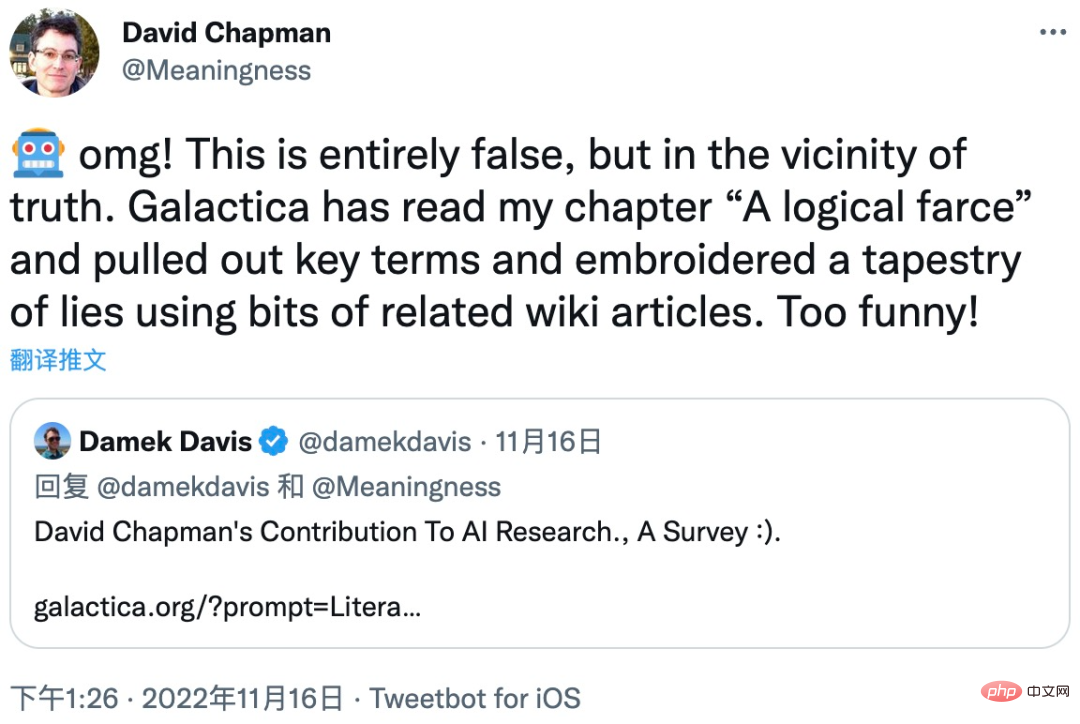

David Chapman은 이 문제의 심각성을 설명하기 위해 자신의 논문 중 하나를 예로 사용했습니다. Galactica 모델은 논문의 "논리적 희극" 부분에서 핵심 용어를 추출한 후 일부 관련 Wikipedia 기사를 사용하고 최종적으로 오류와 누락이 가득한 기사를 편집하고 합성했습니다.

갤럭티카 모델의 체험판이 내려졌기 때문에 이 글이 논문의 원래 의도에서 얼마나 벗어났는지 알 수 없습니다. 그러나 초보자가 Galactica 모델 합성에 대한 이 기사를 읽는다면 심각한 오해를 받을 수 있다고 생각할 수 있습니다.

유명한 AI 학자이자 Robust.AI의 창립자인 Gary Marcus도 Galactica 모델에 대해 강한 의구심을 표명했습니다. "대형 언어 모델(LLM)이 수학과 과학 지식을 혼동한다는 것은 다소 무섭습니다. 고등학생 이를 좋아하고 교사를 속이는 데 사용할 수도 있습니다.

뉴욕 대학교 컴퓨터 과학과의 학자들도 Galactica 모델의 결과를 테스트한 결과 Galactica가 질문에 답하지 않는다는 사실을 발견했습니다. :

출처 : https://cs.nyu.edu/~davise/papers/ExperimentWithGalaxica.html

우선, 이 실험에서 Galactica 모델의 답에는 다음이 포함됩니다. 다음과 같은 몇 가지 올바른 정보:

그뿐만 아니라 Galactica 모델 답변의 일부 세부 사항에는 사실과 관련된 오류가 있습니다.

New의 실험입니다. York University는 Galactica 모델에서 생성된 결과에 심각한 오류가 있음을 매우 구체적으로 보여 주며, 연구에서는 다양한 문제에 대해 여러 실험을 수행했으며, Galactica에서 생성된 오류 정보는 매번 오류로 가득 차 있음을 보여줍니다. 뉴욕대학교 실험 보고서: https://cs.nyu.edu/~davise/papers/ExperimentWithGalaxica.html 일부 네티즌들은 Galactica의 실패에 대해 다음과 같은 한계를 지적했습니다. 딥 러닝: "딥 러닝의 본질은 인간 지능과 본질적으로 다르며 일반적인 인공 지능(AGI)을 전혀 달성할 수 없는 데이터에서 학습하는 것입니다. 향후 발전에 대해서는 의견이 다릅니다." 그러나 "지식"을 잘못 생성하는 Galactica와 같은 언어 모델은 바람직하지 않다는 것은 의심의 여지가 없습니다.

위 내용은 온라인에 올라간 지 이틀 만에 대형 AI 모델 논문 작성 사이트 빛의 속도로 삭제: 무책임한 조작의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!