Li Feifei의 두 견습생이 공동으로 안내: '다중 모드 프롬프트'를 이해할 수 있는 로봇은 제로 샷 성능을 2.9배 향상시킬 수 있습니다.

인공지능 분야의 다음 개발 기회는 AI 모델에 '몸'을 장착하고 현실 세계와 상호작용하여 학습하는 것일 수도 있습니다.

특정 환경에서 수행되는 자연어 처리, 컴퓨터 비전 등의 기존 작업에 비해 개방 분야의 로봇 기술은 확실히 더 어렵습니다.

예를 들어, 프롬프트 기반 학습을 사용하면 단일 언어 모델이 프롬프트 수정만으로 코드 작성, 초록 작성, 질문 및 답변과 같은 모든 자연어 처리 작업을 수행할 수 있습니다.

그러나 로봇 공학에는 단일 샘플 시연을 모방하거나, 언어 지침을 따르거나, 특정 시각적 목표를 달성하는 등 더 많은 유형의 작업 사양이 있습니다. 이러한 작업은 일반적으로 다른 작업으로 간주되며 에 의해 특별히 훈련됩니다. 모델 이를 처리하려면.

최근 NVIDIA, Stanford University, Macalester College, Caltech, Tsinghua University 및 Austin에 있는 Texas University의 연구원들은 다중 양식을 활용하는 Transformer 기반 범용 로봇 에이전트 VIMA를 공동으로 제안했습니다. 매우 높은 일반화 성능으로 수많은 로봇 작동 작업을 처리할 수 있습니다.

논문 링크: https://arxiv.org/abs/2210.03094

프로젝트 링크: https://vimalabs.github.io/

코드 링크: https://github.com/vimalabs/VIMA

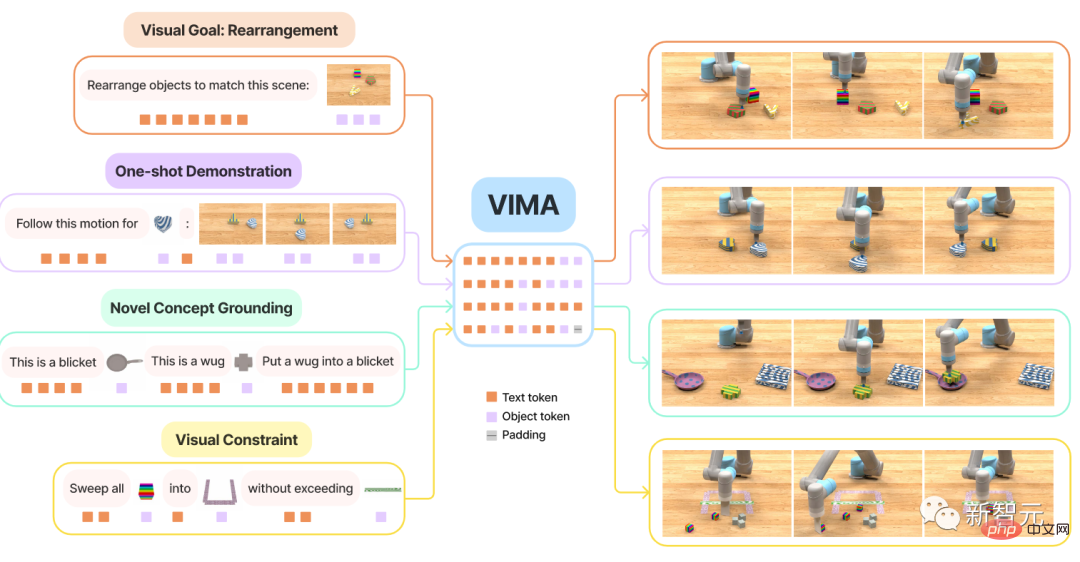

입력 프롬프트는 인터리브 텍스트 및 시각적 기호입니다.

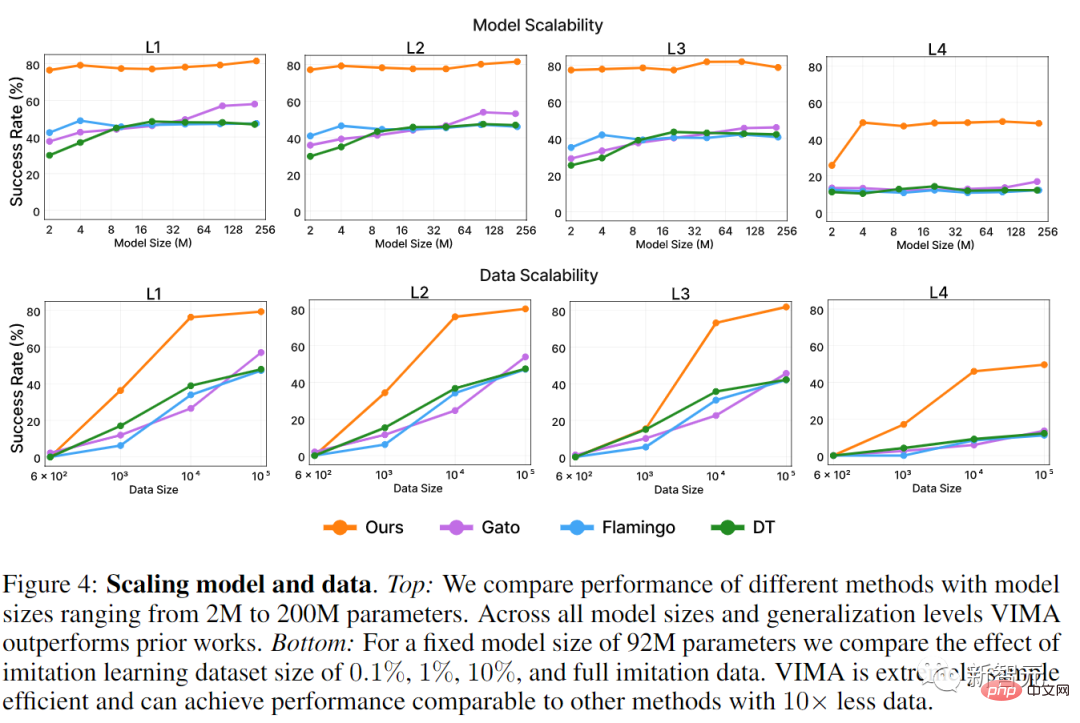

VIMA를 교육하고 평가하기 위해 연구원들은 다중 모달 프롬프트가 포함된 수천 개의 절차적으로 생성된 데스크톱 작업과 600,000개 이상의 전문가 궤적을 포함하는 새로운 시뮬레이션 벤치마크 데이터세트를 제안합니다. 모델은 4개 레벨으로 평가됩니다.

동일한 크기의 모델과 동일한 양의 훈련 데이터를 사용하여 가장 어려운 제로샷 일반화 설정에서 VIMA의 성공률은 현재 sota 방법의 2.9배입니다.

학습 데이터가 10배 감소하더라도 VIMA는 여전히 다른 방법보다 2.7배 더 나은 성능을 발휘합니다.현재 모든 코드, 사전 훈련된 모델, 데이터 세트 및 시뮬레이션 벤치마크는

완전한 오픈 소스입니다.

논문의 첫 번째 저자는 스탠포드 대학교 석사 2년차이자 현재 NVIDIA 연구소에서 인턴으로 근무하고 있는Yunfan Jiang입니다. 2020년 에든버러 대학교를 졸업했습니다. 그의 주요 연구방향은 환경과의 상호작용을 통해 학습하는 구체화된 인공지능(embodied AI)이다. 구체적인 연구 내용은 대규모 기본 모델을 사용하여 개방형 구현 에이전트를 구현하는 방법입니다. 이 논문에는 두 명의 멘토가 포함되어 있으며 둘 다 Li Feifei의 전 학생이었습니다.

Zhu Yuke 는 저장대학교에서 학사 학위를 취득하고 캐나다 저장대학교와 사이먼 프레이저 대학교에서 이중 학위를 받았습니다. 석사 및 박사 과정 학생들은 스탠포드 대학에서 리 페이페이(Li Feifei) 지도 아래 공부하고 2019년 8월에 박사 학위를 취득했습니다. Zhu Yuke는 현재 UT 오스틴 컴퓨터 과학과 조교수, 로봇 인식 및 학습 연구소 소장, NVIDIA 연구소 선임 연구 과학자입니다.

는 저장대학교에서 학사 학위를 취득하고 캐나다 저장대학교와 사이먼 프레이저 대학교에서 이중 학위를 받았습니다. 석사 및 박사 과정 학생들은 스탠포드 대학에서 리 페이페이(Li Feifei) 지도 아래 공부하고 2019년 8월에 박사 학위를 취득했습니다. Zhu Yuke는 현재 UT 오스틴 컴퓨터 과학과 조교수, 로봇 인식 및 학습 연구소 소장, NVIDIA 연구소 선임 연구 과학자입니다.

Fan Linxi는 스탠포드 대학교에서 박사 학위를 취득하고 Li Feifei 밑에서 공부했으며 현재 NVIDIA AI의 연구 과학자입니다. 주요 연구 방향은 일반적으로 유능한 자율 에이전트를 개발하는 것입니다. 구체적인 연구 작업은 기본 모델, 정책 학습, 로봇 공학, 다중 모드 학습 및 대규모 시스템을 다루고 있습니다.

로봇 및 다중 모드 프롬프트

Transformer는 NLP 분야의 멀티 태스킹에서 매우 높은 성능을 달성했습니다. 하나의 모델만 질문 및 답변, 기계 번역, 텍스트 요약 등을 동시에 완료할 수 있습니다.

다양한 작업을 구현하기 위한 인터페이스는 입력 텍스트 프롬프트에 있으므로 특정 작업 요구 사항을 일반 대형 모델에 전달합니다.

이 프롬프트 인터페이스를 일반 로봇 에이전트에서도 사용할 수 있나요?

가사 로봇의 경우 이상적으로는 Bring it to me만 입력하면 로봇이 그림에 따라 컵을 가져올 수 있습니다.

로봇이 새로운 기술을 배워야 할 때는 비디오 데모를 입력하여 배우는 것이 가장 좋습니다. 로봇이 낯선 물체와 상호작용해야 하는 경우, 그림만으로도 쉽게 설명할 수 있습니다.

동시에 안전한 배포를 보장하기 위해 사용자는 Do not enter the room

과 같은 시각적 제약 조건을 추가로 지정할 수 있습니다. 이러한 기능을 달성하기 위해 VIMA 모델은 주로 세 부분으로 구성됩니다: 공식 다중 모드 프롬프트

, 로봇 조작 작업을 시퀀스 모델링 문제로 변환2 다중 작업 작업이 가능한 새로운 로봇 에이전트 모델

3. 에이전트의 확장성과 일반성을 체계적으로 평가하기 위한 작업의 다양한 대규모 벤치마크를 갖춘 새로운 로봇 에이전트 모델

첫째, 다중 모드 프롬프트가 제공하는 유연성을 통해 개발자는 단일 에이전트를 지정하고 구축할 수 있습니다. 다수의 Task 사양을 지원하는 모델에서 본 논문에서는 주로 6가지 유형의 작업을 고려합니다:

1, Simple object 조작(Simple object 조작) , 작업 프롬프트는 put

into형식입니다. 해당 슬롯은 개체의 이미지입니다. , 재배열과 같은 목표 설정을 달성하기 위해 개체 조작

3, 새로운 개념 수용, 프롬프트에는 dax, blicket 등과 같은 일부 흔하지 않은 단어를 프롬프트의 이미지를 통해 설명할 수 있으며 지침에 직접 사용할 수 있어 에이전트의 새로운 개념 인지 속도를 테스트할 수 있습니다.

4, 단일 샘플 원샷 비디오 모방, 비디오 시연을 보고 동일한 이동 경로로 특정 개체를 재현하는 방법을 알아보세요.

5, 시각적 제약 조건 만족, 로봇은 위반하지 않도록 개체를 주의 깊게 조작해야 합니다.

6. 시각적 추론(Visual Reasoning) . "

와 동일한 질감을 가진 모든 개체를 컨테이너에 넣습니다"와 같이 에이전트가 추론해야 하는 작업이 있습니다. "를 용기에 넣은 다음 다시 제자리에 넣으세요". 예를 들어 일부 작업 동사(소설 개념 ) 이전에 볼 수 없었던 시연 영상(모방)을 통해 소개할 수도 있습니다

새로운 벤치마크 VIM-BENCH영리한 여성이 밥 없이 요리하는 것은 어렵습니다.

멀티모달 로봇 학습 벤치마크 VIMA-BENCH로 몇 가지 지원 데이터를 준비했습니다.

시뮬레이션 환경에서 기존 벤치마크는 일반적으로 특정 작업 사양을 목표로 합니다. 현재 탐지 에이전트 기능을 목표로 하는 풍부한 다중 모드 작업 제품군과 포괄적인 테스트 플랫폼을 제공할 수 있는 벤치마크는 없습니다.

이를 위해 연구원들은 Ravens 로봇 시뮬레이터를 확장하여 확장 가능한 객체 및 텍스처 컬렉션을 지원하여 다중 모드 큐를 구성하고 절차적으로 많은 작업을 생성함으로써 VIMA-BENCH를 구축했습니다.

특히 VIMA-BENCH는 1000개의 독립적인 작업으로 인스턴스화할 수 있는 다중 모드 프롬프트 템플릿이 포함된 17개의 메타 작업을 제공합니다. 각 메타 작업은 위의 6가지 작업 지정 방법 중 하나 이상에 속합니다.

VIMA-BENCH는 스크립트된 Oracle 에이전트를 통해 대량의 모방 학습 데이터를 생성할 수 있습니다.

Observation and Actions에서 시뮬레이터의 관찰 공간은 정면 및 하향식 뷰에서 렌더링된 RGB 이미지로 구성되며, 벤치마크는 Train 객체 중심 모델을 위한 사실적인 객체 분할 및 경계 상자도 제공합니다.

VIM-BENCH는 전작의 고급 액션 공간을 계승하여 말단 효과의 자세에 따라 결정되는 "픽 앤 플레이스", "와이프" 등 가장 기본적인 동작 스킬로 구성됩니다. .

시뮬레이터에는 모든 객체의 정확한 위치, 다중 모드 명령의 기본 해석과 같은 권한 있는 시뮬레이터 상태 정보를 사용하여 전문적인 데모를 생성할 수 있는 스크립트가 있는 oracle 프로그램도 포함되어 있습니다.

마지막으로 연구원들은 사전 프로그래밍된 오라클을 통해 모방 학습을 위한 전문가 궤적의 대규모 오프라인 데이터 세트를 생성했습니다. 데이터 세트에는 각 메타 작업에 대한 50,000개의 궤적이 포함되어 총 650,000개의 성공적인 궤적이 포함됩니다.

또한 쉬운 평가를 위해 객체 모델 및 텍스처의 하위 집합을 유지하고 제로샷 일반화 테스트를 위해 17개 메타 작업 중 4개를 사용합니다.

VIMA-BENCH의 각 작업 기준에는 성공과 실패만 있을 뿐 중간 상태에 대한 보상 신호는 없습니다.

테스트 시간에 연구원들은 물리 시뮬레이터에서 에이전트 전략을 실행하여 성공률을 계산했으며, 평가된 모든 메타 작업의 평균 성공률이 최종 보고된 지표였습니다.

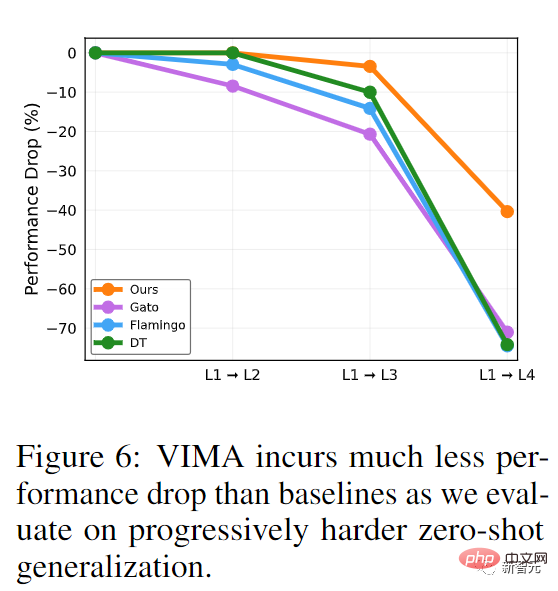

평가 프로토콜에는 체계적으로 에이전트의 일반화 능력을 조사하기 위한 4개 레벨이 포함되어 있습니다. 각 레벨은 훈련 분포에서 더 많이 벗어나므로 엄밀히 말하면 한 레벨이 다음 레벨보다 더 어렵습니다.

1. 배치 일반화: 훈련 중에는 모든 프롬프트가 단어 단위로 표시되지만 테스트 중에는 바탕 화면의 개체 배치가 무작위입니다.

2, 조합 일반화: 훈련에서는 모든 재료(형용사)와 3차원 물체(명사)를 볼 수 있지만 테스트에서는 몇 가지 새로운 조합 형태가 나타납니다.

3. 새로운 개체 일반화: 테스트 프롬프트와 시뮬레이션된 작업 공간에는 새로운 형용사와 개체가 포함됩니다.

4, 새로운 작업 일반화: 테스트 중 새로운 프롬프트 템플릿을 사용한 새로운 메타 작업

VIMA 모델

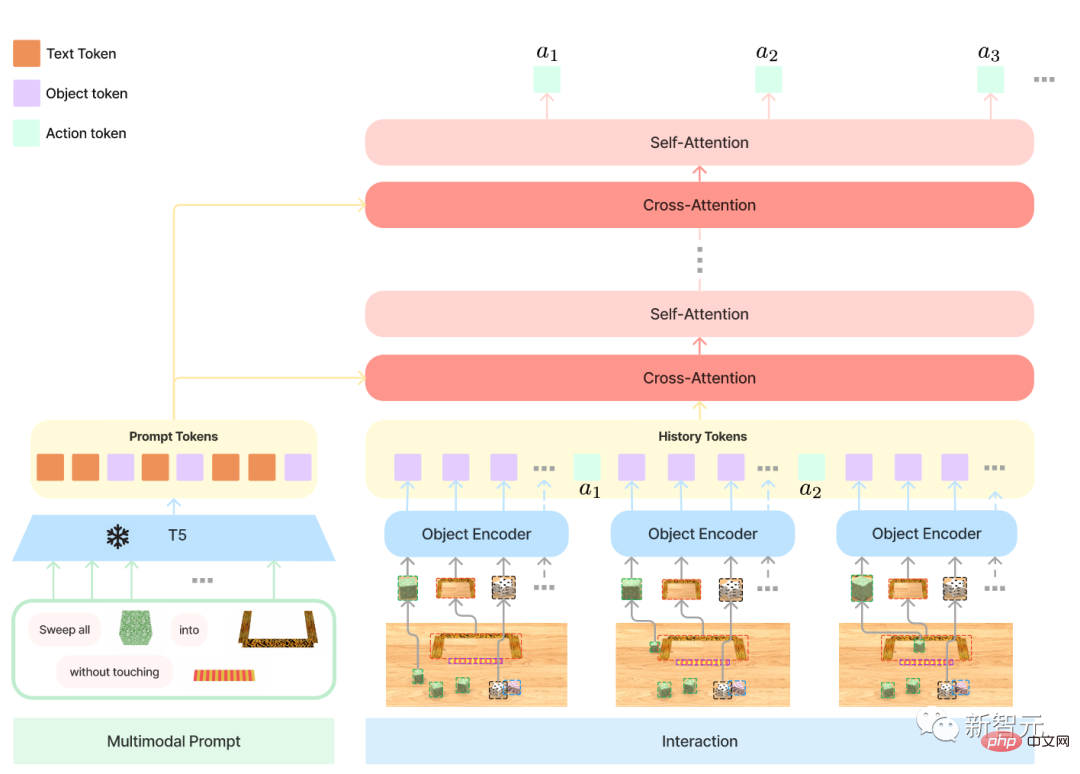

멀티 모달 프롬프트에는 총 세 가지 형식이 포함됩니다.

1, Text, 사전 훈련된 T5 모델을 사용하여 단어를 분할하고 단어 벡터를 얻습니다.

2, 전체 데스크탑 장면, 먼저 Mask R-CNN을 사용하여 모든 독립 개체, 각 개체를 식별합니다. 경계 상자와 잘린 이미지로 표현된 다음 각각 경계 bo 인코더와 ViT를 사용하여 인코딩됩니다.

3, 단일 객체의 이미지, 또한 ViT를 사용하여 토큰을 얻은 다음 결과 시퀀스를 사전 훈련된 T5 인코더 모델에 입력합니다.

로봇 컨트롤러, 즉 디코더의 입력은 프롬프트 시퀀스의 여러 교차 주의 레이어 이후의 표현 및 궤적 히스토리 시퀀스입니다.

이러한 디자인은 프롬프트에 대한 연결을 향상하고 원래 프롬프트 토큰을 더 잘 유지하고 처리하며 컴퓨팅 효율성을 높일 수 있습니다.

테스트 단계의 실험 설계는 주로 세 가지 질문에 답하기 위한 것입니다:

1, 다중 모드 프롬프트를 사용하는 다양한 작업에서 VIMA와 이전 SOTA Transformer 기반 에이전트의 성능 비교 ;

2, VIMA의 모델 용량 및 데이터 볼륨 확장 속성

3, 다양한 시각적 단어 분할기, 조건부 프롬프트 및 조건부 인코딩이 최종 의사 결정에 영향을 미칠지 여부.

비교된 기본 모델에는 Gato, Flamingo 및 Decision Transformer(DT)

가 포함됩니다. 먼저 모델 스케일링에서 연구원들은 모든 방법을 2M에서 200M로 확장했습니다. 매개변수 수는 다음과 같습니다. 훈련에 사용되며 인코더의 크기는 항상 T5 기반으로 유지됩니다. VIMA는 모든 수준에서 제로샷 일반화 평가에서 다른 작업보다 절대적으로 좋습니다.

Gato와 Flamingo는 더 큰 크기의 모델에서 성능이 향상되었지만 VIMA는 여전히 모든 모델보다 우수합니다.

데이터 스케일링에서 연구원들은 각 방법의 학습 데이터에 대해 0.1%, 1%, 10%의 다양한 실험을 수행했으며 VIMA에는 1%만 필요합니다. 10배의 데이터를 사용하여 다른 방법으로 훈련된 L1 및 L2 일반화 지표를 달성할 수 있습니다. L4 지표에서 훈련 데이터의 1%만 사용하여 VIMA는 이미 전체 데이터 양에 대해 훈련된 다른 모델보다 우수합니다.

점진적 일반화 성능 비교에서는 더 어려운 일반화 작업에는 미세 조정이 사용되지 않았습니다. VIMA 모델은 특히 L1에서 L2로, L1에서 L3으로 성능 회귀가 가장 적은 반면 다른 모델은 20% 이상 성능이 저하되었습니다. 이는 VIMA가 보다 일반화된 전략과 보다 강력한 표현을 학습했음을 의미합니다.

참조:

https://arxiv.org/abs/2210.03094

위 내용은 Li Feifei의 두 견습생이 공동으로 안내: '다중 모드 프롬프트'를 이해할 수 있는 로봇은 제로 샷 성능을 2.9배 향상시킬 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7569

7569

15

15

1386

1386

52

52

87

87

11

11

61

61

19

19

28

28

107

107

날아다니는 것, 입을 벌리는 것, 쳐다보는 것, 눈썹을 치켜올리는 것 등의 얼굴 특징을 AI가 완벽하게 모방할 수 있어 영상사기 예방이 불가능하다.

Dec 14, 2023 pm 11:30 PM

날아다니는 것, 입을 벌리는 것, 쳐다보는 것, 눈썹을 치켜올리는 것 등의 얼굴 특징을 AI가 완벽하게 모방할 수 있어 영상사기 예방이 불가능하다.

Dec 14, 2023 pm 11:30 PM

이렇게 강력한 AI 모방 능력을 가지고 있다면, 막는 것은 사실상 불가능합니다. 이제 AI의 발전이 이 정도 수준에 이르렀나? 앞발은 이목구비를 날리게 하고, 뒷발은 쳐다보는 것, 눈썹을 치켜올리는 것, 삐죽이는 것 등 아무리 과장된 표정이라도 완벽하게 흉내낸다. 난이도를 높이고, 눈썹을 더 높이 올리고, 눈을 크게 뜨고, 입 모양까지 비뚤어지게 표현하는 등 가상 캐릭터 아바타가 표정을 완벽하게 재현할 수 있다. 왼쪽의 매개변수를 조정하면 오른쪽의 가상 아바타도 그에 따라 움직임을 변경하여 입과 눈을 클로즈업하여 모방이 완전히 동일하다고는 할 수 없으며 표정만 정확합니다. 마찬가지다(맨 오른쪽). 이 연구는 GaussianAvatars를 제안하는 뮌헨 기술 대학과 같은 기관에서 나왔습니다.

2세대 아메카가 왔습니다! 그는 청중과 유창하게 소통할 수 있고, 표정이 더욱 사실적이며, 수십 개 언어를 구사할 수 있다.

Mar 04, 2024 am 09:10 AM

2세대 아메카가 왔습니다! 그는 청중과 유창하게 소통할 수 있고, 표정이 더욱 사실적이며, 수십 개 언어를 구사할 수 있다.

Mar 04, 2024 am 09:10 AM

휴머노이드 로봇 아메카가 2세대로 업그레이드 되었습니다! 최근 세계이동통신학회(MWC2024)에서 세계 최고 수준의 로봇 아메카(Ameca)가 다시 등장했다. 행사장 주변에는 아메카가 많은 관중을 끌어 모았습니다. GPT-4의 축복으로 Ameca는 다양한 문제에 실시간으로 대응할 수 있습니다. "춤을 추자." 감정이 있느냐는 질문에 아메카는 매우 생생해 보이는 일련의 표정으로 대답했습니다. 불과 며칠 전, Ameca의 뒤를 잇는 영국 로봇 회사인 EngineeredArts는 팀의 최신 개발 결과를 시연했습니다. 영상 속 로봇 아메카는 시각 능력을 갖고 있어 방 전체와 특정 사물을 보고 묘사할 수 있다. 가장 놀라운 점은 그녀도 할 수 있다는 것입니다.

AI는 어떻게 로봇을 보다 자율적이고 적응력 있게 만들 수 있습니까?

Jun 03, 2024 pm 07:18 PM

AI는 어떻게 로봇을 보다 자율적이고 적응력 있게 만들 수 있습니까?

Jun 03, 2024 pm 07:18 PM

산업자동화 기술 분야에서 최근 무시하기 어려운 두 핫스팟이 있는데 바로 인공지능(AI)과 엔비디아다. 원본 콘텐츠의 의미를 바꾸지 말고, 콘텐츠를 미세 조정하고, 콘텐츠를 다시 작성하고, 계속하지 마세요. “그뿐만 아니라 Nvidia가 원래 그래픽 처리 장치(GPU)에만 국한되지 않기 때문에 둘은 밀접하게 관련되어 있습니다. 엔비디아는 최근 GPU를 확장해 디지털 트윈 분야까지 확장하고 있으며, 최근 떠오르는 AI 기술과도 긴밀하게 연결돼 있다”고 말했다. Schneider Electric, Teradyne Robotics, MiR 및 Universal Robots 회사도 포함됩니다. 최근 엔비디아(Nvidia)는

2개월 만에 휴머노이드 로봇 '워커S' 옷 개기 가능

Apr 03, 2024 am 08:01 AM

2개월 만에 휴머노이드 로봇 '워커S' 옷 개기 가능

Apr 03, 2024 am 08:01 AM

기계력 보고서 편집자: 우신(Wu Xin) 국내판 휴머노이드 로봇+대형 모델팀이 옷 접기 등 복잡하고 유연한 재료의 작업 작업을 처음으로 완료했습니다. OpenAI 멀티모달 대형 모델을 접목한 Figure01이 공개되면서 국내 동종업체들의 관련 진전이 주목받고 있다. 바로 어제, 중국의 "1위 휴머노이드 로봇 주식"인 UBTECH는 Baidu Wenxin의 대형 모델과 긴밀하게 통합되어 몇 가지 흥미로운 새로운 기능을 보여주는 휴머노이드 로봇 WalkerS의 첫 번째 데모를 출시했습니다. 이제 Baidu Wenxin의 대형 모델 역량을 활용한 WalkerS의 모습은 이렇습니다. Figure01과 마찬가지로 WalkerS는 움직이지 않고 책상 뒤에 서서 일련의 작업을 완료합니다. 인간의 명령을 따르고 옷을 접을 수 있습니다.

다섯 개의 유연한 손가락과 초인적인 속도를 갖춘 인간 작업을 자율적으로 완료하는 최초의 로봇 등장, 가상 공간 훈련을 지원하는 대형 모델

Mar 11, 2024 pm 12:10 PM

다섯 개의 유연한 손가락과 초인적인 속도를 갖춘 인간 작업을 자율적으로 완료하는 최초의 로봇 등장, 가상 공간 훈련을 지원하는 대형 모델

Mar 11, 2024 pm 12:10 PM

이번 주, 오픈AI(OpenAI), 마이크로소프트(Microsoft), 베조스(Bezos), 엔비디아(Nvidia)가 투자한 로봇 회사인 FigureAI는 약 7억 달러의 자금 조달을 받았으며 내년 내에 독립적으로 걸을 수 있는 휴머노이드 로봇을 개발할 계획이라고 발표했습니다. 그리고 Tesla의 Optimus Prime은 계속해서 좋은 소식을 받았습니다. 올해가 휴머노이드 로봇이 폭발하는 해가 될 것이라는 데는 누구도 의심하지 않는다. 캐나다에 본사를 둔 로봇 회사인 SanctuaryAI는 최근 새로운 휴머노이드 로봇인 Phoenix를 출시했습니다. 관계자들은 이 로봇이 인간과 같은 속도로 자율적으로 많은 작업을 완료할 수 있다고 주장한다. 인간의 속도로 자동으로 작업을 완료할 수 있는 세계 최초의 로봇인 Pheonix는 각 물체를 부드럽게 잡고 움직이며 우아하게 왼쪽과 오른쪽에 배치할 수 있습니다. 자동으로 물체를 식별할 수 있습니다.

인간형 로봇은 마술을 할 수 있습니다. 봄 축제 갈라 프로그램 팀에서 자세히 알아보세요.

Feb 04, 2024 am 09:03 AM

인간형 로봇은 마술을 할 수 있습니다. 봄 축제 갈라 프로그램 팀에서 자세히 알아보세요.

Feb 04, 2024 am 09:03 AM

눈 깜짝할 사이에 로봇이 마법을 배웠다고? 먼저 테이블 위의 물숟가락을 집어서 관객들에게 아무것도 없다는 것을 증명하는 모습이 보였고... 그리고 달걀 같은 물체를 손에 쥐고 다시 물숟가락을 테이블 위에 올려 놓았습니다. 그리고 "주문을 걸기" 시작했습니다... ...다시 물숟가락을 집었을 때 기적이 일어났습니다. 원래 넣었던 알은 사라지고, 튀어나온 것은 농구공으로 변해버렸는데... 연속적인 동작을 다시 살펴보자: △ 이 애니메이션은 2배속으로 일련의 동작을 보여주며, 보기만 해도 부드럽게 흘러간다. 0.5배속으로 반복해서 영상을 보면, 마침내 단서를 발견했습니다. 내 손의 속도가 더 빨랐다면 적에게 숨길 수도 있었을 것입니다. 일부 네티즌들은 로봇의 마법 실력이 자신보다 훨씬 높다고 한탄했습니다. 이 마법을 우리를 위해 수행한 사람은 매그였습니다.

미래를 만들어가는 10대의 휴머노이드 로봇

Mar 22, 2024 pm 08:51 PM

미래를 만들어가는 10대의 휴머노이드 로봇

Mar 22, 2024 pm 08:51 PM

다음 10가지 휴머노이드 로봇이 우리의 미래를 형성하고 있습니다. 1. ASIMO: Honda가 개발한 ASIMO는 가장 잘 알려진 휴머노이드 로봇 중 하나입니다. 높이 4피트, 무게 119파운드의 ASIMO는 복잡한 환경을 탐색하고 인간과 상호 작용할 수 있는 고급 센서와 인공 지능 기능을 갖추고 있습니다. ASIMO의 다재다능함은 장애인 지원부터 이벤트 프레젠테이션 제공까지 다양한 작업에 적합합니다. 2. 페퍼(Pepper): 소프트뱅크 로보틱스가 만든 페퍼는 인간의 사회적 동반자가 되는 것을 목표로 한다. 표현력이 풍부한 얼굴과 감정을 인식하는 능력을 갖춘 Pepper는 대화에 참여하고, 소매업 환경을 돕고, 교육 지원도 제공할 수 있습니다. 피망

구름고래 Xiaoyao 001 청소 및 걸레질 로봇에는 '뇌'가 있습니다! 경험 |

Apr 26, 2024 pm 04:22 PM

구름고래 Xiaoyao 001 청소 및 걸레질 로봇에는 '뇌'가 있습니다! 경험 |

Apr 26, 2024 pm 04:22 PM

쓸고 닦는 로봇은 최근 소비자들 사이에서 가장 인기 있는 스마트 가전제품 중 하나입니다. 그것이 가져오는 조작의 편리함, 심지어 조작이 필요하지 않은 것만으로도 게으른 사람들이 손을 자유롭게 할 수 있게 되어 소비자는 일상적인 집안일에서 "해방"되고 위장된 형태로 삶의 질이 향상됩니다. 이러한 열풍에 힘입어 시중에 나와 있는 거의 모든 가전제품 브랜드가 자체적으로 청소, 물걸레 로봇을 제작하고 있어 전체 청소, 물걸레 로봇 시장이 매우 활발해지고 있습니다. 그러나 시장의 급속한 확장은 필연적으로 숨겨진 위험을 가져올 것입니다. 많은 제조업체가 더 많은 시장 점유율을 빠르게 점유하기 위해 바다의 전술을 사용할 것이며 결과적으로 업그레이드 포인트 없이 많은 신제품이 나올 것이라고도 합니다. '마트료시카' 모델이라고 해도 과언이 아닙니다. 그러나 모든 청소 및 걸레질 로봇이 그런 것은 아닙니다.