Tesla 슈퍼컴퓨팅 칩이 GPGPU를 능가할 수 있을까요?

저자: Chen Wei 박사, 스토리지 및 컴퓨팅/GPU 아키텍처 및 AI 전문가, 수석 전문직. 중관촌 클라우드 컴퓨팅 산업 연합, 중국 광학 공학 협회 전문가, 국제 컴퓨터 연맹(ACM) 회원, 중국 컴퓨터 연맹(CCF) 전문 회원. 그는 한때 AI 회사의 수석 과학자이자 주요 메모리 칩 제조업체의 3D NAND 설계 책임자를 역임했습니다. 그의 주요 업적에는 국내 최초의 고전력 재구성 가능한 스토리지 및 컴퓨팅 프로세서 제품 아키텍처(프로토타입 내부 테스트 완료)가 포함됩니다. 주요 인터넷 제조업체), 최초의 의료용 도메인별 AI 프로세서(이미 적용), 최초의 RISC-V/x86/ARM 플랫폼 호환 AI 가속 컴파일러(이미 Alibaba Pingtouge/Xinlai와 협력하여 적용), 중국 최초의 3D NAND 칩 아키텍처 및 디자인 팀이 설립되었고(삼성 벤치마킹) 중국 최초의 임베디드 플래시 메모리 컴파일러(TSMC 벤치마킹 및 플랫폼 수준에 적용됨)가 탄생했습니다.

2022년 9월 마지막 날, 테슬라의 인공지능의 날, 테슬라의 '옵티머스 프라임' 로봇이 공식 데뷔했습니다. Tesla 엔지니어에 따르면 2022년 인공지능의 날은 Tesla 로봇이 외부 지원 없이 '출시'된 첫 번째 사례입니다. "라며 늠름하게 걸으며 관객들에게 일대일로 인사를 건넸다. 약간의 움직임이 둔한 점을 제외하고는 모든 것이 매우 자연스럽습니다.

1 테슬라 로봇의 힘은 '내부 코어'에 있다?

Tesla는 사무실 주변에서 로봇이 "일하는" 영상을 선보입니다. 옵티머스 프라임이라는 로봇은 물건을 나르고, 식물에 물을 주고, 한동안 공장에서 자율적으로 일하기도 했습니다. 테슬라는 "우리의 목표는 유용한 휴머노이드 로봇을 가능한 한 빨리 만드는 것"이라며 "로봇을 2만 달러 미만, 즉 테슬라의 전기차보다 저렴하게 만드는 것이 목표"라고 덧붙였다.

테슬라 로봇이 이렇게 강력한 이유는 테슬라 자체의 AI 기술 축적뿐만 아니라, 주로 테슬라가 자체 개발한 강력한 AI 칩 덕분입니다. 이 AI 칩은 GPU는 물론이고 전통적인 CPU도 아닌 복잡한 AI 계산에 더 적합한 형태다.

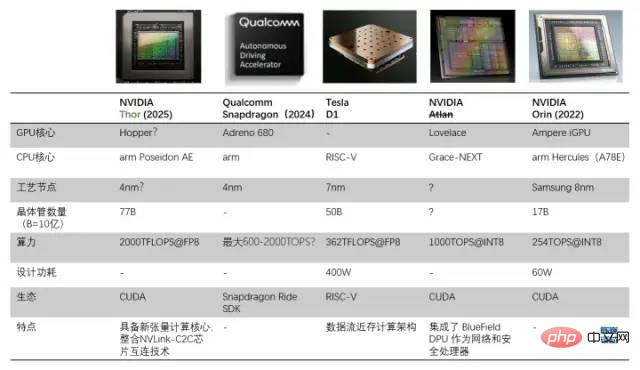

D1 프로세서와 기타 자율주행/로봇 프로세서 비교

1.1 데이터 흐름 니어 메모리 아키텍처를 기반으로 GPU를 능가하는 범용 AI 칩 제작

테슬라가 자체 제작 칩을 사용하는 이유는 GPU가 딥 러닝 훈련을 처리하도록 특별히 설계되지 않았기 때문에 컴퓨팅 작업에서 GPU가 상대적으로 비효율적이기 때문입니다. Tesla와 Dojo(Dojo는 훈련 모듈의 이름이자 커널 아키텍처의 이름입니다)의 목표는 "최고의 AI 훈련 성능을 달성하는 것입니다. 더 크고 복잡한 신경망 모델을 활성화하여 높은 에너지 효율성과 비용을 달성합니다." 효율성." 컴퓨팅." 테슬라의 기준은 미래에 GPU를 사용할 필요가 없도록 다른 어떤 컴퓨터보다 인공지능 컴퓨팅에 뛰어난 컴퓨터를 만드는 것입니다.

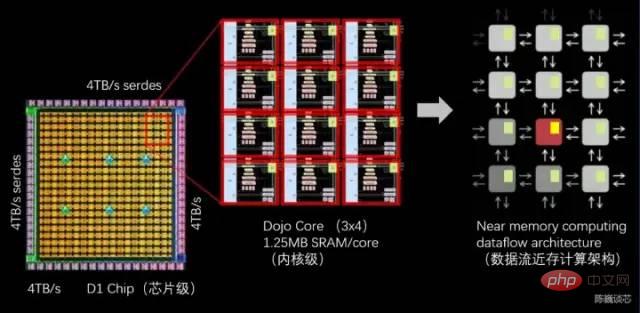

슈퍼컴퓨터 구축의 핵심은 높은 대역폭(어려움)과 낮은 대기 시간(매우 어려움)을 유지하면서 컴퓨팅 성능을 확장하는 방법입니다. Tesla가 제공하는 솔루션은 강력한 칩과 고유한 그리드 구조로 구성된 분산형 2D 아키텍처(평면) 또는 데이터 흐름 Near-Memory 컴퓨팅 아키텍처입니다.

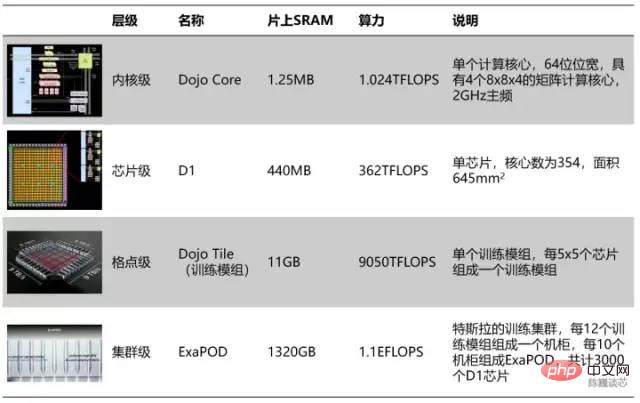

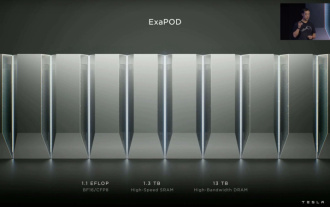

Tesla 컴퓨팅 장치의 계층적 구분

계층적 구분에 따르면 모든 354개의 Dojo 코어가 D1 칩을 형성하고 모든 25개의 칩이 훈련 모듈을 구성합니다. 최종 120개의 훈련 모듈은 총 3,000개의 D1 칩으로 구성된 ExaPOD 컴퓨팅 클러스터 세트를 구성합니다.

Tesla Dojo 칩 훈련 모듈은 6개 GPU 서버 그룹의 성능을 달성할 수 있지만 비용은 단일 GPU 서버 그룹보다 저렴합니다. 단일 Dojo 서버의 컴퓨팅 성능은 54PFLOPS에 달했습니다. 단 4개의 Dojo 캐비닛으로 4,000개의 GPU로 구성된 72개의 GPU 랙을 대체할 수 있습니다. Dojo는 일반적으로 몇 달이 걸리는 AI 컴퓨팅(훈련) 작업을 1주일로 줄여줍니다. 이런 '큰 컴퓨팅 파워가 기적을 낳을 수 있다'는 것은 테슬라의 자율주행 스타일과 일맥상통한다. 분명히 이 칩은 Tesla의 AI 기술 발전을 크게 가속화할 것입니다.

물론 이 칩 모듈은 아직 "완벽한" 수준에 도달하지 못했습니다. 데이터 흐름 근거리 컴퓨팅이라는 아이디어를 채택했지만 컴퓨팅 성능과 에너지 효율성 비율은 이를 초과하지 않습니다. GPU. 단일 서버는 전류가 2000A에 달할 정도로 막대한 전력을 소비하므로 특별히 맞춤화된 전원 공급 장치가 필요합니다. Tesla D1 칩은 이미 니어 메모리 컴퓨팅 아키텍처의 구조적 한계입니다. Tesla가 "인 메모리 컴퓨팅" 또는 "인 메모리 로직" 아키텍처를 채택한다면 아마도 칩 성능이나 에너지 효율성 비율이 크게 향상될 것입니다.

Tesla Dojo 칩 서버는 12개의 Dojo 교육 모듈(2개 레이어, 레이어당 6개)로 구성됩니다.

1.2 Tesla의 Dojo 아키텍처 설계 철학

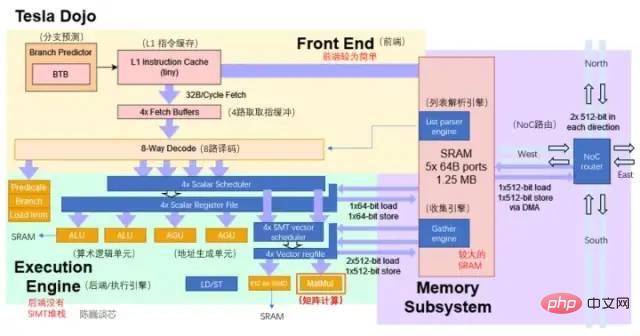

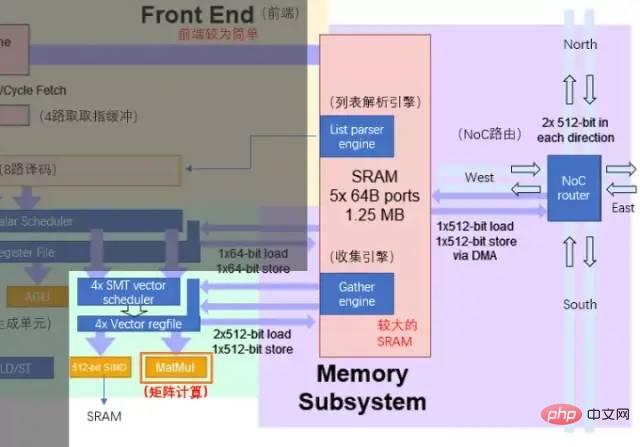

Dojo 코어는 높은 처리량과 4개의 디코딩 코어를 갖춘 8개의 디코딩 코어입니다. 웨이 매트릭스 컴퓨팅 장치(8x8) 및 1.25MB의 로컬 SRAM. 그러나 Dojo 코어의 크기는 크지 않습니다. 이에 비해 Fujitsu의 A64FX는 동일한 프로세스 노드에서 두 배 이상의 영역을 차지합니다.

Dojo 코어의 구조를 통해 일반 AI 프로세서에 대한 Tesla의 설계 철학을 볼 수 있습니다.

- 면적 감소: Tesla는 다수의 컴퓨팅 코어를 칩에 통합하여 AI의 처리량을 최대화합니다. 컴퓨팅을 위해서는 컴퓨팅 파워를 보장하면서 단일 코어의 면적을 가능한 작게 만들고, 슈퍼컴퓨팅 시스템의 컴퓨팅 파워 스태킹과 지연 사이의 모순을 더 잘 절충하는 것이 필요합니다.

- 캐싱 및 대기 시간 합리화: 영역 컴퓨팅 효율성을 최대화하기 위해 Dojo 커널은 기본 분기 예측기와 작은 명령 캐싱만 사용하여 상대적으로 보수적인 2GHz(보수적인 클록 회로는 더 적은 영역을 차지하는 경향이 있음)에서 실행됩니다. 필요한 구성 요소만 유지하는 간소화된 아키텍처입니다. 나머지 영역은 벡터 계산 및 행렬 계산 장치에 최대한 남겨 둡니다. 물론 커널 프로그램의 코드 공간이 크거나 분기가 많은 경우 이 전략으로 인해 성능이 일부 저하될 수 있습니다.

- 기능 간소화: 내부 계산을 실행하는 데 필요하지 않은 프로세서 기능을 제거하여 전력 및 면적 사용량을 더욱 줄입니다. Dojo 코어는 데이터측 캐싱을 수행하지 않고 가상 메모리를 지원하지 않으며 정확한 예외를 지원하지 않습니다.

Tesla와 Musk에게 Dojo는 도장처럼 모양과 배치가 다를 뿐만 아니라 도장의 정신과도 밀접한 관련이 있는 디자인 철학으로 "적을수록 좋다"라는 프로세서 디자인 미학을 완벽하게 구현합니다.

2 D1 코어는 RISC-V 아키텍처인가요?

먼저 각 도장의 구조와 특징을 살펴보겠습니다.

각 Dojo 코어는 벡터 계산/행렬 계산 기능을 갖춘 프로세서이며 완전한 명령 가져오기, 디코딩 및 실행 구성 요소를 갖추고 있습니다. Dojo 코어는 GPU보다 다양한 알고리즘과 분기 코드에 더 잘 적응할 수 있는 CPU와 유사한 스타일을 가지고 있습니다. D1의 명령어 세트는 RISC-V와 유사합니다. 프로세서는 2GHz에서 실행되며 4개의 8x8 행렬 곱셈 계산 장치 세트가 있습니다. 또한 AI 계산 가속화에 초점을 맞춘 사용자 정의 벡터 지침 세트도 있습니다.

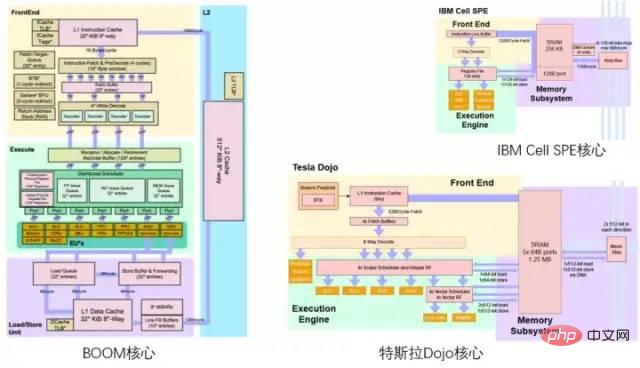

RISC-V 분야에 익숙한 사람들은 아마도 Tesla의 Dojo 아키텍처 다이어그램의 색 구성표가 Berkeley의 BOOM 프로세서 아키텍처 다이어그램에 경의를 표하는 것처럼 보인다는 것을 알 수 있을 것입니다. 상단은 노란색, 하단은 녹색, 하단은 보라색입니다. 바닥. Tesla Dojo Core와 Berkeley Boom/IBM Cell Core

2.1 D1 Core 전체 아키텍처 핵심 구조 (파란색 부품이 추가/수정 됨) 세부 사항 간의 비교. )

Dojo의 핵심 구조는 BOOM보다 더 간소화되어 실행 구성 요소의 활용도를 높이기 위한 Rename과 같은 구성 요소가 없으며 가상 메모리 지원도 어렵습니다. 그러나 이 설계의 장점은 제어부가 차지하는 면적을 줄이고, 칩 상의 계산 실행부에 더 많은 영역을 할당할 수 있다는 점이다. 각 Dojo 코어는 1.024TFLOPS의 컴퓨팅 성능을 제공합니다. 각각의 거의 모든 컴퓨팅 성능이 매트릭스 컴퓨팅 장치에 의해 제공된다는 것을 알 수 있습니다. 따라서 매트릭스 컴퓨팅 유닛과 SRAM은 D1 프로세서의 컴퓨팅 에너지 효율 비율을 공동으로 결정합니다.

Dojo 코어의 주요 매개변수

Dojo 코어의 주요 매개변수

BTB는 성공한 분기 명령어의 주소와 분기 대상 주소를 버퍼에 저장합니다. 버퍼는 분기 명령어의 주소로 식별됩니다. 파이프라인 프로세서에서 분기의 성능 저하는 분기 경로를 예측하고 분기에서 사용하는 정보를 캐싱하여 줄일 수 있습니다.

일반 CPU가 다양한 작업을 수행할 때 메모리(또는 SRAM)에서 데이터를 가져오는 데 필요한 메모리 주소를 계산해야 합니다. 예를 들어, CPU 코어가 실제 메모리 위치에서 데이터를 가져오기 전에 배열 요소의 메모리 위치를 계산해야 합니다. 이러한 주소 생성 계산에는 덧셈, 뺄셈, 모듈로 산술 또는 비트 이동과 같은 다양한 정수 산술 연산이 포함됩니다. 메모리 주소 계산은 여러 일반 기계 명령어를 컴파일하거나 Tesla Dojo와 같은 AGU 하드웨어 회로를 통해 직접 실행할 수 있습니다. 이러한 방식으로 다양한 주소 생성 계산을 ALU에서 오프로드하여 AI 계산을 수행하는 데 필요한 CPU 사이클 수를 줄여 컴퓨팅 성능을 향상시킬 수 있습니다.

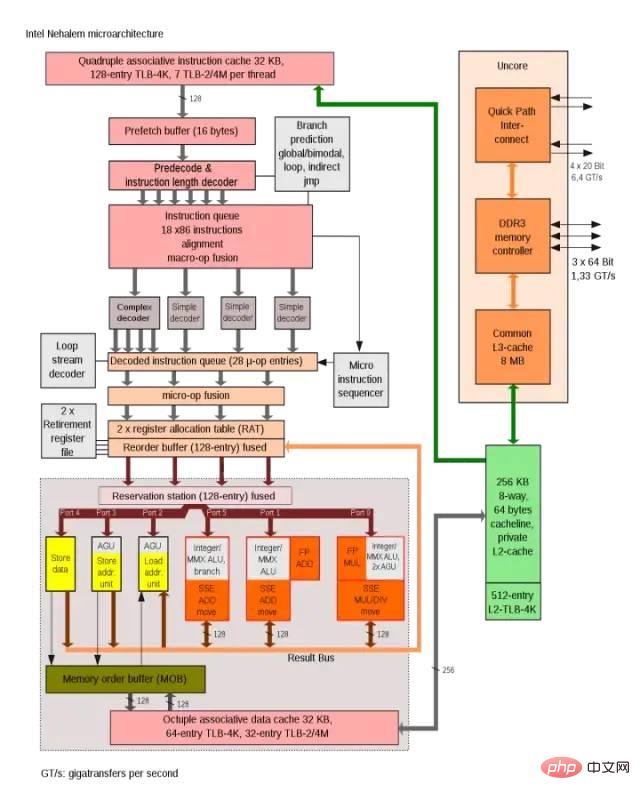

Intel Nehalem 아키텍처는 AGU를 사용하여 단일 주기 주소 액세스 효율성을 향상합니다.

Dojo 코어의 연결 방법은 IBM Cell 프로세서의 SPE 코어 연결 방법과 더 유사합니다. 주요 유사점은 다음과 같습니다.

- D1이나 SPE에서 실행되는 코드는 모두 시스템 메모리에 직접 액세스할 수 없으며 애플리케이션은 주로 로컬 SRAM에서 작동합니다.

- 주 메모리(DDR 또는 HBM)의 데이터가 필요한 경우 DMA 작업은 다음과 같습니다. 읽는 데 사용됩니다. D1이나 Cell의 SPE는 가상 메모리를 지원하지 않습니다.

- 다음에서는 계산 및 행렬 곱셈 모듈과 커널의 저장을 소개합니다.

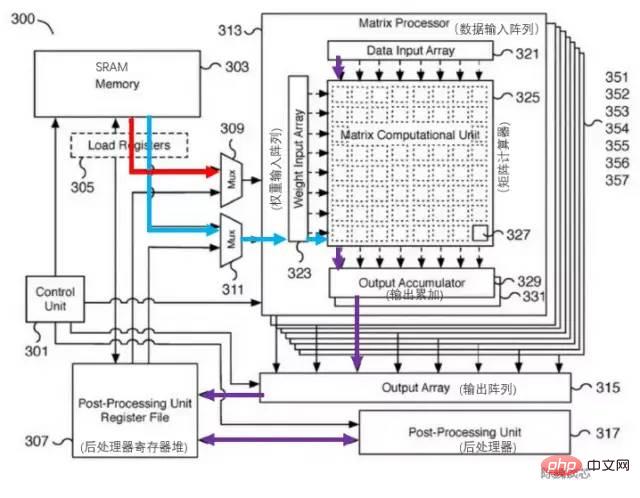

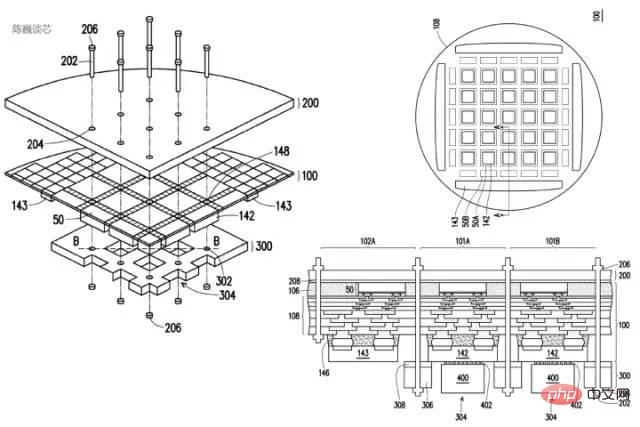

2.2 컴퓨팅 코어 매트릭스 컴퓨팅 장치 및 온칩 스토리지

Dojo 아키텍처의 컴퓨팅 성능 향상의 핵심은 매트릭스 컴퓨팅 장치입니다. 매트릭스 컴퓨팅 장치와 코어 SRAM 간의 데이터 상호 작용은 주요 코어 데이터 전송 전력 소비를 구성합니다.테슬라 매트릭스 컴퓨팅 유닛의 해당 특허는 아래와 같습니다. 이 모듈의 핵심 구성 요소는 8x8 행렬-행렬 곱셈 장치(그림에서는 행렬 계산기라고 함)입니다. 입력은 데이터 입력 배열이고, 가중치 입력 배열은 행렬 곱셈을 계산한 후 직접 누적됩니다. 각 Dojo 코어에는 4방향 8x8 행렬 곱셈 장치가 포함되어 있습니다.

테슬라 매트릭스 컴퓨팅 장치 특허

테슬라 매트릭스 컴퓨팅 장치 특허

아키텍처 다이어그램에는 L1 캐시와 SRAM이 하나만 있으므로 Tesla가 캐시 영역을 절약하고 대기 시간을 줄이기 위해 RISC-V 캐시 구조를 간소화했다는 것은 대담한 추측입니다. 코어당 1.25MB SRAM 블록은 SIMD 및 매트릭스 컴퓨팅 장치에 대한 2x512비트 읽기(AI 계산의 가중치 및 데이터에 해당) 및 512비트 쓰기 대역폭은 물론 정수에 대한 64비트 읽기 및 쓰기 기능을 제공할 수 있습니다. 등록 파일. 계산의 주요 데이터 흐름은 SRAM에서 SIMD 및 행렬 곱셈 장치로 이어집니다.

행렬 계산 장치의 주요 처리 흐름은 다음과 같습니다.

SRAM에서 멀티플렉서(Mux)를 통해 가중치 입력 배열(Weight 입력 배열)로 가중치를 로드하고, SRAM에서 데이터 입력 배열(데이터 입력)로 데이터를 로드합니다. 정렬).

입력 데이터와 가중치는 행렬 계산기(행렬 계산 장치)에서 곱해집니다(내적 또는 외부 곱?).

곱셈 계산 결과는 출력 누산기(Output 누산기)로 출력되어 누산됩니다. 여기서 계산할 때 8x8을 초과하는 행렬 계산은 행렬 분할 및 접합을 통해 수행할 수 있습니다.

누적된 출력은 캐시용 후처리기 레지스터 파일로 전달된 후 후처리됩니다(활성화, 풀링, 패딩 등의 작업 수행 가능).

전체 계산 과정은 CPU 개입 없이 컨트롤 유닛(Control Unit)에 의해 직접 제어됩니다.

실행 장치와 SRAM/NoC 간의 데이터 상호 작용

Dojo 코어 내의 SRAM은 읽기 및 쓰기 대역폭이 매우 크며 400GB/초로 로드하고 270GB/초로 로드할 수 있습니다. 쓰기 속도. Dojo 코어 명령어 세트에는 NoC를 통해 라우팅되는 전용 네트워크 전송 명령어가 있어 D1 칩 또는 Dojo 교육 모듈에 있는 다른 코어의 SRAM 메모리 안팎으로 데이터를 직접 이동할 수 있습니다.

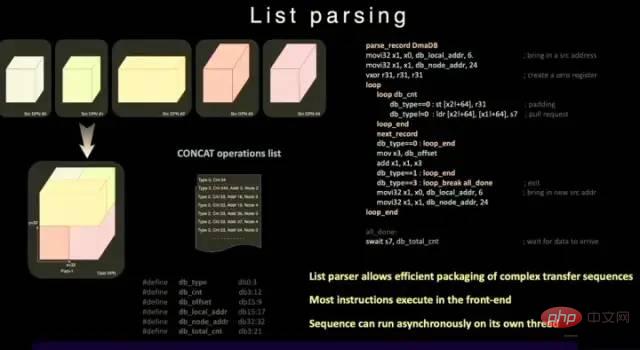

일반 SRAM과 달리 Dojo의 SRAM에는 목록 파서 엔진과 수집 엔진이 포함되어 있습니다. 목록 구문 분석 기능은 D1 칩의 주요 기능 중 하나입니다. 목록 구문 분석 엔진은 전송 효율성을 향상시키기 위해 다양한 데이터 유형의 복잡한 전송 시퀀스를 패키징할 수 있습니다.

리스트 파싱 기능

작업 지연, 면적, 복잡성을 더욱 줄이기 위해 D1은 가상 메모리를 지원하지 않습니다. 일반 프로세서에서는 프로그램이 사용하는 메모리 주소가 물리 메모리 주소에 직접 접근하지 않고, 운영체제가 설정한 페이징 구조를 이용해 CPU에서 물리 주소로 변환된다.

D1 코어에서 4방향 SMT 기능은 계산에서 명시적인 병렬 처리를 허용하여 AGU를 단순화하고 Tesla가 충분히 짧은 지연 시간으로 SRAM에 액세스할 수 있도록 하는 계산 방법을 처리합니다. 장점은 중간 L1 데이터 캐싱을 피할 수 있다는 것입니다. 지연 시간.

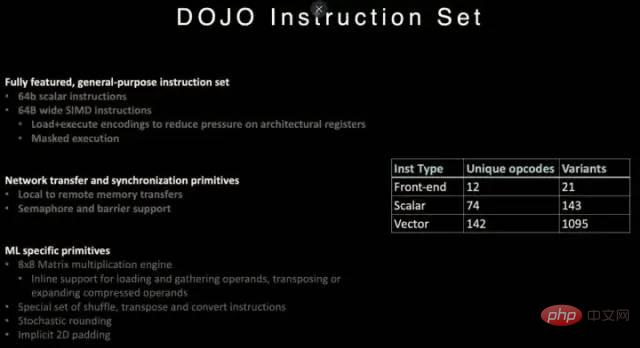

2.3 Dojo 명령어 세트

D1 프로세서 명령어 세트

D1은 RISC-V 아키텍처의 명령어를 참조하고 일부 명령어, 특히 벡터 계산과 관련된 명령어를 사용자 정의합니다.

D1 명령어 세트는 64비트 스칼라 명령어 및 64바이트 SIMD 명령어, 동기화 프리미티브를 사용한 네트워크 전송 및 기계 학습/딥 러닝(예: 8x8 행렬 계산)과 관련된 특수 프리미티브를 지원합니다.

네트워크 데이터 전송 및 동기화 프리미티브 측면에서 로컬 스토리지(SRAM)에서 원격 스토리지로 데이터를 전송하기 위한 명령어 프리미티브(Primitives)는 물론 세마포어(Semaphore) 및 장벽 제약 조건(Barrier Constraints)을 지원합니다. 이를 통해 D1은 멀티스레딩을 지원할 수 있으며 메모리 작업 명령은 여러 D1 코어에서 실행될 수 있습니다.

기계 학습 및 딥 러닝을 위해 Tesla는 셔플, 전치, 변환과 같은 수학적 연산은 물론 확률론적 반올림 및 패딩 관련 지침을 포함한 지침을 정의합니다.

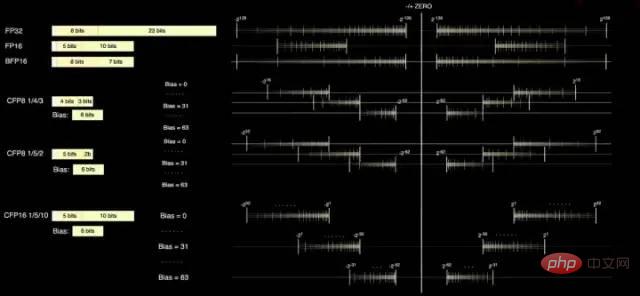

2.4 데이터 형식

D1 코어에는 FP32와 FP16이라는 두 가지 표준 계산 형식이 있으며 추론에 더 적합한 BFP16 형식도 있습니다. 혼합 정밀도 컴퓨팅의 성능 향상을 달성하기 위해 D1은 낮은 정밀도와 높은 처리량을 위해 8비트 CFP8 형식도 사용합니다.

CFP8을 사용하면 더 많은 승수 공간을 절약하여 거의 동일한 컴퓨팅 성능을 얻을 수 있다는 점은 D1의 컴퓨팅 성능 밀도를 높이는 데 매우 유용합니다.

Dojo 컴파일러는 가수 정밀도를 슬라이드하여 더 넓은 범위와 정밀도를 포괄할 수 있습니다. 언제든지 최대 16개의 서로 다른 벡터 형식을 사용할 수 있어 컴퓨팅 성능을 높일 수 있는 유연성을 제공합니다.

D1 프로세서 데이터 형식

Tesla에서 제공한 정보에 따르면 CFP8은 행렬 곱셈 장치(CFP16 형식으로 저장됨) 내부 계산에 사용할 수 있습니다.

3 Dojo 아키텍처 프로세서가 GPU를 능가할 수 있습니까?

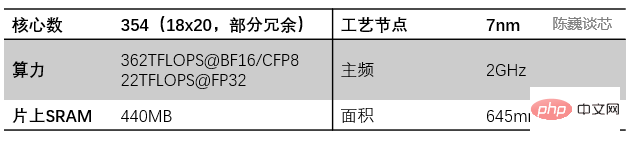

D1 프로세서는 TSMC에서 제조하며 7나노미터 제조 공정을 사용합니다. 500억 개의 트랜지스터와 645mm²의 칩 면적을 갖추고 있으며 이는 NVIDIA의 A100(826mm²) 및 AMD Arcturus(750mm²)보다 작습니다. .

3.1 Dojo 데이터 흐름 메모리 기반 컴퓨팅 아키텍처

D1 프로세서 구조

각 D1 프로세서는 18 x 20 Dojo 코어 스플라이싱으로 구성됩니다. 각 D1 프로세서에는 354개의 Dojo 코어가 있습니다. (360개의 코어 중 354개만 사용하는 이유는 수율 및 프로세서별 코어 안정성을 고려한 것입니다.) TSMC에서 7nm 제조 공정을 사용하여 500억 개의 트랜지스터와 645mm²의 칩 면적으로 제조됩니다.

각 Dojo 코어에는 기본 무게와 데이터 저장 장치로 1.25MB SRAM이 있습니다. 서로 다른 Dojo 코어는 온칩 네트워크 라우팅(NoC 라우팅)을 통해 연결되며, 서로 다른 Dojo 코어는 데이터 캐시를 공유하는 대신 복잡한 NoC 네트워크를 통해 데이터 동기화를 수행합니다. NoC는 각 방향에서 클록 주기당 64B로 노드 경계를 가로질러 4개 방향(남동쪽, 북서쪽)으로 8개의 패킷을 처리할 수 있습니다. 즉, 인접한 각 Dojo 코어의 네 방향 모두에서 메시로 들어오는 패킷 하나와 나가는 패킷 하나입니다. NoC 라우터는 또한 사이클당 한 번씩 코어 내의 SRAM에 64B 양방향 읽기 및 쓰기를 수행할 수 있습니다.

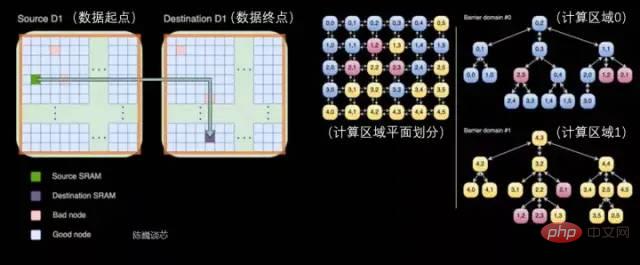

D1 프로세서 내의 교차 프로세서 전송 및 작업 분할

각 Dojo 코어는 매트릭스 컴퓨팅 기능을 갖춘 비교적 완전한 CPU와 유사한 클래스입니다(각 코어에는 별도의 매트릭스 컴퓨팅 장치가 있으므로) , 프론트엔드가 비교적 작기 때문에 여기서는 CPU와 유사하다고 합니다.) 데이터 흐름 아키텍처는 SambaNova의 2차원 데이터 흐름 그리드 구조와 다소 유사하며, 데이터는 메모리로 돌아가지 않고 직접 흐릅니다.

D1 칩은 2GHz에서 실행되며 440MB의 거대한 SRAM을 갖추고 있습니다. Tesla는 컴퓨팅 그리드의 분산 SRAM에 설계를 집중하여 더 빠르고 더 가까운 다수의 온칩 스토리지와 온칩 스토리지 간의 전송을 통해 메모리에 대한 액세스 빈도를 줄여 전체 시스템의 성능을 향상시킵니다. 데이터 흐름 저장 및 컴퓨팅 통합 아키텍처(데이터 흐름 근접 메모리 컴퓨팅)의 분명한 특징을 가지고 있습니다.

각 D1 칩에는 576개의 양방향 SerDes 채널이 분산되어 있으며 4TB/초의 단일 측 대역폭으로 다른 D1 칩에 연결할 수 있습니다.

D1 프로세서 칩의 주요 매개변수

3.2 Dojo 훈련 모듈의 칩렛 패키징 상호 연결 기술

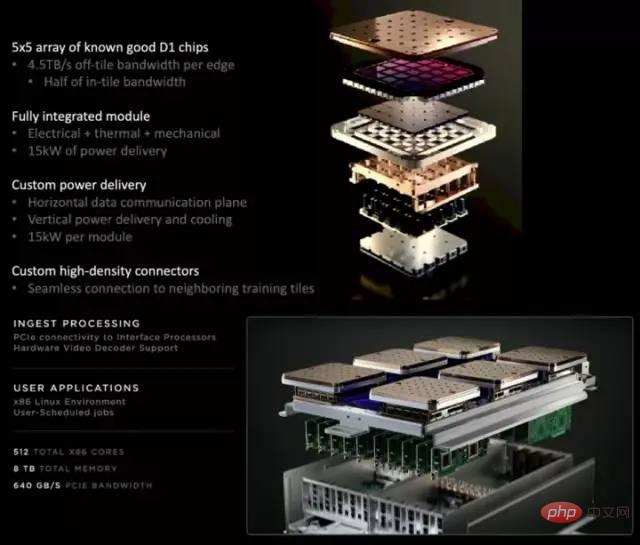

각 D1 훈련 모듈은 5x5 D1 칩 배열로 배열됩니다. 차원 메쉬 구조. 온칩 크로스 코어 SRAM은 무려 11GB에 달하고, 전력 소모도 무려 15kW에 달합니다. 에너지 효율 비율은 0.6TFLOPS/W@BF16/CFP8입니다. (제가 잘못 계산했으면 좋겠습니다. 그렇지 않으면 이 에너지 효율 비율은 실제로 이상적이지 않습니다.) 외부 32GB 공유 HBM 메모리. (HBM2e 또는 HBM3)

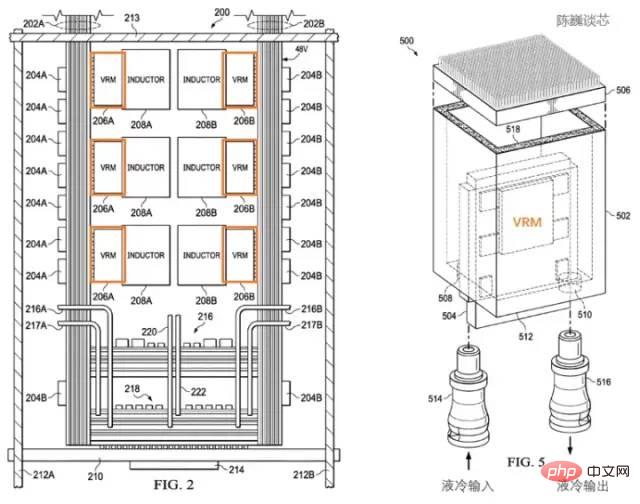

테슬라 D1 프로세서의 특허받은 방열 구조

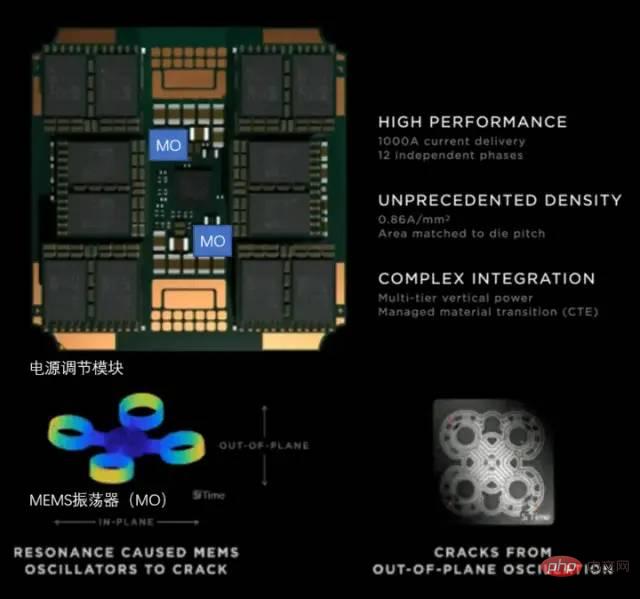

Tesla는 전용 전력 조절 모듈(VRM)과 방열 구조를 사용하여 전력 소비를 관리합니다. 여기에는 전력 소비 관리의 두 가지 주요 목적이 있습니다.

불필요한 전력 손실을 줄이고 에너지 효율을 향상시킵니다.

열 변형으로 인한 프로세서 모듈 고장을 줄입니다.

Tesla의 특허에 따르면 전력 조절 모듈이 칩 자체에 수직임을 알 수 있습니다. 이는 프로세서 평면이 차지하는 면적을 크게 줄이고 액체 냉각을 통해 프로세서 온도의 균형을 빠르게 맞출 수 있습니다.

Tesla D1 프로세서의 특허받은 방열 및 패키징 구조

트레이닝 모듈은 InFO_SoW(Silicon on Wafer) 패키징을 사용하여 칩 간의 상호 연결 밀도를 높입니다. 이 패키지는 TSMC의 INFO_SoW 기술 외에도 Tesla의 자체 기계 패키징 구조를 사용하여 프로세서 모듈의 오류를 줄입니다.

각 교육 모듈의 외부 가장자리에 있는 40개의 I/O 칩은 36TB/s의 총 대역폭 또는 10TB/s의 스팬 대역폭을 달성합니다. 교육 모듈의 각 레이어는 초고속 스토리지 시스템에 연결됩니다. 640GB의 실행 메모리는 18TB/s 이상의 대역폭과 1TB/s 이상의 네트워크 스위칭 대역폭을 제공할 수 있습니다.

데이터 전송 방향은 칩 평면과 평행하고, 전원 공급 장치와 액체 냉각 방향은 칩 평면과 수직입니다. 이것은 매우 아름다운 구조 설계이며 다양한 교육 모듈을 상호 연결할 수 있습니다. 3차원 구조를 통해 칩 모듈의 전원 공급 면적을 절약하고 컴퓨팅 칩 간의 거리를 최대한 줄인다.

A Dojo POD 캐비닛은 2개 층의 컴퓨팅 트레이와 보관 시스템으로 구성됩니다. 각 팔레트 레벨에는 6개의 D1 교육 모듈이 있습니다. 2층에 걸쳐 12개의 교육 모듈로 구성된 캐비닛은 108PFLOPS의 딥 러닝 컴퓨팅 성능을 제공할 수 있습니다.

Dojo 모듈 및 Dojo POD 캐비닛

3.3 전원 관리 및 열 방출 제어

슈퍼컴퓨팅 플랫폼의 열 방출은 항상 슈퍼컴퓨팅 시스템의 수준을 측정하는 중요한 차원이었습니다.

D1 칩의 열 설계 능력

Tesla는 Dojo POD에서 완전히 자체 개발한 VRM(전압 조절 모듈)을 사용합니다. 단일 VRM은 52V 전압과 1000A를 초과하는 엄청난 전류를 제공할 수 있으며 현재 목표는 0.86입니다. 총 12개의 독립적인 전원 공급 장치 위상을 갖춘 평방 밀리미터당 A입니다.

Tesla의 전력 조절 모듈

고밀도 칩 방열을 위해 열팽창 계수(CTE) 제어에 중점을 둡니다. Dojo 시스템의 칩 밀도는 매우 높으며 CTE가 약간 통제되지 않으면 구조적 변형/고장을 유발하여 연결 오류가 발생할 수 있습니다.

Tesla가 자체 개발한 VRM은 MEMS 발진기(MO)를 사용하여 전력 조절 모듈의 열 변형을 감지하여 지난 2년 동안 14개 버전을 반복했으며 마침내 CTE 표시기에 대한 내부 요구 사항을 완전히 충족했습니다. MEMS 기술을 통해 전원을 능동적으로 조절하는 방식은 로켓 본체의 진동을 제어하는 능동적인 조절 방식과 유사하다.

3.4 Dojo 아키텍처 프로세서의 컴파일 생태학

D1 프로세서 소프트웨어 스택

D1과 같은 AI 칩의 경우 컴파일 생태학은 칩 자체만큼 중요합니다.

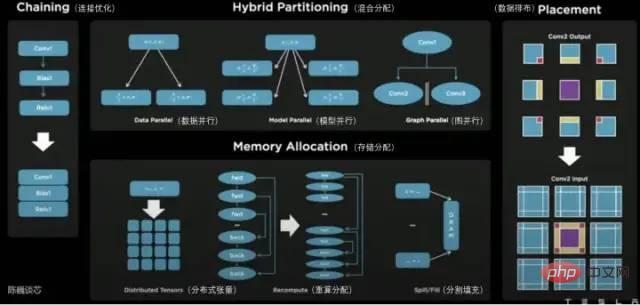

D1 프로세서 플레인에서 D1은 매트릭스 컴퓨팅 장치로 구분됩니다. 컴파일 도구 체인은 작업 분할 및 데이터 저장소 구성을 담당하며 저장소 사용량을 줄이기 위해 다양한 방법으로 세분화된 병렬 컴퓨팅을 수행합니다.

Dojo 컴파일러가 지원하는 병렬 방법에는 데이터 병렬성, 모델 병렬성 및 그래프 병렬성이 포함됩니다. 지원되는 스토리지 할당 방법에는 분산 텐서, 다시 계산된 할당 및 분할 채우기가 포함됩니다.

컴파일러 자체는 루프 및 그래프 최적화 알고리즘을 포함하여 다양한 CPU에서 일반적으로 사용되는 동적 제어 흐름을 처리할 수 있습니다. Dojo 컴파일러를 사용하면 사용자는 Dojo 대규모 분산 시스템을 전체 설계 및 교육을 위한 가속기로 사용할 수 있습니다.

전체 소프트웨어 생태계의 최상위 레이어는 PyTorch를 기반으로 하고, 맨 아래 레이어는 Dojo 드라이버를 기반으로 하며, 중간에 Dojo 컴파일러와 LLVM을 사용하여 컴파일 레이어를 구성합니다. 여기에 LLVM을 추가한 후 Tesla는 컴파일 최적화를 위해 이미 LLVM에 있는 다양한 컴파일 생태계를 더 잘 활용할 수 있습니다.

Tesla Dojo Compiler

4 결론

Tesla AI Day를 통해 우리는 Tesla 로봇의 진정한 본체와 그 강력한 "내부 코어"를 더 많은 인식과 함께 보았습니다.

Tesla의 Dojo 코어는 이전 CPU 및 GPU 아키텍처와 다릅니다. CPU의 특성을 결합한 유선형 GPU라고 할 수 있습니다. 그 컴파일도 CPU 및 GPU와 상당히 다를 것이라고 믿습니다. 컴퓨팅 밀도를 높이기 위해 Tesla는 매우 간소화된 최적화를 수행하고 적극적으로 조정된 전원 관리 메커니즘을 제공했습니다.

Tesla Dojo 아키텍처는 도장이라고 불릴 뿐만 아니라 그 디자인은 실제로 단순함과 덜함을 기반으로 합니다. 이 아키텍처는 CPU, GPU 다음으로 또 다른 전형적인 형태의 컴퓨팅 칩 아키텍처가 될까요? 기다려 보자.

위 내용은 Tesla 슈퍼컴퓨팅 칩이 GPGPU를 능가할 수 있을까요?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7467

7467

15

15

1376

1376

52

52

77

77

11

11

45

45

19

19

18

18

19

19

Tesla Dojo 슈퍼컴퓨팅 데뷔, Musk: 연말까지 AI 훈련을 위한 컴퓨팅 성능은 대략 NVIDIA H100 GPU 8,000대와 동일할 것입니다

Jul 24, 2024 am 10:38 AM

Tesla Dojo 슈퍼컴퓨팅 데뷔, Musk: 연말까지 AI 훈련을 위한 컴퓨팅 성능은 대략 NVIDIA H100 GPU 8,000대와 동일할 것입니다

Jul 24, 2024 am 10:38 AM

7월 24일 본 홈페이지 소식에 따르면, 테슬라 CEO 엘론 머스크(Elon Musk)는 오늘 실적 컨퍼런스콜에서 회사가 엔비디아 H100 2천대를 탑재할 역대 최대 규모의 인공지능 훈련 클러스터를 곧 완성할 예정이라고 밝혔다. GPU. 머스크는 또한 회사 수익 결산에서 투자자들에게 Nvidia의 GPU가 비싸기 때문에 Tesla가 Dojo 슈퍼컴퓨터 개발에 참여할 것이라고 말했습니다. 이 사이트는 Musk의 연설 일부를 다음과 같이 번역했습니다. Dojo를 통해 NVIDIA와 경쟁하는 길은 어렵지만 이제 우리는 NVIDIA에 과도하게 의존하고 있다고 생각합니다. 엔비디아 입장에서는 필연적으로 시장이 감당할 수 있는 수준까지 GPU 가격을 인상하겠지만,

Tesla가 마침내 조치를 취했습니다! 자율주행 택시 곧 공개될까? !

Apr 08, 2024 pm 05:49 PM

Tesla가 마침내 조치를 취했습니다! 자율주행 택시 곧 공개될까? !

Apr 08, 2024 pm 05:49 PM

4월 8일 뉴스에 따르면, 일론 머스크 테슬라 최고경영자(CEO)는 최근 테슬라가 자율주행차 기술을 본격적으로 개발하기 위해 노력하고 있다고 밝혔다. 많은 기대를 모으고 있는 무인 자율주행택시 로보택시가 8월 8일 정식 출시될 예정이다. 데이터 편집자는 머스크의 다음과 같은 진술을 알게 되었습니다. 앞서 로이터통신은 테슬라의 자동차 운전 계획이 로보택시 생산에 집중할 것이라고 보도한 바 있다. 그러나 머스크는 이를 반박하면서 로이터가 저가차 개발 계획을 취소하고 또다시 허위 보도를 했다고 비난하면서 저가차 모델2와 로보택스가

도전하기 위해 절벽 위로 솟아오르는 테슬라 사이버트럭, 한계를 뛰어넘는 파워쇼!

Mar 07, 2024 pm 09:28 PM

도전하기 위해 절벽 위로 솟아오르는 테슬라 사이버트럭, 한계를 뛰어넘는 파워쇼!

Mar 07, 2024 pm 09:28 PM

3월 7일 뉴스에 따르면 최근 미국 유타주의 작은 마을에서 '지옥의 복수로 가는 길'에 도전하는 테슬라 사이버트럭의 영상이 인터넷에 공개됐다. 클리프는 미국 유타주 솔트레이크시티에 위치해 있으며, 아웃도어 매니아들에게 인기 있는 곳이다. 여기에는 30개 이상의 오프로드 도로가 있으며, 울퉁불퉁하고 가파른 암벽은 많은 극한의 오프로드 애호가들이 도전하도록 유혹합니다. 영상에는 테슬라 사이버트럭이 45도에 가까운 V자형 계곡에 도전했을 때 3개의 모터의 강력한 힘을 이용해 꾸준히 오르며 마침내 정상에 오르는 모습이 담겨 있다. 오르막길에서 사이버트럭은 미끄러운 바위 표면에도 불구하고 미끄러짐 없이 잘 작동했습니다. 편집자의 이해에 따르면 Tesla Cybertruck 모델은 단일 모터 후면으로 구분됩니다.

테슬라의 신형 모델3 고성능 버전이 한국 인증을 통과, 전력 파라미터가 노출돼 눈길을 끌었다.

Mar 06, 2024 pm 08:49 PM

테슬라의 신형 모델3 고성능 버전이 한국 인증을 통과, 전력 파라미터가 노출돼 눈길을 끌었다.

Mar 06, 2024 pm 08:49 PM

3월 6일 뉴스에 따르면 최근 언론에서는 테슬라의 신형 모델3 고성능 버전이 한국 관련 인증을 통과했다고 밝히며 눈길을 끄는 출력 매개변수를 잇달아 공개했다. 이 신차에는 전면에 장착된 3D3 유도 비동기 모터와 후면에 장착된 4D2 영구자석 동기 모터 등 첨단 듀얼 모터 시스템이 탑재돼 놀라운 출력을 낼 것으로 알려졌다. 구체적으로 프론트 모터는 215마력, 리어 모터는 최대 412마력을 제공하여 차량의 총 출력은 무려 461kW에 이릅니다. 후면 4D2 모터만으로도 약 303kW의 출력을 낸다. 이 신형 자동차의 모터 설계는 속도가 110km/h에 도달할 때 최고 출력에 도달할 수 있어 고속 주행 시 신형 Model 3의 성능이 더 좋아집니다.

Tesla의 FSD 기술이 독일을 놀라게 하고 미래에는 자율주행이 유망합니다

Apr 29, 2024 pm 01:20 PM

Tesla의 FSD 기술이 독일을 놀라게 하고 미래에는 자율주행이 유망합니다

Apr 29, 2024 pm 01:20 PM

4월 29일 뉴스에 따르면, 테슬라는 최근 많은 기대를 모았던 완전 자율주행 FSD 기술을 독일에서 처음으로 공개 시연하며, FSD 기술이 유럽 시장에 공식 진출했음을 알렸습니다. 시연 행사에서 스웨덴 교통부의 수석 고문인 Rikard Fredriksson이 이를 경험할 기회를 가졌습니다. 그는 테슬라 모델Y를 타고 FSD(완전자율주행)의 편리함을 직접 경험했다. 독일 도로에서의 성능. Fredriksson은 Apple의 자동차 프로젝트에서 제품 안전 관련 직책을 맡았으며 자율 주행 기술에 대해 깊이 이해하고 있습니다. Fredriksson의 운전 보조 시스템을 경험한 후 FSD+12의 운전은 부드럽고 자연스럽습니다. 그는 또한 뮌헨 도심에서 공항으로 이동할 때 다음과 같이 구체적으로 언급했습니다.

Tesla Cybertruck 양산은 긍정적인 신호를 보이고, 텍사스 공장의 항공사진은 대규모 생산 상황을 보여줍니다

Mar 15, 2024 pm 12:04 PM

Tesla Cybertruck 양산은 긍정적인 신호를 보이고, 텍사스 공장의 항공사진은 대규모 생산 상황을 보여줍니다

Mar 15, 2024 pm 12:04 PM

테슬라의 최신 순수 전기 픽업트럭 사이버트럭(Cybertruck)의 생산 진행 상황이 많은 관심을 받고 있다. Tesla는 눈에 띄지 않지만 최근 Jeff Roberts라는 Tesla 관찰자가 촬영한 텍사스 기가팩토리의 항공 영상은 사이버트럭 생산의 긍정적인 신호를 외부 세계에 드러내는 것으로 보입니다. 영상에 따르면 텍사스주 테슬라 기가팩토리에는 이미 300대 이상의 사이버트럭이 다양한 지역에 분산돼 있다. 이번에 나온 숫자는 지금까지 공장에서 발견된 사이버트럭 중 가장 많은 숫자로, 해당 모델의 양산이 급속도로 발전하고 있음을 보여준다. 이는 테슬라가 사이버트럭 생산에 상당한 진전을 이뤘음을 보여준다. Tesla는 이전에 Cybertr에 대한 우려를 표명했지만

Tesla의 2024년 1분기 재무 보고서 발표: 매출 감소, 저가형 모델 생산이 의제

Apr 24, 2024 pm 06:16 PM

Tesla의 2024년 1분기 재무 보고서 발표: 매출 감소, 저가형 모델 생산이 의제

Apr 24, 2024 pm 06:16 PM

4월 24일 뉴스에 따르면, 테슬라는 오늘 2024년 1분기 재무보고서를 공개했다. 보고서에 따르면 Tesla는 해당 분기 동안 전년 동기 대비 9% 감소한 213억 1천만 달러의 매출을 달성한 것으로 나타났습니다. 이 수치는 시장 분석가들이 예측한 223억 달러보다 약간 낮았습니다. 동시에 회사의 순이익은 11억 2900만 달러로 전년 동기 대비 55% 급감했습니다. Tesla는 자동차 판매에서 큰 성공을 거두었습니다. 1분기에는 전 세계적으로 386,800대의 차량이 인도되었으며, 이는 시장의 이전 예상인 약 430,000대보다 훨씬 낮은 수치입니다. 지난해 같은 기간과 비교하면 배송량이 8.3% 줄었고, 전분기와 비교해도 20.1% 급감했다. 이는 테슬라가 2020년 이후 처음으로 전년 동기 대비 납품 감소를 기록한 것이다. 속도를 늦추려면

Tesla의 상하이 에너지 저장 기가팩토리(Shanghai Energy Storage Gigafactory)는 연내 시험 가동에 들어갈 예정이며, 예상 에너지 저장 규모는 거의 40GWh에 이릅니다.

Mar 22, 2024 pm 12:32 PM

Tesla의 상하이 에너지 저장 기가팩토리(Shanghai Energy Storage Gigafactory)는 연내 시험 가동에 들어갈 예정이며, 예상 에너지 저장 규모는 거의 40GWh에 이릅니다.

Mar 22, 2024 pm 12:32 PM

상하이 미래 산업 파일럿 존 건설이 '1주년'을 맞이했습니다. Lingang New Area Management Committee 하이테크 부문 이사 Lu Yu가 주최한 언론 브리핑에서 많은 기대를 모으고 있는 Tesla 에너지 저장 장치에 대한 중요한 정보가 나왔습니다. 프로젝트가 공개되었습니다. Lu Yu는 이 프로젝트가 올해 안에 시험 생산을 완료할 계획이며 생산 규모는 40GWh에 가까울 것으로 예상한다고 말했습니다. 이 소식은 Tesla의 에너지 저장 프로젝트가 지역 산업 발전과 재생 에너지 활용에 큰 의미를 갖는다는 점에서 큰 관심을 끌었습니다. 세계적인 전기차 제조사인 테슬라의 에너지 저장 분야 참여가 큰 관심을 끌었다. 상하이와 협력함으로써 Tesla의 Lingang New Area 에너지 저장 프로젝트 건설은 지역 산업 수준과 기술 혁신 역량을 향상시키는 데 도움이 될 것입니다. Lu Yu는 또한 새로운 에너지 분야에서 Lingang의 다른 진전을 소개했습니다. 그가 언급한