인공지능 300년! LSTM의 아버지가 쓴 1만 단어 장문의 글: 현대 AI와 딥러닝의 발전사를 자세히 설명

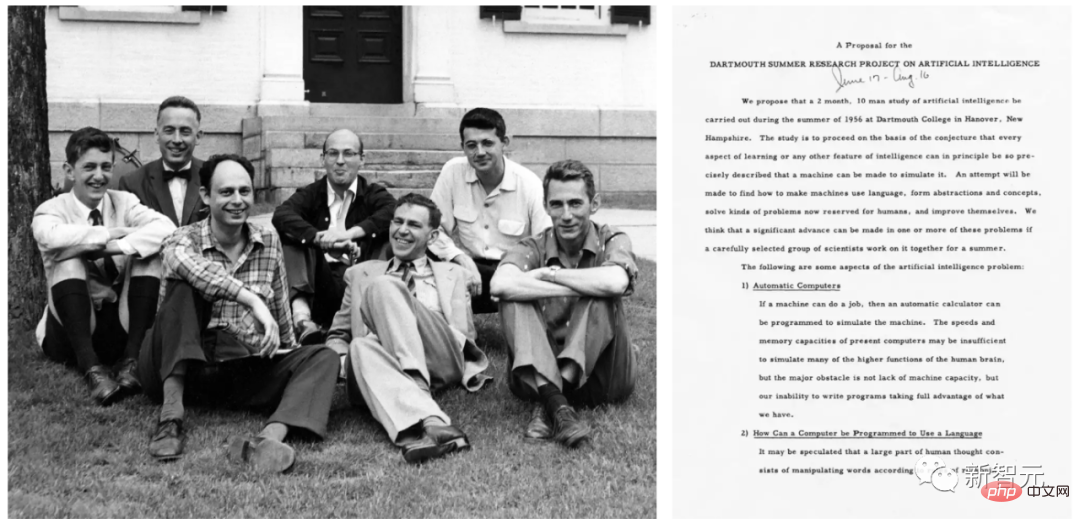

"인공 지능"이라는 용어는 1956년 다트머스 회의에서 존 매카시(John McCarthy) 등이 처음 공식적으로 제안했습니다.

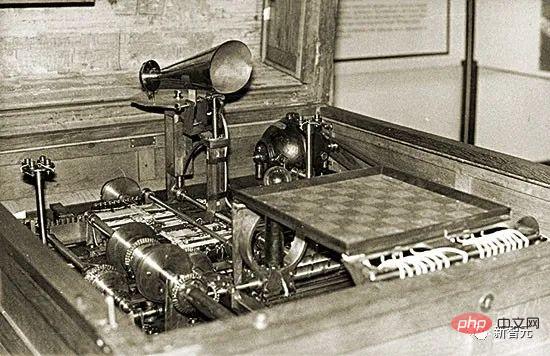

실용적인 AI는 이미 1914년에 제안되었습니다. 당시 Leonardo Torres y Quevedo는 최초의 작동 가능한 체스 머신 터미널 플레이어를 만들었습니다. 당시 체스는 지능이 있는 생물의 영역으로 제한된 활동으로 간주되었습니다.

인공지능 이론의 역사는 1931~34년으로 거슬러 올라갑니다. 당시 Kurt Gödel은 모든 유형의 계산 기반 인공 지능의 근본적인 한계를 확인했습니다.

1980년대가 다가오고 있으며 이 시기의 AI 역사에서는 정리 증명, 논리 프로그래밍, 전문가 시스템, 휴리스틱 검색 등의 주제가 강조될 것입니다.

2000년대 초반 AI의 역사는 서포트 벡터 머신, 커널 방법과 같은 주제에 더 큰 중점을 두었을 것입니다. 베이지안 추론과 기타 확률 및 통계적 개념, 의사결정 트리, 앙상블 방법, 군집 지능, 진화적 계산은 많은 성공적인 AI 애플리케이션을 구동하는 기술입니다.

2020년대 AI 연구는 더욱 "복고적"입니다. 예를 들어 경사하강법을 통해 훈련된 심층 비선형 인공 신경망, 특히 피드백 기반 순환 네트워크와 같은 개념을 강조하는 체인 규칙이 있습니다.

Schmidhuber는 이 기사가 이전의 오해의 소지가 있는 "딥 러닝의 역사"를 정정한다고 말했습니다. 그의 생각에 딥러닝의 이전 역사는 기사에 언급된 중요한 작업의 대부분을 무시했습니다.

또한 Schmidhuber는 신경망이 "컴퓨터가 패턴을 인식하고 인간 지능을 시뮬레이션하는 데 도움이 되는 도구로 1980년대에 도입되었다"는 일반적인 오해를 반박했습니다. 사실 신경망은 1980년대 이전에 등장했기 때문입니다.

1. 1676년: 역학점 할당의 연쇄 법칙

1676년 고트프리트 빌헬름 라이프니츠는 회고록에서 미적분학의 연쇄 법칙을 출판했습니다. 오늘날 이 규칙은 심층 신경망의 학점 할당의 핵심이며 현대 딥 러닝의 기초입니다.

Gottfried Wilhelm Leibniz

신경망에는 다른 뉴런의 입력에 대한 미분 함수를 계산하는 노드 또는 뉴런이 있습니다. 이전 함수의 매개변수나 가중치를 수정한 후 최종 함수 출력의 변경 사항을 알고 싶다면 체인 규칙을 사용해야 합니다.

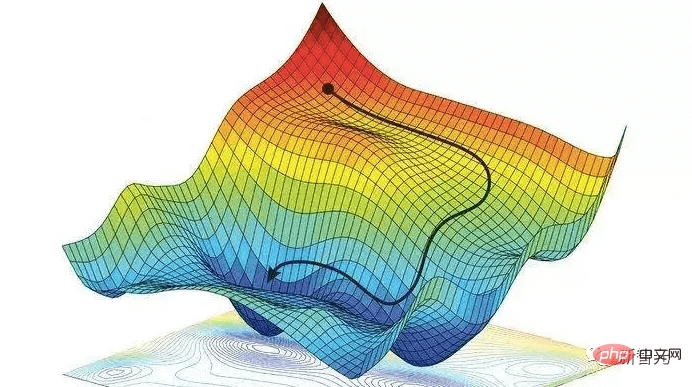

이 답변은 경사하강법에도 사용됩니다. 훈련 세트의 입력 패턴을 원하는 출력 패턴으로 변환하도록 신경망을 가르치기 위해 모든 신경망 가중치는 최대 로컬 개선 방향으로 조금씩 변경되어 약간 더 나은 신경망을 생성하는 등의 작업을 수행합니다. , 점차적으로 손실 함수를 최소화하기 위해 가중치와 편향의 최적 조합에 가까워집니다.

라이프니츠가 미적분학을 발견한 최초의 수학자이기도 하다는 점은 주목할 가치가 있습니다. 그와 아이작 뉴턴은 독립적으로 미적분학을 발견했으며, 그가 사용한 미적분학의 수학적 기호는 일반적으로 라이프니츠가 발명한 기호가 더 광범위하고 적용 범위가 더 넓은 것으로 간주됩니다.

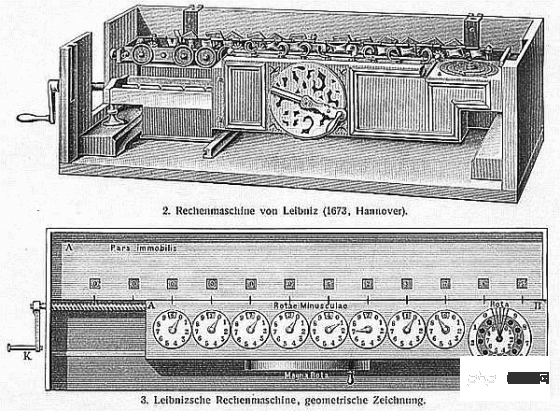

또한 라이프니츠는 "세계 최초의 컴퓨터 과학자"였습니다. 그는 1673년에 네 가지 산술 연산을 모두 수행할 수 있는 최초의 기계를 설계하여 현대 컴퓨터 과학의 토대를 마련했습니다.

2. 19세기 초: 신경망, 선형 회귀 및 얕은 학습

1805년에 Adrien-Marie Legendre는 현재 일반적으로 선형 신경망이라고 불리는 내용을 출판했습니다.

Adrien Marie Legendre

나중에 요한 칼 프리드리히 가우스도 비슷한 연구로 유명해 칭찬을 받았습니다.

200년 전의 이 신경망에는 두 개의 레이어가 있습니다. 하나는 여러 입력 단위가 있는 입력 레이어이고 다른 하나는 출력 레이어입니다. 각 입력 셀은 실수 값을 보유할 수 있으며 실수 값 가중치와의 연결을 통해 출력에 연결됩니다.

신경망의 출력은 입력과 가중치의 곱의 합입니다. 입력 벡터의 훈련 세트와 각 벡터에 대한 예상 목표 값이 주어지면 가중치를 조정하여 신경망 출력과 해당 목표 간의 제곱 오차 합계를 최소화합니다.

물론 당시에는 이것을 신경망이라고 부르지 않았습니다. 이는 선형 회귀라고도 널리 알려진 최소 제곱이라고 합니다. 그러나 이는 오늘날의 선형 신경망과 수학적으로 동일합니다. 동일한 기본 알고리즘, 동일한 오류 함수, 동일한 적응 매개변수/가중치입니다.

Johann Carl Friedrich Gauss

이 간단한 신경망은 비선형 레이어가 많은 "딥 러닝"과 달리 "얕은 학습"을 수행합니다. 실제로 많은 신경망 과정은 이 접근 방식에 대한 소개로 시작한 다음 더 복잡하고 심층적인 신경망으로 넘어갑니다.

요즘에는 모든 기술 과목의 학생들이 수학 수업, 특히 분석, 선형 대수 및 통계 수업을 의무적으로 수강해야 합니다. 이 모든 분야에서 대수학의 기본 정리, 가우스 소거 방법, 통계의 가우스 분포 등 많은 중요한 결과와 방법이 가우스에 기인합니다.

"고대 이래 가장 위대한 수학자"로 알려진 그는 또한 미분 기하학, 정수론(자신이 가장 좋아하는 과목) 및 비유클리드 기하학을 개척했습니다. 그의 업적이 없었다면 AI를 포함한 현대 공학은 생각할 수도 없었을 것입니다.

III: 최초의 순환 신경망

인간의 두뇌와 유사하게 순환 신경망(RNN)은 피드백 연결을 가지고 있어 특정 내부 노드에서 다른 노드로의 직접적인 연결을 따라갈 수 있으며 마침내 종료됩니다. 출발점에서. 이는 시퀀스 처리 중 과거 이벤트에 대한 메모리를 활성화하는 데 중요합니다.

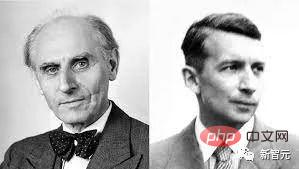

Wilhelm Lenz(왼쪽); Ernst Ising(오른쪽)

물리학자 Ernst Ising과 Wilhelm Lenz는 1920년대 최초의 비학습형 RNN 아키텍처인 Ising 모델을 소개하고 분석했습니다. 입력 조건에 따라 평형 상태에 들어가며 최초의 RNN 학습 모델의 기초가 됩니다.

1972년 Shun-Ichi Amari는 Ising 모델 루프 아키텍처를 적응형으로 만들어 연결 가중치를 변경하여 입력 패턴을 출력 패턴과 연결하는 방법을 학습했습니다. 이것은 세계 최초의 학습 RNN입니다.

Shunichi Amari

현재 가장 인기 있는 RNN은 Schmidhuber가 제안한 장단기 기억 네트워크 LSTM입니다. 이는 20세기에 가장 많이 인용되는 신경망이 되었습니다.

4. 1958년: 다층 피드포워드 신경망

1958년 Frank Rosenblatt는 선형 신경망과 임계값 함수를 결합하여 더 깊은 다층 퍼셉트론(MLP)을 설계했습니다.

Frank Rosenblatt

다층 퍼셉트론은 인간 신경계의 원리를 따르고 학습하여 데이터 예측을 합니다. 먼저 학습한 다음 가중치를 사용하여 데이터를 저장하고, 알고리즘을 사용하여 가중치를 조정하고 훈련 중 편향, 즉 실제 값과 예측 값 간의 오차를 줄입니다.

다층 피드포워드 네트워크의 학습에는 오류 역전파 알고리즘이 사용되는 경우가 많기 때문에 이는 패턴 인식 분야의 표준 지도 학습 알고리즘으로 간주되며 전산 신경학과 병렬 분야에서 계속 연구되고 있습니다. 분산 처리 주제.

5. 최초의 딥 러닝

1965년 우크라이나에서 Alexey Ivakhnenko와 Valentin Lapa가 임의의 수의 숨겨진 레이어를 갖춘 최초의 딥 MLP를 도입하면서 딥 피드포워드 네트워크 아키텍처에 대한 성공적인 학습이 시작되었습니다. 학습 알고리즘.

Alexey Ivakhnenko

입력 벡터와 해당 목표 출력 벡터가 주어지면 계층은 회귀 분석을 통해 점진적으로 성장하고 훈련된 다음 별도의 검증 세트를 사용하여 정리됩니다. 여기서 정규화는 중복 단위를 제거하는 데 사용됩니다. 레이어 수와 레이어당 단위는 문제에 따라 학습됩니다.

나중의 심층 신경망과 마찬가지로 Ivakhnenko의 네트워크는 수신 데이터의 계층적, 분산형, 내부 표현을 생성하는 방법을 배웠습니다.

그는 그것을 딥러닝 신경망이라고 부르지 않았지만 실제로는 그렇습니다. 실제로 "딥 러닝"이라는 용어는 1986년 Dechter에 의해 처음으로 기계 학습에 도입되었으며, Aizenberg et al.은 2000년에 "신경망" 개념을 도입했습니다.

VI. 1967-68: 확률적 경사하강법

1967년 아마리 준이치는 처음으로 확률적 경사하강법(SGD)을 통한 신경망 훈련을 제안했습니다.

아마리 순이치(Shunichi Amari)와 그의 학생 사이토(Saito)는 비선형적으로 분리 가능한 패턴 클래스를 분류하도록 훈련된 두 개의 수정 가능한 레이어가 있는 5레이어 MLP에서 내부 표현을 배웠습니다.

Rumelhart와 Hinton et al.은 1986년에 비슷한 작업을 수행했으며 이를 역전파 알고리즘이라고 명명했습니다.

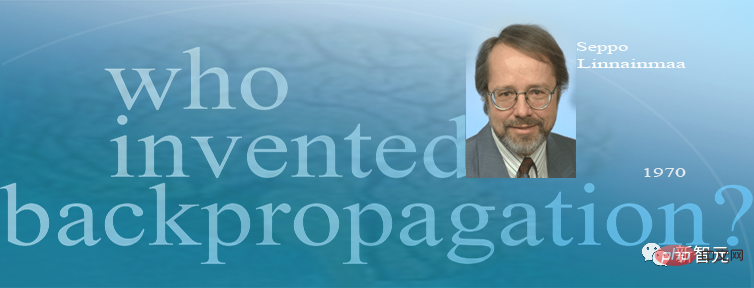

7. 1970년: 역전파 알고리즘

1970년에 Seppo Linnainmaa는 "자동 차등 역방향 모드"라고도 알려진 유명한 미분 가능 노드 네트워크 크레딧 할당 알고리즘인 역전파 알고리즘을 최초로 발표했습니다.

Seppo Linnainmaa

Linnainmaa는 임의의 이산 희소 연결의 경우 신경망에 대한 효율적인 오류 역전파 방법을 처음으로 설명합니다. 이는 이제 PyTorch 및 Google의 Tensorflow와 같이 널리 사용되는 신경망 소프트웨어 패키지의 기반이 되었습니다.

역전파는 본질적으로 심층 네트워크에 대한 라이프니츠의 체인 규칙을 구현하는 효율적인 방법입니다. Cauchy가 제안한 경사하강법은 특정 신경망 연결을 점차적으로 약화시키고 다른 연결을 강화하기 위해 많은 실험 과정에서 사용되었습니다.

1985년, 컴퓨팅 비용이 1970년보다 약 1,000배 낮았고, 데스크톱 컴퓨터가 부유한 학술 실험실에서 일반화되었을 때 David Rumelhart와 다른 사람들은 알려진 방법에 대한 실험적 분석을 수행했습니다.

David Rumelhart

실험을 통해 Rumelhart 외 연구진은 역전파가 신경망의 숨겨진 계층에서 유용한 내부 표현을 생성할 수 있음을 입증했습니다. 적어도 지도 학습의 경우 위에서 언급한 Amari Shunichi의 SGD 방법을 통한 딥 러닝보다 역전파가 더 효과적인 경우가 많습니다.

2010년 이전에는 많은 사람들이 다층 신경망을 훈련하려면 감독되지 않은 사전 훈련이 필요하다고 믿었습니다. 2010년에 Dan Ciresan과 함께 Schmidhuber 팀은 간단한 역전파를 통해 심층 FNN을 훈련할 수 있으며 중요한 응용 분야에 대해 감독되지 않은 사전 훈련이 전혀 필요하지 않음을 보여주었습니다.

8. 최초의 컨볼루션 신경망

1979년에 후쿠시마 쿠니히코는 STRL: Neocognitron에서 패턴 인식을 위한 신경망 모델을 개발했습니다. ㅋㅋㅋ 인공지능 핵심기술.

후쿠시마 박사가 소개한 네오코그니트론은 콘볼루션과 다운샘플링을 사용한 최초의 신경망이자 콘볼루션 신경망의 원형이기도 합니다.

후쿠시마 박사가 소개한 네오코그니트론은 콘볼루션과 다운샘플링을 사용한 최초의 신경망이자 콘볼루션 신경망의 원형이기도 합니다.

후쿠시마 쿠니히코가 설계한 학습 기능을 갖춘 인공 다층 신경망은 뇌의 시각 네트워크를 모방할 수 있습니다. 이 "통찰력"은 현대 인공 지능 기술의 기초가 되었습니다. 후쿠시마 박사의 연구는 자율주행차부터 안면 인식, 암 탐지부터 홍수 예측까지 다양한 분야의 실용적인 응용 분야로 이어졌습니다.

1987년 Alex Waibel은 신경망을 가중치 공유 및 역전파와 컨볼루션과 결합하여 지연 신경망(TDNN) 개념을 제안했습니다.

1989년부터 Yann LeCun 팀은 특히 이미지 부문에서 CNN의 발전에 기여해 왔습니다. ㅋㅋㅋ 팀은 초기 CNN보다 더 깊고 빠른 GPU 기반 CNN인 DanNet을 출시했습니다. 같은 해 DanNet은 컴퓨터 비전 대회에서 우승한 최초의 순수 심층 CNN이 되었습니다.

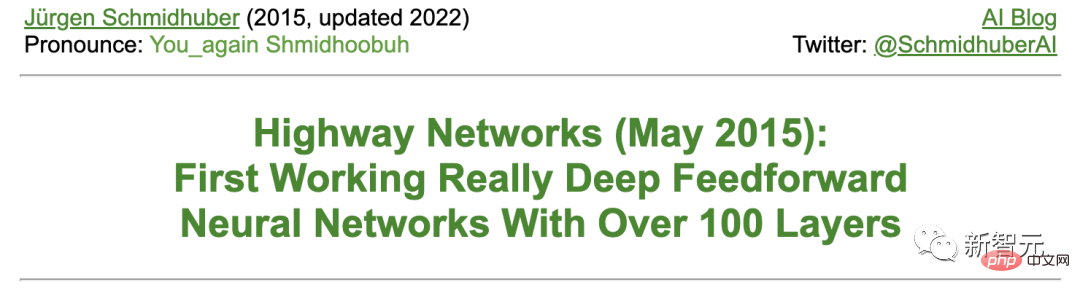

Microsoft Research의 학자 4명이 제안한 ResNet(Residual Neural Network)이 2015년 ImageNet 대규모 시각 인식 대회에서 1위를 차지했습니다.

Schmidhuber는 ResNet이 그의 팀이 개발한 고속 신경망(Highway Net)의 초기 버전이라고 말했습니다. 이는 최대 수십 개의 레이어만 있던 이전 신경망에 비해 수백 개의 레이어를 갖춘 최초의 진정으로 효과적인 심층 피드포워드 신경망입니다.

9. 1987-1990년대: 그래프 신경망 및 확률적 델타 규칙구조화된 데이터(예: 그래픽)를 조작할 수 있는 딥러닝 아키텍처는 1987년 Pollack이 제안했으며 1990년대 초 Sperduti, Goller가 개발했습니다. 확장 및 개선을 위한 Küchler. 오늘날 그래프 신경망은 많은 응용 분야에서 사용됩니다.

테우보 코호넨

1990년에 Stephen Hanson은 역전파를 통해 신경망을 훈련하는 확률론적 방법인 확률론적 델타 규칙을 도입했습니다. 수십 년 후, 이 방법은 "드롭아웃(dropout)"이라는 별명으로 유명해졌습니다.

10. 1990년 2월: Generative Adversarial Network/Curiosity

GAN(Generative Adversarial Network)은 1990년에 "Artificial Intelligence Curiosity"라는 이름으로 처음 출판되었습니다.

두 개의 적대적인 NN(확률 생성기와 예측기)은 최소 제한 게임에서 서로의 손실을 최대화하려고 합니다. 위치:

- 생성기(컨트롤러라고 함)는 확률적 출력을 생성합니다(나중에 StyleGAN과 같은 확률적 단위 사용).

- 예측기(월드 모델이라고 함)는 컨트롤러의 출력을 보고 환경이 이에 어떻게 반응할지 예측합니다. 경사하강법을 사용하여 예측기 NN은 오류를 최소화하는 반면 생성기 NN은 이 오류를 최대화하려고 시도합니다. 즉, 한 네트워크의 손실은 다른 네트워크의 이득이 됩니다.

GAN에 관한 2014년 논문 4년 전, Schmidhuber는 유명한 2010년 설문 조사에서 1990년의 생성적 적대적 NN을 다음과 같이 요약했습니다. "예측 세계 모델인 신경망은 제어를 최대화하는 데 사용됩니다. 기계의 내재적 보상은 모델의 예측 오류."

나중에 출시된 GAN은 단지 예시일 뿐입니다. 실험이 매우 짧은 경우 환경은 컨트롤러(또는 생성기)의 출력이 지정된 세트에 있는지 여부에 따라 단순히 1 또는 0을 반환합니다.

1990년 원리는 강화 학습 탐색 및 사실적 이미지 합성에 널리 사용되지만 후자 분야는 최근 Rombach et al의 Latent Diffusion으로 대체되었습니다.

1991년 Schmidhuber는 1996년 이미지에 적용된 부분 중복 데이터의 별도 표현을 생성하기 위해 예측 가능성 최소화라는 두 개의 적대적 NN을 기반으로 하는 또 다른 ML 방법을 발표했습니다.

1990년 11월, 4월: 하위 목표 생성/지침 작업

최근 몇 세기 동안 대부분의 NN은 고급 추론보다는 단순한 패턴 인식에 전념해 왔습니다.

그러나 1990년대 초반에 처음으로 예외가 나타났습니다. 이 작업은 종단 간 구별이 가능한 "하위 기호" NN에 전통적인 "기호" 계층적 인공 지능의 개념을 주입합니다.

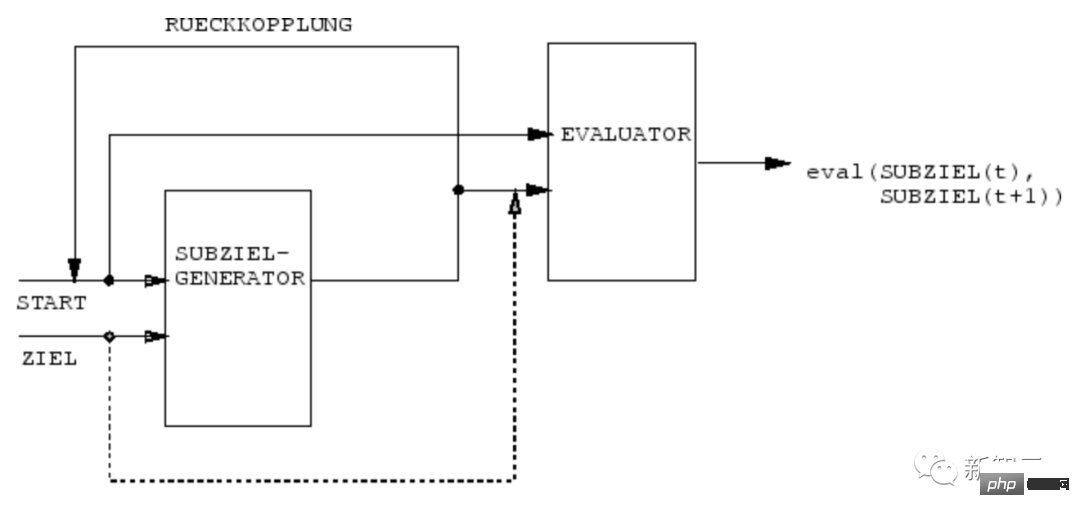

1990년 Schmidhuber 팀의 NN은 HRL(계층적 강화 학습)을 위한 계층적 작업 계획을 생성하기 위해 종단 간 미분 가능 NN의 하위 목표 생성기를 사용하는 방법을 배웠습니다.

RL 머신은 (start, target) 형태로 추가 명령 입력을 받습니다. 추정기 NN은 시작부터 목표까지 현재 보상/비용을 예측하는 방법을 학습합니다. (R)NN 기반 하위 목표 생성기는 또한 평가자 NN의 (복사본)을 사용하여 경사하강법을 통해 (시작, 목표) 일련의 최저 비용 중간 하위 목표를 보고 학습합니다. RL 머신은 최종 목표를 달성하기 위해 이러한 일련의 하위 목표를 사용하려고 시도합니다.

시스템은 다양한 추상화 수준과 다양한 시간 규모에서 실행 계획을 학습하고 원칙적으로 최근 "미해결 문제"라고 불리는 문제를 해결합니다.

1991년 3월 12일: 선형 self-attention을 갖춘 Transformer

"선형 self-attention"을 갖춘 Transformer는 1991년 3월에 처음 출판되었습니다.

소위 "빠른 무게 프로그래머" 또는 "빠른 무게 컨트롤러"는 기존 컴퓨터와 마찬가지로 저장 장치와 제어 장치를 분리하지만 엔드투엔드 차별화, 적응형 및 신경망 접근 방식을 사용합니다.

또한 오늘날의 Transformers는 Schmidhuber가 1990~1991년에 처음 발표한 딥 러닝 방법인 비지도 사전 훈련을 광범위하게 사용합니다.

1991년 4월 13일: 자기 지도 사전 훈련을 통한 딥 러닝

오늘날 가장 강력한 NN은 매우 깊은 경향이 있습니다. 즉, 뉴런의 레이어가 많거나 후속 계산 단계가 많습니다.

그러나 1990년대 이전에는 경사 기반 학습이 깊은 NN에서는 작동하지 않았습니다(얕은 NN에만 해당).

FNN(feedforward NN)과 달리 RNN에는 피드백 연결이 있습니다. 이는 RNN을 모든 길이의 입력 시퀀스(예: 음성 또는 비디오)를 처리할 수 있는 강력한 범용 병렬 시퀀스 컴퓨터로 만듭니다.

그러나 1990년대 이전에 RNN은 실제로 깊은 문제를 학습하는 데 실패했습니다.

이를 위해 Schmidhuber는 "보편적 딥 러닝"을 달성하기 위해 자체 감독 RNN 계층 구조를 구축했습니다.

1991년 4월: 하나의 NN을 다른 NN으로 증류

1991년 Schmidhuber가 제안한 NN 증류 절차를 사용하여 위에 설명된 신경 기록 압축기의 계층적 내부 표현을 단일 재귀 NN(RNN)으로 압축할 수 있습니다. ).

여기에서 학생 NN이 교사 NN의 행동을 모방하도록 훈련함으로써 교사 NN의 지식이 학생 NN으로 "증류"됩니다. 동시에 이전에 배운 기술이 모방되지 않도록 학생 NN을 재교육합니다. 잊혀진) . NN 증류 방법도 수년 후에 다시 출판되었으며 오늘날 널리 사용되고 있습니다.

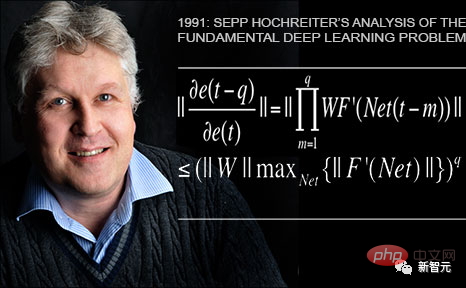

1991년 6월 14일: 기본 문제 - 그라데이션 소멸

Schmidhuber의 첫 학생인 Sepp Hochreiter는 1991년 졸업 논문에서 기본 딥 러닝 문제를 발견하고 분석했습니다.

Deep NN은 현재 유명한 Vanishing Gradient 문제로 어려움을 겪고 있습니다. 일반적인 Deep 또는 Recurrent 네트워크에서는 역전파된 오류 신호가 빠르게 줄어들거나 범위를 벗어나게 됩니다. 두 경우 모두 학습에 실패합니다.

1991년 6월 15일: LSTM/Highway Net/ResNet의 기초

장단기 기억(LSTM) 순환 신경망은 위에서 언급한 1991년 Sepp Hochreiter가 지적한 기본 깊이를 극복합니다. 졸업논문 학습 문제.

1997년에 동료 검토 논문을 출판한 후(현재 20세기에 가장 많이 인용된 NN 기사) Schmidhuber의 학생인 Felix Gers와 Alex Graves는 LSTM과 그 훈련 절차를 더욱 개선했습니다.

1999~2000년에 게시된 LSTM 변형(망각 게이트가 있는 "바닐라 LSTM 아키텍처")은 오늘날에도 여전히 Google의 Tensorflow에서 사용되고 있습니다.

2005년에 Schmidhuber는 LSTM의 완전 역전파 및 양방향 전파(또한 널리 사용됨)에 대한 기사를 처음으로 게시했습니다.

2006년 획기적인 훈련 방법은 시퀀스 정렬과 식별을 동시에 수행하는 "Connectionist Temporal Classification"(CTC)입니다.

Schmidhuber 팀은 2007년에 CTC 훈련된 LSTM을 음성(계층형 LSTM 스택도 있음)에 성공적으로 적용하여 처음으로 뛰어난 엔드투엔드 신경 음성 인식 결과를 달성했습니다.

2009년 Alex의 노력으로 CTC에서 훈련한 LSTM은 국제 대회, 즉 3개의 ICDAR 2009 필기 대회(프랑스어, 페르시아어, 아랍어)에서 우승한 최초의 RNN이 되었습니다. 이는 업계에 큰 관심을 불러일으켰다. LSTM은 음성, 영상 등 시퀀스 데이터와 관련된 모든 상황에서 빠르게 활용됐다.

2015년에는 CTC-LSTM 조합으로 Android 스마트폰에서 Google의 음성 인식 성능이 크게 향상되었습니다. 2019년까지 구글의 모바일 단말 음성인식은 여전히 LSTM 기반이었다.

1995년: 신경 확률적 언어 모델

1995년에 Schmidhuber는 뛰어난 신경 확률적 텍스트 모델을 제안했으며 그 기본 개념은 2003년에 재사용되었습니다.

2001년 Schmidhuber는 HMM과 같은 전통적인 모델이 배울 수 없는 언어를 LSTM이 배울 수 있음을 보여주었습니다.

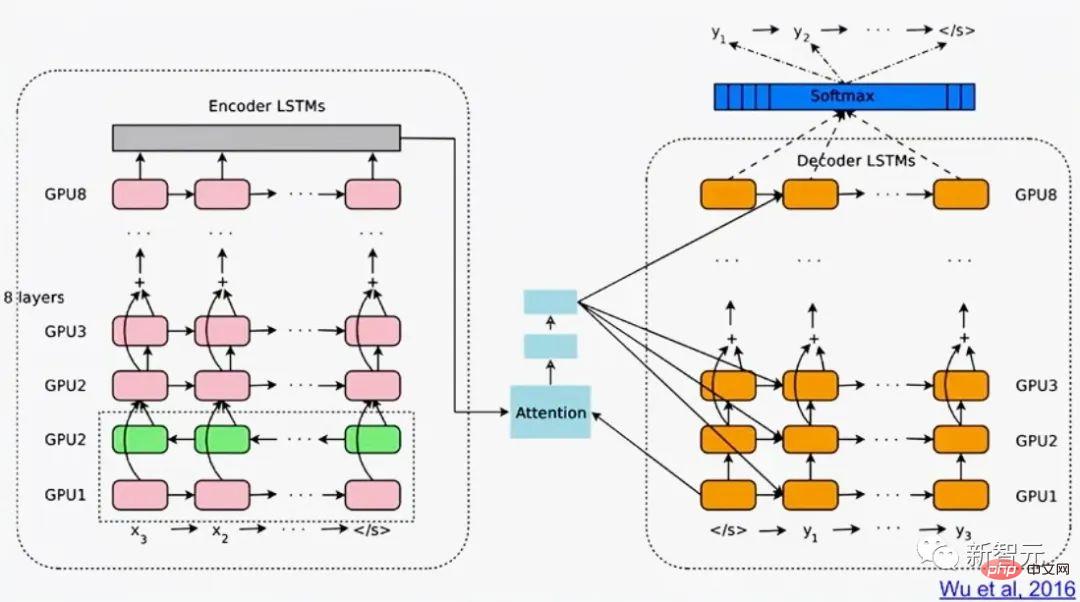

2016년 Google 번역은 두 개의 연결된 LSTM(백서에서는 LSTM을 50번 이상 언급함)을 기반으로 합니다. 하나는 수신 텍스트용이고 다른 하나는 발신 번역용입니다.

같은 해 Google 데이터 센터에서 추론에 사용된 슈퍼 컴퓨팅 성능의 4분의 1 이상이 LSTM에 사용되었습니다(5%는 또 다른 인기 있는 딥 러닝 기술인 CNN에 사용되었습니다).

2017년까지 LSTM은 Facebook(주당 300억 개 이상의 번역), 약 10억 대의 iPhone에서 Apple의 Quicktype, Amazon의 Alexa 음성, Google의 이미지 캡션 생성 및 자동 이메일 응답을 위한 기계 번역도 생성했습니다. 지원을 제공하다.

물론 Schmidhuber의 LSTM은 건강 관리 및 의료 진단에도 널리 사용됩니다. 간단한 Google Scholar 검색으로 제목에 "LSTM"이 포함된 수많은 의학 논문을 찾을 수 있습니다.

2015년 5월 Schmidhuber 팀은 수백 개의 레이어가 있는 최초의 매우 깊은 FNN인 LSTM 원리를 기반으로 하는 고속도로 네트워크를 제안했습니다(이전 NN에는 최대 수십 개의 레이어만 있었습니다). Microsoft의 ResNet(ImageNet 2015 대회에서 우승)은 그 버전입니다.

ImageNet의 초기 Highway Net 성능은 ResNet과 거의 같았습니다. Highway Net의 변형은 순수 잔여 레이어가 제대로 수행되지 않는 특정 알고리즘 작업에도 사용됩니다.

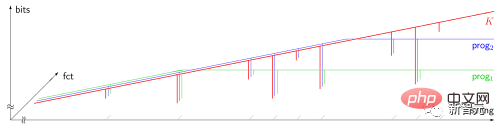

LSTM/Highway Net 원리는 현대 딥러닝의 핵심입니다

딥러닝의 핵심은 NN 깊이입니다.

1990년대에 LSTM은 감독되는 순환 NN에 본질적으로 무한한 깊이를 가져왔고, 2000년에는 LSTM에서 영감을 받은 Highway Net이 피드포워드 NN에 깊이를 가져왔습니다.

이제 LSTM은 20세기에 가장 많이 인용되는 NN이 되었고, Highway Net 버전 중 하나인 ResNet은 21세기에 가장 많이 인용되는 NN입니다.

16, 1980~현재: 교사 없이 동작을 학습하기 위한 NNN

또한 NN은 강화 학습(RL)과도 관련이 있습니다.

일부 문제는 1980년대 초에 발명된 비신경 기술로 해결될 수 있지만. 예를 들어 몬테카를로 트리 탐색(MC), 동적 프로그래밍(DP), 인공 진화, α-β-가지치기, 제어 이론 및 시스템 식별, 확률적 경사하강법, 일반 탐색 기법 등이 있습니다. 그러나 심층 FNN과 RNN은 특정 유형의 RL 작업에 대해 더 나은 결과를 가져올 수 있습니다.

일반적으로 강화 학습 에이전트는 교사의 도움 없이 처음에는 알려지지 않았으며 부분적으로 관찰 가능한 동적 환경과 상호 작용하는 방법을 학습하여 예상되는 누적 보상 신호를 최대화해야 합니다. 행동과 인지된 결과 사이에는 임의적이고 선험적으로 알려지지 않은 지연이 있을 수 있습니다.

환경에 Markov 인터페이스가 있어 RL 에이전트에 대한 입력이 DP(동적 프로그래밍)/TD(시간 차이)/Monte Carlo RL을 기반으로 차선책 동작을 결정하는 데 필요한 모든 정보를 전달할 수 있는 경우 트리 검색(MC)은 매우 성공적일 수 있습니다.

Markov 인터페이스가 없는 더 복잡한 상황의 경우 에이전트는 현재 입력뿐만 아니라 이전 입력 기록도 고려해야 합니다. 이런 점에서 RL 알고리즘과 LSTM의 조합은 표준 솔루션이 되었으며, 특히 LSTM은 정책 그라데이션을 통해 훈련되었습니다.

예를 들어, 2018년에는 OpenAI의 유명한 Dactyl의 중심에 있는 PG 교육을 받은 LSTM이 교사 없이 능숙한 로봇 손을 제어하는 방법을 배웠습니다.

비디오 게임도 마찬가지입니다.

2019년 DeepMind(Schmidhuber Lab 학생이 공동 창립)는 PG에서 훈련한 Deep LSTM 코어를 갖춘 Alphastar를 사용하여 게임 "StarCraft"에서 프로 선수들을 물리쳤습니다.

동시에 RL LSTM(전체 모델 매개변수 수의 84%를 차지)은 Dota 2에서 인간 전문 플레이어를 물리친 유명한 OpenAI Five의 핵심이기도 합니다.

RL의 미래는 상식 추론과 사고 학습에 관한 복잡한 입력 스트림의 컴팩트한 시공간 추상화를 통한 학습/결합/계획에 관한 것입니다.

Schmidhuber는 1990~91년에 발표된 논문에서 자체 감독 신경 기록 압축기가 여러 수준의 추상화 및 여러 시간 척도에서 그리고 엔드투엔드 구별 가능의 하위 목표를 기반으로 표현 개념을 학습할 수 있다고 제안했습니다. NN Generator는 경사하강법을 통해 계층적 작업 계획을 학습할 수 있습니다.

이후 1997년과 2015-18년에는 추상적 사고를 학습하는 보다 정교한 방법이 출판되었습니다.

하드웨어 문제야, 바보야!

지난 천년 동안 컴퓨터 하드웨어의 지속적인 개선과 가속화된 업그레이드가 없었다면 딥러닝 알고리즘은 큰 발전을 이룰 수 없었을 것입니다.

최초로 알려진 기어 컴퓨팅 장치는 2,000여년 전 고대 그리스의 안티키테라 메커니즘입니다. 오늘날 알려진 가장 오래된 복합 과학 컴퓨터이자 세계 최초의 아날로그 컴퓨터입니다.

안티키테라 기계

세계 최초의 실용적인 프로그래밍 가능 기계는 서기 1세기에 고대 그리스 기계공 헬렌에 의해 발명되었습니다.

17세기 기계는 더욱 유연해졌으며 입력 데이터를 기반으로 답을 계산할 수 있었습니다.

간단한 산술을 위한 최초의 기계식 계산기는 1623년 Wilhelm Schickard에 의해 발명 및 제조되었습니다.

1673년 라이프니츠는 네 가지 산술 연산을 모두 수행할 수 있고 메모리를 갖춘 최초의 기계를 설계했습니다. 그는 또한 펀치 카드로 제어되는 이진 컴퓨터의 원리를 설명하고 딥 러닝과 현대 인공 지능의 중요한 부분을 구성하는 체인 규칙을 제안했습니다.

라이프니츠 승수

1800년경 Joseph Marie Jacquard와 다른 사람들은 프랑스에서 최초로 디자인 가능한 직기를 만들었습니다. ——자카드 기계. 이 발명은 컴퓨터와 같은 다른 프로그래밍 가능한 기계의 미래 개발에 중요한 역할을 했습니다.

Jacquard Loom

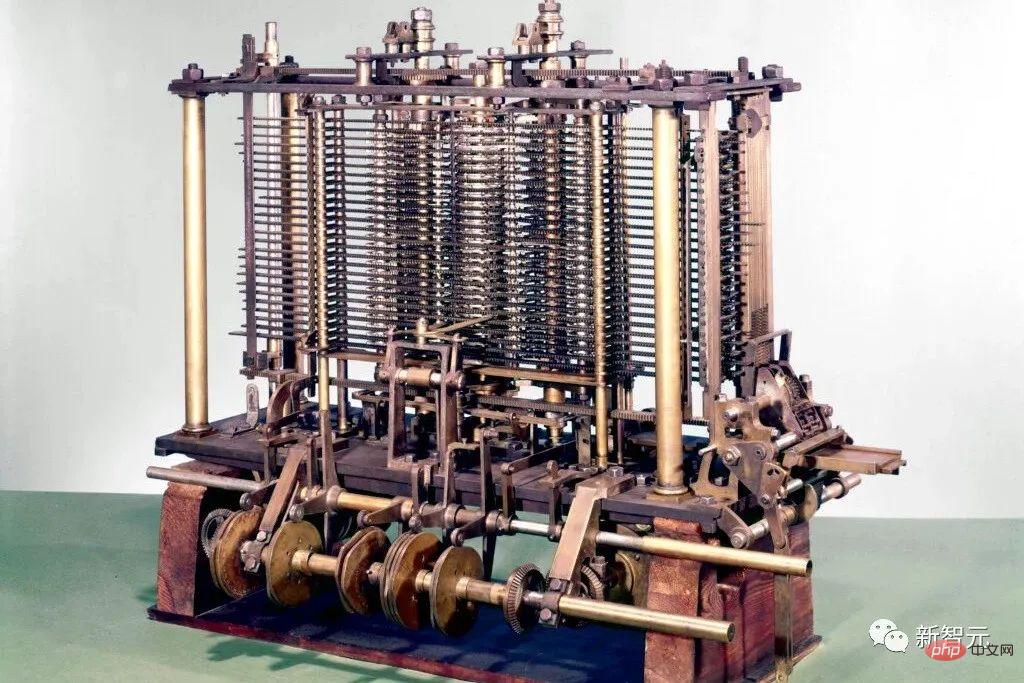

그들은 Ada Lovelace와 그녀의 멘토 Charles Babbage가 현대 전자 기계를 발명하도록 영감을 주었습니다. 컴퓨터의 전신인 Babbage's Difference Engine.

다음 1843년에 Lovelace는 세계 최초의 컴퓨터 알고리즘 세트를 출판했습니다.

배비지의 차분 엔진

1914년 스페인 사람 Leonardo Torres y Quevedo는 최초의 체스 터미널 머신 플레이어를 만들어 20세기 최초의 인공 지능 선구자가 되었습니다.

1935년에서 1941년 사이에 Konrad Zuse는 세계 최초의 프로그래밍 가능 범용 컴퓨터인 Z3를 발명했습니다.

Conrad Zuse

Babbage의 해석 엔진과 달리 Zuse는 전통적인 십진수 계산 대신 라이프니츠의 이진수 계산 원리를 사용했습니다. 이는 하드웨어에 대한 로드를 크게 단순화합니다.

1944년 하워드 에이컨(Howard Aiken)은 팀을 이끌고 세계 최초의 대규모 자동 디지털 컴퓨터인 Mark I(Mark I)을 발명했습니다.

1948년 Frederic Williams, Tom Kilburn 및 Geoff Tootill은 "맨체스터 베이비"라고도 알려진 세계 최초의 전자 저장 프로그램 컴퓨터인 SSEM(Small Experimental Machine)을 발명했습니다.

"맨체스터 베이비" 복제

이후 집적회로(IC)의 도움으로 컴퓨터 작동 속도가 빨라졌습니다. 1949년에 Siemens의 Werner Jacobi는 공통 기판에 여러 개의 트랜지스터를 사용할 수 있는 집적 회로 반도체에 대한 특허를 신청했습니다.

1958년 Jack Kilby는 외부 전선이 있는 집적 회로를 시연했습니다. 1959년에 로버트 노이스는 모놀리식 집적 회로를 제안했습니다. 1970년대부터 그래픽 처리 장치(GPU)는 병렬 처리를 통해 컴퓨팅을 가속화하는 데 사용되었습니다. 오늘날 컴퓨터의 GPU에는 수십억 개의 트랜지스터가 포함되어 있습니다.

신체적 한계는 어디에 있나요?

한스 요아힘 브레머만이 제안한 브레머만 한계에 따르면, 질량 1kg, 부피 1리터의 컴퓨터는 32번째 방향으로 최대 10회의 연산을 수행할 수 있으며 최대 10회의 51회 연산을 수행합니다. 두번째.

Hans Joachim Bremermann

그러나 태양계의 질량은 2x10^30kg에 불과하며 이러한 추세는 몇 세기 안에 깨질 것입니다. 다른 태양계 형태의 추가 질량은 심각하게 제한됩니다.

따라서 물리학의 제약으로 인해 미래의 효율적인 컴퓨팅 하드웨어는 총 연결 비용을 최소화하기 위해 3차원 공간에 콤팩트하게 배치된 많은 프로세서를 갖춘 뇌와 같아야 하며 기본 아키텍처는 본질적으로 깊고 희박하게 연결된 구조입니다. 3차원 RNN.

Schmidhuber는 RNN과 같은 딥러닝 방법이 더욱 중요해질 것이라고 추측합니다.

18. 1931년 이후의 인공지능 이론

현대 인공지능과 딥러닝의 핵심은 주로 최근 세기의 수학인 미적분학, 선형대수학, 통계학을 기반으로 합니다.

1930년대 초 괴델은 현대 이론 컴퓨터 과학을 창시했습니다. 그는 모든 디지털 컴퓨터의 작동을 공리적 형식으로 공식화할 수 있는 정수 기반의 범용 코딩 언어를 도입했습니다.

동시에 괴델은 주어진 계산 정리 테스터를 통해 열거 가능한 공리 세트에서 가능한 모든 정리를 체계적으로 열거하는 유명한 공식 진술도 구성했습니다. 따라서 그는 알고리즘 정리 증명, 계산, 그리고 모든 종류의 계산 기반 인공 지능의 근본적인 한계를 확인했습니다.

또한 Gödel은 John von Neumann에게 보낸 유명한 편지에서 컴퓨터 과학에서 가장 유명한 공개 문제 "P=NP?"를 식별했습니다.

1935년 알론조 교회는 힐베르트와 아커만의 의사결정 문제에 대한 일반적인 해결책이 없음을 증명함으로써 괴델의 결과에 대한 추론을 도출했습니다. 이를 위해 그는 매우 영향력 있는 프로그래밍 언어 LISP의 기초를 형성한 Untyped Lambda Calculus라는 또 다른 범용 코딩 언어를 사용했습니다.

1936년 앨런 튜링은 또 다른 일반 모델인 튜링 기계를 도입하여 위의 결과를 다시 얻었습니다. 같은 해에 Emil Post는 또 다른 독립적인 컴퓨팅 일반 모델을 발표했습니다.

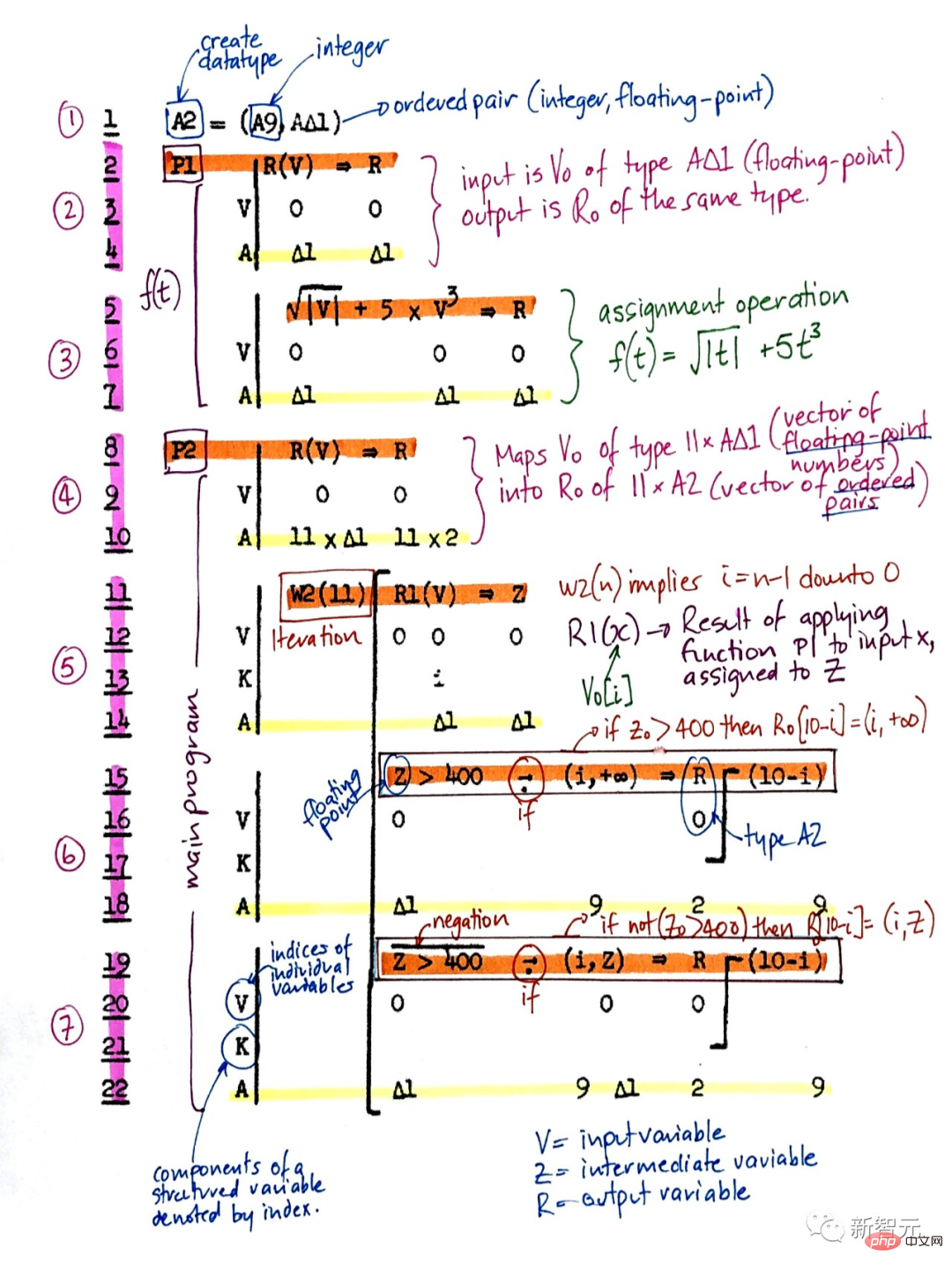

Konrad Zuse는 세계 최초의 사용 가능한 프로그래밍 가능 범용 컴퓨터를 만들었을 뿐만 아니라 최초의 고급 프로그래밍 언어인 Plankalkül을 설계했습니다. 그는 이를 1945년 체스에 적용했고, 1948년에는 정리 증명에 적용했습니다.

Plankalkül

1940~70년대 초기 AI의 대부분은 실제로 전문가 시스템과 논리 프로그래밍을 통한 정리 증명과 괴델식 파생에 관한 것이었습니다.

1964년 Ray Solomonoff는 베이지안(실제로는 라플라시안) 확률적 추론과 이론적인 컴퓨터 과학을 결합하여 수학적으로 최적이지만 계산적으로는 실현 불가능한 학습 방법에 도달했습니다. 과거 관찰로부터 미래 데이터를 예측합니다.

안드레이 콜모고로프(Andrej Kolmogorov)와 함께 그는 코로트코프 복잡도(Korotkoff Complexity) 또는 AIT(알고리즘 정보 이론) 이론을 창시했는데, 이는 컴퓨팅 데이터에 대한 최단 프로그램 개념을 통해 오캄의 면도날 개념을 공식화하여 전통적인 정보 이론을 뛰어넘는 것입니다.

Coriolis 복잡성

자기 참조 괴델 기계의 보다 일반적인 최적성은 점근적 최적성에 국한되지 않습니다.

그래도 이 수학적으로 최적인 AI는 여러 가지 이유로 아직 실제로 구현 가능하지 않습니다. 대신 실용적인 현대 인공 지능은 차선책, 제한적이지만 극도로 이해되지 않은 NN 및 딥 러닝과 같은 기술을 기반으로 합니다.

하지만 20년 후에 인공지능의 역사가 어떤 모습일지 누가 알겠습니까?

위 내용은 인공지능 300년! LSTM의 아버지가 쓴 1만 단어 장문의 글: 현대 AI와 딥러닝의 발전사를 자세히 설명의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7530

7530

15

15

1378

1378

52

52

82

82

11

11

54

54

19

19

21

21

76

76

Bytedance Cutting, SVIP 슈퍼 멤버십 출시: 연간 연속 구독료 499위안, 다양한 AI 기능 제공

Jun 28, 2024 am 03:51 AM

Bytedance Cutting, SVIP 슈퍼 멤버십 출시: 연간 연속 구독료 499위안, 다양한 AI 기능 제공

Jun 28, 2024 am 03:51 AM

이 사이트는 6월 27일에 Jianying이 ByteDance의 자회사인 FaceMeng Technology에서 개발한 비디오 편집 소프트웨어라고 보도했습니다. 이 소프트웨어는 Douyin 플랫폼을 기반으로 하며 기본적으로 플랫폼 사용자를 위한 짧은 비디오 콘텐츠를 제작합니다. Windows, MacOS 및 기타 운영 체제. Jianying은 멤버십 시스템 업그레이드를 공식 발표하고 지능형 번역, 지능형 하이라이트, 지능형 패키징, 디지털 인간 합성 등 다양한 AI 블랙 기술을 포함하는 새로운 SVIP를 출시했습니다. 가격면에서 SVIP 클리핑 월 요금은 79위안, 연간 요금은 599위안(본 사이트 참고: 월 49.9위안에 해당), 월간 연속 구독료는 월 59위안, 연간 연속 구독료는 59위안입니다. 연간 499위안(월 41.6위안)입니다. 또한, 컷 관계자는 "사용자 경험 향상을 위해 기존 VIP에 가입하신 분들도

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

검색 강화 생성 및 의미론적 메모리를 AI 코딩 도우미에 통합하여 개발자 생산성, 효율성 및 정확성을 향상시킵니다. EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG에서 번역됨, 저자 JanakiramMSV. 기본 AI 프로그래밍 도우미는 자연스럽게 도움이 되지만, 소프트웨어 언어에 대한 일반적인 이해와 소프트웨어 작성의 가장 일반적인 패턴에 의존하기 때문에 가장 관련성이 높고 정확한 코드 제안을 제공하지 못하는 경우가 많습니다. 이러한 코딩 도우미가 생성한 코드는 자신이 해결해야 할 문제를 해결하는 데 적합하지만 개별 팀의 코딩 표준, 규칙 및 스타일을 따르지 않는 경우가 많습니다. 이로 인해 코드가 애플리케이션에 승인되기 위해 수정되거나 개선되어야 하는 제안이 나타나는 경우가 많습니다.

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

LLM(대형 언어 모델)은 대규모 텍스트 데이터베이스에서 훈련되어 대량의 실제 지식을 습득합니다. 이 지식은 매개변수에 내장되어 필요할 때 사용할 수 있습니다. 이러한 모델에 대한 지식은 훈련이 끝나면 "구체화"됩니다. 사전 훈련이 끝나면 모델은 실제로 학습을 중단합니다. 모델을 정렬하거나 미세 조정하여 이 지식을 활용하고 사용자 질문에 보다 자연스럽게 응답하는 방법을 알아보세요. 그러나 때로는 모델 지식만으로는 충분하지 않을 때도 있으며, 모델이 RAG를 통해 외부 콘텐츠에 접근할 수 있더라도 미세 조정을 통해 모델을 새로운 도메인에 적응시키는 것이 유익한 것으로 간주됩니다. 이러한 미세 조정은 인간 주석 작성자 또는 기타 LLM 생성자의 입력을 사용하여 수행됩니다. 여기서 모델은 추가적인 실제 지식을 접하고 이를 통합합니다.

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

AIGC에 대해 자세히 알아보려면 다음을 방문하세요. 51CTOAI.x 커뮤니티 https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou는 인터넷 어디에서나 볼 수 있는 전통적인 문제 은행과 다릅니다. 고정관념에서 벗어나 생각해야 합니다. LLM(대형 언어 모델)은 데이터 과학, 생성 인공 지능(GenAI) 및 인공 지능 분야에서 점점 더 중요해지고 있습니다. 이러한 복잡한 알고리즘은 인간의 기술을 향상시키고 많은 산업 분야에서 효율성과 혁신을 촉진하여 기업이 경쟁력을 유지하는 데 핵심이 됩니다. LLM은 자연어 처리, 텍스트 생성, 음성 인식 및 추천 시스템과 같은 분야에서 광범위하게 사용될 수 있습니다. LLM은 대량의 데이터로부터 학습하여 텍스트를 생성할 수 있습니다.

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

편집자 |ScienceAI 질문 응답(QA) 데이터 세트는 자연어 처리(NLP) 연구를 촉진하는 데 중요한 역할을 합니다. 고품질 QA 데이터 세트는 모델을 미세 조정하는 데 사용될 수 있을 뿐만 아니라 LLM(대형 언어 모델)의 기능, 특히 과학적 지식을 이해하고 추론하는 능력을 효과적으로 평가하는 데에도 사용할 수 있습니다. 현재 의학, 화학, 생물학 및 기타 분야를 포괄하는 과학적인 QA 데이터 세트가 많이 있지만 이러한 데이터 세트에는 여전히 몇 가지 단점이 있습니다. 첫째, 데이터 형식이 비교적 단순하고 대부분이 객관식 질문이므로 평가하기 쉽지만 모델의 답변 선택 범위가 제한되고 모델의 과학적 질문 답변 능력을 완전히 테스트할 수 없습니다. 이에 비해 개방형 Q&A는

당신이 모르는 머신러닝의 5가지 학교

Jun 05, 2024 pm 08:51 PM

당신이 모르는 머신러닝의 5가지 학교

Jun 05, 2024 pm 08:51 PM

머신 러닝은 명시적으로 프로그래밍하지 않고도 컴퓨터가 데이터로부터 학습하고 능력을 향상시킬 수 있는 능력을 제공하는 인공 지능의 중요한 분야입니다. 머신러닝은 이미지 인식, 자연어 처리, 추천 시스템, 사기 탐지 등 다양한 분야에서 폭넓게 활용되며 우리의 삶의 방식을 변화시키고 있습니다. 기계 학습 분야에는 다양한 방법과 이론이 있으며, 그 중 가장 영향력 있는 5가지 방법을 "기계 학습의 5개 학교"라고 합니다. 5개 주요 학파는 상징학파, 연결주의 학파, 진화학파, 베이지안 학파, 유추학파이다. 1. 상징주의라고도 알려진 상징주의는 논리적 추론과 지식 표현을 위해 상징을 사용하는 것을 강조합니다. 이 사고 학교는 학습이 기존을 통한 역연역 과정이라고 믿습니다.

SOTA 성능, 샤먼 다중 모드 단백질-리간드 친화성 예측 AI 방법, 최초로 분자 표면 정보 결합

Jul 17, 2024 pm 06:37 PM

SOTA 성능, 샤먼 다중 모드 단백질-리간드 친화성 예측 AI 방법, 최초로 분자 표면 정보 결합

Jul 17, 2024 pm 06:37 PM

Editor | KX 약물 연구 및 개발 분야에서 단백질과 리간드의 결합 친화도를 정확하고 효과적으로 예측하는 것은 약물 스크리닝 및 최적화에 매우 중요합니다. 그러나 현재 연구에서는 단백질-리간드 상호작용에서 분자 표면 정보의 중요한 역할을 고려하지 않습니다. 이를 기반으로 Xiamen University의 연구자들은 처음으로 단백질 표면, 3D 구조 및 서열에 대한 정보를 결합하고 교차 주의 메커니즘을 사용하여 다양한 양식 특징을 비교하는 새로운 다중 모드 특징 추출(MFE) 프레임워크를 제안했습니다. 조정. 실험 결과는 이 방법이 단백질-리간드 결합 친화도를 예측하는 데 있어 최첨단 성능을 달성한다는 것을 보여줍니다. 또한 절제 연구는 이 프레임워크 내에서 단백질 표면 정보와 다중 모드 기능 정렬의 효율성과 필요성을 보여줍니다. 관련 연구는 "S"로 시작된다

SK하이닉스가 8월 6일 12단 HBM3E, 321고 NAND 등 AI 관련 신제품을 선보인다.

Aug 01, 2024 pm 09:40 PM

SK하이닉스가 8월 6일 12단 HBM3E, 321고 NAND 등 AI 관련 신제품을 선보인다.

Aug 01, 2024 pm 09:40 PM

1일 본 사이트 소식에 따르면 SK하이닉스는 오늘(1일) 블로그 게시물을 통해 8월 6일부터 8일까지 미국 캘리포니아주 산타클라라에서 열리는 글로벌 반도체 메모리 서밋 FMS2024에 참가한다고 밝혔다. 많은 새로운 세대의 제품. 인공지능 기술에 대한 관심이 높아지고 있는 가운데, 이전에는 주로 NAND 공급업체를 대상으로 한 플래시 메모리 서밋(FlashMemorySummit)이었던 미래 메모리 및 스토리지 서밋(FutureMemoryandStorage) 소개를 올해는 미래 메모리 및 스토리지 서밋(FutureMemoryandStorage)으로 명칭을 변경했습니다. DRAM 및 스토리지 공급업체와 더 많은 플레이어를 초대하세요. SK하이닉스가 지난해 출시한 신제품