사진을 보내주시고 30초짜리 영상을 만들어주세요!

AI가 또 발전했나요?

그리고 한 장의 사진으로 연속 30초짜리 영상을 생성하는 종류입니다.

으음....화질이 좀 흐릿한거 아닌가요

이것은 단일 이미지(첫 번째 프레임)에서만 생성된 것이며 아무 것도 표시되지 않는다는 점을 알아두세요 기하학적 정보 .

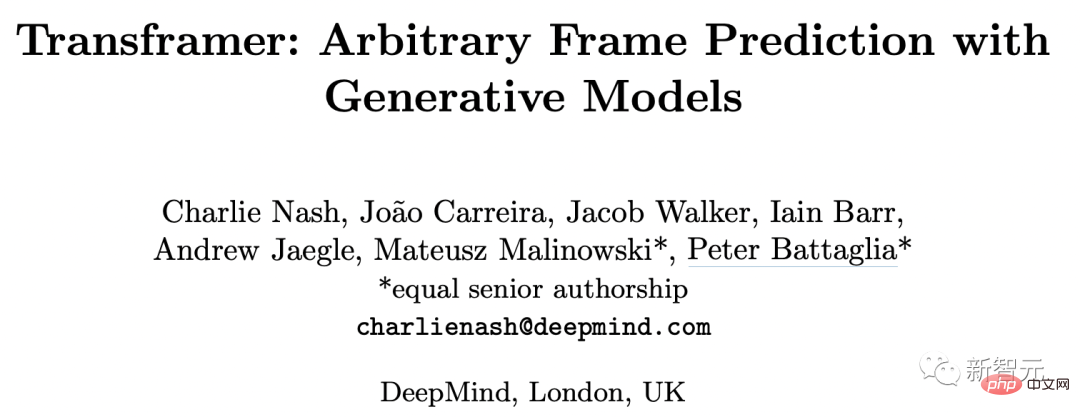

DeepMind - Transframer에서 최근 제안한 확률적 프레임 예측을 기반으로 한 이미지 모델링 및 비전 작업을 위한 일반적인 프레임워크입니다.

간단히 말하면 Transframer를 사용하여 모든 프레임의 확률을 예측하는 것입니다.

이러한 프레임은 이전 비디오 프레임, 타임스탬프 또는 카메라 태그가 지정된 보기 장면일 수 있는 하나 이상의 주석이 달린 컨텍스트 프레임에 따라 조정될 수 있습니다.

Transframer 아키텍처

먼저 이 마법 같은 Transframer 아키텍처가 어떻게 작동하는지 살펴보겠습니다.

페이퍼 주소는 아래에 있으니 관심 있는 아이들은 구경해보세요~ https://arxiv.org/abs/2203.09494

대상에 대한 예측 분포를 추정하기 위해서는 이미지를 위해서는 다양하고 고품질의 출력을 생성할 수 있는 표현 생성 모델이 필요합니다.

단일 이미지 도메인에서 DC Transformer의 결과는 요구 사항을 충족할 수 있지만 우리에게 필요한 다중 이미지 텍스트 세트 {(In,an)}n에서는 조건이 지정되지 않습니다.

그래서 우리는 DC Transformer를 확장하여 이미지 및 주석 조건부 예측을 가능하게 했습니다.

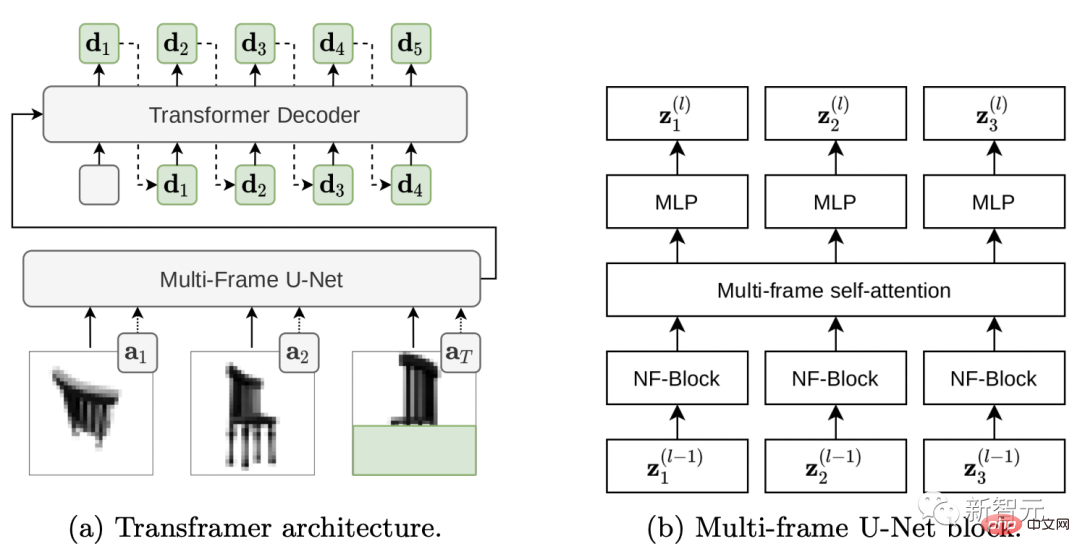

DC Transformer를 부분적으로 숨겨진 Target DCT 이미지는 물론 주석이 달린 프레임 세트를 처리하기 위해 다중 프레임 U-Net 아키텍처를 사용하여 단일 DCT 이미지에서 작동하는 Vision-Transformer 스타일 인코더로 교체했습니다.

Transframer 아키텍처가 어떻게 작동하는지 살펴보겠습니다.

(a) Transframer는 DCT 이미지(a1 및 a2)뿐만 아니라 부분적으로 숨겨진 대상 DCT 이미지(aT) 및 추가 주석을 입력으로 사용하며 이는 다중 프레임 U-Net 인코더에 의해 처리됩니다. 다음으로, U-Net 출력은 교차 주의를 통해 DC-Transformer 디코더로 전달되며, 이는 자동으로 회귀하여 대상 이미지의 숨겨진 부분에 해당하는 DCT 토큰 시퀀스(녹색 문자)를 생성합니다. (b) 다중 프레임 U-Net 블록은 NF-Net 컨볼루션 블록과 다중 프레임 self-attention 블록으로 구성되며, 입력 프레임과 Transformer 스타일 잔여 MLP 간에 정보를 교환합니다.

이미지 입력을 처리하는 Multi-Frame U-Net을 살펴보겠습니다.

U-Net에 대한 입력은 N개의 DCT 프레임과 부분적으로 숨겨진 타겟 DCT 프레임으로 구성된 시퀀스이며, 주석 정보는 각 입력 프레임과 연관된 벡터 형태로 제공됩니다.

U-Net의 핵심 구성 요소는 먼저 공유된 NF-ResNet 컨벌루션 블록을 각 입력 프레임에 적용한 다음 Transformer 스타일 self-attention 블록을 적용하여 프레임 정보를 집계하는 계산 블록입니다. (그림 2b)

NF-ResNet 블록은 TPU의 성능 향상을 목표로 그룹화된 convolution과 squeeze 및 excitation 레이어로 구성됩니다.

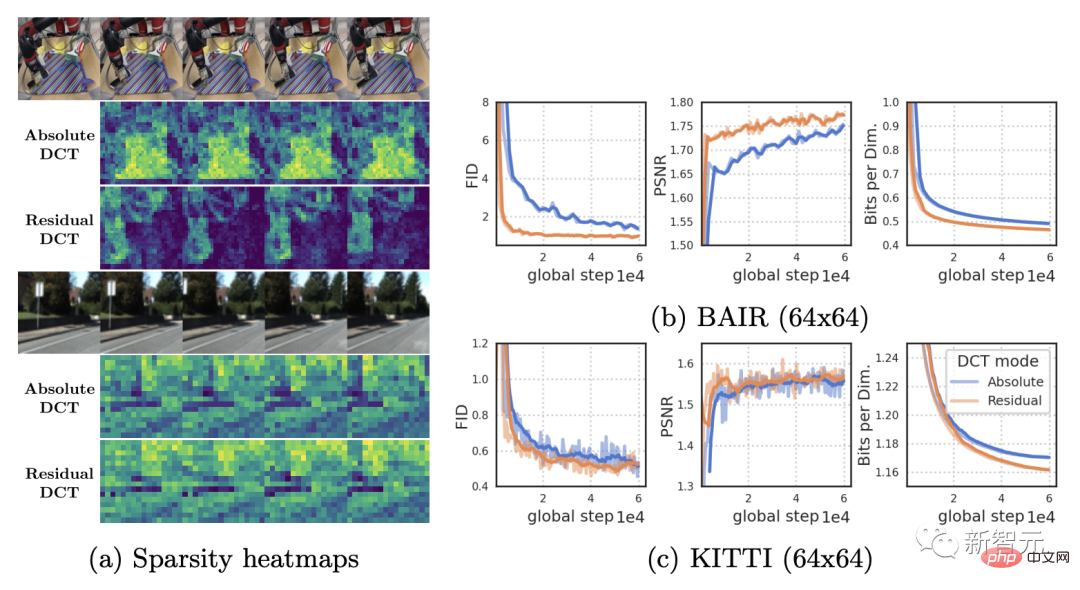

아래 그림 (a)는 RoboNet(128x128) 및 KITTI 비디오의 절대 및 잔차 DCT 표현의 희소성을 비교합니다.

RoboNet은 몇 개의 움직이는 요소만 포함된 정적 비디오로 구성되므로 잔여 프레임 표현의 희소성이 크게 증가합니다.

그리고 KITTI 비디오에는 일반적으로 카메라가 움직이기 때문에 연속 프레임의 거의 모든 부분에서 불일치가 발생합니다.

그러나 이 경우 작은 희소성의 이점도 약화됩니다.

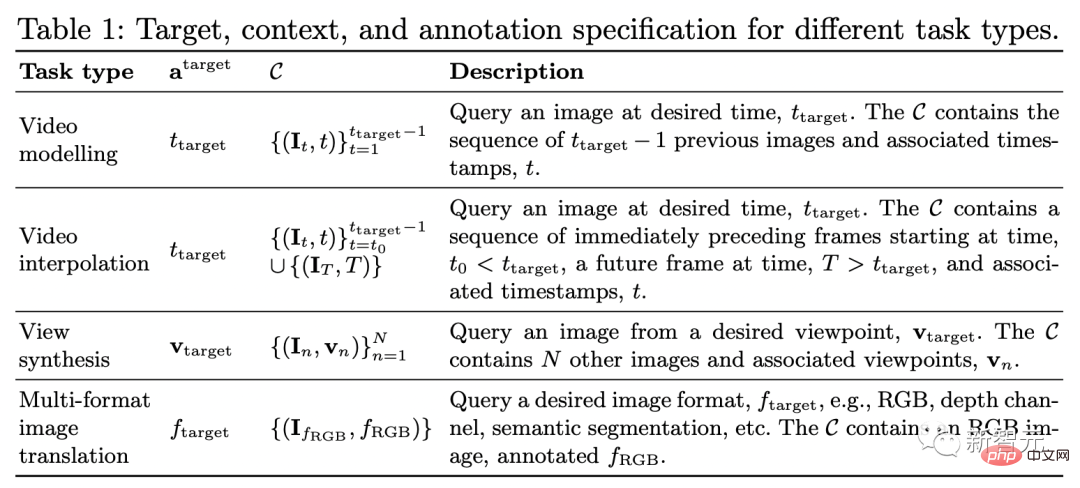

다양한 비전 작업에 강력함

일련의 데이터 세트와 작업에 대한 테스트를 통해 Transframer가 광범위한 작업에 적용될 수 있다는 결과가 나왔습니다.

비디오 모델링, 새로운 뷰 합성, 의미 분할, 객체 인식, 깊이 추정, 광학 흐름 예측 등 포함

비디오 모델링

Transframer를 통해 일련의 입력 비디오 프레임이 주어지면 다음 프레임을 예측합니다.

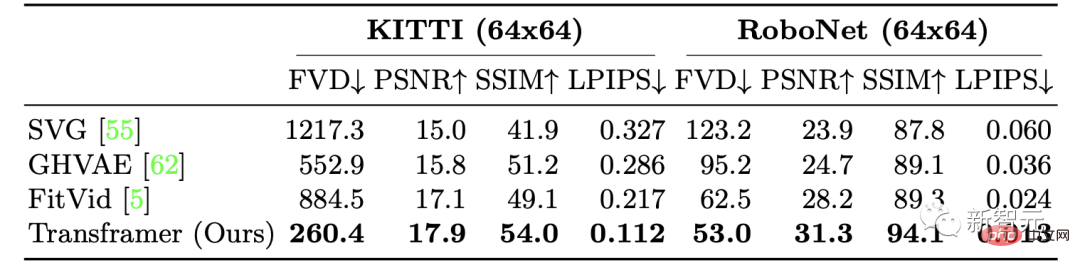

연구원들은 각각 KITTI와 RoboNet이라는 두 가지 데이터 세트를 사용하여 비디오 생성에 대한 Transframer의 성능을 훈련했습니다.

KITTI의 경우 5개의 컨텍스트 프레임과 25개의 샘플 프레임이 주어지면 Transframer 모델의 성능이 모든 측정 항목에서 향상되는 것으로 나타났으며 그중 LPIPS 및 FVD의 개선이 가장 두드러졌습니다.

RoboNet에서 연구원들은 2개의 컨텍스트 프레임과 10개의 샘플링 프레임을 받았고 각각 64x64 및 128x128 해상도로 훈련되었으며 마침내 매우 좋은 결과를 얻었습니다.

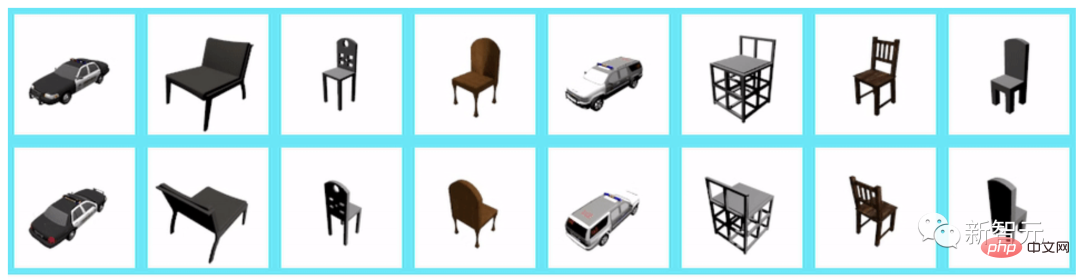

뷰 합성

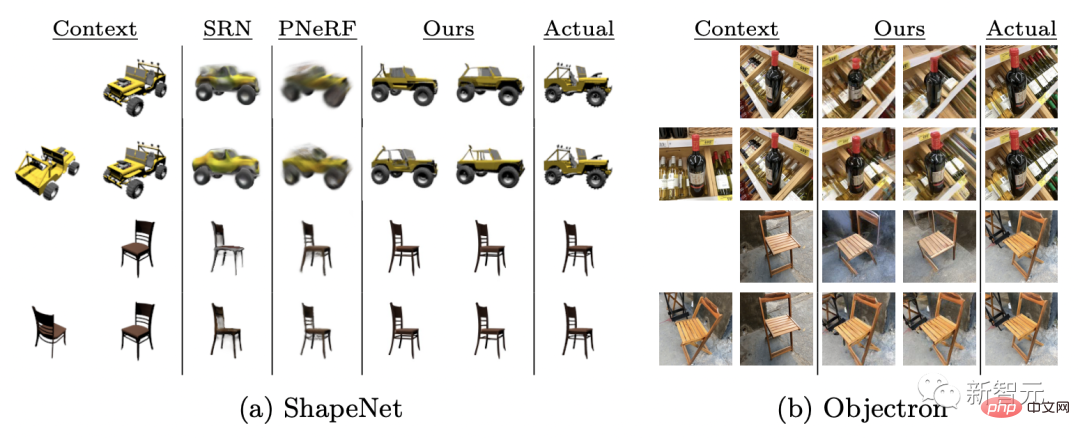

뷰 합성 측면에서 표 1(3행)에 설명된 대로 카메라 뷰를 컨텍스트 및 타겟 주석으로 제공하고 여러 컨텍스트 뷰를 균일하게 샘플링합니다. 지정된 최대값까지.

Model Transframer는 ShapeNet 벤치마크에서 평가되었으며 1-2 상황별 뷰를 제공하여 PixelNeRF 및 SRN보다 훨씬 뛰어난 성능을 보였습니다.

또한 Objectron 데이터 세트를 평가한 후 단일 입력 뷰가 제공되면 모델이 일관된 출력을 생성하지만 의자 다리를 꼬는 것과 같은 일부 기능이 누락되는 것을 볼 수 있습니다.

컨텍스트 뷰가 1개 주어졌을 때 128×128 해상도로 합성된 뷰는 다음과 같습니다.

컨텍스트 뷰가 2개 더 주어졌을 때 128×128 해상도로 합성된 것입니다 보기는 다음과 같습니다:

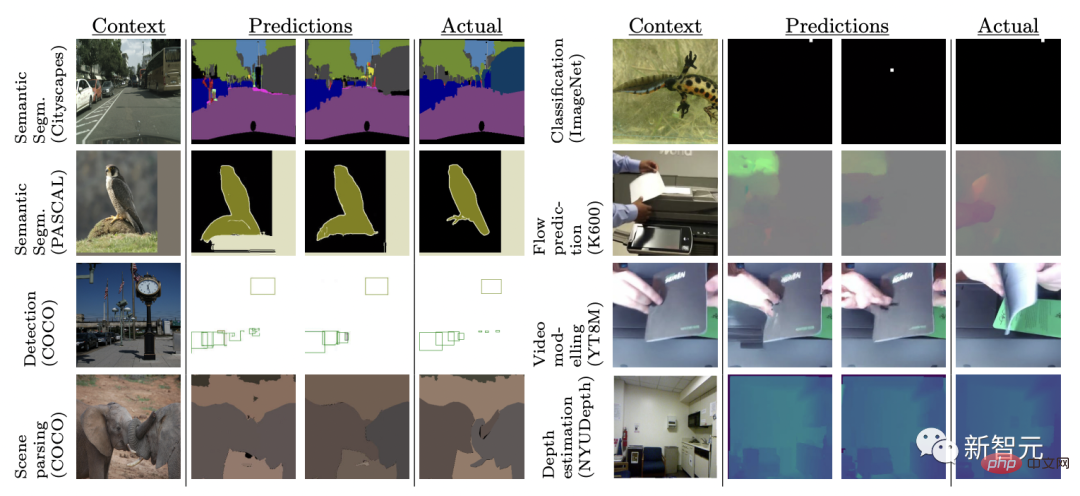

다중 비전 작업

다양한 컴퓨터 비전 작업은 일반적으로 복잡한 아키텍처와 손실 함수를 사용하여 처리됩니다.

여기서 연구원들은 동일한 손실 함수를 사용하여 8가지 작업과 데이터 세트에 대해 Transframer 모델을 공동으로 훈련했습니다.

8가지 작업은 단일 이미지의 광학 흐름 예측, 객체 분류, 감지 및 분할, 의미론적 분할(2개 데이터 세트), 미래 프레임 예측 및 깊이 추정입니다.

결과에 따르면 Transframer는 완전히 다른 작업에서 다른 샘플을 생성하는 방법을 학습하고 Cityscapes와 같은 일부 작업에서는 모델이 고품질 출력을 생성합니다.

그러나 향후 프레임 예측 및 경계 상자 감지와 같은 작업에 대한 모델 출력의 품질은 가변적이므로 이 설정에서 모델링하는 것이 더 어렵다는 것을 의미합니다.

위 내용은 사진을 보내주시고 30초짜리 영상을 만들어주세요!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7333

7333

9

9

1627

1627

14

14

1351

1351

46

46

1262

1262

25

25

1209

1209

29

29

Java 프레임워크에 대한 상용 지원의 비용 효율성을 평가하는 방법

Jun 05, 2024 pm 05:25 PM

Java 프레임워크에 대한 상용 지원의 비용 효율성을 평가하는 방법

Jun 05, 2024 pm 05:25 PM

Java 프레임워크에 대한 상용 지원의 비용/성능 평가에는 다음 단계가 포함됩니다. 필요한 보증 수준과 SLA(서비스 수준 계약) 보장을 결정합니다. 연구지원팀의 경험과 전문성. 업그레이드, 문제 해결, 성능 최적화와 같은 추가 서비스를 고려하십시오. 위험 완화 및 효율성 향상을 기준으로 비즈니스 지원 비용을 평가합니다.

PHP 프레임워크의 경량 옵션은 애플리케이션 성능에 어떤 영향을 줍니까?

Jun 06, 2024 am 10:53 AM

PHP 프레임워크의 경량 옵션은 애플리케이션 성능에 어떤 영향을 줍니까?

Jun 06, 2024 am 10:53 AM

경량 PHP 프레임워크는 작은 크기와 낮은 리소스 소비를 통해 애플리케이션 성능을 향상시킵니다. 그 특징은 다음과 같습니다: 작은 크기, 빠른 시작, 낮은 메모리 사용량, 향상된 응답 속도 및 처리량, 리소스 소비 감소 실제 사례: SlimFramework는 500KB에 불과한 REST API를 생성하며 높은 응답성과 높은 처리량을 제공합니다.

Golang 프레임워크 문서화 모범 사례

Jun 04, 2024 pm 05:00 PM

Golang 프레임워크 문서화 모범 사례

Jun 04, 2024 pm 05:00 PM

Golang 프레임워크에서는 명확하고 포괄적인 문서를 작성하는 것이 중요합니다. 모범 사례에는 Google의 Go 코딩 스타일 가이드와 같은 확립된 문서 스타일을 따르는 것이 포함됩니다. 제목, 부제, 목록 등 명확한 조직 구조를 사용하고 탐색 기능을 제공하세요. 시작 안내서, API 참조 및 개념을 포함하여 포괄적이고 정확한 정보를 제공합니다. 코드 예제를 사용하여 개념과 사용법을 설명합니다. 문서를 계속 업데이트하고, 변경 사항을 추적하고, 새로운 기능을 문서화하세요. GitHub 문제 및 포럼과 같은 지원 및 커뮤니티 리소스를 제공합니다. API 문서와 같은 실용적인 예제를 만듭니다.

다양한 애플리케이션 시나리오에 가장 적합한 golang 프레임워크를 선택하는 방법

Jun 05, 2024 pm 04:05 PM

다양한 애플리케이션 시나리오에 가장 적합한 golang 프레임워크를 선택하는 방법

Jun 05, 2024 pm 04:05 PM

애플리케이션 시나리오를 기반으로 최고의 Go 프레임워크를 선택하세요. 애플리케이션 유형, 언어 기능, 성능 요구 사항 및 생태계를 고려하세요. Common Go 프레임워크: Gin(웹 애플리케이션), Echo(웹 서비스), Fiber(높은 처리량), gorm(ORM), fasthttp(속도). 실제 사례: REST API(Fiber) 구축 및 데이터베이스(gorm)와 상호 작용. 프레임워크를 선택하세요. 주요 성능을 위해서는 fasthttp를 선택하고, 유연한 웹 애플리케이션을 위해서는 Gin/Echo를, 데이터베이스 상호작용을 위해서는 gorm을 선택하세요.

PHP 프레임워크의 학습 곡선은 다른 언어 프레임워크와 어떻게 비교됩니까?

Jun 06, 2024 pm 12:41 PM

PHP 프레임워크의 학습 곡선은 다른 언어 프레임워크와 어떻게 비교됩니까?

Jun 06, 2024 pm 12:41 PM

PHP 프레임워크의 학습 곡선은 언어 숙련도, 프레임워크 복잡성, 문서 품질 및 커뮤니티 지원에 따라 달라집니다. PHP 프레임워크의 학습 곡선은 Python 프레임워크에 비해 높고 Ruby 프레임워크에 비해 낮습니다. Java 프레임워크에 비해 PHP 프레임워크는 학습 곡선이 적당하지만 시작하는 데 걸리는 시간이 더 짧습니다.

다시 OpenAI의 방해를 받아 Google은 오픈 소스 시각적 언어 모델인 PaliGemma를 출시했습니다.

Jun 09, 2024 am 09:17 AM

다시 OpenAI의 방해를 받아 Google은 오픈 소스 시각적 언어 모델인 PaliGemma를 출시했습니다.

Jun 09, 2024 am 09:17 AM

머리말 이 모델은 개방형 구성 요소인 SigLIP 시각적 모델과 Gemma 언어 모델을 결합하여 PaliGemma를 비전과 언어를 결합한 작업 처리에 탁월하게 만듭니다. PaliGemma의 사용 시나리오에는 이미지 자막, 이미지 태그 및 시각적 질문 답변이 포함됩니다. 이러한 애플리케이션 시나리오는 이미지 콘텐츠를 이해하고 주요 기능을 추출하는 PaliGemma의 기능을 활용한 다음 이 정보를 언어 출력으로 변환하여 사용자와의 상호 작용 또는 자동화된 콘텐츠 생성을 가능하게 합니다. 이러한 유연성 덕분에 PaliGemma는 연구 개발 환경뿐만 아니라 고객 서비스, 콘텐츠 추천 시스템 등과 같은 상용 애플리케이션에도 적합합니다. 그림 PaliGemma가 할 수 있는 작업 메시지가 표시되면 그림을 사용할 수 있습니다.

Java 프레임워크의 성능 비교

Jun 04, 2024 pm 03:56 PM

Java 프레임워크의 성능 비교

Jun 04, 2024 pm 03:56 PM

벤치마크에 따르면 소규모 고성능 애플리케이션의 경우 Quarkus(빠른 시작, 낮은 메모리) 또는 Micronaut(TechEmpower 우수)가 이상적인 선택입니다. SpringBoot는 대규모 풀 스택 애플리케이션에 적합하지만 시작 시간과 메모리 사용량이 약간 느립니다.

golang 프레임워크 개발에 대한 자세한 실제 설명: 질문과 답변

Jun 06, 2024 am 10:57 AM

golang 프레임워크 개발에 대한 자세한 실제 설명: 질문과 답변

Jun 06, 2024 am 10:57 AM

Go 프레임워크 개발에서 일반적인 과제와 해결 방법은 다음과 같습니다. 오류 처리: 관리에는 오류 패키지를 사용하고 중앙에서 오류를 처리하려면 미들웨어를 사용합니다. 인증 및 권한 부여: 타사 라이브러리를 통합하고 사용자 정의 미들웨어를 생성하여 자격 증명을 확인합니다. 동시 처리: 고루틴, 뮤텍스 및 채널을 사용하여 리소스 액세스를 제어합니다. 단위 테스트: 격리를 위해 getest 패키지, 모의 및 스텁을 사용하고, 충분성을 보장하기 위한 코드 적용 도구를 사용합니다. 배포 및 모니터링: Docker 컨테이너를 사용하여 배포를 패키징하고, 데이터 백업을 설정하고, 로깅 및 모니터링 도구를 사용하여 성능과 오류를 추적합니다.