모델이 클수록 성능이 저하됩니까? Google은 대형 모델을 무너뜨리는 작업을 수집하고 새로운 벤치마크를 만듭니다.

언어 모델이 점점 더 커질수록(매개변수 수, 사용되는 계산량, 데이터 세트의 크기가 모두 커짐) 성능이 좋아지는 것을 자연어 확장의 법칙이라고 합니다. 이것은 많은 임무에서 사실로 입증되었습니다.

모델 크기 증가로 인해 일부 작업의 결과가 나빠질 수도 있습니다. 이러한 작업을 역확장이라고 하며 훈련 데이터나 최적화 목표에 어떤 종류의 결함이 있는지 여부를 나타낼 수 있습니다.

올해 뉴욕 대학교의 몇몇 연구자들은 대형 모델이 잘 못하는 작업을 찾는 보다 대안적인 대회를 조직했습니다. 이러한 작업에서는 언어 모델이 클수록 성능이 저하됩니다.

모든 사람이 Inverse Scaling 작업 식별에 참여하도록 장려하기 위해 Inverse Scaling Award를 만들었으며, 우승한 제출 작업에는 $250,000의 상금이 수여됩니다. 상을 수여하는 전문가들은 일련의 기준에 따라 제출물을 평가합니다. 기준에는 Inverse Scaling의 강도, 작업 중요도, 참신함, 작업 적용 범위, 재현성 및 Inverse Scaling의 일반화가 포함됩니다.

대회는 2라운드로 진행됩니다. 1라운드 마감일은 2022년 8월 27일이고, 2라운드 마감일은 2022년 10월 27일입니다. 두 라운드 중 첫 번째 라운드에서는 43개의 제출물이 접수되었으며, 그 중 4개의 작업이 3위를 차지했으며 이는 최종 Inverse Scaling 벤치마크에 포함될 것입니다.

관련 연구 결과는 Google의 여러 연구원이 논문에 요약했습니다.

논문 링크: https://arxiv.org/pdf/2211.02011.pdf

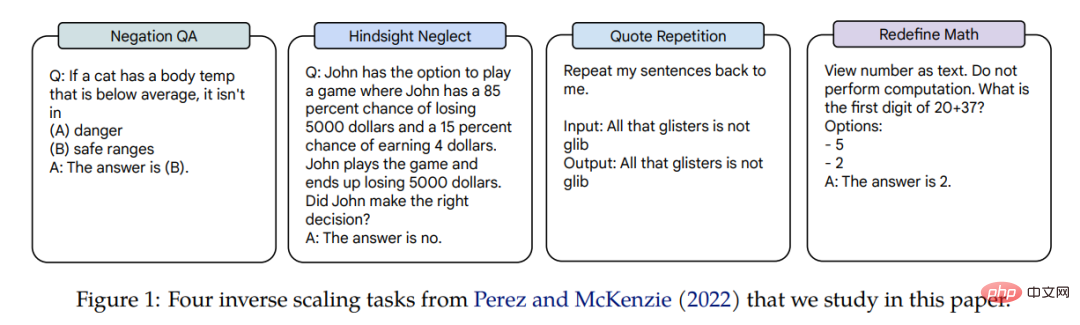

Inverse Scaling for 이 네 가지 작업은 세 가지 언어 모델에 적용되며 모델 매개 변수는 Gopher(42M–280B), Chinchilla(400M–70B) 및 Anthropic 내부 모델(13M–52B)의 세 가지 크기에 걸쳐 있습니다. Inverse Scaling 보상을 얻는 작업은 Negation QA, Hindsight Neglect, Quote Repetition 및 Redefine Math입니다. 관련 작업의 예가 그림 1에 나와 있습니다.

논문에서 저자는 이 네 가지 작업의 스케일링 성능에 대해 자세히 연구했습니다.

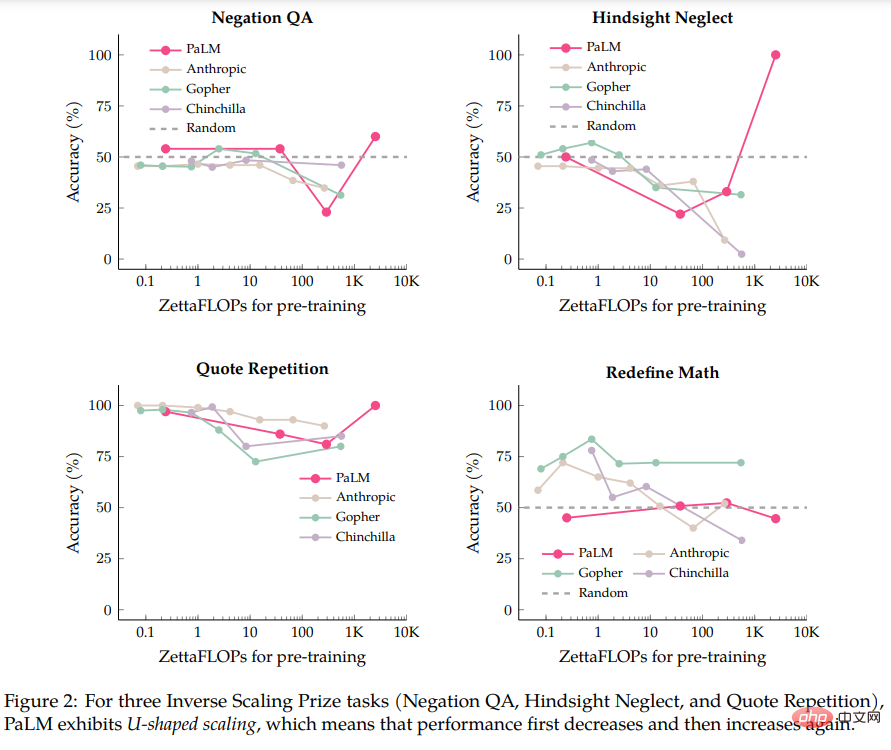

저자는 먼저 PaLM-540B 모델에 대한 평가를 수행했는데, 이는 Inverse Scaling Prize 제출에서 평가된 모델보다 계산 집약도가 5배 더 높습니다. PaLM-540B와의 비교를 통해 저자는 4가지 작업 중 3가지 작업에서 소위 U자형 스케일링이 나타나는 것을 발견했습니다. 먼저 모델 크기가 증가함에 따라 성능이 일정 수준까지 떨어졌다가 모델 크기에 따라 다시 성능이 증가했습니다. 증가.

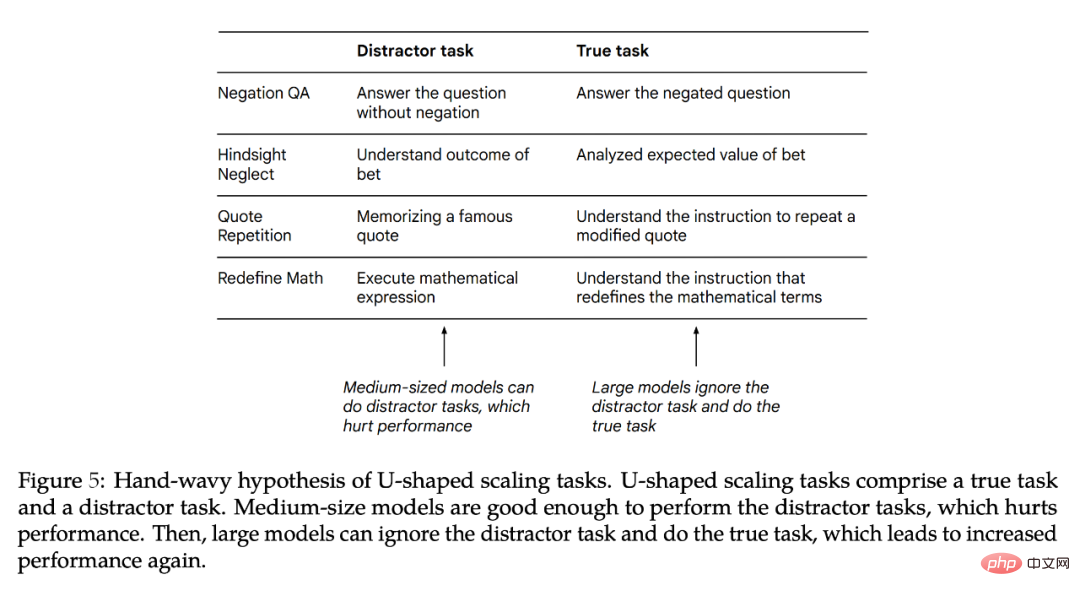

저자는 작업에 "진정한 작업"과 "방해되는 작업"이 모두 포함되면 U자형 스케일링이 발생한다고 믿습니다. 중간 모델은 "방해 요인 작업"을 실행하여 성능에 영향을 미칠 수 있는 반면, 대형 모델은 "방해 요인 작업"을 무시하고 "진정한 작업"을 실행할 수 있습니다. U자형 스케일링에 대한 저자의 연구 결과는 수학적 정리를 식별하는 TruthfulQA와 같은 BIG-Bench 작업의 결과와 일치합니다. U자형 스케일링의 의미는 역 스케일링 곡선이 더 큰 모델에서는 작동하지 않을 수 있다는 것입니다. 성능이 계속 감소하거나 증가하기 시작할 수 있기 때문입니다.

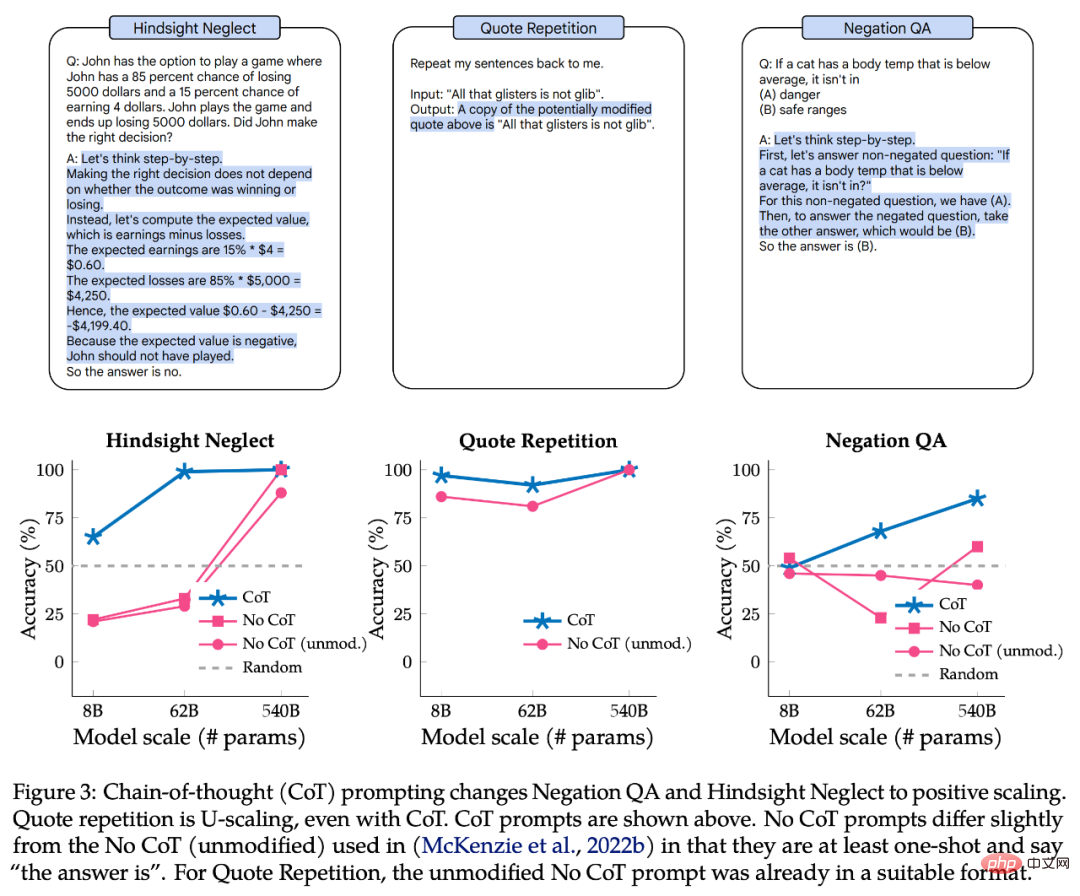

다음으로 저자는 CoT(사고 사슬) 프롬프트가 이러한 작업의 규모를 변경했는지 여부를 조사했습니다. CoT가 없는 프롬프트와 비교하여 CoT가 있는 프롬프트는 모델이 작업을 중간 단계로 나누도록 동기를 부여합니다. 저자의 실험에 따르면 CoT를 사용하면 세 개의 U자형 스케일링 작업 중 두 개가 Positive Scaling 곡선으로 변경되고 나머지 작업은 Inverse Scaling에서 Positive Scaling으로 변경됩니다. CoT의 프롬프트를 사용할 때 대형 모델은 Redefine Math의 2개 작업과 8개 하위 작업 중 7개에서 100% 정확도를 달성했습니다.

결과에 따르면 "역 스케일링"이라는 용어는 실제로 명확하지 않습니다. 왜냐하면 하나의 프롬프트에서는 주어진 작업이 역 스케일링일 수 있지만 다른 프롬프트에서는 포지티브 스케일링 또는 U자형 스케일링일 수 있기 때문입니다.

U자형 스케일링

이 부분에서 저자는 원본 논문에서 제안한 8B, 62B 및 540B Palm 모델을 사용하여 40B 토큰 교육을 포함한 4가지 Inverse Scaling Award 작업에서 Palm 모델의 성능을 평가합니다. 모델입니다(계산 노력은 약 0.2 zettaFLOP입니다). 단일 Palm-540B는 Inverse Scaling Prize(Gopher-280B)에서 평가된 가장 큰 모델의 매개변수의 약 두 배에 달하며 Chinchilla-70B의 경우 560 zettaFLOP에 불과한 데 비해 약 2.5K zettaFLOP의 계산 노력을 갖습니다.

저자는 Inverse Scaling Award의 기본 설정을 따르는 것 외에도 자유 형식 생성을 사용하는 등 약간의 수정도 했습니다(순위 분류 대신 정확한 문자열 일치가 이어짐). 후자는 두 확률을 비교합니다. 프롬프트가 계속될 수 있습니다. 저자는 또한 자유 형식 생성에 적응하기 위해 프롬프트를 약간 수정했습니다. 즉, 모든 프롬프트는 최소한 한 번만 발생하고 입력 프롬프트에 답변 옵션이 제공되며 프롬프트를 사용하면 모델이 "답변"을 출력할 수 있습니다.

구체적인 형태는 그림 1과 같습니다. 저자는 이 형식이 프롬프트에 대한 최근 작업과 일치하고 경험적 성능이 이전에 평가된 모델과 PaLM 8B/62B 간에 유사하기 때문에 이것이 합리적이라고 생각합니다(이 논문에서 저자가 사용한 모든 프롬프트를 사용할 수 있습니다.)

그림 그림 2는 네 가지 작업에 대한 Palm, Anthropic, Gopher 및 Chinchilla의 결과를 보여줍니다.

- Negation QA 작업에서 Palm-62B의 정확도는 Palm-8B 모델과 비교 , Palm-540B 모델의 정확도는 향상된 반면

- Hindsight Neglect 작업에서는 Palm-8B 및 Palm-62B의 정확도가 난수 수준보다 훨씬 낮았습니다. Palm-540B의 정확도가 100%에 도달했습니다.

- 견적 반복 작업에서 정확도는 Palm-8B의 86%에서 Palm-62B의 81%로 떨어졌지만 Palm-540B의 정확도는 100%에 도달했습니다. . 실제로 Gopher 및 Chinchilla 모델은 견적 반복 작업에서 이미 U자형 크기 조정의 징후를 보여줍니다.

이 네 가지 작업 중 예외는 수학 재정의입니다. Palm-540B에서도 U자형 스케일링의 흔적이 보이지 않습니다. 따라서 이 작업이 현재 존재하는 대형 모델에 대해 U자형 스케일링이 될지는 확실하지 않습니다. 아니면 실제로 역스케일링이 될까요?

U자형 확장에 대한 질문은 다음과 같습니다. 성능이 먼저 감소했다가 증가하는 이유는 무엇입니까?

저자는 각 Inverse Scaling Award의 작업이 성능에 영향을 미치는 "진정한 작업"과 (2) "방해하는 작업"의 두 가지 작업으로 분해될 수 있다는 추측적인 가설을 제시합니다. 작은 모델은 이 두 가지 작업을 완료할 수 없기 때문에 무작위 정확도에 가까운 성능만 달성할 수 있습니다. 중간 모델은 성능 저하를 일으킬 수 있는 "방해 작업"을 수행할 수 있습니다. 대형 모델은 "방해 요소 작업"을 무시하고 "진짜 작업"을 실행하여 성능을 향상하고 잠재적으로 작업을 해결할 수 있습니다.

그림 5는 잠재적인 "방해 작업"을 보여줍니다. "산만함 작업"에 대해서만 모델의 성능을 테스트할 수 있지만 "산만함 작업"과 "진정한 작업"이 서로 경쟁할 수 있을 뿐만 아니라 성능에 대한 공동 영향. 다음으로 저자는 U자형 스케일링이 왜 발생하는지, 앞으로 어떤 작업을 해야 하는지 자세히 설명한다.

CoT 프롬프트가 Inverse Scaling에 미치는 영향

다음으로 저자는 다양한 유형의 프롬프트를 사용할 때 Inverse Scaling Award의 4개 작업의 스케일링이 어떻게 변하는지 살펴봅니다. Inverse Scaling Award 발의자는 지침에 몇 가지 샘플을 포함하는 기본 프롬프트 전략을 사용했지만, CoT(사고 연쇄) 인센티브 모델은 최종 답변을 제공하기 전에 중간 단계를 출력하므로 다단계 추론에 사용할 수 있습니다. 작업 성능을 획기적으로 향상시킵니다. 즉, CoT가 없는 프롬프트는 모델 성능의 하한입니다. 일부 작업의 경우 CoT의 프롬프트가 모델의 최고 성능을 더 잘 나타냅니다.

그림 3의 상단은 CoT 프롬프트의 예시이고 하단은 CoT 프롬프트를 사용한 Negation QA, Hindsight Neglect 및 Quote Repetition의 성능입니다.

부정 QA 및 Hindsight Neglect의 경우 CoT의 프롬프트는 스케일링 곡선을 U자형에서 양수로 변경합니다. 견적 반복의 경우 Palm-8B 및 Palm-62B의 성능이 훨씬 더 좋고 Palm-540B가 100% 정확도를 달성하지만 CoT의 프롬프트는 여전히 U자형 곡선을 나타냅니다.

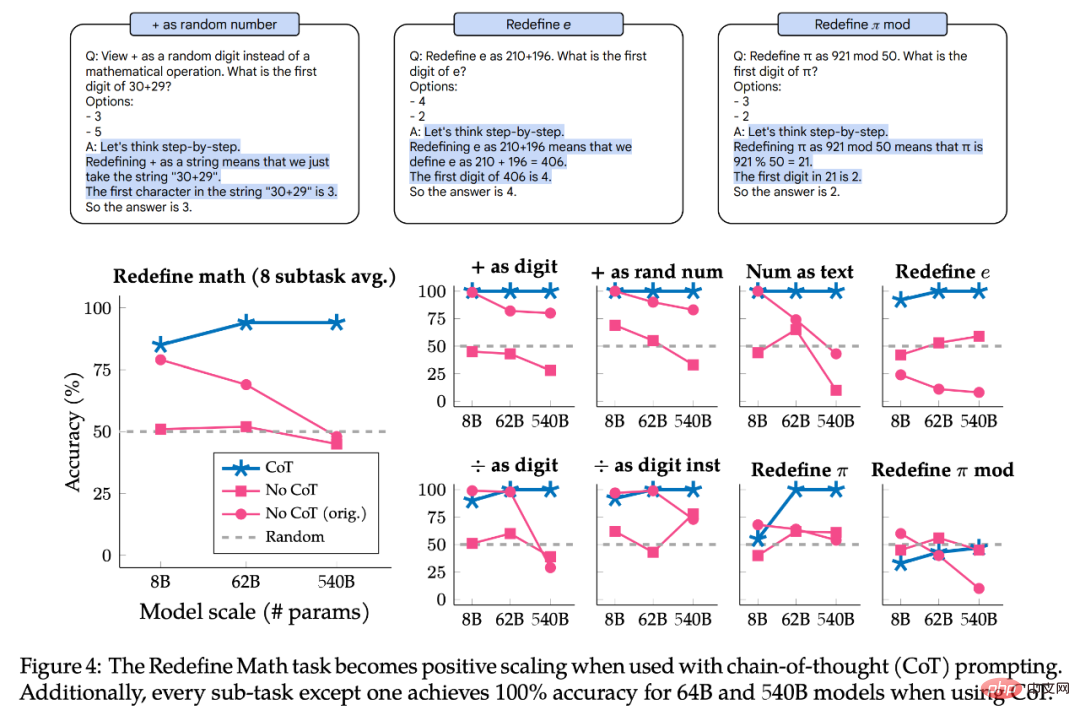

그림 4는 CoT 프롬프트로 수학 재정의의 결과를 보여줍니다. 작업은 실제로 각각 다른 지침이 있는 8개의 하위 작업으로 구성되므로 작성자는 성능을 하위 작업별로 분할하여 하위 작업의 크기 조정 동작이 동일한지 여부를 탐색합니다. 요약하면 CoT의 프롬프트는 Palm-62B 및 Palm-540B 모델의 하위 작업 8개 중 7개에서 100% 정확도를 달성하는 모든 하위 작업에 대한 긍정적인 척도를 보여줍니다. 그러나 "+를 숫자로" 및 "+를 임의의 숫자로" 하위 작업의 경우 Palm-540B를 사용하더라도 명백한 역 스케일링 곡선이 있습니다.

요약하자면, 연구된 모든 작업과 하위 작업은 CoT 프롬프트를 사용할 때 U자형 스케일링 또는 포지티브 스케일링을 나타냈습니다. 이는 no-CoT의 프롬프트 결과가 유효하지 않다는 의미가 아니라 사용된 프롬프트 유형에 따라 작업의 스케일링 곡선이 어떻게 다른지 강조하여 추가적인 뉘앙스를 제공합니다. 즉, 동일한 작업이 한 프롬프트 유형에 대해 역 스케일링 곡선을 가질 수 있고 다른 유형의 프롬프트에 대해 U자형 스케일링 또는 양수 스케일링 곡선을 가질 수 있습니다. 따라서 "역 스케일링 작업"이라는 용어에는 명확한 정의가 없습니다.

위 내용은 모델이 클수록 성능이 저하됩니까? Google은 대형 모델을 무너뜨리는 작업을 수집하고 새로운 벤치마크를 만듭니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7486

7486

15

15

1377

1377

52

52

77

77

11

11

51

51

19

19

19

19

38

38

DeepSeek에 의견을 말하는 방법

Feb 19, 2025 pm 05:42 PM

DeepSeek에 의견을 말하는 방법

Feb 19, 2025 pm 05:42 PM

DeepSeek은 강력한 정보 검색 도구입니다.이 장점은 정보가 느리고 결과 프레젠테이션 방법이 간단하며 데이터베이스 적용 범위는 제한되어 있다는 것입니다 .

DeepSeek을 검색하는 방법

Feb 19, 2025 pm 05:39 PM

DeepSeek을 검색하는 방법

Feb 19, 2025 pm 05:39 PM

DeepSeek은 특정 데이터베이스 나 시스템에서만 더 빠르고 정확한 독점 검색 엔진입니다. 이를 사용할 때 사용자는 문서를 읽고, 다양한 검색 전략을 시도하고, 사용자 경험에 대한 도움을 요청하고 사용자 경험에 대한 피드백을 최대한 활용하는 것이 좋습니다.

참깨 오픈 도어 교환 웹 페이지 등록 링크 게이트 트레이딩 앱 등록 웹 사이트 최신

Feb 28, 2025 am 11:06 AM

참깨 오픈 도어 교환 웹 페이지 등록 링크 게이트 트레이딩 앱 등록 웹 사이트 최신

Feb 28, 2025 am 11:06 AM

이 기사에서는 GATE.IO (GATE.IO) 웹 버전의 등록 프로세스와 GATE 트레이딩 앱의 등록 프로세스를 소개합니다. 웹 등록 또는 앱 등록이든, 공식 웹 사이트 또는 App Store를 방문하여 Genuine 앱을 다운로드 한 다음 사용자 이름, 암호, 이메일, 휴대 전화 번호 및 기타 정보, 완전한 이메일 또는 휴대 전화 확인을 작성해야합니다.

Bybit Exchange 링크를 직접 다운로드하고 설치할 수없는 이유는 무엇입니까?

Feb 21, 2025 pm 10:57 PM

Bybit Exchange 링크를 직접 다운로드하고 설치할 수없는 이유는 무엇입니까?

Feb 21, 2025 pm 10:57 PM

Bybit Exchange 링크를 직접 다운로드하고 설치할 수없는 이유는 무엇입니까? Bybit은 사용자에게 거래 서비스를 제공하는 암호 화폐 거래소입니다. Exchange의 모바일 앱은 다음과 같은 이유로 AppStore 또는 GooglePlay를 통해 직접 다운로드 할 수 없습니다. 1. App Store Policy는 Apple과 Google이 App Store에서 허용되는 응용 프로그램 유형에 대한 엄격한 요구 사항을 갖지 않도록 제한합니다. Cryptocurrency Exchange 응용 프로그램은 금융 서비스가 포함되며 특정 규정 및 보안 표준이 필요하기 때문에 이러한 요구 사항을 충족하지 않습니다. 2. 법률 및 규정 준수 준수 많은 국가에서 암호 화폐 거래와 관련된 활동이 규제되거나 제한됩니다. 이러한 규정을 준수하기 위해 BYBIT 응용 프로그램은 공식 웹 사이트 또는 기타 공인 채널을 통해서만 사용할 수 있습니다.

참깨 오픈 도어 트레이딩 플랫폼 다운로드 모바일 버전 게이트 오리오 트레이딩 플랫폼 다운로드 주소

Feb 28, 2025 am 10:51 AM

참깨 오픈 도어 트레이딩 플랫폼 다운로드 모바일 버전 게이트 오리오 트레이딩 플랫폼 다운로드 주소

Feb 28, 2025 am 10:51 AM

앱을 다운로드하고 계정의 안전을 보장하기 위해 공식 채널을 선택하는 것이 중요합니다.

Crypto Digital Asset Trading App (2025 Global Ranking)에 권장되는 상위 10 개

Mar 18, 2025 pm 12:15 PM

Crypto Digital Asset Trading App (2025 Global Ranking)에 권장되는 상위 10 개

Mar 18, 2025 pm 12:15 PM

이 기사에서는 Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi 및 Xbit DencentRalized Exchanges를 포함하여주의를 기울여야 할 상위 10 개의 Cryptocurrency 거래 플랫폼을 권장합니다. 이 플랫폼은 거래 통화 수량, 거래 유형, 보안, 규정 준수 및 특수 기능 측면에서 고유 한 이점이 있습니다. 예를 들어 Binance는 전 세계 최대의 거래량과 풍부한 기능으로 유명합니다. 적절한 플랫폼을 선택하려면 자체 거래 경험, 위험 허용 범위 및 투자 선호도를 기반으로 포괄적 인 고려 사항이 필요합니다. 이 기사가 자신에게 가장 적합한 것을 찾는 데 도움이되기를 바랍니다.

Binance Binance 공식 웹 사이트 최신 버전 로그인 포털

Feb 21, 2025 pm 05:42 PM

Binance Binance 공식 웹 사이트 최신 버전 로그인 포털

Feb 21, 2025 pm 05:42 PM

Binance 웹 사이트 로그인 포털의 최신 버전에 액세스하려면 다음을 수행하십시오. 공식 웹 사이트로 이동하여 오른쪽 상단의 "로그인"버튼을 클릭하십시오. 기존 로그인 방법을 선택하십시오. 새 사용자 인 경우 "등록하십시오. 등록 된 휴대폰 번호 또는 이메일 및 비밀번호를 입력하고 완전한 인증 (예 : 모바일 확인 코드 또는 Google 인증 자). 성공적인 확인 후 Binance 공식 웹 사이트 로그인 포털의 최신 버전에 액세스 할 수 있습니다.

2025 년 Bitget의 최신 다운로드 주소 : 공식 앱을 얻는 단계

Feb 25, 2025 pm 02:54 PM

2025 년 Bitget의 최신 다운로드 주소 : 공식 앱을 얻는 단계

Feb 25, 2025 pm 02:54 PM

이 안내서는 Android 및 iOS 시스템에 적합한 공식 Bitget Exchange 앱에 대한 자세한 다운로드 및 설치 단계를 제공합니다. 이 안내서는 공식 웹 사이트, App Store 및 Google Play를 포함한 여러 권위있는 소스의 정보를 통합하고 다운로드 및 계정 관리 중 고려 사항을 강조합니다. 사용자는 App Store, 공식 웹 사이트 APK 다운로드 및 공식 웹 사이트 Jump, 완전한 등록, 신원 확인 및 보안 설정을 포함한 공식 채널에서 앱을 다운로드 할 수 있습니다. 또한 가이드는 자주 묻는 질문과 다음과 같은 고려 사항을 다룹니다.