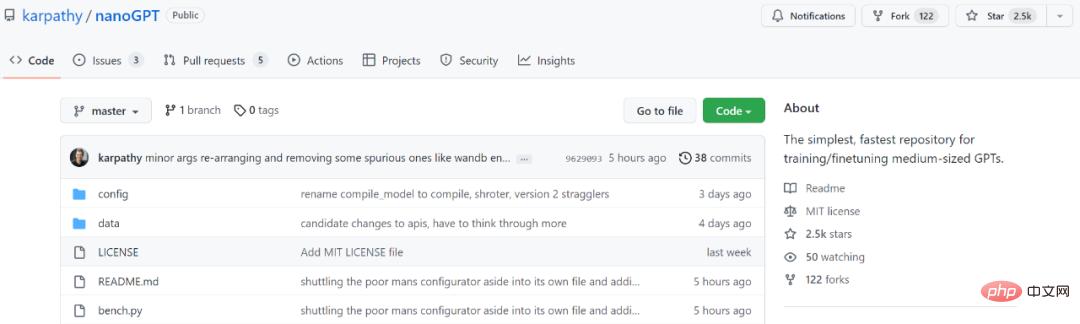

빠르게 별 2,500개를 획득한 Andrej Karpathy는 minGPT 라이브러리를 다시 작성했습니다.

인공지능 분야 '폭력적 미학'의 대표작으로 GPT는 탄생 초기 1억 1700만 개의 매개변수에서 175개까지 치솟았다고 할 수 있다. GPT-3의 10억 매개변수. GPT-3 출시와 함께 OpenAI는 상용 API를 커뮤니티에 공개하여 모든 사람이 GPT-3를 사용하여 더 많은 실험을 시도하도록 장려했습니다. 그러나 API를 사용하려면 애플리케이션이 필요하며 애플리케이션이 아무 소용이 없을 가능성이 높습니다.

제한된 리소스를 가진 연구원들이 대형 모델을 가지고 노는 즐거움을 경험할 수 있도록 전 Tesla AI 디렉터인 Andrej Karpathy는 약 300줄의 코드만으로 PyTorch를 기반으로 하는 작은 GPT 교육 라이브러리를 작성했습니다. 이 minGPT는 추가 작업과 문자 수준의 언어 모델링을 수행할 수 있으며 정확도도 나쁘지 않습니다.

2년 후 minGPT가 업데이트되었으며 Karpathy는 NanoGPT라는 새 버전을 출시했습니다. 이 라이브러리는 중간 크기의 GPT를 훈련하고 미세 조정하는 데 사용됩니다. 출시된 지 불과 며칠 만에 별 2500개를 모았습니다.

프로젝트 주소: https://github.com/karpathy/nanoGPT

프로젝트 소개에서 Karpathy는 다음과 같이 썼습니다. "NanoGPT는 훈련 및 미세 조정 매체에 사용됩니다. scale GPT를 위한 가장 간단하고 빠른 라이브러리입니다. minGPT는 너무 복잡해서 사용하기 꺼려지기 때문입니다. NanoGPT는 아직 개발 중이며 현재 OpenWebText 데이터세트에서 GPT를 재현하는 작업 중입니다.

NanoGPT 코드의 설계 목표는 간단하고 읽기 쉬운 것입니다. 여기서 train.py는 약 300줄의 코드이고, model.py는 선택적으로 GPT-2 가중치를 로드할 수 있는 약 300줄의 GPT 모델 정의입니다. 》

$ cd data/openwebtext

$ python prepare.py

$ python train.py

$ torchrun --standalone --nproc_per_node=4 train.py

$ python sample.py

새 텍스트에서 GPT를 미세 조정하는 방법은 data/shakespeare를 방문하여 prepare.py를 참조하세요. OpenWebText와 달리 이는 몇 초 안에 실행됩니다. 미세 조정에는 시간이 거의 걸리지 않습니다. 예를 들어 단일 GPU에서는 몇 분 밖에 걸리지 않습니다. 다음은 미세 조정 실행의 예입니다

$ python train.py config/finetune_shakespeare.py

위 내용은 빠르게 별 2,500개를 획득한 Andrej Karpathy는 minGPT 라이브러리를 다시 작성했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7555

7555

15

15

1382

1382

52

52

83

83

11

11

59

59

19

19

28

28

96

96

나는 Cursor AI와 함께 Vibe 코딩을 시도했는데 놀랍습니다!

Mar 20, 2025 pm 03:34 PM

나는 Cursor AI와 함께 Vibe 코딩을 시도했는데 놀랍습니다!

Mar 20, 2025 pm 03:34 PM

Vibe Coding은 끝없는 코드 라인 대신 자연 언어를 사용하여 애플리케이션을 생성함으로써 소프트웨어 개발의 세계를 재구성하고 있습니다. Andrej Karpathy와 같은 비전가들로부터 영감을 얻은이 혁신적인 접근 방식은 Dev가

2025 년 2 월 2 일 Genai 출시 : GPT-4.5, Grok-3 & More!

Mar 22, 2025 am 10:58 AM

2025 년 2 월 2 일 Genai 출시 : GPT-4.5, Grok-3 & More!

Mar 22, 2025 am 10:58 AM

2025 년 2 월은 Generative AI의 또 다른 게임 변화 달이었으며, 가장 기대되는 모델 업그레이드와 획기적인 새로운 기능을 제공합니다. Xai 's Grok 3 및 Anthropic's Claude 3.7 Sonnet, Openai 's G에 이르기까지

물체 감지에 Yolo V12를 사용하는 방법은 무엇입니까?

Mar 22, 2025 am 11:07 AM

물체 감지에 Yolo V12를 사용하는 방법은 무엇입니까?

Mar 22, 2025 am 11:07 AM

Yolo (한 번만 보이면)는 주요 실시간 객체 감지 프레임 워크였으며 각 반복은 이전 버전에서 개선되었습니다. 최신 버전 Yolo V12는 정확도를 크게 향상시키는 발전을 소개합니다.

창의적인 프로젝트를위한 최고의 AI 아트 발전기 (무료 & amp; 유료)

Apr 02, 2025 pm 06:10 PM

창의적인 프로젝트를위한 최고의 AI 아트 발전기 (무료 & amp; 유료)

Apr 02, 2025 pm 06:10 PM

이 기사는 최고의 AI 아트 생성기를 검토하여 자신의 기능, 창의적인 프로젝트에 대한 적합성 및 가치에 대해 논의합니다. Midjourney를 전문가에게 최고의 가치로 강조하고 고품질의 사용자 정의 가능한 예술에 Dall-E 2를 추천합니다.

chatgpt 4 o를 사용할 수 있습니까?

Mar 28, 2025 pm 05:29 PM

chatgpt 4 o를 사용할 수 있습니까?

Mar 28, 2025 pm 05:29 PM

ChatGpt 4는 현재 이용 가능하고 널리 사용되며 ChatGpt 3.5와 같은 전임자와 비교하여 상황을 이해하고 일관된 응답을 생성하는 데 상당한 개선을 보여줍니다. 향후 개발에는보다 개인화 된 인터가 포함될 수 있습니다

chatgpt보다 어떤 AI가 더 낫습니까?

Mar 18, 2025 pm 06:05 PM

chatgpt보다 어떤 AI가 더 낫습니까?

Mar 18, 2025 pm 06:05 PM

이 기사에서는 AI 모델이 Lamda, Llama 및 Grok과 같은 Chatgpt를 능가하는 것에 대해 논의하여 정확성, 이해 및 산업 영향의 장점을 강조합니다. (159 자).

다음 래그 모델에 Mistral OCR을 사용하는 방법

Mar 21, 2025 am 11:11 AM

다음 래그 모델에 Mistral OCR을 사용하는 방법

Mar 21, 2025 am 11:11 AM

Mistral OCR : 복수 문서 이해를 가진 검색 방지 생성 혁신 RAG (Resprieved-Augmented Generation) 시스템은 AI 기능을 크게 발전시켜보다 정보에 입각 한 대응을 위해 방대한 데이터 저장에 액세스 할 수 있도록했습니다.

컨텐츠 생성을 향상시키기 위해 AI를 쓰는 최고 AI 작문

Apr 02, 2025 pm 06:11 PM

컨텐츠 생성을 향상시키기 위해 AI를 쓰는 최고 AI 작문

Apr 02, 2025 pm 06:11 PM

이 기사는 Grammarly, Jasper, Copy.ai, Writesonic 및 Rytr와 같은 최고의 AI 작문 조수에 대해 논의하여 콘텐츠 제작을위한 독특한 기능에 중점을 둡니다. Jasper는 SEO 최적화가 뛰어나고 AI 도구는 톤 구성을 유지하는 데 도움이된다고 주장합니다.