소비자급 GPU로 단 하루 만에 학습하면 어떤 BERT 모델을 얻을 수 있나요?

최근 언어 모델이 다시 한번 AI 분야에 불을 지폈습니다. 사전 학습된 언어 모델의 비지도 학습 속성을 통해 대규모 샘플을 기반으로 학습할 수 있으며, 분류든 질문 및 답변이든 많은 양의 의미적, 문법적 지식을 얻을 수 있어 AI가 수행하는 데는 문제가 없을 것으로 보입니다. 해결할 수 없습니다.

그러나 대형 모델은 기술적 혁신을 가져올 뿐만 아니라 컴퓨팅 성능에 대한 끊임없는 요구도 따릅니다.

최근 메릴랜드 대학의 Jonas Geiping과 Tom Goldstein은 계산 확장에 관한 모든 연구를 논의하고 계산 축소의 개선 방향을 탐구했습니다. 그들의 연구는 머신러닝 커뮤니티의 주목을 끌었습니다.

새로운 연구에서 저자는 단일 소비자급 GPU(RTX 2080Ti)로 어떤 종류의 언어 모델을 훈련할 수 있는지 논의하고 흥미로운 결과를 얻었습니다. 어떻게 구현되는지 살펴보겠습니다.

자연어 처리(NLP) 분야에서는 Transformer 아키텍처를 기반으로 사전 학습된 모델이 주류가 되었으며 많은 혁신을 가져왔습니다. 대부분 이러한 모델이 강력한 성능을 발휘하는 이유는 규모가 크기 때문입니다. 모델 매개변수와 데이터의 양이 증가함에 따라 모델 성능은 계속해서 향상될 것입니다. 따라서 NLP 분야 내에서는 모델 크기를 늘리려는 경쟁이 벌어지고 있습니다.

그러나 대규모 언어 모델(LLM)을 훈련할 수 있다고 믿는 연구원이나 실무자는 거의 없으며 일반적으로 업계의 거대 기술 기업만이 LLM을 훈련할 수 있는 리소스를 가지고 있습니다.

이러한 추세를 반전시키기 위해 메릴랜드 대학의 연구자들은 몇 가지 탐색을 수행했습니다.

논문 "Cramming: Training a Language Model on a Single GPU in One Day":

논문 링크: https://arxiv.org/abs/2212.14034

이 질문은 대부분의 연구자와 실무자를 위한 것입니다. 모델 훈련 비용의 참고자료가 될 뿐만 아니라 극도로 높은 LLM 훈련 비용의 병목 현상을 해소할 수 있을 것으로 기대된다는 점에서 큰 의미가 있습니다. 연구 논문은 트위터에서 빠르게 관심과 토론을 불러일으켰습니다.

IBM의 NLP 연구 전문가인 Leshem Choshen은 Twitter에 다음과 같이 말했습니다. "이 문서는 여러분이 생각할 수 있는 모든 대규모 모델 훈련 트릭을 요약합니다."

메릴랜드 대학의 연구자들은 다음과 같이 믿습니다. press 축소된 모델 사전 훈련이 대규모 사전 훈련의 실행 가능한 시뮬레이션이라면 현재 달성하기 어려운 일련의 대규모 모델에 대한 추가 학문적 연구가 열릴 것입니다.

더 나아가 본 연구에서는 모델 크기의 영향뿐만 아니라 지난 몇 년간 NLP 분야의 전반적인 발전을 벤치마킹하려고 합니다.

이 연구에서는 시험 전날 전체 언어 모델을 배우는 '벼락치기'라는 과제를 만들었습니다. 연구원들은 먼저 훈련 파이프라인의 측면을 분석하여 어떤 수정이 소규모 시뮬레이션 모델의 성능을 실제로 향상시킬 수 있는지 이해했습니다. 그리고 연구에 따르면 이렇게 제한된 환경에서도 모델 성능은 대규모 컴퓨팅 환경에서 관찰되는 확장 법칙을 엄격하게 따릅니다.

모델 아키텍처가 작을수록 기울기 계산 속도가 빨라지지만 전체 모델 개선 속도는 시간이 지나도 거의 동일하게 유지됩니다. 본 연구에서는 모델 크기에 영향을 주지 않고 기울기 계산의 효율성을 향상시켜 성능 향상을 얻기 위해 확장 법칙을 사용하려고 합니다. 결국, 이 연구는 낮은 교육 비용으로 GLUE 작업에서 BERT에 가깝거나 심지어 이를 초과하는 훌륭한 성능을 갖춘 모델을 성공적으로 교육했습니다.

일반 종사자와 연구자의 자원 환경을 시뮬레이션하기 위해 본 연구에서는 먼저 자원이 제한된 연구 환경을 구축했습니다.

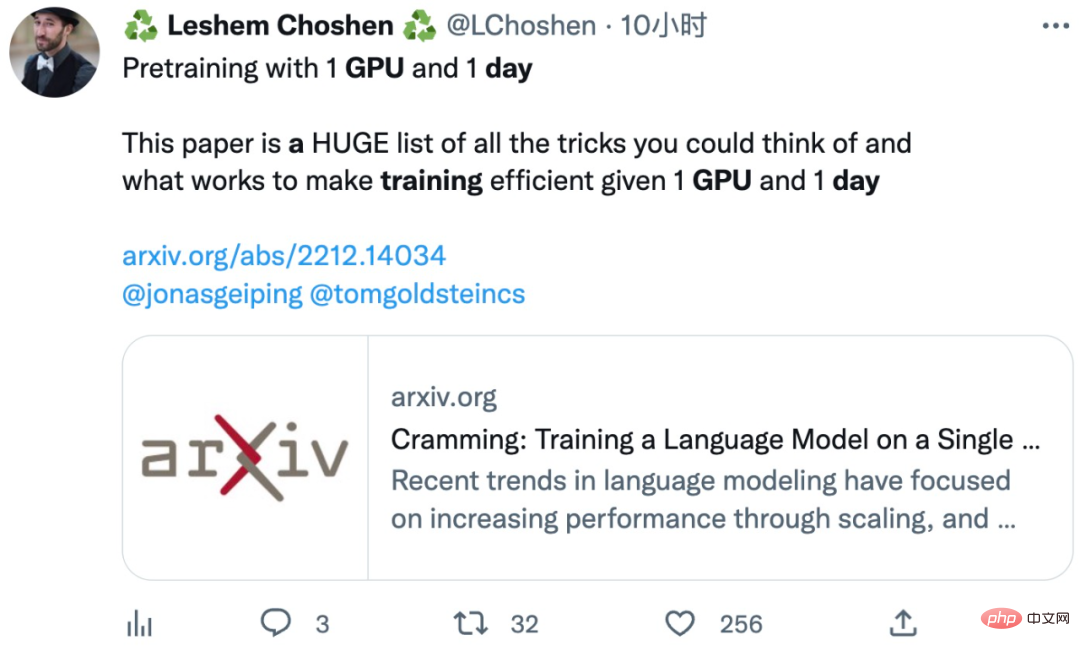

이 연구의 특정 훈련 설정과 일부 고전적인 대형 모델의 비교는 다음 표에 나와 있습니다.

연구원들은 일반적인 구현 및 초기 데이터 설정을 시도하고 아키텍처 수정, 교육 및 데이터 세트 수정을 시도했습니다.

실험은 PyTorch에서 수행되며 가능한 한 공정하게 특수 구현을 사용하지 않고 모든 것이 PyTorch 프레임워크의 구현 수준에서 유지되며 모든 구성 요소에 적용할 수 있는 자동 연산자 융합만 허용됩니다. 효율적인 주의 커널은 아키텍처 변형 후에만 다시 활성화됩니다.

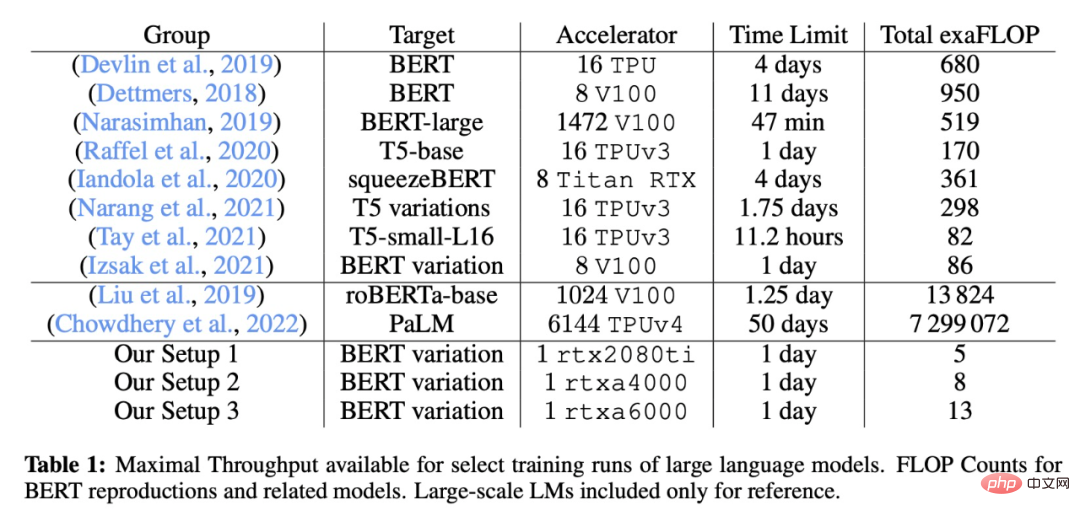

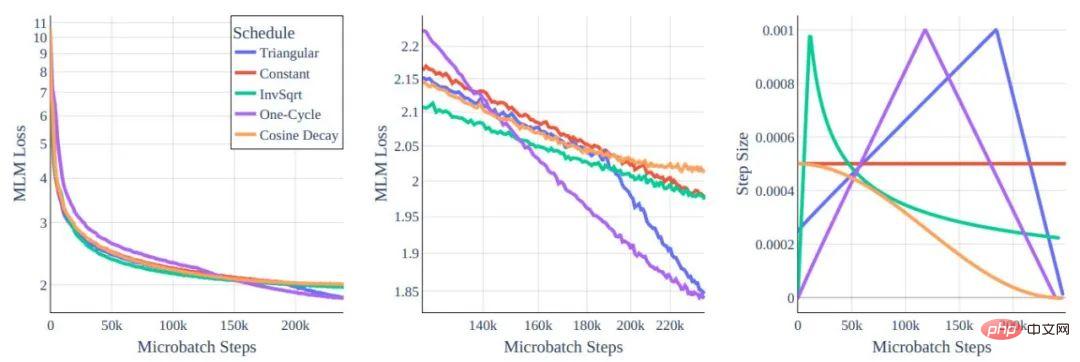

그림 1: MLM 손실 함수와 다양한 변환기 아키텍처 변형의 토큰 비교

왼쪽: 전역 보기. 오른쪽: 10e8 및 더 많은 토큰으로 확대되었습니다.

모든 모델은 동일한 컴퓨팅 성능 비용으로 훈련되었습니다. 아키텍처 재구성을 통해 달성한 개선 효과가 미미하다는 것을 알 수 있습니다.

성능 향상과 관련하여 우리가 가장 먼저 생각하는 방법은 확실히 모델 아키텍처를 수정하는 것입니다. 직관적으로 하루에 카드 1개를 학습하는 데는 더 작은/저용량 모델이 최적인 것 같습니다. 그러나 모델 유형과 훈련 효율성 사이의 관계를 연구한 후 연구원들은 확장 법칙이 규모 축소에 큰 장애물을 만든다는 사실을 발견했습니다. 각 토큰의 훈련 효율성은 변환기 유형보다는 모델 크기에 따라 크게 달라집니다.

또한 더 작은 모델은 덜 효율적으로 학습하므로 처리량 증가가 크게 느려집니다. 다행스럽게도 동일한 크기의 모델에서 훈련 효율성이 거의 동일하다는 사실은 유사한 매개변수 번호를 가진 적합한 아키텍처를 찾을 수 있으며 주로 단일 경사 단계에 영향을 미치는 계산 시간을 기반으로 설계를 선택할 수 있음을 의미합니다.

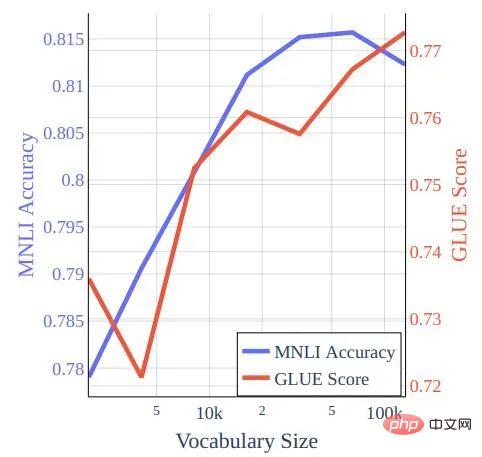

그림 2: 학습률 일정

행동은 전 세계적으로 유사하지만 중간 확대를 보면 차이가 있음을 알 수 있습니다.

이 작업에서 저자는 하이퍼파라미터 훈련이 BERT 기반 아키텍처에 미치는 영향을 연구했습니다. 당연히 원래 BERT 교육 방법의 모델은 Cramming 스타일 교육 요구 사항에 따라 잘 수행되지 않았기 때문에 연구원들은 몇 가지 표준 선택을 다시 검토했습니다.

저자는 데이터 세트를 최적화하는 아이디어도 연구했습니다. 확장의 법칙은 아키텍처 수정으로 인한 상당한 이득(계산 효율성 이상의)을 방지하지만, 확장의 법칙은 더 나은 데이터에 대한 교육을 방해하지 않습니다. 초당 더 많은 토큰을 훈련하려면 더 나은 토큰을 훈련해야 합니다.

그림 3: bookcorpus-wikipedia 데이터에 대한 Cramming 스타일 교육으로 교육된 모델의 어휘 크기 대 GLUE 점수 및 MNLI 정확도.

연구원들은 GLUE 벤치마크와 WNLI의 성능을 체계적으로 평가했으며, 이전 섹션에서는 MNLI(m)만 사용되었으며 전체 GLUE 점수를 기반으로 하이퍼파라미터가 조정되지 않았다는 점에 주목했습니다. 새로운 연구에서 저자는 배치 크기가 32이고 학습 속도가 2 × 10-5인 BERT 기반의 5개 시대에 대한 모든 데이터 세트를 미세 조정했습니다. 이는 Cramming 훈련 모델에 적합하지 않습니다. 이 모델은 배치 크기 16과 코사인 감쇠를 통한 4 × 10−5 학습률에서 약간의 개선을 얻을 수 있습니다(이 설정은 사전 훈련된 BERT 체크포인트를 향상시키지 않습니다).

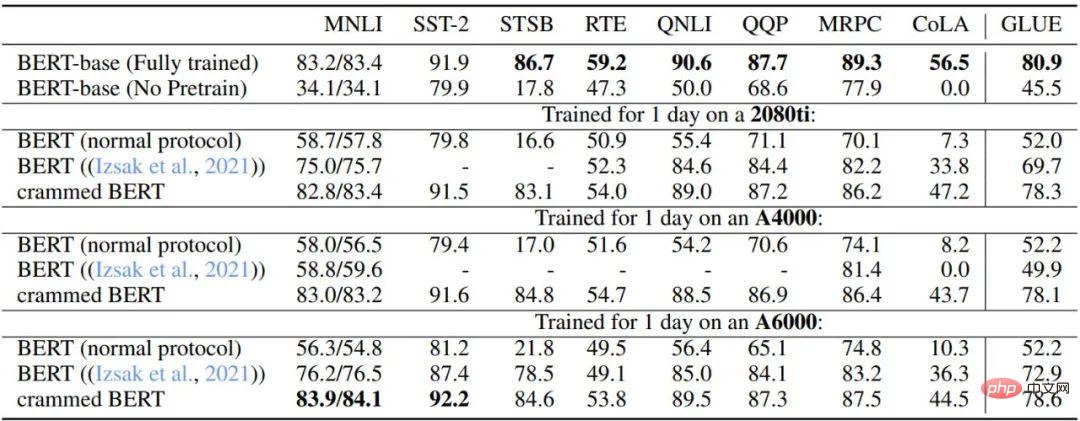

표 3과 표 4는 GLUE 다운스트림 작업에 대한 이 설정의 성능을 설명합니다. 저자는 원래 BERT 기반 체크포인트, 컴퓨팅 파워 한계에 도달한 후 중지되는 BERT 사전 훈련 설정, Izsak et al.의 2021년 연구에서 설명된 설정, GPU당 하루 동안 훈련한 수정된 설정을 비교했습니다. 환경. 전반적으로 성능은 놀라울 정도로 좋으며 특히 MNLI, QQP, QNLI 및 SST-2와 같은 대규모 데이터세트의 경우 다운스트림 미세 조정을 통해 전체 BERT 모델과 Cramming 설정 변형 간의 나머지 차이점을 완화할 수 있습니다.

또한 저자는 컴퓨팅 성능이 제한된 일반 BERT 교육 및 Izsak 외 연구진이 설명한 방법에 비해 새로운 방법이 크게 향상되었음을 발견했습니다. Izsak 등의 연구에서 설명된 방법은 원래 전체 8-GPU 블레이드 서버용으로 설계되었으며 새로운 시나리오에서는 BERT 대형 모델을 더 작은 GPU로 압축하는 것이 대부분의 성능을 담당했습니다. 감소.

표 3: 기본 BERT 및 Cramming 버전 모델의 GLUE-dev 성능 비교

모든 작업의 하이퍼 매개변수는 고정되어 있고 에포크 제한은 5이며 누락된 값은 NaN입니다. 8-GPU 블레이드 서버용으로 설계되었으며 여기서는 모든 컴퓨팅이 단일 GPU에 담겨 있습니다.

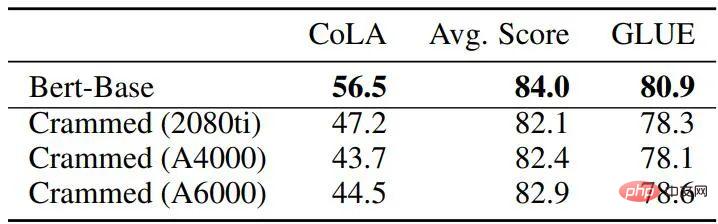

표 4: 기준 BERT와 패딩 모델 간의 GLUE-dev 성능 비교

일반적으로 논문의 방법을 사용하면 훈련 결과가 원래 BERT와 매우 유사하지만 총합은 후자에 사용되는 FLOPS는 45~136배 더 빠른 새로운 방법입니다(16개 TPU에서 4일이 소요됨). 그리고 훈련 시간이 16배(8 GPU에서 2일 훈련) 연장되면 새로운 방법의 성능은 실제로 원래 BERT보다 훨씬 향상되어 RoBERTa 수준에 도달합니다.

이 작업에서 사람들은 계산적으로 매우 제한된 환경에서 변환기 기반 언어 모델이 얼마나 많은 성능을 달성할 수 있는지 논의했습니다. 다행히도 몇 가지 수정 방향을 통해 GLUE에서 우수한 다운스트림 성능을 얻을 수 있습니다. 연구원들은 이 연구가 추가 개선을 위한 기준을 제공하고 최근 몇 년 동안 변압기 아키텍처에 대해 제안된 많은 개선 사항과 기술에 대한 이론적 지원을 제공할 수 있기를 바라고 있습니다.

위 내용은 하루에 하나의 카드 챌린지: RTX2080Ti는 대규모 모델 훈련을 처리하여 컴퓨팅 성능을 136배 절약하고 학계는 환호합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!