정말 중요한 연구! 32편의 논문에서 2022년 AI 핫스팟을 살펴본다

세계가 여전히 회복되고 있는 동안, 특히 인공 지능 분야의 연구는 열광적인 속도를 늦추지 못했습니다.

또한 올해에는 AI 윤리, 편견, 거버넌스 및 투명성이 새롭게 강조되었습니다.

인공지능과 인간 두뇌에 대한 우리의 이해, 그리고 인공지능과의 연관성은 끊임없이 진화하고 있으며 가까운 미래에는 우리 삶의 질을 향상시키는 이러한 애플리케이션이 빛을 발할 것입니다.

유명 블로거 Louis Bouchard도 자신의 블로그에서 2022년에 32개의(!) AI 기술 혁신을 기록했습니다.

이 놀라운 연구가 무엇인지 살펴 보겠습니다!

기사 주소: https://www.louisbouchard.ai/2022-ai-recap/

LaMA: 푸리에 회선을 기반으로 한 해상도 강력한 대형 마스크 수리

이 상황: 당신과 당신의 친구들은 멋진 사진을 찍었습니다. 그 결과, 누군가 당신 뒤에 있어 Moments 또는 Xiaohongshu로 보내고 싶은 사진을 파괴하고 있음을 알게 되었습니다. 하지만 이제는 이것이 더 이상 문제가 되지 않습니다.

푸리에 컨볼루션을 기반으로 하는 강력한 해상도의 대형 마스크 인페인팅 방법을 사용하면 사용자가 이미지에서 원하지 않는 콘텐츠를 쉽게 제거할 수 있습니다. 사람도, 쓰레기통도 쉽게 사라질 수 있습니다.

주머니 속에 전문 PS 디자이너가 있는 듯한, 클릭 한 번으로 쉽게 클리어할 수 있습니다.

간단해 보이지만 이미지 인페인팅은 많은 AI 연구자들이 오랫동안 해결해 온 문제입니다.

논문 링크: https://arxiv.org/abs/2109.07161

프로젝트 주소: https://github.com/saic-mdal/lama

Colab 데모: https://colab.research.google.com/github/saic-mdal/lama/blob/master/colab/LaMa_inpainting.ipynb

동영상 설명: https://youtu.be/Ia79AvGzveQ

간단한 분석: https://www.louisbouchard.ai/lama/

STIT: GAN 기반의 실제 영상 얼굴 편집

이런 경험을 해보셨을 텐데요: 영화를 보면서 , 영화 속 배우들이 자신보다 훨씬 더 젊어 보인다는 것을 알게 될 것입니다.

제미니 맨의 Will Smith

이전에는 전문가가 수백 또는 수천 시간의 작업을 수행하고 이러한 배우가 등장하는 장면을 수동으로 편집해야 했습니다. 하지만 AI를 사용하면 몇 분 안에 할 수 있습니다.

사실 많은 기술을 사용하면 미소를 더 많이 짓고 더 젊어 보이거나 늙어 보이게 만들 수 있으며, 이 모든 작업은 인공 지능 기반 알고리즘을 사용하여 자동으로 수행됩니다. 영상에서는 AI 기반 얼굴조작이라고 불리며 2022년의 최첨단 기술을 표현하고 있다.

논문 링크: https://arxiv.org/abs/2201.08361

프로젝트 주소: https://github.com/rotemtzaban/STIT

영상 설명: https://youtu.be/mqItu9XoUgk

간략 분석: https://www.louisbouchard.ai/stitch-it-in-time/

NeROIC : 온라인 갤러리의 신경 렌더링을 활용

신경 렌더링은 사물, 사람 또는 장면의 사진을 통해 공간에서 사실적인 3D 모델을 생성할 수 있습니다.

이 기술을 사용하면 물체에 대한 몇 장의 사진만 있으면 기계에 사진 속 물체를 이해하고 우주에서 물체가 어떻게 보이는지 시뮬레이션하도록 요청할 수 있습니다.

인간은 현실 세계를 이해하기 때문에 이미지를 통해 사물의 물리적 형태를 이해하는 것이 쉽습니다. 하지만 픽셀만 볼 수 있는 기계의 경우 이는 완전히 다른 문제입니다.

생성된 모델을 어떻게 새로운 장면에 통합할 수 있나요? 사진의 조명 조건과 각도가 다르고 결과 모델이 그에 따라 변경된다면 어떻게 될까요? Snapchat과 University of Southern California가 이 새로운 연구에서 해결해야 할 질문은 다음과 같습니다.

논문 링크: https://arxiv.org/abs/2201.02533

프로젝트 주소: https://github.com/snap-research/NeROIC

영상 설명: https://youtu.be/88Pl9zD1Z78

간단한 분석: https://www.louisbouchard.ai/neroic/

SpeechPainter: 텍스트 조건에서의 음성 복구

이미지용 예를 들어, 머신러닝 기반 인페인팅 기술은 내용을 제거할 수 있을 뿐만 아니라 배경 정보를 기반으로 이미지에서 누락된 부분을 채울 수도 있습니다.

비디오 복원의 경우 프레임 간 일관성을 유지하는 것뿐만 아니라 잘못된 아티팩트 생성을 방지하는 것도 과제입니다. 동시에, 비디오에서 특정 사람을 성공적으로 "쫓아내려면" 그 사람의 목소리도 삭제해야 합니다.

이를 위해 Google 연구원들은 동영상에서 문법, 발음 교정은 물론 배경 소음까지 제거할 수 있는 새로운 음성 복구 방법을 제안했습니다.

논문 링크: https://arxiv.org/abs/2202.07273

영상설명: https://youtu.be/zIIc4bRf5Hg

단편분석: https:// www.louisbouchard.ai/speech-inpainting-with-ai/

GFP-GAN: 생성적 안면 사전 분석을 사용한 실제 맹인 얼굴 복원

오랜 세월 때문에 소중히 여기는 오래된 사진이 있나요? 얼마 전인데 화질이 흐릿한가요? 걱정하지 마십시오. Blind Face Restoration을 사용하면 추억이 영원히 지속될 것입니다.

이 새로운 무료 AI 모델은 대부분의 오래된 사진을 순식간에 복구할 수 있습니다. 복원 전 사진의 품질이 매우 낮더라도 매우 잘 작동합니다. 전에는 이것이 종종 꽤 어려운 일이었습니다.

더 멋진 점은 원하는 방식으로 시도해 볼 수 있다는 것입니다. 그들은 코드를 오픈 소스로 공개하고 모든 사람이 시도해 볼 수 있는 데모 및 온라인 애플리케이션을 만들었습니다. 나는 이 기술이 당신을 놀라게 할 것이라고 믿습니다!

논문 링크: https://arxiv.org/abs/2101.04061

프로젝트 주소: https://github.com/TencentARC/GFPGAN

Colab 데모: https://colab.research.google.com/drive/1sVsoBd9AjckIXThgtZhGrHRfFI6UUYOo

온라인 신청: https://huggingface.co/spaces/akhaliq/GFPGAN

동영상 설명: https://youtu.be/nLDVtzcSeqM

간단한 분석: https://www.louisbouchard.ai/gfp-gan/

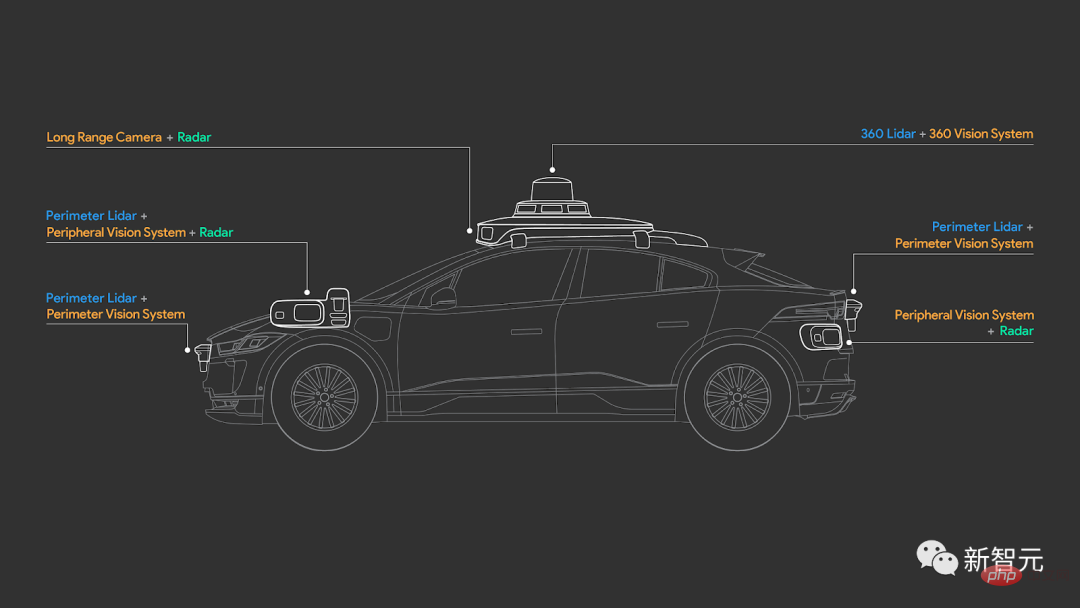

4D-Net: 다중 모드 정렬 학습

자율주행차는 어떻게 '6방향'을 볼 수 있을까?

자동차 회사에서 사용하는 LiDAR 센서나 기타 이상한 카메라에 대해 들어보셨을 것입니다. 하지만 그들은 어떻게 일하고, 세상을 어떻게 보고, 우리와 비교하여 정확히 무엇이 다르게 보일까요?

페이퍼 링크: https://arxiv.org/abs/2109.01066

세상을 이해하기 위해 카메라만 사용하는 Tesla와 달리 Waymo와 같은 대부분의 자율주행차 제조업체는 용도는 일반 카메라와 3D LiDAR 센서입니다.

일반 카메라처럼 이미지를 생성하지 않고 대신 3D 포인트 클라우드를 생성하고 RGB 감지 정보를 사용하여 물체 사이의 거리를 측정하고 물체에 투사하는 펄스 레이저의 이동 시간을 계산합니다.

그럼에도 불구하고, 어떻게 이 정보를 효과적으로 결합하고 차량이 이를 이해할 수 있게 만들 수 있을까요? 차량은 궁극적으로 무엇을 보게 될까요? 자율주행은 충분히 안전할까? Waymo와 Google의 새로운 연구 논문이 이러한 미스터리에 답할 것입니다.

영상 설명: https://youtu.be/0nJMnw1Ldks

간단한 분석: https://www.louisbouchard.ai/waymo-lidar/

Instant NeRF: 멀티 기반 -해상도 비율 해시 인코딩 인스턴트 신경 프리미티브

사진을 통해 세상이 어떻게 보이는지 시뮬레이션하는 방법은 무엇입니까?

AI 모델을 사용하면 사람들은 캡처한 이미지를 고품질 3D 모델로 바꿀 수 있습니다. 이 어려운 작업을 통해 연구자들은 2D 이미지를 사용하여 물체나 사람이 3차원 세계에서 어떻게 보이는지 만들 수 있습니다.

해시 코딩을 기반으로 한 그래픽 프리미티브를 사용하여 NVIDIA는 5초의 NeRF 교육을 달성하고 더 나은 결과를 얻었습니다. 2년이 채 안 되는 연구 기간 동안 NeRF의 훈련 속도는 1,000배 이상 향상되었습니다.

논문 링크: https://arxiv.org/abs/2201.05989

프로젝트 주소: https://github.com/NVlabs/instant-ngp

영상 설명: https://youtu.be/UHQZBQOVAIU

간략 분석: https://www.louisbouchard.ai/nvidia-photos-into-3d-scenes/

DALL· E 2: CLIP 기능을 기반으로 한 텍스트-이미지 생성 모델

지난해 OpenAI는 텍스트-이미지 생성 모델 DALL·E를 출시했습니다. 이제 DALL·E 2의 업그레이드 버전이 다시 등장했습니다.

DALL·E 2는 텍스트에서 사실적인 이미지를 생성할 뿐만 아니라 출력 해상도도 4배나 높습니다!

그러나 OpenAI를 만족시키기에는 성능 향상이 충분하지 않아 DALL·E 2에 이미지 복구라는 새로운 기술을 배우게 했습니다.

즉, DALL·E 2로 이미지를 편집하거나 배경의 플라밍고 등 원하는 새 요소를 추가할 수 있습니다.

논문 링크: https://arxiv.org/abs/2204.06125

영상 설명: https://youtu.be/rdGVbPI42sA

간단한 분석: https ://www.louisbouchard.ai/openais-new-model-dall-e-2-is-amazing/

MyStyle: 개인화된 세대 이전

Google과 Tel Aviv University는 매우 강력한 DeepFake 기술을 제안했습니다. 그것으로 당신은 거의 모든 것을 할 수 있습니다.

한 사람의 사진을 수백 장 찍고, 이미지를 인코딩하고, 원하는 모습을 수정, 편집 또는 만들기만 하면 됩니다.

특히 생성된 결과를 볼 때 놀랍기도 하고 무섭기도 합니다.

논문 링크: https://arxiv.org/abs/2203.17272

프로젝트 주소: https://mystyle-personalized-prior.github.io/

영상 설명: https://youtu.be/BNWAEvFfFvQ

간단한 분석: https://www.louisbouchard.ai/mystyle/

OPT: 사전 훈련된 Transformer 언어 모델 공개

GPT-3를 그토록 강력하게 만드는 것은 아키텍처와 크기입니다.

인간 두뇌의 뉴런 수의 두 배인 1,750억 개의 매개변수를 가지고 있습니다! 이러한 대규모 신경망을 통해 모델은 거의 전체 인터넷을 학습하여 우리가 텍스트를 작성하고 교환하고 이해하는 방법을 이해할 수 있었습니다.

사람들이 GPT-3의 강력한 기능에 놀랐을 때 메타는 오픈 소스 커뮤니티를 향해 큰 발걸음을 내디뎠습니다. 그들은 이제 완전 오픈 소스인 똑같이 강력한 모델을 출시했습니다!

이 모델은 1000억 개 이상의 레벨 매개변수를 가질 뿐만 아니라, GPT-3에 비해 OPT-175B는 더 개방적이고 접근성이 뛰어납니다.

논문 링크: https://arxiv.org/abs/2205.01068

프로젝트 주소: https://github.com/facebookresearch/metaseq

동영상 링크: https://youtu.be/Ejg0OunCi9U

간략한 분석: https://www.louisbouchard.ai/opt-meta/

BlobGAN: 공간적으로 이산적인 장면 표현

장면을 설명하는 방법에 대해 Adobe 연구팀은 BlobGAN이라는 새로운 방법을 제시했습니다.

BlobGAN은 "blob"을 사용하여 장면의 개체를 설명합니다. 연구원은 얼룩을 이동하여 더 크게, 더 작게 만들거나 삭제할 수도 있으며, 이는 이미지에서 나타내는 개체에 동일한 효과를 갖습니다.

저자가 결과를 공유하므로 블롭을 복제하여 데이터세트에 새 이미지를 만들 수 있습니다.

이제 BlobGAN의 코드가 오픈소스로 공개되었습니다. 관심 있는 친구들은 서둘러서 사용해 보세요!

문서 링크: https://arxiv.org/abs/2205.02837

프로젝트 주소: https://github.com/dave-epstein/blobgan

Colab 데모 : https://colab.research.google.com/drive/1clvh28Yds5CvKsYYENGLS3iIIrlZK4xO?usp=sharing#scrollTo=0QuVIyVplOKu

영상 설명: https://youtu.be/mnEzjpiA_4E

간단한 분석: https://www.louisbouchard.ai/blobgan/

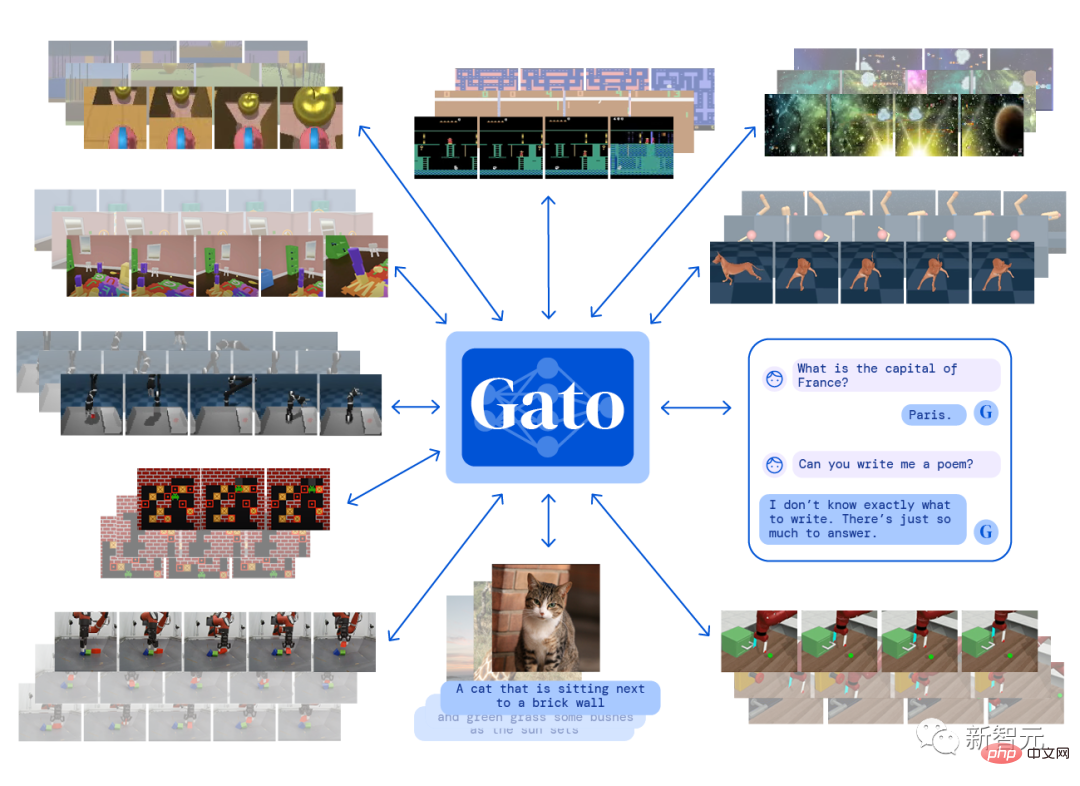

Gato: Generalist Agent

DeepMind는 단일 "일반" 에이전트 Gato를 구축했습니다. Atari 게임을 하고, 자막 이미지를 만들고, 사람들과 채팅하고, 로봇 팔을 제어할 수 있습니다!

더 충격적인 것은 단 한 번의 훈련과 동일한 가중치를 사용하여 모든 작업을 완료할 수 있다는 것입니다.

Gato는 다중 모달 에이전트입니다. 이는 이미지 캡션을 생성하고 질문에 답변하는 챗봇 역할을 모두 수행할 수 있음을 의미합니다.

GPT-3도 채팅을 할 수 있지만 Gato가 더 많은 일을 할 수 있다는 것은 분명합니다. 결국 채팅을 할 수 있는 AI는 많지만 게임을 할 수 있는 AI는 많지 않습니다.

논문 링크: https://arxiv.org/abs/2205.06175

영상 설명: https://youtu.be/xZKSWNv6Esc

짧다 스토리 분석: https://www.louisbouchard.ai/deepmind-gato/

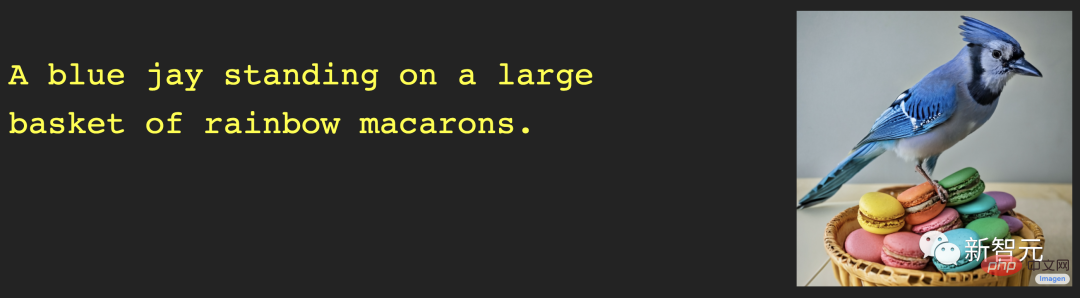

Imagen: 깊은 언어 이해를 갖춘 텍스트-이미지 확산 모델

DALL·E 2가 훌륭하다고 생각한다면 그럴 수도 있습니다. 또한 Google Brain의 새로운 모델인 Imagen을 살펴보세요.

DALL·E는 훌륭하지만 생성된 이미지의 현실성이 부족한 경우가 많습니다. 이것이 바로 Google 팀이 개발한 Imagen의 문제입니다.

텍스트-이미지 모델을 비교한 벤치마크에 따르면 Imagen은 대규모 언어 모델에 대한 텍스트 임베딩을 사용한 텍스트-이미지 합성에서 놀라운 결과를 달성했습니다. 결과 이미지는 상상력이 풍부하고 현실적입니다.

논문 링크: https://arxiv.org/abs/2205.11487

프로젝트 주소: https://imagen.research.google/

영상설명 : https://youtu.be/qhtYPhPWCsI

간략분석 : https://www.louisbouchard.ai/google-brain-imagen/

DALL·E Mini

세트 Xiao Zha의 무서운 사진은 한동안 트위터에서 인기를 끌었습니다. 이 가격 대비 가치가 높은 San 작품 세트는 DALL·E mini에서 제작했습니다.

DALL·E 제품군의 "청소년 에디션"인 DALL·E mini는 무료이며 오픈 소스입니다. 코드는 남았는데 다음 마법개조 캐릭터는 누구일까요?

프로젝트 주소: https://github.com/borisdayma/dalle-mini

온라인 체험: https://huggingface.co/spaces/dalle-mini/dalle-mini

영상 설명: https://youtu.be/K3bZXXjW788

간단한 분석: https://www.louisbouchard.ai/dalle-mini/

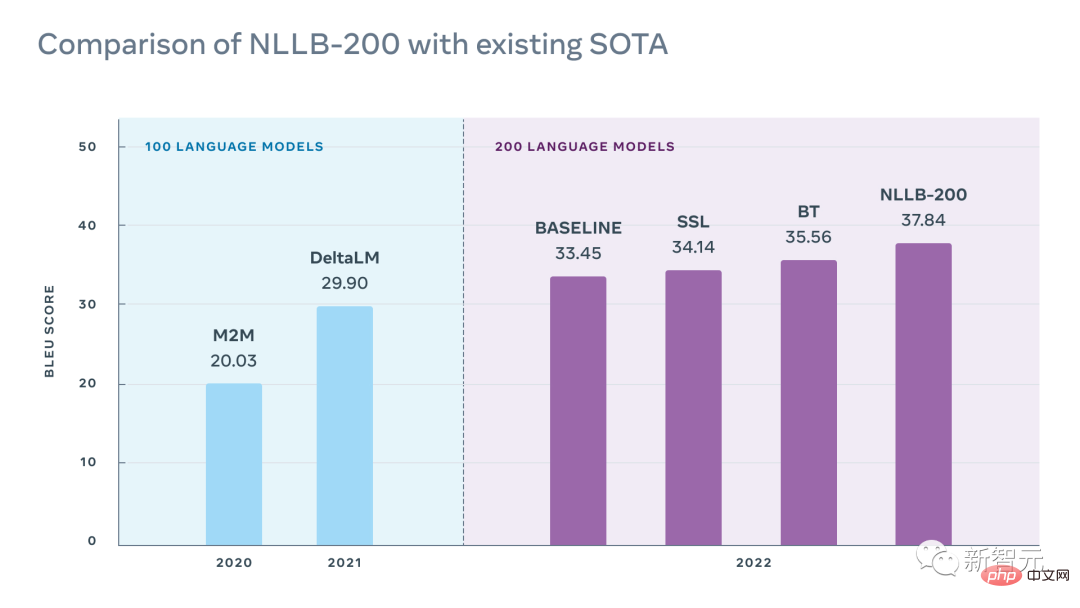

NLLB: 언어가 남지 않습니다

Meta AI는 이 NLLB-200 모델을 출시했습니다. 모델 명명 개념은 "No Language Left Behind"에서 유래되었으며 200개 이상의 언어로 임의 번역이 가능합니다.

연구의 하이라이트는 연구자들이 대부분의 저자원 언어 훈련을 여러 배로 향상시키는 동시에 200개 이상의 언어 번역에 대한 SOTA 결과를 달성했다는 것입니다.

논문 링크: https://research.facebook.com/publications/no-언어-left-behind/

프로젝트 주소: https://github.com/facebookresearch/ fairseq/tree/nllb

온라인 체험: https://nllb.metademolab.com/

영상 설명: https://youtu.be/2G4NeG17Eis

간단한 분석: https://www.louisbouchard.ai/no-언어-left-behind/

듀얼 셔터 광학 진동 감지 시스템

소리도 볼 수 있나요?

CVPR 2022 최우수 논문 명예상을 수상한 본 연구는 "느린" 카메라(130FPS) 진동을 사용하여 여러 장면 소스의 고속(최대 63kHz) 표면을 동시에 감지하는 새로운 듀얼 셔터 방식을 제안합니다. , 오디오 소스로 인한 진동을 캡처하여 이를 수행합니다.

따라서 악기 분리, 소음 제거 등 다양한 요구를 실현할 수 있습니다.

페이퍼 링크: https://openaccess.thecvf.com/content/CVPR2022/papers/Sheinin_Dual-Shutter_Optical_Vibration_Sensing_CVPR_2022_paper.pdf

프로젝트 주소: https://imaging.cs.cmu .edu/vibration/

영상설명 : https://youtu.be/n1M8ZVspJcs

간략분석 : https://www.louisbouchard.ai/cvpr-2022-best -paper/

Make-A-Scene: 인간 사전을 이용한 장면 기반 텍스트-이미지 생성

Make-A-Scene은 단순한 "또 다른 DALL·E"가 아닙니다.

DALL·E가 텍스트 프롬프트를 기반으로 임의의 이미지를 생성할 수 있다는 점은 정말 멋지지만 생성된 결과에 대한 사용자의 제어도 제한됩니다.

Meta의 목표는 이러한 텍스트-이미지 추세를 이전 스케치-이미지 모델과 결합하여 텍스트와 스케치 조건 이미지 생성 간의 연결인 "Make-A-Scene"을 만들어 창의적인 표현을 촉진하는 것입니다. .훌륭한 조화.

논문 링크: https://arxiv.org/abs/2203.13131

영상 설명: https://youtu.be/K3bZXXjW788

간단한 분석: https://www.louisbouchard.ai/make-a-scene/

BANMo: 모든 영상 빌드에서 타겟 3D 애니메이션 모델

Meta의 이번 연구를 바탕으로 고양이와 강아지의 여러 동영상을 업로드하는 등 변형 가능한 개체를 캡처하는 동영상만 제공하면 BANMo는 이를 수천 개의 2D 큐에서 결합할 수 있습니다. 미리 정의된 모양 템플릿이 필요 없이 편집 가능한 애니메이션 3D 모델을 재구성하기 위해 표준 공간에 통합되었습니다.

논문 링크: https://arxiv.org/abs/2112.12761

프로젝트 주소: https://github.com/facebookresearch/banmo

영상설명 : https://youtu.be/jDTy-liFoCQ

간단한 분석 : https://www.louisbouchard.ai/banmo/

잠재확산모델을 이용한 고해상도 영상합성

올해 인기를 끌었던 이미지 생성 모델 DALL·E, Imagen, Stable Diffusion 등 강력한 이미지 생성 모델들의 공통점은 무엇일까요? 높은 계산 비용과 광범위한 훈련 시간 외에도 모두 동일한 확산 메커니즘을 기반으로 합니다.

확산 모델은 최근 DALL·E를 사용한 텍스트-이미지 변환을 포함한 대부분의 이미지 작업과 이미지 인페인팅, 스타일 전송 또는 이미지 초해상도와 같은 기타 여러 이미지 생성 관련 작업에서 SOTA 결과를 달성했습니다.

논문 링크: https://arxiv.org/abs/2112.10752

프로젝트 주소: https://github.com/CompVis/latent-diffusion

영상설명: https://youtu.be/RGBNdD3Wn-g

간단한 분석: https://www.louisbouchard.ai/latent-diffusion-models/

PSG: 장면 기반 이미지 생성 모델

AI는 이미지 속 사물을 정확하게 식별하는 데 도움이 되지만 사물과 환경 간의 관계를 이해하는 것은 그리 쉽지 않습니다.

이를 위해 난양폴리테크닉 연구진은 파노라마 분할을 기반으로 한 파놉틱 장면 그래프 생성(PSG) 작업을 제안했습니다.

감지 프레임을 기반으로 하는 기존 장면 그래프 생성과 비교하여 PSG 작업은 이미지의 모든 관계(물체와 개체 간의 관계, 개체와 배경 간의 관계, 배경과 배경 간의 관계 포함)를 종합적으로 출력해야 합니다. , 정확한 분할 블록을 사용하여 개체 위치를 지정합니다.

논문 링크: https://arxiv.org/abs/2207.11247

프로젝트 주소: https://psgdataset.org/

온라인 신청: https: //huggingface.co/spaces/ECCV2022/PSG

영상설명 : https://youtu.be/cSsE_H_0Cr8

간략분석 : https://www.louisbouchard.ai /psg/

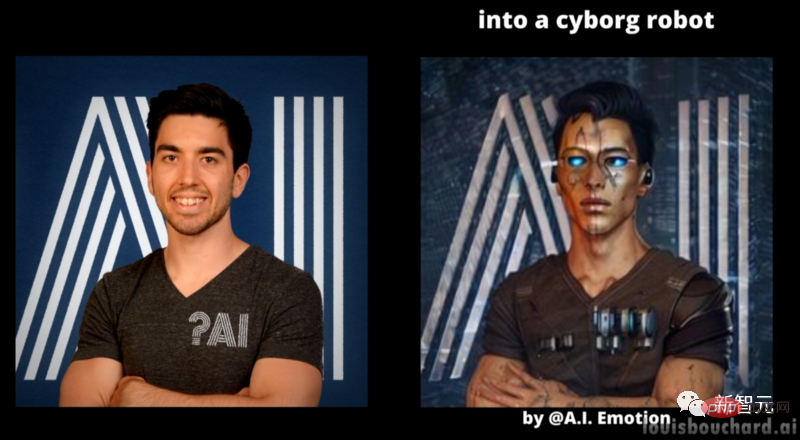

텍스트 반전을 사용하여 텍스트를 이미지로 맞춤 생성하세요

올해 주요 제조사의 이미지 생성 모델은 바다를 건너는 팔선과 같다고 할 수 있으며 각각 마법의 힘을 발휘합니다. 그런데 모델이 특정 스타일의 이미지 작품을 생성하도록 하는 방법은 무엇입니까?

텔아비브 대학교의 학자들과 NVIDIA가 협력하여 원하는 이미지를 DIY할 수 있는 맞춤형 이미지 생성 모델을 출시했습니다.

논문 링크: https://arxiv.org/abs/2208.01618

프로젝트 주소: https://textual-inversion.github.io/

영상 설명: https://youtu.be/f3oXa7_SYek

간단한 분석: https://www.louisbouchard.ai/imageworthoneword/

일반 영상 인식을 위한 언어 이미지 사전 학습 모델

시각적 텍스트 모델 학습은 의심할 여지 없이 큰 성공을 거두었지만 이 새로운 언어 이미지 사전 학습 방법을 비디오 도메인으로 확장하는 방법은 여전히 열려 있는 질문입니다.

Microsoft와 중국과학원의 학자들은 새로운 모델을 처음부터 사전 학습하는 대신 사전 학습된 언어-이미지 모델을 비디오 인식에 직접 적용하는 간단하고 효과적인 방법을 제안했습니다.

논문 링크: https://arxiv.org/abs/2208.02816

프로젝트 주소: https://github.com/microsoft/VideoX/tree/master/X-CLIP

영상 설명: https://youtu.be/seb4lmVPEe8

간단한 분석: https://www.louisbouchard.ai/general-video-recognition/

Make-A-Video: 원클릭 텍스트 생성 동영상 모델

화가는 캔버스에 자유롭게 그림을 그릴 수 있습니다. 이렇게 선명하고 부드러운 그림을 보면 동영상의 모든 프레임이 AI에 의해 생성된다고 생각하실 수 있나요?

MetaAI가 출시한 Make-A-Video는 몇 단어만 입력하면 몇 초 만에 다양한 스타일의 동영상을 생성할 수 있습니다. 'DALL·E의 동영상 버전'이라고 해도 과언이 아닙니다.

논문 링크: https://arxiv.org/abs/2209.14792

영상 설명: https://youtu.be/MWwESVyHWto

짧다 이야기 분석: https://www.louisbouchard.ai/make-a-video/

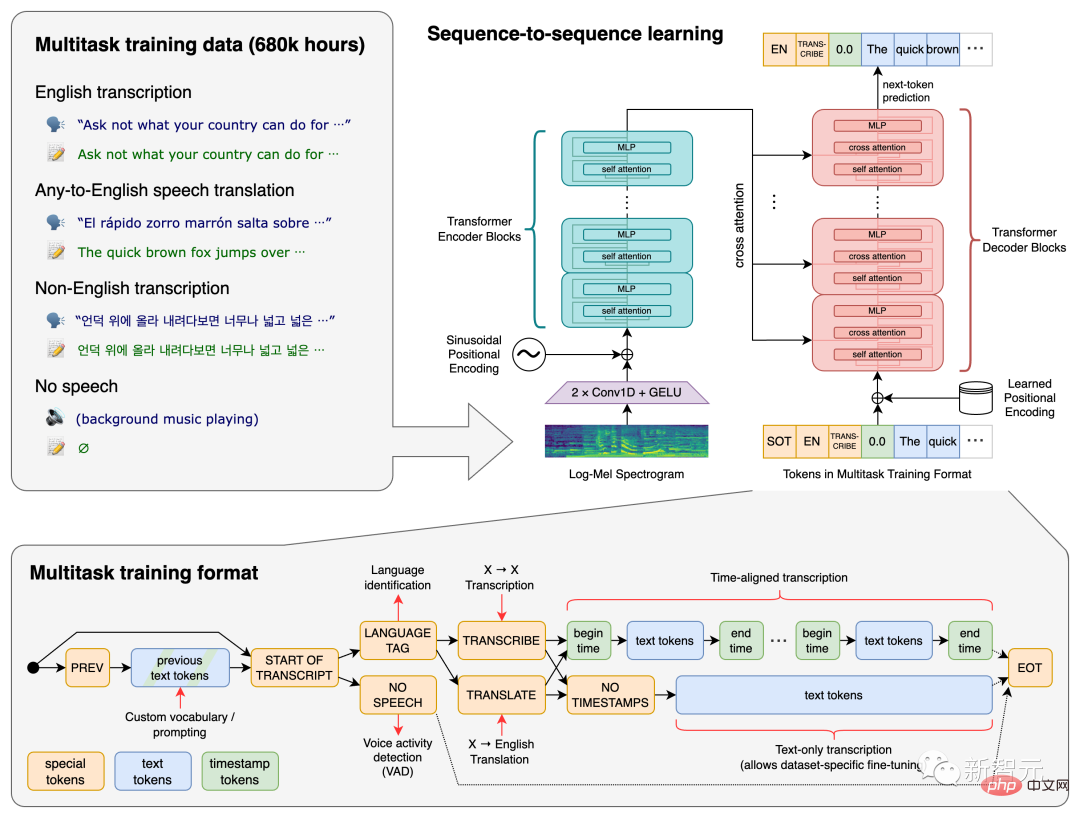

Whisper: Large-Scale Weakly Supervised Speech Recognition Model

... 영상 속의 말, 심지어 당신이 이해하지 못하는 언어도요?

OpenAI의 오픈 소스 Whisper가 바로 그 일을 할 수 있습니다.

Whisper는 680,000시간 이상의 다국어 데이터로 훈련되었습니다. 시끄러운 배경에서 다국어 소리를 인식하고 이를 전문 용어로 변환할 수도 있습니다.

논문 링크: https://arxiv.org/abs/2212.04356

프로젝트 주소: https://github.com/openai/whisper

영상 설명: https://youtu.be/uFOkMme19Zs

간단한 분석: https://www.louisbouchard.ai/whisper/

DreamFusion: 2D 이미지를 사용하여 생성 3D 모델

텍스트는 이미지, 동영상, 3D 모델을 생성할 수 있습니다~

Google에서 출시한 DreamFusion은 수십억 개의 이미지-텍스트 쌍에 대해 사전 학습된 2D 텍스트 대 이미지 확산 모델을 사용하여 한 번의 클릭으로 3D 모델을 생성할 수 있습니다. 훈련된 확산 모델은 텍스트-3D 모델 합성 분야에서 최근 획기적인 발전을 이루었습니다.

논문 링크: https://arxiv.org/abs/2209.14988

영상 설명: https://youtu.be/epuU0VRIcjE

짧다 스토리 분석: https://www.louisbouchard.ai/dreamfusion/

Imagic: 확산 모델 기반의 실제 이미지 편집 방법

DALL·E 등의 텍스트 이미지 생성 모델을 사용하면 입력만 하면 됩니다. 원하는 이미지를 얻기 위한 한 줄의 텍스트 그러나 AI가 생성한 이미지는 때로는 완벽하지 않습니다.

Google, 이스라엘 공과대학, Weizmann Institute of Science의 연구진은 텍스트만으로 실제 사진의 PS를 구현할 수 있는 확산 모델 기반의 실제 이미지 편집 방법인 Imagic을 선보였습니다.

예를 들어, 사람의 원래 모습을 유지하면서 포즈와 구도를 바꿀 수도 있고, 서 있는 개가 앉고 새가 날개를 펼칠 수도 있습니다.

논문 링크: https://arxiv.org/abs/2210.09276

프로젝트 주소: https://imagic-editing.github.io/

동영상 설명: https://youtu.be/gbpPQ5kVJhM

간단한 분석: https://www.louisbouchard.ai/imagic/

eDiffi: DALL보다 고품질의 텍스트 이미지 합성 모델

· E와 Stable Diffusion의 더욱 강력한 이미지 합성 모델이 출시되었습니다!

더 높은 품질의 이미지를 더욱 정확하게 생성할 수 있는 NVIDIA의 eDiffi입니다. 또한, 브러시 템플릿을 추가하면 작업에 창의성과 유연성을 더할 수 있습니다.

논문 링크: https://arxiv.org/abs/2211.01324

프로젝트 주소: https://deepimagination.cc/eDiff-I/

영상 설명: https://youtu.be/grwp-ht_ixo

간단한 분석: https://www.louisbouchard.ai/ediffi/

무한의 자연: 하나의 이미지로 배우는 무한 자연풍경 생성보기

사진을 찍고 문을 열듯이 사진 속으로 날아가는 상상을 해보셨나요?

Google과 코넬 대학의 학자들은 단일 이미지에서 자연 장면을 무제한으로 생성할 수 있는 InfiniteNature-Zero를 통해 이러한 상상을 현실로 만들었습니다.

논문 링크: https://arxiv.org/abs/2207.11148

프로젝트 주소: https://infinite-nature.github.io/

영상 설명: https://youtu.be/FQzGhukV-l0

간단한 분석: https://www.louisbouchard.ai/infinitenature-zero

Galaxica: 과학 모델을 위한 거대한 언어

Meta가 개발한 Galactica는 GPT-3와 비슷한 크기의 대형 언어 모델이지만 전문 분야는 과학 지식입니다.

모델은 정부 백서, 뉴스 리뷰, Wikipedia 페이지 및 코드를 작성할 수 있으며 인용 방법과 방정식 작성 방법도 알고 있습니다. 이는 인공지능과 과학에 있어 큰 의미를 지닌다.

논문 링크: https://arxiv.org/abs/2211.09085

영상 설명: https://youtu.be/2GfxkCWWzLU

짧다 스토리 분석: https://www.louisbouchard.ai/galactica/

RAD-NeRF: 오디오 공간 분해 기반 실시간 인물 사진 합성 모델

DeepFake와 NeRF 등장 이후 AI가 얼굴을 바꾸는 것 같다 그런데 AI로 대체된 얼굴이 입 모양과 맞지 않아 그 비밀이 드러나는 경우가 있다.

RAD-NeRF의 등장으로 영상에 등장하는 화자의 실시간 인물 사진 합성이 가능하고, 맞춤형 아바타도 지원됩니다.

논문 링크: https://arxiv.org/abs/2211.12368

프로젝트 주소: https://me.kiui.moe/radnerf/

동영상 설명: https://youtu.be/JUqnLN6Q4B0

간단한 분석: https://www.louisbouchard.ai/rad-nerf/

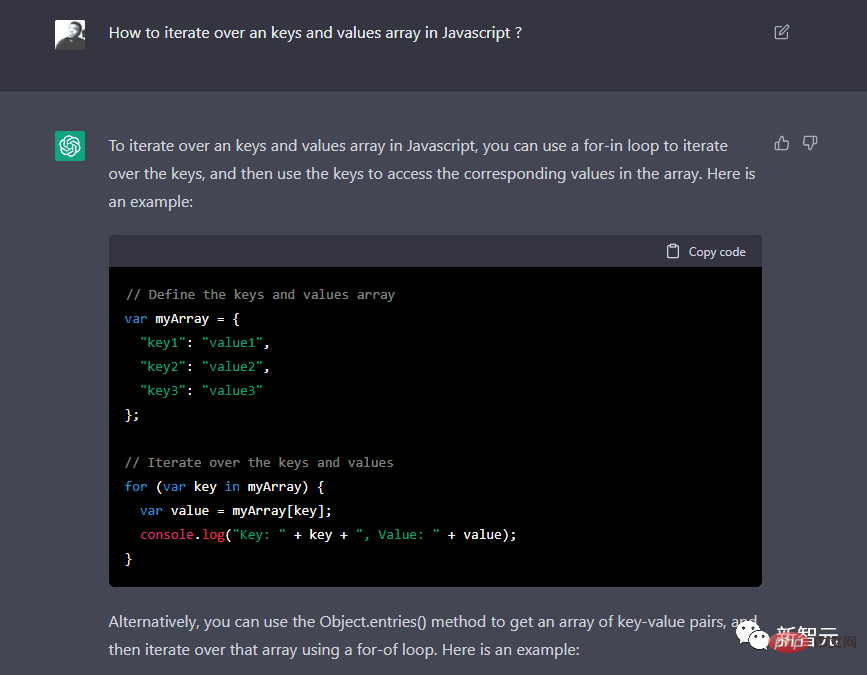

ChatGPT: 대화에 최적화된 언어 모델

2022 How ChatGPT가 없으면 올해의 블록버스터 작품이 될 수 있을까요? 이것은 인터넷 전체에서 인기를 얻었고 네티즌들이 포르노 기사, 코드 및 기타 응용 프로그램을 작성하기 위해 개발했습니다. 아직 모르신다면 여기로 빨리 오세요. 보세요!

영상설명 : https://youtu.be/AsFgn8vU-tQ

간략분석 : https://www.louisbouchard.ai/chatgpt/

사용가능 제작용으로 직접 영상 얼굴 리에이징

현재의 컴퓨터 비전 모델은 얼굴 나이, 스타일 이전 등을 생성할 수 있지만 이는 멋져 보일 뿐이며 실제 적용에서는 거의 효과가 없습니다. 후속 비디오 프레임에서는 종종 수동 보조 편집이 필요합니다.

최근 디즈니는 제작용 비디오 이미지에서 얼굴을 다시 노화시키는 최초의 실용적이고 완전 자동화된 방법인 FRAN(Face Re-Aging Network)을 출시하여 영화에서 메이크업 아티스트의 필요성을 공식적으로 발표했습니다. 배우들의 비주얼이 끝났다.

논문 링크: https://dl.acm.org/doi/pdf/10.1145/3550454.3555520

프로젝트 주소: https://studios.disneyresearch.com/2022/11 /30/production-ready-face-re-aging-for-visual- Effects/

영상설명 : https://youtu.be/WC03N0NFfwk

간략분석 : https://youtu.be/WC03N0NFfwk

🎜🎜🎜 ://www.louisbouchard.ai/disney-re-age/🎜🎜🎜위 내용은 정말 중요한 연구! 32편의 논문에서 2022년 AI 핫스팟을 살펴본다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

C에서 DMA 운영을 이해하는 방법?

Apr 28, 2025 pm 10:09 PM

C에서 DMA 운영을 이해하는 방법?

Apr 28, 2025 pm 10:09 PM

C의 DMA는 직접 메모리 액세스 기술인 DirectMemoryAccess를 말하며 하드웨어 장치는 CPU 개입없이 데이터를 메모리로 직접 전송할 수 있습니다. 1) DMA 운영은 하드웨어 장치 및 드라이버에 크게 의존하며 구현 방법은 시스템마다 다릅니다. 2) 메모리에 직접 액세스하면 보안 위험이 발생할 수 있으며 코드의 정확성과 보안이 보장되어야합니다. 3) DMA는 성능을 향상시킬 수 있지만 부적절하게 사용하면 시스템 성능이 저하 될 수 있습니다. 실습과 학습을 통해 우리는 DMA 사용 기술을 습득하고 고속 데이터 전송 및 실시간 신호 처리와 같은 시나리오에서 효과를 극대화 할 수 있습니다.

C에서 Chrono 라이브러리를 사용하는 방법?

Apr 28, 2025 pm 10:18 PM

C에서 Chrono 라이브러리를 사용하는 방법?

Apr 28, 2025 pm 10:18 PM

C에서 Chrono 라이브러리를 사용하면 시간과 시간 간격을보다 정확하게 제어 할 수 있습니다. 이 도서관의 매력을 탐구합시다. C의 크로노 라이브러리는 표준 라이브러리의 일부로 시간과 시간 간격을 다루는 현대적인 방법을 제공합니다. 시간과 C 시간으로 고통받는 프로그래머에게는 Chrono가 의심 할 여지없이 혜택입니다. 코드의 가독성과 유지 가능성을 향상시킬뿐만 아니라 더 높은 정확도와 유연성을 제공합니다. 기본부터 시작합시다. Chrono 라이브러리에는 주로 다음 주요 구성 요소가 포함됩니다. std :: Chrono :: System_Clock : 현재 시간을 얻는 데 사용되는 시스템 클럭을 나타냅니다. STD :: 크론

C에서 스레드 성능을 측정하는 방법?

Apr 28, 2025 pm 10:21 PM

C에서 스레드 성능을 측정하는 방법?

Apr 28, 2025 pm 10:21 PM

C에서 스레드 성능을 측정하면 표준 라이브러리에서 타이밍 도구, 성능 분석 도구 및 사용자 정의 타이머를 사용할 수 있습니다. 1. 라이브러리를 사용하여 실행 시간을 측정하십시오. 2. 성능 분석을 위해 GPROF를 사용하십시오. 단계에는 컴파일 중에 -pg 옵션 추가, GMON.out 파일을 생성하기 위해 프로그램을 실행하며 성능 보고서를 생성하는 것이 포함됩니다. 3. Valgrind의 Callgrind 모듈을 사용하여보다 자세한 분석을 수행하십시오. 단계에는 Callgrind.out 파일을 생성하고 Kcachegrind를 사용하여 결과를보기위한 프로그램 실행이 포함됩니다. 4. 사용자 정의 타이머는 특정 코드 세그먼트의 실행 시간을 유연하게 측정 할 수 있습니다. 이 방법은 스레드 성능을 완전히 이해하고 코드를 최적화하는 데 도움이됩니다.

정량적 거래 순위 2025 디지털 통화 정량 거래 앱에 대한 상위 10 개 권장 사항

Apr 30, 2025 pm 07:24 PM

정량적 거래 순위 2025 디지털 통화 정량 거래 앱에 대한 상위 10 개 권장 사항

Apr 30, 2025 pm 07:24 PM

교환의 내장 양자화 도구에는 다음이 포함됩니다. 1. Binance : Binance 선물 정량 모듈, 낮은 취급 수수료 및 AI 지원 거래를 지원합니다. 2. OKX (OUYI) : 다중 계정 관리 및 지능형 주문 라우팅을 지원하고 기관 수준의 위험 관리를 제공합니다. 독립적 인 정량적 전략 플랫폼에는 다음이 포함됩니다. 4. Quadency : 맞춤형 위험 임계 값을 지원하는 전문 수준 알고리즘 전략 라이브러리. 5. Pionex : 내장 16 사전 설정 전략, 낮은 거래 수수료. 수직 도메인 도구에는 다음이 포함됩니다. 6. Cryptohopper : 클라우드 기반 정량 플랫폼, 150 개의 기술 지표를 지원합니다. 7. BITSGAP :

C에서 높은 DPI 디스플레이를 처리하는 방법?

Apr 28, 2025 pm 09:57 PM

C에서 높은 DPI 디스플레이를 처리하는 방법?

Apr 28, 2025 pm 09:57 PM

C에서 높은 DPI 디스플레이를 처리 할 수 있습니다. 1) DPI 및 스케일링을 이해하고 운영 체제 API를 사용하여 DPI 정보를 얻고 그래픽 출력을 조정하십시오. 2) 크로스 플랫폼 호환성을 처리하고 SDL 또는 QT와 같은 크로스 플랫폼 그래픽 라이브러리를 사용하십시오. 3) 성능 최적화를 수행하고 캐시, 하드웨어 가속 및 세부 사항 수준의 동적 조정을 통해 성능 향상; 4) 흐릿한 텍스트 및 인터페이스 요소와 같은 일반적인 문제를 해결하고 DPI 스케일링을 올바르게 적용하여 해결합니다.

C의 실시간 운영 체제 프로그래밍이란 무엇입니까?

Apr 28, 2025 pm 10:15 PM

C의 실시간 운영 체제 프로그래밍이란 무엇입니까?

Apr 28, 2025 pm 10:15 PM

C는 실시간 운영 체제 (RTO) 프로그래밍에서 잘 수행하여 효율적인 실행 효율성과 정확한 시간 관리를 제공합니다. 1) c 하드웨어 리소스의 직접 작동 및 효율적인 메모리 관리를 통해 RTO의 요구를 충족시킵니다. 2) 객체 지향 기능을 사용하여 C는 유연한 작업 스케줄링 시스템을 설계 할 수 있습니다. 3) C는 효율적인 인터럽트 처리를 지원하지만 실시간을 보장하려면 동적 메모리 할당 및 예외 처리를 피해야합니다. 4) 템플릿 프로그래밍 및 인라인 함수는 성능 최적화에 도움이됩니다. 5) 실제 응용 분야에서 C는 효율적인 로깅 시스템을 구현하는 데 사용될 수 있습니다.

MySQL 테이블에 필드를 추가 및 삭제하는 단계

Apr 29, 2025 pm 04:15 PM

MySQL 테이블에 필드를 추가 및 삭제하는 단계

Apr 29, 2025 pm 04:15 PM

MySQL에서는 altertabletable_nameaddcolumnnew_columnvarchar (255) 이후에 필드를 추가하여 altertabletable_namedropcolumncolumn_to_drop을 사용하여 필드를 삭제합니다. 필드를 추가 할 때는 쿼리 성능 및 데이터 구조를 최적화하기위한 위치를 지정해야합니다. 필드를 삭제하기 전에 작업이 돌이킬 수 없는지 확인해야합니다. 온라인 DDL, 백업 데이터, 테스트 환경 및 저하 기간을 사용하여 테이블 구조 수정은 성능 최적화 및 모범 사례입니다.

C에서 문자열 스트림을 사용하는 방법?

Apr 28, 2025 pm 09:12 PM

C에서 문자열 스트림을 사용하는 방법?

Apr 28, 2025 pm 09:12 PM

C에서 문자열 스트림을 사용하기위한 주요 단계와 예방 조치는 다음과 같습니다. 1. 출력 문자열 스트림을 생성하고 정수를 문자열로 변환하는 것과 같은 데이터를 변환합니다. 2. 벡터를 문자열로 변환하는 것과 같은 복잡한 데이터 구조의 직렬화에 적용하십시오. 3. 성능 문제에주의를 기울이고 많은 양의 데이터를 처리 할 때 문자열 스트림을 자주 사용하지 마십시오. std :: string의 Append 메소드를 사용하는 것을 고려할 수 있습니다. 4. 메모리 관리에주의를 기울이고 스트림 스트림 객체의 자주 생성과 파괴를 피하십시오. std :: stringstream을 재사용하거나 사용할 수 있습니다.