ChatGPT의 인기는 누구에게나 명백하며, 성공을 뒷받침하는 기술을 위해서는 인간의 피드백을 기반으로 한 지도 지도 미세 조정 및 강화 학습이 중요합니다. 이러한 기술은 컴퓨터 비전(CV)을 포함한 다른 AI 분야로도 점차 확장되고 있습니다.

컴퓨터 비전에서 복잡한 출력을 처리할 때 성공의 주요 기준은 모델이 훈련 목표에 얼마나 잘 최적화되었는지가 아니라 예측 기능이 작업에 얼마나 잘 맞는지, 즉 얼마나 잘 모델은 의도된 용도로 수행됩니다.

이러한 일관성을 추구하기 위해 일부 연구자들은 모델 아키텍처, 데이터, 최적화, 샘플링, 후처리 등을 일부 개선했습니다. 예를 들어 객체 감지 작업에서 연구원들은 NMS(Non-Maximum Suppression), 세트 기반 전역 손실, 입력 데이터 변경을 사용하여 테스트 시 동작이 개선된 모델을 얻었습니다. 이러한 방법은 상당한 이점을 제공하지만 특정 작업에만 유용하고 임무 위험을 간접적으로만 최적화하는 경우가 많습니다.

CV뿐만 아니라 자연어 처리(NLP), 강화 학습(RL) 등 다른 분야에서도 이러한 현상을 널리 연구하고 있습니다. 이러한 영역에서는 번역이나 요약 생성과 같이 잘 정의되지 않은 작업에 대한 최적화 목표를 공식화하는 것이 매우 어렵습니다. 이러한 유형의 문제를 다룰 때 일반적인 접근 방식은 예제의 출력을 모방한 다음 강화 학습을 수행하여 모델을 보상 기능에 맞추는 것입니다. NLP 분야에서는 사전 훈련된 대규모 언어 모델과 인간 피드백에 의해 정의된 보상을 사용하여 지정하기 어려운 작업을 처리하는 이 접근 방식을 사용하여 흥미로운 결과를 생성했습니다.

또한 동일한 방법이 이미지 캡션 작업에도 널리 사용되며 CIDEr(Vedantam et al. 2015 제안)가 보상으로 사용됩니다. 그럼에도 불구하고, 우리가 아는 한, 보상 최적화는 (텍스트가 아닌) 컴퓨터 비전 작업에서 이전에 탐색된 적이 없습니다.

최근 Google Brain 팀의 연구원들은 "Tuning Computer Vision Models with Task Rewards"라는 논문에서 REINFORCE 알고리즘(1992년 Williams가 제안)을 사용하여 사전 훈련된 모델을 조정(Tuning)하는 것을 입증했습니다. 보상 기능은 즉시 사용 가능한 다양한 컴퓨터 비전 작업에 사용할 수 있습니다 .

실제로 강화 학습 작업에 관한 많은 연구에서 Williams의 REINFORCE 알고리즘을 언급할 것이며, 이는 이 알고리즘의 중요성을 보여줍니다. REINFORCE 알고리즘은 정책 그래디언트와 심지어 강화학습까지 대표하는 대표적인 알고리즘이라고 할 수 있습니다.

논문 주소: https://arxiv.org/pdf/2302.08242v1.pdf

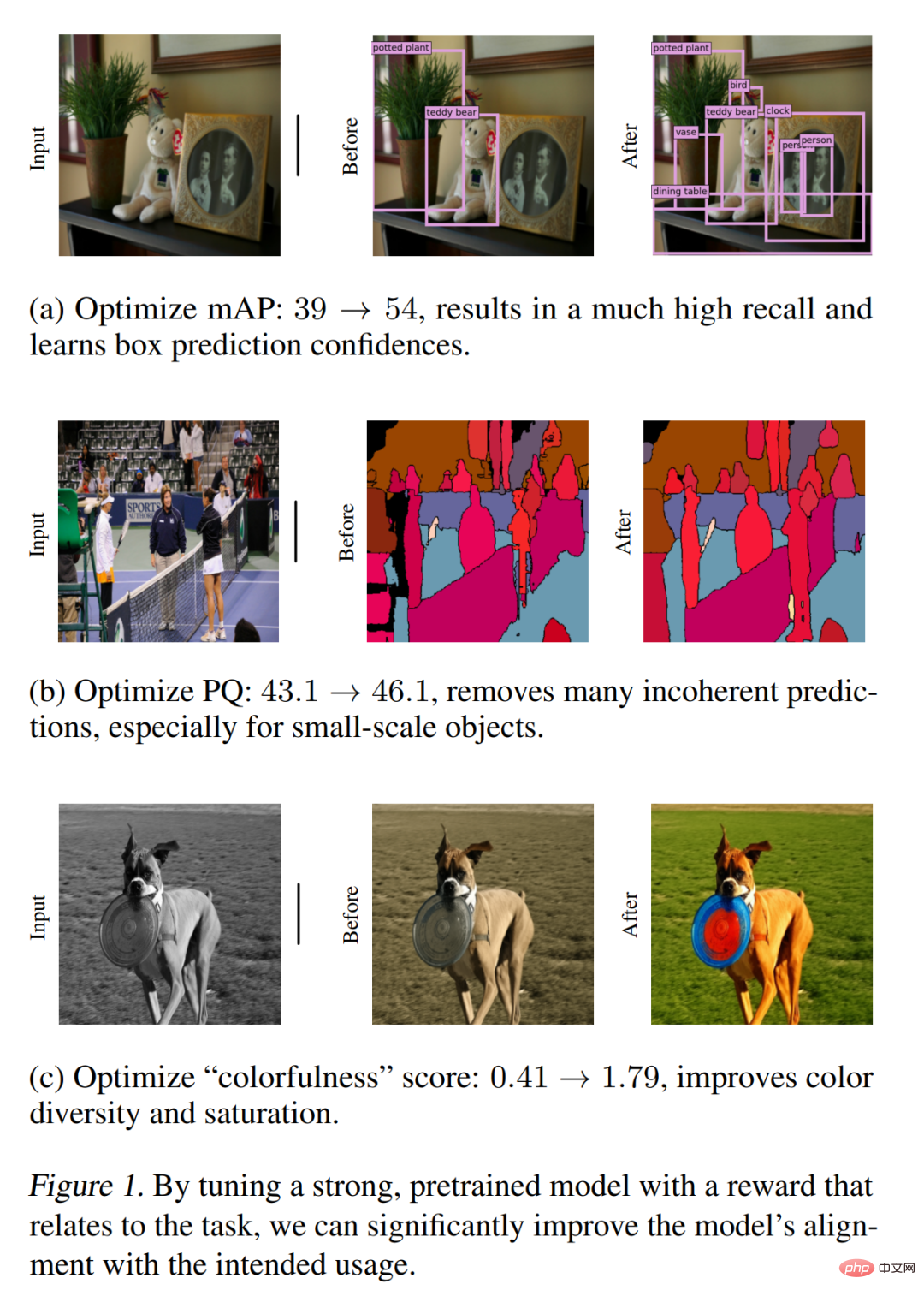

그림 1은 주로 표적 탐지, 파노라마 분할 및 이미지 색상 정량을 위한 보상 최적화 대역을 포함한 몇 가지 주요 결과를 보여줍니다. 그리고 질적 개선. 본 연구에서 제안한 방법은 다양한 CV 작업을 처리하는 데 간단하고 효과적이며 다양성과 적응성을 보여줍니다. 본 논문에서는 평가 지표 형태의 보상을 주로 사용하지만, 이러한 예비 결과는 이 방법이 인간 피드백이나 전체 시스템 성능과 같이 더 복잡하고 지정하기 어려운 컴퓨터 비전 모델을 최적화하는 효과적인 방법이 될 수 있음을 보여줍니다. .

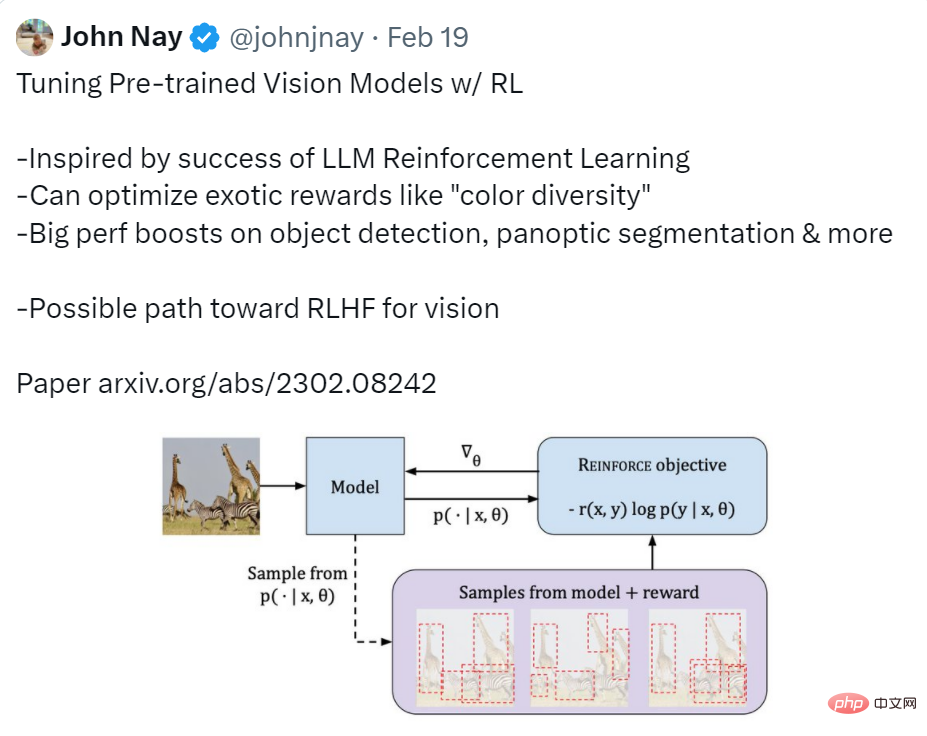

Twitter 사용자는 이 기사에 대해 비교적 포괄적인 요약을 제공했습니다. 즉, 이 기사에서 구현된 기능은 RL을 사용하여 사전 훈련된 시각적 모델을 조정하는 것입니다. 연구 동기는 LLM 강화 학습의 성공에서 영감을 얻었습니다. 그 효과는 표적 탐지, 파노라마 분할 등의 성능이 크게 향상되었습니다. 그는 또한 이 연구가 시각적 RLHF(Reinforcement Learning from Human Feedback)를 달성하는 효과적인 방법이 될 수 있다고 말했습니다.

출처: https://twitter.com/johnjnay/status/1627009121378598912

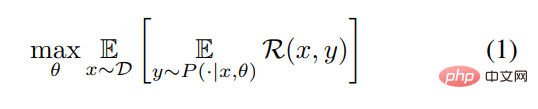

연구에서는 CV 작업을 입력 x(예: 이미지)를 출력 y = [y_1, y_1,… , y_n](텍스트 토큰 시퀀스, 경계 상자 시퀀스 등). 본 연구에서는 보상 함수 R을 최대화하기 위해 θ를 매개변수로 하는 조건부 분포 P(y|x, θ)를 학습하는 것을 목표로 합니다. 이를 설명하기 위해 추상 공식을 사용하기 위해 이 기사에서는 다음과 같은 최적화 문제를 해결합니다.

이제 문제가 발생했으므로 다음 단계는 문제를 해결하는 방법입니다. 먼저 최대 우도 추정을 사용하여 모델을 사전 훈련한 다음 REINFORCE 알고리즘을 사용합니다. 모델을 조정하세요. 이 두 단계의 구체적인 프로세스를 살펴보겠습니다.

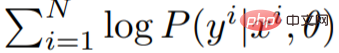

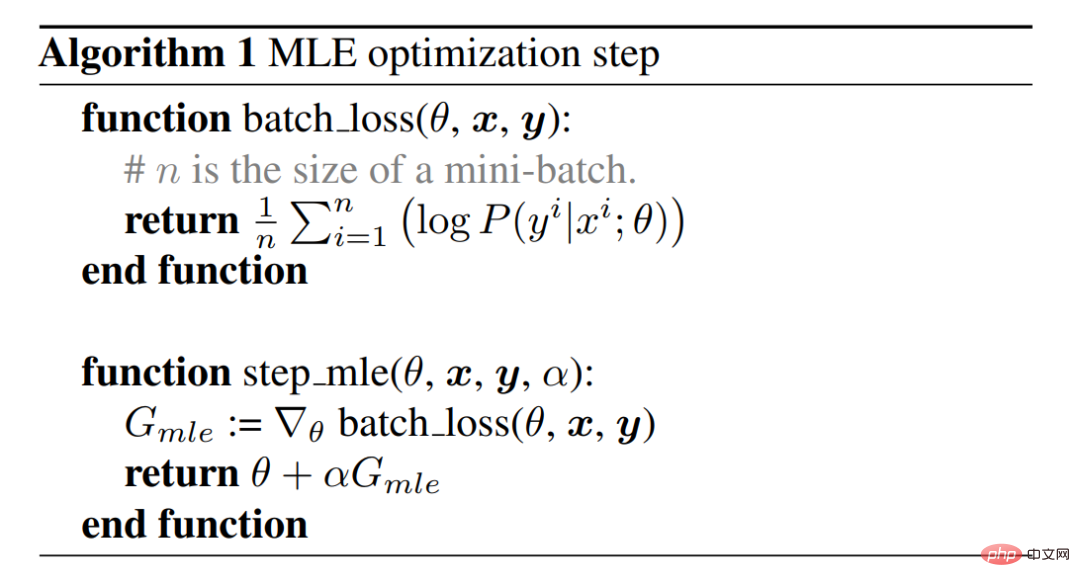

최대 우도 사전 훈련

먼저 최대 우도 원리를 사용하여 매개변수 θ를 추정하고 훈련 데이터의 분포를 캡처합니다. 이는 훈련 데이터의 로그 우도

를 최대화하여 작동하는 경사하강법 알고리즘을 사용하여 달성됩니다. 알고리즘 1과 그림 2는 모델 학습에 가장 일반적인 방법인 MLE(최대 우도 추정) 최적화 단계를 설명합니다. 이 단계를 완료하면 MLE 모델이 생성됩니다.

를 최대화하여 작동하는 경사하강법 알고리즘을 사용하여 달성됩니다. 알고리즘 1과 그림 2는 모델 학습에 가장 일반적인 방법인 MLE(최대 우도 추정) 최적화 단계를 설명합니다. 이 단계를 완료하면 MLE 모델이 생성됩니다.

REINFORC 알고리즘은 보상을 최대화합니다.

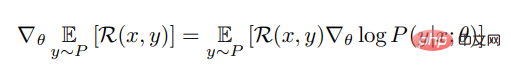

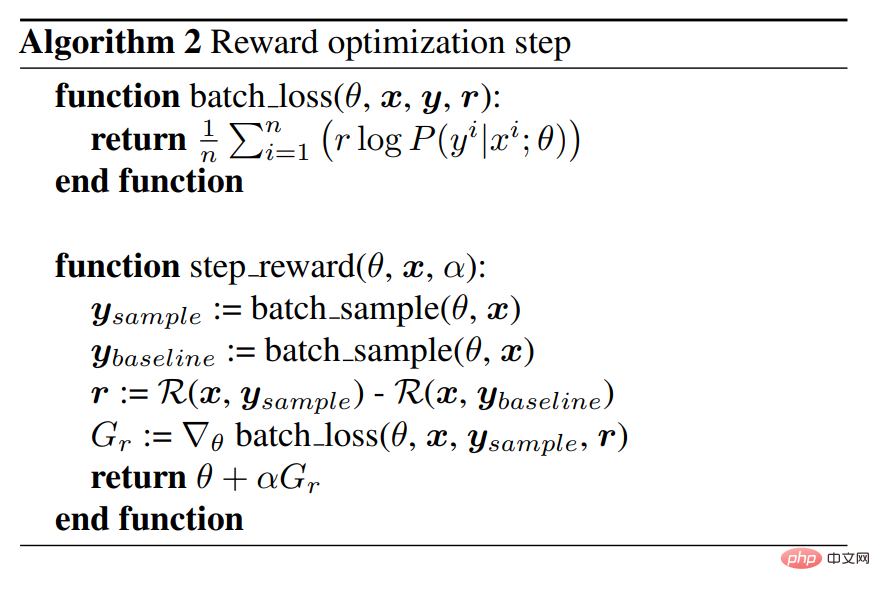

작업 위험에 적응하기 위해 MLE 모델을 더 잘 최적화하려면 보상 기능을 최대화하는 것도 필요합니다. 주어진 입력 x에 대해 본 연구에서는 REINFORCE 알고리즘을 활용하여 주어진 x에 대한 예상 보상의 기울기를 추정하며 공식은 다음과 같습니다.

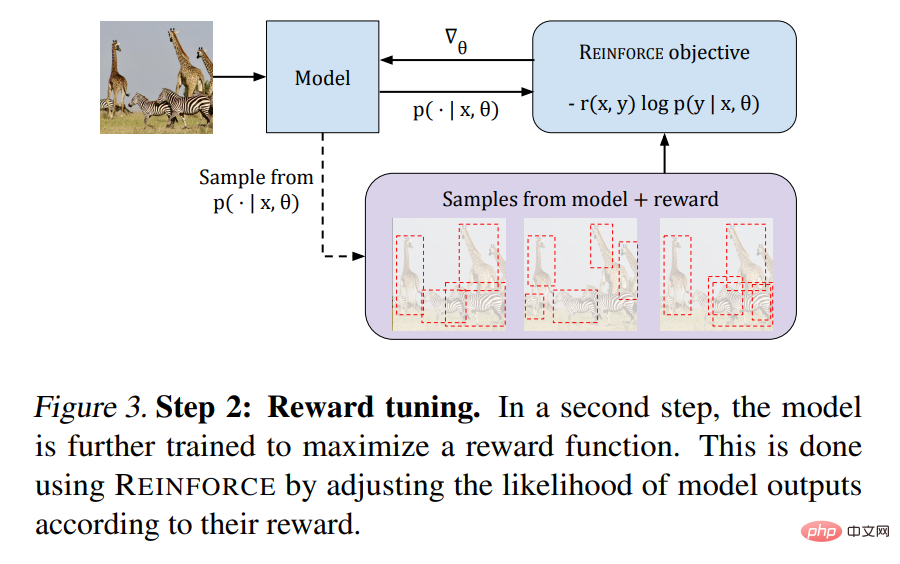

알고리즘 2는 의사코드를 제공하며 그림 3은 그 과정을 보여줍니다. :

다음으로, 시각적 작업에 대해 이 글에서 제안한 방법의 성능을 살펴보겠습니다.

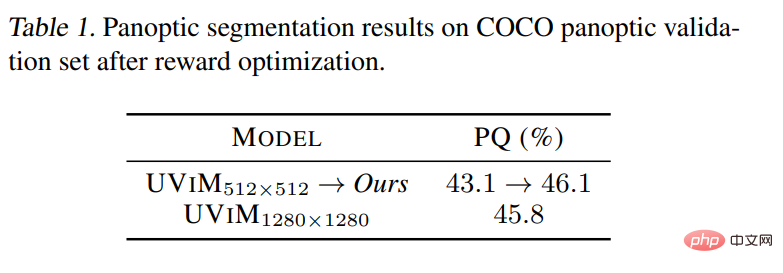

파노라마 분할

아래 표 1에서 볼 수 있듯이 조정 프로세스는 MLE 모델을 크게 향상시킵니다. 육안 검사 후 결과는 튜닝 후 모델이 일관되지 않은 예측을 피하는 데 더 나은 것으로 나타났습니다. 특히 소규모 개체의 경우 그림 1을 참조하세요.

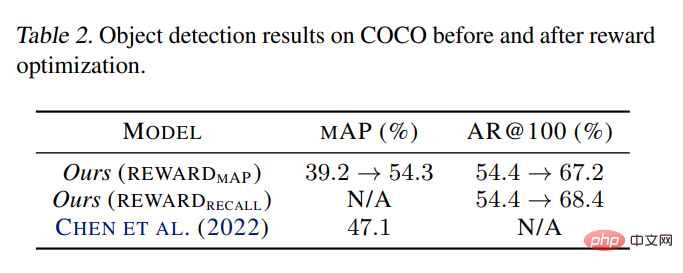

ObjectDetection

표 2는 최적화를 통해 이 연구에서 원래 MLE 모델의 mAP 점수가 39.2%에서 54.3%로 크게 향상되었음을 보여줍니다. Pix2seq에서는 약간 더 큰 1333×1333 해상도와 많은 휴리스틱을 갖춘 동일한 크기의 ViT-B 모델이 47.1%를 달성했습니다. 더 큰 ViT-L 백본을 사용할 때 Pix2seq는 50.0%의 최상의 표적 탐지 결과를 보고했습니다.

채색

그림 4에 제시된 정성적 결과는 새 모델이 지속적으로 더욱 다채로운 이미지를 생성한다는 것을 분명히 보여줍니다.

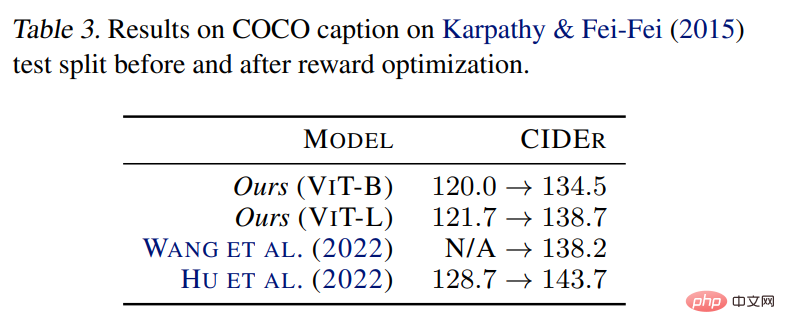

이미지 설명

표 3 결과는 제안된 방법을 적용하면 MLE 모델을 개선할 수 있음을 보여줍니다. 이는 문헌의 이전 관찰과 일치하며 방법이 다음과 같음을 보여줍니다. 특정 임무 위험에 대한 튜닝의 효율성에 적합합니다.

위 내용은 Google은 30년 전의 고전 알고리즘을 재사용하고 CV는 강화 학습을 도입합니다. 네티즌: 시각적 RLHF가 올까요?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!