모두가 ChatGPT를 사용하는 꿈이 곧 이루어지나요?

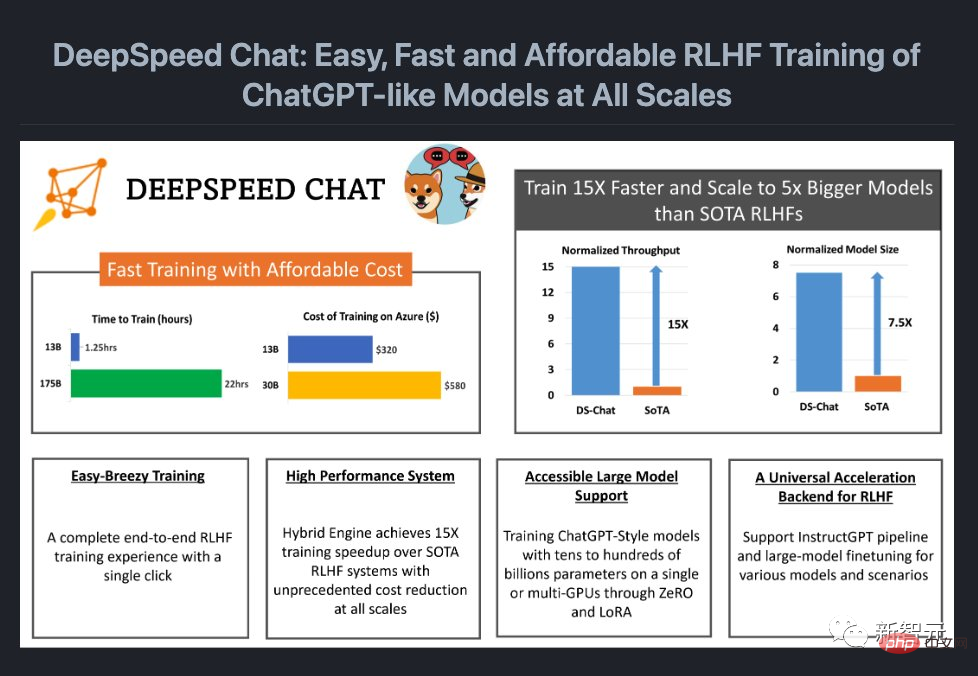

지금 Microsoft는 모델 교육에 완전한 RLHF 프로세스를 추가할 수 있는 시스템 프레임워크인 DeepSpeed Chat을 오픈 소스로 공개했습니다.

즉, 이제 모든 크기의 고품질 ChatGPT와 유사한 모델을 손쉽게 사용할 수 있습니다! ㅋㅋㅋ 더 많은 사람들이 ChatGPT와 유사한 모델을 사용할 수 있도록 오픈 소스 커뮤니티에서는 LLaMa, Alpaca, Vicuna 및 Databricks-Dolly와 같은 모델을 연속적으로 출시했습니다.

그러나 엔드투엔드 RLHF 규모 시스템이 부족하기 때문에 현재 ChatGPT와 유사한 모델의 교육은 여전히 매우 어렵습니다. DeepSpeed Chat의 출현은 이러한 "버그"를 보완합니다.

그러나 엔드투엔드 RLHF 규모 시스템이 부족하기 때문에 현재 ChatGPT와 유사한 모델의 교육은 여전히 매우 어렵습니다. DeepSpeed Chat의 출현은 이러한 "버그"를 보완합니다.

더 놀라운 점은 DeepSpeed Chat이 비용을 크게 절감했다는 것입니다.

이전에는 값비싼 다중 GPU 설정이 많은 연구자의 능력을 넘어섰고, 다중 GPU 클러스터에 액세스하더라도 기존 방법으로는 수천억 개의 매개변수 ChatGPT 모델을 훈련할 여유가 없었습니다.

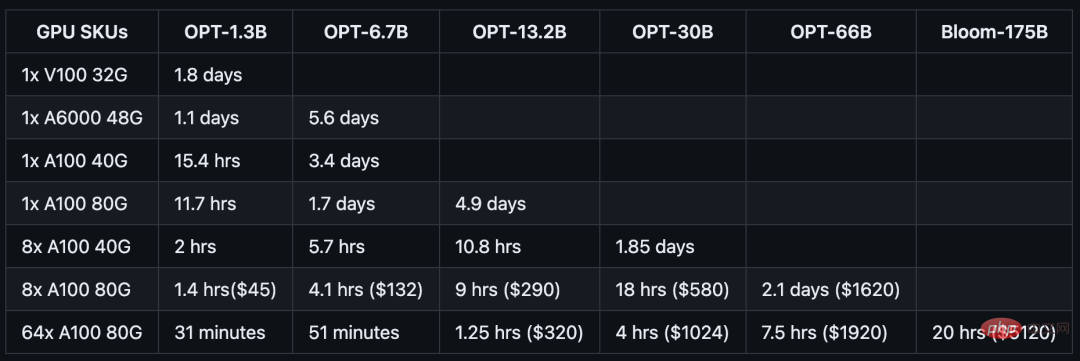

이제 단 $1,620의 비용으로 하이브리드 엔진 DeepSpeed-HE를 통해 OPT-66B 모델을 2.1일 만에 훈련할 수 있습니다.

그리고 다중 노드, 다중 GPU 시스템을 사용하는 경우 DeepSpeed-HE는 1.25시간 안에 320달러를 들여 OPT-13B 모델을 훈련할 수 있고, 5120달러를 들여 OPT-13B 모델을 훈련할 수 있습니다. 하루 미만.

그리고 다중 노드, 다중 GPU 시스템을 사용하는 경우 DeepSpeed-HE는 1.25시간 안에 320달러를 들여 OPT-13B 모델을 훈련할 수 있고, 5120달러를 들여 OPT-13B 모델을 훈련할 수 있습니다. 하루 미만.

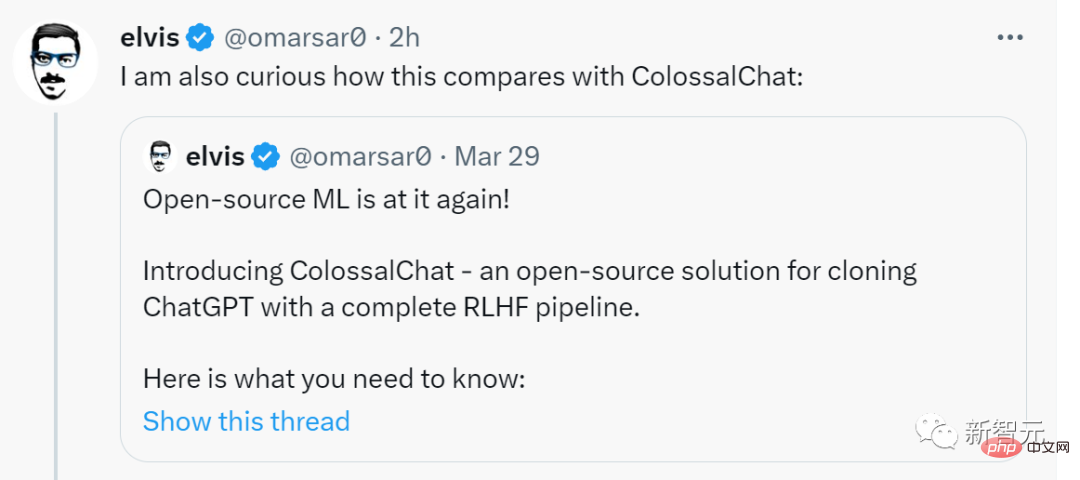

전 메타 AI 전문가 Elvis는 이것이 큰 일이라며 신나게 리트윗했으며 DeepSpeed Chat이 ColossalChat과 어떻게 비교되는지 궁금해했습니다.

이제 어떻게 작동하는지 살펴보겠습니다.

DeepSpeed-Chat으로 트레이닝한 후, 13억 개의 매개변수 버전인 "ChatGPT"가 질의응답 세션에서 매우 좋은 성적을 거두었습니다. 질문의 맥락을 파악할 수 있을 뿐만 아니라 제공된 답변도 관련성이 있습니다.

여러 차례의 대화에서 "ChatGPT"의 13억 매개변수 버전이 보여준 성능은 이 스케일이 본래 갖고 있던 인상을 완전히 뛰어넘었습니다.

첫 번째 ChatGPT를 생성하는 코드

물론 경험하기 전에 환경을 구성해야 합니다.

git clone https://github.com/microsoft/DeepSpeed.git cd DeepSpeed pip install . git clone https://github.com/microsoft/DeepSpeedExamples.git cd DeepSpeedExamples/applications/DeepSpeed-Chat/ pip install -r requirements.txt

커피 한 잔을 마시고 13억 개의 매개변수 버전 훈련을 완료하세요. ChatGPT

커피 한 잔을 마시고 13억 개의 매개변수 버전 훈련을 완료하세요. ChatGPT1-2시간 정도 커피를 마시거나 점심 시간을 보낼 수 있다면 DeepSpeed-Chat을 사용하여 "작은 장난감"을 훈련시켜 볼 수도 있습니다.

python train.py --actor-model facebook/opt-1.3b --reward-model facebook/opt-350m --num-gpus 1

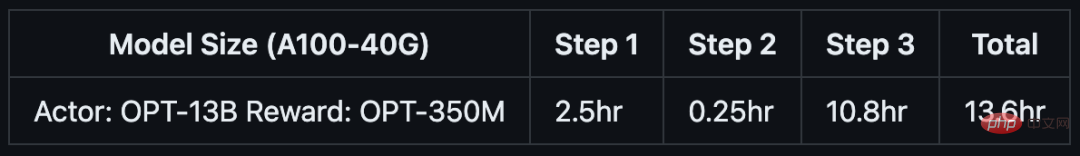

如果你只有半天的时间,以及一台服务器节点,则可以通过预训练的OPT-13B作为actor模型,OPT-350M作为reward模型,来生成一个130亿参数的类ChatGPT模型:

python train.py --actor-model facebook/opt-13b --reward-model facebook/opt-350m --num-gpus 8

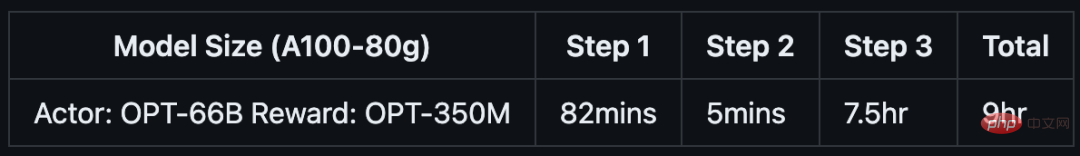

单DGX节点,搭载了8个NVIDIA A100-40G GPU:

如果你可以使用多节点集群或云资源,并希望训练一个更大、更高质量的模型。那么只需基于下面这行代码,输入你想要的模型大小(如66B)和GPU数量(如64):

python train.py --actor-model facebook/opt-66b --reward-model facebook/opt-350m --num-gpus 64

8个DGX节点,每个节点配备8个NVIDIA A100-80G GPU:

具体来说,针对不同规模的模型和硬件配置,DeepSpeed-RLHF系统所需的时间和成本如下:

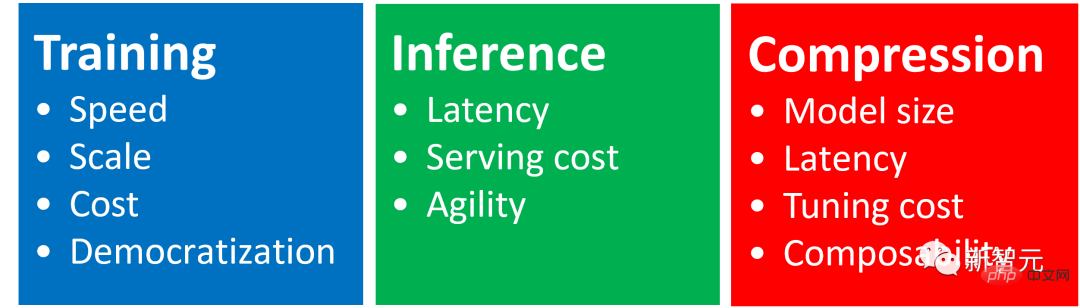

DeepSpeed Chat是一种通用系统框架,能够实现类似ChatGPT模型的端到端RLHF训练,从而帮助我们生成自己的高质量类ChatGPT模型。

DeepSpeed Chat具有以下三大核心功能:

1. 简化ChatGPT类型模型的训练和强化推理体验

开发者只需一个脚本,就能实现多个训练步骤,并且在完成后还可以利用推理API进行对话式交互测试。

2. DeepSpeed-RLHF模块

DeepSpeed-RLHF复刻了InstructGPT论文中的训练模式,并提供了数据抽象和混合功能,支持开发者使用多个不同来源的数据源进行训练。

3. DeepSpeed-RLHF系统

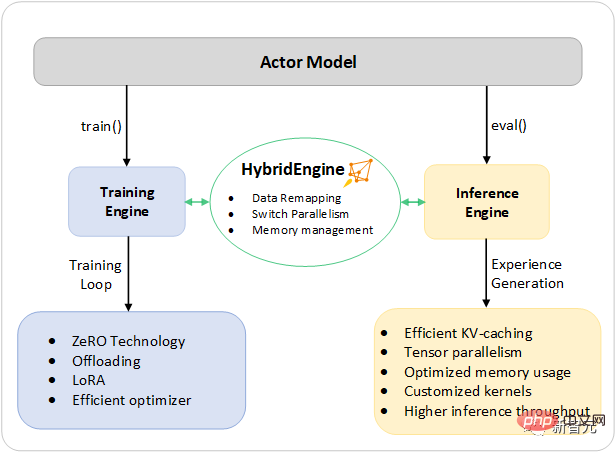

团队将DeepSpeed的训练(training engine)和推理能力(inference engine) 整合成了一个统一的混合引擎(DeepSpeed Hybrid Engine or DeepSpeed-HE)中,用于RLHF训练。由于,DeepSpeed-HE能够无缝地在推理和训练模式之间切换,因此可以利用来自DeepSpeed-Inference的各种优化。

DeepSpeed-RLHF系统在大规模训练中具有无与伦比的效率,使复杂的RLHF训练变得快速、经济并且易于大规模推广:

DeepSpeed-HE比现有系统快15倍以上,使RLHF训练快速且经济实惠。

例如,DeepSpeed-HE在Azure云上只需9小时即可训练一个OPT-13B模型,只需18小时即可训练一个OPT-30B模型。这两种训练分别花费不到300美元和600美元。

DeepSpeed-HE는 수천억 개의 매개변수로 훈련 모델을 지원할 수 있으며 다중 노드 다중 GPU 시스템에서 뛰어난 확장성을 보여줍니다.

따라서 130억 개의 매개변수가 있는 모델이라도 단 1.25시간 만에 학습할 수 있습니다. 1,750억 개의 매개변수가 있는 모델의 경우 DeepSpeed-HE를 사용한 교육은 하루도 채 걸리지 않습니다.

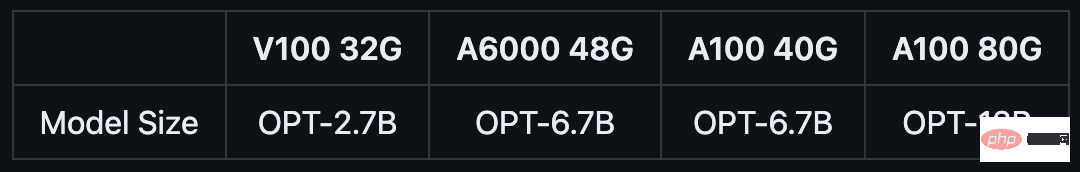

단일 GPU만으로 DeepSpeed-HE는 130억 개 이상의 매개변수가 있는 교육 모델을 지원할 수 있습니다. 이를 통해 다중 GPU 시스템에 액세스할 수 없는 데이터 과학자 및 연구원은 경량 RLHF 모델뿐만 아니라 다양한 사용 시나리오에 대처할 수 있는 크고 강력한 모델도 쉽게 생성할 수 있습니다.

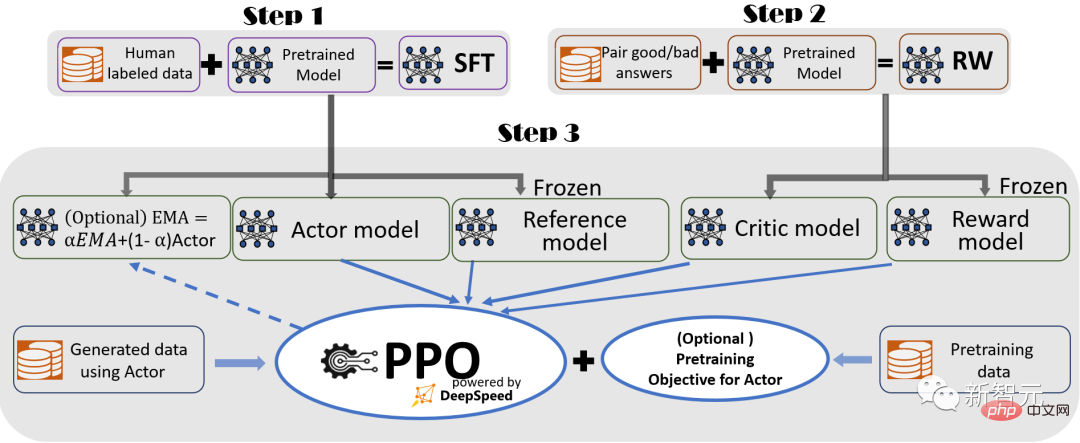

원활한 교육 경험을 제공하기 위해 연구원들은 InstructGPT를 따랐으며 DeepSpeed-Chat에 완전한 엔드 투 엔드 교육 프로세스를 포함했습니다.

일부 선택 기능을 포함한 DeepSpeed-Chat의 RLHF 훈련 프로세스 다이어그램

프로세스에는 세 가지 주요 단계가 포함됩니다.

감시 -튜닝(SFT) , 선별된 인간 응답을 사용하여 다양한 쿼리에 대해 사전 훈련된 언어 모델을 미세 조정합니다.

보상 모델 미세 조정, 동일한 쿼리에 대한 여러 답변에 대한 사람의 평가가 포함된 데이터 세트를 사용하여 독립적인(보통 SFT보다 작은) 보상 모델(RW)을 훈련합니다.

RLHF 교육 이 단계에서는 RW 모델의 보상 피드백과 함께 PPO(근사적 정책 최적화) 알고리즘을 사용하여 SFT 모델을 더욱 미세 조정합니다.

3단계에서 연구원은 모델 품질을 향상시키는 데 도움이 되는 두 가지 추가 기능도 제공합니다.

- EMA(지수 이동 평균) 수집, 최종 평가를 위해 EMA 기반 체크포인트를 선택할 수 있습니다.

- 공개 벤치마크(예: SQuAD2.0)에서 성능 회귀를 방지하기 위해 사전 훈련 목표(예: 다음 단어 예측)와 PPO 목표를 혼합하는 하이브리드 훈련입니다.

EMA와 하이브리드 교육은 교육을 방해하지 않기 때문에 다른 오픈 소스 프레임워크에서 종종 무시되는 두 가지 교육 기능입니다.

그러나 InstructGPT에 따르면 EMA 체크포인트는 기존 최종 학습 모델보다 더 나은 응답 품질을 제공하는 경향이 있으며 하이브리드 학습은 모델이 사전 학습 기준 해결 기능을 유지하는 데 도움이 될 수 있습니다.

따라서 연구자들은 사용자가 InstructGPT에 설명된 훈련 경험을 완벽하게 얻을 수 있도록 이러한 기능을 제공합니다.

InstructGPT 논문과의 높은 일관성 외에도 연구원은 개발자가 다양한 데이터 리소스를 사용하여 자신의 RLHF 모델을 훈련할 수 있는 기능도 제공합니다.

DeepSpeed -Chat에는 (1) 다양한 데이터 세트의 형식을 통합하는 추상 데이터 세트 레이어와 (2) 데이터 분할/혼합 기능이 탑재되어 있어 여러 데이터 세트를 적절하게 혼합한 다음 3개의 훈련 단계로 분할합니다.

DeepSpeed 훈련에서 ZeRO 기반 최적화와 유연한 병렬 전략의 조합을 통해 달성되는 대형 모델의 기존 미세 조정과 유사한 안내 RLHF 파이프라인의 1단계와 2단계를 나타냅니다. 규모와 속도를 달성하기 위해.

그리고 파이프라인의 3단계는 성능 영향 측면에서 가장 복잡한 부분입니다.

각 반복은 두 단계를 효과적으로 처리해야 합니다. a) 훈련 입력을 생성하기 위해 토큰/경험 생성에 사용되는 추론 단계 b) 행위자와 보상 모델의 가중치를 업데이트하는 훈련 단계 상호 작용 및 일정.

두 가지 주요 어려움이 발생합니다. (1) 여러 SFT 및 RW 모델이 세 번째 단계에서 실행되어야 하기 때문에 메모리 비용이 발생합니다. (2) 제대로 가속되지 않으면 응답 단계의 느린 생성 속도가 크게 느려집니다. 세 번째 단계 전체.

또한 연구원들이 3단계인 지수 이동 평균(EMA) 수집과 하이브리드 훈련에서 추가한 두 가지 중요한 기능에는 추가 메모리 및 훈련 비용이 발생합니다.

이러한 과제를 해결하기 위해 연구원들은 DeepSpeed 훈련 및 추론의 모든 시스템 기능을 통합 인프라인 하이브리드 엔진에 결합했습니다.

빠른 훈련 모드에는 오리지널 DeepSpeed 엔진을 활용하고, 생성/평가 모드에는 DeepSpeed 추론 엔진을 손쉽게 적용하여 RLHF 훈련의 3단계를 위한 더 빠른 훈련 시스템을 제공합니다.

아래 그림에 표시된 것처럼 DeepSpeed 훈련과 추론 엔진 사이의 전환은 원활합니다. 행위자 모델에 대한 일반적인 평가 및 훈련 모드를 활성화함으로써 DeepSpeed는 추론과 훈련을 실행할 때 다양한 최적화를 선택합니다. 프로세스를 통해 모델을 더 빠르게 실행하고 전체 시스템 처리량을 향상시킵니다.

DeepSpeed 하이브리드 엔진은 RLHF 프로세스 중 가장 시간이 많이 걸리는 부분을 가속화하도록 설계되었습니다.

RLHF 교육의 경험 생성 단계 추론 실행 중에 DeepSpeed 하이브리드 엔진 경량 메모리 관리 시스템을 사용하여 KV 캐시 및 중간 결과를 처리하는 동시에 고도로 최적화된 추론 CUDA 코어 및 텐서 병렬 컴퓨팅을 사용하여 기존 솔루션에 비해 처리량(초당 토큰 수)이 크게 증가합니다.

훈련 중에 하이브리드 엔진은 DeepSpeed의 ZeRO 기술 시리즈 및 LoRA(Low-Order Adaptation)와 같은 메모리 최적화 기술을 가능하게 합니다.

연구원들이 이러한 시스템의 최적화를 설계하고 구현하는 방법은 시스템이 서로 호환되도록 만들고 함께 결합하여 통합 하이브리드 엔진에서 최고의 훈련 효율성을 제공할 수 있도록 하는 것입니다.

하이브리드 엔진은 훈련 및 추론 중에 모델 파티셔닝을 원활하게 변경하여 텐서 병렬 기반 추론 및 ZeRO 기반 훈련 샤딩 메커니즘을 지원할 수 있습니다.

또한 모든 모드에서 메모리 가용성을 극대화하기 위해 메모리 시스템을 재구성할 수도 있습니다.

이는 메모리 할당 병목 현상을 방지하고 대규모 배치 크기를 지원하여 성능을 크게 향상시킬 수 있습니다.

요약하자면, 하이브리드 엔진은 현대 RLHF 교육의 한계를 뛰어넘어 RLHF 워크로드에 비교할 수 없는 규모와 시스템 효율성을 제공합니다.

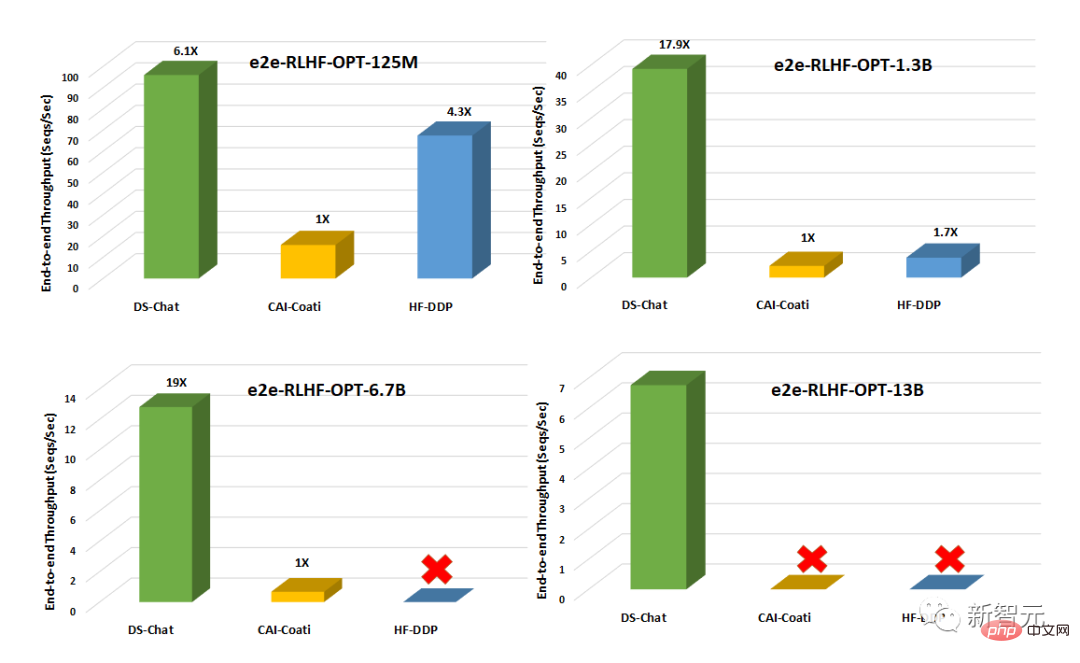

Colossal-AI 또는 HuggingFace-DDP와 같은 기존 시스템과 비교하여 DeepSpeed-Chat은 10배 이상의 처리량을 가지며 동일한 대기 시간 예산으로 더 큰 데이터 세트를 훈련할 수 있습니다. 배우 모델을 사용하거나 비슷한 크기의 모델을 더 저렴한 비용으로 교육합니다.

예를 들어 DeepSpeed는 단일 GPU에서 RLHF 훈련 처리량을 10배 이상 향상시킵니다. CAI-Coati와 HF-DDP는 모두 1.3B 모델을 실행할 수 있지만 DeepSpeed는 동일한 하드웨어에서 6.5B 모델을 실행할 수 있으며 이는 직접적으로 5배 더 높습니다.

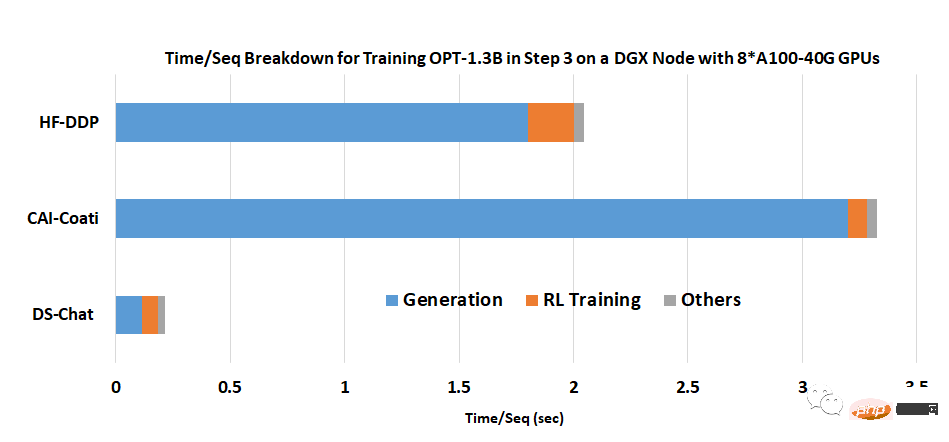

단일 노드의 여러 GPU에서 DeepSpeed-Chat은 시스템 처리량 측면에서 CAI-Coati보다 6~19배 빠르고, HF-DDP는 1.4~10.5배 빠릅니다.

팀은 DeepSpeed-Chat이 이렇게 뛰어난 결과를 얻을 수 있는 주요 이유 중 하나가 세대 단계에서 하이브리드 엔진이 제공하는 가속력이라고 밝혔습니다.

위 내용은 누구나 ChatGPT를 가지고 있습니다! Microsoft DeepSpeed Chat이 충격적으로 출시되었습니다. 수천억 개의 대형 모델에 대한 원 클릭 RLHF 교육의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!