AI가 당신을 똑똑히 보았습니다, YOLO+ByteTrack+다중 라벨 분류 네트워크

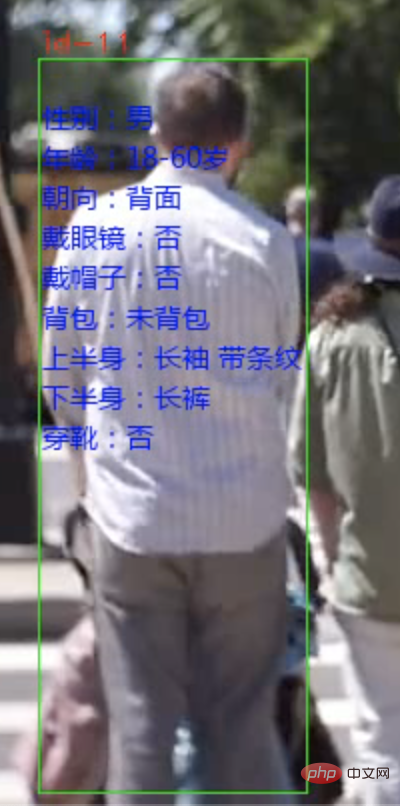

오늘은 보행자 속성 분석 시스템에 대해 알려드리겠습니다. 비디오 또는 카메라 비디오 스트림을 통해 보행자를 식별할 수 있으며 각 사람의 속성을 표시할 수 있습니다.

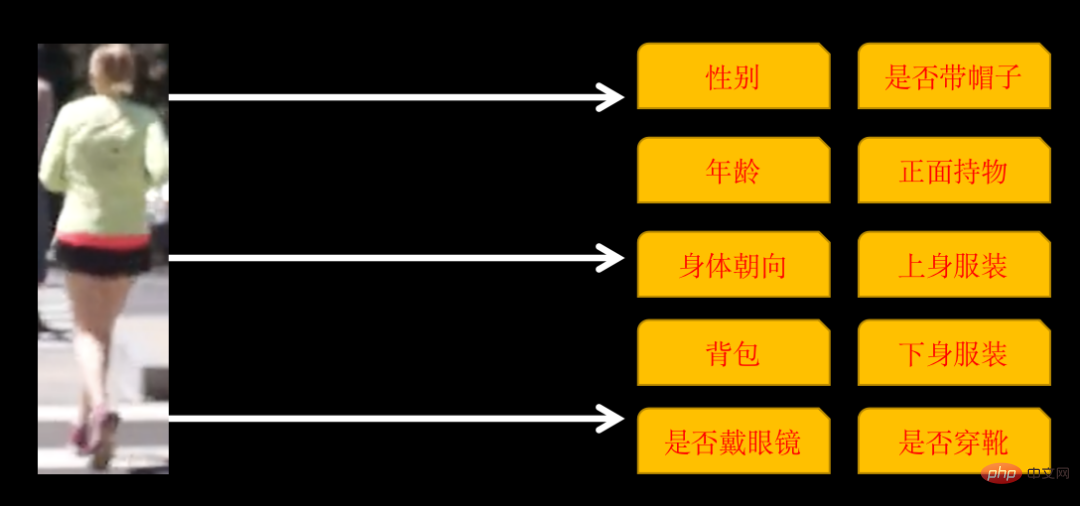

식별된 속성에는 다음 10개의 카테고리가 포함됩니다

신체 방향이 전면, 측면, 후면인 경우 일부 카테고리에는 여러 속성이 있으므로 최종 훈련에는 26개의 속성이 있습니다.

이러한 시스템을 구현하려면 3단계가 필요합니다.

- YOlOv5를 사용하여 보행자를 식별합니다.

- ByteTrack을 사용하여 동일한 사람을 추적하고 표시합니다.

- 다중 레이블 이미지 분류 네트워크를 훈련하여 보행자의 26가지 속성을 식별합니다.

1. 보행자 식별 및 추적

보행자 인식은 YOLOv5 표적 탐지 모델을 사용합니다. 모델을 직접 훈련할 수도 있고, YOLOv5 사전 훈련된 모델을 직접 사용할 수도 있습니다.

보행자 추적은 다중 객체 추적 기술(MOT) 기술을 사용합니다. 영상은 하나의 사진으로 구성됩니다. 우리 인간은 서로 다른 사진에서 동일한 사람을 식별할 수 있지만 보행자를 추적하지 않으면 AI가 식별할 수 없습니다. 동일한 사람을 추적하고 각 보행자에게 고유한 ID를 할당하려면 MOT 기술이 필요합니다.

YOLOv5 모델의 훈련 및 사용, 다중 객체 추적 기술(MOT) 기술의 원리 및 구현 솔루션은 이전 기사에서 자세히 설명되어 있습니다. 관심 있는 친구는 "YOLOv5+ByteTrack 통계" 기사를 확인할 수 있습니다. " 교통 흐름".

2. 다중 라벨 분류 네트워크 훈련

우리가 처음 접한 이미지 분류의 대부분은 단일 라벨 분류였습니다. 즉, 사진은 1개의 카테고리로 분류되고 카테고리는 두 개의 카테고리 또는 다중 카테고리가 될 수 있습니다. . 세 가지 범주가 있다고 가정하면 각 그림에 해당하는 레이블은 다음과 같은 일반적인 형식일 수 있습니다.

001.jpg010 002.jpg100 003.jpg100

label하나의 위치만 1입니다.

오늘 훈련할 다중 라벨 분류 네트워크는 여러 카테고리를 동시에 포함하는 그림입니다. 라벨 형식은 다음과 같습니다:

001.jpg011 002.jpg111 003.jpg100

label은 1개의 위치를 가질 수 있습니다.

이러한 네트워크를 훈련하는 데는 두 가지 옵션이 있습니다. 하나는 각 범주를 단일 레이블 분류로 처리하고, 손실을 별도로 계산하고, 총계를 요약하고, 기울기를 계산하여 네트워크 매개변수를 업데이트하는 것입니다.

다른 하나는 직접 훈련할 수 있지만 네트워크 세부 사항에 주의해야 합니다. ResNet50을 예로 들어보겠습니다.

resnet50 = ResNet50(include_top=False, weights='imagenet')

# 迁移学习,不重新训练卷积层

for layer in resnet50.layers:

layer.trainable = False

# 新的全连接层

x = Flatten()(resnet50.output)

x = Dense(1024)(x)

x = Activation('relu')(x)

x = BatchNormalization()(x)

x = Dropout(0.5)(x)

# 输出 26 个属性的多分类标签

x = Dense(26, activatinotallow='sigmoid')(x)

model = Model(inputs = resnet50.input, outputs=x)최종 출력 레이어의 활성화 함수는 시그모이드여야 합니다. 각 속성. 같은 방식으로 훈련 중 손실 함수도 Binary_crossentropy를 사용해야 합니다.

사실 위 두 방법의 원리는 비슷하지만 개발 작업량은 다릅니다.

여기에서는 편의상 PaddleCls를 사용하여 훈련합니다. Paddle의 구성은 간단하지만 자체 규칙만 따를 수 있고 맞춤 설정이 더 까다롭다는 단점이 있습니다.

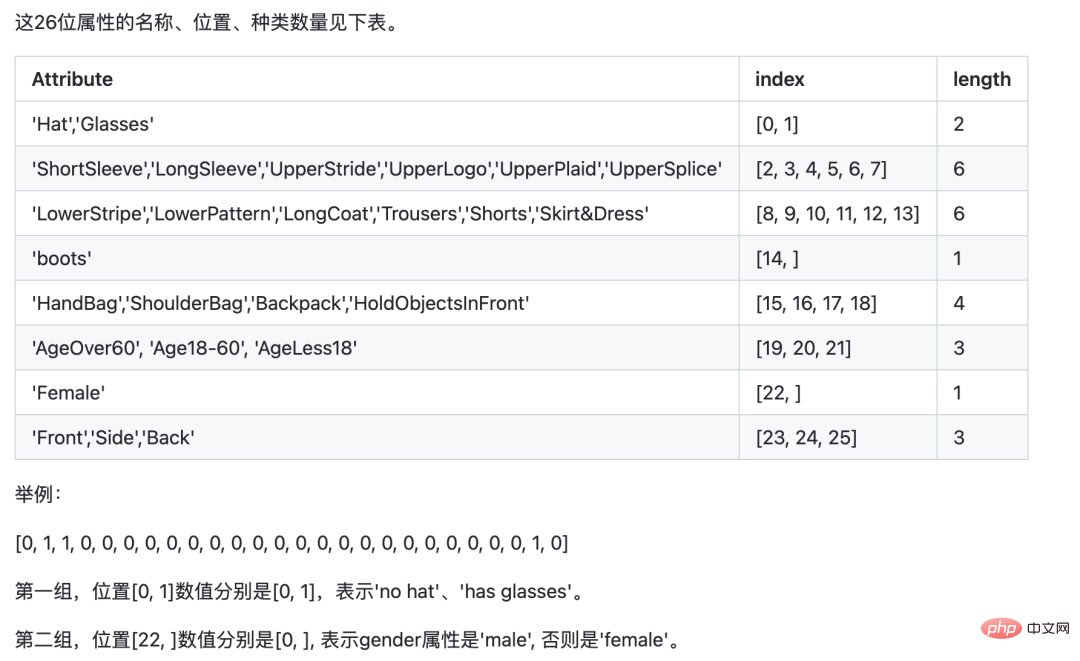

모델 학습에서는 PA100K 데이터 세트를 사용합니다. PA100K 데이터 세트에서 정의한 원래 레이블은 Paddle과 동일한 의미를 갖지만 순서가 다릅니다.

예: 원래 라벨의 첫 번째 숫자는 라벨이 여성인지 여부를 나타내고, Paddle에서는 라벨이 모자를 쓰고 있는지 여부를 나타내기 위해 첫 번째 숫자가 필요하며, 22번째 숫자는 라벨이 여성인지 여부를 나타냅니다.

Paddle의 요구 사항에 따라 원래 라벨 위치를 조정할 수 있으므로 나중에 추론이 더 쉬워집니다.

Download PaddleClas

git clone https://github.com/PaddlePaddle/PaddleClas

다운로드한 데이터세트의 압축을 풀고 PaddleClas의 데이터세트 디렉터리에 넣습니다.

ppcls/configs/PULC/person_attribute/PPLCNet_x1_0.yaml 구성 파일을 찾아 이미지 및 라벨 경로를 구성하세요.

DataLoader: Train: dataset: name: MultiLabelDataset image_root: "dataset/pa100k/" #指定训练AI가 당신을 똑똑히 보았습니다, YOLO+ByteTrack+다중 라벨 분류 네트워크所在根路径 cls_label_path: "dataset/pa100k/train_list.txt" #指定训练列表文件位置 label_ratio: True transform_ops: Eval: dataset: name: MultiLabelDataset image_root: "dataset/pa100k/" #指定评估AI가 당신을 똑똑히 보았습니다, YOLO+ByteTrack+다중 라벨 분류 네트워크所在根路径 cls_label_path: "dataset/pa100k/val_list.txt" #指定评估列表文件位置 label_ratio: True transform_ops:

train_list.txt의 형식은

00001.jpg0,0,1,0,....

입니다. 구성 후

python3 tools/train.py -c ./ppcls/configs/PULC/person_attribute/PPLCNet_x1_0.yaml

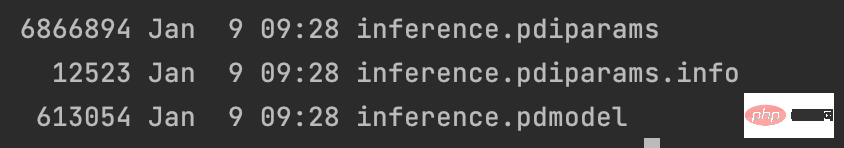

학습 후 모델을 내보내고

python3 tools/export_model.py -c ./ppcls/configs/PULC/person_attribute/PPLCNet_x1_0.yaml -o Global.pretrained_model=output/PPLCNet_x1_0/best_model -o Global.save_inference_dir=deploy/models/PPLCNet_x1_0_person_attribute_infer

내보낸 결과를 ~/.paddleclas/inference_model/PULC/person_attribute/에 배치할 수 있습니다.

디렉토리에서 PaddleCls가 제공하는 함수를 사용하여

import paddleclas model = paddleclas.PaddleClas(model_name="person_attribute") result = model.predict(input_data="./test_imgs/000001.jpg") print(result)

를 직접 호출할 수 있습니다. 출력 결과는 다음과 같습니다.

[{'attributes': ['Female', 'Age18-60', 'Front', 'Glasses: False', 'Hat: False', 'HoldObjectsInFront: True', 'ShoulderBag', 'Upper: ShortSleeve', 'Lower:Trousers', 'No boots'], 'output': [0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 1, 0, 1, 0, 1, 1, 0, 0], 'filename': './test_imgs/000001.jpg'}]모델 학습 프로세스는 여기서 끝납니다. 전체 프로젝트의 데이터 세트와 소스 코드 포장되었습니다.

위 내용은 AI가 당신을 똑똑히 보았습니다, YOLO+ByteTrack+다중 라벨 분류 네트워크의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

비트 코인의 가치는 얼마입니까?

Apr 28, 2025 pm 07:42 PM

비트 코인의 가치는 얼마입니까?

Apr 28, 2025 pm 07:42 PM

비트 코인의 가격은 $ 20,000에서 $ 30,000입니다. 1. Bitcoin의 가격은 2009 년 이후 극적으로 변동하여 2017 년에 거의 20,000 달러에 이르렀으며 2021 년에는 거의 60,000 달러에 달합니다. 가격은 시장 수요, 공급 및 거시 경제 환경과 같은 요인의 영향을받습니다. 3. 거래소, 모바일 앱 및 웹 사이트를 통해 실시간 가격을 얻으십시오. 4. 비트 코인 가격은 시장 감정과 외부 요인에 의해 유발되는 변동성이 높습니다. 5. 전통적인 금융 시장과의 특정 관계가 있으며 글로벌 주식 시장, 미국 달러의 강점 등의 영향을받습니다. 6. 장기 추세는 낙관적이지만, 위험은주의해서 평가되어야합니다.

세계 10 대 통화 거래 플랫폼 중 2025 년 상위 10 개 통화 거래 플랫폼 중 하나

Apr 28, 2025 pm 08:12 PM

세계 10 대 통화 거래 플랫폼 중 2025 년 상위 10 개 통화 거래 플랫폼 중 하나

Apr 28, 2025 pm 08:12 PM

2025 년 전 세계의 상위 10 개 암호 화폐 교환에는 Binance, Okx, Gate.io, Coinbase, Kraken, Huobi, Bitfinex, Kucoin, Bittrex 및 Poloniex가 포함됩니다.

세계의 상위 10 개 통화 거래 플랫폼 중 상위 10 개 통화 거래 플랫폼의 최신 버전

Apr 28, 2025 pm 08:09 PM

세계의 상위 10 개 통화 거래 플랫폼 중 상위 10 개 통화 거래 플랫폼의 최신 버전

Apr 28, 2025 pm 08:09 PM

전 세계의 상위 10 개 암호 화폐 거래 플랫폼에는 Binance, OKX, Gate.io, Coinbase, Kraken, Huobi Global, Bitfinex, Bittrex, Kucoin 및 Poloniex가 포함되며 다양한 거래 방법과 강력한 보안 조치가 제공됩니다.

상위 10 개의 가상 통화 거래 앱은 무엇입니까? 최신 디지털 환전 순위

Apr 28, 2025 pm 08:03 PM

상위 10 개의 가상 통화 거래 앱은 무엇입니까? 최신 디지털 환전 순위

Apr 28, 2025 pm 08:03 PM

Binance, Okx, Gate.io와 같은 상위 10 개 디지털 환전 거래소는 시스템, 효율적인 다양한 거래 및 엄격한 보안 조치를 개선했습니다.

암호 해독 게이트.IO 전략 업그레이드 : Memebox 2.0에서 암호화 자산 관리를 재정의하는 방법?

Apr 28, 2025 pm 03:33 PM

암호 해독 게이트.IO 전략 업그레이드 : Memebox 2.0에서 암호화 자산 관리를 재정의하는 방법?

Apr 28, 2025 pm 03:33 PM

Memebox 2.0은 혁신적인 아키텍처 및 성능 혁신을 통해 암호화 자산 관리를 재정의합니다. 1) 자산 사일로, 소득 부패 및 보안 및 편의의 역설의 세 가지 주요 고통 지점을 해결합니다. 2) 지능형 자산 허브, 동적 위험 관리 및 반환 향상 엔진을 통해 크로스 체인 전송 속도, 평균 수율 및 보안 사고 응답 속도가 향상됩니다. 3) 사용자 가치 재구성을 실현하여 자산 시각화, 정책 자동화 및 거버넌스 통합을 사용자에게 제공합니다. 4) 생태 협력 및 규정 준수 혁신을 통해 플랫폼의 전반적인 효과가 향상되었습니다. 5) 앞으로, 스마트 계약 보험 풀, 예측 시장 통합 및 AI 중심 자산 할당이 시작되어 업계의 발전을 계속 이끌 것입니다.

최고 통화 거래 플랫폼은 무엇입니까? 상위 10 개 최신 가상 화폐 거래소

Apr 28, 2025 pm 08:06 PM

최고 통화 거래 플랫폼은 무엇입니까? 상위 10 개 최신 가상 화폐 거래소

Apr 28, 2025 pm 08:06 PM

현재 10 개의 가상 환전 거래소 중 하나입니다. 1. Binance, 2. OKX, 3. Gate.io, 4. Coin Library, 5. Siren, 6. Huobi Global Station, 7. Bybit, 8. Bitcoin, 10. 비트 스탬프.

신뢰할 수있는 디지털 통화 거래 플랫폼. 세계 10 대 디지털 환전. 2025

Apr 28, 2025 pm 04:30 PM

신뢰할 수있는 디지털 통화 거래 플랫폼. 세계 10 대 디지털 환전. 2025

Apr 28, 2025 pm 04:30 PM

권장 신뢰할 수있는 디지털 통화 거래 플랫폼 : 1. OKX, 2. BINANCE, 3. COINBASE, 4. KRAKEN, 5. HUOBI, 6. KUCOIN, 7. BITFINEX, 8. GEMINI, 9. BITSTAMP, 10. POLONIEX, 이러한 플랫폼, 사용자 경험 및 다양한 기능, 다양한 수준의 사용자에게 적합합니다.

C에서 Chrono 라이브러리를 사용하는 방법?

Apr 28, 2025 pm 10:18 PM

C에서 Chrono 라이브러리를 사용하는 방법?

Apr 28, 2025 pm 10:18 PM

C에서 Chrono 라이브러리를 사용하면 시간과 시간 간격을보다 정확하게 제어 할 수 있습니다. 이 도서관의 매력을 탐구합시다. C의 크로노 라이브러리는 표준 라이브러리의 일부로 시간과 시간 간격을 다루는 현대적인 방법을 제공합니다. 시간과 C 시간으로 고통받는 프로그래머에게는 Chrono가 의심 할 여지없이 혜택입니다. 코드의 가독성과 유지 가능성을 향상시킬뿐만 아니라 더 높은 정확도와 유연성을 제공합니다. 기본부터 시작합시다. Chrono 라이브러리에는 주로 다음 주요 구성 요소가 포함됩니다. std :: Chrono :: System_Clock : 현재 시간을 얻는 데 사용되는 시스템 클럭을 나타냅니다. STD :: 크론