딥러닝에는 새로운 함정이 있습니다! 시드니 대학교는 텍스트를 사용하여 이미지 컷아웃을 안내하는 새로운 교차 모드 작업을 제안합니다.

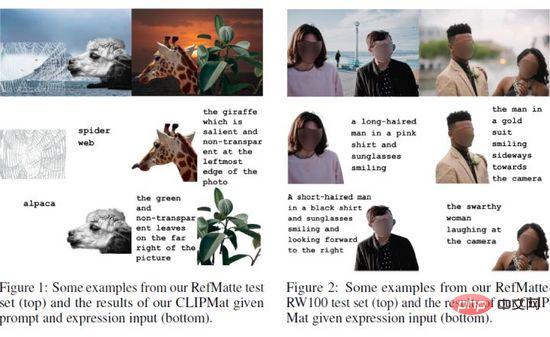

이미지 컷아웃은 이미지에서 정확한 전경을 추출하는 것을 말합니다. 현재의 자동 방법은 이미지에서 모든 주요 개체를 무차별적으로 추출하는 경향이 있습니다. 본 논문에서 저자는 주어진 자연어 설명과 가장 잘 일치할 수 있는 특정 객체의 상세한 알파 매트를 추출하는 것을 의미하는 RIM(Reference Image Matting)이라는 새로운 작업을 제안합니다. 그러나 널리 사용되는 시각적 접지 방법은 고품질 RIM 데이터 세트가 부족하기 때문에 분할 수준으로 제한됩니다. 이러한 격차를 메우기 위해 저자는 유연성 논리와 재라벨링된 다양한 속성을 통해 현재 공개된 고품질 매트 전망을 기반으로 합성 이미지를 생성하는 포괄적인 이미지 합성 및 표현 생성 엔진을 설계하여 최초의 대규모 도전적인 데이터 세트인 RefMatte를 구축했습니다. .

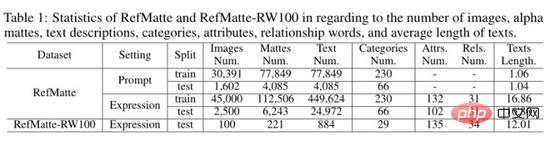

RefMatte는 230개 개체 카테고리, 47,500개 이미지, 118,749개 표현 영역 엔터티, 474,996개 표현으로 구성되어 있으며 향후에도 쉽게 확장할 수 있습니다. 또한 저자는 RIM 모델의 일반화 능력을 추가로 평가하기 위해 인위적으로 생성된 문구 주석을 사용하여 100개의 자연 이미지로 구성된 실제 테스트 세트를 구축했습니다. 먼저 프롬프트 기반과 표현 기반의 두 가지 컨텍스트에서 RIM 작업을 정의한 다음 몇 가지 일반적인 이미지 매트 방법과 특정 모델 디자인을 테스트했습니다. 이러한 결과는 기존 방법의 한계와 가능한 솔루션에 대한 경험적 통찰력을 제공합니다. 새로운 작업 RIM과 새로운 데이터 세트 RefMatte는 이 분야에서 새로운 연구 방향을 제시하고 향후 연구를 촉진할 것으로 믿어집니다.

논문 제목: Reference Image Matting

논문 주소: https://arxiv.org/abs/2206.0514 9

코드 주소: https://github.com/JizhiziLi/RI M

1.

이미지매팅이란 전경의 부드러운 아파매팅을 자연스러운 영상으로 추출하는 것을 말하며 화상회의, 광고제작, 전자상거래 프로모션 등 다양한 다운스트림 애플리케이션에 유리합니다. 일반적인 매팅 방법은 1) 트라이맵과 같은 보조 입력 기반 방법과 2) 수동 개입 없이 전경을 추출하는 자동 매팅 방법의 두 가지 그룹으로 나눌 수 있습니다. 그러나 전자는 자동 적용 시나리오에 적합하지 않으며 후자는 일반적으로 사람, 동물 또는 모든 중요한 개체와 같은 특정 개체 범주로 제한됩니다. 임의의 객체에 대해 제어 가능한 이미지 매트를 수행하는 방법, 즉 주어진 자연어 설명과 가장 잘 일치하는 특정 객체의 알파 매트를 추출하는 방법은 여전히 탐구해야 할 문제입니다.

참조 표현 분할(RES), 참조 이미지 분할(RIS), 시각적 질문 답변(VQA), 참조 표현 이해(REC)와 같은 언어 기반 작업이 널리 탐구되었습니다. ReferIt, Google RefExp, RefCOCO, VGPhraseCut 및 Cops-Ref와 같은 많은 데이터 세트를 기반으로 이 영역에서 큰 진전이 이루어졌습니다. 예를 들어, RES 방법은 자연어 설명으로 표시된 임의의 객체를 분할하는 것을 목표로 합니다. 그러나 획득된 마스크는 데이터 세트의 저해상도 이미지와 거친 마스크 주석으로 인해 미세한 세부 사항이 없는 분할 수준으로 제한됩니다. 따라서 전경 개체의 상세한 알파 매트가 필요한 장면에서는 사용되지 않을 것입니다.

이러한 공백을 메우기 위해 저자는 본 논문에서 "RIM(Referring Image Matting)"이라는 새로운 작업을 제안합니다. RIM은 상세한 고품질 알파 매트와 함께 주어진 자연어 설명과 가장 잘 일치하는 이미지의 특정 전경 개체를 추출하는 것을 말합니다. 위의 두 가지 매팅 방법으로 해결한 작업과 달리 RIM은 언어적 설명이 나타내는 이미지에서 임의의 개체에 대한 제어 가능한 이미지 매팅을 목표로 합니다. 이는 산업 응용 분야에서 실질적인 의미를 가지며 학계에 새로운 연구 방향을 제시합니다.

RIM 연구를 촉진하기 위해 저자는 230개의 개체 범주, 47,500개의 이미지, 118,749개의 표현 영역 엔터티와 해당 고품질 알파 매트 및 474,996개의 표현 구성으로 구성된 RefMatte라는 첫 번째 데이터 세트를 구축했습니다.

구체적으로, 이 데이터 세트를 구축하기 위해 저자는 먼저 AM-2k, P3M-10k, AIM-500, SIM과 같은 널리 사용되는 공개 매트 데이터 세트를 다시 방문하고 각 개체에 수동으로 레이블을 지정하여 신중하게 검사했습니다. 또한 저자는 여러 딥 러닝 기반의 사전 훈련된 모델을 사용하여 인간의 성별, 연령, 의복 유형과 같은 각 개체에 대한 다양한 속성을 생성합니다. 그런 다음 저자는 다른 전경 개체를 고려하여 합리적인 절대 및 상대 위치로 합성 이미지를 생성하기 위한 포괄적인 구성 및 표현 생성 엔진을 설계합니다. 마지막으로 저자는 다양한 언어 설명을 생성하기 위해 풍부한 시각적 속성을 활용하는 여러 표현 논리 형식을 제안합니다. 또한 저자는 RIM 방법의 일반화 능력을 평가하기 위해 다양한 개체와 사람의 주석이 달린 표현을 포함하는 100개의 이미지가 포함된 실제 테스트 세트 RefMatte-RW100을 제안합니다. 위의 이미지는 몇 가지 예를 보여줍니다.

관련 작업에서 최신 방법에 대한 공정하고 종합적인 평가를 제공하기 위해 저자는 이를 힌트 기반 설정과 표현 기반 설정의 두 가지 설정으로 RefMatte에서 벤치마킹합니다. 언어적 설명. 대표적인 방법은 세분화 작업을 위해 특별히 설계되었기 때문에 이를 RIM 작업에 직접 적용할 때 여전히 격차가 있습니다.

이 문제를 해결하기 위해 저자는 RIM에 맞게 사용자 정의하는 두 가지 전략을 제안했습니다. 즉, 1) CLIPSeg 위에 CLIPmat이라는 경량 매트 헤더를 신중하게 설계하여 고품질 알파 매트 결과를 생성하는 동시에 엔드투엔드를 유지합니다. 2) 세분화/매팅 결과를 더욱 향상시키기 위해 여러 개의 개별적인 거친 이미지 기반 매팅 방법이 사후 구체화로 제공됩니다. 광범위한 실험 결과 1) RIM 작업 연구를 위해 제안된 RefMatte 데이터 세트의 가치를 입증하고, 2) 언어 설명 형식의 중요한 역할을 식별하고, 3) 제안된 사용자 정의 전략의 효율성을 검증합니다.

이 연구의 주요 기여는 세 가지입니다. 1) 주어진 자연어 설명과 가장 잘 일치하는 특정 전경 개체의 알파 매트를 식별하고 추출하는 것을 목표로 하는 RIM이라는 새로운 작업을 정의합니다. 2) 47,500개의 이미지 이미지와 118,749개의 표현 영역으로 구성된 최초의 대규모 데이터 세트 RefMatte를 설정합니다. 고품질 알파 매트 및 풍부한 표현을 갖춘 엔터티 3) RefMatte에 대한 두 가지 RIM 맞춤형 전략을 사용하여 두 가지 다른 설정에서 대표적인 최첨단 방법을 벤치마킹하고 몇 가지 유용한 통찰력을 얻었습니다.

2. 방법

이 섹션에서는 RefMatte를 빌드하는 파이프라인(섹션 3.1 및 섹션 3.2)과 작업 설정(섹션 3.3) 및 데이터 세트의 통계(섹션 3.5)가 소개됩니다. . 위 이미지는 RefMatte의 몇 가지 예를 보여줍니다. 또한 저자는 수동으로 레이블이 지정된 풍부한 언어 설명으로 주석이 달린 100개의 자연 이미지로 구성된 실제 테스트 세트를 구성합니다(섹션 3.4).

2.1 매트 엔터티 준비

RefMatte 데이터 세트를 구축하는 데 도움이 될 만큼 고품질 매트 엔터티를 준비하기 위해 저자는 현재 사용 가능한 매트 데이터 세트를 다시 방문하여 요구 사항을 충족하는 잠재 고객을 필터링합니다. 그런 다음 모든 후보 엔터티에는 해당 카테고리로 수동으로 레이블이 지정되고 여러 딥 러닝 기반 사전 학습 모델을 사용하여 해당 속성에 주석이 추가됩니다.

전처리 및 필터링

이미지 매트 작업의 특성상 모든 후보 엔터티는 고해상도여야 하며 알파 매트에 명확하고 미세한 디테일이 있어야 합니다. 또한 데이터는 향후 연구를 촉진하기 위해 공개 라이센스를 통해 개인 정보 보호 문제 없이 공개적으로 이용 가능해야 합니다. 이러한 요구 사항을 위해 저자는 AM-2k, P3M-10k 및 AIM-500의 모든 전경 이미지를 사용했습니다. 특히 P3M-10k의 경우 작성자는 두 개 이상의 고정 전경 인스턴스가 있는 이미지를 필터링하여 각 엔터티가 하나의 전경 인스턴스에만 연결되도록 합니다. SIM, DIM 및 HATT와 같은 다른 사용 가능한 데이터 세트의 경우 작성자는 인간 인스턴스 중에서 식별 가능한 얼굴이 있는 전경 이미지를 필터링합니다. 저자는 또한 해상도가 낮거나 알파 매트 품질이 낮은 전경 이미지를 필터링합니다. 최종 총 엔터티 수는 13,187개였습니다. 후속 합성 단계에 사용되는 배경 이미지의 경우 저자는 BG-20k의 모든 이미지를 선택했습니다.

엔티티의 카테고리 이름에 주석 달기

이전의 자동 잘라내기 방법은 이미지에서 전경에 있는 주요 개체를 모두 추출하는 경향이 있었기 때문에 각 엔터티에 대한 특정(카테고리) 이름을 제공하지 않았습니다. 그러나 RIM 작업의 경우 이를 설명하려면 엔터티 이름이 필요합니다. 저자는 사람들이 특정 엔터티에 사용하는 가장 일반적인 이름을 나타내는 항목 수준 범주 이름으로 각 엔터티에 레이블을 지정했습니다. 여기서는 반자동 전략이 사용됩니다. 특히 저자는 ResNet-50-FPN 백본과 함께 Mask RCNN 감지기를 사용하여 각 전경 인스턴스의 클래스 이름을 자동으로 감지하고 레이블을 지정한 다음 수동으로 검사하고 수정합니다. RefMatte에는 총 230개의 카테고리가 있습니다. 또한 저자는 다양성을 높이기 위해 WordNet을 사용하여 각 범주 이름에 대한 동의어를 생성합니다. 저자는 수동으로 동의어를 확인하고 그 중 일부를 보다 합리적인 동의어로 대체했습니다.

엔티티 속성에 주석 달기

모든 엔터티가 풍부한 시각적 속성을 가지도록 하여 풍부한 표현의 형성을 지원하기 위해 저자는 인간의 색상, 성별, 연령 및 의복 유형과 같은 다양한 속성을 모든 엔터티에 주석을 달았습니다. 엔터티. 저자는 또한 이러한 속성을 생성하기 위해 반자동 전략을 사용합니다. 색상을 생성하기 위해 저자는 전경 이미지의 모든 픽셀 값을 클러스터링하고 가장 일반적인 값을 찾아 웹 색상의 특정 색상과 일치시킵니다. 성별과 연령에 대해 저자는 사전 훈련된 모델을 사용합니다. 상식을 사용하여 예상 연령을 기준으로 연령 그룹을 정의합니다. 의류 유형의 경우 저자는 사전 훈련된 모델을 사용합니다. 또한, 전경 분류에서 영감을 받아 저자는 눈에 띄거나 중요하지 않은 속성과 투명하거나 불투명한 속성을 모든 엔터티에 추가합니다. 이러한 속성은 이미지 매트 작업에서도 중요하기 때문입니다. 궁극적으로 모든 개체에는 최소 3개의 속성이 있고, 인간 개체에는 최소 6개의 속성이 있습니다.

2.2 이미지 합성 및 표현 생성

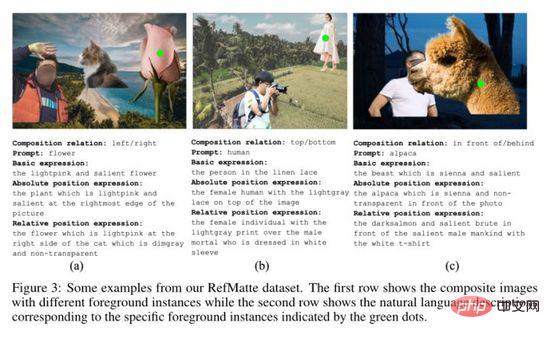

이전 섹션에서 수집한 컷아웃 엔터티를 기반으로 저자는 RefMatte 데이터 세트를 구축하기 위한 이미지 합성 엔진과 표현 생성 엔진을 제안했습니다. 다양한 엔터티를 배열하여 합리적인 합성 이미지를 형성하는 동시에 이러한 합성 이미지의 엔터티를 설명하기 위해 의미상 명확하고 문법적으로 정확하며 풍부하고 화려한 표현을 생성하는 방법이 RefMatte를 구축하는 핵심이며 또한 어렵습니다. 이를 위해 저자는 합성 이미지에서 서로 다른 개체를 배열하기 위한 6가지 위치 관계를 정의하고 서로 다른 논리적 형식을 활용하여 적절한 표현을 생성합니다.

이미지 구성 엔진

엔터티의 고해상도를 유지하면서 합리적인 위치 관계로 배열하기 위해 저자는 각 합성 이미지에 대해 2~3개의 엔터티를 채택합니다. 저자는 왼쪽, 오른쪽, 위, 아래, 앞, 뒤의 여섯 가지 위치 관계를 정의합니다. 각 관계에 대해 전경 이미지가 먼저 생성되고 BG-20k의 배경 이미지와 알파 블렌딩을 통해 합성되었습니다. 특히 왼쪽, 오른쪽, 위쪽 및 아래쪽 관계의 경우 작성자는 세부 정보를 보존하기 위해 전경 인스턴스에 폐색이 없는지 확인합니다. 전후 관계의 경우 전경 인스턴스 간의 폐색은 상대 위치를 조정하여 시뮬레이션됩니다. 저자는 각 관계를 나타내는 후보 단어 가방을 준비합니다.

표현 생성 엔진

합성 이미지의 개체에 대한 풍부한 표현 방법을 제공하기 위해 저자는 정의된 다양한 논리 형식의 관점에서 각 개체에 대해 세 가지 표현 방법을 정의합니다. 여기서  는 속성을 나타내고

는 속성을 나타내고  는 범주를 나타냅니다. 이름 ,

는 범주를 나타냅니다. 이름 ,  는 참조 엔터티와 관련 엔터티 간의 관계를 나타냅니다. 세 가지 특정 표현의 예는 위의 (a), (b) 및 (c)에 나와 있습니다.

는 참조 엔터티와 관련 엔터티 간의 관계를 나타냅니다. 세 가지 특정 표현의 예는 위의 (a), (b) 및 (c)에 나와 있습니다.

2.3 데이터세트 분할 및 작업 설정

데이터세트 분할

데이터세트에는 총 13,187개의 지도 엔터티가 있으며, 그 중 11,799개는 훈련 세트를 만드는 데 사용되고 1,388개는 테스트 세트에 사용됩니다. 그러나 대부분의 엔터티가 인간 또는 동물 범주에 속하기 때문에 훈련 및 테스트 세트의 범주는 균형이 맞지 않습니다. 구체적으로 훈련 세트의 11,799개 엔터티 중 인간은 9,186명, 동물은 1,800개, 객체는 813개입니다. 1,388개의 엔터티로 구성된 테스트 세트에는 인간 977명, 동물 200명, 개체 211개가 있습니다. 범주의 균형을 맞추기 위해 저자는 개체를 복제하여 인간:동물:객체의 5:1:1 비율을 달성했습니다. 따라서 훈련 세트에는 인간 10,550명, 동물 2,110개, 객체 2,110개가 있고, 테스트 세트에는 인간 1,055명, 동물 211개, 객체 211개가 있습니다.

RefMatte용 이미지를 생성하기 위해 저자는 훈련 또는 테스트 분할에서 인간 5명, 동물 1명, 개체 1개 세트를 선택하여 이미지 합성 엔진에 공급합니다. 훈련 또는 테스트 분할의 각 그룹에 대해 저자는 훈련 세트를 구성하기 위해 20개의 이미지를 생성하고 테스트 세트를 구성하기 위해 10개의 이미지를 생성했습니다. 왼쪽/오른쪽:상단/하단:앞/뒤 관계의 비율은 7:2:1로 설정됩니다. 각 이미지의 엔터티 수는 2 또는 3으로 설정됩니다. 맥락에 따라 작성자는 각 엔터티에 대해 높은 해상도를 유지하기 위해 항상 2개의 엔터티를 선택합니다. 이 과정을 거치면 훈련 이미지 42,200개와 테스트 이미지 2,110개가 생성됩니다. 엔터티 조합의 다양성을 더욱 향상시키기 위해 모든 후보에서 엔터티와 관계를 무작위로 선택하여 또 다른 2800개의 훈련 이미지와 390개의 테스트 이미지를 구성합니다. 마지막으로 훈련 세트에는 45,000개의 합성 이미지가 있고 테스트 세트에는 2,500개의 이미지가 있습니다.

작업 설정

다양한 형태의 언어 설명이 주어진 RIM 접근 방식을 벤치마킹하기 위해 작성자는 RefMatte에서 두 가지 설정을 설정했습니다.

프롬프트 기반 설정: 이 설정의 텍스트 설명은 프롬프트입니다. -레벨 항목 엔터티 이름 예를 들어 위 그림의 프롬프트는 꽃, 인간, 알파카입니다.

표현 기반 설정: 이 설정에서 텍스트 설명은 기본에서 선택한 표현입니다. 식, 절대 위치 식, 상대 위치 식. 위 이미지에서도 몇 가지 예를 볼 수 있습니다.

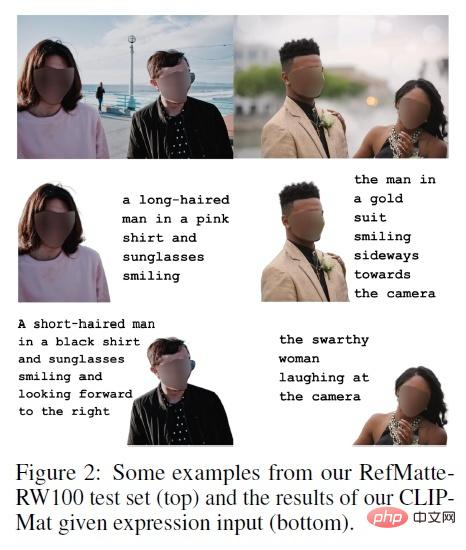

2.4 실제 테스트 세트

RefMatte는 합성 이미지를 기반으로 하기 때문에 실제 이미지와 도메인 차이가 있을 수 있습니다. 실제 이미지에 대해 훈련된 RIM 모델의 일반화 능력을 연구하기 위해 저자는 100개의 실제 고해상도 이미지로 구성된 RefMatte-RW100이라는 실제 테스트 세트를 추가로 구축했습니다. 에는 2~3개의 엔터티가 있습니다. 그런 다음 저자는 섹션 3.2의 동일한 세 가지 설정에 따라 표현에 주석을 추가합니다. 추가적으로 저자는 주석에 자유로운 표현을 추가했습니다. 고품질 알파 컷아웃 태그의 경우 작성자는 Adobe Photoshop 및 GIMP와 같은 이미지 편집 소프트웨어를 사용하여 생성합니다. RefMatte-RW100의 몇 가지 예가 위에 나와 있습니다.

2.5 RefMatte 데이터세트와 RefMatte-RW100 테스트 세트의 통계

저자는 RefMatte 데이터세트와 RefMatte-RW100 테스트 세트의 통계를 위 표와 같이 계산했습니다. 프롬프트 기반 설정의 경우 텍스트 설명이 엔트리 레벨 카테고리 이름이므로 작성자는 모호한 추론을 피하기 위해 동일한 카테고리에 속하는 여러 엔터티가 있는 이미지를 제거합니다. 따라서 이 설정에서는 훈련 세트에 30,391개의 이미지가 있고 테스트 세트에 1,602개의 이미지가 있습니다. 알파 컷아웃의 수, 텍스트 설명, 카테고리, 속성 및 관계가 위 표에 각각 표시됩니다. 프롬프트 기반 설정에서는 일반적으로 범주당 하나의 단어만 있기 때문에 평균 텍스트 길이는 약 1인 반면, 표현식 기반 설정에서는 훨씬 더 깁니다(예: RefMatte에서 약 16.8, RefMatte-RW100에서 약 16.8). 12.

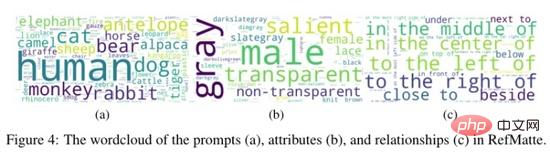

저자는 위 그림의 RefMatte에서 프롬프트, 속성 및 관계로 구성된 단어 구름도 생성했습니다. 볼 수 있듯이 데이터 세트에는 이미지 매트 작업에서 매우 일반적이기 때문에 인간과 동물의 많은 부분이 포함되어 있습니다. RefMatte의 가장 일반적인 속성은 남성형, 회색형, 투명형, 두드러진 속성인 반면 관계형 단어는 보다 균형 잡혀 있습니다.

3. 실험

RIM과 RIS/RES의 작업 차이로 인해 RIS/RES 방법을 RIM에 직접 적용한 결과는 낙관적이지 않습니다. 이 문제를 해결하기 위해 저자는 RIM을 위해 맞춤화하는 두 가지 전략을 제안합니다.

1) 매트 헤드 추가: 기존 모델 위에 경량 매트 헤드를 설계하여 이식성을 유지하면서 고품질 알파 매트를 생성합니다. 엔드투엔드 훈련 가능한 파이프라인 . 특히 저자는 CLIPMat이라는 경량 매트 디코더를 설계했습니다.

2) 매트 리파이너 사용: 저자는 세분화/매팅 결과를 더욱 향상시키기 위해 거친 이미지를 기반으로 하는 별도의 매트 방법을 사용합니다. 위의 방법 중. 특히 저자는 컷아웃 리파이너로 이미지와 거친 이미지를 입력하여 GFM과 P3M을 교육합니다.

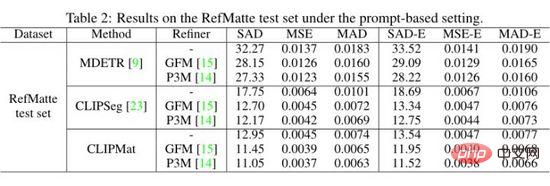

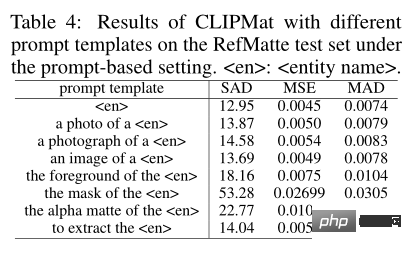

저자는 RefMatte 테스트 세트의 힌트 기반 설정에서 MDETR, CLIPSeg 및 CLIPMat을 평가하고 정량적 결과를 위 표에 표시합니다. MDETR 및 CLIPSeg와 비교하여 CLIPMat은 컷아웃 구체화 사용 여부에 관계없이 가장 잘 수행되는 것을 볼 수 있습니다. RIM 작업에 대해 CLIPSeg를 사용자 정의하기 위해 컷아웃 헤더를 추가하는 효과를 검증합니다. 또한 두 가지 컷아웃 구체화 중 하나를 사용하면 세 가지 방법의 성능을 더욱 향상시킬 수 있습니다.

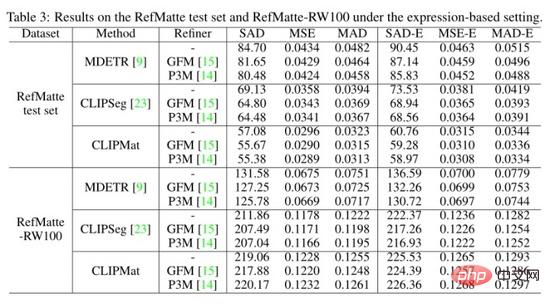

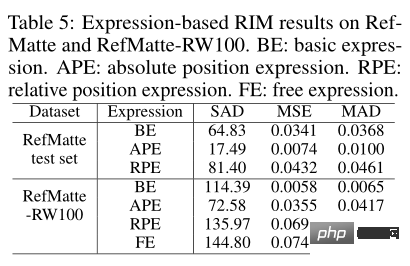

저자들도 RefMatte 테스트 세트에 대한 세 가지 방법과 RefMatte-RW100의 표현 기반 설정을 평가하고 정량적 결과를 위 표에 표시했습니다. CLIPMat은 RefMatte 테스트 세트에 대한 더 많은 세부 정보를 보존하는 좋은 기능을 다시 보여줍니다. CLIPSeg 및 CLIPMat과 같은 단일 단계 방법은 RefMatte-RW100에서 테스트할 때 2단계 방법, 즉 MDETR보다 뒤떨어집니다. 이는 아마도 교차 모달 의미론을 이해하는 MDETR 검출기의 더 나은 능력 때문일 것입니다.

프롬프트 입력 형식의 영향을 조사하기 위해 저자는 다양한 프롬프트 템플릿의 성능을 평가했습니다. 사용된 전통적인 템플릿 외에도 저자는

이 기사에서는 작업의 다양한 표현 유형을 소개하므로 각 유형이 컷아웃 성능에 미치는 영향을 확인할 수 있습니다. 위 표에서 볼 수 있듯이 가장 성능이 뛰어난 모델인 CLIPMat는 RefMatte 테스트 세트에서 테스트되었으며 MDETR 모델은 RefMatte-RW100에서 테스트되었습니다.

4. 요약

본 논문에서는 RIM(Reference Image Matting)이라는 새로운 작업을 제안하고 대규모 데이터 세트인 RefMatte를 구축합니다. 저자는 RIM 관련 작업에 대한 기존 대표 방법을 맞춤화하고 RefMatte에 대한 광범위한 실험을 통해 성능을 측정합니다. 본 논문의 실험 결과는 모델 설계, 텍스트 설명의 영향, 합성 이미지와 실제 이미지 사이의 영역 격차에 대한 유용한 통찰력을 제공합니다. RIM 연구는 대화형 이미지 편집 및 인간-컴퓨터 상호 작용과 같은 많은 실제 응용 프로그램에 도움이 될 수 있습니다. RefMatte는 이 분야의 연구를 촉진할 수 있습니다. 그러나 합성과 실제 영역의 차이로 인해 실제 이미지에 대한 일반화가 제한될 수 있습니다.

위 내용은 딥러닝에는 새로운 함정이 있습니다! 시드니 대학교는 텍스트를 사용하여 이미지 컷아웃을 안내하는 새로운 교차 모드 작업을 제안합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7503

7503

15

15

1377

1377

52

52

78

78

11

11

52

52

19

19

19

19

54

54

세계에서 가장 강력한 오픈 소스 MoE 모델이 여기에 있습니다. 중국의 기능은 GPT-4와 비슷하며 가격은 GPT-4-Turbo의 거의 1%에 불과합니다.

May 07, 2024 pm 04:13 PM

세계에서 가장 강력한 오픈 소스 MoE 모델이 여기에 있습니다. 중국의 기능은 GPT-4와 비슷하며 가격은 GPT-4-Turbo의 거의 1%에 불과합니다.

May 07, 2024 pm 04:13 PM

기존 컴퓨팅을 능가할 뿐만 아니라 더 낮은 비용으로 더 효율적인 성능을 달성하는 인공 지능 모델을 상상해 보세요. 이것은 공상과학 소설이 아닙니다. DeepSeek-V2[1], 세계에서 가장 강력한 오픈 소스 MoE 모델이 여기에 있습니다. DeepSeek-V2는 경제적인 훈련과 효율적인 추론이라는 특징을 지닌 전문가(MoE) 언어 모델의 강력한 혼합입니다. 이는 236B 매개변수로 구성되며, 그 중 21B는 각 마커를 활성화하는 데 사용됩니다. DeepSeek67B와 비교하여 DeepSeek-V2는 더 강력한 성능을 제공하는 동시에 훈련 비용을 42.5% 절감하고 KV 캐시를 93.3% 줄이며 최대 생성 처리량을 5.76배로 늘립니다. DeepSeek은 일반 인공지능을 연구하는 회사입니다.

AI가 수학적 연구를 전복시킨다! 필즈상 수상자이자 중국계 미국인 수학자, Terence Tao가 좋아하는 11개 논문 발표 |

Apr 09, 2024 am 11:52 AM

AI가 수학적 연구를 전복시킨다! 필즈상 수상자이자 중국계 미국인 수학자, Terence Tao가 좋아하는 11개 논문 발표 |

Apr 09, 2024 am 11:52 AM

AI는 실제로 수학을 변화시키고 있습니다. 최근 이 문제에 주목하고 있는 타오저쉬안(Tao Zhexuan)은 '미국수학회지(Bulletin of the American Mathematical Society)' 최신호를 게재했다. '기계가 수학을 바꿀 것인가?'라는 주제를 중심으로 많은 수학자들이 그들의 의견을 표현했습니다. 저자는 필즈상 수상자 Akshay Venkatesh, 중국 수학자 Zheng Lejun, 뉴욕대학교 컴퓨터 과학자 Ernest Davis 등 업계의 유명 학자들을 포함해 강력한 라인업을 보유하고 있습니다. AI의 세계는 극적으로 변했습니다. 이 기사 중 상당수는 1년 전에 제출되었습니다.

ORB-SLAM3를 넘어! SL-SLAM: 저조도, 심한 흔들림, 약한 텍스처 장면을 모두 처리합니다.

May 30, 2024 am 09:35 AM

ORB-SLAM3를 넘어! SL-SLAM: 저조도, 심한 흔들림, 약한 텍스처 장면을 모두 처리합니다.

May 30, 2024 am 09:35 AM

이전에 작성했던 오늘은 딥 러닝 기술이 복잡한 환경에서 비전 기반 SLAM(동시 위치 파악 및 매핑)의 성능을 향상할 수 있는 방법에 대해 논의합니다. 심층 특징 추출과 깊이 일치 방법을 결합하여 저조도 조건, 동적 조명, 질감이 약한 영역 및 심한 지터와 같은 까다로운 시나리오에서 적응을 향상하도록 설계된 다목적 하이브리드 시각적 SLAM 시스템을 소개합니다. 우리 시스템은 확장 단안, 스테레오, 단안 관성 및 스테레오 관성 구성을 포함한 여러 모드를 지원합니다. 또한 시각적 SLAM을 딥러닝 방법과 결합하여 다른 연구에 영감을 주는 방법도 분석합니다. 공개 데이터 세트 및 자체 샘플링 데이터에 대한 광범위한 실험을 통해 위치 정확도 및 추적 견고성 측면에서 SL-SLAM의 우수성을 입증합니다.

안녕하세요, 일렉트릭 아틀라스입니다! 보스턴 다이나믹스 로봇 부활, 180도 이상한 움직임에 겁먹은 머스크

Apr 18, 2024 pm 07:58 PM

안녕하세요, 일렉트릭 아틀라스입니다! 보스턴 다이나믹스 로봇 부활, 180도 이상한 움직임에 겁먹은 머스크

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas가 공식적으로 전기 로봇 시대에 돌입했습니다! 어제 유압식 Atlas가 역사의 무대에서 "눈물을 흘리며" 물러났습니다. 오늘 Boston Dynamics는 전기식 Atlas가 작동 중이라고 발표했습니다. 상업용 휴머노이드 로봇 분야에서는 보스턴 다이내믹스가 테슬라와 경쟁하겠다는 각오를 다진 것으로 보인다. 새 영상은 공개된 지 10시간 만에 이미 100만 명이 넘는 조회수를 기록했다. 옛 사람들은 떠나고 새로운 역할이 등장하는 것은 역사적 필연이다. 올해가 휴머노이드 로봇의 폭발적인 해라는 것은 의심의 여지가 없습니다. 네티즌들은 “로봇의 발전으로 올해 개막식도 인간처럼 생겼고, 자유도도 인간보다 훨씬 크다. 그런데 정말 공포영화가 아닌가?”라는 반응을 보였다. 영상 시작 부분에서 아틀라스는 바닥에 등을 대고 가만히 누워 있는 모습입니다. 다음은 입이 떡 벌어지는 내용이다

MLP를 대체하는 KAN은 오픈소스 프로젝트를 통해 컨볼루션으로 확장되었습니다.

Jun 01, 2024 pm 10:03 PM

MLP를 대체하는 KAN은 오픈소스 프로젝트를 통해 컨볼루션으로 확장되었습니다.

Jun 01, 2024 pm 10:03 PM

이달 초 MIT와 기타 기관의 연구자들은 MLP에 대한 매우 유망한 대안인 KAN을 제안했습니다. KAN은 정확성과 해석성 측면에서 MLP보다 뛰어납니다. 그리고 매우 적은 수의 매개변수로 더 많은 수의 매개변수를 사용하여 실행되는 MLP보다 성능이 뛰어날 수 있습니다. 예를 들어 저자는 KAN을 사용하여 더 작은 네트워크와 더 높은 수준의 자동화로 DeepMind의 결과를 재현했다고 밝혔습니다. 구체적으로 DeepMind의 MLP에는 약 300,000개의 매개변수가 있는 반면 KAN에는 약 200개의 매개변수만 있습니다. KAN은 MLP와 같이 강력한 수학적 기반을 가지고 있으며, KAN은 Kolmogorov-Arnold 표현 정리를 기반으로 합니다. 아래 그림과 같이 KAN은

Google은 열광하고 있습니다. JAX 성능이 Pytorch와 TensorFlow를 능가합니다! GPU 추론 훈련을 위한 가장 빠른 선택이 될 수 있습니다.

Apr 01, 2024 pm 07:46 PM

Google은 열광하고 있습니다. JAX 성능이 Pytorch와 TensorFlow를 능가합니다! GPU 추론 훈련을 위한 가장 빠른 선택이 될 수 있습니다.

Apr 01, 2024 pm 07:46 PM

Google이 추진하는 JAX의 성능은 최근 벤치마크 테스트에서 Pytorch와 TensorFlow를 능가하여 7개 지표에서 1위를 차지했습니다. 그리고 JAX 성능이 가장 좋은 TPU에서는 테스트가 이루어지지 않았습니다. 개발자들 사이에서는 여전히 Tensorflow보다 Pytorch가 더 인기가 있습니다. 그러나 앞으로는 더 큰 모델이 JAX 플랫폼을 기반으로 훈련되고 실행될 것입니다. 모델 최근 Keras 팀은 기본 PyTorch 구현을 사용하여 세 가지 백엔드(TensorFlow, JAX, PyTorch)와 TensorFlow를 사용하는 Keras2를 벤치마킹했습니다. 첫째, 그들은 주류 세트를 선택합니다.

FisheyeDetNet: 어안 카메라를 기반으로 한 최초의 표적 탐지 알고리즘

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 어안 카메라를 기반으로 한 최초의 표적 탐지 알고리즘

Apr 26, 2024 am 11:37 AM

표적 탐지는 자율주행 시스템에서 상대적으로 성숙한 문제이며, 그 중 보행자 탐지는 가장 먼저 배포되는 알고리즘 중 하나입니다. 대부분의 논문에서 매우 포괄적인 연구가 수행되었습니다. 그러나 서라운드 뷰를 위한 어안 카메라를 사용한 거리 인식은 상대적으로 덜 연구되었습니다. 큰 방사형 왜곡으로 인해 표준 경계 상자 표현은 어안 카메라에서 구현하기 어렵습니다. 위의 설명을 완화하기 위해 확장된 경계 상자, 타원 및 일반 다각형 디자인을 극/각 표현으로 탐색하고 인스턴스 분할 mIOU 메트릭을 정의하여 이러한 표현을 분석합니다. 제안된 다각형 형태의 모델 fisheyeDetNet은 다른 모델보다 성능이 뛰어나며 동시에 자율 주행을 위한 Valeo fisheye 카메라 데이터 세트에서 49.5% mAP를 달성합니다.

공장에서 일하는 테슬라 로봇, 머스크 : 올해 손의 자유도가 22도에 달할 것!

May 06, 2024 pm 04:13 PM

공장에서 일하는 테슬라 로봇, 머스크 : 올해 손의 자유도가 22도에 달할 것!

May 06, 2024 pm 04:13 PM

테슬라의 로봇 옵티머스(Optimus)의 최신 영상이 공개됐는데, 이미 공장에서 작동이 가능한 상태다. 정상 속도에서는 배터리(테슬라의 4680 배터리)를 다음과 같이 분류합니다. 공식은 또한 20배 속도로 보이는 모습을 공개했습니다. 작은 "워크스테이션"에서 따고 따고 따고 : 이번에 출시됩니다. 영상에는 옵티머스가 공장에서 이 작업을 전 과정에 걸쳐 사람의 개입 없이 완전히 자율적으로 완료하는 모습이 담겨 있습니다. 그리고 Optimus의 관점에서 보면 자동 오류 수정에 중점을 두고 구부러진 배터리를 집어 넣을 수도 있습니다. NVIDIA 과학자 Jim Fan은 Optimus의 손에 대해 높은 평가를 했습니다. Optimus의 손은 세계의 다섯 손가락 로봇 중 하나입니다. 가장 능숙합니다. 손은 촉각적일 뿐만 아니라