대형 모델은 공식과 참고자료를 포함하여 자체적으로 논문을 '작성'할 수 있습니다. 이제 평가판이 온라인에 제공됩니다.

최근에는 다양한 주제 분야의 연구가 발전하면서 과학 문헌과 데이터가 폭발적으로 증가하여 학계 연구자들이 많은 양의 정보에서 유용한 통찰력을 발견하는 것이 점점 더 어려워지고 있습니다. 일반적으로 사람들은 과학적 지식을 얻기 위해 검색엔진을 사용하지만, 검색엔진은 과학지식을 자율적으로 정리할 수 없습니다.

이제 Meta AI 연구팀이 과학적 지식을 저장, 결합, 추론할 수 있는 새로운 대규모 언어 모델인 Galactica를 제안했습니다.

- 논문 주소: https://galactica.org/static/paper.pdf

- 시험판 주소: https://galactica.org/

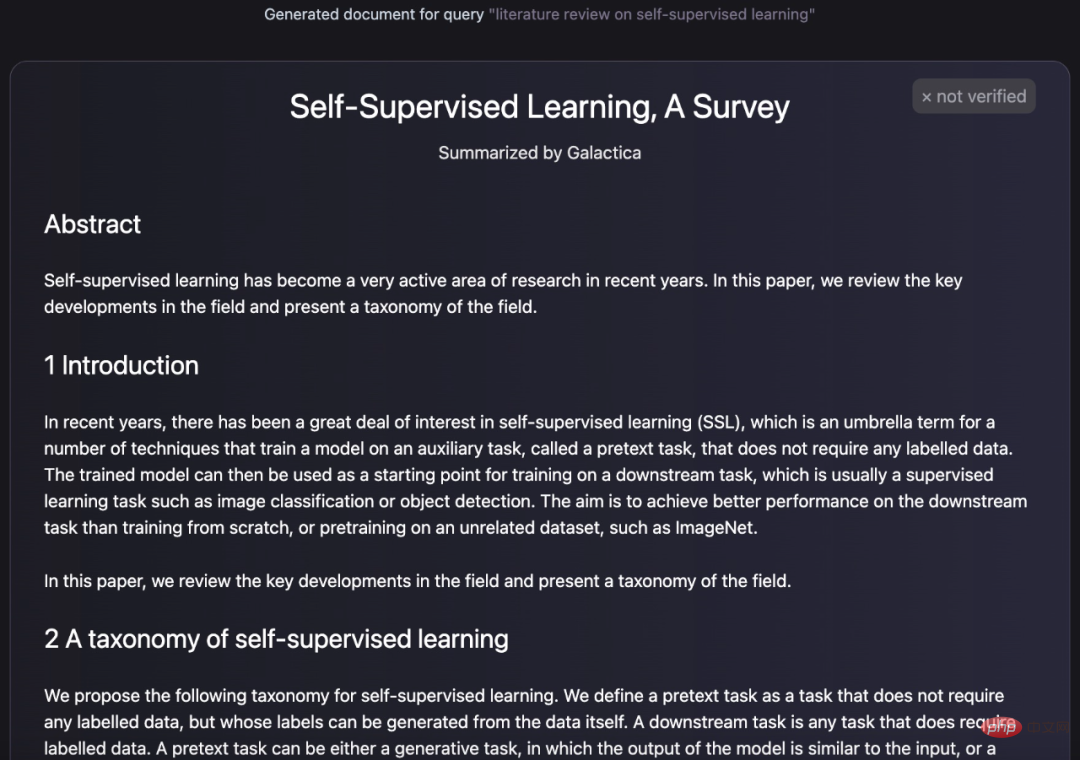

Galaxica 모델 얼마나 강력한가요? 자체적으로 리뷰 논문을 요약하고 요약할 수 있습니다.

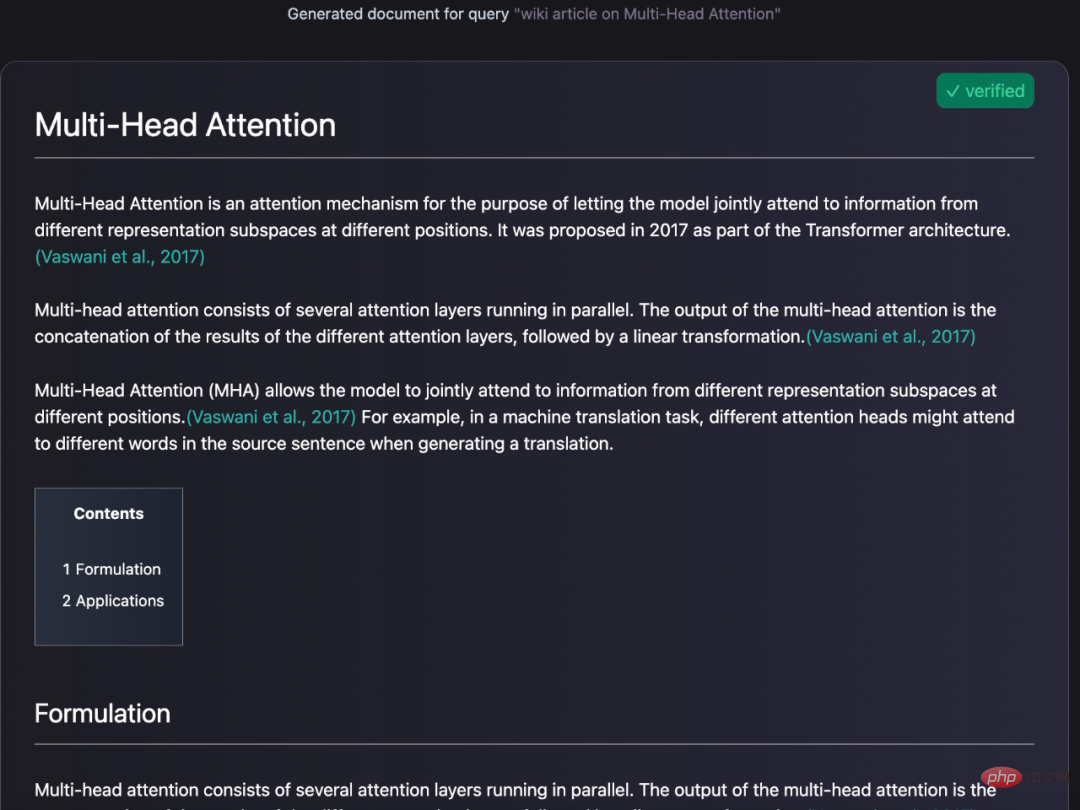

또한 항목에 대한 백과사전 쿼리를 생성할 수도 있습니다.

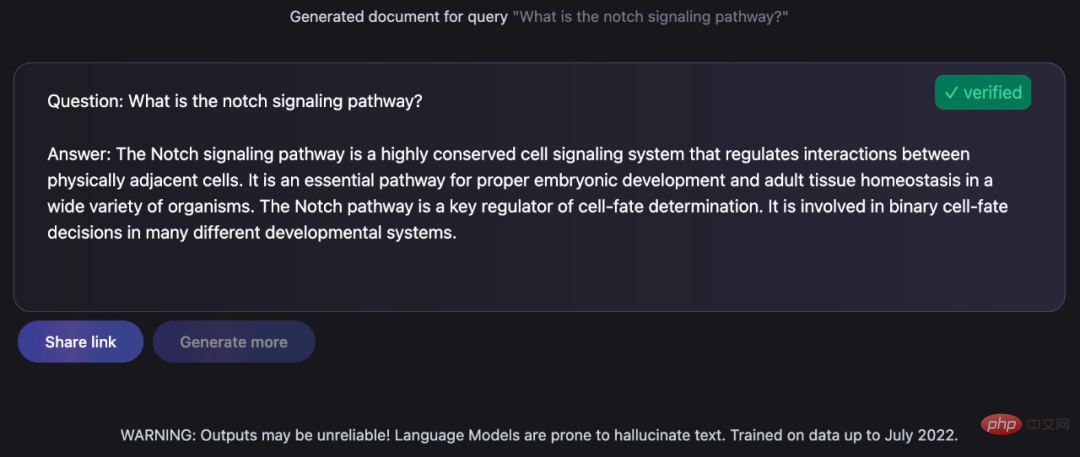

제기된 질문에 대한 지식이 풍부한 답변 제공:

이 작업은 인류학자에게는 여전히 어려운 일이지만 Galactica는 이 작업을 잘 완료했습니다. Turing Award 수상자 Yann LeCun도 자신의 칭찬을 트윗했습니다.

Galactica 모델의 구체적인 세부 사항을 살펴보겠습니다.

모델 개요

Galactica 모델은 4,800만 개 이상의 논문, 교과서 및 유인물, 수백만 개의 화합물 및 단백질 지식, 과학 자료를 포함하여 논문, 참고 자료, 지식 기반 및 기타 다양한 소스로 구성된 대규모 과학 자료에서 훈련되었습니다. 웹사이트, 백과사전 등 선별되지 않은 웹 크롤러 기반 텍스트에 의존하는 기존 언어 모델과 달리 Galactica 교육에 사용되는 코퍼스는 고품질이며 고도로 선별되어 있습니다. 이 연구는 과적합 없이 여러 시대에 대해 모델을 훈련했으며, 여기서 반복 토큰을 사용하여 업스트림 및 다운스트림 작업의 성능이 향상되었습니다.

Galactica는 다양한 과학 작업에서 기존 모델보다 성능이 뛰어납니다. LaTeX 방정식과 같은 기술 지식 탐색 작업에서 Galactica와 GPT-3의 성능은 68.2% VS 49.0%입니다. Galactica는 또한 추론 능력이 뛰어나 수학적 MMLU 벤치마크에서 Chinchilla를 크게 능가합니다.

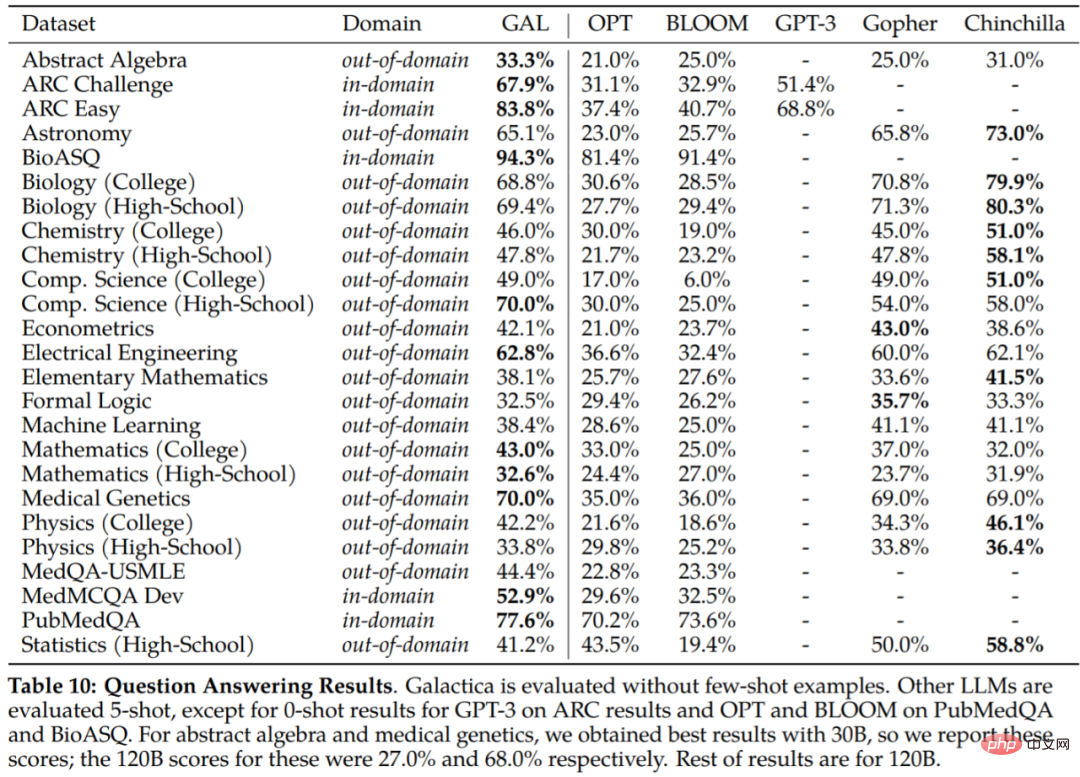

Galactica는 공통 코퍼스에 대한 교육을 받지 않았음에도 불구하고 BIG 벤치에서 BLOOM 및 OPT-175B보다 성능이 뛰어납니다. 또한 PubMedQA 및 MedMCQA 개발과 같은 다운스트림 작업에서 77.6%와 52.9%의 새로운 최고 성능을 달성했습니다.

간단히 말하면, 연구는 내부 작동을 모방하기 위해 특별한 토큰에 단계별 추론을 캡슐화합니다. 이를 통해 연구원들은 아래 Galactica의 시험 인터페이스에 표시된 것처럼 자연어를 사용하여 모델과 상호 작용할 수 있습니다.

Galactica는 텍스트 생성 외에도 화학 공식 및 단백질 서열과 관련된 다중 모드 작업도 수행할 수 있다는 점을 언급할 가치가 있습니다. 이는 약물 발견 분야에 기여할 것입니다.

구현 세부 정보

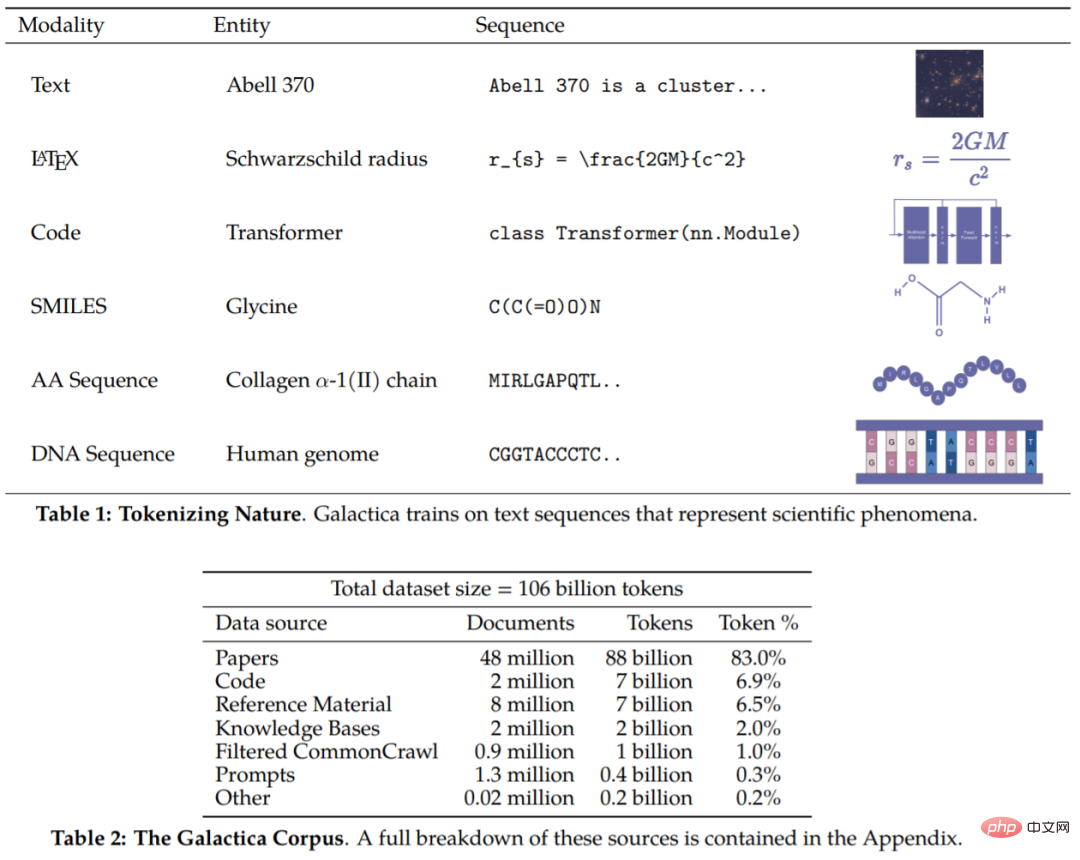

이 기사의 자료에는 논문, 참고 자료, 백과사전 및 기타 과학 자료에서 가져온 1,060억 개의 토큰이 포함되어 있습니다. 본 연구에는 자연어 자원(논문, 참고서)과 자연의 서열(단백질 서열, 화학적 형태)이 모두 포함되어 있다고 할 수 있습니다. 코퍼스의 세부 사항은 표 1과 2에 나와 있습니다.

이제 말뭉치가 생겼으니 다음 단계는 데이터를 조작하는 방법입니다. 일반적으로 토큰화의 설계는 매우 중요합니다. 예를 들어, 단백질 서열이 아미노산 잔기 측면에서 작성된 경우 문자 기반 토큰화가 적합합니다. 토큰화를 달성하기 위해 본 연구에서는 다양한 방식으로 특화된 토큰화를 수행했습니다. 구체적인 표현에는 다음이 포함되지만 이에 국한되지는 않습니다.

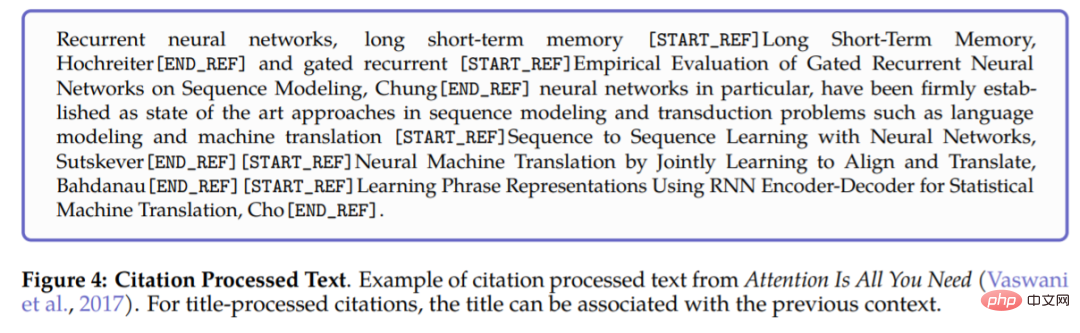

- 참조: 특수 참조 토큰 [START_REF] 및 [END_REF]를 사용하여 참조를 래핑합니다.

- 단계별 추론: 작업 메모리 토큰을 사용하여 캡슐화합니다. 단계별 추론 및 시뮬레이션 내부 작업 메모리 컨텍스트

- 숫자: 숫자를 별도의 토큰으로 나눕니다. 예를 들어 737612.62 → 7,3,7,6,1,2,.,6,2;

- SMILES 수식: 시퀀스를 [START_SMILES] 및 [END_SMILES]로 래핑하고 문자 기반 토큰화를 적용합니다. 마찬가지로 이 연구에서는 [START_I_SMILES] 및 [END_I_SMILES]를 사용하여 이성체 SMILES를 나타냅니다. 예: C(C(=O)O)N→C, (,C,(,=,O,),O,),N

- DNA 시퀀스: 각 뉴클레오티드에 문자 기반 토큰화 적용 염기는 토큰으로 간주되며 시작 토큰은 [START_DNA] 및 [END_DNA]입니다. 예를 들어 CGGTACCCTC→C, G, G, T, A, C, C, C, T, C입니다.

아래 그림 4는 논문에 대한 참조 처리의 예를 보여줍니다. 참조를 처리할 때 전역 식별자와 특수 토큰 [START_REF] 및 [END_REF]를 사용하여 참조 위치를 나타냅니다.

데이터 세트가 처리된 후 다음 단계는 이를 구현하는 방법입니다. Galactica는 Transformer 아키텍처를 기반으로 다음과 같이 수정했습니다.

- GeLU 활성화: 다양한 크기의 모델에 GeLU 활성화를 사용합니다.

- 컨텍스트 창: 다양한 크기의 모델에는 2048 길이의 컨텍스트 창을 사용합니다.

- 편향 없음: PaLM을 따르며 밀도가 높은 커널 또는 레이어 사양에 편향이 사용되지 않습니다.

- 위치 임베딩 학습: 모델에 대한 위치 임베딩 학습

- 용어집: BPE를 사용하여 용어집 작성 50,000개의 토큰이 포함되어 있습니다.

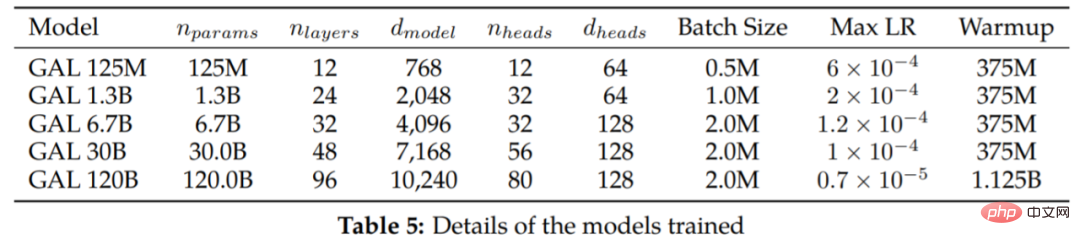

표 5에는 다양한 크기와 훈련 하이퍼파라미터의 모델이 나열되어 있습니다.

실험

중복 토큰은 무해한 것으로 간주됩니다.

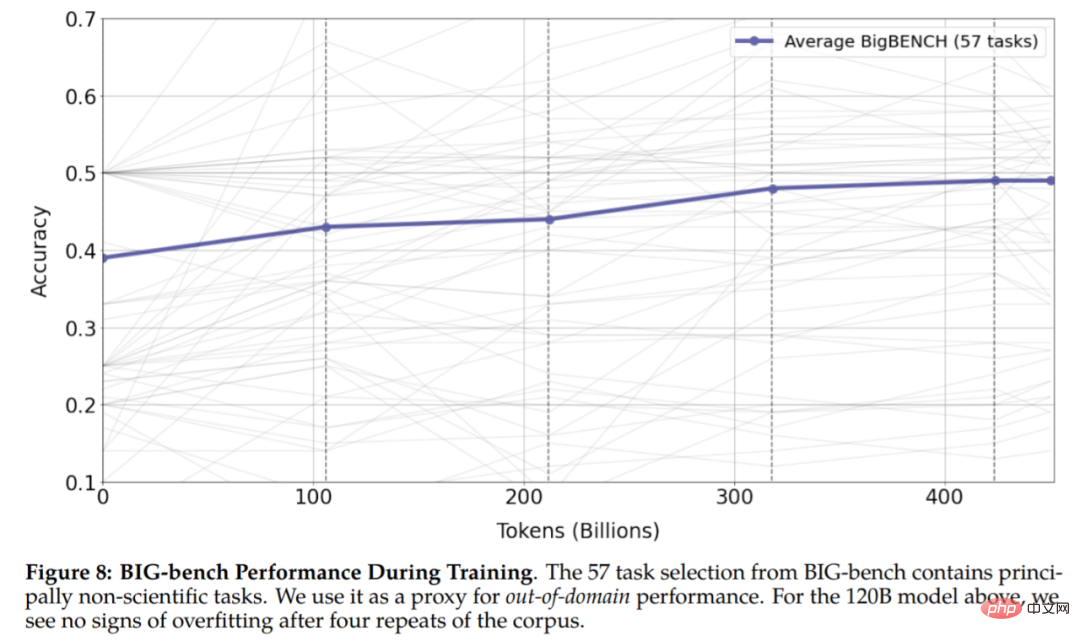

그림 6에서 볼 수 있듯이 4번의 훈련 이후 검증 손실은 계속해서 감소합니다. 120B 매개변수를 가진 모델은 다섯 번째 에포크가 시작될 때만 과적합되기 시작합니다. 기존 연구에 따르면 중복 토큰이 성능에 해로울 수 있다는 사실이 밝혀졌기 때문에 이는 예상치 못한 일입니다. 또한 연구에서는 30B 및 120B 모델이 검증 손실이 정체(또는 증가)된 후 감소하는 획기적인 이중 감소 효과를 나타냄을 발견했습니다. 이 효과는 각 시대마다 더욱 강해지며, 특히 훈련이 끝난 120B 모델의 경우 더욱 두드러집니다.

그림 8 결과는 실험에서 과적합의 징후가 없음을 보여 주며, 이는 반복된 토큰이 다운스트림 및 업스트림 작업의 성능을 향상시킬 수 있음을 보여줍니다. heculse 기타 결과 ing 타이핑 공식은 너무 느립니다. 이제 프롬프트로 라텍스를 생성 할 수 있습니다. 화학 반응, Galactica 생성물의 경우 모델은 반응물만을 기준으로 추론할 수 있으며 결과는 다음과 같습니다.

일부 다른 결과는 표 7에 보고됩니다.

갤럭티카의 추론 능력. 본 연구는 MMLU 수학 벤치마크에서 먼저 평가되었으며 평가 결과는 표 8에 보고되어 있습니다. Galactica는 더 큰 기본 모델에 비해 강력한 성능을 발휘하며 토큰을 사용하면 더 작은 30B Galactica 모델에서도 Chinchilla의 성능이 향상되는 것으로 보입니다.

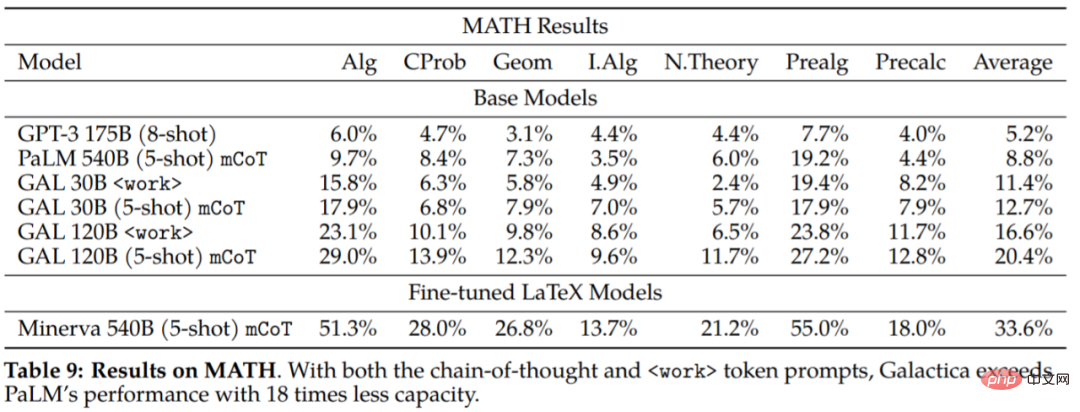

이 연구에서는 Galactica의 추론 기능을 더 자세히 탐색하기 위해 MATH 데이터 세트도 평가했습니다.

실험 결과에서 결론을 내릴 수 있습니다. Galactica는 사고 연결 및 유도 측면에서 기본 PaLM보다 훨씬 뛰어납니다. 모델. 이는 Galactica가 수학적 작업을 처리하는 데 더 나은 선택임을 시사합니다. 다운스트림 작업에 대한

평가 결과는 표 10에 나와 있습니다. Galactica는 다른 언어 모델보다 성능이 훨씬 뛰어나며 대부분의 작업에서 더 큰 모델보다 성능이 뛰어납니다(Gopher 280B). 성능 차이는 Chinchilla의 차이보다 크며, 특히 고등학교 과목과 덜 수학적, 기억 집약적인 작업 등 하위 작업에서 더 강한 것으로 보입니다. 대조적으로 Galactica는 수학과 대학원 수준의 작업에서 더 나은 성과를 거두는 경향이 있습니다.

이 연구는 또한 입력 맥락에 따라 인용을 예측하는 Chinchilla의 능력을 평가했습니다. 이는 Chinchilla의 과학 문헌 정리 능력에 대한 중요한 테스트입니다. 결과는 다음과 같습니다.

더 많은 실험적인 내용은 원문을 참고해주세요.

위 내용은 대형 모델은 공식과 참고자료를 포함하여 자체적으로 논문을 '작성'할 수 있습니다. 이제 평가판이 온라인에 제공됩니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7552

7552

15

15

1382

1382

52

52

83

83

11

11

59

59

19

19

22

22

95

95

Centos Shutdown 명령 줄

Apr 14, 2025 pm 09:12 PM

Centos Shutdown 명령 줄

Apr 14, 2025 pm 09:12 PM

CentOS 종료 명령은 종료이며 구문은 종료 [옵션] 시간 [정보]입니다. 옵션은 다음과 같습니다. -H 시스템 중지 즉시 옵션; -P 종료 후 전원을 끕니다. -R 다시 시작; -대기 시간. 시간은 즉시 (현재), 분 (분) 또는 특정 시간 (HH : MM)으로 지정할 수 있습니다. 추가 정보는 시스템 메시지에 표시 될 수 있습니다.

Centos에서 Gitlab의 백업 방법은 무엇입니까?

Apr 14, 2025 pm 05:33 PM

Centos에서 Gitlab의 백업 방법은 무엇입니까?

Apr 14, 2025 pm 05:33 PM

CentOS 시스템 하에서 Gitlab의 백업 및 복구 정책 데이터 보안 및 복구 가능성을 보장하기 위해 CentOS의 Gitlab은 다양한 백업 방법을 제공합니다. 이 기사는 완전한 GITLAB 백업 및 복구 전략을 설정하는 데 도움이되는 몇 가지 일반적인 백업 방법, 구성 매개 변수 및 복구 프로세스를 자세히 소개합니다. 1. 수동 백업 gitlab-rakegitlab : 백업 : 명령을 작성하여 수동 백업을 실행하십시오. 이 명령은 gitlab 저장소, 데이터베이스, 사용자, 사용자 그룹, 키 및 권한과 같은 주요 정보를 백업합니다. 기본 백업 파일은/var/opt/gitlab/backups 디렉토리에 저장됩니다. /etc /gitlab을 수정할 수 있습니다

Centos HDFS 구성을 확인하는 방법

Apr 14, 2025 pm 07:21 PM

Centos HDFS 구성을 확인하는 방법

Apr 14, 2025 pm 07:21 PM

CentOS 시스템에서 HDFS 구성 확인에 대한 완전한 안내서이 기사에서는 CentOS 시스템에서 HDF의 구성 및 실행 상태를 효과적으로 확인하는 방법을 안내합니다. 다음 단계는 HDF의 설정 및 작동을 완전히 이해하는 데 도움이됩니다. Hadoop 환경 변수 확인 : 먼저 Hadoop 환경 변수가 올바르게 설정되어 있는지 확인하십시오. 터미널에서 다음 명령을 실행하여 Hadoop이 올바르게 설치되고 구성되었는지 확인하십시오. Hadoopversion Check HDFS 구성 파일 : HDFS의 Core 구성 파일은/etc/hadoop/conf/directory에 있으며 Core-Site.xml 및 HDFS-Site.xml이 중요합니다. 사용

Centos에서 Zookeeper의 성능을 조정하는 방법은 무엇입니까?

Apr 14, 2025 pm 03:18 PM

Centos에서 Zookeeper의 성능을 조정하는 방법은 무엇입니까?

Apr 14, 2025 pm 03:18 PM

CentOS에 대한 Zookeeper Performance Tuning은 하드웨어 구성, 운영 체제 최적화, 구성 매개 변수 조정, 모니터링 및 유지 관리 등 여러 측면에서 시작할 수 있습니다. 특정 튜닝 방법은 다음과 같습니다. SSD는 하드웨어 구성에 권장됩니다. Zookeeper의 데이터는 디스크에 작성되므로 SSD를 사용하여 I/O 성능을 향상시키는 것이 좋습니다. 충분한 메모리 : 자주 디스크 읽기 및 쓰기를 피하기 위해 충분한 메모리 리소스를 동물원에 충분한 메모리 자원을 할당하십시오. 멀티 코어 CPU : 멀티 코어 CPU를 사용하여 Zookeeper가이를 병렬로 처리 할 수 있도록하십시오.

Centos에서 Pytorch 모델을 훈련시키는 방법

Apr 14, 2025 pm 03:03 PM

Centos에서 Pytorch 모델을 훈련시키는 방법

Apr 14, 2025 pm 03:03 PM

CentOS 시스템에서 Pytorch 모델을 효율적으로 교육하려면 단계가 필요 하며이 기사는 자세한 가이드를 제공합니다. 1. 환경 준비 : 파이썬 및 종속성 설치 : CentOS 시스템은 일반적으로 파이썬을 사전 설치하지만 버전은 더 오래 될 수 있습니다. YUM 또는 DNF를 사용하여 Python 3 및 Upgrade Pip : Sudoyumupdatepython3 (또는 SudodnfupdatePython3), PIP3INSTALL-UPGRADEPIP를 설치하는 것이 좋습니다. CUDA 및 CUDNN (GPU 가속도) : NVIDIAGPU를 사용하는 경우 Cudatool을 설치해야합니다.

Centos에서 Pytorch에 대한 GPU 지원은 어떻습니까?

Apr 14, 2025 pm 06:48 PM

Centos에서 Pytorch에 대한 GPU 지원은 어떻습니까?

Apr 14, 2025 pm 06:48 PM

CentOS 시스템에서 Pytorch GPU 가속도를 활성화하려면 Cuda, Cudnn 및 GPU 버전의 Pytorch를 설치해야합니다. 다음 단계는 프로세스를 안내합니다. CUDA 및 CUDNN 설치 CUDA 버전 호환성 결정 : NVIDIA-SMI 명령을 사용하여 NVIDIA 그래픽 카드에서 지원하는 CUDA 버전을보십시오. 예를 들어, MX450 그래픽 카드는 CUDA11.1 이상을 지원할 수 있습니다. Cudatoolkit 다운로드 및 설치 : NVIDIACUDATOOLKIT의 공식 웹 사이트를 방문하여 그래픽 카드에서 지원하는 가장 높은 CUDA 버전에 따라 해당 버전을 다운로드하여 설치하십시오. CUDNN 라이브러리 설치 :

Docker 원리에 대한 자세한 설명

Apr 14, 2025 pm 11:57 PM

Docker 원리에 대한 자세한 설명

Apr 14, 2025 pm 11:57 PM

Docker는 Linux 커널 기능을 사용하여 효율적이고 고립 된 응용 프로그램 실행 환경을 제공합니다. 작동 원리는 다음과 같습니다. 1. 거울은 읽기 전용 템플릿으로 사용되며, 여기에는 응용 프로그램을 실행하는 데 필요한 모든 것을 포함합니다. 2. Union 파일 시스템 (Unionfs)은 여러 파일 시스템을 스택하고 차이점 만 저장하고 공간을 절약하고 속도를 높입니다. 3. 데몬은 거울과 컨테이너를 관리하고 클라이언트는 상호 작용을 위해 사용합니다. 4. 네임 스페이스 및 CGroup은 컨테이너 격리 및 자원 제한을 구현합니다. 5. 다중 네트워크 모드는 컨테이너 상호 연결을 지원합니다. 이러한 핵심 개념을 이해 함으로써만 Docker를 더 잘 활용할 수 있습니다.

Centos에서 Pytorch 버전을 선택하는 방법

Apr 14, 2025 pm 02:51 PM

Centos에서 Pytorch 버전을 선택하는 방법

Apr 14, 2025 pm 02:51 PM

Centos에서 Pytorch 버전을 선택할 때 다음과 같은 주요 요소를 고려해야합니다. 1. Cuda 버전 호환성 GPU 지원 : NVIDIA GPU가 있고 GPU 가속도를 사용하려면 해당 CUDA 버전을 지원하는 Pytorch를 선택해야합니다. NVIDIA-SMI 명령을 실행하여 지원되는 CUDA 버전을 볼 수 있습니다. CPU 버전 : GPU가 없거나 GPU를 사용하지 않으려면 Pytorch의 CPU 버전을 선택할 수 있습니다. 2. 파이썬 버전 Pytorch