설명 가능한 인공 지능 시스템(XAI) 구축을 위한 6가지 권장 Python 프레임워크

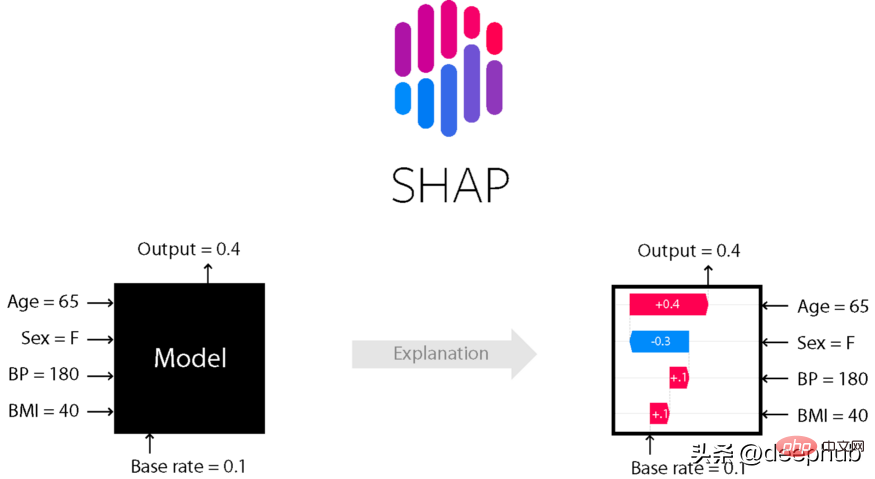

AI는 블랙박스와 같아서 스스로 결정을 내릴 수 있지만 사람들은 그 이유를 모릅니다. AI 모델을 구축하고 데이터를 입력한 뒤 결과를 출력하는데, 한 가지 문제는 AI가 왜 그런 결론에 도달했는지 설명할 수 없다는 점이다. 맥락이나 설명 없이 출력되는 결과를 단순히 받아들이는 것이 아니라, AI가 어떤 결론에 도달하는지 그 이유를 이해할 필요가 있습니다.

통역성은 사람들의 이해를 돕기 위해 설계되었습니다.

- 어떻게 학습했나요?

- 무엇을 배웠나요?

- 특정 입력에 대해 결정을 내린 이유는 무엇인가요?

- 결정이 신뢰할 수 있나요? 이번 글에서는 해석성을 위한 6가지 Python 프레임워크를 소개하겠습니다.

pip 또는 conda를 사용하여 shap 라이브러리를 설치하세요.

# install with pippip install shap# install with condaconda install -c conda-forge shap

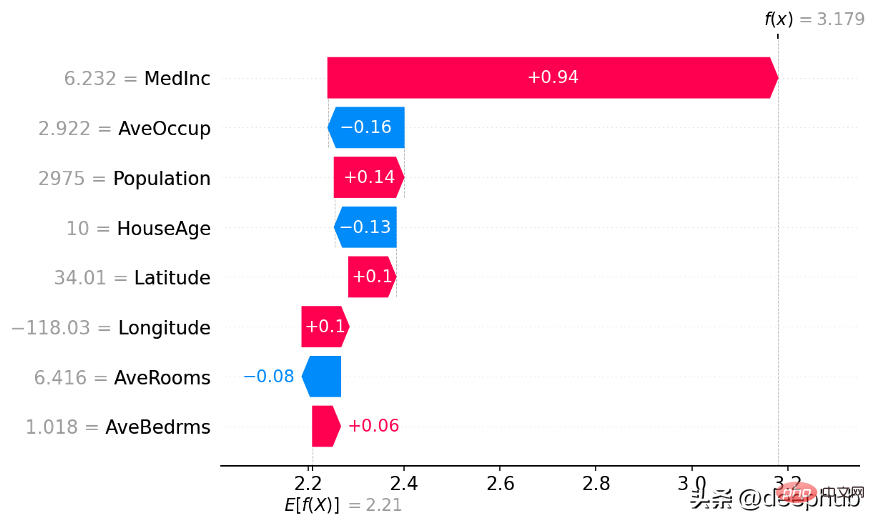

Shap 라이브러리를 사용하여 폭포형 차트 작성

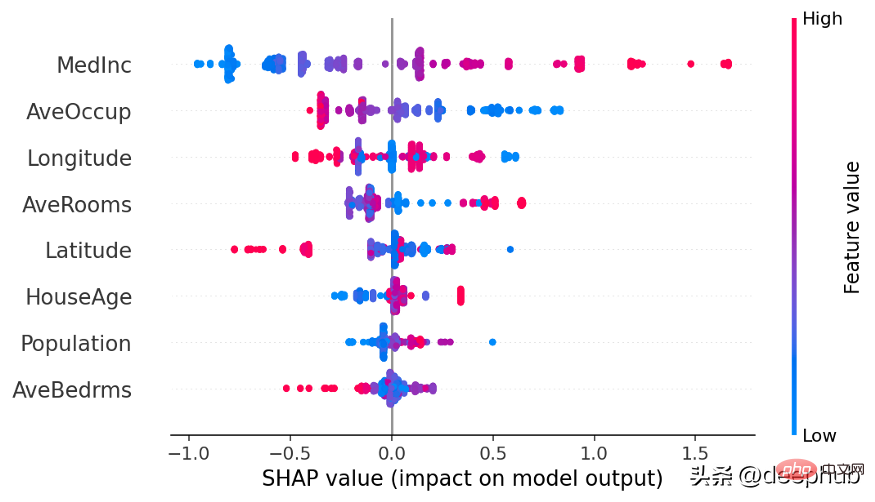

Shap 라이브러리를 사용하여 Beeswarm 차트 작성

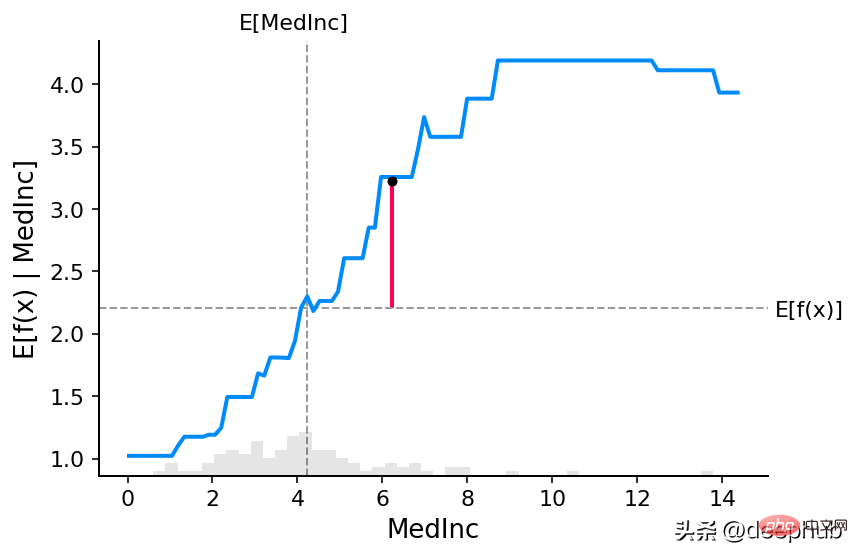

Shap 라이브러리를 사용하여 부분 종속성 그래프 작성

pip 설치 사용

pip install lime

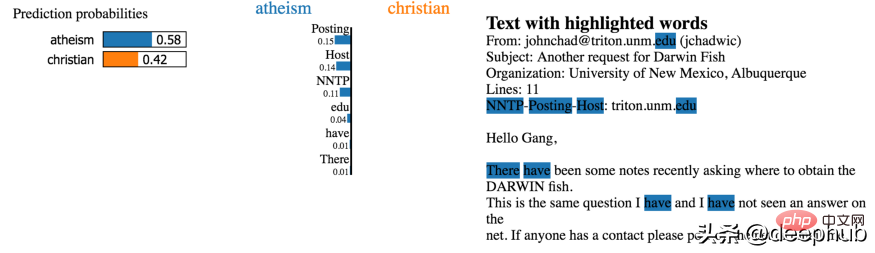

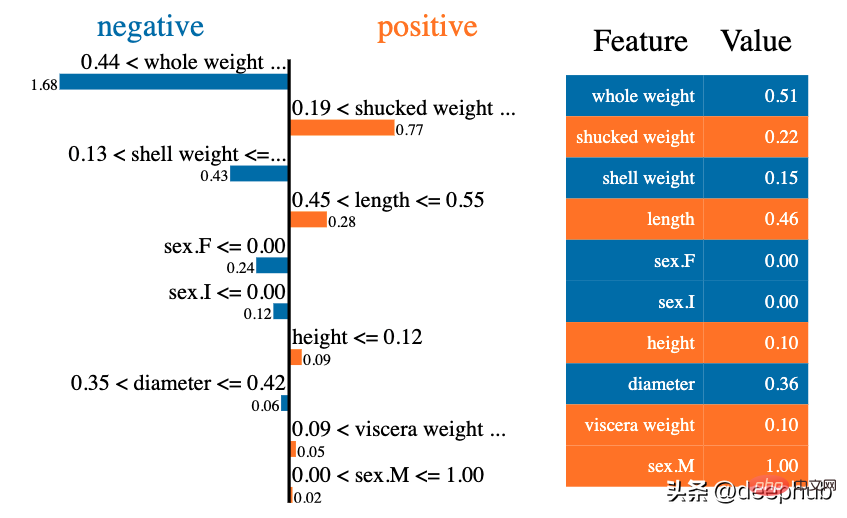

LIME 기반 부분 설명 그래프

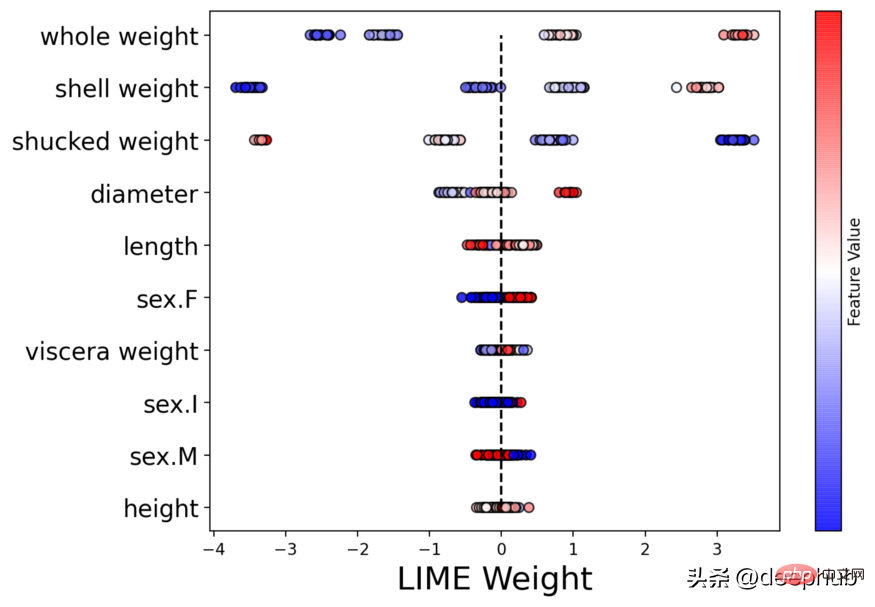

LIME 기반 Beeswarm 그래프

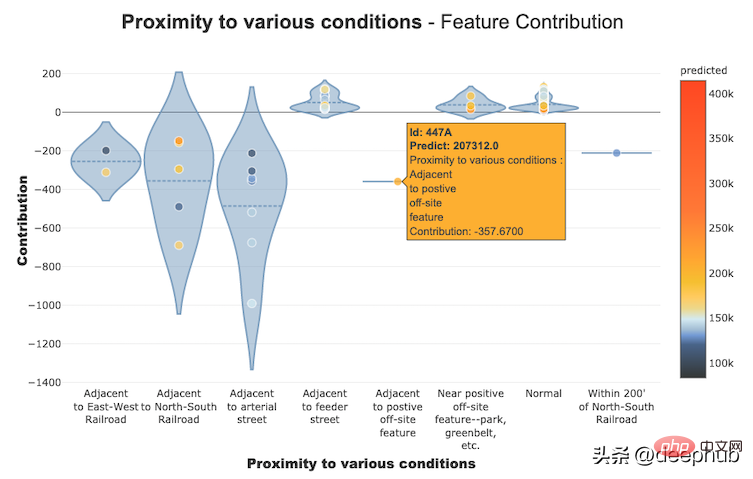

Shapash를 사용하여 기능 기여 그래프 구축

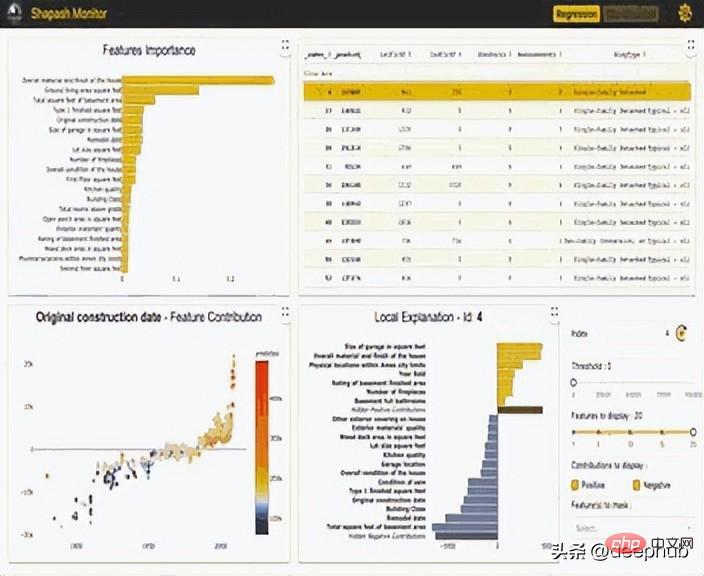

Shapash 라이브러리를 사용하여 생성된 대화형 대시보드

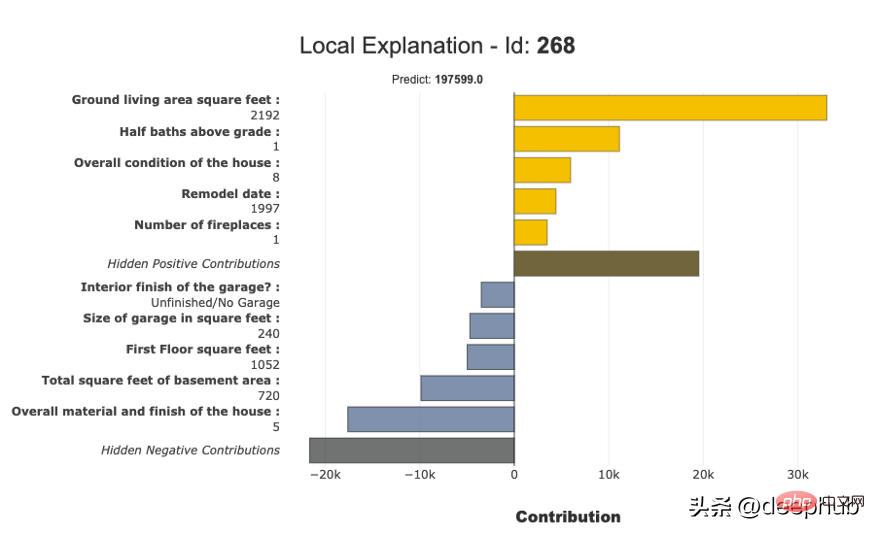

Shapash를 사용하여 구축된 부분 설명 그래프

InterpretML은 두 가지 유형의 해석 가능성을 보여줍니다. 유리박스 모델 – 해석 가능성을 위해 설계된 기계 학습 모델(예: 선형 모델, 규칙 목록, 일반화된 추가 모델) 및 블랙 박스 해석 기술 – 해석 가능성 기존 시스템(예: 부분 종속성, LIME). 내장된 확장 가능한 시각화 플랫폼을 통해 통합 API를 사용하고 여러 방법을 캡슐화하는 이 패키지를 통해 연구자는 해석 가능성 알고리즘을 쉽게 비교할 수 있습니다. InterpretML에는 많은 블랙박스 모델만큼 정확할 수 있는 강력하고 해석 가능한 유리박스 모델인 Boosting Machine 설명의 첫 번째 구현도 포함되어 있습니다.

InterpretML을 사용하여 구축된 로컬 설명 대화형 플롯

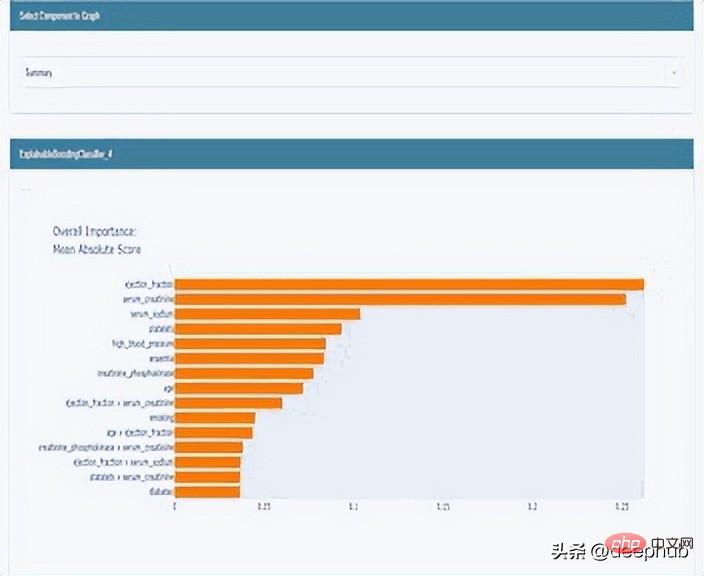

InterpretML을 사용하여 구축된 전역 설명 플롯

ELI5

ELI5는 기계 학습 분류자를 디버깅하고 예측을 해석하는 데 도움이 되는 Python 라이브러리입니다. 현재 지원되는 기계 학습 프레임워크는 다음과 같습니다.

- scikit-learn

- 전 세계적으로 작동합니다.

- 모델의 개별 예측을 검사하고 모델이 어떤 결정을 내리는지 설명합니다.

- ELI5 라이브러리를 사용하여 전역 가중치 생성

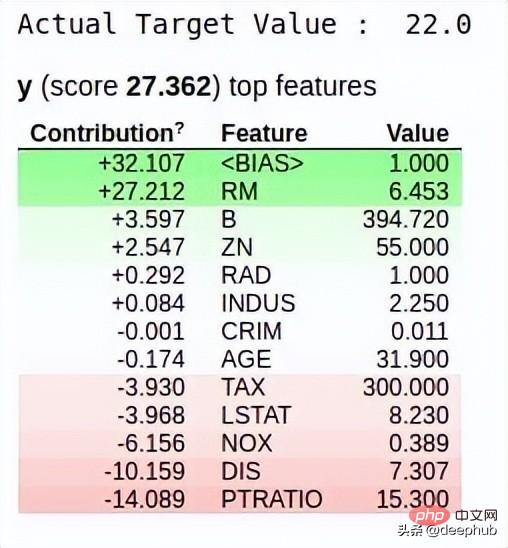

ELI5 라이브러리를 사용하여 로컬 가중치 생성

위 내용은 설명 가능한 인공 지능 시스템(XAI) 구축을 위한 6가지 권장 Python 프레임워크의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7517

7517

15

15

1378

1378

52

52

79

79

11

11

53

53

19

19

21

21

66

66

Python vs. C : 응용 및 사용 사례가 비교되었습니다

Apr 12, 2025 am 12:01 AM

Python vs. C : 응용 및 사용 사례가 비교되었습니다

Apr 12, 2025 am 12:01 AM

Python은 데이터 과학, 웹 개발 및 자동화 작업에 적합한 반면 C는 시스템 프로그래밍, 게임 개발 및 임베디드 시스템에 적합합니다. Python은 단순성과 강력한 생태계로 유명하며 C는 고성능 및 기본 제어 기능으로 유명합니다.

웹 사이트 성과를 향상시키기 위해 Debian Apache Logs를 사용하는 방법

Apr 12, 2025 pm 11:36 PM

웹 사이트 성과를 향상시키기 위해 Debian Apache Logs를 사용하는 방법

Apr 12, 2025 pm 11:36 PM

이 기사는 데비안 시스템에서 Apache Logs를 분석하여 웹 사이트 성능을 향상시키는 방법을 설명합니다. 1. 로그 분석 기본 사항 Apache Log는 IP 주소, 타임 스탬프, 요청 URL, HTTP 메소드 및 응답 코드를 포함한 모든 HTTP 요청의 자세한 정보를 기록합니다. 데비안 시스템 에서이 로그는 일반적으로 /var/log/apache2/access.log 및 /var/log/apache2/error.log 디렉토리에 있습니다. 로그 구조를 이해하는 것은 효과적인 분석의 첫 번째 단계입니다. 2. 로그 분석 도구 다양한 도구를 사용하여 Apache 로그를 분석 할 수 있습니다.

파이썬 : 게임, Guis 등

Apr 13, 2025 am 12:14 AM

파이썬 : 게임, Guis 등

Apr 13, 2025 am 12:14 AM

Python은 게임 및 GUI 개발에서 탁월합니다. 1) 게임 개발은 Pygame을 사용하여 드로잉, 오디오 및 기타 기능을 제공하며 2D 게임을 만드는 데 적합합니다. 2) GUI 개발은 Tkinter 또는 PYQT를 선택할 수 있습니다. Tkinter는 간단하고 사용하기 쉽고 PYQT는 풍부한 기능을 가지고 있으며 전문 개발에 적합합니다.

Laravel (PHP) vs. Python : 개발 환경 및 생태계

Apr 12, 2025 am 12:10 AM

Laravel (PHP) vs. Python : 개발 환경 및 생태계

Apr 12, 2025 am 12:10 AM

개발 환경과 생태계에서 Laravel과 Python의 비교는 다음과 같습니다. 1. Laravel의 개발 환경은 간단하며 PHP와 작곡가 만 필요합니다. Laravelforge와 같은 풍부한 확장 패키지를 제공하지만 확장 패키지 유지 보수는시기 적절하지 않을 수 있습니다. 2. 파이썬의 개발 환경도 간단하며 파이썬과 PIP 만 필요합니다. 생태계는 거대하고 여러 분야를 다루지 만 버전 및 종속성 관리는 복잡 할 수 있습니다.

PHP 및 Python : 두 가지 인기있는 프로그래밍 언어를 비교합니다

Apr 14, 2025 am 12:13 AM

PHP 및 Python : 두 가지 인기있는 프로그래밍 언어를 비교합니다

Apr 14, 2025 am 12:13 AM

PHP와 Python은 각각 고유 한 장점이 있으며 프로젝트 요구 사항에 따라 선택합니다. 1.PHP는 웹 개발, 특히 웹 사이트의 빠른 개발 및 유지 보수에 적합합니다. 2. Python은 간결한 구문을 가진 데이터 과학, 기계 학습 및 인공 지능에 적합하며 초보자에게 적합합니다.

DDOS 공격 탐지에서 데비안 스나이퍼의 역할

Apr 12, 2025 pm 10:42 PM

DDOS 공격 탐지에서 데비안 스나이퍼의 역할

Apr 12, 2025 pm 10:42 PM

이 기사에서는 DDOS 공격 탐지 방법에 대해 설명합니다. "Debiansniffer"의 직접적인 적용 사례는 발견되지 않았지만 DDOS 공격 탐지에 다음과 같은 방법을 사용할 수 있습니다. 효과적인 DDOS 공격 탐지 기술 : 트래픽 분석을 기반으로 한 탐지 : 갑작스런 트래픽 성장, 특정 포트에서의 연결 감지 등의 비정상적인 네트워크 트래픽 패턴을 모니터링하여 DDOS 공격을 식별합니다. 예를 들어, Pyshark 및 Colorama 라이브러리와 결합 된 Python 스크립트는 실시간으로 네트워크 트래픽을 모니터링하고 경고를 발행 할 수 있습니다. 통계 분석에 기반한 탐지 : 데이터와 같은 네트워크 트래픽의 통계적 특성을 분석하여

NGINX SSL 인증서 업데이트 Debian Tutorial

Apr 13, 2025 am 07:21 AM

NGINX SSL 인증서 업데이트 Debian Tutorial

Apr 13, 2025 am 07:21 AM

이 기사에서는 Debian 시스템에서 NginxSSL 인증서를 업데이트하는 방법에 대해 안내합니다. 1 단계 : CertBot을 먼저 설치하십시오. 시스템에 CERTBOT 및 PYTHON3-CERTBOT-NGINX 패키지가 설치되어 있는지 확인하십시오. 설치되지 않은 경우 다음 명령을 실행하십시오. sudoapt-getupdatesudoapt-getinstallcertbotpython3-certbot-nginx 2 단계 : 인증서 획득 및 구성 rectbot 명령을 사용하여 nginx를 획득하고 nginx를 구성하십시오.

Debian Readdir가 다른 도구와 통합하는 방법

Apr 13, 2025 am 09:42 AM

Debian Readdir가 다른 도구와 통합하는 방법

Apr 13, 2025 am 09:42 AM

데비안 시스템의 readdir 함수는 디렉토리 컨텐츠를 읽는 데 사용되는 시스템 호출이며 종종 C 프로그래밍에 사용됩니다. 이 기사에서는 ReadDir를 다른 도구와 통합하여 기능을 향상시키는 방법을 설명합니다. 방법 1 : C 언어 프로그램을 파이프 라인과 결합하고 먼저 C 프로그램을 작성하여 readDir 함수를 호출하고 결과를 출력하십시오.#포함#포함#포함#포함#includinTmain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {