연구에 따르면 유사성 기반 가중치 인터리브 학습은 딥 러닝의 '기억상실' 문제를 효과적으로 처리할 수 있습니다.

인간과 달리 인공 신경망은 새로운 것을 학습할 때 이전에 학습한 정보를 빨리 잊어버리고 오래된 정보와 새로운 정보를 인터리브하여 재교육해야 합니다. 그러나 모든 오래된 정보를 인터리브하는 것은 시간이 많이 걸리고 필요하지 않을 수도 있습니다. 새로운 정보와 실질적으로 유사한 오래된 정보만을 인터리브하는 것으로 충분할 수 있습니다.

최근 PNAS(Proceedings of the National Academy of Sciences)에서는 왕립대학 펠로인 Bruce McNaughton 팀이 발표한 "Learning in deep Neural Networks and Brains with 유사성 가중치 인터리브 학습"이라는 논문을 발표했습니다. 캐나다학회(Society of Canada)이자 유명한 신경과학자. 그들의 연구에서는 오래된 정보와 새로운 정보의 유사성 가중치 인터리빙 훈련을 수행함으로써 딥 네트워크가 망각율을 줄일 뿐만 아니라 훨씬 적은 양의 데이터를 사용하여 새로운 것을 빠르게 학습할 수 있다는 것을 발견했습니다.

저자들은 또한 최근 활성화된 뉴런과 신경역학적 끌개 역학의 진행 중인 흥분성 궤적을 추적함으로써 뇌에서 유사성 가중 인터리빙이 달성될 수 있다는 가설을 세웠습니다. 이러한 발견은 신경과학과 기계 학습의 발전으로 이어질 수 있습니다.

연구 배경

뇌가 평생 동안 학습하는 방식을 이해하는 것은 장기적인 과제로 남아 있습니다.

인공 신경망(ANN)에서는 새로운 정보를 너무 빨리 통합하면 이전에 획득한 지식이 갑자기 손실되는 치명적인 간섭이 발생할 수 있습니다. 보완 학습 시스템 이론(CLST)은 새로운 기억이 기존 지식과 결합되어 신피질에 점진적으로 통합될 수 있다고 제안합니다.

CLST는 뇌가 새로운 기억을 빠르게 획득하는 해마(HC)와 새로운 데이터를 맥락 없는 구조화된 지식으로 점진적으로 통합하는 신피질(NC)과 같은 보완적인 학습 시스템에 의존한다고 말합니다. 수면 및 조용히 깨어 있는 휴식과 같은 "오프라인 기간" 동안 HC는 NC의 최근 경험 재생을 트리거하는 반면 NC는 기존 범주의 표현을 자발적으로 검색하고 인터리브합니다. 인터리브 재생을 사용하면 경사 하강 방식으로 NC 시냅스 가중치를 점진적으로 조정할 수 있어 새로운 메모리를 우아하게 통합하고 치명적인 간섭을 극복하는 상황에 독립적인 범주 표현을 만들 수 있습니다. 많은 연구에서 신경망의 평생 학습을 달성하기 위해 인터리브 재생을 성공적으로 사용했습니다.

그러나 CLST를 실제로 적용할 때 해결해야 할 중요한 문제가 두 가지 있습니다. 첫째, 뇌가 모든 오래된 데이터에 접근할 수 없을 때 어떻게 정보의 포괄적인 인터리빙이 발생할 수 있습니까? 가능한 해결책 중 하나는 이전에 학습된 예제에 명시적으로 접근하지 않고도 무작위 입력을 통해 내부 표현의 생성 재생을 유도할 수 있는 "의사 리허설"입니다. 어트랙터와 같은 역학은 뇌가 "의사 리허설"을 완료하도록 허용할 수 있지만 "의사 리허설"의 내용은 아직 명확하지 않습니다. 따라서 두 번째 질문은 각각의 새로운 학습 활동 후에 뇌가 이전에 학습한 모든 정보를 엮을 수 있는 충분한 시간을 갖는지 여부입니다.

SWIL(유사성 가중치 인터리브 학습) 알고리즘은 두 번째 문제에 대한 솔루션으로 간주되며, 새로운 정보와 상당한 표현적 유사성을 지닌 오래된 정보를 인터리빙하는 것만으로도 충분할 수 있음을 시사합니다. 경험적 행동 연구에 따르면 일관성이 높은 새로운 정보는 간섭이 거의 없이 NC 구조 지식에 신속하게 통합될 수 있습니다. 이는 새로운 정보가 통합되는 속도가 이전 지식과의 일관성에 달려 있음을 시사합니다. 이러한 행동 결과에 영감을 받아 이전에 얻은 범주 간의 치명적인 간섭 분포를 재검토함으로써 McClelland et al.은 SWIL이 두 개의 상위어 범주(예: "과일"은 "사과" 및 "바나나")가 있는 컨텍스트에서 사용될 수 있음을 입증했습니다. ""), 각 시대는 새로운 정보를 학습하는 데 2.5배 미만의 데이터 양을 사용하여 모든 데이터에 대해 네트워크를 훈련시키는 것과 동일한 성능을 달성합니다. 그러나 연구원들은 더 복잡한 데이터 세트를 사용할 때 유사한 효과를 발견하지 못하여 알고리즘의 확장성에 대한 우려를 불러일으켰습니다.

실험에 따르면 심층 비선형 인공 신경망은 새로운 정보와 많은 표현적 유사성을 공유하는 오래된 정보의 하위 집합만 인터리브하여 새로운 정보를 학습할 수 있습니다. SWIL 알고리즘을 사용함으로써 ANN은 각 에포크마다 제시되는 아주 적은 양의 오래된 정보를 사용하면서 비슷한 수준의 정확성과 최소한의 간섭으로 새로운 정보를 빠르게 학습할 수 있어 높은 데이터 활용도와 빠른 학습을 의미합니다.

동시에 SWIL은 시퀀스 학습 프레임워크에도 적용될 수 있습니다. 또한, 새로운 카테고리를 학습하면 데이터 활용도가 크게 향상될 수 있습니다. 오래된 정보가 이전에 학습된 범주와 유사성이 거의 없다면 제시되는 오래된 정보의 양은 훨씬 적어질 것이며 이는 인간 학습의 실제 사례일 가능성이 높습니다.

마지막으로 저자는 새로운 정보의 중첩에 비례하는 흥분성 편향을 통해 SWIL이 뇌에서 구현되는 방식에 대한 이론적 모델을 제안합니다.

이미지 분류 데이터 세트에 적용된 DNN 역학 모델

McClelland 등의 실험에 따르면 하나의 숨겨진 레이어가 있는 심층 선형 네트워크에서 SWIL은 완전 인터리브 학습(완전 인터리브 학습)과 유사한 새로운 범주를 학습할 수 있습니다. (FIL)은 이전 카테고리 전체를 새 카테고리와 인터리브하지만 데이터를 40% 적게 사용합니다.

그러나 네트워크는 상위명 범주가 2개뿐인 매우 간단한 데이터세트로 훈련되었으므로 알고리즘의 확장성에 대한 의문이 제기됩니다.

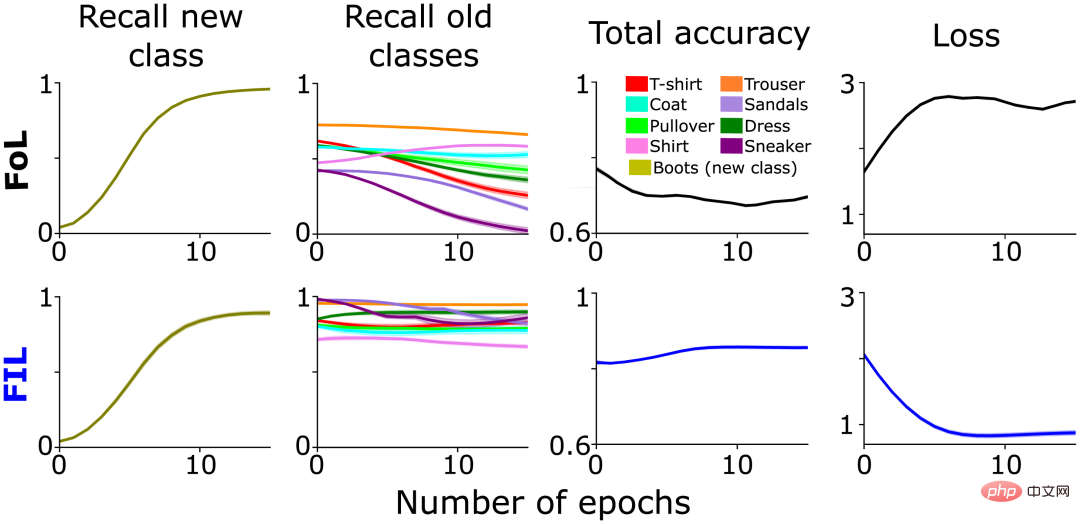

먼저 Fashion-MNIST와 같은 더 복잡한 데이터세트에 대해 하나의 숨겨진 레이어가 있는 심층 선형 신경망에서 다양한 카테고리의 학습이 어떻게 발전하는지 살펴보세요. "부츠" 및 "가방" 카테고리를 제거한 후 모델은 나머지 8개 카테고리에서 87%의 테스트 정확도를 달성했습니다. 그런 다음 저자 팀은 두 가지 다른 조건에서 (새로운) "부팅" 클래스를 학습하기 위해 모델을 재교육했으며 각각 10번 반복했습니다.

- 완전 인터리브 학습(FIL), 즉 모든 카테고리(새 카테고리 + 이전에 학습된 카테고리)가 동일한 확률로 제시됩니다. 두 경우 모두, 에포크당 총 180개의 이미지가 표시되며, 각 에포크마다 동일한 이미지가 표시됩니다.

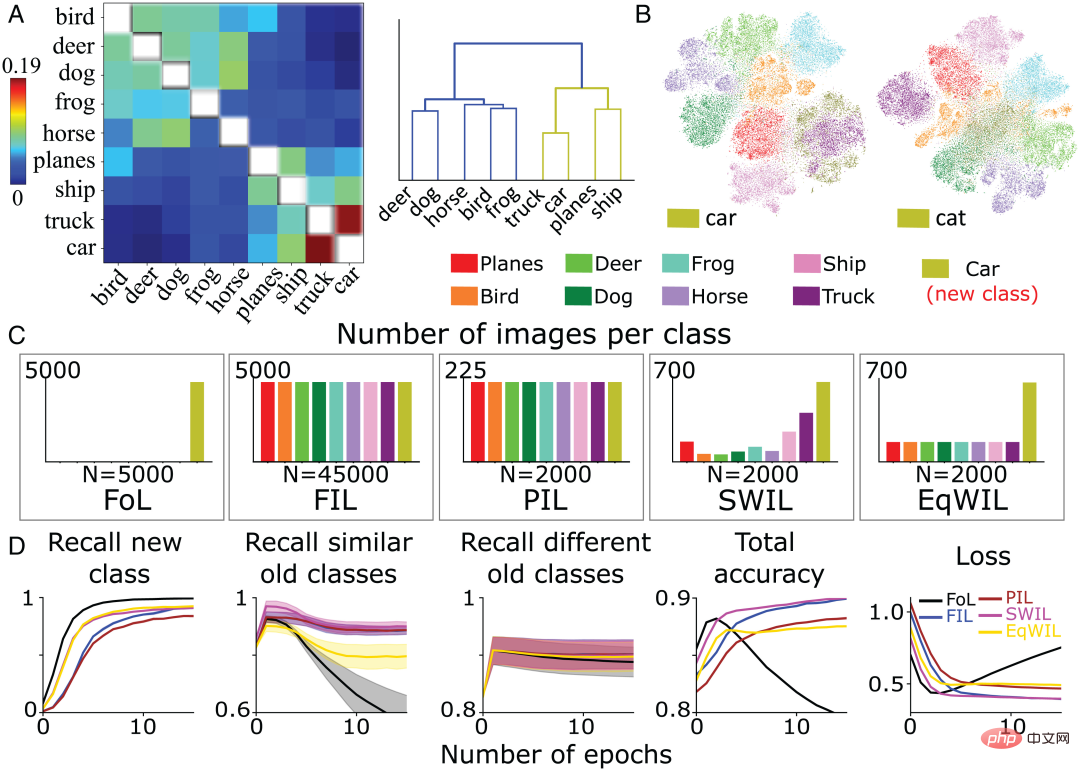

그림 1:

그림 1:

다른 카테고리 간의 유사성 계산

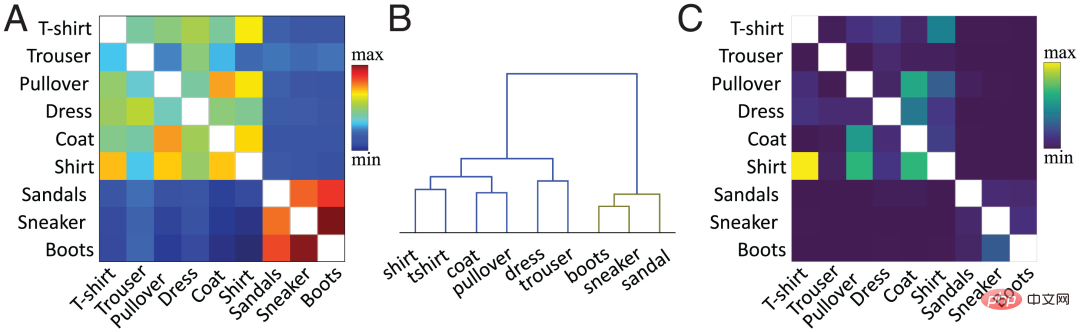

FoL이 새로운 카테고리를 학습하면 유사한 이전 카테고리에 대한 분류 성능이 크게 떨어집니다. 다중 카테고리 속성 유사성과 학습 사이의 관계는 이전에 탐색되었으며 심층 선형 네트워크가 알려진 일관된 속성을 빠르게 획득할 수 있다는 것이 나타났습니다. 대조적으로, 기존 범주 계층 구조에 일관되지 않은 속성의 새로운 분기를 추가하려면 느리고 점진적이며 시차를 둔 학습이 필요합니다. 현재 작업에서 저자 팀은 제안된 방법을 사용하여 기능 수준에서 유사성을 계산합니다. 간단히 말하면, 대상 히든 레이어(보통 두 번째 레이어)에 있는 기존 클래스와 새 클래스의 클래스별 평균 활성화 벡터 간의 코사인 유사성이 계산됩니다. 그림 2A는 Fashion MNIST 데이터세트를 기반으로 새로운 "부팅" 카테고리와 이전 카테고리에 대해 사전 훈련된 네트워크의 두 번째 레이어 활성화 함수를 기반으로 저자 팀이 계산한 유사성 매트릭스를 보여줍니다. 범주 간의 유사성은 사물에 대한 우리의 시각적 인식과 일치합니다. 예를 들어, 계층적 클러스터링 다이어그램(그림 2B)에서 "boot" 클래스와 "sneaker" 및 "sandal" 클래스 간의 관계뿐만 아니라 "shirt"("shirt") 및 "sandal" 클래스 간의 관계도 관찰할 수 있습니다. '티셔츠'('셔츠')는 카테고리 간 유사성이 높습니다. 유사성 행렬(그림 2A)은 혼동 행렬(그림 2C)과 정확히 일치합니다. 유사도가 높을수록 이미지를 혼동하기 쉽습니다. 예를 들어 '셔츠' 카테고리의 이미지는 '티셔츠', '점퍼', '재킷' 카테고리의 이미지와 쉽게 혼동됩니다. 측정은 신경망의 학습 역학을 예측합니다. 이전 섹션의 FoL 결과 그래프(그림 1)에서는 이전 카테고리의 재현율 곡선에 유사한 클래스 유사성 곡선이 있습니다. 다른 이전 카테고리("바지" 등)와 비교하여 FoL은 새로운 "부츠" 카테고리를 학습할 때 유사한 이전 카테고리("운동화" 및 "샌들")를 빠르게 잊어버립니다. 그림 2:

그림 2:

심층 선형 신경망을 사용하면 새로운 것을 빠르고 효율적으로 학습할 수 있습니다. 다음으로 새로운 분류 학습 역학을 연구하기 위해 처음 두 조건을 기반으로 3개의 새로운 조건이 추가되었으며 각 조건은 10번 반복되었습니다.

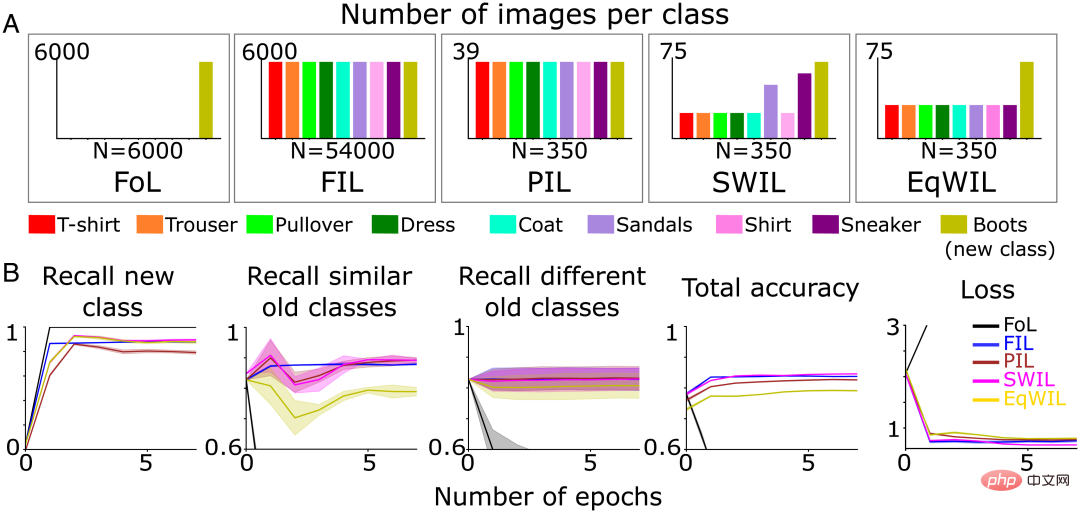

- FoL(총 n=6000 이미지/에포크);

- FIL(총 n=54000 이미지/에포크, 6000 이미지/클래스)

- 부분 인터리브 학습(PIL)은 이미지의 작은 A 하위 집합을 사용합니다(총 n= 350개의 이미지/에포크, 약 39개의 이미지/클래스), 각 카테고리(새 카테고리 + 기존 카테고리)의 이미지는 동일한 확률로 표시됩니다.

- SWIL, 각 에포크는 동일한 총 이미지 수를 사용하고 PIL을 재교육하지만 기존에 가중치를 둡니다. (새로운) "부팅" 카테고리와의 유사성을 기반으로 한 카테고리 이미지

- EqWIL(Equally Weighted Interleaved Learning)은 SWIL과 동일한 번호를 사용합니다. "부팅" 클래스 이미지는 재교육되지만 기존 클래스 이미지에 대해 동일한 가중치를 갖습니다( 그림 3A).

작성팀은 위에서 언급한 것과 동일한 테스트 데이터 세트를 사용했습니다(총 n=9000개 이미지). 각 조건에서 신경망의 성능이 점근선에 도달하면 훈련이 중지됩니다. Epoch당 더 적은 훈련 데이터가 사용되지만 새로운 "부팅" 클래스를 예측하는 정확도는 점근선에 도달하는 데 더 오랜 시간이 걸리며 PIL은 FIL에 비해 재현율이 낮습니다(H=7.27, P

SWIL의 경우 유사성 계산을 사용하여 인터리브할 기존 이전 카테고리 이미지의 비율을 결정합니다. 이를 기반으로 저자 팀은 각 이전 카테고리에서 가중치가 적용된 확률로 입력 이미지를 무작위로 그립니다. 다른 카테고리에 비해 '운동화'와 '샌들' 카테고리는 가장 유사하므로 인터리브되는 비율이 더 높습니다(그림 3A).

덴드로그램(그림 2B)에 따르면 저자 팀은 "sneaker"와 "sandal" 클래스를 유사한 이전 클래스로 참조하고 나머지는 다른 이전 클래스로 참조합니다. 새로운 클래스 재현율(그림 3B의 열 1 및 표 1의 "새 클래스" 열), PIL의 전체 정밀도 및 손실(H=5.44, P0.05)은 FIL과 비슷합니다. EqWIL(H=10.99, P

작성팀은 SWIL과 FIL을 비교하기 위해 다음 두 가지 방법을 사용합니다.

- FIL과 SWIL에 저장된 이미지 수의 비율인 메모리 비율은 저장된 데이터 양의 감소를 나타냅니다. FIL과 SWIL의 비율인 가속 비율 SWIL에 제시된 총 콘텐츠 수의 비율로 새 카테고리 회상에 대한 포화 정확도를 달성하여 새 카테고리를 학습하는 데 필요한 시간이 단축됨을 나타냅니다.

그림 3 (A) 저자 팀은 성능이 정체될 때까지 5가지 학습 조건에서 새로운 "부팅" 클래스(올리브 그린)를 학습하기 위해 신경망을 사전 훈련했습니다. 1) FoL(총계) n= 6000개 이미지/에포크), 2) FIL(총 n=54000개 이미지/에포크), 3) PIL(총 n=350개 이미지/에포크), 4) SWIL(총 n=350개 이미지/에포크) 및 5) EqWIL (총 n=350개 이미지/에포크). (B) FoL(검은색), FIL(파란색), PIL(갈색), SWIL(마젠타) 및 EqWIL(금색)은 새로운 범주, 유사한 이전 범주(“운동화” 및 “샌들”) 및 다른 이전 범주를 예측합니다. 비율, 모든 범주를 예측하는 총 정확도, 테스트 데이터 세트의 교차 엔트로피 손실(가로축은 에포크 수)입니다.

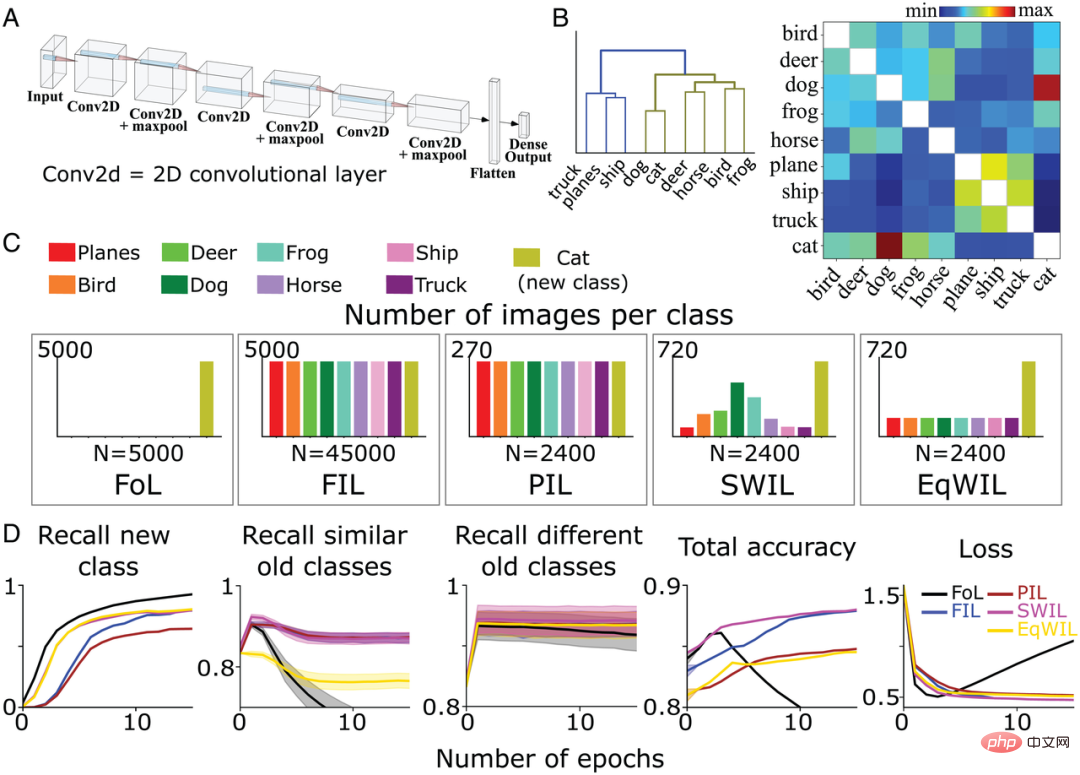

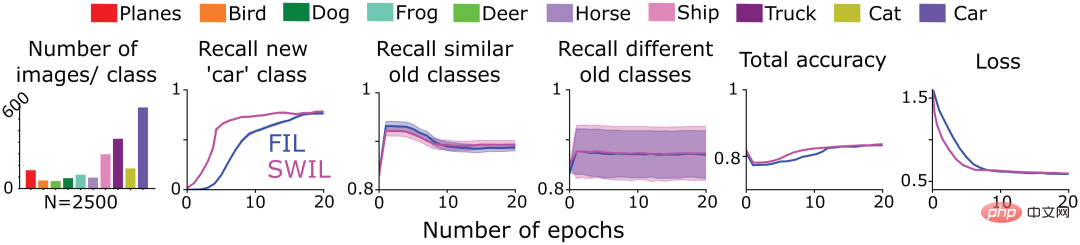

SWIL을 사용하여 CIFAR10 기반 CNN의 새로운 범주 학습 다음으로 SWIL이 더 복잡한 환경에서 작동할 수 있는지 테스트하기 위해 저자 팀은 완전히 연결된 출력 레이어가 있는 6레이어 비선형 CNN을 교육했습니다(그림 4A) CIFAR10 데이터 세트에서 나머지 8개 카테고리("고양이" 및 "자동차" 제외)의 이미지를 식별합니다. 또한 이전에 정의된 5가지 훈련 조건(FoL, FIL, PIL, SWIL 및 EqWIL)에서 "cat" 클래스를 학습하기 위해 모델을 재훈련했습니다. 그림 4C는 5가지 조건에서 각 범주의 이미지 분포를 보여줍니다. SWIL, PIL 및 EqWIL 조건의 경우 에포크당 총 이미지 수는 2400개였고, FIL 및 FoL의 경우 에포크당 총 이미지 수는 각각 45000개와 5000개였습니다. 저자 팀은 성능이 안정화될 때까지 각 상황에 대해 별도로 네트워크를 훈련했습니다. 그들은 이전에 볼 수 없었던 총 9000개의 이미지(클래스당 1000개 이미지, "자동차" 클래스 제외)에 대해 모델을 테스트했습니다. 그림 4B는 CIFAR10 데이터 세트를 기반으로 저자 팀이 계산한 유사성 매트릭스입니다. "고양이" 클래스는 "개" 클래스와 더 유사하지만 다른 동물 클래스는 동일한 분기에 속합니다(그림 4B 왼쪽).수형도(그림 4B)에 따르면 "트럭"("트럭"), "선박"("선박") 및 "비행기"("항공기") 범주는 "고양이"를 제외하고 서로 다른 이전 범주라고 합니다. " 카테고리 나머지 동물 카테고리를 유사한 이전 카테고리라고 합니다. FoL의 경우 모델은 새로운 "cat" 클래스를 학습하지만 이전 클래스는 잊어버립니다. Fashion-MNIST 데이터 세트의 결과와 유사하게 "dog" 클래스("cat" 클래스와 가장 유사함)와 "truck" 클래스("cat" 클래스와 가장 유사하지 않음) 모두에 간섭 기울기가 있습니다. ), 그중 "개" 클래스의 망각율이 가장 높고, "트럭" 카테고리의 망각율이 가장 낮습니다.

그림 4D에 표시된 것처럼 FIL 알고리즘은 새로운 "cat" 클래스를 학습할 때 치명적인 간섭을 극복합니다. PIL 알고리즘의 경우 모델은 새로운 "cat" 클래스를 학습하기 위해 각 epoch의 데이터 양의 18.75배를 사용하지만 "cat" 클래스의 재현율은 FIL보다 높습니다(H=5.72, P0.05). ; 표 2 및 그림 4D 참조). SWIL은 PIL보다 새로운 "cat" 클래스에 대한 재현율이 더 높습니다(H=7.89, P

FIL, PIL, SWIL 및 EqWIL은 다양한 이전 범주를 예측하는 데 유사한 성능을 나타냅니다(H=0.6, P>0.05). SWI는 PIL보다 더 나은 새로운 "cat" 클래스를 통합하고 EqWIL의 관측 간섭을 극복하는 데 도움이 됩니다. FIL과 비교하면 SWIL을 사용하여 새로운 범주를 학습하는 것이 더 빠르며 가속 비율 = 31.25x(45000×10/(2400×6))이고 더 적은 데이터를 사용합니다(메모리 비율 = 18.75x). 이러한 결과는 SWIL이 비선형 CNN과 보다 현실적인 데이터 세트에서도 새로운 범주를 효과적으로 학습할 수 있음을 보여줍니다.

그림 4: (A) 저자 팀은 완전히 연결된 출력 레이어가 있는 6레이어 비선형 CNN을 사용하여 CIFAR10 데이터세트의 8개 범주를 학습합니다. (B) 유사성 매트릭스(오른쪽)는 새로운 "cat" 클래스를 제시한 후 마지막 컨볼루셔널 레이어의 활성화 함수를 기반으로 저자 팀에 의해 계산됩니다. 유사성 매트릭스(왼쪽)에 계층적 클러스터링을 적용하면 덴드로그램에서 동물(올리브 녹색)과 차량(파란색)의 두 상위 범주 그룹이 표시됩니다. (C) 저자 팀은 성능이 안정화될 때까지 5가지 다른 조건에서 새로운 "고양이" 클래스(올리브 그린)를 학습하도록 CNN을 사전 훈련했습니다. 1) FoL(총 n=5000개 이미지/에포크) 2) FIL(총 n) =45000개 이미지/에포크), 3) PIL(총 n=2400개 이미지/에포크), 4) SWIL(총 n=2400개 이미지/에포크), 5) EqWIL(총 n=2400개 이미지/에포크) 각 조건은 10번 반복되었습니다. (D) FoL(검은색), FIL(파란색), PIL(갈색), SWIL(마젠타) 및 EqWIL(금색)은 새 클래스, 유사한 이전 클래스(CIFAR10 데이터세트의 다른 동물 클래스) 및 다른 이전 클래스("평면)를 예측합니다. ", "선박" 및 "트럭"), 모든 범주의 총 예측 정확도, 테스트 데이터 세트의 교차 엔트로피 손실(여기서 가로좌표는 시대 수)입니다.

새로운 콘텐츠와 기존 카테고리의 일관성이 학습 시간 및 필수 데이터에 미치는 영향

네트워크에 큰 변경을 가하지 않고도 이전에 학습한 카테고리에 새로운 콘텐츠를 추가할 수 있다면 두 사람은 다음과 같이 말합니다. 일관성을 유지하십시오. 이 프레임워크를 기반으로, 더 적은 수의 기존 범주(낮은 일관성)를 방해하는 새로운 범주를 학습하는 것보다 더 적은 수의 기존 범주(낮은 일관성)를 방해하는 새로운 범주를 학습하는 것이 네트워크에 더 쉽게 통합될 수 있습니다.

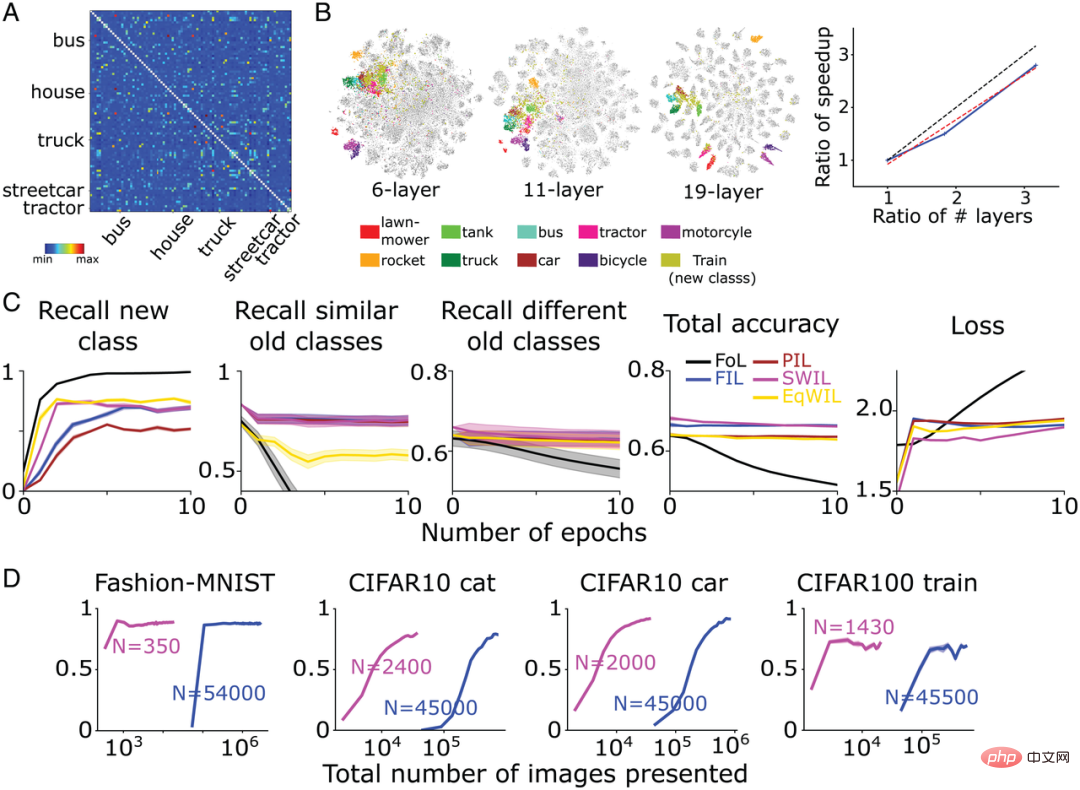

위 추론을 테스트하기 위해 저자 팀은 이전 섹션에서 사전 훈련된 CNN을 사용하여 이전에 설명한 5가지 학습 조건 모두에서 새로운 "자동차" 카테고리를 학습했습니다. 그림 5A는 "자동차" 카테고리의 유사성 매트릭스를 보여줍니다. 기존의 다른 카테고리와 비교할 때 "자동차"와 "트럭", "배"와 "비행기"는 동일한 레벨 노드 아래에 있어 더 유사함을 나타냅니다. 추가 확인을 위해 저자 팀은 유사성 계산에 사용되는 활성화 계층에 대해 t-SNE 차원 감소 시각화 분석을 수행했습니다(그림 5B). 연구에 따르면 "자동차" 클래스는 다른 차량 클래스("트럭", "배" 및 "비행기")와 상당히 겹치는 반면 "고양이" 클래스는 다른 동물 클래스("개", "개구리", "말"( "말"), "새"( "새") 및 "사슴"( "사슴"))이 겹칩니다.

저자 팀의 기대에 따라 FoL은 "자동차" 카테고리를 학습할 때 치명적인 간섭을 생성하며 유사한 이전 카테고리를 더 많이 간섭합니다. 이는 FIL을 사용하여 극복됩니다(그림 5D). PIL, SWIL 및 EqWIL의 경우 에포크당 총 n = 2000개의 이미지가 있습니다(그림 5C). SWIL 알고리즘을 사용하여 모델은 FIL과 유사한 정확도(H=0.79, P>0.05)로 새로운 "자동차" 범주를 학습할 수 있으며 기존 범주(유사한 범주와 다른 범주 포함)에 대한 간섭을 최소화할 수 있습니다. 그림 5D의 열 2에 표시된 대로 EqWIL을 사용하여 모델은 SWIL과 동일한 방식으로 새로운 "자동차" 클래스를 학습하지만 다른 유사한 범주(예: "트럭")와의 간섭 수준이 더 높습니다(H=53.81). , P

FIL과 비교하여 SWIL은 새로운 콘텐츠를 더 빠르게 학습할 수 있으며 가속 비율 = 48.75x(45000×12/(2000×6))이며 메모리 요구 사항이 감소하며 메모리 비율 = 22.5x입니다. "고양이"(48.75x 대 31.25x)에 비해 "자동차"는 더 적은 수의 클래스(예: "트럭", "배" 및 "비행기")를 인터리브하여 더 빠르게 학습할 수 있는 반면, "고양이"는 더 많은 카테고리(예: "개", "개구리", "말", "개구리" 및 "사슴"과 같이)이 겹칩니다. 이러한 시뮬레이션 실험은 새로운 범주의 교차 및 가속화된 학습에 필요한 이전 범주 데이터의 양이 사전 지식과 새로운 정보의 일관성에 따라 달라짐을 보여줍니다.

그림 5: (A) 저자 팀은 두 번째 레이어 활성화 함수를 기반으로 유사성 행렬(왼쪽)을 계산하고 새로운 "자동차" 카테고리를 제시한 후 유사성 행렬의 계층적 클러스터링을 수행했습니다. 최종 결과 사진(오른쪽). (B) 모델은 새로운 "자동차" 범주와 "고양이" 범주를 각각 학습합니다. 마지막 합성곱 계층이 활성화 함수를 통과한 후 저자 팀은 t-SNE 차원 감소 시각화 결과를 수행합니다. (C) 저자 팀은 성능이 안정화될 때까지 5가지 다른 조건에서 새로운 "자동차" 클래스(올리브 그린)를 학습하도록 CNN을 사전 훈련했습니다. 1) FoL(총 n=5000개 이미지/에포크) 2) FIL(총 n) =45000개 이미지/에포크), 3) PIL(총 n=2000개 이미지/에포크), 4) SWIL(총 n=2000개 이미지/에포크), 5) EqWIL(총 n=2000개 이미지/에포크) (D) FoL(검은색), FIL(파란색), PIL(갈색), SWIL(자홍색) 및 EqWIL(금색)은 새로운 범주, 유사한 이전 범주("비행기", "선박" 및 "트럭")를 예측하고 리콜 다양한 이전 범주(CIFAR10 데이터 세트의 다른 동물 범주)의 비율, 모든 범주의 전체 예측 정확도, 테스트 데이터 세트의 교차 엔트로피 손실(가로축은 시대 수)입니다. 각 그래프는 평균 10회 반복을 표시하며 음영 처리된 영역은 ±1 SEM입니다.

SWIL을 사용하여 시퀀스 학습

다음으로 저자 팀은 직렬화(시퀀스 학습 프레임워크) 형식으로 제시된 새로운 콘텐츠를 SWIL을 사용하여 학습할 수 있는지 테스트했습니다. 이를 위해 그들은 그림 4의 훈련된 CNN 모델을 채택하여 FIL 및 SWIL 조건 하에서 CIFAR10 데이터 세트의 "cat" 클래스(작업 1)를 학습하고 CIFAR10의 나머지 9개 범주에 대해서만 훈련한 다음 각 조건에 대해 훈련했습니다. 다음으로 모델을 훈련하여 새로운 "car" 클래스를 학습합니다(작업 2). 그림 6의 첫 번째 열은 SWIL 조건에서 "자동차" 카테고리를 학습할 때 다른 카테고리의 이미지 수 분포를 보여줍니다(총 n=2500 이미지/에포크). "cat" 클래스를 예측하면 새로운 "car" 클래스도 교차 학습됩니다. 모델 성능은 FIL 조건에서 가장 좋기 때문에 SWIL 결과는 FIL과만 비교되었습니다.

그림 6에서 볼 수 있듯이 SWIL의 신규 및 기존 카테고리 예측 능력은 FIL(H=14.3, P>0.05)과 동일합니다. 모델은 SWIL 알고리즘을 사용하여 45x(50000×20/(2500×8))의 가속 비율로 새로운 "자동차" 카테고리를 더 빠르게 학습하고 각 시대의 메모리 공간은 FIL보다 20배 적습니다. 모델이 "고양이" 및 "자동차" 범주를 학습할 때 SWIL 조건(메모리 비율과 속도 향상 비율은 각각 18.75x 및 20x)에서 에포크당 사용되는 이미지 수는 FIL에서 에포크당 사용되는 전체 데이터보다 적습니다. 조건 세트(각각 31.25x 및 45x의 메모리 비율 및 속도 향상 비율)를 사용하고 여전히 새로운 범주를 빠르게 학습합니다. 이 아이디어를 확장하면 학습된 범주의 수가 계속 증가함에 따라 저자 팀은 모델의 학습 시간과 데이터 저장 공간이 기하급수적으로 줄어들어 새로운 범주를 보다 효율적으로 학습할 수 있을 것으로 기대하며, 이는 아마도 인간의 뇌가 실제로 학습할 때 어떤 일이 일어나는지 반영할 수 있을 것입니다.

실험 결과에 따르면 SWIL은 시퀀스 학습 프레임워크에 여러 개의 새로운 클래스를 통합하여 신경망이 간섭 없이 학습을 계속할 수 있음을 보여줍니다.

그림 6: 저자 팀은 성능이 수렴될 때까지 새로운 "cat" 클래스(작업 1)를 학습한 다음 "car" 클래스(작업 2)를 학습하도록 6계층 CNN을 학습했습니다. 다음 두 가지 경우 Yu Stable: 1) FIL: 동일한 확률로 제시된 이전 카테고리(다른 색상으로 그려짐)와 새 카테고리("고양이"/"자동차")의 모든 이미지를 포함합니다. 2) SWIL: 다음을 포함하는 이미지를 기반으로 합니다. 새로운 카테고리("cat"/"car")와 비례적으로 이전 카테고리 예를 사용합니다. 또한 Task 1에서 학습한 "cat" 클래스를 포함하고 Task 2에서 학습한 "car" 클래스의 유사성을 기준으로 가중치를 부여합니다. 첫 번째 하위 그림은 각 시대에 사용된 이미지 수의 분포를 보여줍니다. 나머지 하위 그림은 각각 새 범주, 유사한 이전 범주 및 다른 이전 범주를 예측하고 예측할 때 FIL(파란색) 및 SWIL(자홍색)의 재현율을 나타냅니다. 모든 범주의 재현율. 테스트 데이터 세트의 전체 정확도 및 교차 엔트로피 손실. 여기서 가로축은 시대 수입니다.

SWIL을 사용하여 카테고리 간 거리를 넓히고 학습 시간과 데이터 양을 줄입니다

저자팀은 마침내 SWIL 알고리즘의 일반화를 테스트하고 더 많은 카테고리를 포함하는 데이터 세트를 학습할 수 있는지, 더 복잡한 네트워크 아키텍처에 적용 가능합니다.

그들은 CIFAR100 데이터 세트(훈련 세트 500개 이미지/클래스, 테스트 세트 100개 이미지/클래스)에서 복잡한 CNN 모델-VGG19(총 19개 레이어)를 훈련하고 90개 범주를 학습했습니다. 그런 다음 네트워크는 새로운 범주를 학습하도록 재교육됩니다. 그림 7A는 CIFAR100 데이터 세트를 기반으로 두 번째 레이어의 활성화 함수를 기반으로 저자 팀이 계산한 유사성 매트릭스를 보여줍니다. 그림 7B에 표시된 대로 새로운 "기차" 클래스는 "버스"("버스"), "전차"("트램") 및 "트랙터"("트랙터") 등과 같은 많은 기존 교통 클래스와 호환됩니다. ) 매우 유사합니다.

FIL에 비해 SWIL은 새로운 것을 더 빠르게 학습할 수 있고(속도 향상 비율 = 95.45x(45500×6/(1430×2))) 훨씬 적은 데이터를 사용할 수 있으며(메모리 비율 = 31.8x) 성능은 기본적으로 동일합니다(H=8.21, P>0.05). 그림 7C에 표시된 것처럼 PIL(H=10.34, P

동시에 서로 다른 범주의 표현 간의 큰 거리가 모델 학습을 가속화하기 위한 기본 조건을 구성하는지 탐색하기 위해 저자 팀은 두 가지 신경망 모델을 추가로 훈련했습니다. CIFAR10 기반 그래프 4는 그림 5와 동일합니다.

- VGG11(11개 레이어)은 CIFAR100 데이터 세트에서 90개 범주를 학습하고 FIL 및 SWIL이라는 두 가지 조건에서만 새로운 "훈련" 클래스를 훈련합니다.

그림 7:

그림 7:

네트워크가 겹치지 않는 더 많은 클래스에 대해 훈련되고 표현 간의 거리가 더 커지면 속도가 더욱 향상됩니까? 이를 위해 저자 팀은 심층 선형 네트워크(그림 1-3의 Fashion-MNIST 예제에 사용됨)를 채택하고 8개의 Fashion-MNIST 카테고리("가방" 제외)로 구성된 네트워크를 학습하도록 훈련했습니다.” 및 "부팅" 범주) 및 10개의 Digit-MNIST 범주를 수행한 다음 새로운 "부팅" 범주를 학습하도록 네트워크를 훈련시킵니다. 저자 팀의 기대에 맞춰 "부츠"는 기존 카테고리 "샌들" 및 "스니커"와 더 유사하며 나머지 패션-MNIST 카테고리(주로 의류 이미지 포함)가 그 뒤를 따릅니다. 마지막으로 Digit-MNIST 카테고리(주로 디지털 이미지 포함)입니다. 이를 기반으로 저자 팀은 먼저 더 유사한 이전 카테고리 샘플을 인터리브한 다음 Fashion-MNIST 및 Digit-MNIST 카테고리 샘플을 인터리브했습니다(총 n=350 이미지/에포크). 실험 결과에 따르면 FIL과 유사하게 SWIL은 간섭 없이 새로운 카테고리 콘텐츠를 빠르게 학습할 수 있지만 메모리 비율이 325.7x(114000/350)이고 가속 비율이 162.85x(228000/228000)인 훨씬 작은 데이터 하위 집합을 사용하는 것으로 나타났습니다. /350). 저자 팀은 현재 결과에서 Fashion-MNIST 데이터 세트에 비해 카테고리 수(18/8)가 2.25배 증가하여 2.1배(162.85/77.1)의 속도 향상을 관찰했습니다.

이 섹션의 실험 결과는 SWIL이 보다 복잡한 데이터 세트(CIFAR100) 및 신경망 모델(VGG19)에 적용될 수 있음을 확인하는 데 도움이 되며 알고리즘의 일반화를 입증합니다. 또한 범주 간의 내부 거리를 넓히거나 겹치지 않는 범주의 수를 늘리면 학습 속도가 더욱 향상되고 메모리 부하가 감소할 수 있음을 입증했습니다.

요약

인공 신경망은 지속적인 학습에서 심각한 문제에 직면하며 종종 치명적인 간섭을 나타냅니다. 이 문제를 극복하기 위해 많은 연구에서는 새로운 콘텐츠와 기존 콘텐츠를 교차 학습하여 네트워크를 공동으로 훈련시키는 완전 인터리브 학습(FIL)을 사용했습니다. FIL은 새로운 정보를 배울 때마다 기존의 모든 정보를 엮어야 하기 때문에 생물학적으로 믿기 어렵고 시간이 많이 걸리는 프로세스입니다. 최근 일부 연구에서는 FIL이 필요하지 않을 수 있으며, SWIL(Silarity Weighted Interleaved Learning) 방법을 사용하여 새로운 콘텐츠와 표현적 유사성이 큰 기존 콘텐츠만 인터리빙하면 동일한 학습 효과를 얻을 수 있다는 사실이 밝혀졌습니다. 그러나 SWIL의 확장성에 대한 우려가 제기되었습니다.

이 문서에서는 SWIL 알고리즘을 확장하고 다양한 데이터 세트(Fashion-MNIST, CIFAR10 및 CIFAR100)와 신경망 모델(심층 선형 네트워크 및 CNN)을 기반으로 이를 테스트합니다. 모든 조건에서 유사성 가중 인터리브 학습(SWIL)과 동일 가중 인터리브 학습(EqWIL)은 부분 인터리브 학습(PIL)에 비해 새로운 범주를 학습하는 데 더 나은 성능을 보였습니다. SWIL과 EqWIL은 이전 카테고리에 비해 새로운 카테고리의 상대적 빈도를 높이기 때문에 이는 작성자 팀의 기대와 일치합니다.

이 문서는 또한 유사한 콘텐츠를 신중하게 선택하고 엮으면 기존 카테고리를 동일하게 서브샘플링하는 것(예: EqWIL 방법)에 비해 유사한 이전 카테고리에 대한 치명적인 간섭을 줄일 수 있음을 보여줍니다. SWIL은 새로운 범주와 기존 범주를 예측하는 데 FIL과 유사하게 수행되지만 필요한 교육 데이터를 크게 줄이면서 새로운 콘텐츠 학습 속도를 크게 향상시킵니다(그림 7D). SWIL은 시퀀스 학습 프레임워크에서 새로운 범주를 학습하여 일반화 기능을 더욱 입증할 수 있습니다. ㅋㅋㅋ 전반적으로 실험 결과는 비현실적인 훈련 시간을 줄임으로써 뇌가 원래 CLST 모델의 주요 약점 중 하나를 실제로 극복했다는 가능한 통찰력을 제공합니다.

위 내용은 연구에 따르면 유사성 기반 가중치 인터리브 학습은 딥 러닝의 '기억상실' 문제를 효과적으로 처리할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7489

7489

15

15

1377

1377

52

52

77

77

11

11

52

52

19

19

19

19

41

41

YOLO는 불멸이다! YOLOv9 출시: 성능과 속도 SOTA~

Feb 26, 2024 am 11:31 AM

YOLO는 불멸이다! YOLOv9 출시: 성능과 속도 SOTA~

Feb 26, 2024 am 11:31 AM

오늘날의 딥러닝 방법은 모델의 예측 결과가 실제 상황에 가장 가깝도록 가장 적합한 목적 함수를 설계하는 데 중점을 두고 있습니다. 동시에 예측을 위한 충분한 정보를 얻을 수 있도록 적합한 아키텍처를 설계해야 합니다. 기존 방법은 입력 데이터가 레이어별 특징 추출 및 공간 변환을 거치면 많은 양의 정보가 손실된다는 사실을 무시합니다. 이 글에서는 딥 네트워크를 통해 데이터를 전송할 때 중요한 문제, 즉 정보 병목 현상과 가역 기능을 살펴보겠습니다. 이를 바탕으로 다중 목표를 달성하기 위해 심층 네트워크에서 요구되는 다양한 변화에 대처하기 위해 PGI(Programmable Gradient Information) 개념을 제안합니다. PGI는 목적 함수를 계산하기 위해 대상 작업에 대한 완전한 입력 정보를 제공할 수 있으므로 네트워크 가중치를 업데이트하기 위한 신뢰할 수 있는 기울기 정보를 얻을 수 있습니다. 또한 새로운 경량 네트워크 프레임워크가 설계되었습니다.

자율 주행을 위한 세 가지 주류 칩 아키텍처 개요를 한 기사로 살펴보세요.

Apr 12, 2023 pm 12:07 PM

자율 주행을 위한 세 가지 주류 칩 아키텍처 개요를 한 기사로 살펴보세요.

Apr 12, 2023 pm 12:07 PM

현재 주류 AI 칩은 크게 GPU, FPGA, ASIC 세 가지 범주로 나뉜다. GPU와 FPGA는 모두 초기 단계에서 상대적으로 성숙한 칩 아키텍처이며 범용 칩입니다. ASIC은 특정 AI 시나리오에 맞게 맞춤화된 칩입니다. 업계에서는 CPU가 AI 컴퓨팅에 적합하지 않지만 AI 애플리케이션에도 필수적이라는 점을 확인했다. GPU와 CPU의 GPU 솔루션 아키텍처 비교 CPU는 von Neumann 아키텍처를 따르며, 그 핵심은 프로그램/데이터 저장 및 직렬 순차 실행입니다. 따라서 CPU 아키텍처는 저장 장치(Cache)와 제어 장치(Control)를 배치하는 데 많은 공간이 필요한 반면, 컴퓨팅 장치(ALU)는 작은 부분만 차지하므로 CPU가 대규모 작업을 수행합니다. 병렬 컴퓨팅.

'Bilibili UP의 소유자는 세계 최초의 레드스톤 기반 신경망을 성공적으로 만들었습니다. 이는 소셜 미디어에서 센세이션을 일으켰고 Yann LeCun의 칭찬을 받았습니다.'

May 07, 2023 pm 10:58 PM

'Bilibili UP의 소유자는 세계 최초의 레드스톤 기반 신경망을 성공적으로 만들었습니다. 이는 소셜 미디어에서 센세이션을 일으켰고 Yann LeCun의 칭찬을 받았습니다.'

May 07, 2023 pm 10:58 PM

마인크래프트에서 레드스톤은 매우 중요한 아이템이다. 스위치, 레드스톤 횃불, 레드스톤 블록은 게임 내 고유한 재료로 전선이나 물체에 전기와 같은 에너지를 공급할 수 있습니다. 레드스톤 회로는 다른 기계를 제어하거나 활성화하기 위한 구조물을 만드는 데 사용할 수 있습니다. 이 회로 자체는 플레이어의 수동 활성화에 응답하도록 설계할 수도 있고, 반복적으로 신호를 출력하거나 생물체 움직임과 같은 비플레이어에 의한 변경에 응답할 수도 있습니다. 아이템 낙하, 식물 성장, 낮과 밤 등. 따라서 내 세계에서 레드스톤은 자동문, 조명 스위치, 스트로보 전원 공급 장치와 같은 단순한 기계부터 거대한 엘리베이터, 자동 농장, 소형 게임 플랫폼, 심지어 게임 내 컴퓨터까지 매우 다양한 유형의 기계를 제어할 수 있습니다. . 최근 B 스테이션 UP 메인@

다중 경로, 다중 도메인, 모든 것을 포함합니다! Google AI, 다중 도메인 학습 일반 모델 MDL 출시

May 28, 2023 pm 02:12 PM

다중 경로, 다중 도메인, 모든 것을 포함합니다! Google AI, 다중 도메인 학습 일반 모델 MDL 출시

May 28, 2023 pm 02:12 PM

비전 작업(예: 이미지 분류)을 위한 딥 러닝 모델은 일반적으로 단일 시각적 영역(예: 자연 이미지 또는 컴퓨터 생성 이미지)의 데이터를 사용하여 엔드투엔드 학습됩니다. 일반적으로 여러 도메인에 대한 비전 작업을 완료하는 애플리케이션은 각 개별 도메인에 대해 여러 모델을 구축하고 이를 독립적으로 교육해야 합니다. 추론 중에는 각 모델이 특정 도메인 입력 데이터를 처리합니다. 서로 다른 분야를 지향하더라도 이러한 모델 간 초기 레이어의 일부 기능은 유사하므로 이러한 모델의 공동 학습이 더 효율적입니다. 이렇게 하면 대기 시간과 전력 소비가 줄어들고, 각 모델 매개변수를 저장하는 데 드는 메모리 비용이 줄어듭니다. 이러한 접근 방식을 다중 도메인 학습(MDL)이라고 합니다. 또한 MDL 모델은 단일 모델보다 성능이 뛰어날 수도 있습니다.

1.3ms는 1.3ms가 걸립니다! Tsinghua의 최신 오픈 소스 모바일 신경망 아키텍처 RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms는 1.3ms가 걸립니다! Tsinghua의 최신 오픈 소스 모바일 신경망 아키텍처 RepViT

Mar 11, 2024 pm 12:07 PM

논문 주소: https://arxiv.org/abs/2307.09283 코드 주소: https://github.com/THU-MIG/RepViTRepViT는 모바일 ViT 아키텍처에서 잘 작동하며 상당한 이점을 보여줍니다. 다음으로, 본 연구의 기여를 살펴보겠습니다. 기사에서는 경량 ViT가 일반적으로 시각적 작업에서 경량 CNN보다 더 나은 성능을 발휘한다고 언급했는데, 그 이유는 주로 모델이 전역 표현을 학습할 수 있는 MSHA(Multi-Head Self-Attention 모듈) 때문입니다. 그러나 경량 ViT와 경량 CNN 간의 아키텍처 차이점은 완전히 연구되지 않았습니다. 본 연구에서 저자는 경량 ViT를 효과적인

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

편집자 |ScienceAI 질문 응답(QA) 데이터 세트는 자연어 처리(NLP) 연구를 촉진하는 데 중요한 역할을 합니다. 고품질 QA 데이터 세트는 모델을 미세 조정하는 데 사용될 수 있을 뿐만 아니라 LLM(대형 언어 모델)의 기능, 특히 과학적 지식을 이해하고 추론하는 능력을 효과적으로 평가하는 데에도 사용할 수 있습니다. 현재 의학, 화학, 생물학 및 기타 분야를 포괄하는 과학적인 QA 데이터 세트가 많이 있지만 이러한 데이터 세트에는 여전히 몇 가지 단점이 있습니다. 첫째, 데이터 형식이 비교적 단순하고 대부분이 객관식 질문이므로 평가하기 쉽지만 모델의 답변 선택 범위가 제한되고 모델의 과학적 질문 답변 능력을 완전히 테스트할 수 없습니다. 이에 비해 개방형 Q&A는

몇 년 안에 프로그래머가 쇠퇴할 것이라는 사실을 알고 계십니까?

Nov 08, 2023 am 11:17 AM

몇 년 안에 프로그래머가 쇠퇴할 것이라는 사실을 알고 계십니까?

Nov 08, 2023 am 11:17 AM

"ComputerWorld" 잡지는 IBM이 엔지니어가 필요한 수학 공식을 작성한 다음 이를 제출하면 프로그래밍이 종료되도록 하는 새로운 언어 FORTRAN을 개발했기 때문에 "프로그래밍은 1960년에 사라질 것"이라는 기사를 쓴 적이 있습니다. 몇 년 후 우리는 비즈니스 용어를 사용하여 문제를 설명하고 컴퓨터에 COBOL이라는 프로그래밍 언어를 사용하면 더 이상 프로그래머가 필요하지 않다는 새로운 말을 들었습니다. 이후 IBM은 직원들이 양식을 작성하고 보고서를 생성할 수 있는 RPG라는 새로운 프로그래밍 언어를 개발해 회사의 프로그래밍 요구 사항 대부분을 이를 통해 완료할 수 있다고 합니다.

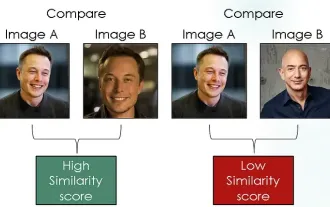

이미지 유사성 비교를 위해 대비 손실을 사용하는 Siamese 네트워크 탐색

Apr 02, 2024 am 11:37 AM

이미지 유사성 비교를 위해 대비 손실을 사용하는 Siamese 네트워크 탐색

Apr 02, 2024 am 11:37 AM

소개 컴퓨터 비전 분야에서 이미지 유사성을 정확하게 측정하는 것은 광범위한 실제 응용 분야에서 중요한 작업입니다. 이미지 검색 엔진부터 얼굴 인식 시스템, 콘텐츠 기반 추천 시스템까지 유사한 이미지를 효과적으로 비교하고 찾는 능력이 중요합니다. 대조 손실과 결합된 Siamese 네트워크는 데이터 기반 방식으로 이미지 유사성을 학습하기 위한 강력한 프레임워크를 제공합니다. 이 블로그 게시물에서는 Siamese 네트워크에 대해 자세히 알아보고 대비 손실의 개념을 살펴보고 이 두 구성 요소가 어떻게 함께 작동하여 효과적인 이미지 유사성 모델을 생성하는지 살펴보겠습니다. 첫째, Siamese 네트워크는 동일한 가중치와 매개변수를 공유하는 두 개의 동일한 하위 네트워크로 구성됩니다. 각 하위 네트워크는 입력 이미지를 특징 벡터로 인코딩합니다.