Translator | Zhu Xianzhong

Reviewer | Chonglou

이미지 출처 https://www.php.cn/link/f74412c3c1c8 899f3 c130bb30ed0e363, 저자 자신 Made by

인공 지능은 우리가 살고 일하고 기술과 상호 작용하는 방식을 변화시키는 데 놀라운 발전을 이루고 있습니다. 최근 눈에 띄는 진전을 보인 분야 중 하나는 GPT-3, ChatGPT 및 과 같은 대규모 언어 모델(LLM)의 개발입니다. GPT-4. 이러한 모델은 번역, 텍스트 요약, 질문 응답과 같은 언어학적 작업을 매우 정확하게 수행할 수 있습니다.

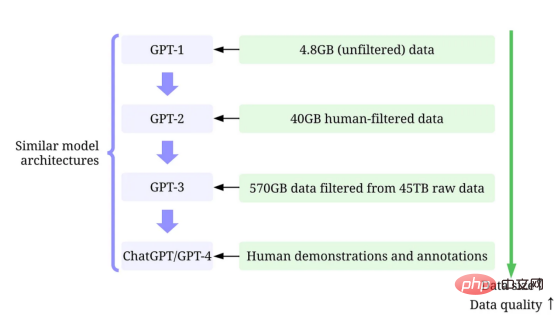

대형 언어 모델의 계속 증가하는 모델 크기를 무시하기는 어렵지만, 이들의 성공이 주로 훈련에 사용되는 대량의 고품질 데이터에 기인한다는 점을 인식하는 것도 마찬가지로 중요합니다.

이 기사에서는 최근 설문조사 논문(문헌 1 및 2 끝)의 견해를 참조하여 데이터 중심 인공 지능 관점에서 대규모 언어 모델의 최근 진행 상황에 대한 개요를 제공하겠습니다. 및 GitHub 해당 기술 리소스에 있습니다. 특히, 데이터 과학 커뮤니티에서 점점 커지고 있는 관점인 데이터 중심 인공 지능이라는 렌즈를 통해 GPT 모델을 자세히 살펴보겠습니다. 학습 데이터 개발, 추론 데이터 개발, 데이터 유지 관리라는 세 가지 데이터 중심 인공 지능 목표에 대해 논의하여 GPT 모델 뒤에 있는 데이터 중심 인공 지능 개념을 공개합니다.

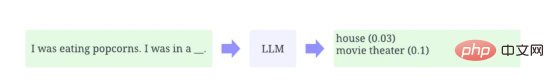

LLM(Large Language Model)은 문맥에 따라 단어를 추론하도록 훈련된 자연어 처리 모델입니다. 예를 들어, LLM의 가장 기본적인 기능은 주어진 상황에서 누락된 토큰을 예측하는 것입니다. 이를 위해 LLM은 방대한 양의 데이터로부터 각 후보 토큰의 확률을 예측하도록 훈련됩니다.

컨텍스트가 포함된 대규모 언어 모델을 사용하여 토큰 누락 확률을 예측하는 예시(저자 본인이 직접 제공한 이미지)

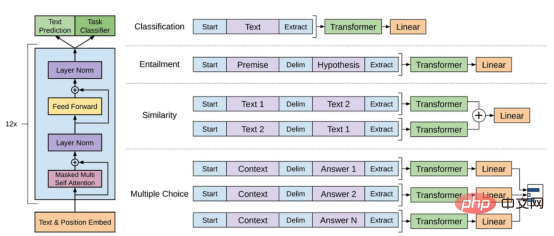

GPT 모델은 GPT-1, GPT-2, 등 OpenAI가 만든 일련의 대규모 언어 모델을 말합니다. GPT -3, InstructGPT 및 ChatGPT/GPT-4. 다른 대규모 언어 모델과 마찬가지로 GPT 모델의 아키텍처는 텍스트 및 위치 임베딩을 입력으로 사용하고 Attention 레이어를 사용하여 토큰 간의 관계를 모델링하는 Transformers에 크게 기반을 두고 있습니다.

GPT-1 모델 아키텍처 다이어그램, 이 이미지는 논문 https://www.php.cn/link/c3bfbc2fc89bd1dd71ad5fc5ac96ae69

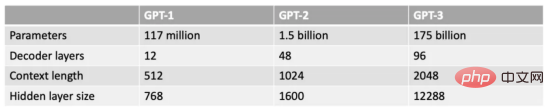

나중 GPT 모델은 GPT와 유사한 것을 사용합니다. 1 아키텍처는 더 많은 모델 매개변수를 사용하고 더 많은 레이어, 더 큰 컨텍스트 길이, 숨겨진 레이어 크기 등을 갖습니다.

GPT 모델의 다양한 모델 크기 비교(작성자 제공 이미지)

데이터 중심 인공 지능은 인공 지능 시스템을 구축하는 방법에 대한 새로운 사고 방식입니다. 인공 지능의 선구자인 Andrew Ng는 이 아이디어를 옹호해 왔습니다.

데이터 중심 인공 지능은 인공 지능 시스템을 구축하는 데 사용되는 데이터를 체계적으로 엔지니어링하는 학문입니다.

——Andrew Ng

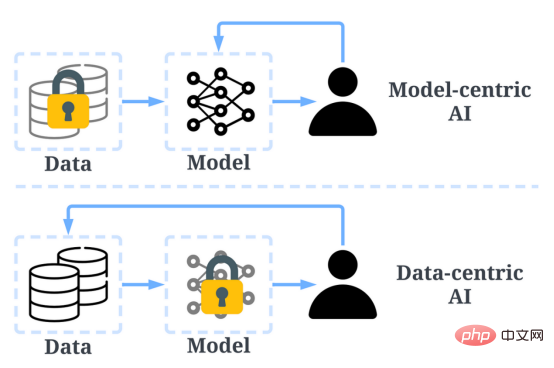

과거에는 데이터가 기본적으로 변경되지 않은 상태에서 더 나은 모델(모델 중심 인공 지능)을 만드는 데 주로 집중했습니다. 그러나 이 접근 방식은 부정확한 레이블, 중복, 편향 등 데이터에서 발생할 수 있는 다양한 문제를 고려하지 않기 때문에 현실 세계에서 문제를 일으킬 수 있습니다. 따라서 데이터 세트를 "과적합"한다고 해서 반드시 모델 동작이 더 좋아지는 것은 아닙니다.

반면, 데이터 중심 AI는 AI 시스템 구축에 사용되는 데이터의 질과 양을 향상시키는 데 중점을 둡니다. 이는 관심이 데이터 자체에 집중되는 반면 모델은 상대적으로 더 고정되어 있음을 의미합니다. AI 시스템 개발에 대한 데이터 중심 접근 방식은 훈련에 사용되는 데이터가 궁극적으로 모델의 최대 성능을 결정하므로 현실 세계에서 더 큰 잠재력을 갖습니다.

"데이터 중심"은 "데이터 중심"과 근본적으로 다르다는 점에 주목할 가치가 있습니다. 왜냐하면 후자는 인공 지능 개발을 안내하기 위한 데이터 사용만 강조하는 반면, 인공 지능 개발은 일반적으로 여전히 데이터 기반에 기반을 두고 있기 때문입니다. 비엔지니어링 데이터 중심의 모델 개발.

데이터 중심 인공 지능과 모델 중심 AI의 비교 (사진 출처: https://www.php.cn/link/f9afa97535cf7c8789a1c50a2cd83787 저자)

전반적으로 데이터 중심 인공 지능 프레임워크는 세 가지 목표로 구성됩니다.

데이터 중심 인공 지능 프레임워크(논문 작성자의 이미지 https://www.php.cn/link/f74412c3c1c8899f3c130bb30ed0e363)

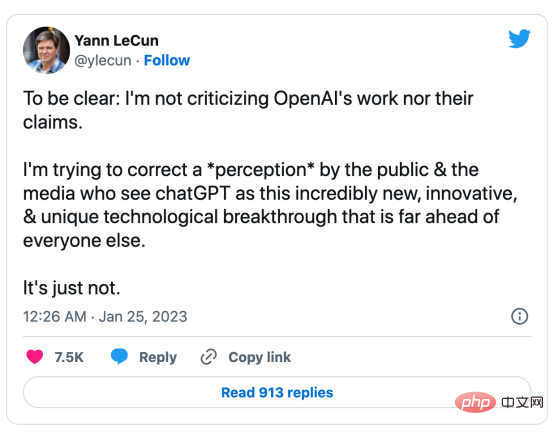

몇 달 전, 인공 지능 업계의 선두주자인 Yann LeCun은 자신의 트위터에서 ChatGPT가 전혀 새로운 것이 아니라고 밝혔습니다. 실제로 ChatGPT 및 GPT-4(T변압기 및 인간 피드백을 통한 강화 학습 등)에서 사용되는 모든 기술은 새로운 기술이 아닙니다. 그러나 이전 모델이 달성할 수 없었던 놀라운 결과를 달성했습니다. 그렇다면 성공의 원동력은 무엇입니까?

우선 훈련데이터 개발을 강화하세요. 더 나은 데이터 수집, 데이터 라벨링, 데이터 준비 전략을 통해 GPT 모델을 훈련하는 데 사용되는 데이터의 양과 품질이 크게 향상되었습니다.

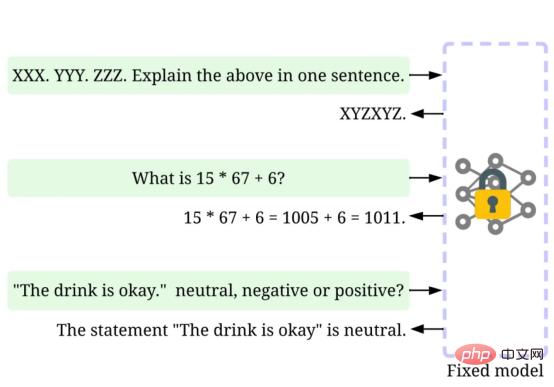

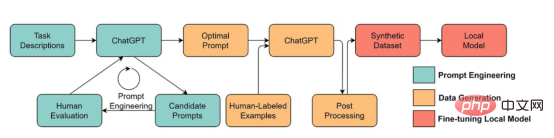

둘째, 추론 데이터를 개발합니다. 최근 GPT 모델은 충분히 강력해졌기 때문에 모델을 수정하면서 힌트를 조정(또는 추론 데이터를 조정)함으로써 다양한 목표를 달성할 수 있습니다. 예를 들어, 추론 프로세스를 안내하기 위해 "요약하세요" 또는 "TL;DR"과 같은 지침과 함께 요약 텍스트를 제공하여 텍스트 요약을 수행할 수 있습니다.

신속한 미세 조정, 사진 제공: 작성자

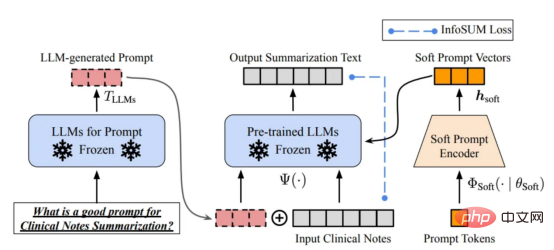

올바른 추론 프롬프트를 디자인하는 것은 어려운 작업입니다. 이는 휴리스틱 기술에 크게 의존합니다. 좋은 설문조사는 사람들이 지금까지 사용하는 다양한 유도 방법을 요약합니다. 때로는 의미상 유사한 단서라도 매우 다른 출력을 가질 수 있습니다. 이 경우 불일치를 줄이기 위해 소프트 큐 기반 보정이 필요할 수 있습니다.

소프트 프롬프트 기반 교정. 이 이미지는 원저자

의 허가를 받아 https://arxiv.org/abs/2303.13035v1 논문에서 가져온 것입니다. 대규모 언어 모델 추론 데이터 개발에 대한 연구는 아직 초기 단계입니다. . 가까운 미래에는 이미 다른 작업에서 사용되는 더 많은 추론 데이터 개발 기술이 대규모 언어 모델 분야에 적용될 수 있습니다.

데이터 유지 관리 측면에서 ChatGPT/GPT-4는 상용 제품으로서 단순한 성공적인 교육이 아니라 지속적인 업데이트와 유지 관리가 필요합니다. 분명히 우리는 OpenAI 외부에서 데이터 유지 관리가 어떻게 수행되는지 모릅니다. 따라서 GPT 모델에서 사용되었거나 사용될 가능성이 있는 몇 가지 일반적인 데이터 중심 AI 전략에 대해 논의합니다.

ChatGPT/GPT-4 시스템은 그림에 표시된 것처럼 "좋아요"와 "좋아요"라는 두 개의 아이콘 버튼을 통해 사용자 피드백을 수집하여 시스템 개발을 더욱 촉진할 수 있습니다. 여기 스크린샷은 https://chat.openai.com/chat에서 가져온 것입니다.

대규모 언어 모델의 성공은 인공 지능에 혁명을 일으켰습니다. 앞으로 대규모 언어 모델은 데이터 과학 수명주기에 더욱 혁명을 일으킬 수 있습니다. 이를 위해 우리는 두 가지 예측을 내린다.

참조 정보

참조 정보

이 기사가 귀하의 작업에 영감을 주기를 바랍니다. 다음 문서에서 데이터 중심 AI 프레임워크와 이것이 대규모 언어 모델에 어떤 이점을 제공하는지 자세히 알아볼 수 있습니다.

[1]데이터 중심 인공지능 리뷰.

[2]데이터 중심 인공지능의 전망과 과제.

저희는 관련 데이터 중심 인공 지능 리소스를 정기적으로 업데이트하는 GitHub 코드 저장소도 유지 관리하고 있습니다.

다음 글에서는 데이터 중심 인공지능의 세 가지 목표(훈련 데이터 개발, 추론 데이터 개발, 데이터 유지 관리)에 대해 자세히 알아보고 대표적인 방법을 소개하겠습니다.

Zhu Xianzhong, 51CTO 커뮤니티 편집자, 51CTO 전문 블로거, 강사, 웨이팡 대학의 컴퓨터 교사이자 프리랜스 프로그래밍 업계의 베테랑입니다.

원제: GPT 모델의 데이터 중심 AI 개념은 무엇입니까?, 저자: Henry Lai

위 내용은 GPT 모델 속 데이터 중심 AI의 비밀의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!