EMNLP 2022 컨퍼런스 공식 종료, 최우수 장편 논문, 최우수 단편 논문 및 기타 수상 발표

최근 아랍에미리트의 수도 아부다비에서 자연어 처리 분야 최고의 컨퍼런스인 EMNLP 2022가 열렸습니다.

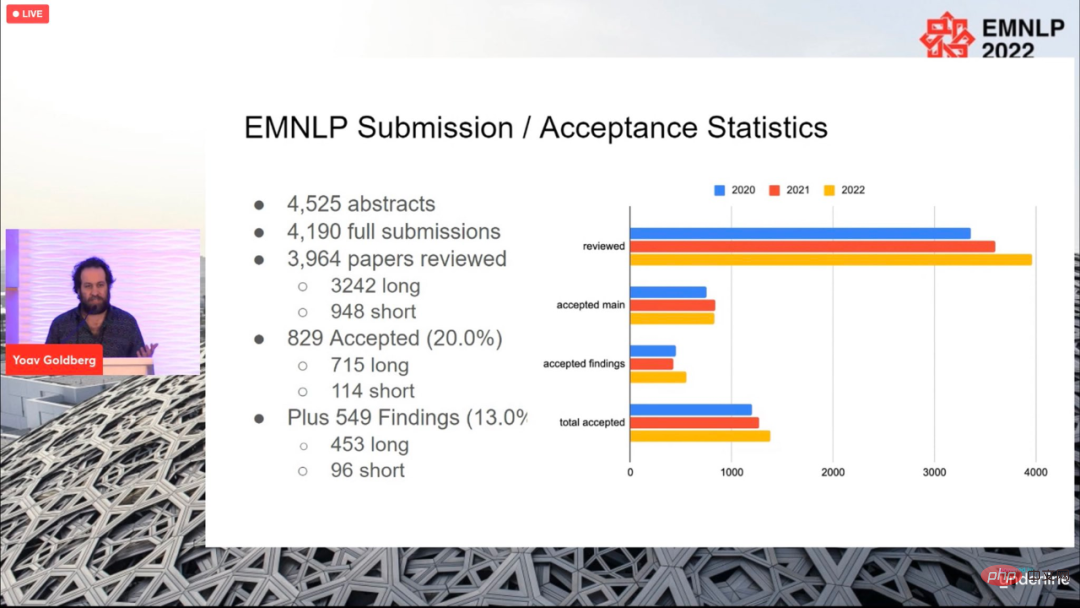

올해 학회에는 총 4190편의 논문이 제출되어 829편(장편 715편, 114편)이 최종 승인되었으며, 전체 합격률은 20%로 이전과 크게 다르지 않습니다. 연령.

컨퍼런스는 현지 시간으로 12월 11일에 종료되었으며, 최우수 장편논문(1편), 최우수 단편논문(1편), 최우수 단편논문(1편) 등 올해의 논문상도 발표되었습니다. 데모 문서(1개 기사).

Best Long Paper

Paper: Tangram Shapes를 사용한 추상적 시각적 추론

- 저자: Anya Ji , Noriyuki Kojima, Noah Rush, Alane Suhr, Wai Keen Vong , Robert D. Hawkins , Yoav Artzi

- 기관: 코넬 대학교, 뉴욕 대학교, Allen 연구소, 프린스턴 대학교

- 논문 링크: https://arxiv.org/pdf/2211.16492.pdf

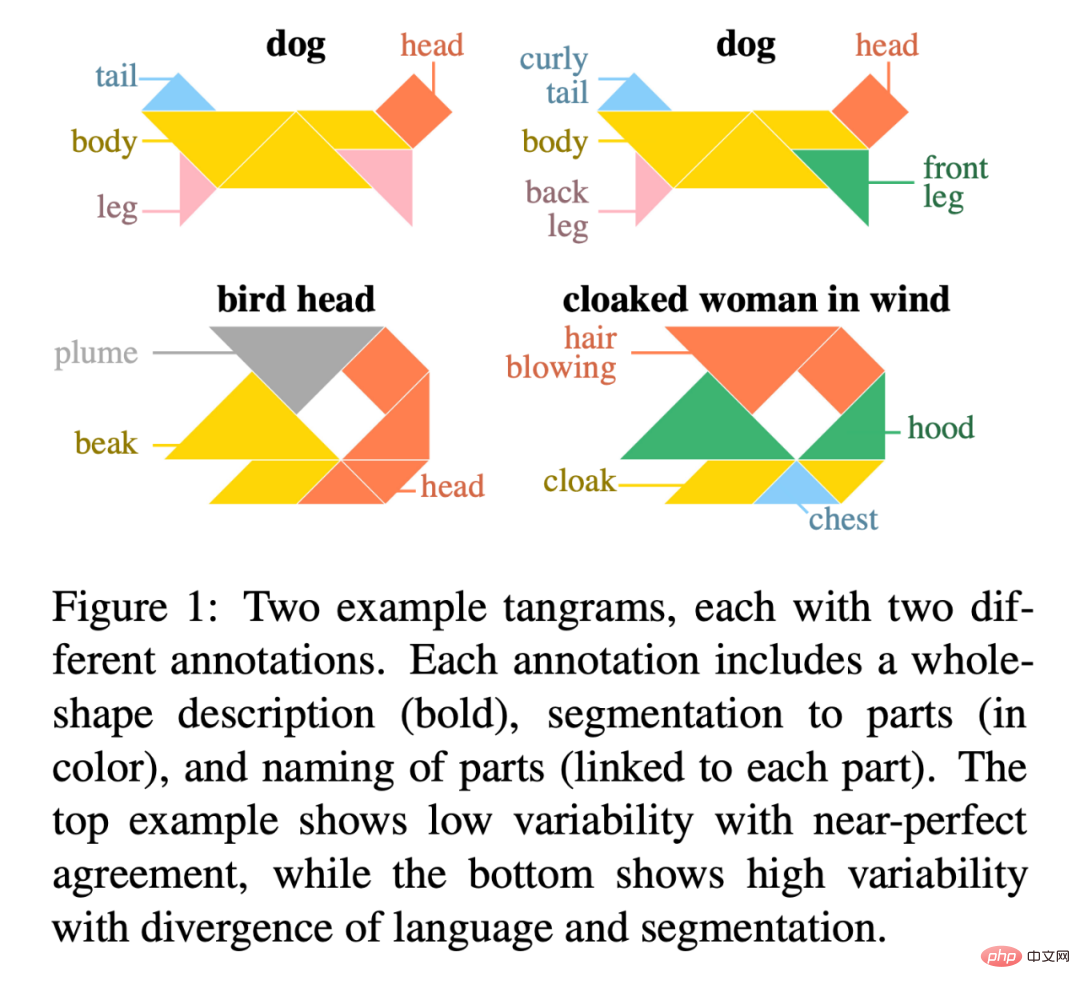

Paper abstract: 본 논문에서 연구원은 인간과 기계의 추상적 시각적 추론을 연구하기 위한 리소스 라이브러리인 "KiloGram"을 소개합니다. KiloGram은 두 가지 방법으로 기존 리소스를 크게 향상시킵니다. 먼저 연구자들은 1,016개의 도형을 선별하고 디지털화하여 기존 작업에 사용된 것보다 2배 더 큰 컬렉션을 만들었습니다. 이 컬렉션은 명명 변형의 전체 범위에 대한 적용 범위를 크게 늘려 인간의 명명 행동에 대한 보다 포괄적인 관점을 제공합니다. 둘째, 컬렉션은 각 탱그램을 단일한 전체 모양이 아닌 원본 퍼즐 조각으로 구성된 벡터 모양으로 취급합니다. 이러한 분해를 통해 전체 모양과 부분에 대한 추론이 가능해집니다. 연구원들은 이 새로운 디지털 직소 퍼즐 그래픽 컬렉션을 사용하여 명명 동작의 다양성을 반영하는 대량의 텍스트 설명 데이터를 수집했습니다.

연구원들은 크라우드소싱을 활용하여 주석 프로세스를 확장하고 각 모양에 대해 여러 주석을 수집하여 단일 샘플이 아닌 도출된 주석의 분포를 나타냈습니다. 총 13,404개의 주석이 수집되었으며, 각 주석은 완전한 개체와 해당 개체의 분할된 부분을 설명합니다.

KiloGram의 잠재력은 광범위합니다. 우리는 이 리소스를 사용하여 최근 다중 모드 모델의 추상적인 시각적 추론 기능을 평가했으며 사전 훈련된 가중치가 미세 조정을 통해 크게 향상되는 제한적인 추상 추론 기능을 나타냄을 관찰했습니다. 그들은 또한 명시적인 설명이 특히 언어와 시각적 입력을 공동으로 인코딩할 때 인간과 모델 모두의 추상적 추론을 촉진한다는 것을 관찰했습니다.

그림 1은 각각 두 개의 서로 다른 주석이 있는 두 개의 칠교판의 예입니다. 각 주석에는 전체 모양에 대한 설명(굵은 글씨), 부품 분할(색상), 각 부품에 대한 이름(각 부품에 연결됨)이 포함됩니다. 위쪽 예는 거의 완벽에 가까운 일치에 대한 낮은 가변성을 보여 주는 반면, 아래쪽 예는 언어 및 분할 분기에 대한 높은 가변성을 보여줍니다.

KiloGram 주소: https://lil.nlp.cornell.edu/kilogram

이 컨퍼런스의 최우수 장편 논문 후보는 Kayo Yin과 Graham Neubig입니다. 두 명의 연구원이 획득했습니다.

논문: 대조 설명을 사용한 언어 모델 해석

- 저자: Kayo Yin, Graham Neubig

논문 초록: 모델의 해석 가능성 방법은 다음과 같습니다. NLP를 설명하는 데 사용됨 출력 공간이 상대적으로 작은 텍스트 분류와 같은 작업에 대한 모델 결정. 그러나 언어 생성에 적용하면 출력 공간이 수만 개의 토큰으로 구성되는 경우가 많아 이러한 방법으로는 유익한 설명을 제공할 수 없습니다. 언어 모델은 토큰을 예측하기 위해 품사, 숫자, 시제 또는 의미와 같은 다양한 기능을 고려해야 합니다. 기존의 설명 방법은 이러한 모든 특징에 대한 증거를 단일 설명으로 결합하기 때문에 인간이 이해하기 어렵습니다.

언어 모델링에서 다양한 결정을 구별하기 위해 연구자들은 대조 설명에 초점을 맞춘 언어 모델을 탐색합니다. 그들은 눈에 띄는 입력 토큰을 찾고 모델이 하나의 토큰을 예측했지만 다른 토큰은 예측하지 않은 이유를 설명합니다. 연구에 따르면 주요 문법 현상을 검증하는 데 있어서 대조 설명이 비대비 설명보다 훨씬 더 우수하며 인간 관찰자를 위한 대조 모델 시뮬레이션 가능성이 크게 향상되는 것으로 나타났습니다. 연구자들은 또한 모델이 유사한 증거를 사용하는 대조되는 결정 그룹을 식별하고 모델이 다양한 언어 생성 결정에 사용하는 입력 토큰을 설명할 수 있었습니다.

코드 주소: https://github.com/kayoyin/interpret-lm

최고의 짧은 논문

논문: 주제별 정규화된 저자 표현 학습

- 작성자 : Jitkapat Sawatphol, Nonthakit Chaiwong, Can Udomcharoenchaikit, Sarana Nutanong

- 기관: VISTEC Institute of Science and Technology, Thai

요약: 본 연구에서 연구자들은 저자권 표시를 제안했습니다. 정규화, 주제 간 성능을 향상시키고 보이지 않는 작성자도 처리할 수 있는 증류 프레임워크입니다. 이 접근 방식은 모든 저자 표시 모델에 적용될 수 있습니다. 실험 결과 교차 주제 설정에서 4/6 성능이 향상되는 것으로 나타났습니다. 동시에 연구자들의 분석에 따르면 주제가 많은 데이터 세트에서 주제 전반에 걸쳐 설정된 훈련 샤드에는 주제 정보 유출 문제가 있어 주제 간 속성을 평가하는 능력이 약화되는 것으로 나타났습니다.

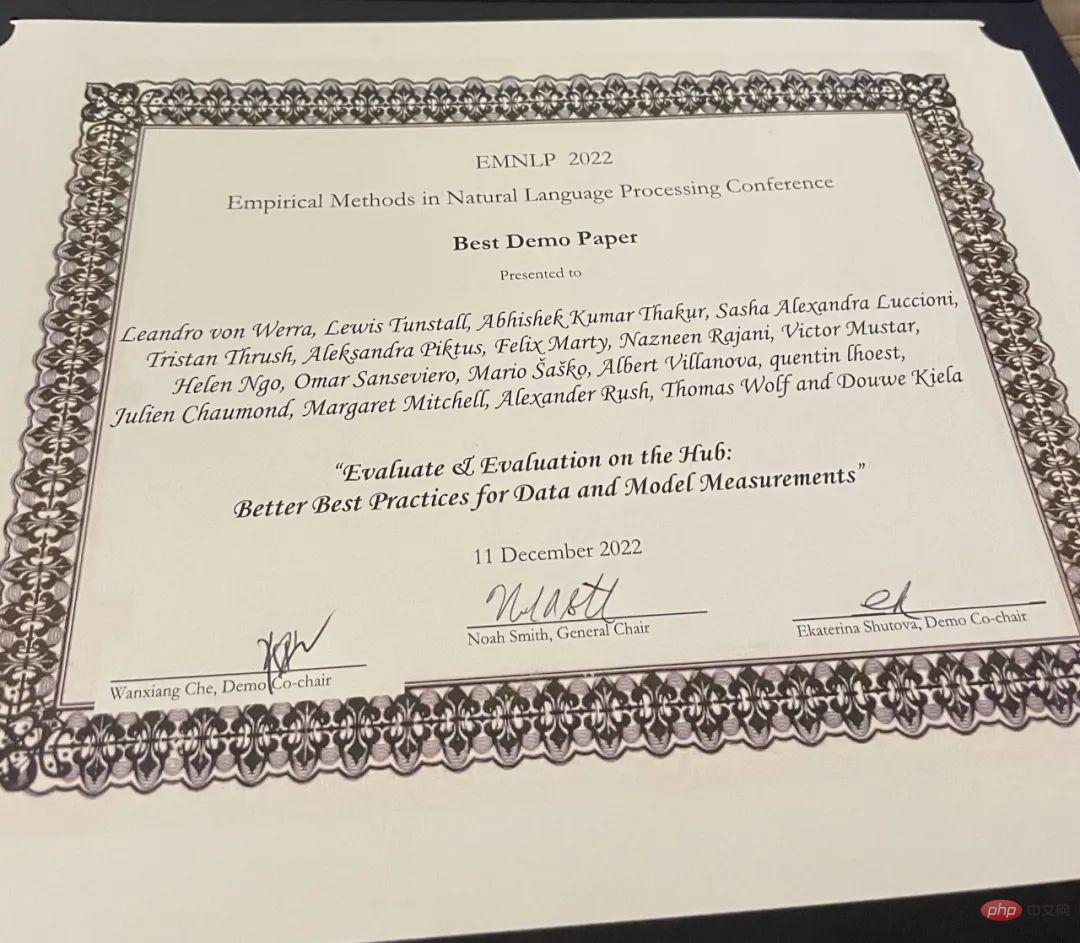

최고의 데모 문서

문서: 허브에서의 평가 및 평가: 데이터 및 모델 측정에 대한 더 나은 모범 사례

- 저자: Leandro von Werra, Lewis Tunstall, Abhishek Thakur, Alexandra Sasha Luccioni et al

- 기관: Hugging Face

- 논문 링크: https://arxiv.org/pdf/2210.01970.pdf

논문 초록: 평가는 머신 학습(ML)의 핵심 부분인 이 연구에서는 ML의 모델 및 데이터 세트를 평가하는 데 도움이 되는 도구 세트인 허브의 평가 및 평가를 소개합니다. Evaluate는 다양한 모델과 데이터세트를 비교하고 다양한 측정항목을 지원하는 라이브러리입니다. Evaluate 라이브러리는 평가 재현성을 지원하고, 평가 프로세스를 문서화하고, 평가 범위를 확장하여 모델 성능의 더 많은 측면을 포괄하도록 설계되었습니다. 여기에는 다양한 도메인 및 시나리오에 대한 50개 이상의 효율적인 사양 구현, 대화형 문서, 구현 및 평가 결과를 쉽게 공유하는 기능이 포함되어 있습니다.

프로젝트 주소: https://github.com/huggingface/evaluate

또한 연구원은 Hugging Face에서 75,000개 이상의 모델을 무료로 평가할 수 있는 플랫폼인 Evaluation on the Hub도 출시했습니다. 버튼 클릭만으로 대규모 평가를 위한 허브 및 11,000개의 데이터세트를 이용할 수 있습니다.

위 내용은 EMNLP 2022 컨퍼런스 공식 종료, 최우수 장편 논문, 최우수 단편 논문 및 기타 수상 발표의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7677

7677

15

15

1393

1393

52

52

1207

1207

24

24

91

91

11

11

73

73

19

19

Stable Diffusion 3 논문이 드디어 공개되고, 아키텍처의 세부 사항이 공개되어 Sora를 재현하는 데 도움이 될까요?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 논문이 드디어 공개되고, 아키텍처의 세부 사항이 공개되어 Sora를 재현하는 데 도움이 될까요?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3의 논문이 드디어 나왔습니다! 이 모델은 2주 전에 출시되었으며 Sora와 동일한 DiT(DiffusionTransformer) 아키텍처를 사용합니다. 출시되자마자 큰 화제를 불러일으켰습니다. 이전 버전과 비교하여 StableDiffusion3에서 생성된 이미지의 품질이 크게 향상되었습니다. 이제 다중 테마 프롬프트를 지원하고 텍스트 쓰기 효과도 향상되었으며 더 이상 잘못된 문자가 표시되지 않습니다. StabilityAI는 StableDiffusion3이 800M에서 8B 범위의 매개변수 크기를 가진 일련의 모델임을 지적했습니다. 이 매개변수 범위는 모델이 많은 휴대용 장치에서 직접 실행될 수 있어 AI 사용이 크게 줄어든다는 것을 의미합니다.

ICCV'23 논문상 'Fighting of Gods'! Meta Divide Everything과 ControlNet이 공동 선정되었는데, 심사위원들을 놀라게 한 기사가 또 있었습니다.

Oct 04, 2023 pm 08:37 PM

ICCV'23 논문상 'Fighting of Gods'! Meta Divide Everything과 ControlNet이 공동 선정되었는데, 심사위원들을 놀라게 한 기사가 또 있었습니다.

Oct 04, 2023 pm 08:37 PM

프랑스 파리에서 열린 최고의 컴퓨터 비전 컨퍼런스 ICCV2023이 막 끝났습니다! 올해 최우수 논문상은 그야말로 '신들의 싸움'이다. 예를 들어 최우수 논문상을 수상한 두 논문에는 빈센트 그래프 AI 분야를 전복한 작품인 ControlNet이 포함됐다. 오픈 소스 이후 ControlNet은 GitHub에서 24,000개의 별을 받았습니다. 확산 모델이든, 컴퓨터 비전 전체 분야이든, 이 논문의 수상은 당연한 것입니다. 최우수 논문상에 대한 명예로운 언급은 또 다른 유명한 논문인 Meta의 "Separate Everything" "Model SAM에 수여되었습니다. "Segment Everything"은 출시 이후 뒤에서 나온 모델을 포함해 다양한 이미지 분할 AI 모델의 "벤치마크"가 되었습니다.

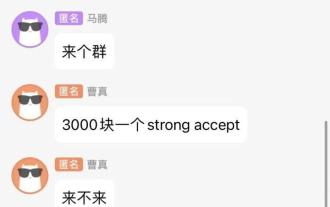

채팅 스크린샷을 통해 AI 리뷰의 숨겨진 규칙을 밝혀보세요! AAAI 3000위안은 강력하게 받아들여집니까?

Apr 12, 2023 am 08:34 AM

채팅 스크린샷을 통해 AI 리뷰의 숨겨진 규칙을 밝혀보세요! AAAI 3000위안은 강력하게 받아들여집니까?

Apr 12, 2023 am 08:34 AM

AAAI 2023 논문 제출 마감일이 다가오던 무렵, AI 제출 그룹의 익명 채팅 스크린샷이 갑자기 Zhihu에 나타났습니다. 그 중 한 명은 "3000위안 강력한 수락" 서비스를 제공할 수 있다고 주장했습니다. 해당 소식이 알려지자 네티즌들은 곧바로 공분을 샀다. 그러나 아직 서두르지 마십시오. Zhihu 상사 "Fine Tuning"은 이것이 아마도 "언어적 즐거움"일 가능성이 높다고 말했습니다. 『파인튜닝』에 따르면 인사와 갱범죄는 어느 분야에서나 피할 수 없는 문제다. openreview의 등장으로 cmt의 다양한 단점이 점점 더 명확해졌습니다. 앞으로는 작은 서클이 운영할 수 있는 공간은 더 작아지겠지만 항상 여유가 있을 것입니다. 이는 개인적인 문제이지 투고 시스템이나 메커니즘의 문제가 아니기 때문입니다. 오픈R을 소개합니다

확산 모델을 사용하여 종이 일러스트레이션을 자동으로 생성할 수도 있으며 ICLR에서도 허용됩니다.

Jun 27, 2023 pm 05:46 PM

확산 모델을 사용하여 종이 일러스트레이션을 자동으로 생성할 수도 있으며 ICLR에서도 허용됩니다.

Jun 27, 2023 pm 05:46 PM

생성형 AI(Generative AI)는 인공 지능 커뮤니티를 휩쓸었습니다. 개인과 기업 모두 Vincent 사진, Vincent 비디오, Vincent 음악 등과 같은 관련 모달 변환 애플리케이션을 만드는 데 열중하기 시작했습니다. 최근 ServiceNow Research, LIVIA 등 과학 연구 기관의 여러 연구자들이 텍스트 설명을 기반으로 논문에서 차트를 생성하려고 시도했습니다. 이를 위해 그들은 FigGen이라는 새로운 방법을 제안했고, 관련 논문도 ICLR2023에 TinyPaper로 포함됐다. 그림 논문 주소: https://arxiv.org/pdf/2306.00800.pdf 어떤 사람들은 '논문에서 차트를 생성하는 데 무엇이 그렇게 어렵나요?'라고 묻습니다. 이것이 과학 연구에 어떻게 도움이 됩니까?

NeRF와 자율주행의 과거와 현재, 10편에 가까운 논문 요약!

Nov 14, 2023 pm 03:09 PM

NeRF와 자율주행의 과거와 현재, 10편에 가까운 논문 요약!

Nov 14, 2023 pm 03:09 PM

Neural Radiance Fields가 2020년에 제안된 이후 관련 논문의 수가 기하급수적으로 늘어났습니다. 이는 3차원 재구성의 중요한 분야가 되었을 뿐만 아니라 자율 주행을 위한 중요한 도구로서 연구 분야에서도 점차 활발해졌습니다. NeRF는 지난 2년 동안 갑자기 등장했습니다. 주로 특징점 추출 및 일치, 에피폴라 기하학 및 삼각측량, PnP 및 번들 조정 및 기존 CV 재구성 파이프라인의 기타 단계를 건너뛰고 메쉬 재구성, 매핑 및 광 추적도 건너뛰기 때문입니다. , 2D에서 직접 입력된 이미지를 이용해 방사선장을 학습한 후, 방사선장에서 실제 사진에 가까운 렌더링 이미지를 출력합니다. 즉, 신경망을 기반으로 한 암시적 3차원 모델을 지정된 관점에 맞추도록 합니다.

중국팀이 최우수 논문상과 최우수 시스템 논문상을 수상하며 CoRL 연구 결과가 발표됐다.

Nov 10, 2023 pm 02:21 PM

중국팀이 최우수 논문상과 최우수 시스템 논문상을 수상하며 CoRL 연구 결과가 발표됐다.

Nov 10, 2023 pm 02:21 PM

CoRL은 2017년 처음 개최된 이후 로봇공학과 머신러닝이 교차하는 분야에서 세계 최고의 학술 컨퍼런스 중 하나로 자리매김했습니다. CoRL은 이론과 응용을 포함하여 로봇공학, 기계학습, 제어 등 다양한 주제를 다루는 로봇학습 연구를 위한 단일 주제 컨퍼런스입니다. 2023 CoRL 컨퍼런스는 11월 6일부터 9일까지 미국 애틀랜타에서 개최됩니다. 공식 자료에 따르면 올해 CoRL에는 25개국 199편의 논문이 선정됐다. 인기 있는 주제로는 운영, 강화 학습 등이 있습니다. CoRL은 AAAI, CVPR 등 대규모 AI 학술회의에 비해 규모는 작지만, 올해 대형 모델, 체화된 지능, 휴머노이드 로봇 등 개념의 인기가 높아지면서 관련 연구도 주목할 만하다.

CVPR 2023 순위 공개, 합격률 25.78%! 2,360편의 논문이 접수되었고, 제출 건수는 9,155편으로 급증했습니다.

Apr 13, 2023 am 09:37 AM

CVPR 2023 순위 공개, 합격률 25.78%! 2,360편의 논문이 접수되었고, 제출 건수는 9,155편으로 급증했습니다.

Apr 13, 2023 am 09:37 AM

방금 CVPR 2023에서는 다음과 같은 기사를 발표했습니다. 올해 우리는 기록적인 9,155편의 논문을 접수했으며(CVPR2022보다 12% 더 많음), 2,360편의 논문을 접수했으며 합격률은 25.78%입니다. 통계에 따르면 2010년부터 2016년까지 7년간 CVPR 제출 건수는 1,724건에서 2,145건으로 증가하는 데 그쳤다. 2017년 이후 급등하며 급속한 성장기에 접어들었고, 2019년에는 처음으로 5,000건을 돌파했고, 2022년에는 투고 건수가 8,161건에 이르렀다. 보시다시피 올해 총 9,155편의 논문이 제출되어 역대 최고 기록을 세웠습니다. 전염병이 완화된 후 올해 CVPR 정상회담은 캐나다에서 개최될 예정입니다. 올해는 단일 트랙 컨퍼런스 형식을 채택하고 기존 구술 선발 방식을 폐지한다. 구글 조사

상하이교통대학교 동문이 최우수 논문을 수상하고, 최고의 로봇공학 학회인 CoRL 2022의 수상이 발표되었습니다.

Apr 11, 2023 pm 11:43 PM

상하이교통대학교 동문이 최우수 논문을 수상하고, 최고의 로봇공학 학회인 CoRL 2022의 수상이 발표되었습니다.

Apr 11, 2023 pm 11:43 PM

CoRL은 2017년 처음 개최된 이래 로봇공학과 머신러닝의 교차점에서 세계 최고의 학술 컨퍼런스 중 하나로 자리매김했습니다. CoRL은 로봇 학습 연구를 위한 단일 트랙 컨퍼런스로, 이론 및 응용을 포함하여 로봇 공학, 기계 학습 및 제어와 같은 다양한 주제를 다룹니다. 2022 CoRL 컨퍼런스는 12월 14일부터 18일까지 뉴질랜드 오클랜드에서 개최됩니다. 이번 학회에는 총 504편의 논문이 접수되었으며, 최종적으로 구두논문 34편, 포스터논문 163편이 접수되었으며 합격률은 39%였습니다. 현재 CoRL 2022에서는 Best Paper Award, Best System Paper Award, Special Innovation Award를 포함한 모든 수상작을 발표했습니다. 펜실베니아 대학의 GRASP 실험