트랜스포머 리뷰: BERT에서 GPT4까지

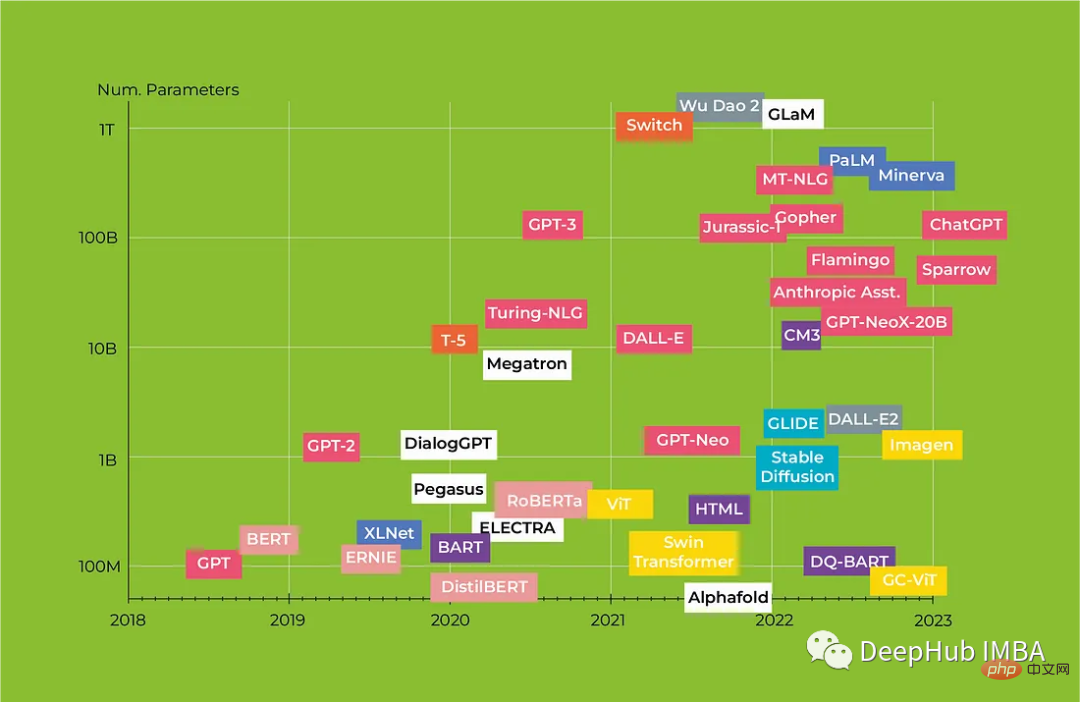

인공지능은 최근 몇 년 사이 가장 화두가 되었고, 순수 공상과학으로만 여겨졌던 서비스가 이제 신경망의 발달로 현실화되고 있습니다. 대화 에이전트에서 미디어 콘텐츠 생성에 이르기까지 인공 지능은 우리가 기술과 상호 작용하는 방식을 변화시키고 있습니다. 특히, 머신러닝(ML) 모델은 자연어 처리(NLP) 분야에서 상당한 발전을 이루었습니다. 핵심 혁신은 "self-attention"과 시퀀스 처리를 위한 Transformers 아키텍처의 도입으로, 이전에 해당 분야를 지배했던 몇 가지 핵심 문제를 해결할 수 있게 되었습니다.

이 기사에서는 혁신적인 Transformers 아키텍처와 그것이 NLP를 어떻게 변화시키고 있는지 살펴보고 BERT에서 Alpaca까지 Transformers 모델에 대한 포괄적인 검토를 제공하여 각 모델의 주요 기능과 그 기능을 강조합니다. 잠재적인 응용.

Bert와 유사한 텍스트 모델

첫 번째 부분은 Transformer 인코더 기반 모델로 벡터화, 분류, 시퀀스 라벨링, QA(질문 및 답변), NER(명명된 엔터티 인식) 등에 사용됩니다.

1. BERT Google / 2018

Transformer 인코더, 워드피스 토큰화(30K 어휘). 입력 임베딩은 레이블 벡터, 학습 가능한 위치 벡터, 조각 벡터(첫 번째 텍스트 또는 두 번째 텍스트)의 세 가지 벡터로 구성됩니다. 모델 입력은 CLS 토큰 임베딩, 첫 번째 텍스트 임베딩, 두 번째 텍스트 임베딩입니다.

BERT에는 MLM(Masked Language Modeling)과 NSP(다음 문장 예측)라는 두 가지 훈련 작업이 있습니다. MLM에서는 토큰의 15%가 마스크되고, 80%는 MASK 토큰으로 대체되고, 10%는 무작위 토큰으로 대체되고, 10%는 변경되지 않은 상태로 유지됩니다. 모델은 올바른 토큰을 예측하며 손실은 차단된 토큰의 15%에 대해서만 계산됩니다. NSP에서 모델은 두 번째 텍스트가 첫 번째 텍스트 뒤에 오는지 여부를 예측합니다. CLS 토큰의 출력 벡터에 대한 예측이 이루어집니다.

훈련 속도를 높이기 위해 먼저 훈련의 90%는 128개 토큰의 시퀀스 길이에서 수행되고 나머지 10% 시간은 보다 효과적인 위치 임베딩을 얻기 위해 512개 토큰에서 모델을 훈련하는 데 사용됩니다.

2, RoBERTa Facebook / 2019

BERT의 개선된 버전으로 MLM에서만 훈련되며(NSP는 덜 유용하다고 간주되기 때문에) 훈련 순서가 더 깁니다(512개 토큰). 동적 마스킹(동일한 데이터가 다시 처리되면 다른 토큰이 마스킹됨)을 사용하여 학습 하이퍼파라미터를 신중하게 선택합니다.

3. 원본 XLM에서는 모든 언어에 공유 BPE 어휘가 있었습니다.

XLM에는 MLM과 번역이라는 두 가지 교육 작업이 있습니다. 번역은 본질적으로 한 쌍의 텍스트에 대한 MLM과 동일하지만 텍스트는 무작위 마스크 및 세그먼트 임베딩 인코딩 언어를 사용하여 서로 병렬 번역됩니다.

4. Transformer-XL Carnegie Mellon University / 2019

이 모델은 긴 시퀀스를 처리하도록 설계되었으며 조각의 루프 처리와 상대 위치 인코딩이라는 두 가지 주요 아이디어를 가지고 있습니다.

긴 텍스트는 여러 세그먼트로 나누어 한 번에 한 세그먼트씩 처리됩니다. 이전 세그먼트의 출력은 캐싱되며, 현재 세그먼트의 self-attention을 계산할 때 현재 세그먼트와 이전 세그먼트의 출력을 기반으로 키와 값을 계산합니다(그냥 연결했을 뿐입니다). 그라데이션은 현재 세그먼트 내에서만 계산됩니다.

이 방법은 절대 위치에서는 작동하지 않습니다. 따라서 Attention 가중치 공식은 모델에서 다시 매개변수화됩니다. 절대 위치 인코딩 벡터는 마커 위치 사이의 거리 사인과 모든 위치에 공통된 학습 가능한 벡터를 기반으로 하는 고정 행렬로 대체됩니다.

5. ERNIE Tsinghua University, Huawei / 2019

지식 그래프의 명명된 엔터티에 대한 정보를 BERT에 삽입합니다. 입력은 텍스트 토큰 세트와 엔터티 토큰 세트로 구성됩니다(각 토큰은 전체 엔터티를 나타냄). 텍스트 토큰은 BERT로 인코딩됩니다. BERT 위에는 K개의 인코더 블록 세트가 있습니다(네트워크 매개변수의 약 3%를 차지함). 이러한 블록에서는

텍스트 토큰의 업데이트 벡터와 엔터티 토큰의 원본 벡터가 먼저 독립적으로 계산됩니다.- 엔티티 벡터가 텍스트에 나타나는 첫 번째 토큰과 일치합니다.

- GeLU를 사용하여 활성화합니다. 텍스트 토큰의 새로운 숨겨진 표현을 얻는 데 사용됩니다.

- 텍스트 및 엔터티 토큰의 새로운 벡터는 숨겨진 표현에서 얻어지고 다음 인코더 블록에 입력으로 전달됩니다.

- 사전 훈련 중에 MLM, NSP 및 토큰의 엔터티 예측(오토인코더와 같은)의 세 가지 손실이 계산되며, 오토인코더는 다음 규칙을 사용합니다.

- 15%의 경우 일치가 제거되고 모델은 텍스트만을 기반으로 엔터티를 예측해야 합니다.

- 그 외의 경우에는 정상입니다.

- 사전 훈련된 모델은 일반 BERT 모델(CLS 토큰 사용)처럼 미세 조정할 수 있습니다. 엔터티와 해당 유형 간의 관계를 결정하기 위해 세부 조정에 추가 절차를 사용할 수도 있습니다.

6. XLNet Carnegie Mellon University / 2019

BERT 교육 과정에 문제가 있기 때문입니다:

- 훈련 중에 손실 계산은 마스크 표시만 계산합니다.

- 개별 마커만 차단되며 차단된 마커 하나의 예측은 다른 마커의 예측에 영향을 미치지 않습니다.

- 모델이 훈련 중에 적극적으로 보는 실제 애플리케이션에는 MASK 토큰이 없습니다.

XLNet은 MASK를 직접 사용하는 대신 짧은 컨텍스트에서 토큰을 예측하는 방법을 학습하는 PLM(대체 언어 모델링) 작업을 제외하고 Transformer-XL을 기반으로 합니다. 이렇게 하면 모든 마커에 대해 그라데이션이 계산되고 특수 마스크 마커가 필요하지 않습니다.

컨텍스트의 토큰은 뒤섞여 있지만(예: i번째 토큰은 i-2 및 i+1번째 토큰을 기반으로 예측할 수 있음) 위치는 여전히 알려져 있습니다. 이는 현재 위치 인코딩(Transformer-XL 포함)에서는 불가능합니다. 컨텍스트의 일부가 주어진 토큰의 확률을 예측하려고 할 때 모델은 토큰 자체를 알아야 하지만 컨텍스트에서 토큰의 위치를 알아야 합니다. 이 문제를 해결하기 위해 그들은 self-attention을 두 개의 스트림으로 나눕니다.

- 각 마커 위치에는 하나가 아닌 두 개의 벡터, 즉 콘텐츠 벡터와 쿼리 벡터가 있습니다.

- 콘텐츠 벡터에는 토큰에 대한 전체 정보가 포함되어 있는 반면, 쿼리 벡터에는 위치 정보만 포함되어 있습니다.

- token의 두 벡터는 모두 context 벡터를 기반으로 계산되지만 self-attention의 쿼리 벡터는 과거 콘텐츠 벡터를 사용하여 계산되고, 콘텐츠 벡터는 과거 쿼리 벡터를 사용하여 계산됩니다.

- 쿼리 벡터는 해당 토큰의 내용에 대한 정보를 받지 않지만 컨텍스트에 대한 모든 정보를 알고 있는 반면, 콘텐츠 벡터는 완전한 정보를 포함합니다.

미세 조정 중에 쿼리 벡터를 무시하면 모델이 일반 Transformer-XL처럼 작동합니다.

실제로 모델에서는 모델이 올바르게 학습할 수 있을 만큼 컨텍스트가 충분히 길어야 합니다. RoBERTa와 동일한 양의 데이터로 학습하여 비슷한 결과를 얻었지만 구현의 복잡성으로 인해 모델이 RoBERTa만큼 인기를 끌지는 못했습니다.

7, ALBERT Google / 2019

품질 저하 없이 BERT 단순화:

- 서로 다른 인코더 블록에서 공통 매개변수를 사용하고 self-attention의 가중치는 공유될 수 있지만 완전히 연결된 레이어 가중치는 품질저하까지.

- BERT에 비해 더 작은 입력 임베딩과 더 큰 히든 레이어 벡터를 사용했습니다. 이는 네트워크 입력에서 추가 투영 행렬을 사용하여 달성할 수 있으며, 이는 또한 숨겨진 표현의 크기에서 임베딩 크기를 분리합니다.

- 모델의 매개변수는 18배 감소하고, 주행 속도는 1.7배 증가합니다.

모델은 MLM 및 SOP(문장 순서 예측)에 대해 훈련되었습니다.

8, DistilBERT Google / 2019

BERT를 최적화하는 또 다른 방법은 증류입니다.

- 인코더 블록 수가 절반으로 줄어듭니다.

- 세 가지 손실 구성 요소: MLM, 교사 모델 출력과의 교차 엔트로피 및 해당 레이어 코사인 출력 사이의 거리.

- 이 모델은 교사 모델보다 40% 더 작고 60% 더 빠르며, 다양한 작업에서 97%의 품질을 유지합니다.

9, LaBSE Google / 2020

BERT 기반 다국어 벡터화 모델. MLM 및 TLM(마커의 20%가 마스크됨)에 대해 훈련된 다음 미세 조정됩니다. 100개 이상의 언어를 지원하며 50만 개의 태그된 어휘가 포함되어 있습니다.

10, ELECTRA Google, Stanford University / 2020

생성적 적대 방법을 사용하여 BERT 훈련 가속화:

- 두 개의 BERT 유사 모델이 훈련됩니다: 소형 생성기와 주 판별기

- 생성기는 MLM으로 훈련되고, 그런 다음 마스킹된 토큰을 채웁니다

- 판별자는 생성자가 생성한 텍스트의 독창성을 예측하도록 훈련됩니다(교체 감지 작업)

- 훈련이 완료된 후 생성자는 제거되고 판별자로 미세 조정됩니다

훈련 데이터 숫자는 RoBERTa 또는 XLNet과 동일하며 모델은 비슷한 수준의 품질로 BERT, RoBERTa 및 ALBERT보다 빠르게 학습합니다. 훈련 기간이 길어질수록 성능이 향상됩니다.

11, DeBERTa Microsoft / 2020

마커 벡터의 내용과 위치를 두 개의 개별 벡터로 분리하는 또 다른 모델:

- 위치 벡터는 모든 레이어 간에 공유되며 상대적입니다. 즉, 마커 간에는 가능한 모든 거리에 대해 하나씩.

- 두 개의 새로운 가중치 행렬 K_pos 및 Q_pos를 추가했습니다.

- attention 가중치 계산을 수정하고 세 가지 곱의 합으로 단순화합니다: Q_cont * K_cont + Q_cont * K_pos + K_cont * Q_pos

- ALBERT와 마찬가지로 투영 행렬을 사용하여 임베딩 크기와 숨겨진 마크의 크기를 해결합니다. 표현 벡터 커플링.

GPT 및 T5와 유사한 모델

완전한 Transformer를 기반으로 한 모델. 적용 범위는 매우 광범위합니다. 이전 섹션의 작업 외에도 대화 에이전트, 기계 번역, 논리적 및 수학적 추론, 코드 분석 및 생성, 기본적으로 텍스트 생성도 포함됩니다. 가장 크고 "가장 똑똑한" 모델은 일반적으로 디코더 아키텍처를 기반으로 합니다. 이러한 모델은 미세 조정 없이 퓨샷 및 제로샷 모드에서 잘 작동하는 경우가 많습니다.

1, GPT-2 OpenAI/2018

디코더는 인과 LM(왼쪽 컨텍스트를 기반으로 다음 토큰 예측) 작업에 대해 훈련되었습니다. 아키텍처 관점에서 볼 때 몇 가지 사소한 변경 사항이 있습니다. 즉, 각 디코더 블록에서 교차 주의 레이어를 제거하고 LayerNorm을 사용하는 것입니다

사용된 토크나이저는 바이트 수준 BPE(50K 어휘)이며 ("dog", "dog!", "dog.")와 같은 유사한 하위 문자열을 사용하지 않습니다. 최대 시퀀스 길이는 1024입니다. 레이어 출력은 이전에 생성된 모든 태그를 캐시합니다.

2, T5 Google/2019

MLM에 대한 전체 사전 훈련(토큰의 15%가 마스크됨), 코드로 마스크된 범위(

토큰 마스킹

토큰 제거

- 토큰 패딩 문장에서 토큰 순서 반전 임의 토큰 만들기 시퀀스 시작

- 바이트 수준 BPE(어휘 크기 50K)

- 4, CTRL Salesforce / 2019

이것은 Sparse Transformer 아키텍처와 2048개 토큰의 증가된 시퀀스 길이를 갖춘 GPT-2 모델입니다. 아직도 그 문장을 기억하시나요? Don't Ask, Ask it is GPT3

6, mT5 Google / 2020 T5 모델을 기반으로 유사한 훈련을 받았지만 다국어 데이터를 사용합니다. ReLU 활성화는 GeGLU로 대체되었으며 어휘는 250K 토큰으로 확장되었습니다. 7, GLAM Google / 2021이 모델은 개념적으로 Switch Transformer와 유사하지만 미세 조정보다는 몇 장의 샷 모드로 작업하는 데 더 중점을 둡니다. 다양한 크기의 모델은 32~256개의 전문가 레이어(K=2)를 사용합니다. Transformer-XL의 상대 위치 인코딩을 사용합니다. 토큰을 처리할 때 네트워크 매개변수의 10% 미만이 활성화됩니다. 8, LaMDA Google / 2021gpt 같은 모델. 이 모델은 인과 LM에 대해 사전 훈련되고 생성 및 판별 작업에 대해 미세 조정된 대화형 모델입니다. 모델은 외부 시스템(검색, 번역)을 호출할 수도 있습니다. 9. GPT-NeoX-20B EleutherAI / 2022이 모델은 GPT-J와 유사하며 회전 위치 인코딩도 사용합니다. 모델 가중치는 float16으로 표시됩니다. 최대 시퀀스 길이는 2048입니다. 10, BLOOM BigScience / 2022 46개 언어, 13개 프로그래밍 언어로 지원되는 최대 오픈소스 모델입니다. 모델을 교육하기 위해 약 500개의 공개 데이터 세트가 포함된 ROOTS라는 대규모 집계 데이터 세트가 사용됩니다. 11, PaLM Google / 2022이것은 Adafactor를 사용하여 훈련하고 사전 훈련 중에 드롭아웃을 비활성화하고 미세 조정 중에 0.1을 사용하는 대규모 다국어 디코더 모델입니다. 12, LLaMA Meta/2023다중 교육 모델을 훈련하는 데 사용된 과학 연구용 오픈 소스 대규모 gpt형 LM입니다. 이 모델은 Pre-LayerNorm, SwiGLU 활성화 및 RoPE 위치 임베딩을 사용합니다. 오픈소스이기 때문에 코너에서 추월하기 위한 주요 모델 중 하나입니다. 텍스트용 안내 모델이러한 모델 캡처는 모델 출력(예: RLHF)을 수정하여 대화 및 작업 해결 중 응답 품질을 향상시키는 데 사용됩니다. 1. InstructGPT OpenAI/2022이 작업은 지침을 효율적으로 따르도록 GPT-3를 적용합니다. 이 모델은 인간이 일련의 기준에 따라 좋다고 생각하는 힌트와 답변으로 구성된 데이터 세트에서 미세 조정됩니다. InstructGPT를 기반으로 OpenAI는 현재 ChatGPT로 알려진 모델을 만들었습니다. 2, Flan-T5 Google / 2022T5에 적합한 안내 모델입니다. 일부 작업에서는 Flan-T5 11B가 이러한 미세 조정 없이 PaLM 62B보다 성능이 뛰어났습니다. 이 모델은 오픈 소스로 출시되었습니다. 3. Sparrow DeepMind / 2022 기본 모델은 선택된 고품질 대화에서 Chinchilla를 미세 조정하여 얻은 것이며 레이어의 처음 80%는 동결됩니다. 그런 다음 모델은 대화를 안내하는 큰 프롬프트를 사용하여 추가로 훈련되었습니다. Chinchilla를 기반으로 여러 보상 모델도 훈련되었습니다. 모델은 검색 엔진에 액세스하여 응답이 될 수 있는 최대 500자의 스니펫을 검색할 수 있습니다. 추론 중에 보상 모델은 후보자 순위를 매기는 데 사용됩니다. 후보는 모델에 의해 생성되거나 검색에서 얻은 다음 가장 좋은 후보가 응답이 됩니다.4. 알파카 스탠포드 대학교 / 2023

위의 LLaMA 안내 모델. 주요 초점은 GPT-3을 사용하여 데이터 세트를 구축하는 프로세스입니다.

- 목표는 입력이 비어 있을 수 있는 작업-입력-출력 트리플 세트를 얻는 것입니다.

- 인간은 답변이 포함된 175개의 작업 프롬프트를 생성하고, 이는 새로운 작업을 생성하는 GPT-3에 입력됩니다.

- 생성 프로세스는 반복적이며 각 단계마다 인간의 일부 작업 예제와 이전에 생성된 작업 예제의 일부가 제공됩니다.

- GPT-3에서는 생성된 작업을 분류 작업과 비분류 작업으로 나누고 이를 기반으로 다양한 입력과 출력을 생성합니다.

- 트리플은 데이터베이스의 기존 트리플과의 품질 및 차이점을 기준으로 필터링됩니다.

총 52K개의 고유한 트리플이 LLaMA 7B에서 생성되고 미세 조정되었습니다.

5, Koala Berkeley University / 2023

이것은 명령어 데이터에 대한 LLaMA를 미세 조정하는 것이지만 위의 알파카와 달리 GPT-3와 같은 대형 모델에서 생성된 데이터에 대해서만 미세 조정하는 것이 아닙니다. 데이터 세트의 구성은 다음과 같습니다.

- 수학, 시 및 대화에 대한 30,000개의 설명 및 답변 샘플; Alpaca 데이터 세트의 52,000개 샘플

- 유용성과 해로움에 대한 사용자 선호도에 대한 160,000개의 모델 응답; 사용자 질문 및 평가

- 93K 요약 및 사용자 평가

- GPT-3에 비해 품질이 향상되지 않습니다. 그러나 블라인드 테스트에서 사용자는 알파카보다 코알라의 답변을 더 선호했습니다.

- 텍스트에서 이미지를 생성하는 모델

텍스트 설명을 기반으로 하는 이미지 생성기. 변환기와 결합된 확산 모델이 이 분야를 지배하여 이미지 생성뿐만 아니라 콘텐츠 조작 및 해상도 향상도 가능하게 합니다.

1. DALL-E OpenAI/2021

이 작업은 이미지 라벨링 교육과 텍스트 및 이미지의 공동 생성 모델 학습의 두 단계로 수행됩니다.

첫 번째 단계에서는 이미지가 256x256x3 공간에서 32x32xdim으로 그리고 그 반대로 변환되는 dVAE가 훈련됩니다. 여기서 희미함은 숨겨진 표현 벡터의 차원입니다. 총 8192개의 마커 벡터가 있으며, 이는 모델에서 추가로 사용될 것입니다.

사용된 주요 모델은 스파스 트랜스포머 디코더입니다. 텍스트 토큰과 이미지 토큰을 입력으로 사용하여 모델은 공동 분포(Causal LM)를 학습한 후 텍스트를 기반으로 이미지 토큰을 생성할 수 있습니다. dVAE는 동일한 토큰을 기반으로 이미지를 생성합니다. 텍스트 태그의 체중 감량은 1/8이고, 이미지 태그의 체중 감량은 7/8입니다.

텍스트 태그에는 일반 임베딩과 위치 임베딩이 있고, 이미지 태그에는 일반 임베딩, 열 위치 임베딩, 행 위치 임베딩이 있습니다. 텍스트 토큰 시퀀스의 최대 길이는 256이고 토큰화는 BPE(16K 어휘)입니다.

2. GLIDE OpenAI / 2021

픽셀 수준에서 작동하고 텍스트로 제어되는 확산 모델(DM)입니다. Convolution, Attention 및 Residual Connection을 갖춘 U-Net 아키텍처를 기반으로 합니다. 생성을 제어하려면 다양한 방법을 사용하십시오. CLIP

3을 사용하여 얻은 이미지 벡터와 텍스트 벡터의 스칼라 곱, Latent Diffusion [Stable Diffusion] CompVis [Stability AI] / 2021 [2022]

픽셀 공간에서 작동하는 확산 모델에는 주로 2가지 모델이 포함됩니다:

A 잠재 공간 차원 축소 및 생성에서 생성된 VAE 자동 인코더의 내부 표현에 대한 DM- 자동 인코더는 결과에 판별자를 사용하고 추가 정규화를 적용하는 gan과 유사한 방식으로 훈련되어 표준 정규 분포에 근접함을 나타냅니다.

- 결과는 잠재 공간에서 DM 디코딩으로 들어갑니다. 조건이 벡터이면 단계 입력에서 잠재 벡터와 연결되고, 벡터 시퀀스인 경우 교차 주의에 사용됩니다. 다양한 U-Net 레이어. 텍스트 힌트의 경우 CLIP 벡터를 사용하세요.

이 다재다능한 모델은 텍스트를 이미지로 변환, 색상화, 페인팅, 초해상도 등 다양한 작업에 맞게 훈련할 수 있습니다.

4, Imagen Google / 2022

Imagen의 주요 아이디어는 텍스트 인코더의 크기를 늘리면 DM 크기를 늘리는 것보다 생성 모델에 더 많은 이점을 가져올 수 있다는 것입니다. 그래서 CLIP은 T5-XXL로 교체되었습니다.

이미지에서 텍스트를 생성하는 모델

이 섹션의 모델은 다양한 성격의 데이터를 분석하면서 텍스트를 생성하기 때문에 다중 모드 모델이라고도 합니다. 생성된 텍스트는 자연어이거나 로봇과 같은 명령 집합일 수 있습니다.

1, CoCa Google / 2022

별도의 이미지 인코더(ViT 또는 CNN) + 공유 디코더. 전반부는 텍스트를 처리하고 후반부는 이미지 인코더의 출력과 함께 텍스트를 처리합니다.

288x288 이미지는 18x18 덩어리로 잘리고 인코더는 이를 벡터 + 이러한 모든 벡터를 기반으로 하는 공유 관심 풀 벡터로 변환합니다.

디코더 전반부 출력은 문장 끝 부분의 텍스트 벡터와 CLS 토큰 벡터로, 문장형(64K 어휘)을 사용하여 토큰화됩니다. 텍스트와 이미지 벡터는 크로스어텐션을 통해 디코더의 후반부에서 병합됩니다.

두 손실의 가중치는 다음과 같습니다.

이미지의 주의 풀 벡터와 이미지 설명 쌍 텍스트의 CLS 태그 벡터 간의 유사성. 전체 디코더 출력에 대한 자동 회귀 손실(이미지에 따라 다름)- 미세 조정 과정 중에는 이미지 인코더가 정지될 수 있으며 Attention Pool만 미세 조정이 가능합니다.

-

2. PaLM-E Google / 2023

이미지는 ViT로 인코딩되고, 출력 벡터와 텍스트 토큰 및 명령이 PaLM에 공급되고 PaLM이 출력 텍스트를 생성합니다.

PaLM-E는 VQA, 물체 감지, 로봇 작동을 포함한 모든 작업에 사용됩니다.

3. GPT-4 OpenAI/2023

이것은 알려진 세부 사항이 거의 없는 폐쇄형 모델입니다. 아마도 주의력이 희박하고 다중 모드 입력을 갖춘 디코더가 있을 것입니다. 이는 8K에서 32K까지의 시퀀스 길이를 갖는 자동 회귀 훈련 및 미세 조정 RLHF를 사용합니다.

0 및 소수의 샘플을 사용하여 인간 시험에서 테스트되었으며 인간과 유사한 수준에 도달했습니다. 이미지 기반 문제(수학적 문제 포함)를 즉각적이고 단계별로 해결하고, 이미지를 이해하고 해석하며, 코드를 분석하고 생성할 수 있습니다. 소수 언어를 포함한 다양한 언어에도 적합합니다.

요약

다음은 간략한 결론입니다. 불완전하거나 단순히 부정확할 수 있으며 참조용으로만 제공됩니다.

자동 그래픽 카드를 채굴할 수 없게 된 이후 다양한 대형 모델이 몰려들고 모델의 저변도 성장했지만 단순한 레이어 증가와 데이터 세트의 증가는 이를 가능하게 하는 다양한 더 나은 기술로 대체되었습니다. 품질 개선(외부 데이터 및 도구 사용, 향상된 네트워크 구조 및 새로운 미세 조정 기술 사용) 그러나 점점 더 많은 연구 결과에 따르면 교육 데이터의 품질이 양보다 더 중요하다는 사실이 드러났습니다. 데이터 세트를 올바르게 선택하고 구성하면 교육 시간을 줄이고 결과의 품질을 향상시킬 수 있습니다.

OpenAI는 이제 비공개 소스로 전환되어 GPT-2의 가중치를 공개하지 않으려고 시도했지만 실패했습니다. 그러나 GPT4는 블랙박스입니다. 최근 몇 달 동안 오픈 소스 모델의 미세 조정 비용과 추론 속도를 개선하고 최적화하는 추세로 인해 오픈 소스 모델도 빠르게 따라잡으면서 대규모 프라이빗 모델의 가치가 크게 떨어졌습니다. 코너에서 다시 추월할 수 있는 품질의 거인입니다.

최종 오픈 소스 모델의 요약은 다음과 같습니다.

- 인코더 모델 블록 중에서 XLM-RoBERTa 및 LaBSE 모델은 신뢰할 수 있는 다중 언어 솔루션으로 간주됩니다.

- 개방형 생성 모델 중에서 가장 흥미로운 모델은 다음과 같습니다. EleutherAI의 LLaMA 및 모델(모두 미세 조정 버전 있음), Dolly-2, BLOOM(명령 미세 조정 옵션도 있음)입니다.

- 코드 측면에서 SantaCoder의 모델은 나쁘지 않지만 전반적인 품질은 분명합니다. ChatGPT/GPT -4 뒤에

- Transformer-XL 및 Sparse Transformer는 다른 모델에 사용되는 기술을 구현하며 주의 깊게 연구할 수 있습니다.

위 내용은 참고용입니다.

위 내용은 트랜스포머 리뷰: BERT에서 GPT4까지의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7681

7681

15

15

1639

1639

14

14

1393

1393

52

52

1286

1286

25

25

1229

1229

29

29

Bytedance Cutting, SVIP 슈퍼 멤버십 출시: 연간 연속 구독료 499위안, 다양한 AI 기능 제공

Jun 28, 2024 am 03:51 AM

Bytedance Cutting, SVIP 슈퍼 멤버십 출시: 연간 연속 구독료 499위안, 다양한 AI 기능 제공

Jun 28, 2024 am 03:51 AM

이 사이트는 6월 27일에 Jianying이 ByteDance의 자회사인 FaceMeng Technology에서 개발한 비디오 편집 소프트웨어라고 보도했습니다. 이 소프트웨어는 Douyin 플랫폼을 기반으로 하며 기본적으로 플랫폼 사용자를 위한 짧은 비디오 콘텐츠를 제작합니다. Windows, MacOS 및 기타 운영 체제. Jianying은 멤버십 시스템 업그레이드를 공식 발표하고 지능형 번역, 지능형 하이라이트, 지능형 패키징, 디지털 인간 합성 등 다양한 AI 블랙 기술을 포함하는 새로운 SVIP를 출시했습니다. 가격면에서 SVIP 클리핑 월 요금은 79위안, 연간 요금은 599위안(본 사이트 참고: 월 49.9위안에 해당), 월간 연속 구독료는 월 59위안, 연간 연속 구독료는 59위안입니다. 연간 499위안(월 41.6위안)입니다. 또한, 컷 관계자는 "사용자 경험 향상을 위해 기존 VIP에 가입하신 분들도

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

검색 강화 생성 및 의미론적 메모리를 AI 코딩 도우미에 통합하여 개발자 생산성, 효율성 및 정확성을 향상시킵니다. EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG에서 번역됨, 저자 JanakiramMSV. 기본 AI 프로그래밍 도우미는 자연스럽게 도움이 되지만, 소프트웨어 언어에 대한 일반적인 이해와 소프트웨어 작성의 가장 일반적인 패턴에 의존하기 때문에 가장 관련성이 높고 정확한 코드 제안을 제공하지 못하는 경우가 많습니다. 이러한 코딩 도우미가 생성한 코드는 자신이 해결해야 할 문제를 해결하는 데 적합하지만 개별 팀의 코딩 표준, 규칙 및 스타일을 따르지 않는 경우가 많습니다. 이로 인해 코드가 애플리케이션에 승인되기 위해 수정되거나 개선되어야 하는 제안이 나타나는 경우가 많습니다.

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

LLM(대형 언어 모델)은 대규모 텍스트 데이터베이스에서 훈련되어 대량의 실제 지식을 습득합니다. 이 지식은 매개변수에 내장되어 필요할 때 사용할 수 있습니다. 이러한 모델에 대한 지식은 훈련이 끝나면 "구체화"됩니다. 사전 훈련이 끝나면 모델은 실제로 학습을 중단합니다. 모델을 정렬하거나 미세 조정하여 이 지식을 활용하고 사용자 질문에 보다 자연스럽게 응답하는 방법을 알아보세요. 그러나 때로는 모델 지식만으로는 충분하지 않을 때도 있으며, 모델이 RAG를 통해 외부 콘텐츠에 접근할 수 있더라도 미세 조정을 통해 모델을 새로운 도메인에 적응시키는 것이 유익한 것으로 간주됩니다. 이러한 미세 조정은 인간 주석 작성자 또는 기타 LLM 생성자의 입력을 사용하여 수행됩니다. 여기서 모델은 추가적인 실제 지식을 접하고 이를 통합합니다.

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

AIGC에 대해 자세히 알아보려면 다음을 방문하세요. 51CTOAI.x 커뮤니티 https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou는 인터넷 어디에서나 볼 수 있는 전통적인 문제 은행과 다릅니다. 고정관념에서 벗어나 생각해야 합니다. LLM(대형 언어 모델)은 데이터 과학, 생성 인공 지능(GenAI) 및 인공 지능 분야에서 점점 더 중요해지고 있습니다. 이러한 복잡한 알고리즘은 인간의 기술을 향상시키고 많은 산업 분야에서 효율성과 혁신을 촉진하여 기업이 경쟁력을 유지하는 데 핵심이 됩니다. LLM은 자연어 처리, 텍스트 생성, 음성 인식 및 추천 시스템과 같은 분야에서 광범위하게 사용될 수 있습니다. LLM은 대량의 데이터로부터 학습하여 텍스트를 생성할 수 있습니다.

당신이 모르는 머신러닝의 5가지 학교

Jun 05, 2024 pm 08:51 PM

당신이 모르는 머신러닝의 5가지 학교

Jun 05, 2024 pm 08:51 PM

머신 러닝은 명시적으로 프로그래밍하지 않고도 컴퓨터가 데이터로부터 학습하고 능력을 향상시킬 수 있는 능력을 제공하는 인공 지능의 중요한 분야입니다. 머신러닝은 이미지 인식, 자연어 처리, 추천 시스템, 사기 탐지 등 다양한 분야에서 폭넓게 활용되며 우리의 삶의 방식을 변화시키고 있습니다. 기계 학습 분야에는 다양한 방법과 이론이 있으며, 그 중 가장 영향력 있는 5가지 방법을 "기계 학습의 5개 학교"라고 합니다. 5개 주요 학파는 상징학파, 연결주의 학파, 진화학파, 베이지안 학파, 유추학파이다. 1. 상징주의라고도 알려진 상징주의는 논리적 추론과 지식 표현을 위해 상징을 사용하는 것을 강조합니다. 이 사고 학교는 학습이 기존을 통한 역연역 과정이라고 믿습니다.

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

편집자 |ScienceAI 질문 응답(QA) 데이터 세트는 자연어 처리(NLP) 연구를 촉진하는 데 중요한 역할을 합니다. 고품질 QA 데이터 세트는 모델을 미세 조정하는 데 사용될 수 있을 뿐만 아니라 LLM(대형 언어 모델)의 기능, 특히 과학적 지식을 이해하고 추론하는 능력을 효과적으로 평가하는 데에도 사용할 수 있습니다. 현재 의학, 화학, 생물학 및 기타 분야를 포괄하는 과학적인 QA 데이터 세트가 많이 있지만 이러한 데이터 세트에는 여전히 몇 가지 단점이 있습니다. 첫째, 데이터 형식이 비교적 단순하고 대부분이 객관식 질문이므로 평가하기 쉽지만 모델의 답변 선택 범위가 제한되고 모델의 과학적 질문 답변 능력을 완전히 테스트할 수 없습니다. 이에 비해 개방형 Q&A는

SK하이닉스가 8월 6일 12단 HBM3E, 321고 NAND 등 AI 관련 신제품을 선보인다.

Aug 01, 2024 pm 09:40 PM

SK하이닉스가 8월 6일 12단 HBM3E, 321고 NAND 등 AI 관련 신제품을 선보인다.

Aug 01, 2024 pm 09:40 PM

1일 본 사이트 소식에 따르면 SK하이닉스는 오늘(1일) 블로그 게시물을 통해 8월 6일부터 8일까지 미국 캘리포니아주 산타클라라에서 열리는 글로벌 반도체 메모리 서밋 FMS2024에 참가한다고 밝혔다. 많은 새로운 세대의 제품. 인공지능 기술에 대한 관심이 높아지고 있는 가운데, 이전에는 주로 NAND 공급업체를 대상으로 한 플래시 메모리 서밋(FlashMemorySummit)이었던 미래 메모리 및 스토리지 서밋(FutureMemoryandStorage) 소개를 올해는 미래 메모리 및 스토리지 서밋(FutureMemoryandStorage)으로 명칭을 변경했습니다. DRAM 및 스토리지 공급업체와 더 많은 플레이어를 초대하세요. SK하이닉스가 지난해 출시한 신제품

SOTA 성능, 샤먼 다중 모드 단백질-리간드 친화성 예측 AI 방법, 최초로 분자 표면 정보 결합

Jul 17, 2024 pm 06:37 PM

SOTA 성능, 샤먼 다중 모드 단백질-리간드 친화성 예측 AI 방법, 최초로 분자 표면 정보 결합

Jul 17, 2024 pm 06:37 PM

Editor | KX 약물 연구 및 개발 분야에서 단백질과 리간드의 결합 친화도를 정확하고 효과적으로 예측하는 것은 약물 스크리닝 및 최적화에 매우 중요합니다. 그러나 현재 연구에서는 단백질-리간드 상호작용에서 분자 표면 정보의 중요한 역할을 고려하지 않습니다. 이를 기반으로 Xiamen University의 연구자들은 처음으로 단백질 표면, 3D 구조 및 서열에 대한 정보를 결합하고 교차 주의 메커니즘을 사용하여 다양한 양식 특징을 비교하는 새로운 다중 모드 특징 추출(MFE) 프레임워크를 제안했습니다. 조정. 실험 결과는 이 방법이 단백질-리간드 결합 친화도를 예측하는 데 있어 최첨단 성능을 달성한다는 것을 보여줍니다. 또한 절제 연구는 이 프레임워크 내에서 단백질 표면 정보와 다중 모드 기능 정렬의 효율성과 필요성을 보여줍니다. 관련 연구는 "S"로 시작된다