Python beautifulsoup4 모듈을 사용하는 방법

1. BeautifulSoup4의 보충 기본 지식

BeautifulSoup4은 주로 HTML과 XML을 구문 분석하는 데 사용되는 크롤러 지식 시스템에서 HTML 구문 분석이 더 많이 이루어집니다. 라이브러리 설치 명령은 다음과 같습니다.BeautifulSoup4 是一款 python 解析库,主要用于解析 HTML 和 XML,在爬虫知识体系中解析 HTML 会比较多一些,

该库安装命令如下:

pip install beautifulsoup4

BeautifulSoup 在解析数据时,需依赖第三方解析器,常用解析器与优势如下所示:

python 标准库 html.parser:python 内置标准库,容错能力强;lxml 解析器:速度快,容错能力强;html5lib:容错性最强,解析方式与浏览器一致。

接下来用一段自定义的 HTML 代码来演示 beautifulsoup4 库的基本使用,测试代码如下:

<html>

<head>

<title>测试bs4模块脚本</title>

</head>

<body>

<h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2>

<p>用一段自定义的 HTML 代码来演示</p>

</body>

</html>使用 BeautifulSoup 对其进行简单的操作,包含实例化 BS 对象,输出页面标签等内容。

from bs4 import BeautifulSoup text_str = """<html> <head> <title>测试bs4模块脚本</title> </head> <body> <h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2> <p>用1段自定义的 HTML 代码来演示</p> <p>用2段自定义的 HTML 代码来演示</p> </body> </html> """ # 实例化 Beautiful Soup 对象 soup = BeautifulSoup(text_str, "html.parser") # 上述是将字符串格式化为 Beautiful Soup 对象,你可以从一个文件进行格式化 # soup = BeautifulSoup(open('test.html')) print(soup) # 输入网页标题 title 标签 print(soup.title) # 输入网页 head 标签 print(soup.head) # 测试输入段落标签 p print(soup.p) # 默认获取第一个

我们可以通过 BeautifulSoup 对象,直接调用网页标签,这里存在一个问题,通过 BS 对象调用标签只能获取排在第一位置上的标签,如上述代码中,只获取到了一个 p 标签,如果想要获取更多内容,请继续阅读。

学习到这里,我们需要了解 BeautifulSoup 中的 4 个内置对象:

BeautifulSoup:基本对象,整个 HTML 对象,一般当做 Tag 对象看即可;Tag:标签对象,标签就是网页中的各个节点,例如 title,head,p;NavigableString:标签内部字符串;Comment:注释对象,爬虫里面使用场景不多。

下述代码为你演示这几种对象出现的场景,注意代码中的相关注释:

from bs4 import BeautifulSoup text_str = """<html> <head> <title>测试bs4模块脚本</title> </head> <body> <h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2> <p>用1段自定义的 HTML 代码来演示</p> <p>用2段自定义的 HTML 代码来演示</p> </body> </html> """ # 实例化 Beautiful Soup 对象 soup = BeautifulSoup(text_str, "html.parser") # 上述是将字符串格式化为 Beautiful Soup 对象,你可以从一个文件进行格式化 # soup = BeautifulSoup(open('test.html')) print(soup) print(type(soup)) # <class 'bs4.BeautifulSoup'> # 输入网页标题 title 标签 print(soup.title) print(type(soup.title)) # <class 'bs4.element.Tag'> print(type(soup.title.string)) # <class 'bs4.element.NavigableString'> # 输入网页 head 标签 print(soup.head)

对于 Tag 对象,有两个重要的属性,是 name 和 attrs

from bs4 import BeautifulSoup text_str = """<html> <head> <title>测试bs4模块脚本</title> </head> <body> <h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2> <p>用1段自定义的 HTML 代码来演示</p> <p>用2段自定义的 HTML 代码来演示</p> <a href="http://www.csdn.net" rel="external nofollow" rel="external nofollow" >CSDN 网站</a> </body> </html> """ # 实例化 Beautiful Soup 对象 soup = BeautifulSoup(text_str, "html.parser") print(soup.name) # [document] print(soup.title.name) # 获取标签名 title print(soup.html.body.a) # 可以通过标签层级获取下层标签 print(soup.body.a) # html 作为一个特殊的根标签,可以省略 print(soup.p.a) # 无法获取到 a 标签 print(soup.a.attrs) # 获取属性

上述代码演示了获取 name 属性和 attrs 属性的用法,其中 attrs 属性得到的是一个字典,可以通过键获取对应的值。

获取标签的属性值,在 BeautifulSoup 中,还可以使用如下方法:

print(soup.a["href"])

print(soup.a.get("href"))获取 NavigableString 对象 获取了网页标签之后,就要获取标签内文本了,通过下述代码进行。

print(soup.a.string)

除此之外,你还可以使用 text 属性和 get_text() 方法获取标签内容。

print(soup.a.string) print(soup.a.text) print(soup.a.get_text())

还可以获取标签内所有文本,使用 strings 和 stripped_strings 即可。

print(list(soup.body.strings)) # 获取到空格或者换行 print(list(soup.body.stripped_strings)) # 去除空格或者换行

扩展标签/节点选择器之遍历文档树

直接子节点

标签(Tag)对象的直接子元素,可以使用 contents 和 children 属性获取。

from bs4 import BeautifulSoup

text_str = """<html>

<head>

<title>测试bs4模块脚本</title>

</head>

<body>

<div id="content">

<h2 id="橡皮擦的爬虫课-span-最棒-span">橡皮擦的爬虫课<span>最棒</span></h2>

<p>用1段自定义的 HTML 代码来演示</p>

<p>用2段自定义的 HTML 代码来演示</p>

<a href="http://www.csdn.net" rel="external nofollow" rel="external nofollow" >CSDN 网站</a>

</div>

<ul class="nav">

<li>首页</li>

<li>博客</li>

<li>专栏课程</li>

</ul>

</body>

</html>

"""

# 实例化 Beautiful Soup 对象

soup = BeautifulSoup(text_str, "html.parser")

# contents 属性获取节点的直接子节点,以列表的形式返回内容

print(soup.div.contents) # 返回列表

# children 属性获取的也是节点的直接子节点,以生成器的类型返回

print(soup.div.children) # 返回 <list_iterator object at 0x00000111EE9B6340>请注意以上两个属性获取的都是直接子节点,例如 h2 标签内的后代标签 span ,不会单独获取到。

如果希望将所有的标签都获取到,使用 descendants 属性,它返回的是一个生成器,所有标签包括标签内的文本都会单独获取。

print(list(soup.div.descendants))

其它节点的获取(了解即可,即查即用)

parent和parents:直接父节点和所有父节点;next_sibling,next_siblings,previous_sibling,previous_siblings:分别表示下一个兄弟节点、下面所有兄弟节点、上一个兄弟节点、上面所有兄弟节点,由于换行符也是一个节点,所有在使用这几个属性时,要注意一下换行符;next_element,next_elements,previous_element,previous_elements:这几个属性分别表示上一个节点或者下一个节点,注意它们不分层次,而是针对所有节点,例如上述代码中div节点的下一个节点是h2,而div节点的兄弟节点是ul。

文档树搜索相关函数

第一个要学习的函数就是 find_all() 函数,原型如下所示:

find_all(name,attrs,recursive,text,limit=None,**kwargs)

name:该参数为 tag 标签的名字,例如find_all('p')是查找所有的pprint(soup.find_all('li')) # 获取所有的 li print(soup.find_all(attrs={'class': 'nav'})) # 传入 attrs 属性 print(soup.find_all(re.compile("p"))) # 传递正则,实测效果不理想 print(soup.find_all(['a','p'])) # 传递列表로그인 후 복사로그인 후 복사BeautifulSoup데이터를 구문 분석할 때 타사 구문 분석기에 의존해야 합니다. 일반적으로 사용되는 구문 분석기와 그 장점은 다음과 같습니다. 다음:🎜< ul class=" list-paddingleft-2">- 🎜

python 표준 라이브러리 html.parser: Python 내장 표준 라이브러리, 강력한 내결함성 🎜< /li> - 🎜

lxml 파서: 빠르고 내결함성 🎜 - 🎜

html5lib: 가장 내결함성이 뛰어나고 구문 분석 방법 브라우저와 일치합니다. 🎜

beautifulsoup4 라이브러리의 기본 사용을 보여줍니다. 테스트 코드는 다음과 같습니다. 🎜print(soup.body.div.find_all(['a','p'],recursive=False)) # 传递列表

BeautifulSoup< 사용 /code> BS 개체 인스턴스화, 페이지 태그 출력 등을 포함하여 간단한 작업을 수행합니다. 🎜<div class="code" style="position:relative; padding:0px; margin:0px;"><div class="code" style="position:relative; padding:0px; margin:0px;"><pre class='brush:php;toolbar:false;'>print(soup.find_all(text=&#39;首页&#39;)) # [&#39;首页&#39;]

print(soup.find_all(text=re.compile("^首"))) # [&#39;首页&#39;]

print(soup.find_all(text=["首页",re.compile(&#39;课&#39;)])) # [&#39;橡皮擦的爬虫课&#39;, &#39;首页&#39;, &#39;专栏课程&#39;]</pre><div class="contentsignin">로그인 후 복사</div></div><div class="contentsignin">로그인 후 복사</div></div>🎜BeautifulSoup 개체를 통해 웹페이지 태그를 직접 호출할 수 있는데 여기에는 문제가 있습니다. BS 개체를 통해 태그를 호출하면 태그 순위가 1위만 나올 수 있습니다. 예를 들어 위 코드에서는 <code>p<가 하나만 있습니다. /code> 태그를 얻었습니다. 더 많은 콘텐츠를 얻으려면 계속 읽으십시오. 🎜🎜<strong>이것을 배운 후에는 BeautifulSoup에 내장된 4개의 객체를 이해해야 합니다: </strong>🎜<ul class=" list-paddingleft-2"><li>🎜<code>BeautifulSoup</code >: 기본 개체, 전체 HTML 개체는 일반적으로 태그 개체로 볼 수 있습니다. 🎜</li><li>🎜<code>태그: 태그 개체, 태그는 웹 페이지의 각 노드입니다. 예: 제목, 머리글, p ;🎜NavigableString: 태그 내부 문자열 🎜Comment: 주석 개체 , 크롤러의 사용 시나리오는 동일하지 않습니다. 🎜print(soup.find_all(class_ = 'nav')) print(soup.find_all(class_ = 'nav li'))

name 및 attrs라는 두 가지 중요한 속성이 있습니다.🎜print(soup.select('ul[class^="na"]'))

name을 얻는 방법을 보여줍니다. 속성 및 attrs 속성의 사용. 여기서 attrs 속성은 사전을 가져오고 해당 값은 키로 얻을 수 있습니다. 🎜🎜태그의 속성 값을 가져옵니다. BeautifulSoup에서는 다음 방법을 사용할 수도 있습니다. 🎜print(soup.select('ul[class*="li"]'))

NavigableString 개체 가져오기 웹페이지 태그를 가져온 후 다음 코드를 통해 태그의 텍스트를 가져와야 합니다. 🎜from bs4 import BeautifulSoup

import requests

import logging

logging.basicConfig(level=logging.NOTSET)

def get_html(url, headers) -> None:

try:

res = requests.get(url=url, headers=headers, timeout=3)

except Exception as e:

logging.debug("采集异常", e)

if res is not None:

html_str = res.text

soup = BeautifulSoup(html_str, "html.parser")

imgs = soup.find_all(attrs={'class': 'lazy'})

print("获取到的数据量是", len(imgs))

datas = []

for item in imgs:

name = item.get('alt')

src = item["src"]

logging.info(f"{name},{src}")

# 获取拼接数据

datas.append((name, src))

save(datas, headers)

def save(datas, headers) -> None:

if datas is not None:

for item in datas:

try:

# 抓取图片

res = requests.get(url=item[1], headers=headers, timeout=5)

except Exception as e:

logging.debug(e)

if res is not None:

img_data = res.content

with open("./imgs/{}.jpg".format(item[0]), "wb+") as f:

f.write(img_data)

else:

return None

if __name__ == '__main__':

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/93.0.4577.82 Safari/537.36"

}

url_format = "http://www.9thws.com/#p{}"

urls = [url_format.format(i) for i in range(1, 2)]

get_html(urls[0], headers)text 속성과 get_text() 메서드를 사용하여 태그 콘텐츠를 가져올 수도 있습니다. 🎜rrreee🎜 strings 및 stripped_strings를 사용하여 태그의 모든 텍스트를 가져올 수도 있습니다. 🎜rrreee🎜문서 트리를 순회하는 확장된 태그/노드 선택기🎜🎜직접 하위 노드🎜🎜태그(태그) 객체의 직접 하위 요소, contents를 사용할 수 있으며 children 속성 획득. 🎜rrreee🎜위의 두 속성은 h2 태그 내의 하위 태그 span와 같은 직접 하위 노드를 획득하고 분리되지 않습니다. 🎜🎜모든 태그를 가져오려면 생성기를 반환하는 descendants 속성을 사용하세요. 그러면 태그 내의 텍스트를 포함한 모든 태그가 별도로 가져옵니다. 🎜rrreee🎜다른 노드 획득(알고 확인하고 사용하세요)🎜- 🎜

부모및부모code >: 직접 상위 노드 및 모든 상위 노드 🎜 - 🎜

next_sibling,next_siblings,previous_sibling,Previous_siblings: 다음 형제 노드, 아래의 모든 형제 노드, 이전 형제 노드 및 위의 모든 형제 노드를 나타냅니다. 개행 문자도 노드이므로 이러한 속성을 사용할 때는 개행 문자에 주의하세요. - 🎜

next_element,next_elements,previous_element,previous_elements: 이러한 속성은 각각 이전을 나타냅니다. 노드 또는 다음 노드는 계층적이지 않고 모든 노드에 적용됩니다. 예를 들어 위 코드에서div노드의 다음 노드는h2입니다. ,div노드의 형제 노드는ul입니다. 🎜

find_all() 함수이고, 프로토타입은 다음과 같습니다. 표시:🎜rrreee- 🎜

name: 이 매개변수는 태그 태그의 이름입니다(예:find_all). ('p' )는 모든p태그를 찾는 것이며 태그 이름 문자열, 정규 표현식 및 목록을 허용할 수 있습니다 🎜 attrs:传入的属性,该参数可以字典的形式传入,例如attrs={'class': 'nav'},返回的结果是 tag 类型的列表;

上述两个参数的用法示例如下:

print(soup.find_all('li')) # 获取所有的 li

print(soup.find_all(attrs={'class': 'nav'})) # 传入 attrs 属性

print(soup.find_all(re.compile("p"))) # 传递正则,实测效果不理想

print(soup.find_all(['a','p'])) # 传递列表recursive:调用find_all ()方法时,BeautifulSoup 会检索当前 tag 的所有子孙节点,如果只想搜索 tag 的直接子节点,可以使用参数recursive=False,测试代码如下:

print(soup.body.div.find_all(['a','p'],recursive=False)) # 传递列表

text:可以检索文档中的文本字符串内容,与name参数的可选值一样,text参数接受标签名字符串、正则表达式、 列表;

print(soup.find_all(text='首页')) # ['首页']

print(soup.find_all(text=re.compile("^首"))) # ['首页']

print(soup.find_all(text=["首页",re.compile('课')])) # ['橡皮擦的爬虫课', '首页', '专栏课程']limit:可以用来限制返回结果的数量;kwargs:如果一个指定名字的参数不是搜索内置的参数名,搜索时会把该参数当作 tag 的属性来搜索。这里要按class属性搜索,因为class是 python 的保留字,需要写作class_,按class_查找时,只要一个 CSS 类名满足即可,如需多个 CSS 名称,填写顺序需要与标签一致。

print(soup.find_all(class_ = 'nav')) print(soup.find_all(class_ = 'nav li'))

还需要注意网页节点中,有些属性在搜索中不能作为kwargs参数使用,比如html5 中的 data-*属性,需要通过attrs参数进行匹配。

与

find_all()方法用户基本一致的其它方法清单如下:

find():函数原型find( name , attrs , recursive , text , **kwargs ),返回一个匹配元素;find_parents(),find_parent():函数原型find_parent(self, name=None, attrs={}, **kwargs),返回当前节点的父级节点;find_next_siblings(),find_next_sibling():函数原型find_next_sibling(self, name=None, attrs={}, text=None, **kwargs),返回当前节点的下一兄弟节点;find_previous_siblings(),find_previous_sibling():同上,返回当前的节点的上一兄弟节点;find_all_next(),find_next(),find_all_previous () ,find_previous ():函数原型find_all_next(self, name=None, attrs={}, text=None, limit=None, **kwargs),检索当前节点的后代节点。

CSS 选择器 该小节的知识点与pyquery有点撞车,核心使用select()方法即可实现,返回数据是列表元组。

通过标签名查找,

soup.select("title");通过类名查找,

soup.select(".nav");通过 id 名查找,

soup.select("#content");通过组合查找,

soup.select("div#content");通过属性查找,

soup.select("div[id='content'"),soup.select("a[href]");

在通过属性查找时,还有一些技巧可以使用,例如:

^=:可以获取以 XX 开头的节点:

print(soup.select('ul[class^="na"]'))

*=:获取属性包含指定字符的节点:

print(soup.select('ul[class*="li"]'))

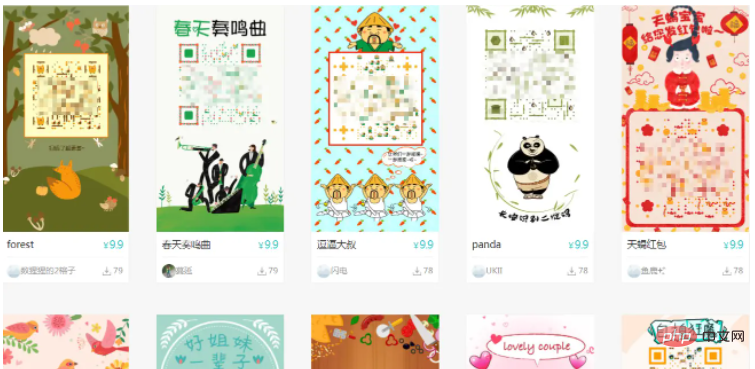

二、爬虫案例

BeautifulSoup 的基础知识掌握之后,在进行爬虫案例的编写,就非常简单了,本次要采集的目标网站 ,该目标网站有大量的艺术二维码,可以供设计大哥做参考。

下述应用到了 BeautifulSoup 模块的标签检索与属性检索,完整代码如下:

from bs4 import BeautifulSoup

import requests

import logging

logging.basicConfig(level=logging.NOTSET)

def get_html(url, headers) -> None:

try:

res = requests.get(url=url, headers=headers, timeout=3)

except Exception as e:

logging.debug("采集异常", e)

if res is not None:

html_str = res.text

soup = BeautifulSoup(html_str, "html.parser")

imgs = soup.find_all(attrs={'class': 'lazy'})

print("获取到的数据量是", len(imgs))

datas = []

for item in imgs:

name = item.get('alt')

src = item["src"]

logging.info(f"{name},{src}")

# 获取拼接数据

datas.append((name, src))

save(datas, headers)

def save(datas, headers) -> None:

if datas is not None:

for item in datas:

try:

# 抓取图片

res = requests.get(url=item[1], headers=headers, timeout=5)

except Exception as e:

logging.debug(e)

if res is not None:

img_data = res.content

with open("./imgs/{}.jpg".format(item[0]), "wb+") as f:

f.write(img_data)

else:

return None

if __name__ == '__main__':

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/93.0.4577.82 Safari/537.36"

}

url_format = "http://www.9thws.com/#p{}"

urls = [url_format.format(i) for i in range(1, 2)]

get_html(urls[0], headers)本次代码测试输出采用的 logging 模块实现,效果如下图所示。 测试仅采集了 1 页数据,如需扩大采集范围,只需要修改 main 函数内页码规则即可。 ==代码编写过程中,发现数据请求是类型是 POST,数据返回格式是 JSON,所以本案例仅作为 BeautifulSoup 的上手案例吧==

위 내용은 Python beautifulsoup4 모듈을 사용하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7480

7480

15

15

1377

1377

52

52

77

77

11

11

51

51

19

19

19

19

33

33

MySQL은 지불해야합니다

Apr 08, 2025 pm 05:36 PM

MySQL은 지불해야합니다

Apr 08, 2025 pm 05:36 PM

MySQL에는 무료 커뮤니티 버전과 유료 엔터프라이즈 버전이 있습니다. 커뮤니티 버전은 무료로 사용 및 수정할 수 있지만 지원은 제한되어 있으며 안정성이 낮은 응용 프로그램에 적합하며 기술 기능이 강합니다. Enterprise Edition은 안정적이고 신뢰할 수있는 고성능 데이터베이스가 필요하고 지원 비용을 기꺼이 지불하는 응용 프로그램에 대한 포괄적 인 상업적 지원을 제공합니다. 버전을 선택할 때 고려 된 요소에는 응용 프로그램 중요도, 예산 책정 및 기술 기술이 포함됩니다. 완벽한 옵션은없고 가장 적합한 옵션 만 있으므로 특정 상황에 따라 신중하게 선택해야합니다.

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

이 기사는 MySQL 데이터베이스의 작동을 소개합니다. 먼저 MySQLworkBench 또는 명령 줄 클라이언트와 같은 MySQL 클라이언트를 설치해야합니다. 1. MySQL-Uroot-P 명령을 사용하여 서버에 연결하고 루트 계정 암호로 로그인하십시오. 2. CreateABase를 사용하여 데이터베이스를 작성하고 데이터베이스를 선택하십시오. 3. CreateTable을 사용하여 테이블을 만들고 필드 및 데이터 유형을 정의하십시오. 4. InsertInto를 사용하여 데이터를 삽입하고 데이터를 쿼리하고 업데이트를 통해 데이터를 업데이트하고 DELETE를 통해 데이터를 삭제하십시오. 이러한 단계를 마스터하고 일반적인 문제를 처리하는 법을 배우고 데이터베이스 성능을 최적화하면 MySQL을 효율적으로 사용할 수 있습니다.

MySQL 다운로드 파일이 손상되어 설치할 수 없습니다. 수리 솔루션

Apr 08, 2025 am 11:21 AM

MySQL 다운로드 파일이 손상되어 설치할 수 없습니다. 수리 솔루션

Apr 08, 2025 am 11:21 AM

MySQL 다운로드 파일은 손상되었습니다. 어떻게해야합니까? 아아, mySQL을 다운로드하면 파일 손상을 만날 수 있습니다. 요즘 정말 쉽지 않습니다! 이 기사는 모든 사람이 우회를 피할 수 있도록이 문제를 해결하는 방법에 대해 이야기합니다. 읽은 후 손상된 MySQL 설치 패키지를 복구 할 수있을뿐만 아니라 향후에 갇히지 않도록 다운로드 및 설치 프로세스에 대해 더 깊이 이해할 수 있습니다. 파일 다운로드가 손상된 이유에 대해 먼저 이야기합시다. 이에 대한 많은 이유가 있습니다. 네트워크 문제는 범인입니다. 네트워크의 다운로드 프로세스 및 불안정성의 중단으로 인해 파일 손상이 발생할 수 있습니다. 다운로드 소스 자체에도 문제가 있습니다. 서버 파일 자체가 고장 났으며 물론 다운로드하면 고장됩니다. 또한 일부 안티 바이러스 소프트웨어의 과도한 "열정적 인"스캔으로 인해 파일 손상이 발생할 수 있습니다. 진단 문제 : 파일이 실제로 손상되었는지 확인하십시오

다운로드 후 MySQL을 설치할 수 없습니다

Apr 08, 2025 am 11:24 AM

다운로드 후 MySQL을 설치할 수 없습니다

Apr 08, 2025 am 11:24 AM

MySQL 설치 실패의 주된 이유는 다음과 같습니다. 1. 권한 문제, 관리자로 실행하거나 Sudo 명령을 사용해야합니다. 2. 종속성이 누락되었으며 관련 개발 패키지를 설치해야합니다. 3. 포트 충돌, 포트 3306을 차지하는 프로그램을 닫거나 구성 파일을 수정해야합니다. 4. 설치 패키지가 손상되어 무결성을 다운로드하여 확인해야합니다. 5. 환경 변수가 잘못 구성되었으며 운영 체제에 따라 환경 변수를 올바르게 구성해야합니다. 이러한 문제를 해결하고 각 단계를 신중하게 확인하여 MySQL을 성공적으로 설치하십시오.

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

고로드 애플리케이션의 MySQL 성능을 최적화하는 방법은 무엇입니까?

Apr 08, 2025 pm 06:03 PM

MySQL 데이터베이스 성능 최적화 안내서 리소스 집약적 응용 프로그램에서 MySQL 데이터베이스는 중요한 역할을 수행하며 대규모 트랜잭션 관리를 담당합니다. 그러나 응용 프로그램 규모가 확장됨에 따라 데이터베이스 성능 병목 현상은 종종 제약이됩니다. 이 기사는 일련의 효과적인 MySQL 성능 최적화 전략을 탐색하여 응용 프로그램이 고 부하에서 효율적이고 반응이 유지되도록합니다. 실제 사례를 결합하여 인덱싱, 쿼리 최적화, 데이터베이스 설계 및 캐싱과 같은 심층적 인 주요 기술을 설명합니다. 1. 데이터베이스 아키텍처 설계 및 최적화 된 데이터베이스 아키텍처는 MySQL 성능 최적화의 초석입니다. 몇 가지 핵심 원칙은 다음과 같습니다. 올바른 데이터 유형을 선택하고 요구 사항을 충족하는 가장 작은 데이터 유형을 선택하면 저장 공간을 절약 할 수있을뿐만 아니라 데이터 처리 속도를 향상시킬 수 있습니다.

MySQL 설치 후 시작할 수없는 서비스에 대한 솔루션

Apr 08, 2025 am 11:18 AM

MySQL 설치 후 시작할 수없는 서비스에 대한 솔루션

Apr 08, 2025 am 11:18 AM

MySQL이 시작을 거부 했습니까? 당황하지 말고 확인합시다! 많은 친구들이 MySQL을 설치 한 후 서비스를 시작할 수 없다는 것을 알았으며 너무 불안했습니다! 걱정하지 마십시오.이 기사는 침착하게 다루고 그 뒤에있는 마스터 마인드를 찾을 수 있습니다! 그것을 읽은 후에는이 문제를 해결할뿐만 아니라 MySQL 서비스에 대한 이해와 문제 해결 문제에 대한 아이디어를 향상시키고보다 강력한 데이터베이스 관리자가 될 수 있습니다! MySQL 서비스는 시작되지 않았으며 간단한 구성 오류에서 복잡한 시스템 문제에 이르기까지 여러 가지 이유가 있습니다. 가장 일반적인 측면부터 시작하겠습니다. 기본 지식 : 서비스 시작 프로세스 MySQL 서비스 시작에 대한 간단한 설명. 간단히 말해서 운영 체제는 MySQL 관련 파일을로드 한 다음 MySQL 데몬을 시작합니다. 여기에는 구성이 포함됩니다

MySQL 설치 후 데이터베이스 성능을 최적화하는 방법

Apr 08, 2025 am 11:36 AM

MySQL 설치 후 데이터베이스 성능을 최적화하는 방법

Apr 08, 2025 am 11:36 AM

MySQL 성능 최적화는 설치 구성, 인덱싱 및 쿼리 최적화, 모니터링 및 튜닝의 세 가지 측면에서 시작해야합니다. 1. 설치 후 innodb_buffer_pool_size 매개 변수와 같은 서버 구성에 따라 my.cnf 파일을 조정해야합니다. 2. 과도한 인덱스를 피하기 위해 적절한 색인을 작성하고 Execution 명령을 사용하여 실행 계획을 분석하는 것과 같은 쿼리 문을 최적화합니다. 3. MySQL의 자체 모니터링 도구 (showprocesslist, showstatus)를 사용하여 데이터베이스 건강을 모니터링하고 정기적으로 백업 및 데이터베이스를 구성하십시오. 이러한 단계를 지속적으로 최적화함으로써 MySQL 데이터베이스의 성능을 향상시킬 수 있습니다.

MySQL은 인터넷이 필요합니까?

Apr 08, 2025 pm 02:18 PM

MySQL은 인터넷이 필요합니까?

Apr 08, 2025 pm 02:18 PM

MySQL은 기본 데이터 저장 및 관리를위한 네트워크 연결없이 실행할 수 있습니다. 그러나 다른 시스템과의 상호 작용, 원격 액세스 또는 복제 및 클러스터링과 같은 고급 기능을 사용하려면 네트워크 연결이 필요합니다. 또한 보안 측정 (예 : 방화벽), 성능 최적화 (올바른 네트워크 연결 선택) 및 데이터 백업은 인터넷에 연결하는 데 중요합니다.