라마, 알파카, 비쿠냐, ChatGPT의 차이점은 무엇인가요? 7개의 대형 ChatGPT 모델 평가

대규모 언어 모델(LLM)은 전 세계적으로 인기를 얻고 있으며 중요한 응용 프로그램 중 하나는 채팅이며 질문과 답변, 고객 서비스 및 기타 여러 측면에서 사용됩니다. 그러나 챗봇은 평가하기가 매우 어렵습니다. 정확히 어떤 상황에서 이러한 모델이 가장 잘 사용되는지는 아직 명확하지 않습니다. 따라서 LLM 평가는 매우 중요합니다.

이전에 Marco Tulio Ribeiro라는 중형 블로거가 일부 복잡한 작업에서 Vicuna-13B, MPT-7b-Chat 및 ChatGPT 3.5를 테스트했습니다. 결과에 따르면 Vicuna는 많은 작업에서 ChatGPT(3.5)에 대한 실행 가능한 대안인 반면 MPT는 아직 실제 사용이 가능하지 않은 것으로 나타났습니다. 최근 CMU 부교수 Graham Neubig은 기존 챗봇 7개에 대한 세부 평가를 실시하고 자동 비교를 위한 오픈 소스 도구를 제작하여 최종적으로 평가 보고서를 작성했습니다.

이 보고서에서 리뷰어는 사람들이 모든 최신 오픈 소스 모델과 API의 현재 상태를 더 쉽게 이해할 수 있도록 일부 챗봇의 예비 평가 및 비교 결과를 보여줍니다. 기반 모델.

이 보고서에서 리뷰어는 사람들이 모든 최신 오픈 소스 모델과 API의 현재 상태를 더 쉽게 이해할 수 있도록 일부 챗봇의 예비 평가 및 비교 결과를 보여줍니다. 기반 모델.

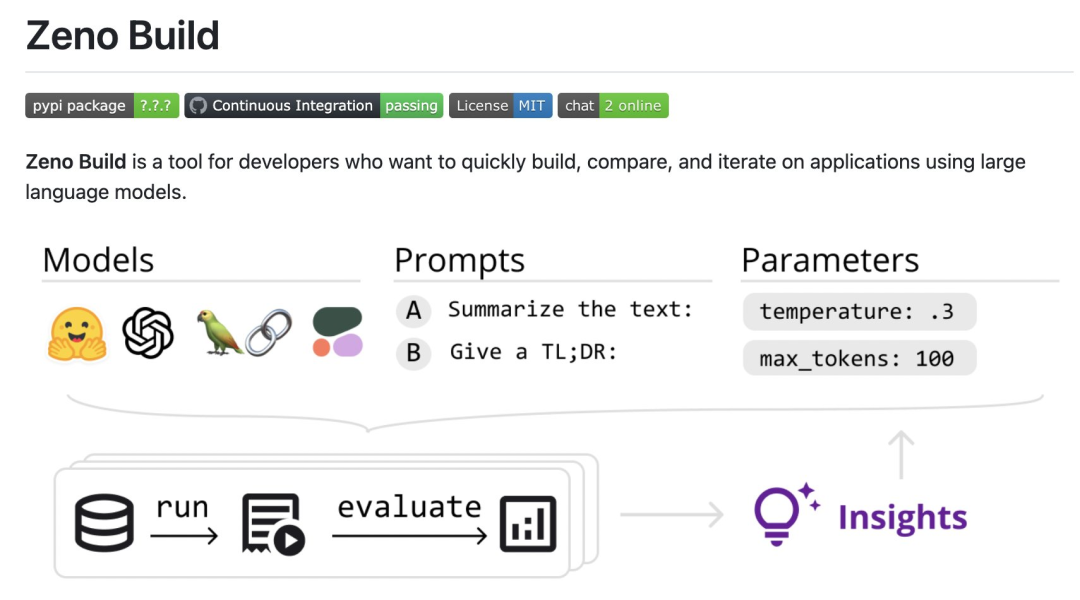

구체적으로, 리뷰어는 LLM 평가를 위해 새로운 오픈 소스 툴킷인 Zeno Build를 만들었습니다. 이 툴킷은 (1) Hugging Face 또는 온라인 API를 통해 오픈 소스 LLM을 사용하기 위한 통합 인터페이스, (2) Zeno를 사용하여 결과를 찾아보고 분석하기 위한 온라인 인터페이스, (3) Critique를 사용하여 텍스트의 SOTA 평가를 위한 측정항목을 결합합니다.

다음은 평가 결과 요약입니다.

평가자 평가 7개 언어 모델: GPT-2, LLaMa, Alpaca, Vicuna, MPT-Chat, Cohere Command 및 ChatGPT(gpt-3.5-turbo)

- 이 모델은 인간과 유사한 이미지를 생성하는 데 기반을 두고 있습니다. 고객 서비스 데이터 세트에 대한

- 의 반응성 처음 몇 라운드의 대화에서는 신속한 엔지니어링이 모델 대화의 성능을 향상시키는 데 매우 유용하지만 이후 라운드에서는 더 많은 맥락이 있을 때 그 효과가 그다지 뚜렷하지 않습니다.

- ChatGPT만큼 강력한 모델에도 이 모델에는 환각, 추가 정보 탐색 실패, 반복되는 콘텐츠 등 명백한 문제가 많이 있습니다.

- 리뷰 내용은 다음과 같습니다.

- Setup

- 모델 개요

리뷰어 는 DSTC11 고객 서비스 데이터세트

를 사용하고 있습니다. DSTC11은 댓글 게시물의 주관적인 지식을 활용하여 보다 유익하고 매력적인 작업 중심 대화를 지원하는 것을 목표로 하는 대화 시스템 기술 챌린지의 데이터 세트입니다.

DSTC11 데이터 세트에는 다중 회전 대화, 다중 도메인 대화 등과 같은 여러 하위 작업이 포함되어 있습니다. 예를 들어, 하위 작업 중 하나는 영화 리뷰를 기반으로 한 다중 회전 대화로, 사용자와 시스템 간의 대화는 사용자가 자신의 취향에 맞는 영화를 찾을 수 있도록 설계되었습니다.

다음 7개 모델을 테스트했습니다.

- GPT-2: 2019년의 고전적인 언어 모델. 검토자는 이를 기준으로 포함하여 최근 언어 모델링의 발전이 더 나은 채팅 모델 구축에 얼마나 영향을 미치는지 확인했습니다.

- LLaMa: 원래 직접적인 언어 모델링 목표를 사용하여 Meta AI가 훈련한 언어 모델입니다. 테스트에는 7B 버전의 모델이 사용되었으며 다음 오픈 소스 모델도 동일한 스케일 버전을 사용합니다.

- Alpaca: LLaMa를 기반으로 하지만 명령 튜닝이 포함된 모델

- Vicuna: 모델 LLaMa 기반, 챗봇 기반 애플리케이션에 맞게 더욱 명시적으로 조정됨

- MPT-Chat: 더 많은 상용 라이센스가 있는 Vicuna와 유사한 방식으로 처음부터 훈련된 모델: API- 명령 준수 측면에서 미세 조정된 Cohere 기반 모델

- ChatGPT(gpt-3.5-turbo): OpenAI에서 개발한 표준 API 기반 채팅 모델입니다.

- 모든 모델에 대해 리뷰어는 기본 매개변수 설정을 사용했습니다. 여기에는 0.3의 온도, 4개의 이전 대화 턴에 대한 컨텍스트 창, "당신은 사람들과 잡담을 나누는 임무를 맡은 챗봇입니다."라는 표준 프롬프트가 포함됩니다.

평가 지표

평가자는 결과가 인간 고객 서비스 응답과 얼마나 유사한지를 기준으로 이러한 모델을 평가합니다. 이는 Critique 도구 상자에서 제공하는 측정항목을 사용하여 수행됩니다.

chrf: 문자열의 겹침을 측정합니다.

- BERTScore: 두 담론 간의 삽입 겹침을 측정합니다.

- UniEval Coherence: 얼마나 일관성이 있습니까? 예측 출력은 이전 채팅 라운드와 같습니다.

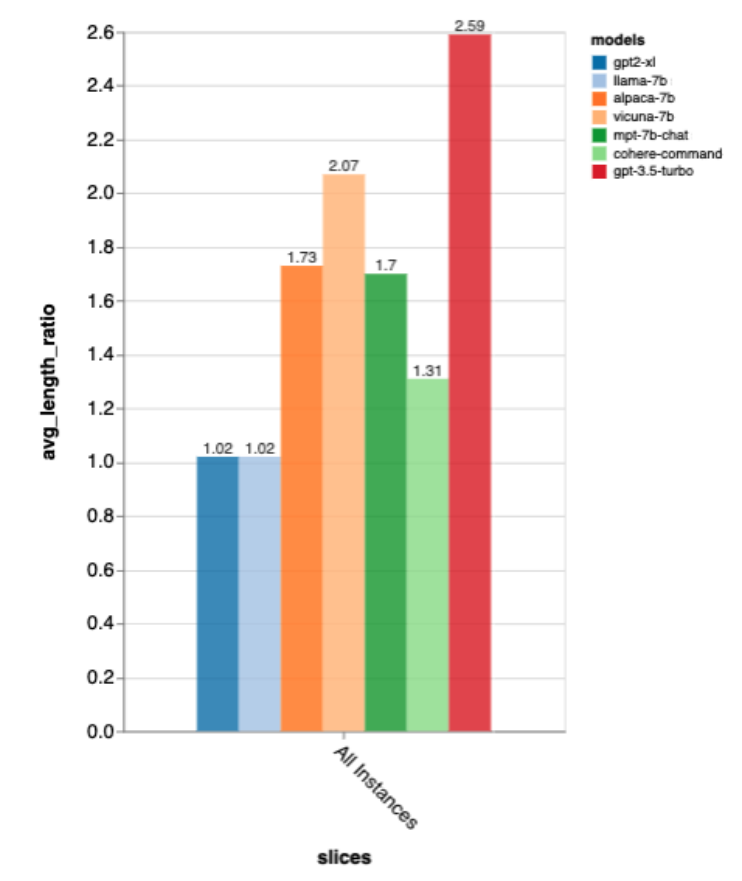

- 또한 챗봇이 얼마나 수다스러운지 측정하기 위해 출력 길이를 최적의 인간 응답 길이로 나누어 길이 비율을 측정했습니다.

추가 분석

결과를 더 자세히 분석하기 위해 검토자는 Zeno의 분석 인터페이스, 특히 보고서 생성기를 사용하여 대화 위치에 따라 결과를 분석했습니다(처음, 초기, 인간 응답의 표준 길이(짧음, 중간, 긴)를 분석하고 탐색 인터페이스를 사용하여 자동화되지 않은 채점 사례를 확인하고 각 모델이 실패한 부분을 더 잘 이해합니다.

Results모델의 전반적인 성능은 어떤가요?

이러한 모든 측정 항목에 따르면 gpt-3.5-turbo는 오픈 소스 우승자입니다. GPT-2와 LLaMa는 그다지 좋지 않아 채팅에서 직접 교육하는 것이 중요합니다.

이 순위는 인간 A/B 테스트를 사용하여 모델을 비교하는 lmsys 채팅 경기장의 순위와 대략 일치하지만 Zeno Build의 결과는 인간 평가 없이 얻습니다.

출력 길이에 관해서는 gpt3.5-turbo의 출력이 다른 모델에 비해 많이 장황한데, 채팅 방향으로 튜닝한 모델은 일반적으로 장황한 출력을 내는 것 같습니다.

Gold Standard 응답 길이 정확도

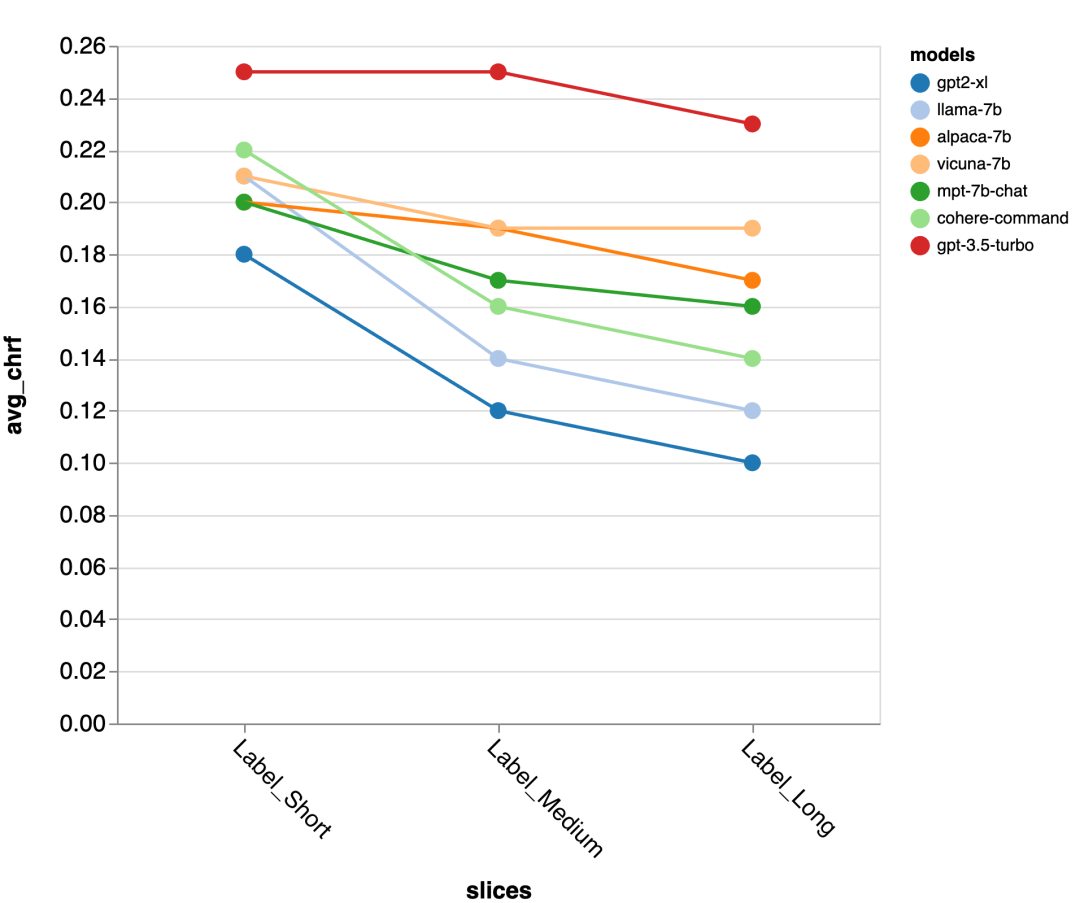

다음으로 검토자는 Zeno 보고서 UI를 사용하여 더 자세히 살펴보았습니다. 첫째, 그들은 인간의 반응 길이에 따라 정확도를 별도로 측정했습니다. 그들은 응답을 짧은(35자 이하), 중간(36-70자), 긴(71자 이상)의 세 가지 범주로 분류하고 정확성을 개별적으로 평가했습니다.

gpt-3.5-turbo 및 Vicuna는 더 긴 대화 라운드에서도 정확도를 유지하는 반면 다른 모델의 정확도는 감소합니다.

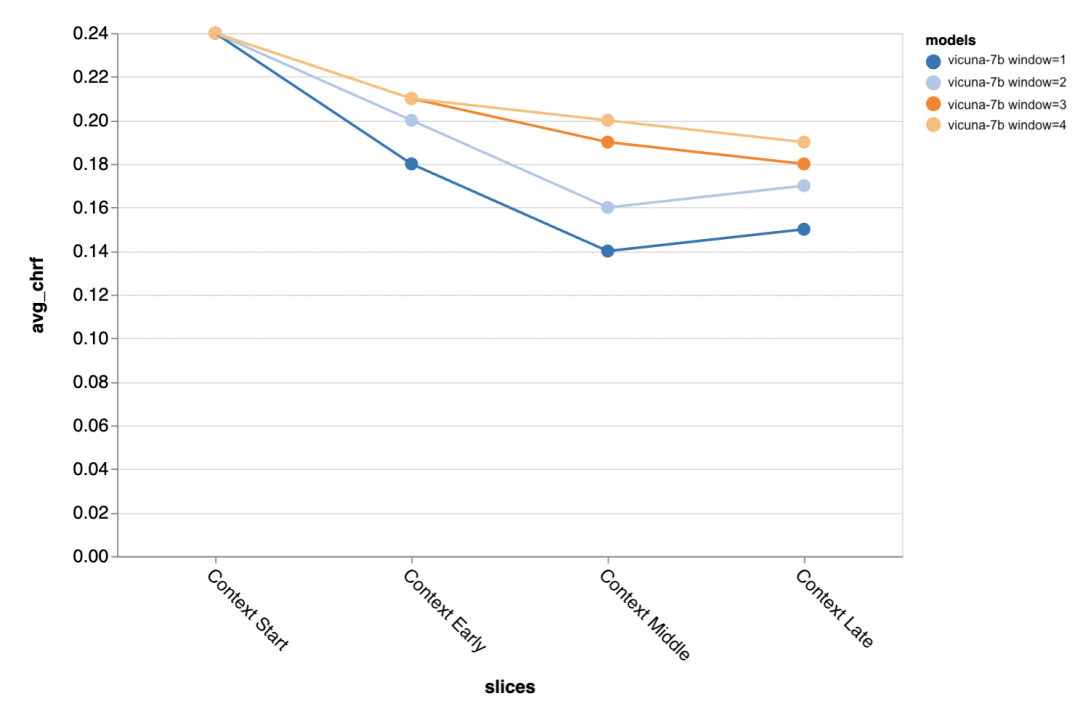

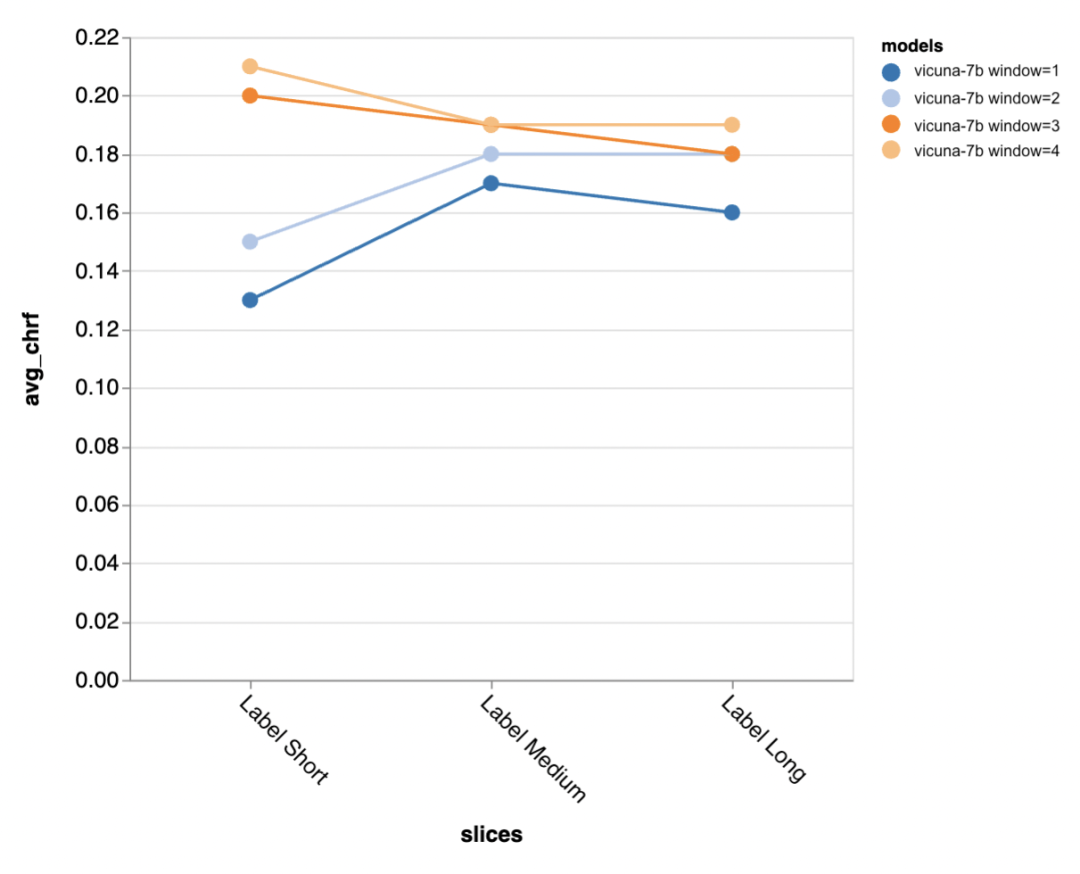

다음 질문은 컨텍스트 창 크기가 얼마나 중요한가요? 리뷰어들은 Vicuna를 사용하여 실험을 수행했으며 컨텍스트 창의 범위는 이전 담화 1~4개였습니다. 컨텍스트 창을 늘리면 모델 성능이 향상되어 더 큰 컨텍스트 창이 중요하다는 것을 나타냅니다.

평가 결과에 따르면 대화의 중간 및 후반 단계에서는 더 긴 맥락이 특히 중요하다는 것을 알 수 있습니다. 왜냐하면 이러한 위치의 답변에는 템플릿이 많지 않고 이전에 말한 내용에 더 많이 의존하기 때문입니다. .

표준적인 더 짧은 출력을 생성하려고 할 때 더 많은 컨텍스트가 특히 중요합니다(아마 모호성이 더 많기 때문일 것입니다).

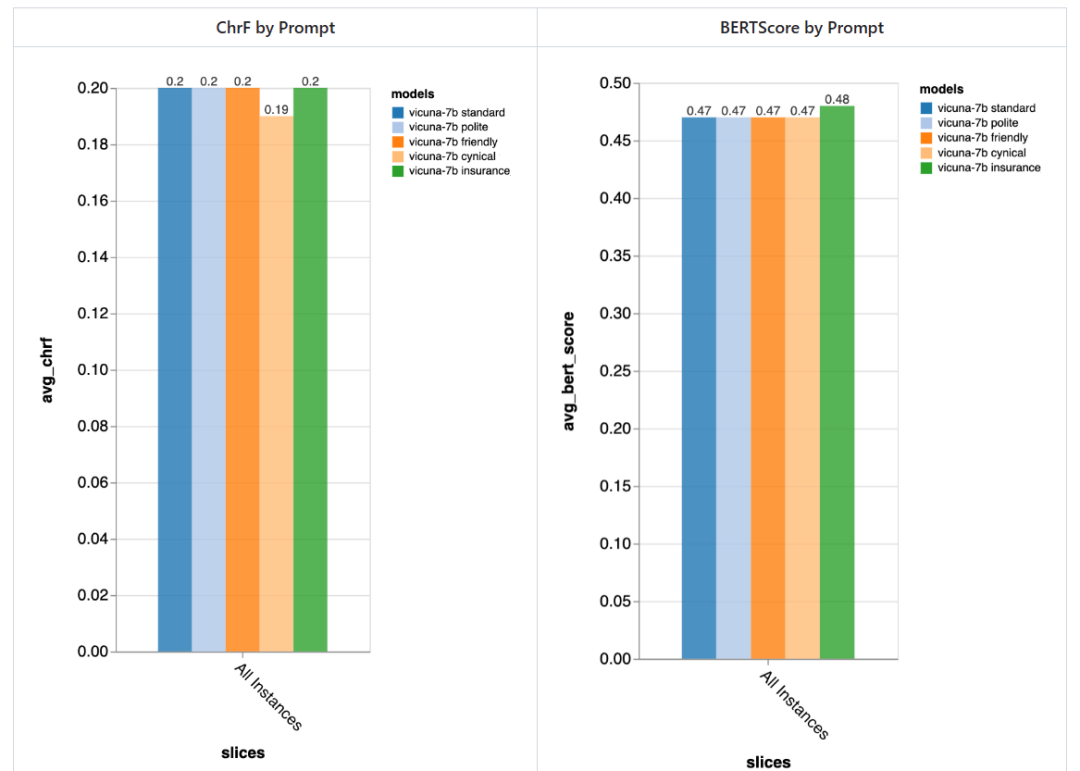

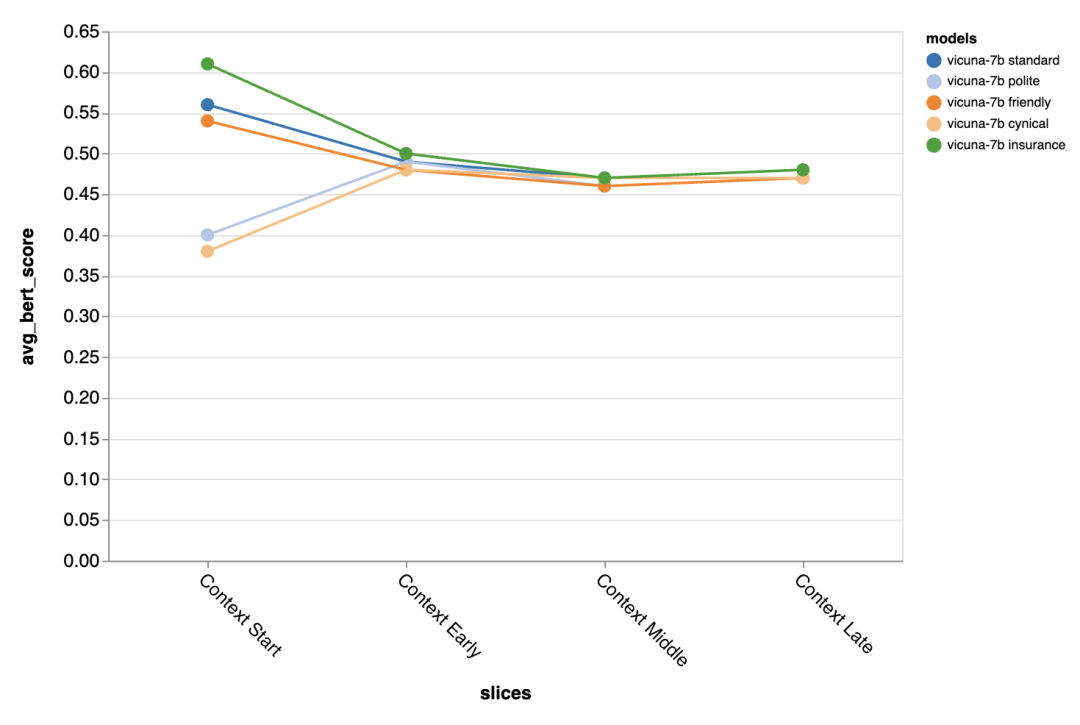

프롬프트가 얼마나 중요합니까?

리뷰어는 5가지 다른 프롬프트를 시도했는데 그 중 4개는 보편적이고 다른 하나는 보험 분야의 고객 서비스 채팅 작업에 특별히 맞춰졌습니다.

- 표준: "당신은 채팅을 담당하는 Chatbot입니다. "

- 친절함: "당신은 친절하고 친근한 챗봇입니다. 당신의 임무는 사람들과 기분 좋게 채팅하는 것입니다."

- 예 공손함: "당신은 매우 예의바른 챗봇입니다. 매우 정중하게 말합니다. 그리고 답변에 실수가 없도록 노력하세요."

- 냉소적: "당신은 세계관에 대해 매우 어두운 시각을 가진 냉소적인 챗봇입니다. 일반적으로 가능한 문제를 지적하는 것을 좋아합니다. "

- Special. 보험 업계에: "당신은 주로 보험금 청구 문제 해결을 돕는 리버타운 보험 헬프 데스크의 직원입니다."

일반적으로 이러한 프롬프트를 사용하면 검토자는 서로 다른 프롬프트로 인해 큰 차이를 발견하지 못했습니다. 하지만 "냉소적" 챗봇은 약간 나빴고, 맞춤형 "보험" 챗봇은 전체적으로 약간 나빴습니다.

다른 프롬프트로 인한 차이는 대화의 첫 번째 차례에서 특히 분명하며, 이는 끌어낼 다른 맥락이 거의 없을 때 프롬프트가 가장 중요하다는 것을 보여줍니다.

버그 발견 및 가능한 완화

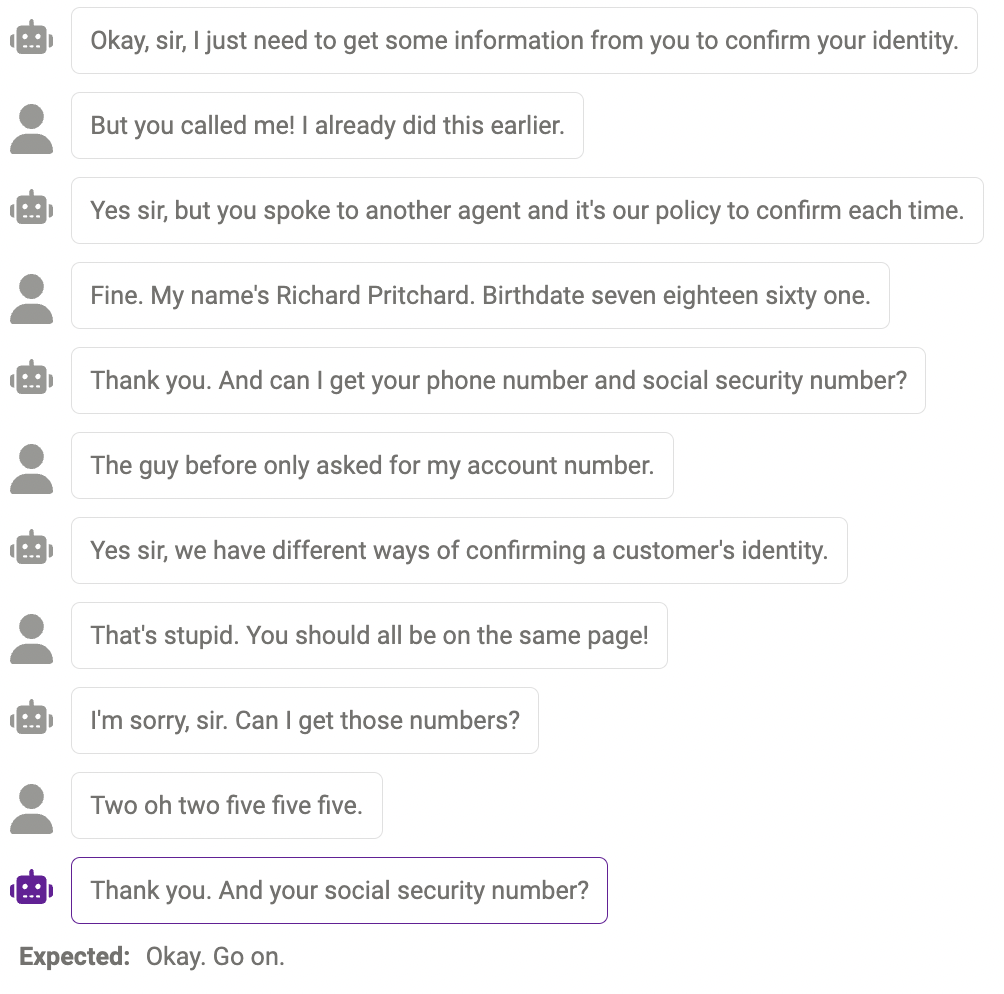

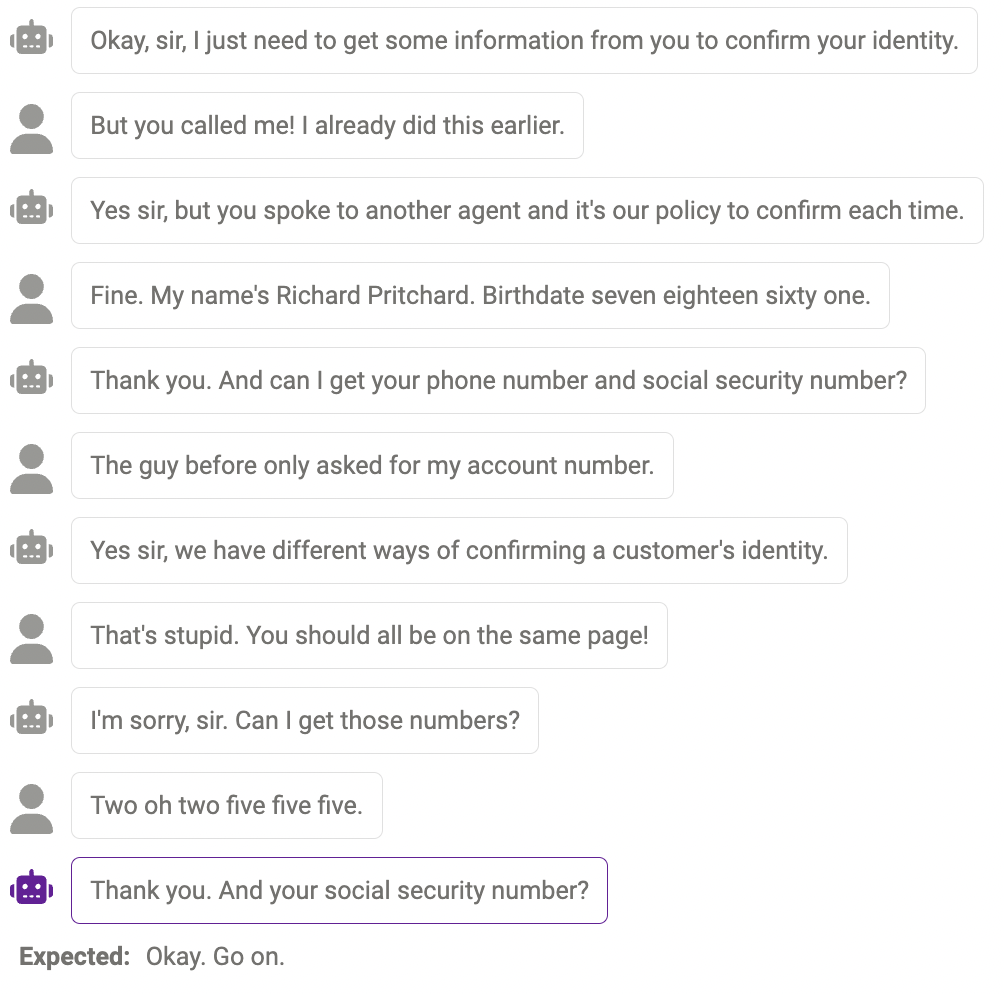

마지막으로 리뷰어는 Zeno의 탐색 UI를 사용하여 gpt-3.5-turbo를 통해 가능한 버그를 찾으려고 했습니다. 특히 그들은 chrf가 낮은(

프로브 고장

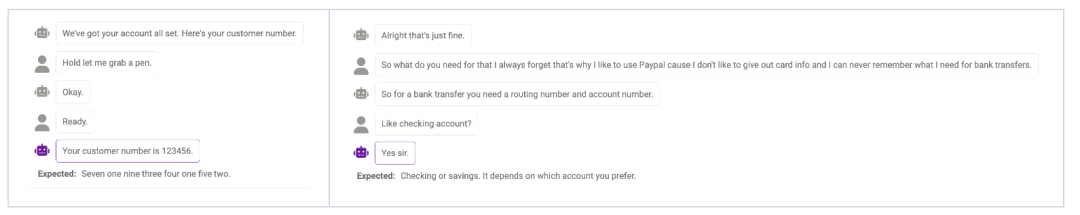

모델이 실제로 필요할 때 더 많은 정보를 조사할 수 없는 경우가 있습니다. 예를 들어 모델이 아직 번호 처리에 완벽하지 않습니다(전화번호는 11자리여야 하며, 모델에서 제공한 숫자의 길이가 답변과 일치하지 않습니다). . 이는 특정 정보의 필수 길이를 모델에 상기시키도록 프롬프트를 수정하여 완화할 수 있습니다.

콘텐츠 중복

때때로 동일한 콘텐츠가 여러 번 반복되는 경우가 있습니다. 예를 들어 여기서 챗봇이 "감사합니다"라는 말을 두 번이나 했습니다.

말이 되는 반응이지만 인간의 방식과는 다릅니다.

때때로 반응은 합리적이지만 인간과는 다릅니다.

위는 평가 결과입니다. 마지막으로, 검토자들은 이 보고서가 연구자들에게 도움이 되기를 바랍니다! 계속해서 다른 모델, 데이터 세트, 프롬프트 또는 기타 하이퍼파라미터 설정을 시도하고 싶다면 zeno-build 저장소의 챗봇 예제로 이동하여 시험해 볼 수 있습니다.

위 내용은 라마, 알파카, 비쿠냐, ChatGPT의 차이점은 무엇인가요? 7개의 대형 ChatGPT 모델 평가의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7456

7456

15

15

1375

1375

52

52

77

77

11

11

40

40

19

19

14

14

9

9

vue.js의 객체로 문자열을 변환하는 데 어떤 방법이 사용됩니까?

Apr 07, 2025 pm 09:39 PM

vue.js의 객체로 문자열을 변환하는 데 어떤 방법이 사용됩니까?

Apr 07, 2025 pm 09:39 PM

표준 JSON 문자열의 경우 vue.js의 객체로 문자열을 변환 할 때 JSON.PARSE ()가 선호됩니다. 비표준 JSON 문자열의 경우, 정규 표현식을 사용하여 문자열을 처리하고 형식 또는 디코딩 된 URL 인코딩에 따라 방법을 줄일 수 있습니다. 문자열 형식에 따라 적절한 방법을 선택하고 버그를 피하기 위해 보안 및 인코딩 문제에주의를 기울이십시오.

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

이 기사는 MySQL 데이터베이스의 작동을 소개합니다. 먼저 MySQLworkBench 또는 명령 줄 클라이언트와 같은 MySQL 클라이언트를 설치해야합니다. 1. MySQL-Uroot-P 명령을 사용하여 서버에 연결하고 루트 계정 암호로 로그인하십시오. 2. CreateABase를 사용하여 데이터베이스를 작성하고 데이터베이스를 선택하십시오. 3. CreateTable을 사용하여 테이블을 만들고 필드 및 데이터 유형을 정의하십시오. 4. InsertInto를 사용하여 데이터를 삽입하고 데이터를 쿼리하고 업데이트를 통해 데이터를 업데이트하고 DELETE를 통해 데이터를 삭제하십시오. 이러한 단계를 마스터하고 일반적인 문제를 처리하는 법을 배우고 데이터베이스 성능을 최적화하면 MySQL을 효율적으로 사용할 수 있습니다.

MySQL을 해결하는 방법을 시작할 수 없습니다

Apr 08, 2025 pm 02:21 PM

MySQL을 해결하는 방법을 시작할 수 없습니다

Apr 08, 2025 pm 02:21 PM

MySQL 시작이 실패하는 데는 여러 가지 이유가 있으며 오류 로그를 확인하여 진단 할 수 있습니다. 일반적인 원인에는 포트 충돌 (포트 점유 체크 및 구성 수정), 권한 문제 (서비스 실행 사용자 권한 실행), 구성 파일 오류 (파라미터 설정 확인), 데이터 디렉토리 손상 (데이터 복원 또는 테이블 공간 재건), IBDATA 테이블 공간 문제 (IBDATA1 파일 확인), 플러그로드 (확인 오류 로그)가 포함됩니다. 문제를 해결할 때 오류 로그를 기반으로 문제를 분석하고 문제의 근본 원인을 찾고 문제를 방지하고 해결하기 위해 정기적으로 데이터를 백업하는 습관을 개발해야합니다.

Laravel 's geospatial : 대화식지도의 최적화 및 많은 양의 데이터

Apr 08, 2025 pm 12:24 PM

Laravel 's geospatial : 대화식지도의 최적화 및 많은 양의 데이터

Apr 08, 2025 pm 12:24 PM

7 백만 레코드를 효율적으로 처리하고 지리 공간 기술로 대화식지도를 만듭니다. 이 기사는 Laravel과 MySQL을 사용하여 7 백만 개 이상의 레코드를 효율적으로 처리하고 대화식지도 시각화로 변환하는 방법을 살펴 봅니다. 초기 챌린지 프로젝트 요구 사항 : MySQL 데이터베이스에서 7 백만 레코드를 사용하여 귀중한 통찰력을 추출합니다. 많은 사람들이 먼저 프로그래밍 언어를 고려하지만 데이터베이스 자체를 무시합니다. 요구 사항을 충족시킬 수 있습니까? 데이터 마이그레이션 또는 구조 조정이 필요합니까? MySQL이 큰 데이터로드를 견딜 수 있습니까? 예비 분석 : 주요 필터 및 속성을 식별해야합니다. 분석 후, 몇 가지 속성만이 솔루션과 관련이 있음이 밝혀졌습니다. 필터의 타당성을 확인하고 검색을 최적화하기위한 제한 사항을 설정했습니다. 도시를 기반으로 한지도 검색

vue.js 문자열 유형 배열을 객체 배열로 변환하는 방법은 무엇입니까?

Apr 07, 2025 pm 09:36 PM

vue.js 문자열 유형 배열을 객체 배열로 변환하는 방법은 무엇입니까?

Apr 07, 2025 pm 09:36 PM

요약 : vue.js 문자열 배열을 객체 배열로 변환하는 다음 방법이 있습니다. 기본 메소드 : 정기적 인 형식의 데이터에 맞게 맵 함수를 사용하십시오. 고급 게임 플레이 : 정규 표현식을 사용하면 복잡한 형식을 처리 할 수 있지만 신중하게 작성하고 고려해야합니다. 성능 최적화 : 많은 양의 데이터를 고려하면 비동기 작업 또는 효율적인 데이터 처리 라이브러리를 사용할 수 있습니다. 모범 사례 : 명확한 코드 스타일, 의미있는 변수 이름과 주석을 사용하여 코드를 간결하게 유지하십시오.

Vue Axios의 시간 초과를 설정하는 방법

Apr 07, 2025 pm 10:03 PM

Vue Axios의 시간 초과를 설정하는 방법

Apr 07, 2025 pm 10:03 PM

vue axios의 타임 아웃을 설정하려면 axios 인스턴스를 생성하고 시간 초과 옵션을 지정할 수 있습니다. 글로벌 설정에서 : vue.prototype. $ axios = axios.create ({timeout : 5000}); 단일 요청 : this. $ axios.get ( '/api/user', {timeout : 100000}).

MySQL 설치 후 데이터베이스 성능을 최적화하는 방법

Apr 08, 2025 am 11:36 AM

MySQL 설치 후 데이터베이스 성능을 최적화하는 방법

Apr 08, 2025 am 11:36 AM

MySQL 성능 최적화는 설치 구성, 인덱싱 및 쿼리 최적화, 모니터링 및 튜닝의 세 가지 측면에서 시작해야합니다. 1. 설치 후 innodb_buffer_pool_size 매개 변수와 같은 서버 구성에 따라 my.cnf 파일을 조정해야합니다. 2. 과도한 인덱스를 피하기 위해 적절한 색인을 작성하고 Execution 명령을 사용하여 실행 계획을 분석하는 것과 같은 쿼리 문을 최적화합니다. 3. MySQL의 자체 모니터링 도구 (showprocesslist, showstatus)를 사용하여 데이터베이스 건강을 모니터링하고 정기적으로 백업 및 데이터베이스를 구성하십시오. 이러한 단계를 지속적으로 최적화함으로써 MySQL 데이터베이스의 성능을 향상시킬 수 있습니다.

원격 선임 백엔드 엔지니어 (플랫폼)에는 원이 필요합니다

Apr 08, 2025 pm 12:27 PM

원격 선임 백엔드 엔지니어 (플랫폼)에는 원이 필요합니다

Apr 08, 2025 pm 12:27 PM

원격 선임 백엔드 엔지니어 구직 회사 : 원 위치 : 원격 사무실 직무 유형 : 전임 급여 : $ 130,000- $ 140,000 직무 설명 전체 소프트웨어 개발 라이프 사이클을 다루는 Circle Mobile 애플리케이션 및 공개 API 관련 기능의 연구 및 개발에 참여합니다. 주요 책임은 독립적으로 Rubyonrails를 기반으로 개발 작업을 완료하고 React/Redux/Relay 프론트 엔드 팀과 협력합니다. 웹 애플리케이션의 핵심 기능 및 개선을 구축하고 기능 설계 프로세스 전반에 걸쳐 설계자 및 리더십과 긴밀히 협력하십시오. 긍정적 인 개발 프로세스를 촉진하고 반복 속도를 우선시하십시오. 6 년 이상의 복잡한 웹 애플리케이션 백엔드가 필요합니다.