신간 도서 추천 | 임베디드 인공지능 |

《내장형 인공지능》

리빈이 편집

ISBN: 978-7-302-62796-8

가격: 69.00위안

QR코드를 스캔하시면 책을 할인된 가격으로 구매하실 수 있습니다

ChatGPT의 등장으로 일반 인공지능(AGI)의 원형이 인류에게 공개되었습니다. 사람들은 인공 신경망이 특정 규모에 도달하면 의인화된 학습 방법(예: RLHF)과 결합하여 갑자기 기적이 일어나고 지능이 인간 두뇌의 족쇄를 제거하기 시작하고 컴퓨터에서 실현된다는 것을 발견했습니다!

그러나 여전히 해결해야 할 과제가 있습니다. 휴머노이드 로봇과 같이 크기와 전력 소비가 인간과 비슷한 기계에서 위의 기적을 이룰 수 있을까요?

현재 ChatGPT는 훈련 및 추론을 위해 30,000개 이상의 GPU를 사용해야 하며, 총 전력은 1천만 와트가 넘고 일일 전기 요금은 약 US$50,000입니다. 인간의 뇌의 부피는 약 1.5리터에 불과하고 전력은 20와트 미만이다. 로봇이나 더 작은 드론, 휴대폰, 스마트 가전제품, IoT 기기에 일반 인공지능을 내장하려면 위의 과제를 극복해야 합니다. 『임베디드 인공지능』이라는 책이 탐구하고 싶은 주제는 바로 이것이다.

임베디드 인공지능 분야에서는 더 높은 에너지 효율을 사용해 더욱 간소화된 알고리즘을 실행하고 이를 더 작은 크기와 무게의 기계에 배치하여 현실 세계에서 실시간 추론 작업을 완료할 것입니다. 한마디로 가장 효율적인 방식으로 인공지능을 구현해야 한다는 것입니다!

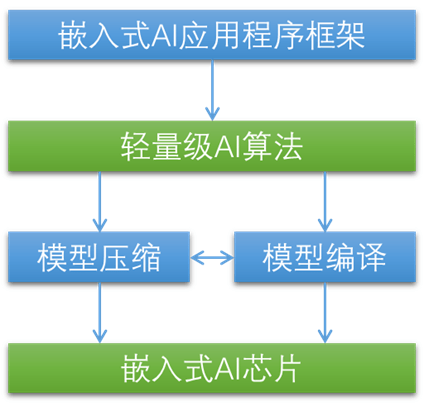

이 문제를 극복하려면 모든 수준에서 문제를 해결해야 합니다. 정리하자면, 임베디드 인공지능을 구현하기 위해서는 다섯 가지 구성요소가 필요합니다.

내장형 AI 칩. 에너지 효율이 높은 AI 가속기입니다.

경량 AI 알고리즘. 계산 복잡성이 낮고 매개변수도 적지만 정확도는 대규모 AI 알고리즘과 비슷합니다.

모델 압축. 경량 AI 알고리즘에서 중복되는 매개변수를 더욱 다듬고 이를 더욱 간소화된 방식으로 표현합니다.

컴파일 최적화. 모델을 AI 가속기의 지시에 더 적합한 인코딩으로 변환합니다.

다층 계단식 애플리케이션 프레임워크. 보다 적절한 시기에 보다 적절한 알고리즘을 사용하여 전체 시스템 비용과 에너지 소비를 줄입니다.

이 5가지 구성 요소를 조합하여 일반 인공 지능이 기계에 실제로 내장되어 보고 듣고 말하고 생각하고 진정으로 "살아" 다른 형태의 생명체가 될 것으로 예상됩니다.—— 인공 생명체.

물론 위의 꿈을 실현하려면 갈 길이 멀다. 이 책은 문제를 탐구하고 문제를 해결하기 위한 현재 방법과 도구의 개요를 설명하는 입문 가이드입니다. 최종 답은 아니지만 거기에 도달하는 열쇠를 제공합니다.

로봇, 드론, 휴대폰, 스마트 가전, 사물인터넷 기기 등 일반 인공지능을 구현하는 데 관심이 있다면 분명 유용한 입문서일 것이다.

이 책의 특징

1. 국내 임베디드 인공지능을 종합적으로 소개하는 최초의 책.

2. 내용은 풍부하고 상세하며 임베디드 인공 지능의 원리, 플랫폼 및 사례를 다룹니다.

3. 임베디드 인공지능의 원리를 체계적으로 요약하고, 개념이 참신하고 구성이 명확합니다.

4. 주류 임베디드 신경망 칩 및 소프트웨어 프레임워크를 포함한 내장형 인공 지능 플랫폼 구현에 대한 포괄적인 소개입니다.

5. 임베디드 인공지능의 개발 과정을 요약해 보세요.

6. 원리와 실습을 결합하여 코드를 사용하여 임베디드 인공지능의 실제 적용 사례를 보여줍니다.

적용 사례

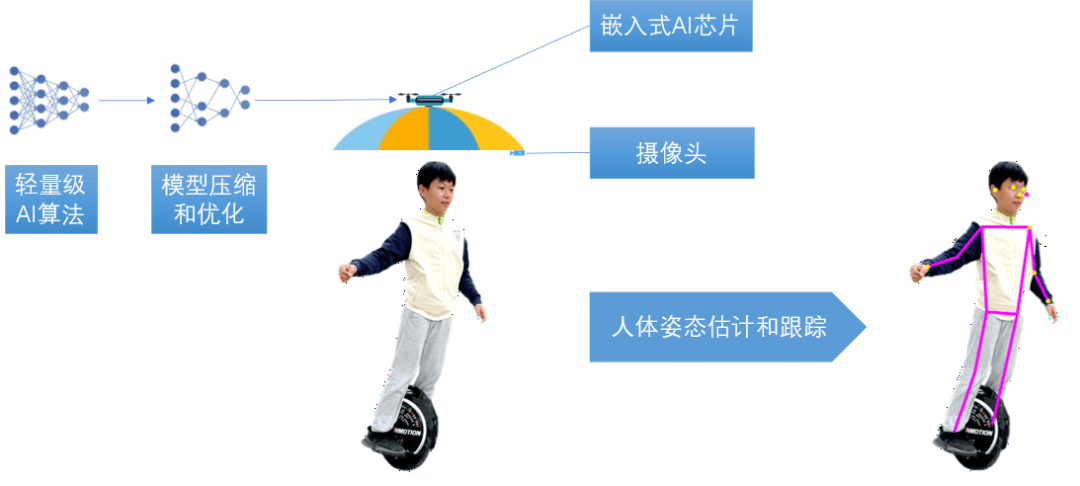

책의 마지막 장에서는 드론을 기반으로 날아다니는 태양 우산을 구현하려고 합니다. 이 우산은 사람들의 움직임을 실시간으로 추적하고 언제든지 태양으로부터 사람들을 차단함으로써 사람들의 손을 자유롭게 하고 날 수 있게 해줍니다. 더운 여름에는 쇼핑하고, 놀고, 주목받으세요.

무인 낙하산에 대한 인체 추적을 달성하기 위해 머신 비전 방법을 사용할 것입니다. 낙하산 전면에 장착된 카메라로 인체를 촬영하고, 경량 인체 자세 추정 알고리즘을 통해 인체의 윤곽을 계산해 사람의 머리 위치, 얼굴 특징, 사지 관절 등을 획득한 후 분석한다. 무인 낙하산이 이 움직임을 추적하고 언제든지 무인 낙하산의 공간적 위치를 조정하고 달성할 수 있도록 사람이 앞으로 나아갈 방향, 후퇴, 회전 또는 오르막 또는 내리막을 예측하는 인체의 움직임. 인체에 대한 다음과 차양 효과.

무게, 전력 소모 등을 고려하여 전용 내장형 AI 칩을 사용해야 합니다. 책에서는 엔비디아 젯슨(NVIDIA Jetson)을 개발 사례로 사용합니다. 이제 ARM 기반 SoC와 같이 와트당 더 강력한 추론 성능을 갖춘 칩이 급속한 기술 발전으로 인한 과제를 해결하기 위해 널리 사용되었습니다. 하지만 책에서 소개한 프로세스와 방법은 여전히 적용 가능합니다.

위의 경량 알고리즘이 내장된 AI 칩에 대한 실시간 추론 요구 사항을 충족하려면 모델 압축 및 최적화 기술을 사용하여 모델을 잘라내고 정량화하고 모델의 매개변수를 줄이고 성능을 개선해야 합니다. 추론 성능은 2배로 높이고, 전력 소모는 줄였으며, 전용 임베디드 AI 칩 추론에 최적화됐다. 이 책에서는 TensorRT를 예로 들어 ARM 기반 SoC를 사용하면 Tensorflow Lite와 같은 압축 및 최적화 기술을 사용할 수 있음을 설명합니다.

드디어 이 책의 지식을 활용하여 드디어 무인 파라솔을 날릴 수 있게 되었습니다!

목차

읽으려면 위로 스와이프하세요

1부 원칙

1장 인공지능과 인공신경망

1.1 인공지능이란 무엇인가

1.2 인공신경망이란

1.3 인간의 뇌

1.4 인공 신경망의 기본 구성

1.4.1 인공 뉴런

1.4.2 인공 신경망의 구조

1.5 인공 신경망의 학습 메커니즘

1.6 인공 신경망의 종류

1.7 인공 신경망의 장점

1.8 심층 신경망

1.8.1 심층신경망이란

18.2 일반적인 심층 신경망

1.8.3 컨볼루셔널 신경망

1.9 신경망 아키텍처 검색(NAS)

1.9.1 검색 공간

1.9.2 강화학습 검색

1.9.3 프로그레시브 검색

1.9.4 이산 검색

1.10 전이학습

1.10.1 전이학습이란

1.10.2 전이학습의 종류

1.10.3 전이학습의 장점

1.10.4 전이학습 방법

1.10.5 전이학습과 임베디드 인공지능

2장 임베디드 인공지능

2.1 임베디드 인공지능이란

2.2 임베디드 인공지능이 필요한 이유

2.3 초기 시도: 클라우드 컴퓨팅 모델

2.4 클라우드에서 장치로: 로컬 모드

2.5 임베디드 인공지능의 기술적 과제

2.5.1 모델 규모

2.5.2 에너지 효율성

2.5.3 메모리 액세스

2.5.4 추론 속도

2.5.5 크기 및 무게

2.6 임베디드 인공지능 구현 방식

2.7 임베디드 인공지능의 구현 구성요소

임베디드 AI 칩의 3장 원리

3.1 병렬 컴퓨팅

3.2 맥동 배열

3.3 다단계 캐시

3.4 데이터 흐름

4장 경량 신경망

4.1 계산 복잡성 감소

4.1.1 그룹화된 컨볼루션

4.1.2 깊이 방향 컨볼루션

4.1.3 점별 컨볼루션

4.1.4 깊이 분리 가능한 컨볼루션

4.1.5 채널 비순차적 믹싱

4.2 스퀴즈넷

4.2.1 핵심 아이디어

4.2.2 네트워크 구조

4.2.3 성능

4.3 예외

4.3.1 핵심 아이디어

4.3.2 네트워크 구조

4.3.3 성능

4.4 모바일넷 v1

4.4.1 핵심 아이디어

4.4.2 네트워크 구조

4.4.3 성능

4.5 모바일넷 v2

4.5.1 핵심 아이디어

4.5.2 네트워크 구조

4.5.3 성능

4.6 엠나스넷

4.6.1 핵심 아이디어

4.6.2 네트워크 구조

4.6.3 성능

4.7 모바일넷 v3

4.7.1 핵심 아이디어

4.7.2 네트워크 구조

4.7.3 성능

4.6 경량 신경망 적용

5장 심층 신경망 압축

5.1 신경망 압축의 일반적인 방법

5.1.1 가지치기

5.1.2 가중치 공유

5.1.3 수량화

5.1.4 이진/삼진 변환

5.1.5 위노그라드 컨볼루션

5.2 압축-컴파일 공동 디자인

5.2.1 압축 및 컴파일 공동 설계의 개념

5.2.2 압축기

5.2.5 컴파일러

5.2.6 압축 및 컴파일 공동 설계의 장점

6장 임베디드 신경망 응용 프레임워크

6.1 계층적 계단식 시스템의 구조

6.2 계층적 계단식 시스템의 효율성

6.4 로컬-클라우드 협업 모드

7장 평생 딥러닝

7.1 기존 딥러닝의 결함과 이유

7.2 평생 딥러닝의 목표

7.3 평생딥러닝의 특징

7.4 신경생물학적 의미

7.5 평생 심층 신경망 구현

7.5.1 이중 학습 시스템

7.5.2 실시간 업데이트

7.5.3 메모리 병합

7.5.4 실제 시나리오에 적응

7.6 평생 딥 러닝 및 임베디드 인공 지능

파트 2 플랫폼

8장 임베디드 신경망 하드웨어 가속기

8.1 개요

8.2 엔비디아 젯슨

8.2.1 Jetson 모듈 소개

8.2.1 Jetson 모듈 내부 구조

8.2.3 젯슨 퍼포먼스

8.3 인텔 모비디우스

8.3.1 Movidius Myriad X VPU 칩

8.3.2 Intel 신경망 컴퓨팅 스틱

8.4 Google 엣지 TPU

8.4.1 Google Edge TPU 소개

8.4.2 Google Edge TPU 작동 방식

8.5 자일링스 DPU

8.6 ARM 에토스 NPU

8.6.1 ARM 머신러닝 프로세서

8.6.2 Ethos-N 시리즈

8.6.3 에토스-U 시리즈

요약

9장 임베디드 신경망 소프트웨어 프레임워크

9.1 텐서플로우 라이트

9.1.1 TensorFlow Lite 소개

9.1.2 TensorFlow Lite 작동 방식

9.2 텐서RT

9.3 오픈VINO

9.3.1 OpenVINO 소개

9.3.2 Open VINO의 구조

9.3.3 공개 VINO 애플리케이션 개발

9.4 자일링스 바이티스

9.5 uTensor

9.6 아파치 TVM

요약

3부 구현

10장 임베디드 신경망 개발 환경 구축

10.1 임베디드 AI 개발 프로세스

10.2 NVIDIA Jetson 개발 프로세스

11장 임베디드 신경망 모델 최적화

11.1 TensorFlow 모델 최적화

11.1.1 훈련 후 최적화

11.1.2 훈련 중 최적화

11.2 TensorRT 모델 최적화

11.2.1 주류 딥 러닝 프레임워크와 통합

11.2.2 임베디드 시스템에 배포

11.2.3 텐서RT API

11.2.4 TensorRT 적용 예시

11.2.5 모델 변환기

11.3 두 가지 모델 최적화 기술 비교

12장 임베디드 장치에서 추론 수행

12.1 소스에서 프로젝트 빌드

12.2 ImageNet을 사용하여 이미지 분류 구현

12.2.1 정적 이미지 분류

12.2.2 카메라 실시간 영상 분류

12.3 DetectNet을 사용하여 표적 탐지 달성

13.3.1 정적 이미지 타겟 감지

13.3.2 카메라 실시간 영상 표적 탐지

12.4 SegNet을 사용하여 의미론적 분할 구현

12.4.1 정적 이미지 의미론적 분할

12.4.2 비디오 의미론적 분할

12.5 PyTorch를 사용하여 전이 학습 구현

12.6 변환된 모델 사용

13장 임베디드 신경망 응용예

13.1 애플리케이션 시나리오

13.2 하드웨어 선택

13.3 모델 개발

결론: 모든 것의 지능

위 내용은 신간 도서 추천 | 임베디드 인공지능 |의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7746

7746

15

15

1643

1643

14

14

1397

1397

52

52

1291

1291

25

25

1234

1234

29

29

창의적인 프로젝트를위한 최고의 AI 아트 발전기 (무료 & amp; 유료)

Apr 02, 2025 pm 06:10 PM

창의적인 프로젝트를위한 최고의 AI 아트 발전기 (무료 & amp; 유료)

Apr 02, 2025 pm 06:10 PM

이 기사는 최고의 AI 아트 생성기를 검토하여 자신의 기능, 창의적인 프로젝트에 대한 적합성 및 가치에 대해 논의합니다. Midjourney를 전문가에게 최고의 가치로 강조하고 고품질의 사용자 정의 가능한 예술에 Dall-E 2를 추천합니다.

Meta Llama 3.2- 분석 Vidhya를 시작합니다

Apr 11, 2025 pm 12:04 PM

Meta Llama 3.2- 분석 Vidhya를 시작합니다

Apr 11, 2025 pm 12:04 PM

메타의 라마 3.2 : 멀티 모달 및 모바일 AI의 도약 Meta는 최근 AI에서 강력한 비전 기능과 모바일 장치에 최적화 된 가벼운 텍스트 모델을 특징으로하는 AI의 상당한 발전 인 Llama 3.2를 공개했습니다. 성공을 바탕으로 o

최고의 AI 챗봇 비교 (Chatgpt, Gemini, Claude & amp; more)

Apr 02, 2025 pm 06:09 PM

최고의 AI 챗봇 비교 (Chatgpt, Gemini, Claude & amp; more)

Apr 02, 2025 pm 06:09 PM

이 기사는 Chatgpt, Gemini 및 Claude와 같은 최고의 AI 챗봇을 비교하여 고유 한 기능, 사용자 정의 옵션 및 자연어 처리 및 신뢰성의 성능에 중점을 둡니다.

chatgpt 4 o를 사용할 수 있습니까?

Mar 28, 2025 pm 05:29 PM

chatgpt 4 o를 사용할 수 있습니까?

Mar 28, 2025 pm 05:29 PM

ChatGpt 4는 현재 이용 가능하고 널리 사용되며 ChatGpt 3.5와 같은 전임자와 비교하여 상황을 이해하고 일관된 응답을 생성하는 데 상당한 개선을 보여줍니다. 향후 개발에는보다 개인화 된 인터가 포함될 수 있습니다

컨텐츠 생성을 향상시키기 위해 AI를 쓰는 최고 AI 작문

Apr 02, 2025 pm 06:11 PM

컨텐츠 생성을 향상시키기 위해 AI를 쓰는 최고 AI 작문

Apr 02, 2025 pm 06:11 PM

이 기사는 Grammarly, Jasper, Copy.ai, Writesonic 및 Rytr와 같은 최고의 AI 작문 조수에 대해 논의하여 콘텐츠 제작을위한 독특한 기능에 중점을 둡니다. Jasper는 SEO 최적화가 뛰어나고 AI 도구는 톤 구성을 유지하는 데 도움이된다고 주장합니다.

최고의 AI 음성 생성기 선택 : 최고 옵션 검토

Apr 02, 2025 pm 06:12 PM

최고의 AI 음성 생성기 선택 : 최고 옵션 검토

Apr 02, 2025 pm 06:12 PM

이 기사는 Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson 및 Destript와 같은 최고의 AI 음성 생성기를 검토하여 기능, 음성 품질 및 다양한 요구에 대한 적합성에 중점을 둡니다.

AI 에이전트를 구축하기위한 상위 7 개의 에이전트 래그 시스템

Mar 31, 2025 pm 04:25 PM

AI 에이전트를 구축하기위한 상위 7 개의 에이전트 래그 시스템

Mar 31, 2025 pm 04:25 PM

2024는 콘텐츠 생성에 LLM을 사용하는 것에서 내부 작업을 이해하는 것으로 바뀌는 것을 목격했습니다. 이 탐사는 AI 요원의 발견으로 이어졌다 - 자율 시스템을 처리하는 과제와 최소한의 인간 개입으로 결정을 내렸다. buildin

AV 바이트 : Meta ' S Llama 3.2, Google의 Gemini 1.5 등

Apr 11, 2025 pm 12:01 PM

AV 바이트 : Meta ' S Llama 3.2, Google의 Gemini 1.5 등

Apr 11, 2025 pm 12:01 PM

이번 주 AI 환경 : 발전의 회오리 바람, 윤리적 고려 사항 및 규제 토론. OpenAi, Google, Meta 및 Microsoft와 같은 주요 플레이어